%EC%9D%B8%EA%B3%B5%EC%A7%80%EB%8A%A5

-

이의진 교수, 차량 대화형서비스 안전성 향상 기술 개발

〈 이의진 교수, 김아욱 박사과정 〉

우리 대학 산업및시스템공학과 이의진 교수 연구팀이 차량용 인공지능이 능동적으로 운전자에게 대화 서비스를 어느 시점에 제공해야 하는지 자동으로 판단할 수 있는 기술을 개발했다.

연구팀은 차량에서 수집되는 다양한 센서 데이터와 주변 환경 정보를 통합 분석해 언제 운전자에게 말을 걸어야 하는지 자동 판단하는 인공지능 기술을 개발했다.

차량 대화형서비스가 가진 문제를 해결하는 데 중점을 둔 이번 연구는 인공지능의 자동판단 기술을 통해 대화형서비스로 인한 운전자 주의분산 문제를 해결함으로써, 부적절한 시점에 운전자에게 대화를 시도하다가 발생할 수 있는 교통사고 등을 방지하는 기반기술이 될 것으로 기대된다.

이번 연구결과는 유비쿼터스 컴퓨팅 분야 국제 최우수학회인 ACM 유비콤(UbiComp)에서 9월 13일 발표됐다. 김아욱 박사과정이 1저자로 참여하고 최우혁 박사과정, 삼성리서치 박정미 연구원, 현대자동차 김계윤 연구원과의 공동 연구로 이뤄졌다. (논문명: Interrupting Drivers for Interactions: Predicting Opportune Moments for In-vehicle Proactive Auditory-verbal Tasks)

차량 대화형서비스는 편의와 안전을 동시에 제공해야 한다. 운전 중에 대화형서비스에만 집중하면 전방 주시에 소홀하거나 주변 상황에 주의를 기울이지 못하는 문제가 발생한다. 이는 운전뿐만 아니라 대화형서비스 사용 전반에도 부정적인 영향을 줄 수도 있다.

연구진은 말 걸기 적절한 시점 판단을 위해 ▲현재 운전상황의 안전도 ▲대화 서비스 수행의 성공률 ▲운전 중 대화 수행 중 운전자가 느끼는 주관적 어려움을 통합적으로 고려한 인지 모델을 제시했다.

연구팀의 인지 모델은 개별 척도를 다양하게 조합해 인공지능 에이전트가 제공하는 대화형서비스의 유형에 따른 개입 시점의 판단 기준을 설정할 수 있다.

일기예보 같은 단순 정보만을 전달하는 경우 현재 운전상황의 안전도만 고려해 개입 시점을 판단할 수 있고, ‘그래’, ‘아니’ 같은 간단한 대답을 해야 하는 질문에는 현재 운전상황의 안전도와 대화 서비스 수행의 성공률을 함께 고려한다. 매우 보수적으로 세 가지 척도를 모두 함께 고려해 판단할 수 있다. 이 방식은 에이전트와 운전자가 여러 차례의 상호작용을 통해 의사결정을 할 때 사용한다.

정확도 높은 자동판단 인공지능 기술 개발을 위해서는 실제 도로 운전 중 에이전트와의 상호작용 데이터가 필요하기 때문에 연구팀은 반복적인 시제품 제작 및 테스트를 수행해 실제 차량 주행환경에서 사용 가능한 내비게이션 앱 기반 모의 대화형서비스를 개발했다.

자동판단을 위해 대화형서비스 시스템과 차량을 연동해 운전대 조작, 브레이크 페달 조작 상태 등 차량 내 센서 데이터와 차간거리, 차량흐름 등 주변 환경 정보를 통합 수집했다.

연구팀은 모의 대화형서비스를 사용해 29명의 운전자가 실제 운전 중에 음성 에이전트와 수행한 1천 3백 88회의 상호작용 및 센서 데이터를 구축했고, 이를 활용해 기계학습 훈련 및 테스트를 수행한 결과 적절 시점 검출 정확도가 최대 87%에 달하는 것을 확인했다.

연구팀의 이번 기술 개발로 대화형서비스로 인한 운전자 주의분산 문제를 해결할 수 있을 것으로 전망된다. 이 기술은 대화형서비스를 제공하는 차량 인포테인먼트 시스템에 바로 적용할 수 있다. 운전 부주의 실시간 진단 및 중재에도 적용될 수 있을 것으로 기대된다.

이의진 교수는 “앞으로의 차량 서비스는 더욱더 능동적으로 서비스를 제공하는 형태로 거듭나게 될 것이다”라며 “자동차에서 생성되는 기본 센서 데이터만을 활용해 최적 개입 시점을 정확히 찾을 수가 있어 앞으로는 안전한 대화 서비스 제공이 가능할 것이다”라고 밝혔다.

이번 연구는 한국연구재단 차세대정보컴퓨팅기술개발사업과 현대NGV의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 실차 데이터 수집장비 및 실제 실험 모습

그림2. 모의 대화형서비스 개념도

그림3. 차량 대화형서비스의 안전성 증진 기술 개념도

2019.11.12 조회수 19401

이의진 교수, 차량 대화형서비스 안전성 향상 기술 개발

〈 이의진 교수, 김아욱 박사과정 〉

우리 대학 산업및시스템공학과 이의진 교수 연구팀이 차량용 인공지능이 능동적으로 운전자에게 대화 서비스를 어느 시점에 제공해야 하는지 자동으로 판단할 수 있는 기술을 개발했다.

연구팀은 차량에서 수집되는 다양한 센서 데이터와 주변 환경 정보를 통합 분석해 언제 운전자에게 말을 걸어야 하는지 자동 판단하는 인공지능 기술을 개발했다.

차량 대화형서비스가 가진 문제를 해결하는 데 중점을 둔 이번 연구는 인공지능의 자동판단 기술을 통해 대화형서비스로 인한 운전자 주의분산 문제를 해결함으로써, 부적절한 시점에 운전자에게 대화를 시도하다가 발생할 수 있는 교통사고 등을 방지하는 기반기술이 될 것으로 기대된다.

이번 연구결과는 유비쿼터스 컴퓨팅 분야 국제 최우수학회인 ACM 유비콤(UbiComp)에서 9월 13일 발표됐다. 김아욱 박사과정이 1저자로 참여하고 최우혁 박사과정, 삼성리서치 박정미 연구원, 현대자동차 김계윤 연구원과의 공동 연구로 이뤄졌다. (논문명: Interrupting Drivers for Interactions: Predicting Opportune Moments for In-vehicle Proactive Auditory-verbal Tasks)

차량 대화형서비스는 편의와 안전을 동시에 제공해야 한다. 운전 중에 대화형서비스에만 집중하면 전방 주시에 소홀하거나 주변 상황에 주의를 기울이지 못하는 문제가 발생한다. 이는 운전뿐만 아니라 대화형서비스 사용 전반에도 부정적인 영향을 줄 수도 있다.

연구진은 말 걸기 적절한 시점 판단을 위해 ▲현재 운전상황의 안전도 ▲대화 서비스 수행의 성공률 ▲운전 중 대화 수행 중 운전자가 느끼는 주관적 어려움을 통합적으로 고려한 인지 모델을 제시했다.

연구팀의 인지 모델은 개별 척도를 다양하게 조합해 인공지능 에이전트가 제공하는 대화형서비스의 유형에 따른 개입 시점의 판단 기준을 설정할 수 있다.

일기예보 같은 단순 정보만을 전달하는 경우 현재 운전상황의 안전도만 고려해 개입 시점을 판단할 수 있고, ‘그래’, ‘아니’ 같은 간단한 대답을 해야 하는 질문에는 현재 운전상황의 안전도와 대화 서비스 수행의 성공률을 함께 고려한다. 매우 보수적으로 세 가지 척도를 모두 함께 고려해 판단할 수 있다. 이 방식은 에이전트와 운전자가 여러 차례의 상호작용을 통해 의사결정을 할 때 사용한다.

정확도 높은 자동판단 인공지능 기술 개발을 위해서는 실제 도로 운전 중 에이전트와의 상호작용 데이터가 필요하기 때문에 연구팀은 반복적인 시제품 제작 및 테스트를 수행해 실제 차량 주행환경에서 사용 가능한 내비게이션 앱 기반 모의 대화형서비스를 개발했다.

자동판단을 위해 대화형서비스 시스템과 차량을 연동해 운전대 조작, 브레이크 페달 조작 상태 등 차량 내 센서 데이터와 차간거리, 차량흐름 등 주변 환경 정보를 통합 수집했다.

연구팀은 모의 대화형서비스를 사용해 29명의 운전자가 실제 운전 중에 음성 에이전트와 수행한 1천 3백 88회의 상호작용 및 센서 데이터를 구축했고, 이를 활용해 기계학습 훈련 및 테스트를 수행한 결과 적절 시점 검출 정확도가 최대 87%에 달하는 것을 확인했다.

연구팀의 이번 기술 개발로 대화형서비스로 인한 운전자 주의분산 문제를 해결할 수 있을 것으로 전망된다. 이 기술은 대화형서비스를 제공하는 차량 인포테인먼트 시스템에 바로 적용할 수 있다. 운전 부주의 실시간 진단 및 중재에도 적용될 수 있을 것으로 기대된다.

이의진 교수는 “앞으로의 차량 서비스는 더욱더 능동적으로 서비스를 제공하는 형태로 거듭나게 될 것이다”라며 “자동차에서 생성되는 기본 센서 데이터만을 활용해 최적 개입 시점을 정확히 찾을 수가 있어 앞으로는 안전한 대화 서비스 제공이 가능할 것이다”라고 밝혔다.

이번 연구는 한국연구재단 차세대정보컴퓨팅기술개발사업과 현대NGV의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 실차 데이터 수집장비 및 실제 실험 모습

그림2. 모의 대화형서비스 개념도

그림3. 차량 대화형서비스의 안전성 증진 기술 개념도

2019.11.12 조회수 19401 -

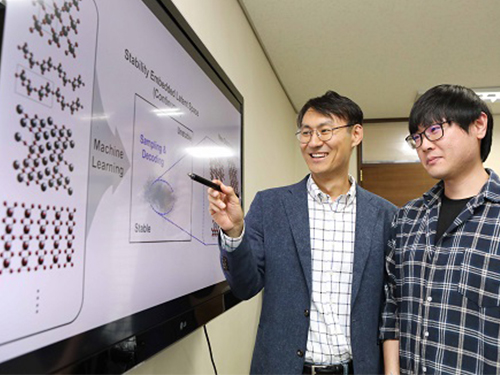

정유성 교수, 인공지능을 통한 소재 역설계 기술 개발

〈 정유성 교수, 노주환 박사과정〉

우리 대학 EEWS대학원/생명화학공학과 정유성 교수 연구팀이 인공지능을 활용해 원하는 물성을 갖는 신소재를 역설계하는 기술을 개발했다.

연구팀은 알고리즘을 통해 수만 개의 물질을 학습시킨 뒤 인공지능을 통해 원하는 물성을 갖는 소재를 역설계하는 방식으로 4종의 신물질을 발견했다. 향후 신소재 개발에 크게 이바지할 수 있을 것으로 기대된다.

노주환 박사과정이 1저자로 참여한 이번 연구 결과는 ‘셀 (Cell)’ 자매지 ‘매터(Matter)’ 10월 2일 자 온라인판에 출판됐다. (논문명 : Inverse Design of Solid State Materials via a Continuous Representation)

소재 연구의 궁극적인 목표는 원하는 물성을 갖는 신소재를 개발하는 것이다. 하지만 현재까지의 신소재 개발은 화학적 직관과 실험적 시행착오를 통한 방법 위주였기 때문에 개발 비용과 시간이 많이 들어 소재 개념화에서부터 상용화에 걸리는 시간이 평균 30년 정도 소요됐다.

기존의 소재 개발 과정은 소재를 시행착오를 통해 합성하고 난 후 물성을 측정해 만들어진 소재가 응용 목적에 맞는 소재인지를 평가하는 방식으로 개발됐다.

정 교수 연구팀은 인공지능 기술과 슈퍼컴퓨터 활용을 융합해 이러한 소재 개발을 기간을 크게 단축할 수 있는 새로운 소재 역설계 방법을 개발했다. 정 교수팀이 개발한 소재 역설계 방법은 기계(알고리즘)로 기존의 수만 개 물질과 그 물질들이 갖는 물성을 학습하게 한 후, 원하는 물성을 갖는 물질을 인공지능 기반 알고리즘이 역으로 생성하는 방식이다.

연구팀이 개발한 소재 역설계 방법은 기존의 컴퓨터 스크리닝을 통해 소재 설계를 가속화 하는 연구와도 차별성이 있다. 스크리닝 기반의 소재 발견 기술은 발견될 물질이 스크리닝 대상이 되는 물질 데이터베이스를 벗어날 수 없다는 한계를 가지고 있다. 따라서 데이터베이스에 존재하지 않는 새로운 형태의 소재를 발견하지 못한다는 단점이 있다.

연구팀이 개발한 신소재 역발견 모델은 인공지능 모델의 한 종류인 생성모델을 이용한 것으로, 생성모델은 이미지 및 음성 처리에 활발하게 활용되고 있는 기술이다. 예를 들어 수천 명의 얼굴들을 기계로 학습하게 해 새로운 사람의 얼굴을 생성해 내는 인공지능 기법이다.

연구팀은 이미지 생성에 주로 쓰이는 생성모델 기반의 인공지능 기법을 알려지지 않은 무기 고체 소재를 생성하는 데 최초로 적용했다. 특히 기존의 생성모델을 고체 소재에 적용하기 위해 역변환이 가능한 3차원 이미지 기반의 표현자를 도입함으로써 현재까지의 소재 역설계 모델의 한계를 극복했고, 이를 iMatGen(image-based Materials Generator) 이라 이름 지었다.

연구팀은 개발된 소재 역설계 기법을 새로운 바나듐 산화물 결정구조를 예측하는데 적용했다. 이 학습 과정에서 기존에 알려진 물질을 제외해 학습하더라도 제외된 물질들을 역으로 재발견할 수 있음을 확인해 개발 모델의 타당성을 검증했다.

최종적으로 개발된 모델을 통해 학습된 연속 잠재공간을 다양한 방법으로 샘플링하고 역변환 함으로써 기존에 존재하지 않는 전혀 새로운 바나듐 산화물 결정구조를 예측할 수 있었다.

정유성 교수는 “이번 연구는 원하는 물성을 갖는 무기 고체 소재를 역으로 설계하는 방법을 데이터 기반 기계학습으로 최초로 보인 예로, 향후 다양한 응용 분야의 신소재 개발에 도움을 줄 수 있을 것으로 기대한다”라고 말했다.

이번 연구 성과는 한국연구재단, 산업통상자원부 산하 에너지기술평가원, 그리고 KISTI의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 개발된 소재 역설계 모델

2019.10.07 조회수 13027

정유성 교수, 인공지능을 통한 소재 역설계 기술 개발

〈 정유성 교수, 노주환 박사과정〉

우리 대학 EEWS대학원/생명화학공학과 정유성 교수 연구팀이 인공지능을 활용해 원하는 물성을 갖는 신소재를 역설계하는 기술을 개발했다.

연구팀은 알고리즘을 통해 수만 개의 물질을 학습시킨 뒤 인공지능을 통해 원하는 물성을 갖는 소재를 역설계하는 방식으로 4종의 신물질을 발견했다. 향후 신소재 개발에 크게 이바지할 수 있을 것으로 기대된다.

노주환 박사과정이 1저자로 참여한 이번 연구 결과는 ‘셀 (Cell)’ 자매지 ‘매터(Matter)’ 10월 2일 자 온라인판에 출판됐다. (논문명 : Inverse Design of Solid State Materials via a Continuous Representation)

소재 연구의 궁극적인 목표는 원하는 물성을 갖는 신소재를 개발하는 것이다. 하지만 현재까지의 신소재 개발은 화학적 직관과 실험적 시행착오를 통한 방법 위주였기 때문에 개발 비용과 시간이 많이 들어 소재 개념화에서부터 상용화에 걸리는 시간이 평균 30년 정도 소요됐다.

기존의 소재 개발 과정은 소재를 시행착오를 통해 합성하고 난 후 물성을 측정해 만들어진 소재가 응용 목적에 맞는 소재인지를 평가하는 방식으로 개발됐다.

정 교수 연구팀은 인공지능 기술과 슈퍼컴퓨터 활용을 융합해 이러한 소재 개발을 기간을 크게 단축할 수 있는 새로운 소재 역설계 방법을 개발했다. 정 교수팀이 개발한 소재 역설계 방법은 기계(알고리즘)로 기존의 수만 개 물질과 그 물질들이 갖는 물성을 학습하게 한 후, 원하는 물성을 갖는 물질을 인공지능 기반 알고리즘이 역으로 생성하는 방식이다.

연구팀이 개발한 소재 역설계 방법은 기존의 컴퓨터 스크리닝을 통해 소재 설계를 가속화 하는 연구와도 차별성이 있다. 스크리닝 기반의 소재 발견 기술은 발견될 물질이 스크리닝 대상이 되는 물질 데이터베이스를 벗어날 수 없다는 한계를 가지고 있다. 따라서 데이터베이스에 존재하지 않는 새로운 형태의 소재를 발견하지 못한다는 단점이 있다.

연구팀이 개발한 신소재 역발견 모델은 인공지능 모델의 한 종류인 생성모델을 이용한 것으로, 생성모델은 이미지 및 음성 처리에 활발하게 활용되고 있는 기술이다. 예를 들어 수천 명의 얼굴들을 기계로 학습하게 해 새로운 사람의 얼굴을 생성해 내는 인공지능 기법이다.

연구팀은 이미지 생성에 주로 쓰이는 생성모델 기반의 인공지능 기법을 알려지지 않은 무기 고체 소재를 생성하는 데 최초로 적용했다. 특히 기존의 생성모델을 고체 소재에 적용하기 위해 역변환이 가능한 3차원 이미지 기반의 표현자를 도입함으로써 현재까지의 소재 역설계 모델의 한계를 극복했고, 이를 iMatGen(image-based Materials Generator) 이라 이름 지었다.

연구팀은 개발된 소재 역설계 기법을 새로운 바나듐 산화물 결정구조를 예측하는데 적용했다. 이 학습 과정에서 기존에 알려진 물질을 제외해 학습하더라도 제외된 물질들을 역으로 재발견할 수 있음을 확인해 개발 모델의 타당성을 검증했다.

최종적으로 개발된 모델을 통해 학습된 연속 잠재공간을 다양한 방법으로 샘플링하고 역변환 함으로써 기존에 존재하지 않는 전혀 새로운 바나듐 산화물 결정구조를 예측할 수 있었다.

정유성 교수는 “이번 연구는 원하는 물성을 갖는 무기 고체 소재를 역으로 설계하는 방법을 데이터 기반 기계학습으로 최초로 보인 예로, 향후 다양한 응용 분야의 신소재 개발에 도움을 줄 수 있을 것으로 기대한다”라고 말했다.

이번 연구 성과는 한국연구재단, 산업통상자원부 산하 에너지기술평가원, 그리고 KISTI의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 개발된 소재 역설계 모델

2019.10.07 조회수 13027 -

이상완 교수, 신경과학-인공지능 융합으로 공학적 난제 해결

〈 (왼쪽부터) 안수진 박사과정, 이지항 박사, 이상완 교수 〉

우리 대학 바이오및뇌공학과 이상완 교수 연구팀이 영국 케임브리지 대학, 구글 딥마인드와의 공동 연구를 통해 차세대 뇌 기반 인공지능 시스템 설계의 방향을 제시했다.

이번 연구는 인간의 두뇌가 기존의 인공지능 알고리즘이 해결하지 못하는 부분을 해결할 수 있다는 사실에 기반한 신경과학-인공지능 융합 연구이다.

성능, 효율, 속도의 균형적 설계와 같은 다양한 공학적 난제를 해결할 수 있는 신경과학 기반 강화학습 이론을 제안한 것으로 새로운 인공지능 알고리즘 설계에 긍정적인 영향을 줄 것으로 기대된다.

이상완 교수와 함께 이지항 박사, 안수진 박사과정이 주도한 이번 연구는 국제 학술지 사이언스의 자매지 ‘사이언스 로보틱스(Science Robotics)’ 1월 16일 자 온라인판에 포커스 형식으로 게재됐다.

최적제어 이론에서 출발한 강화학습은 기계 학습의 한 영역으로 지난 20여 년 동안 꾸준히 연구된 분야이다. 특히 지난 5년 동안은 딥러닝 기술을 발전과 맞물려 급격한 성장을 이뤘다.

딥러닝 기반 강화학습 알고리즘은 최근 알파고와 같은 전략 탐색 문제, 로봇 제어, 응급실 비상 대응 시스템과 같은 의료 진단 등 다양한 분야에 적용되고 있다. 그러나 주어진 문제에 맞게 시스템을 설계해야 하는 점, 불확실성이 높은 환경에서는 성능이 보장되지 않는 점 등이 근본적인 해결책으로 남아있다.

강화학습은 의사 결정 및 계산신경과학 분야에서도 지난 20년간 꾸준히 연구되고 있다. 이상완 교수는 2014년 인간의 전두엽-기저핵 뇌 회로에서 이종 강화학습을 제어한다는 신경과학적 증거를 학계에 발표한 바 있다. 2015년에는 같은 뇌 회로에서 고속 추론 과정을 제어한다는 연구를 발표했다.

연구팀은 이번 연구에서 강화학습 등의 개별 인공지능 알고리즘이 해결하지 못하는 공학적 문제를 인간의 두뇌가 이미 해결하고 있다는 사실에 기반한 ‘전두엽 메타 제어’ 이론을 제안했다.

중뇌 도파민-복외측전전두피질 네트워크에서 외부 환경에 대한 학습의 신뢰도를 스스로 평가할 수 있는 보상 예측 신호나 상태 예측 신호와 같은 정보를 처리하며, 인간의 두뇌는 이 정보들을 경쟁적-협력적으로 통합하는 프로세스를 통해 외부 환경에 가장 적합한 학습 및 추론 전략을 찾는다는 것이 이론의 핵심이다.

이러한 원리를 단일 인공지능 알고리즘이나 로봇설계에 적용하면 외부 상황변화에 강인하게 성능, 효율, 속도 세 조건(performance-efficiency-speed tradeoff) 사이의 균형점을 유지하는 최적의 제어 시스템을 설계할 수 있다. 더 나아가 다수의 인공지능 개체가 협력하는 상황에서는 서로의 전략을 이용함으로 협력-경쟁 사이의 균형점을 유지할 수 있다.

1 저자인 이지항 박사는 “현대 인공지능의 우수한 성능은 사람의 행동 수준 관찰뿐 아니라 두뇌의 저수준 신경 시스템을 알고리즘으로 구현해 적극적으로 발전시킨 결과라고 보고 있다”라며 “이번 연구는 계산신경과학에 기반한 결과로 현대 딥러닝과 강화학습에서 겪는 성능, 효율, 속도 사이의 난제를 해결하는 실마리가 될 수 있고, 새로운 인공지능 알고리즘 설계에 많은 영감을 줄 것이다”라고 말했다.

이상완 교수는 “연구를 하다 보면 우리의 두뇌는 공학적 난제를 의외로 쉽게 해결하고 있음을 알 수 있다. 이 원리를 인공지능 알고리즘 설계에 적용하는 뇌 기반 인공지능 연구는 구글 딥마인드, MIT, 캘리포니아 공과대학, UCL 등 해외 유수 기관에서도 관심을 두는 신경과학-인공지능 융합 연구 분야이다”라며 “장기적으로는 차세대 인공지능 핵심 연구 분야 중의 하나로 자리를 잡을 것으로 기대한다”라고 말했다.

이번 연구는 과학기술정보통신부 및 정보통신기술진흥센터 연구개발 사업, 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 외부 환경에 따라 성능-효율-속도 문제 균형점을 찾는 뇌기반 강화학습 이론 (좌), 이를 최적 제어하는 ‘전두엽 메타 제어’(중) 및 로보틱스 분야 문제 해결 적용 사례 (우)

2019.01.24 조회수 13539

이상완 교수, 신경과학-인공지능 융합으로 공학적 난제 해결

〈 (왼쪽부터) 안수진 박사과정, 이지항 박사, 이상완 교수 〉

우리 대학 바이오및뇌공학과 이상완 교수 연구팀이 영국 케임브리지 대학, 구글 딥마인드와의 공동 연구를 통해 차세대 뇌 기반 인공지능 시스템 설계의 방향을 제시했다.

이번 연구는 인간의 두뇌가 기존의 인공지능 알고리즘이 해결하지 못하는 부분을 해결할 수 있다는 사실에 기반한 신경과학-인공지능 융합 연구이다.

성능, 효율, 속도의 균형적 설계와 같은 다양한 공학적 난제를 해결할 수 있는 신경과학 기반 강화학습 이론을 제안한 것으로 새로운 인공지능 알고리즘 설계에 긍정적인 영향을 줄 것으로 기대된다.

이상완 교수와 함께 이지항 박사, 안수진 박사과정이 주도한 이번 연구는 국제 학술지 사이언스의 자매지 ‘사이언스 로보틱스(Science Robotics)’ 1월 16일 자 온라인판에 포커스 형식으로 게재됐다.

최적제어 이론에서 출발한 강화학습은 기계 학습의 한 영역으로 지난 20여 년 동안 꾸준히 연구된 분야이다. 특히 지난 5년 동안은 딥러닝 기술을 발전과 맞물려 급격한 성장을 이뤘다.

딥러닝 기반 강화학습 알고리즘은 최근 알파고와 같은 전략 탐색 문제, 로봇 제어, 응급실 비상 대응 시스템과 같은 의료 진단 등 다양한 분야에 적용되고 있다. 그러나 주어진 문제에 맞게 시스템을 설계해야 하는 점, 불확실성이 높은 환경에서는 성능이 보장되지 않는 점 등이 근본적인 해결책으로 남아있다.

강화학습은 의사 결정 및 계산신경과학 분야에서도 지난 20년간 꾸준히 연구되고 있다. 이상완 교수는 2014년 인간의 전두엽-기저핵 뇌 회로에서 이종 강화학습을 제어한다는 신경과학적 증거를 학계에 발표한 바 있다. 2015년에는 같은 뇌 회로에서 고속 추론 과정을 제어한다는 연구를 발표했다.

연구팀은 이번 연구에서 강화학습 등의 개별 인공지능 알고리즘이 해결하지 못하는 공학적 문제를 인간의 두뇌가 이미 해결하고 있다는 사실에 기반한 ‘전두엽 메타 제어’ 이론을 제안했다.

중뇌 도파민-복외측전전두피질 네트워크에서 외부 환경에 대한 학습의 신뢰도를 스스로 평가할 수 있는 보상 예측 신호나 상태 예측 신호와 같은 정보를 처리하며, 인간의 두뇌는 이 정보들을 경쟁적-협력적으로 통합하는 프로세스를 통해 외부 환경에 가장 적합한 학습 및 추론 전략을 찾는다는 것이 이론의 핵심이다.

이러한 원리를 단일 인공지능 알고리즘이나 로봇설계에 적용하면 외부 상황변화에 강인하게 성능, 효율, 속도 세 조건(performance-efficiency-speed tradeoff) 사이의 균형점을 유지하는 최적의 제어 시스템을 설계할 수 있다. 더 나아가 다수의 인공지능 개체가 협력하는 상황에서는 서로의 전략을 이용함으로 협력-경쟁 사이의 균형점을 유지할 수 있다.

1 저자인 이지항 박사는 “현대 인공지능의 우수한 성능은 사람의 행동 수준 관찰뿐 아니라 두뇌의 저수준 신경 시스템을 알고리즘으로 구현해 적극적으로 발전시킨 결과라고 보고 있다”라며 “이번 연구는 계산신경과학에 기반한 결과로 현대 딥러닝과 강화학습에서 겪는 성능, 효율, 속도 사이의 난제를 해결하는 실마리가 될 수 있고, 새로운 인공지능 알고리즘 설계에 많은 영감을 줄 것이다”라고 말했다.

이상완 교수는 “연구를 하다 보면 우리의 두뇌는 공학적 난제를 의외로 쉽게 해결하고 있음을 알 수 있다. 이 원리를 인공지능 알고리즘 설계에 적용하는 뇌 기반 인공지능 연구는 구글 딥마인드, MIT, 캘리포니아 공과대학, UCL 등 해외 유수 기관에서도 관심을 두는 신경과학-인공지능 융합 연구 분야이다”라며 “장기적으로는 차세대 인공지능 핵심 연구 분야 중의 하나로 자리를 잡을 것으로 기대한다”라고 말했다.

이번 연구는 과학기술정보통신부 및 정보통신기술진흥센터 연구개발 사업, 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 외부 환경에 따라 성능-효율-속도 문제 균형점을 찾는 뇌기반 강화학습 이론 (좌), 이를 최적 제어하는 ‘전두엽 메타 제어’(중) 및 로보틱스 분야 문제 해결 적용 사례 (우)

2019.01.24 조회수 13539 -

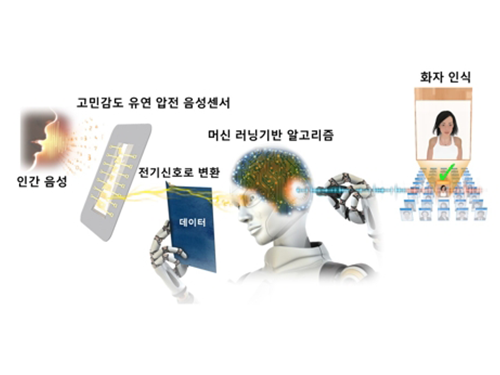

이건재 교수, 유창동 교수, 유연 압전 화자인식 음성센서 개발

〈 이 건 재 교수 〉

우리 대학 신소재공학과 이건재 교수와 전기및전자공학부 유창동 교수 공동 연구팀이 인공지능 기반의 화자(話者) 인식용 유연 압전 음성센서를 개발했다.

이번 연구를 통해 개인별 음성 서비스를 스마트 홈 가전이나 인공지능 비서, 생체 인증 분야 등 차세대 기술에 활용 가능할 것으로 기대된다.

이번 연구 결과는 국제 학술지 ‘나노 에너지(Nano Energy)’ 9월호에 ‘민감도’와 ‘화자인식’ 논문 두 편으로 동시 게재됐고 현재 관련 기술은 실용화 단계에 있다. (민감도 논문 : Basilar Membrane-Inspired Self-Powered Acoustic Sensor Enabled by Highly Sensitive Multi Tunable Frequency Band, 화자인식 논문 : Machine Learning-based Self-powered Acoustic Sensor for Speaker Recognition)

음성 센서는 인간과 기계 사이의 자유로운 소통을 가능하게 만드는 가장 직관적인 수단으로 4차 산업혁명의 핵심 기술로 주목받고 있다. 음성센서 시장은 2021년 대략 160억 달러 규모로 커질 것으로 예상된다.

그러나 현재 산업계에서는 음성 신호 수신 시 정전용량을 측정하는 콘덴서 형식을 사용하기 때문에 민감도가 낮고 인식 거리가 짧아 화자 인식률에 한계가 있다.

이번 연구에서 이 교수 연구팀은 인간의 달팽이관을 모사해 주파수에 따라 다른 영역이 진동하는 사다리꼴의 얇은 막을 제작했다. 음성신호에 따른 공진형 진동을 유연 압전 물질을 통해 감지하는 자가발전 고민감 음성 센서를 개발했다.

연구팀의 음성 센서는 기존 기술 대비 2배 이상 높은 민감도를 가져 미세한 음성 신호를 원거리에서도 감지할 수 있다. 또한 다채널로 신호를 받아들여 하나의 언어에 대해 복수 개의 데이터를 얻을 수 있다.

이 기술을 기반으로 누가 이야기하는지 찾아내는 화자인식 시스템에 적용해 97.5%의 화자인식 성공률을 무향실에서 달성했고 기존 기술 대비 오류를 75% 이상 줄였다.

화자인식 서비스는 음성 분야에 세상을 바꿀 next big thing으로 기대를 받고 있다. 기존 기술은 소프트웨어 업그레이드를 통한 접근으로 인식률에 한계가 있었지만 연구팀의 기술은 하드웨어 센서를 개발함으로써 능력을 크게 향상시켰다. 추후 첨단 소프트웨어를 접목한다면 다양한 환경에서도 화자 및 음성 인식률을 높일 수 있을 것으로 예상된다.

이건재 교수는 “이번에 개발한 머신 러닝 기반 고민감 유연 압전 음성센서는 화자를 정확하게 구별할 수 있기 때문에 개인별 음성 서비스를 스마트 가전이나 인공지능 비서에 접목할 수 있을 것이며 생체 인증 및 핀테크와 같은 보안 분야에서도 큰 역할을 할 수 있을 것이다”고 말했다.

이번 연구는 스마트 IT 융합시스템 연구단의 지원을 받아 수행됐다.

<관련 영상>

https://www.youtube.com/watch?v=QGEVJxCFVpc&feature=youtu.be

□ 그림 설명

그림1. 인간의 달팽이관을 모사한 유연 압전 음성 센서 구조

그림2. 인공지능을 통한 화자 인식 개략도

2018.10.04 조회수 14337

이건재 교수, 유창동 교수, 유연 압전 화자인식 음성센서 개발

〈 이 건 재 교수 〉

우리 대학 신소재공학과 이건재 교수와 전기및전자공학부 유창동 교수 공동 연구팀이 인공지능 기반의 화자(話者) 인식용 유연 압전 음성센서를 개발했다.

이번 연구를 통해 개인별 음성 서비스를 스마트 홈 가전이나 인공지능 비서, 생체 인증 분야 등 차세대 기술에 활용 가능할 것으로 기대된다.

이번 연구 결과는 국제 학술지 ‘나노 에너지(Nano Energy)’ 9월호에 ‘민감도’와 ‘화자인식’ 논문 두 편으로 동시 게재됐고 현재 관련 기술은 실용화 단계에 있다. (민감도 논문 : Basilar Membrane-Inspired Self-Powered Acoustic Sensor Enabled by Highly Sensitive Multi Tunable Frequency Band, 화자인식 논문 : Machine Learning-based Self-powered Acoustic Sensor for Speaker Recognition)

음성 센서는 인간과 기계 사이의 자유로운 소통을 가능하게 만드는 가장 직관적인 수단으로 4차 산업혁명의 핵심 기술로 주목받고 있다. 음성센서 시장은 2021년 대략 160억 달러 규모로 커질 것으로 예상된다.

그러나 현재 산업계에서는 음성 신호 수신 시 정전용량을 측정하는 콘덴서 형식을 사용하기 때문에 민감도가 낮고 인식 거리가 짧아 화자 인식률에 한계가 있다.

이번 연구에서 이 교수 연구팀은 인간의 달팽이관을 모사해 주파수에 따라 다른 영역이 진동하는 사다리꼴의 얇은 막을 제작했다. 음성신호에 따른 공진형 진동을 유연 압전 물질을 통해 감지하는 자가발전 고민감 음성 센서를 개발했다.

연구팀의 음성 센서는 기존 기술 대비 2배 이상 높은 민감도를 가져 미세한 음성 신호를 원거리에서도 감지할 수 있다. 또한 다채널로 신호를 받아들여 하나의 언어에 대해 복수 개의 데이터를 얻을 수 있다.

이 기술을 기반으로 누가 이야기하는지 찾아내는 화자인식 시스템에 적용해 97.5%의 화자인식 성공률을 무향실에서 달성했고 기존 기술 대비 오류를 75% 이상 줄였다.

화자인식 서비스는 음성 분야에 세상을 바꿀 next big thing으로 기대를 받고 있다. 기존 기술은 소프트웨어 업그레이드를 통한 접근으로 인식률에 한계가 있었지만 연구팀의 기술은 하드웨어 센서를 개발함으로써 능력을 크게 향상시켰다. 추후 첨단 소프트웨어를 접목한다면 다양한 환경에서도 화자 및 음성 인식률을 높일 수 있을 것으로 예상된다.

이건재 교수는 “이번에 개발한 머신 러닝 기반 고민감 유연 압전 음성센서는 화자를 정확하게 구별할 수 있기 때문에 개인별 음성 서비스를 스마트 가전이나 인공지능 비서에 접목할 수 있을 것이며 생체 인증 및 핀테크와 같은 보안 분야에서도 큰 역할을 할 수 있을 것이다”고 말했다.

이번 연구는 스마트 IT 융합시스템 연구단의 지원을 받아 수행됐다.

<관련 영상>

https://www.youtube.com/watch?v=QGEVJxCFVpc&feature=youtu.be

□ 그림 설명

그림1. 인간의 달팽이관을 모사한 유연 압전 음성 센서 구조

그림2. 인공지능을 통한 화자 인식 개략도

2018.10.04 조회수 14337 -

예종철 교수, 인공지능 블랙박스의 원리 밝혀

〈 예종철 교수, 한요섭 연구원, 차은주 연구원 〉

우리 대학 바이오및뇌공학과 예종철 석좌교수 연구팀이 인공지능의 기하학적인 구조를 규명하고 이를 통해 의료영상 및 정밀분야에 활용 가능한 고성능 인공신경망 제작의 수학적인 원리를 밝혔다.

연구팀의 ‘심층 합성곱 프레임렛(Deep Convolutional Framelets)’이라는 새로운 조화분석학적 기술은 인공지능의 블랙박스로 알려진 심층 신경망의 수학적 원리를 밝혀 기존 심층 신경망 구조의 단점을 보완하고 이를 다양하게 응용 가능할 것으로 기대된다.

예종철 석좌교수가 주도하고 한요섭, 차은주 박사과정이 참여한 이번 연구는 응용수학 분야 국제 학술지 ‘사이암 저널 온 이매징 사이언스(SIAM Journal on Imaging Sciences)’ 4월 26일자 온라인 판에 게재됐다.

심층신경망은 최근 폭발적으로 성장하는 인공지능의 핵심을 이루는 딥 러닝의 대표적인 구현 방법이다. 이를 이용한 영상, 음성 인식 및 영상처리 기법, 바둑, 체스 등은 이미 사람의 능력을 뛰어넘고 있으며 현재 4차 산업혁명의 핵심기술로 알려져 있다.

그러나 이러한 심층신경망은 그 뛰어난 성능에도 불구하고 정확한 동작원리가 밝혀지지 않아 예상하지 못한 결과가 나오거나 오류가 발생하는 문제가 있다. 이로 인해 ‘설명 가능한 인공지능(explainable AI: XAI)’에 대한 사회적, 기술적 요구가 커지고 있다.

연구팀은 심층신경망의 구조가 얻어지는 고차원 공간에서의 기하학적 구조를 찾기 위해 노력했다. 그 결과 기존의 신호처리 분야에서 집중 연구된 고차원 구조인 행켈구조 행렬(Hankel matrix)을 기저함수로 분해하는 과정에서 심층신경망 구조가 나오는 것을 발견했다.

행켈 행렬이 분해되는 과정에서 기저함수는 국지기저함수(local basis)와 광역기저함수(non-local basis)로 나눠진다. 연구팀은 광역기저함수와 국지기저함수가 각각 인공지능의 풀링(pooling)과 필터링(filtering) 역할을 한다는 것을 밝혔다.

기존에는 인공지능을 구현하기 위한 심층신경망을 구성할 때 구체적인 작동 원리를 모른 채 실험적으로 구현했다면, 연구팀은 신호를 효과적으로 나타내는 고차원 공간인 행켈 행렬를 찾고 이를 분리하는 방식을 통해 필터링, 풀링 구조를 얻는 이론적인 구조를 제시한 것이다.

이러한 성질을 이용하면 입력신호의 복잡성에 따라 기저함수의 개수와 심층신경망의 깊이를 정해 원하는 심층신경망의 구조를 제시할 수 있다.

연구팀은 수학적 원리를 통해 제안된 인공신경망 구조를 영상잡음제거, 영상 화소복원 및 의료영상 복원 문제에 적용했고 매우 우수한 성능을 보임을 확인했다.

예종철 교수는 “시행착오를 반복해 설계하는 기존의 심층신경망과는 달리 원하는 응용에 따라 최적화된 심층신경망구조를 수학적 원리로 디자인하고 그 영향을 예측할 수 있다”며 “이 결과를 통해 의료 영상 등 설명 가능한 인공지능이 필요한 다양한 분야에 응용될 수 있다”고 말했다.

이번 연구는 과학기술정보통신부의 중견연구자지원사업(도약연구) 및 뇌과학원천기술사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 수학적인 원리를 이용한 심층신경망의 설계 예시

그림2. 영상잡음제거 결과

그림3. 영상에서 80% 화소가 사라진 경우 인공신경망을 통해 복원한 결과

2018.05.10 조회수 22298

예종철 교수, 인공지능 블랙박스의 원리 밝혀

〈 예종철 교수, 한요섭 연구원, 차은주 연구원 〉

우리 대학 바이오및뇌공학과 예종철 석좌교수 연구팀이 인공지능의 기하학적인 구조를 규명하고 이를 통해 의료영상 및 정밀분야에 활용 가능한 고성능 인공신경망 제작의 수학적인 원리를 밝혔다.

연구팀의 ‘심층 합성곱 프레임렛(Deep Convolutional Framelets)’이라는 새로운 조화분석학적 기술은 인공지능의 블랙박스로 알려진 심층 신경망의 수학적 원리를 밝혀 기존 심층 신경망 구조의 단점을 보완하고 이를 다양하게 응용 가능할 것으로 기대된다.

예종철 석좌교수가 주도하고 한요섭, 차은주 박사과정이 참여한 이번 연구는 응용수학 분야 국제 학술지 ‘사이암 저널 온 이매징 사이언스(SIAM Journal on Imaging Sciences)’ 4월 26일자 온라인 판에 게재됐다.

심층신경망은 최근 폭발적으로 성장하는 인공지능의 핵심을 이루는 딥 러닝의 대표적인 구현 방법이다. 이를 이용한 영상, 음성 인식 및 영상처리 기법, 바둑, 체스 등은 이미 사람의 능력을 뛰어넘고 있으며 현재 4차 산업혁명의 핵심기술로 알려져 있다.

그러나 이러한 심층신경망은 그 뛰어난 성능에도 불구하고 정확한 동작원리가 밝혀지지 않아 예상하지 못한 결과가 나오거나 오류가 발생하는 문제가 있다. 이로 인해 ‘설명 가능한 인공지능(explainable AI: XAI)’에 대한 사회적, 기술적 요구가 커지고 있다.

연구팀은 심층신경망의 구조가 얻어지는 고차원 공간에서의 기하학적 구조를 찾기 위해 노력했다. 그 결과 기존의 신호처리 분야에서 집중 연구된 고차원 구조인 행켈구조 행렬(Hankel matrix)을 기저함수로 분해하는 과정에서 심층신경망 구조가 나오는 것을 발견했다.

행켈 행렬이 분해되는 과정에서 기저함수는 국지기저함수(local basis)와 광역기저함수(non-local basis)로 나눠진다. 연구팀은 광역기저함수와 국지기저함수가 각각 인공지능의 풀링(pooling)과 필터링(filtering) 역할을 한다는 것을 밝혔다.

기존에는 인공지능을 구현하기 위한 심층신경망을 구성할 때 구체적인 작동 원리를 모른 채 실험적으로 구현했다면, 연구팀은 신호를 효과적으로 나타내는 고차원 공간인 행켈 행렬를 찾고 이를 분리하는 방식을 통해 필터링, 풀링 구조를 얻는 이론적인 구조를 제시한 것이다.

이러한 성질을 이용하면 입력신호의 복잡성에 따라 기저함수의 개수와 심층신경망의 깊이를 정해 원하는 심층신경망의 구조를 제시할 수 있다.

연구팀은 수학적 원리를 통해 제안된 인공신경망 구조를 영상잡음제거, 영상 화소복원 및 의료영상 복원 문제에 적용했고 매우 우수한 성능을 보임을 확인했다.

예종철 교수는 “시행착오를 반복해 설계하는 기존의 심층신경망과는 달리 원하는 응용에 따라 최적화된 심층신경망구조를 수학적 원리로 디자인하고 그 영향을 예측할 수 있다”며 “이 결과를 통해 의료 영상 등 설명 가능한 인공지능이 필요한 다양한 분야에 응용될 수 있다”고 말했다.

이번 연구는 과학기술정보통신부의 중견연구자지원사업(도약연구) 및 뇌과학원천기술사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 수학적인 원리를 이용한 심층신경망의 설계 예시

그림2. 영상잡음제거 결과

그림3. 영상에서 80% 화소가 사라진 경우 인공신경망을 통해 복원한 결과

2018.05.10 조회수 22298 -

이상엽, 김현욱 교수, 약물 상호작용 예측기술 DeepDDI 개발

우리 대학 생명화학공학과 이상엽 특훈교수와 김현욱 교수 공동 연구팀이 약물-약물 및 약물-음식 간 상호작용을 정확하게 예측하기 위해 딥 러닝(deep learning)을 이용해 약물 상호작용 예측 방법론인 딥디디아이 (DeepDDI)를 개발했다.

김현욱 교수, 류재용 연구원이 공동 1저자로 참여한 이번 연구는 국제학술지 ‘미국 국립과학원 회보(PNAS)’ 4월 16일자 온라인판에 게재됐다.

기존의 약물 상호작용 예측 방법론은 약물-약물 간의 상호작용 가능성만을 예측할 뿐, 두 약물 간의 구체적인 약리작용에 대한 정보는 제공하지 못했다. 이러한 이유로 맞춤형 약물 처방, 식이요법 등 응용 연구에서 체계적인 근거를 제시하거나 가설을 세우는 데에 한계가 있었다.

연구팀은 딥 러닝(deep learning) 기술을 적용해 19만 2천 284개의 약물-약물 상호작용을 아우르는 86가지의 약물 상호작용을 92.4%의 정확도로 예측하는 시스템 딥디디아이 (DeepDDI)를 개발했다.

딥디디아이는 두 약물 A, B 간의 상호작용에 대한 예측 결과를 다음과 같이 사람이 읽을 수 있는 영문 문장으로 출력한다 : “The metabolism of Drug B can be decreased when combined with Drug A (약물 A를 약물 B와 함께 복용 시 약물 B의 약물 대사가 감소 될 수 있다)”

연구팀은 딥디디아이를 이용해 두 약물 복용 시 일어날 수 있는 유해반응의 원인, 보고된 인체 부작용을 최소화시킬 수 있는 대체 약물, 특정 약물의 약효를 떨어뜨릴 수 있는 음식 및 음식 성분, 지금껏 알려지지 않은 음식 성분의 활성 등을 예측했다.

이번 연구성과로 약물-약물 및 약물-음식 상호작용을 정확하게 예측할 수 있는 시스템을 활용하는 것이 가능해졌으며 이는 신약개발, 복합적 약의 처방, 투약시의 음식조절 등을 포함해 헬스케어, 정밀의료 산업 및 제약 산업에 중요한 역할을 할 것으로 기대된다.

이상엽 특훈교수는 “이번 연구결과는 4차 산업혁명 시대의 정밀의료를 선도할 수 있는 기반 기술을 개발한 것이다”며, “복합 투여되는 약물들의 부작용을 낮추고 환자 맞춤형 약물 처방과 식이요법 제안을 통한 효과적인 약물치료 전략을 수립할 수 있다. 특히 고령화 사회에서 건강한 삶을 유지하는데 필요한 약-음식 궁합에 대한 제안을 해 줄 수 있는 시스템으로 발전해 나갈 것이다”고 말했다.

이 연구성과는 과학기술정보통신부의 바이오리파이너리를 위한 시스템대사공학 연구사업, KAIST의 4차 산업혁명 인공지능 플래그십 이니셔티브 연구사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 딥디디아이 (DeepDDI)의 모식도 및 예측된다양한 약물-음식성분의 상호작용들의 시각화

2018.04.18 조회수 21254

이상엽, 김현욱 교수, 약물 상호작용 예측기술 DeepDDI 개발

우리 대학 생명화학공학과 이상엽 특훈교수와 김현욱 교수 공동 연구팀이 약물-약물 및 약물-음식 간 상호작용을 정확하게 예측하기 위해 딥 러닝(deep learning)을 이용해 약물 상호작용 예측 방법론인 딥디디아이 (DeepDDI)를 개발했다.

김현욱 교수, 류재용 연구원이 공동 1저자로 참여한 이번 연구는 국제학술지 ‘미국 국립과학원 회보(PNAS)’ 4월 16일자 온라인판에 게재됐다.

기존의 약물 상호작용 예측 방법론은 약물-약물 간의 상호작용 가능성만을 예측할 뿐, 두 약물 간의 구체적인 약리작용에 대한 정보는 제공하지 못했다. 이러한 이유로 맞춤형 약물 처방, 식이요법 등 응용 연구에서 체계적인 근거를 제시하거나 가설을 세우는 데에 한계가 있었다.

연구팀은 딥 러닝(deep learning) 기술을 적용해 19만 2천 284개의 약물-약물 상호작용을 아우르는 86가지의 약물 상호작용을 92.4%의 정확도로 예측하는 시스템 딥디디아이 (DeepDDI)를 개발했다.

딥디디아이는 두 약물 A, B 간의 상호작용에 대한 예측 결과를 다음과 같이 사람이 읽을 수 있는 영문 문장으로 출력한다 : “The metabolism of Drug B can be decreased when combined with Drug A (약물 A를 약물 B와 함께 복용 시 약물 B의 약물 대사가 감소 될 수 있다)”

연구팀은 딥디디아이를 이용해 두 약물 복용 시 일어날 수 있는 유해반응의 원인, 보고된 인체 부작용을 최소화시킬 수 있는 대체 약물, 특정 약물의 약효를 떨어뜨릴 수 있는 음식 및 음식 성분, 지금껏 알려지지 않은 음식 성분의 활성 등을 예측했다.

이번 연구성과로 약물-약물 및 약물-음식 상호작용을 정확하게 예측할 수 있는 시스템을 활용하는 것이 가능해졌으며 이는 신약개발, 복합적 약의 처방, 투약시의 음식조절 등을 포함해 헬스케어, 정밀의료 산업 및 제약 산업에 중요한 역할을 할 것으로 기대된다.

이상엽 특훈교수는 “이번 연구결과는 4차 산업혁명 시대의 정밀의료를 선도할 수 있는 기반 기술을 개발한 것이다”며, “복합 투여되는 약물들의 부작용을 낮추고 환자 맞춤형 약물 처방과 식이요법 제안을 통한 효과적인 약물치료 전략을 수립할 수 있다. 특히 고령화 사회에서 건강한 삶을 유지하는데 필요한 약-음식 궁합에 대한 제안을 해 줄 수 있는 시스템으로 발전해 나갈 것이다”고 말했다.

이 연구성과는 과학기술정보통신부의 바이오리파이너리를 위한 시스템대사공학 연구사업, KAIST의 4차 산업혁명 인공지능 플래그십 이니셔티브 연구사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 딥디디아이 (DeepDDI)의 모식도 및 예측된다양한 약물-음식성분의 상호작용들의 시각화

2018.04.18 조회수 21254 -

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 21792

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 21792 -

박현욱 교수, 머신러닝 통해 MRI 영상촬영시간 단축기술 개발

우리 대학 전기및전자공학부 박현욱 교수 연구팀이 머신러닝 기반의 영상복원법을 이용해 자기공명영상장치(이하 MRI)의 영상 획득시간을 6배 이상 단축시킬 수 있는 기술을 개발했다.

이번 연구를 통해 MRI의 영상획득시간을 대폭 줄임으로써 환자의 편의성을 높일 뿐 아니라 의료비용 절감 효과를 기대할 수 있을 것으로 보인다.

권기남 박사과정이 1저자로 참여한 이번 연구는 국제 학술지 ‘메디컬 피직스(Medical Physics)’ 12월 13일자에 게재됐고 그 우수성을 인정받아 표지 논문에 선정됐다.

MRI는 방사능 없이 연조직의 다양한 대조도를 촬영할 수 있는 영상기기이다. 다양한 해부학적 구조 뿐 아니라 기능적, 생리학적 정보 또한 영상화 할 수 있기 때문에 의료 진단을 위해 매우 높은 빈도로 사용되고 있다.

하지만 MRI는 다른 의료영상기기에 비해 영상획득시간이 오래 걸린다는 단점이 있다. 따라서 환자들은 MRI를 찍기 위해 긴 시간을 대기해야 하고 촬영 과정에서도 자세를 움직이지 않아야 하는 등의 불편함을 감수해야 한다.

특히 길게 소요되는 영상획득시간은 MRI의 비싼 촬영 비용과 직접적인 연관이 있다.

박 교수 연구팀은 MRI의 영상획득시간을 줄이기 위해 데이터를 적게 수집하고 대신 부족한 데이터를 기계학습(Machine Learning)을 이용해 복원하는 방법을 개발했다.

기존의 MRI는 주파수 영역에서 여러 위상 인코딩을 하면서 순차적으로 한 줄씩 얻기 때문에 영상획득시간이 오래 걸린다. 획득 시간을 단축시키기 위해 저주파 영역에서만 데이터를 얻으면 저해상도 영상을 얻게 되고 듬성듬성 데이터를 얻으면 영상에서 인공물이 생기는 에일리어싱 아티팩트 현상이 발생한다.

이러한 에일리어싱 아티팩트를 해결하기 위해 다른 민감도를 갖는 여러 수신 코일을 활용한 병렬 영상법과 신호의 희소성을 이용한 압축 센싱 기법이 주로 활용됐다.

그러나 병렬 영상법은 수신 코일들의 설계에 영향을 받기 때문에 시간을 많이 단축할 수 없고 영상 복원에도 시간이 많이 걸린다.

연구팀은 MRI의 가속화에 의해 발생하는 에일리어싱 아티팩트 현상을 없애기 위해 라인 전체를 고려한 인공 신경망(Deep Neural Networks)을 개발했다.

연구팀은 위 기술과 함께 기존 병렬 영상법에서 이용했던 복수 수신 코일의 정보를 활용했고, 이 방식을 통해 직접적으로 영향을 주는 부분만을 연결해 네트워크의 효율성을 높였다.

기존 방법들의 경우 서브 샘플링 패턴에 많은 영향을 받았지만 박 교수 연구팀의 기술은 다양한 서브샘플링 패턴에 적용 가능하며 기존 방법대비 복원 영상의 우수함을 보였고 실시간 복원 또한 가능하다.

박 교수는 “MRI는 환자 진단에 필요한 필수 장비가 됐지만 영상 획득 시간이 오래 걸려 비용이 비싸고 불편함이 많았다”며 “기계학습을 활용한 방법이 MRI의 영상 획득 시간을 크게 단축할 것으로 기대한다”고 말했다.

이번 연구는 과학기술정보통신부의 인공지능 국가전략프로젝트와 뇌과학원천기술개발사업의 지원을 받아 수행됐다.

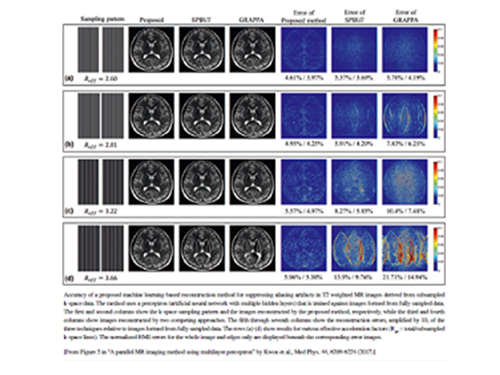

□ 그림 설명

그림1. 국제 학술지 ‘메디컬 피직스 (Medical Physics)’12월호 표지

그림2. 제안하는 네트워크의 모식도

그림3. MRI의 일반적인 영상 획득 및 가속 영상 획득 모식도

2017.12.29 조회수 22512

박현욱 교수, 머신러닝 통해 MRI 영상촬영시간 단축기술 개발

우리 대학 전기및전자공학부 박현욱 교수 연구팀이 머신러닝 기반의 영상복원법을 이용해 자기공명영상장치(이하 MRI)의 영상 획득시간을 6배 이상 단축시킬 수 있는 기술을 개발했다.

이번 연구를 통해 MRI의 영상획득시간을 대폭 줄임으로써 환자의 편의성을 높일 뿐 아니라 의료비용 절감 효과를 기대할 수 있을 것으로 보인다.

권기남 박사과정이 1저자로 참여한 이번 연구는 국제 학술지 ‘메디컬 피직스(Medical Physics)’ 12월 13일자에 게재됐고 그 우수성을 인정받아 표지 논문에 선정됐다.

MRI는 방사능 없이 연조직의 다양한 대조도를 촬영할 수 있는 영상기기이다. 다양한 해부학적 구조 뿐 아니라 기능적, 생리학적 정보 또한 영상화 할 수 있기 때문에 의료 진단을 위해 매우 높은 빈도로 사용되고 있다.

하지만 MRI는 다른 의료영상기기에 비해 영상획득시간이 오래 걸린다는 단점이 있다. 따라서 환자들은 MRI를 찍기 위해 긴 시간을 대기해야 하고 촬영 과정에서도 자세를 움직이지 않아야 하는 등의 불편함을 감수해야 한다.

특히 길게 소요되는 영상획득시간은 MRI의 비싼 촬영 비용과 직접적인 연관이 있다.

박 교수 연구팀은 MRI의 영상획득시간을 줄이기 위해 데이터를 적게 수집하고 대신 부족한 데이터를 기계학습(Machine Learning)을 이용해 복원하는 방법을 개발했다.

기존의 MRI는 주파수 영역에서 여러 위상 인코딩을 하면서 순차적으로 한 줄씩 얻기 때문에 영상획득시간이 오래 걸린다. 획득 시간을 단축시키기 위해 저주파 영역에서만 데이터를 얻으면 저해상도 영상을 얻게 되고 듬성듬성 데이터를 얻으면 영상에서 인공물이 생기는 에일리어싱 아티팩트 현상이 발생한다.

이러한 에일리어싱 아티팩트를 해결하기 위해 다른 민감도를 갖는 여러 수신 코일을 활용한 병렬 영상법과 신호의 희소성을 이용한 압축 센싱 기법이 주로 활용됐다.

그러나 병렬 영상법은 수신 코일들의 설계에 영향을 받기 때문에 시간을 많이 단축할 수 없고 영상 복원에도 시간이 많이 걸린다.

연구팀은 MRI의 가속화에 의해 발생하는 에일리어싱 아티팩트 현상을 없애기 위해 라인 전체를 고려한 인공 신경망(Deep Neural Networks)을 개발했다.

연구팀은 위 기술과 함께 기존 병렬 영상법에서 이용했던 복수 수신 코일의 정보를 활용했고, 이 방식을 통해 직접적으로 영향을 주는 부분만을 연결해 네트워크의 효율성을 높였다.

기존 방법들의 경우 서브 샘플링 패턴에 많은 영향을 받았지만 박 교수 연구팀의 기술은 다양한 서브샘플링 패턴에 적용 가능하며 기존 방법대비 복원 영상의 우수함을 보였고 실시간 복원 또한 가능하다.

박 교수는 “MRI는 환자 진단에 필요한 필수 장비가 됐지만 영상 획득 시간이 오래 걸려 비용이 비싸고 불편함이 많았다”며 “기계학습을 활용한 방법이 MRI의 영상 획득 시간을 크게 단축할 것으로 기대한다”고 말했다.

이번 연구는 과학기술정보통신부의 인공지능 국가전략프로젝트와 뇌과학원천기술개발사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 국제 학술지 ‘메디컬 피직스 (Medical Physics)’12월호 표지

그림2. 제안하는 네트워크의 모식도

그림3. MRI의 일반적인 영상 획득 및 가속 영상 획득 모식도

2017.12.29 조회수 22512 -

이동만 교수, 빅데이터로 SNS 분석해 맞춤형 장소 제공 기술 개발

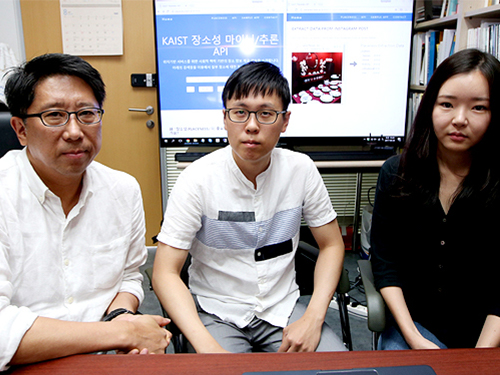

<좌측부터 전산학부 이동만 교수, 신병헌 박사과정 학생, 최인경 박사과정 학생>

전산학부 이동만 교수 연구팀이 소셜 네트워크 서비스(SNS)의 사진과 글을 기반으로 장소의 특성을 분석해 사용자에게 맞춤형 장소를 제공하는 기술을 개발했다. 이 기술은 현재의 위치기반 추천서비스를 인공지능형 개인비서서비스로 도약시키는 원천기술이 될 것으로 기대된다.

이번 연구는 기존 위치기반 장소 검색 및 추천서비스의 검색 수준을 향상시켜 사용자들이 장소를 선택하는 기준을 다양하게 적용시킬 수 있다. 사용자의 트렌드를 반영해 실시간으로 변화된 장소 추천을 할 수 있을 것으로 보인다. 문화기술대학원 이원재, 박주용 교수와 전산학과 차미영 교수가 공동으로 참여한 이번 연구의 API(응용 프로그래밍 인터페이스)는 http://placeness.kaist.ac.kr:8080/ 을 통해 공개됐고 관련 정보는 http://placeness.kaist.ac.kr/wiki/doku.php 에서 열람할 수 있다.

맛집 추천서비스, 소셜 커머스 등 위치를 기반으로 정보 검색 및 추천서비스를 제공하는 업체들은 주로 고객의 후기를 수집하거나 직접 방문을 통해 경험한 내용을 토대로 음식점 혹은 매장을 평가한다. 이는 비교적 정확한 정보를 제공하지만 시간적, 경제적 비용이 많이 소모된다. 또한 사용자 전체의 관심과 선택의 평균에 중점을 두기 때문에 사용자 개인의 특성을 충분히 고려하지 못한다는 한계가 있다. 시간이 지날수록 사용자는 평균 중심의 예상 가능한 선택지를 추천받을 확률이 높아진다.

따라서 같은 장소라도 사용자가 방문하고자 하는 목적이 다르기 때문에(모임, 상견례, 소개팅 등) 방문 목적과 사회적 맥락을 파악할 수 있는 추가적인 기능이 필수적이다. 이를 위해 기본적으로 제공되는 정보 외에도 실제 사람들이 각 장소에서 어떤 세부적 활동을 하며 공간을 소비했는지에 대한 데이터 수집이 필요하다. 연구팀은 문제 개선을 위해 특정 소셜 네트워크 서비스(인스타그램)에 올라온 사진과 텍스트 자료를 바탕으로 이를 분석하는 알고리즘을 개발했다.

기존에 존재하는 딥러닝 방식을 이용해 사진을 분석하는 기술과 연구팀이 새로 개발한 텍스트 분석 기술인 워드백(Wordbag) 기술을 결합했다. 특정 상황이나 분위기에 사용되는 단어들을 분석하고 단어마다 가중치를 둬 분류하는 기술이다. 연구팀은 API에서 주요 연구 이슈에 따라 크게 4개의 세부 분야별 정보를 제공한다. ▲상위 장소의 장소성(장소의 성격 : placeness), ▲상위 장소 내에 있는 세부 장소의 장소성 추론, ▲감성분석 기반의 장소 분위기 추론, ▲사용자와 장소성 간 연관성을 제공한다.

연구팀의 API는 SNS에 존재하는 연구개발 대상으로 지정된 특정 상위장소(코엑스. 아이파크 몰) 및 그 내부의 세부장소에 대해 언급된 데이터를 분석해 행위, 방문자, 시간, 분위기 등 다양한 관점에서 공간의 활용 가능성을 제공한다. 이는 같은 장소라도 사용자가 시간대, 목적에 따라 다르게 활용했던 이력이나 기존 서비스에서 제공이 어려웠던 분위기(ex. 밝은, 전통적인 등)나 방문 목적(ex. 데이트, 공부, 회의)을 데이터로 수집할 수 있기 때문에 사용자의 의도에 따라 장소를 추천할 수 있다.

이 교수는 “이 연구에서 개발된 API를 통해 기존의 위치기반 장소 검색 및 추천 서비스의 검색 수준을 향상시키고 방문자들의 트렌드 변화에 따라 자동으로 변화된 장소를 추천할 수 있다”고 말했다. 또한 “기존 비정형 텍스트 데이터 분석의 한계를 극복하기 위해 사진과 텍스트를 동시에 분석해 공간에 대한 사회적 정보를 추론할 수 있어 현재의 위치기반 추천 서비스가 인공지능형 개인비서서비스로 도약하는 핵심 기술이 될 것이다”고 말했다.

이번 연구는 과학기술정보통신부 디지털콘텐츠 원천기술개발사업의 지원을 받아 수행됐다.

2017.08.29 조회수 22120

이동만 교수, 빅데이터로 SNS 분석해 맞춤형 장소 제공 기술 개발

<좌측부터 전산학부 이동만 교수, 신병헌 박사과정 학생, 최인경 박사과정 학생>

전산학부 이동만 교수 연구팀이 소셜 네트워크 서비스(SNS)의 사진과 글을 기반으로 장소의 특성을 분석해 사용자에게 맞춤형 장소를 제공하는 기술을 개발했다. 이 기술은 현재의 위치기반 추천서비스를 인공지능형 개인비서서비스로 도약시키는 원천기술이 될 것으로 기대된다.

이번 연구는 기존 위치기반 장소 검색 및 추천서비스의 검색 수준을 향상시켜 사용자들이 장소를 선택하는 기준을 다양하게 적용시킬 수 있다. 사용자의 트렌드를 반영해 실시간으로 변화된 장소 추천을 할 수 있을 것으로 보인다. 문화기술대학원 이원재, 박주용 교수와 전산학과 차미영 교수가 공동으로 참여한 이번 연구의 API(응용 프로그래밍 인터페이스)는 http://placeness.kaist.ac.kr:8080/ 을 통해 공개됐고 관련 정보는 http://placeness.kaist.ac.kr/wiki/doku.php 에서 열람할 수 있다.

맛집 추천서비스, 소셜 커머스 등 위치를 기반으로 정보 검색 및 추천서비스를 제공하는 업체들은 주로 고객의 후기를 수집하거나 직접 방문을 통해 경험한 내용을 토대로 음식점 혹은 매장을 평가한다. 이는 비교적 정확한 정보를 제공하지만 시간적, 경제적 비용이 많이 소모된다. 또한 사용자 전체의 관심과 선택의 평균에 중점을 두기 때문에 사용자 개인의 특성을 충분히 고려하지 못한다는 한계가 있다. 시간이 지날수록 사용자는 평균 중심의 예상 가능한 선택지를 추천받을 확률이 높아진다.

따라서 같은 장소라도 사용자가 방문하고자 하는 목적이 다르기 때문에(모임, 상견례, 소개팅 등) 방문 목적과 사회적 맥락을 파악할 수 있는 추가적인 기능이 필수적이다. 이를 위해 기본적으로 제공되는 정보 외에도 실제 사람들이 각 장소에서 어떤 세부적 활동을 하며 공간을 소비했는지에 대한 데이터 수집이 필요하다. 연구팀은 문제 개선을 위해 특정 소셜 네트워크 서비스(인스타그램)에 올라온 사진과 텍스트 자료를 바탕으로 이를 분석하는 알고리즘을 개발했다.

기존에 존재하는 딥러닝 방식을 이용해 사진을 분석하는 기술과 연구팀이 새로 개발한 텍스트 분석 기술인 워드백(Wordbag) 기술을 결합했다. 특정 상황이나 분위기에 사용되는 단어들을 분석하고 단어마다 가중치를 둬 분류하는 기술이다. 연구팀은 API에서 주요 연구 이슈에 따라 크게 4개의 세부 분야별 정보를 제공한다. ▲상위 장소의 장소성(장소의 성격 : placeness), ▲상위 장소 내에 있는 세부 장소의 장소성 추론, ▲감성분석 기반의 장소 분위기 추론, ▲사용자와 장소성 간 연관성을 제공한다.

연구팀의 API는 SNS에 존재하는 연구개발 대상으로 지정된 특정 상위장소(코엑스. 아이파크 몰) 및 그 내부의 세부장소에 대해 언급된 데이터를 분석해 행위, 방문자, 시간, 분위기 등 다양한 관점에서 공간의 활용 가능성을 제공한다. 이는 같은 장소라도 사용자가 시간대, 목적에 따라 다르게 활용했던 이력이나 기존 서비스에서 제공이 어려웠던 분위기(ex. 밝은, 전통적인 등)나 방문 목적(ex. 데이트, 공부, 회의)을 데이터로 수집할 수 있기 때문에 사용자의 의도에 따라 장소를 추천할 수 있다.

이 교수는 “이 연구에서 개발된 API를 통해 기존의 위치기반 장소 검색 및 추천 서비스의 검색 수준을 향상시키고 방문자들의 트렌드 변화에 따라 자동으로 변화된 장소를 추천할 수 있다”고 말했다. 또한 “기존 비정형 텍스트 데이터 분석의 한계를 극복하기 위해 사진과 텍스트를 동시에 분석해 공간에 대한 사회적 정보를 추론할 수 있어 현재의 위치기반 추천 서비스가 인공지능형 개인비서서비스로 도약하는 핵심 기술이 될 것이다”고 말했다.

이번 연구는 과학기술정보통신부 디지털콘텐츠 원천기술개발사업의 지원을 받아 수행됐다.

2017.08.29 조회수 22120 -

유회준 교수, 인공지능 얼굴인식 시스템 K-EYE 개발

우리 대학 전기및전자공학과 유회준 교수 연구팀이 딥러닝 알고리즘을 세계 최소 전력으로 구현하는 인공지능 반도체 칩 CNNP를 개발했다. 그리고 이를 내장한 얼굴인식 시스템 K-Eye 시리즈를 개발했다.

연구팀이 개발한 K-Eye 시리즈는 웨어러블 디바이스와 동글 타입 2가지로 구성된다. 웨어러블 타입인 K-Eye는 블루투스로 스마트폰과 연동 가능하다.

봉경렬 박사과정이 주도하고 ㈜유엑스팩토리(대표 박준영)과 공동으로 개발한 이번 연구는 지난 2월 미국에서 열린 국제고체회로설계학회(ISSCC)에서 세계 최저전력 CNN칩으로 발표돼 주목을 받았다.

최근 글로벌 IT 기업들이 알파고를 비롯한 인공지능 관련 기술들을 경쟁적으로 발표하고 있다. 그러나 대부분은 소프트웨어 기술이라 속도가 느리고 모바일 환경에서는 구현이 어렵다는 한계가 있다.

따라서 이를 고속 및 저전력으로 구동하기 위해 인공지능 반도체 칩 개발이 필수적이다.

연구팀의 K-Eye 시리즈는 1mW 내외의 적은 전력만으로도 항상 얼굴 인식을 수행하는 상태를 유지하면서 사람의 얼굴을 먼저 알아보고 반응할 수 있다는 특징을 갖는다.

K-Eye의 핵심 기술인 얼웨이즈 온(Always-On) 이미지 센서와 CNNP라는 얼굴 인식 처리 칩이 있었기 때문에 위와 같은 세계 최저전력 기술이 가능했다.

첫 번째 칩인 얼웨이즈 온(Always-On) 이미지 센서는 얼굴이 있는지 없는지 스스로 판단할 수 있어 얼굴 인식이 될 때에만 작동하게 해 대기 전력을 대폭 낮출 수 있다.

얼굴 검출 이미지 센서는 아날로그 프로세싱으로 디지털 프로세싱을 제어해 센서 자체의 출력 소모를 줄였다. 픽셀과 결합된 아날로그 프로세서는 배경 부분과 얼굴 부분을 구분하는 역할을 하고 디지털 프로세서는 선택된 일부 영역에서만 얼굴 검출을 수행하면 돼 효율적인 작업이 가능하다.

두 번째 칩인 CNNP는 딥러닝을 회로, 구조, 알고리즘 전반에 도입하고 재해석을 진행해 최저 수준의 전력을 구현하는 역할을 했다.

특히 CNNP칩은 3가지의 핵심 기술을 사용했는데 ▲알파고 인공지능 알고리즘에서 사용하는 2차원 계산을 1차원 계산으로 바꿔 고속 저전력화 ▲분산형으로 배치된 칩 내 메모리가 가로방향 뿐 아니라 세로방향도 읽어낼 수 있는 특수 저전력 분산 메모리로의 설계 ▲1024개의 곱셈기와 덧셈기가 동시에 구동돼 막강한 계산력을 가지면서 외부 통신망을 거치지 않고 직접 계산 결과를 주고받을 수 있게 한 점이다.

CNNP는 97%의 인식률을 가지면서도 알파고에 사용된 GPU에 비해 5천분의 1정도의 낮은 전력인 0.6mW만을 소모한다.

K-Eye를 목에 건 사용자는 앞에서 다가오는 상대방의 얼굴이 화면에 떠오르면 미리 저장된 정보와 실시간으로 찍힌 사진을 비교해 상대방의 이름 등 정보를 자연스럽게 확인할 수 있다.

동글 타입인 K-EyeQ는 스마트폰에 장착해 이용할 수 있는데 사용자를 알아보고 반응하는 기능을 한다. 미리 기억시킨 사용자의 얼굴이 화면을 향하기만 하면 스마트폰 화면이 저절로 켜지면서 그와 관련된 정보를 제공한다.

또한 입력된 얼굴이 사진인지 실제 사람인지도 구분할 수 있어 사용자의 얼굴 대신 사진을 보여주면 스마트폰은 반응하지 않는다.

유 교수는 “인공지능 반도체 프로세서가 4차 산업혁명시대를 주도할 것으로 기대된다”며 “이번 인공지능 칩과 인식기의 개발로 인해 세계시장에서 한국이 인공지능 산업의 주도권을 갖길 기대한다”고 말했다.

□ 사진 설명.

사진1. K-EYE 사진

사진2. K-EYEQ 사진

사진3. CNNP 칩 사진

2017.06.14 조회수 19616

유회준 교수, 인공지능 얼굴인식 시스템 K-EYE 개발

우리 대학 전기및전자공학과 유회준 교수 연구팀이 딥러닝 알고리즘을 세계 최소 전력으로 구현하는 인공지능 반도체 칩 CNNP를 개발했다. 그리고 이를 내장한 얼굴인식 시스템 K-Eye 시리즈를 개발했다.

연구팀이 개발한 K-Eye 시리즈는 웨어러블 디바이스와 동글 타입 2가지로 구성된다. 웨어러블 타입인 K-Eye는 블루투스로 스마트폰과 연동 가능하다.

봉경렬 박사과정이 주도하고 ㈜유엑스팩토리(대표 박준영)과 공동으로 개발한 이번 연구는 지난 2월 미국에서 열린 국제고체회로설계학회(ISSCC)에서 세계 최저전력 CNN칩으로 발표돼 주목을 받았다.

최근 글로벌 IT 기업들이 알파고를 비롯한 인공지능 관련 기술들을 경쟁적으로 발표하고 있다. 그러나 대부분은 소프트웨어 기술이라 속도가 느리고 모바일 환경에서는 구현이 어렵다는 한계가 있다.

따라서 이를 고속 및 저전력으로 구동하기 위해 인공지능 반도체 칩 개발이 필수적이다.

연구팀의 K-Eye 시리즈는 1mW 내외의 적은 전력만으로도 항상 얼굴 인식을 수행하는 상태를 유지하면서 사람의 얼굴을 먼저 알아보고 반응할 수 있다는 특징을 갖는다.

K-Eye의 핵심 기술인 얼웨이즈 온(Always-On) 이미지 센서와 CNNP라는 얼굴 인식 처리 칩이 있었기 때문에 위와 같은 세계 최저전력 기술이 가능했다.

첫 번째 칩인 얼웨이즈 온(Always-On) 이미지 센서는 얼굴이 있는지 없는지 스스로 판단할 수 있어 얼굴 인식이 될 때에만 작동하게 해 대기 전력을 대폭 낮출 수 있다.

얼굴 검출 이미지 센서는 아날로그 프로세싱으로 디지털 프로세싱을 제어해 센서 자체의 출력 소모를 줄였다. 픽셀과 결합된 아날로그 프로세서는 배경 부분과 얼굴 부분을 구분하는 역할을 하고 디지털 프로세서는 선택된 일부 영역에서만 얼굴 검출을 수행하면 돼 효율적인 작업이 가능하다.

두 번째 칩인 CNNP는 딥러닝을 회로, 구조, 알고리즘 전반에 도입하고 재해석을 진행해 최저 수준의 전력을 구현하는 역할을 했다.

특히 CNNP칩은 3가지의 핵심 기술을 사용했는데 ▲알파고 인공지능 알고리즘에서 사용하는 2차원 계산을 1차원 계산으로 바꿔 고속 저전력화 ▲분산형으로 배치된 칩 내 메모리가 가로방향 뿐 아니라 세로방향도 읽어낼 수 있는 특수 저전력 분산 메모리로의 설계 ▲1024개의 곱셈기와 덧셈기가 동시에 구동돼 막강한 계산력을 가지면서 외부 통신망을 거치지 않고 직접 계산 결과를 주고받을 수 있게 한 점이다.

CNNP는 97%의 인식률을 가지면서도 알파고에 사용된 GPU에 비해 5천분의 1정도의 낮은 전력인 0.6mW만을 소모한다.

K-Eye를 목에 건 사용자는 앞에서 다가오는 상대방의 얼굴이 화면에 떠오르면 미리 저장된 정보와 실시간으로 찍힌 사진을 비교해 상대방의 이름 등 정보를 자연스럽게 확인할 수 있다.

동글 타입인 K-EyeQ는 스마트폰에 장착해 이용할 수 있는데 사용자를 알아보고 반응하는 기능을 한다. 미리 기억시킨 사용자의 얼굴이 화면을 향하기만 하면 스마트폰 화면이 저절로 켜지면서 그와 관련된 정보를 제공한다.

또한 입력된 얼굴이 사진인지 실제 사람인지도 구분할 수 있어 사용자의 얼굴 대신 사진을 보여주면 스마트폰은 반응하지 않는다.

유 교수는 “인공지능 반도체 프로세서가 4차 산업혁명시대를 주도할 것으로 기대된다”며 “이번 인공지능 칩과 인식기의 개발로 인해 세계시장에서 한국이 인공지능 산업의 주도권을 갖길 기대한다”고 말했다.

□ 사진 설명.

사진1. K-EYE 사진

사진2. K-EYEQ 사진

사진3. CNNP 칩 사진

2017.06.14 조회수 19616 -

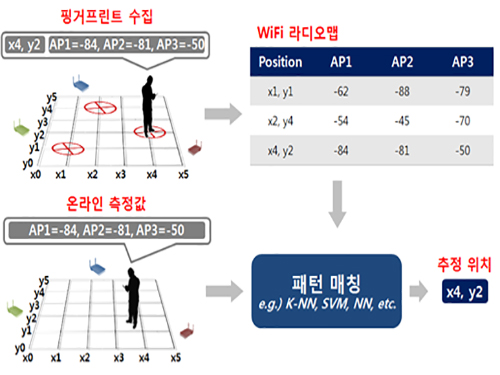

한동수 교수, 크라우드소싱 기반 실내 위치인식 시스템 개발

〈 한 동 수 교수 〉

우리 대학 전산학부 한동수 교수 연구팀(지능형 서비스통합 연구실)이 실내 공간에서 획득한 와이파이 신호의 수집 위치정보를 자동으로 파악할 수 있는 기술을 개발했다.

이 기술은 글로벌 실내 위치인식 시스템 구축에 필요한 핵심 기술로 다수의 스마트폰에서 수집된 무선랜 핑거프린트의 수집 위치를 자동으로 라벨링하는 인공지능 기법이다. 비용을 절감하면서 높은 정확도를 가질 수 있고 무선랜 핑거프린트 수집이 가능한 건물이라면 어느 곳에도 적용 가능하다.

여러 글로벌 기업들이 실내 GPS를 실현하기 위해 전 세계 주요도시에서 수만 건의 실내 지도를 수집했다. 실내 지도와 함께 신호 지도 수집도 시도했지만 높은 정확도를 갖지 못했고 그 결과 실내에서의 위치 인식 서비스 질이 떨어진다.

연구팀은 문제 해결을 위해 실내를 이동 공간과 체류 공간으로 구분하고 각각의 공간에 최적화된 수집 위치 라벨링을 자동화하는 기술을 개발했다.

연구팀이 개발한 기술은 복도, 로비, 계단과 같은 이동 공간에서도 수집된 신호의 위치정보를 별도의 외부 정도 없이도 자동으로 라벨링하는 새로운 자율학습(Unsupervised Learning) 인공지능 기술이다.

이 기술을 토대로 기초실험연구동(N5)과 김병호-김삼열IT융합빌딩(N1)에서 실험을 실시했고, 충분한 양의 학습 데이터가 주어진다는 가정 하에 오차범위 3~4미터 수준의 정확도를 보였다.

이는 수작업을 통해 수집 위치를 라벨링한 결과와 비슷한 정확도로 연구팀이 함께 개발한 지자기 신호, 3축 가속기, 자이로스코프 기반의 딥러닝을 활용한 새로운 센서 퓨전 기법을 통하면 정확도가 더욱 상승하는 결과를 보였다.

그 동안 스마트폰을 통해 수집된 핑거프린트는 활용되지 못하고 버려졌지만 개발된 기술을 통해 무선랜 핑거프린트 빅데이터 영역이 새롭게 열릴 것으로 기대된다.

개발된 GPS 구축 기술은 글로벌 기업이나 국내 위치정보 서비스 기업 등이 전국 범위에서 위치정보 서비스를 제공할 때 도입해 효과적으로 사용할 수 있을 것으로 예상된다.

GPS 신호가 도달하지 않는 실내 환경에서 위치인식 정확도가 높아짐에 따라 포켓몬고 등의 O2O(online to offline) 위치기반 게임도 실내에서 실행 가능할 것으로 기대된다.

또한 다양한 위치기반 SNS, 사물인터넷 등 서비스가 활성화되고 위급한 상황에서 112나 119에 구조요청을 할 시 정확한 위치 파악이 가능할 것으로 보인다.

한 교수는 “개발된 글로벌 실내 위치인식 시스템 구축 기술을 KAIST 실내 위치인식 시스템인 카이로스(KAILOS)에 탑재해 서비스 할 예정이다”며 “전 세계 어느 건물에서든 정확도 높은 실내 위치인식 시스템을 손쉽게 구축할 수 있고 장래에 대부분 실내 공간에서도 위치인식 서비스가 제공 가능할 것이다”고 말했다.

카이로스는 2014년 KAIST에서 출시한 개방형 실내 위치인식 서비스 플랫폼이다. 자신이 원하는 건물의 실내지도를 카이로스에 등록하고 해당 건물의 핑거프린트를 수집해 실내 위치인식 시스템을 구축하도록 지원 중이다.

□ 그림 설명

그림1. 핑거프린트를 수집하여 신호지도를 구축한 뒤, 구축된 신호지도를 기반으로 위치를 추정하는 과정

그림2. KAILOS가 여러 가지 신호와 센서를 복합적으로 사용하였을 때 예상되는 정확도

2017.04.12 조회수 19036

한동수 교수, 크라우드소싱 기반 실내 위치인식 시스템 개발

〈 한 동 수 교수 〉

우리 대학 전산학부 한동수 교수 연구팀(지능형 서비스통합 연구실)이 실내 공간에서 획득한 와이파이 신호의 수집 위치정보를 자동으로 파악할 수 있는 기술을 개발했다.

이 기술은 글로벌 실내 위치인식 시스템 구축에 필요한 핵심 기술로 다수의 스마트폰에서 수집된 무선랜 핑거프린트의 수집 위치를 자동으로 라벨링하는 인공지능 기법이다. 비용을 절감하면서 높은 정확도를 가질 수 있고 무선랜 핑거프린트 수집이 가능한 건물이라면 어느 곳에도 적용 가능하다.

여러 글로벌 기업들이 실내 GPS를 실현하기 위해 전 세계 주요도시에서 수만 건의 실내 지도를 수집했다. 실내 지도와 함께 신호 지도 수집도 시도했지만 높은 정확도를 갖지 못했고 그 결과 실내에서의 위치 인식 서비스 질이 떨어진다.

연구팀은 문제 해결을 위해 실내를 이동 공간과 체류 공간으로 구분하고 각각의 공간에 최적화된 수집 위치 라벨링을 자동화하는 기술을 개발했다.

연구팀이 개발한 기술은 복도, 로비, 계단과 같은 이동 공간에서도 수집된 신호의 위치정보를 별도의 외부 정도 없이도 자동으로 라벨링하는 새로운 자율학습(Unsupervised Learning) 인공지능 기술이다.

이 기술을 토대로 기초실험연구동(N5)과 김병호-김삼열IT융합빌딩(N1)에서 실험을 실시했고, 충분한 양의 학습 데이터가 주어진다는 가정 하에 오차범위 3~4미터 수준의 정확도를 보였다.

이는 수작업을 통해 수집 위치를 라벨링한 결과와 비슷한 정확도로 연구팀이 함께 개발한 지자기 신호, 3축 가속기, 자이로스코프 기반의 딥러닝을 활용한 새로운 센서 퓨전 기법을 통하면 정확도가 더욱 상승하는 결과를 보였다.

그 동안 스마트폰을 통해 수집된 핑거프린트는 활용되지 못하고 버려졌지만 개발된 기술을 통해 무선랜 핑거프린트 빅데이터 영역이 새롭게 열릴 것으로 기대된다.

개발된 GPS 구축 기술은 글로벌 기업이나 국내 위치정보 서비스 기업 등이 전국 범위에서 위치정보 서비스를 제공할 때 도입해 효과적으로 사용할 수 있을 것으로 예상된다.

GPS 신호가 도달하지 않는 실내 환경에서 위치인식 정확도가 높아짐에 따라 포켓몬고 등의 O2O(online to offline) 위치기반 게임도 실내에서 실행 가능할 것으로 기대된다.

또한 다양한 위치기반 SNS, 사물인터넷 등 서비스가 활성화되고 위급한 상황에서 112나 119에 구조요청을 할 시 정확한 위치 파악이 가능할 것으로 보인다.

한 교수는 “개발된 글로벌 실내 위치인식 시스템 구축 기술을 KAIST 실내 위치인식 시스템인 카이로스(KAILOS)에 탑재해 서비스 할 예정이다”며 “전 세계 어느 건물에서든 정확도 높은 실내 위치인식 시스템을 손쉽게 구축할 수 있고 장래에 대부분 실내 공간에서도 위치인식 서비스가 제공 가능할 것이다”고 말했다.

카이로스는 2014년 KAIST에서 출시한 개방형 실내 위치인식 서비스 플랫폼이다. 자신이 원하는 건물의 실내지도를 카이로스에 등록하고 해당 건물의 핑거프린트를 수집해 실내 위치인식 시스템을 구축하도록 지원 중이다.

□ 그림 설명

그림1. 핑거프린트를 수집하여 신호지도를 구축한 뒤, 구축된 신호지도를 기반으로 위치를 추정하는 과정

그림2. KAILOS가 여러 가지 신호와 센서를 복합적으로 사용하였을 때 예상되는 정확도

2017.04.12 조회수 19036 -

김대영 교수, EU와 글로벌 IoT 농식품 생태계 구축을 위한 공동 연구

우리 대학 전산학부 김대영 교수 연구팀과 유럽연합(EU)이 사물인터넷(IoT) 개방형 표준 및 아키텍쳐를 통한 글로벌 농식품 비즈니스 통합 에코시스템 개발 공동연구(The Internet of Food & Farm 2020, IoF2020)를 시작한다.

EU IoF2020 프로젝트는 스마트 팜과 농식품 서비스 분야에 첨단 ICT 융합기술을 활용하여 효율적이면서도 안전하고 건강한 먹거리를 보장하는 글로벌 생태계 조성을 목표로 한다.

유럽 연합이 4년간 3,000만 유로를 지원하는 등 총 3,500만 유로가 투자되는 이번 공동연구는 대학, 연구소, 기업 등 16개국 71개 기관이 참여하는 대형 프로젝트다. 한국에서는 유일하게 KAIST가 참여한다.

연구팀은 자체 개발한 국제 표준 사물인터넷 오픈소스 플랫폼인 올리옷(Oliot)을 활용한 스마트 팜과 푸드 서비스 생태계 테스트베드를 국내 농식품 비즈니스 전반에 구축하고 유럽의 테스트베드와 연동한다. 이들 생태계로부터 수집한 글로벌 빅데이터 분석을 위한 딥러닝 등 최신 인공지능 기술을 개발하여 궁극적으로 사물인터넷 플랫폼과 인공지능 기술이 통합된 시스템을 정부, 기관, 기업, 농민들이 활용할 수 있도록 공개할 예정이다.

IoF2020 프로젝트를 통해 개발되는 기술은 스마트팜 및 농식품 서비스 시장에 직접 투입하여 국내 농식품 산업에 활용될 수 있으며, 갈수록 높아지는 농식품 안전에 대한 요구를 만족시킬 수 있을 것으로 전망된다.

또한 핵심 기술인 올리옷(Oliot) 플랫폼은 농식품 분야 뿐 만 아니라, 스마트 시티, 스마트 팩토리, 헬스케어, 커넥티드 자동차등 다양한 산업에 활용될 것으로 기대된다.

IoF2020 프로젝트 코디네이터인 조지 비어스(George Beers)는 "IoF2020이 농장에서 소비자 식탁으로까지의 유통방식에 패러다임 변화를 가져올 것이며, 푸드 서비스 분야에서의 경쟁력과 우수성을 강화하는 데 기여할 것이라고 믿는다”라고 말했다.

KAIST 김대영 교수(전산학부, 오토아이디랩스(Auto-ID Labs) KAIST 센터장)는 “이미 국내에서 사물인터넷 국제표준 기술 적용을 시작했으며, 이번 프로젝트를 통해 유럽뿐 아니라 중국, 일본, 대만 등 아시아 국가와 남미 국가와도 글로벌 농식품 비즈니스 생태계 통합을 위한 노력이 진행 중이다”라고 밝혔다.

KAIST는 지난 2005년부터 전 세계 6개 대학(MIT(미국), 케임브리지대(영국), 취리히공대(스위스), 푸단대(중국), 게이오대(일본))과 함께 세계 최초로 사물인터넷의 개념을 소개한 ‛오토아이디랩스(Auto-ID Labs)' 국제공동연구소를 운영하며 사물인터넷 생태계 구축을 위한 선행 표준기술을 연구하고 있다.

2017.01.17 조회수 21704

김대영 교수, EU와 글로벌 IoT 농식품 생태계 구축을 위한 공동 연구

우리 대학 전산학부 김대영 교수 연구팀과 유럽연합(EU)이 사물인터넷(IoT) 개방형 표준 및 아키텍쳐를 통한 글로벌 농식품 비즈니스 통합 에코시스템 개발 공동연구(The Internet of Food & Farm 2020, IoF2020)를 시작한다.

EU IoF2020 프로젝트는 스마트 팜과 농식품 서비스 분야에 첨단 ICT 융합기술을 활용하여 효율적이면서도 안전하고 건강한 먹거리를 보장하는 글로벌 생태계 조성을 목표로 한다.

유럽 연합이 4년간 3,000만 유로를 지원하는 등 총 3,500만 유로가 투자되는 이번 공동연구는 대학, 연구소, 기업 등 16개국 71개 기관이 참여하는 대형 프로젝트다. 한국에서는 유일하게 KAIST가 참여한다.

연구팀은 자체 개발한 국제 표준 사물인터넷 오픈소스 플랫폼인 올리옷(Oliot)을 활용한 스마트 팜과 푸드 서비스 생태계 테스트베드를 국내 농식품 비즈니스 전반에 구축하고 유럽의 테스트베드와 연동한다. 이들 생태계로부터 수집한 글로벌 빅데이터 분석을 위한 딥러닝 등 최신 인공지능 기술을 개발하여 궁극적으로 사물인터넷 플랫폼과 인공지능 기술이 통합된 시스템을 정부, 기관, 기업, 농민들이 활용할 수 있도록 공개할 예정이다.

IoF2020 프로젝트를 통해 개발되는 기술은 스마트팜 및 농식품 서비스 시장에 직접 투입하여 국내 농식품 산업에 활용될 수 있으며, 갈수록 높아지는 농식품 안전에 대한 요구를 만족시킬 수 있을 것으로 전망된다.

또한 핵심 기술인 올리옷(Oliot) 플랫폼은 농식품 분야 뿐 만 아니라, 스마트 시티, 스마트 팩토리, 헬스케어, 커넥티드 자동차등 다양한 산업에 활용될 것으로 기대된다.

IoF2020 프로젝트 코디네이터인 조지 비어스(George Beers)는 "IoF2020이 농장에서 소비자 식탁으로까지의 유통방식에 패러다임 변화를 가져올 것이며, 푸드 서비스 분야에서의 경쟁력과 우수성을 강화하는 데 기여할 것이라고 믿는다”라고 말했다.

KAIST 김대영 교수(전산학부, 오토아이디랩스(Auto-ID Labs) KAIST 센터장)는 “이미 국내에서 사물인터넷 국제표준 기술 적용을 시작했으며, 이번 프로젝트를 통해 유럽뿐 아니라 중국, 일본, 대만 등 아시아 국가와 남미 국가와도 글로벌 농식품 비즈니스 생태계 통합을 위한 노력이 진행 중이다”라고 밝혔다.

KAIST는 지난 2005년부터 전 세계 6개 대학(MIT(미국), 케임브리지대(영국), 취리히공대(스위스), 푸단대(중국), 게이오대(일본))과 함께 세계 최초로 사물인터넷의 개념을 소개한 ‛오토아이디랩스(Auto-ID Labs)' 국제공동연구소를 운영하며 사물인터넷 생태계 구축을 위한 선행 표준기술을 연구하고 있다.

2017.01.17 조회수 21704