-

트랜스포머 대체할 차세대 월드모델 기술 세계 최초 개발

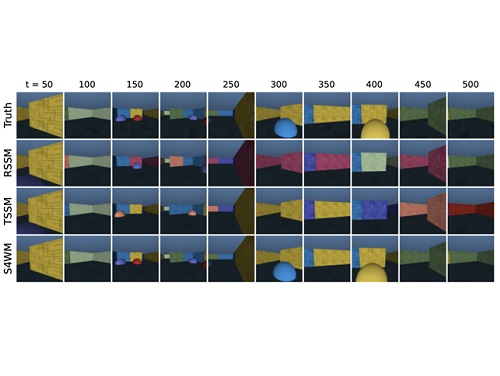

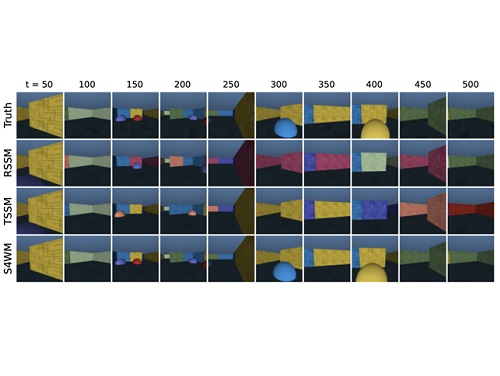

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스 대학교와 협력하여 트랜스포머 및 재귀신경망 기반의 월드모델을 대체할 차세대 에이전트 월드모델 기술을 세계 최초로 개발했다.

월드모델은 인간의 뇌가 현실 세계의 경험을 바탕으로 환경 모델을 구축하는 과정과 유사하다. 이러한 월드모델을 활용하는 인공지능은 특정 행동의 결과를 미리 시뮬레이션해보고 다양한 가설을 검증할 수 있어, 범용 인공지능의 핵심 구성 요소로 여겨진다.

특히, 로봇이나 자율주행 차량과 같은 인공지능 에이전트는 학습을 위해 여러 가지 행동을 시도해 보아야하는데, 이는 위험성과 고장 가능성을 높인다는 단점을 갖는다. 이에 반해, 월드모델을 갖춘 인공지능은 실세계 상호작용 없이도 상상모델 속에서 학습을 가능케 해 큰 이점을 제공한다.

그러나 월드모델은 자연어처리 등에서 큰 발전을 가능하게 한 트랜스포머와 S4와 같은 새로운 시퀀스 모델링 아키텍처의 적용에 한계가 있었다. 이로 인해, 대부분의 월드모델이 성능과 효율성 면에서 제약이 있는 고전적인 재귀적 신경망에 의존하고 있었고 안성진 교수팀은 작년 세계최초로 트랜스포머 기반의 월드모델을 개발하였으나 추론 계산속도나 메모리능력에서 여전히 개선할 문제를 갖고 있었다.

이러한 문제를 해결하기 위해, 안성진 교수가 이끄는 KAIST와 럿거스 대학교 공동연구팀은 재귀적 신경망과 트랜스포머 기반 월드모델의 단점을 극복한 새로운 월드모델의 개발에 성공했다. 연구팀은 S4 시퀀스 모델에 기반한 S4 World Model (S4WM)을 개발하여, 재귀적 신경망의 최대 단점인 병렬처리가 가능한 시퀀스 학습이 불가능하다는 문제를 해결하였다. 또한, 재귀적 신경망의 장점인 빠른 추론시간을 유지하도록 하여 느린 추론 시간을 제공하는 트랜스포머 기반 월드모델의 단점을 극복했다.

연구를 주도한 안성진 교수는 "병렬 학습과 빠른 추론이 가능한 에이전트 월드모델을 세계 최초로 개발했다ˮ며, 이는 "모델기반 강화학습 능력을 획기적으로 개선해 지능형 로봇, 자율주행 차량, 그리고 자율형 인공지능 에이전트 기술 전반에 비용절감과 성능 향상이 예상된다ˮ고 밝혔다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 세계 최고 수준의 인공지능 학회인 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Facing off World Model Backbones: RNNs, Transformers, and S4”Fei Deng, Junyeong Park, Sungjin Ahn, NeurIPS 23, https://arxiv.org/abs/2307.02064

트랜스포머 대체할 차세대 월드모델 기술 세계 최초 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스 대학교와 협력하여 트랜스포머 및 재귀신경망 기반의 월드모델을 대체할 차세대 에이전트 월드모델 기술을 세계 최초로 개발했다.

월드모델은 인간의 뇌가 현실 세계의 경험을 바탕으로 환경 모델을 구축하는 과정과 유사하다. 이러한 월드모델을 활용하는 인공지능은 특정 행동의 결과를 미리 시뮬레이션해보고 다양한 가설을 검증할 수 있어, 범용 인공지능의 핵심 구성 요소로 여겨진다.

특히, 로봇이나 자율주행 차량과 같은 인공지능 에이전트는 학습을 위해 여러 가지 행동을 시도해 보아야하는데, 이는 위험성과 고장 가능성을 높인다는 단점을 갖는다. 이에 반해, 월드모델을 갖춘 인공지능은 실세계 상호작용 없이도 상상모델 속에서 학습을 가능케 해 큰 이점을 제공한다.

그러나 월드모델은 자연어처리 등에서 큰 발전을 가능하게 한 트랜스포머와 S4와 같은 새로운 시퀀스 모델링 아키텍처의 적용에 한계가 있었다. 이로 인해, 대부분의 월드모델이 성능과 효율성 면에서 제약이 있는 고전적인 재귀적 신경망에 의존하고 있었고 안성진 교수팀은 작년 세계최초로 트랜스포머 기반의 월드모델을 개발하였으나 추론 계산속도나 메모리능력에서 여전히 개선할 문제를 갖고 있었다.

이러한 문제를 해결하기 위해, 안성진 교수가 이끄는 KAIST와 럿거스 대학교 공동연구팀은 재귀적 신경망과 트랜스포머 기반 월드모델의 단점을 극복한 새로운 월드모델의 개발에 성공했다. 연구팀은 S4 시퀀스 모델에 기반한 S4 World Model (S4WM)을 개발하여, 재귀적 신경망의 최대 단점인 병렬처리가 가능한 시퀀스 학습이 불가능하다는 문제를 해결하였다. 또한, 재귀적 신경망의 장점인 빠른 추론시간을 유지하도록 하여 느린 추론 시간을 제공하는 트랜스포머 기반 월드모델의 단점을 극복했다.

연구를 주도한 안성진 교수는 "병렬 학습과 빠른 추론이 가능한 에이전트 월드모델을 세계 최초로 개발했다ˮ며, 이는 "모델기반 강화학습 능력을 획기적으로 개선해 지능형 로봇, 자율주행 차량, 그리고 자율형 인공지능 에이전트 기술 전반에 비용절감과 성능 향상이 예상된다ˮ고 밝혔다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 세계 최고 수준의 인공지능 학회인 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Facing off World Model Backbones: RNNs, Transformers, and S4”Fei Deng, Junyeong Park, Sungjin Ahn, NeurIPS 23, https://arxiv.org/abs/2307.02064

2023.11.09

조회수 7049

-

강수 관측 오차범위 42.5% 줄인 알고리즘 개발

강수량의 정확한 파악은 지구의 물 순환을 이해하고 수자원과 재해 대응을 위해 중요하다. 강수량 추정을 위한 알고리즘에는 다양한 방법들이 제안되어 왔으며, 최근에는 기계학습을 이용한 방법들이 많이 제안되고 있다.

우리 대학 문술미래전략대학원(건설및환경공학과 및 녹색성장지속가능대학원 겸임) 김형준 교수와 도쿄대 등으로 구성된 국제 공동연구팀이 인공위성에 탑재된 마이크로파 라디오미터의 관측값을 이용해 지상 강수량을 추정하는 새로운 기계학습 방법을 제안했다고 25일 밝혔다. 연구팀은 기존의 방법과 비교해 전 강수량에 대해 오차(RMSE)를 최소 15.9%에서 최대 42.5%까지 줄이는 데 성공했다.

단순한 데이터 주도(data-driven)모델은 대량의 훈련 데이터가 필요하고 물리적인 일관성이 보장되지 않으며 결과의 원인 분석이 어렵다는 등의 문제가 있었다. 연구팀은 이번 연구에서 위성 강수량 추정에 대한 분야 지식을 명시적으로 포함함으로써 학습 모델 내의 상호 의존적인 지식 교환을 구현했다. 구체적으로, 멀티태스크 학습(multitask learning)이라는 심층 학습 기법을 사용해 강수 여부를 인식하는 분류 모델과 강수 강도를 추정하는 회귀 모델을 통합하고 동시에 학습시켰다.

이번 연구에서 제안한 기계학습 모델에는 이번에 포함된 메커니즘 외에도 다양한 물리적 메커니즘을 포함할 수 있다. 예를 들어, 비 또는 눈, 진눈깨비 등 강수 종류의 분류 및 상승 기류 또는 층상 구름 유형 등 강수를 일으키는 구름 유형의 분류를 포함함으로써 앞으로 추정의 정확도가 더욱 향상될 것으로 기대된다.

김형준 교수의 이번 연구 결과는 국제 학술지 ‘지구물리 연구 레터(Geophysical Research Letters)’에 지난 4월 16일 출판됐다. (논문명: Multi-Task Learning for Simultaneous Retrievals of Passive Microwave Precipitation Estimates and Rain/No-Rain Classification; doi:10.1029/2022GL102283)

한편 이번 연구는 한국연구재단 해외우수과학자유치사업(BP+)와 정보통신기획평가원 인공지능대학원지원(한국과학기술원)지원을 받아 수행됐다.

강수 관측 오차범위 42.5% 줄인 알고리즘 개발

강수량의 정확한 파악은 지구의 물 순환을 이해하고 수자원과 재해 대응을 위해 중요하다. 강수량 추정을 위한 알고리즘에는 다양한 방법들이 제안되어 왔으며, 최근에는 기계학습을 이용한 방법들이 많이 제안되고 있다.

우리 대학 문술미래전략대학원(건설및환경공학과 및 녹색성장지속가능대학원 겸임) 김형준 교수와 도쿄대 등으로 구성된 국제 공동연구팀이 인공위성에 탑재된 마이크로파 라디오미터의 관측값을 이용해 지상 강수량을 추정하는 새로운 기계학습 방법을 제안했다고 25일 밝혔다. 연구팀은 기존의 방법과 비교해 전 강수량에 대해 오차(RMSE)를 최소 15.9%에서 최대 42.5%까지 줄이는 데 성공했다.

단순한 데이터 주도(data-driven)모델은 대량의 훈련 데이터가 필요하고 물리적인 일관성이 보장되지 않으며 결과의 원인 분석이 어렵다는 등의 문제가 있었다. 연구팀은 이번 연구에서 위성 강수량 추정에 대한 분야 지식을 명시적으로 포함함으로써 학습 모델 내의 상호 의존적인 지식 교환을 구현했다. 구체적으로, 멀티태스크 학습(multitask learning)이라는 심층 학습 기법을 사용해 강수 여부를 인식하는 분류 모델과 강수 강도를 추정하는 회귀 모델을 통합하고 동시에 학습시켰다.

이번 연구에서 제안한 기계학습 모델에는 이번에 포함된 메커니즘 외에도 다양한 물리적 메커니즘을 포함할 수 있다. 예를 들어, 비 또는 눈, 진눈깨비 등 강수 종류의 분류 및 상승 기류 또는 층상 구름 유형 등 강수를 일으키는 구름 유형의 분류를 포함함으로써 앞으로 추정의 정확도가 더욱 향상될 것으로 기대된다.

김형준 교수의 이번 연구 결과는 국제 학술지 ‘지구물리 연구 레터(Geophysical Research Letters)’에 지난 4월 16일 출판됐다. (논문명: Multi-Task Learning for Simultaneous Retrievals of Passive Microwave Precipitation Estimates and Rain/No-Rain Classification; doi:10.1029/2022GL102283)

한편 이번 연구는 한국연구재단 해외우수과학자유치사업(BP+)와 정보통신기획평가원 인공지능대학원지원(한국과학기술원)지원을 받아 수행됐다.

2023.04.25

조회수 8777

-

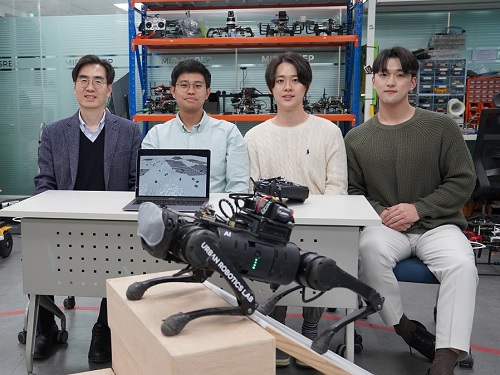

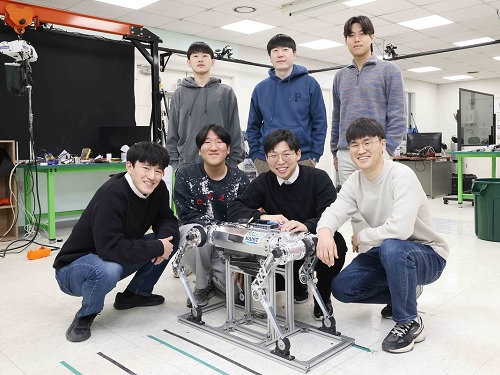

드림워커, 안 보고도 계단을 성큼성큼 걷다

연기가 자욱해 앞이 안보이는 재난 상황에서 별도의 시각이나 촉각 센서의 도움 없이 계단을 오르내리고 나무뿌리와 같은 울퉁불퉁한 환경 등에서 넘어지지 않고 움직이는 사족보행 로봇 기술이 국내 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 명현 교수 연구팀(미래도시 로봇연구실)이 다양한 비정형 환경에서도 강인한 `블라인드 보행(blind locomotion)'을 가능케 하는 보행 로봇 제어 기술을 개발했다고 29일 밝혔다.

연구팀은 사람이 수면 중 깨어서 깜깜한 상태에서 화장실을 갈 때 시각적인 도움이 거의 없이 보행이 가능한 것처럼, 블라인드 보행이 가능하다고 해서 붙여진 ‘드림워크(DreamWaQ)’기술을 개발하였고 이 기술이 적용된 로봇을 ‘드림워커(DreamWaQer)’라고 명명했다. 즉 이 기술을 탑재하면 다양한 형태의 사족보행 로봇 드림워커를 만들어낼 수 있게 되는 것이다.

기존 보행 로봇 제어기는 기구학 또는 동역학 모델을 기반으로 한다. 이를 모델 기반 제어 방식이라고 표현하는데, 특히 야지와 같은 비정형 환경에서 안정적인 보행을 하기 위해서는 모델의 특징 정보를 더욱 빠르게 얻을 수 있어야 한다. 그러나 이는 주변 환경의 인지 능력에 많이 의존하는 모습을 보여 왔다.

이에 비해, 명현 교수 연구팀이 개발한 인공지능 학습 방법 중 하나인 심층 강화학습 기반의 제어기는 시뮬레이터로부터 얻어진 다양한 환경의 데이터를 통해 보행 로봇의 각 모터에 적절한 제어 명령을 빠르게 계산해 줄 수 있다. 시뮬레이션에서 학습된 제어기가 실제 로봇에서 잘 작동하려면 별도의 튜닝 과정이 필요했다면, 연구팀이 개발한 제어기는 별도의 튜닝을 요구하지 않는다는 장점도 있어 다양한 보행 로봇에 쉽게 적용될 수 있을 것으로 기대된다.

연구팀이 개발한 제어기인 드림워크는 크게 지면과 로봇의 정보를 추정하는 상황(context) 추정 네트워크와 제어 명령을 산출하는 정책(policy) 네트워크로 구성된다. 상황추정 네트워크는 관성 정보와 관절 정보들을 통해 암시적으로 지면의 정보를, 명시적으로 로봇의 상태를 추정한다. 이 정보는 정책 네트워크에 입력돼 최적의 제어 명령을 산출하는 데 사용된다. 두 네트워크는 시뮬레이션에서 함께 학습된다.

상황추정 네트워크는 지도학습을 통해 학습되는 반면, 정책 네트워크는 심층 강화학습 방법론인 행동자-비평자(actor-critic) 방식을 통해 학습된다. 행동자 네트워크는 주변 지형 정보를 오직 암시적으로 추정할 수 있다. 시뮬레이션에서는 주변 지형 정보를 알 수 있는데, 지형 정보를 알고 있는 비평자 네트워크가 행동자 네트워크의 정책을 평가한다.

이 모든 학습 과정에는 단 1시간 정도만 소요되며, 실제 로봇에는 학습된 행동자 네트워크만 탑재된다. 주변 지형을 보지 않고도, 오직 로봇 내부의 관성 센서(IMU)와 관절 각도의 측정치를 활용해 시뮬레이션에서 학습한 다양한 환경 중 어느 환경과 유사한지 상상하는 과정을 거친다. 갑자기 계단과 같은 단차를 맞이하는 경우, 발이 단차에 닿기 전까지는 알 수 없지만 발이 닿는 순간 빠르게 지형 정보를 상상한다. 그리고 이렇게 추측된 지형 정보에 알맞은 제어 명령을 각 모터에 전달해 재빠른 적응 보행이 가능하다.

드림워커(DreamWaQer) 로봇은 실험실 환경뿐 아니라, 연석과 과속방지턱이 많은 대학 캠퍼스 환경, 나무뿌리와 자갈이 많은 야지 환경 등에서 보행 시 지면으로부터 몸체까지 높이의 3분의 2 (2/3) 정도의 계단 등을 극복함으로써 강인한 성능을 입증했다. 또한 환경과 무관하게, 0.3m/s의 느린 속도부터 1.0m/s의 다소 빠른 속도까지도 안정적인 보행이 가능함을 연구팀은 확인했다.

이번 연구 결과는 이 마데 아스윈 나렌드라(I Made Aswin Nahrendra) 박사과정이 제1 저자로, 유병호 박사과정이 공동 저자로 참여했으며, 오는 5월 말 영국 런던에서 개최되는 로보틱스 분야의 세계 최고 권위 학회인 ICRA(IEEE International Conference on Robotics and Automation)에 채택되어 발표될 예정이다. (논문명: DreamWaQ: Learning Robust Quadrupedal Locomotion With Implicit Terrain Imagination via Deep Reinforcement Learning)

개발된 드림워크를 탑재한 보행 로봇 드림워커의 구동 및 보행 영상은 아래 주소에서 확인할 수 있다.

메인 영상: https://youtu.be/JC1_bnTxPiQ

쿠키 영상: https://youtu.be/mhUUZVbeDA0

한편, 이번 연구는 산업통상자원부 로봇산업핵심기술개발 사업의 지원을 받아 수행되었다. (과제명: 동적, 비정형 환경에서의 보행 로봇의 자율이동을 위한 이동지능 SW 개발 및 실현장 적용)

드림워커, 안 보고도 계단을 성큼성큼 걷다

연기가 자욱해 앞이 안보이는 재난 상황에서 별도의 시각이나 촉각 센서의 도움 없이 계단을 오르내리고 나무뿌리와 같은 울퉁불퉁한 환경 등에서 넘어지지 않고 움직이는 사족보행 로봇 기술이 국내 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 명현 교수 연구팀(미래도시 로봇연구실)이 다양한 비정형 환경에서도 강인한 `블라인드 보행(blind locomotion)'을 가능케 하는 보행 로봇 제어 기술을 개발했다고 29일 밝혔다.

연구팀은 사람이 수면 중 깨어서 깜깜한 상태에서 화장실을 갈 때 시각적인 도움이 거의 없이 보행이 가능한 것처럼, 블라인드 보행이 가능하다고 해서 붙여진 ‘드림워크(DreamWaQ)’기술을 개발하였고 이 기술이 적용된 로봇을 ‘드림워커(DreamWaQer)’라고 명명했다. 즉 이 기술을 탑재하면 다양한 형태의 사족보행 로봇 드림워커를 만들어낼 수 있게 되는 것이다.

기존 보행 로봇 제어기는 기구학 또는 동역학 모델을 기반으로 한다. 이를 모델 기반 제어 방식이라고 표현하는데, 특히 야지와 같은 비정형 환경에서 안정적인 보행을 하기 위해서는 모델의 특징 정보를 더욱 빠르게 얻을 수 있어야 한다. 그러나 이는 주변 환경의 인지 능력에 많이 의존하는 모습을 보여 왔다.

이에 비해, 명현 교수 연구팀이 개발한 인공지능 학습 방법 중 하나인 심층 강화학습 기반의 제어기는 시뮬레이터로부터 얻어진 다양한 환경의 데이터를 통해 보행 로봇의 각 모터에 적절한 제어 명령을 빠르게 계산해 줄 수 있다. 시뮬레이션에서 학습된 제어기가 실제 로봇에서 잘 작동하려면 별도의 튜닝 과정이 필요했다면, 연구팀이 개발한 제어기는 별도의 튜닝을 요구하지 않는다는 장점도 있어 다양한 보행 로봇에 쉽게 적용될 수 있을 것으로 기대된다.

연구팀이 개발한 제어기인 드림워크는 크게 지면과 로봇의 정보를 추정하는 상황(context) 추정 네트워크와 제어 명령을 산출하는 정책(policy) 네트워크로 구성된다. 상황추정 네트워크는 관성 정보와 관절 정보들을 통해 암시적으로 지면의 정보를, 명시적으로 로봇의 상태를 추정한다. 이 정보는 정책 네트워크에 입력돼 최적의 제어 명령을 산출하는 데 사용된다. 두 네트워크는 시뮬레이션에서 함께 학습된다.

상황추정 네트워크는 지도학습을 통해 학습되는 반면, 정책 네트워크는 심층 강화학습 방법론인 행동자-비평자(actor-critic) 방식을 통해 학습된다. 행동자 네트워크는 주변 지형 정보를 오직 암시적으로 추정할 수 있다. 시뮬레이션에서는 주변 지형 정보를 알 수 있는데, 지형 정보를 알고 있는 비평자 네트워크가 행동자 네트워크의 정책을 평가한다.

이 모든 학습 과정에는 단 1시간 정도만 소요되며, 실제 로봇에는 학습된 행동자 네트워크만 탑재된다. 주변 지형을 보지 않고도, 오직 로봇 내부의 관성 센서(IMU)와 관절 각도의 측정치를 활용해 시뮬레이션에서 학습한 다양한 환경 중 어느 환경과 유사한지 상상하는 과정을 거친다. 갑자기 계단과 같은 단차를 맞이하는 경우, 발이 단차에 닿기 전까지는 알 수 없지만 발이 닿는 순간 빠르게 지형 정보를 상상한다. 그리고 이렇게 추측된 지형 정보에 알맞은 제어 명령을 각 모터에 전달해 재빠른 적응 보행이 가능하다.

드림워커(DreamWaQer) 로봇은 실험실 환경뿐 아니라, 연석과 과속방지턱이 많은 대학 캠퍼스 환경, 나무뿌리와 자갈이 많은 야지 환경 등에서 보행 시 지면으로부터 몸체까지 높이의 3분의 2 (2/3) 정도의 계단 등을 극복함으로써 강인한 성능을 입증했다. 또한 환경과 무관하게, 0.3m/s의 느린 속도부터 1.0m/s의 다소 빠른 속도까지도 안정적인 보행이 가능함을 연구팀은 확인했다.

이번 연구 결과는 이 마데 아스윈 나렌드라(I Made Aswin Nahrendra) 박사과정이 제1 저자로, 유병호 박사과정이 공동 저자로 참여했으며, 오는 5월 말 영국 런던에서 개최되는 로보틱스 분야의 세계 최고 권위 학회인 ICRA(IEEE International Conference on Robotics and Automation)에 채택되어 발표될 예정이다. (논문명: DreamWaQ: Learning Robust Quadrupedal Locomotion With Implicit Terrain Imagination via Deep Reinforcement Learning)

개발된 드림워크를 탑재한 보행 로봇 드림워커의 구동 및 보행 영상은 아래 주소에서 확인할 수 있다.

메인 영상: https://youtu.be/JC1_bnTxPiQ

쿠키 영상: https://youtu.be/mhUUZVbeDA0

한편, 이번 연구는 산업통상자원부 로봇산업핵심기술개발 사업의 지원을 받아 수행되었다. (과제명: 동적, 비정형 환경에서의 보행 로봇의 자율이동을 위한 이동지능 SW 개발 및 실현장 적용)

2023.03.29

조회수 11005

-

‘라이보’ 로봇, 해변을 거침없이 달리다

우리 대학 기계공학과 황보제민 교수 연구팀이 모래와 같이 변형하는 지형에서도 민첩하고 견고하게 보행할 수 있는 사족 로봇 제어기술을 개발했다고 26일 밝혔다.

황보 교수 연구팀은 모래와 같은 입상 물질로 이루어진 지반에서 로봇 보행체가 받는 힘을 모델링하고, 이를 사족 로봇에 시뮬레이션하는 기술을 개발했다. 또한, 사전 정보 없이도 다양한 지반 종류에 스스로 적응해가며 보행하기에 적합한 인공신경망 구조를 도입해 강화학습에 적용했다. 학습된 신경망 제어기는 해변 모래사장에서의 고속 이동과 에어 매트리스 위에서의 회전을 선보이는 등 변화하는 지형에서의 견고성을 입증해 사족 보행 로봇이 적용될 수 있는 영역을 넓힐 것으로 기대된다.

기계공학과 최수영 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `사이언스 로보틱스(Science Robotics)' 1월 8권 74호에 출판됐다. (논문명 : Learning quadrupedal locomotion on deformable terrain)

강화학습은 임의의 상황에서 여러 행동이 초래하는 결과들의 데이터를 수집하고 이를 사용해 임무를 수행하는 기계를 만드는 학습 방법이다. 이때 필요한 데이터의 양이 많아 실제 환경의 물리 현상을 근사하는 시뮬레이션으로 빠르게 데이터를 모으는 방법이 널리 사용되고 있다.

특히 보행 로봇 분야에서 학습 기반 제어기들은 시뮬레이션에서 수집한 데이터를 통해서 학습된 이후 실제 환경에 적용돼 다양한 지형에서 보행 제어를 성공적으로 수행해 온 바 있다.

다만 학습한 시뮬레이션 환경과 실제 마주친 환경이 다른 경우 학습 기반 제어기의 성능은 급격히 감소하기 때문에, 데이터 수집 단계에서 실제와 유사한 환경을 구현하는 것이 중요하다. 따라서, 변형하는 지형을 극복하는 학습 기반 제어기를 만들기 위해서는 시뮬레이터는 유사한 접촉 경험을 제공해야 한다.

연구팀은 기존 연구에서 밝혀진 입상 매체의 추가 질량 효과를 고려하는 지반 반력 모델을 기반으로 보행체의 운동 역학으로부터 접촉에서 발생하는 힘을 예측하는 접촉 모델을 정의했다.

나아가 시간 단계마다 하나 혹은 여러 개의 접촉에서 발생하는 힘을 풀이함으로써 효율적으로 변형하는 지형을 시뮬레이션했다.

연구팀은 또한 로봇의 센서에서 나오는 시계열 데이터를 분석하는 순환 신경망을 사용함으로써 암시적으로 지반 특성을 예측하는 인공신경망 구조를 도입했다.

학습이 완료된 제어기는 연구팀이 직접 제작한 로봇 `라이보'에 탑재돼 로봇의 발이 완전히 모래에 잠기는 해변 모래사장에서 최대 3.03 m/s의 고속 보행을 선보였으며, 추가 작업 없이 풀밭, 육상 트랙, 단단한 땅에 적용됐을 때도 지반 특성에 적응해 안정하게 주행할 수 있었다.

또한, 에어 매트리스에서 1.54 rad/s(초당 약 90°)의 회전을 안정적으로 수행했으며 갑작스럽게 지형이 부드러워지는 환경도 극복하며 빠른 적응력을 입증했다.

연구팀은 지면을 강체로 간주한 제어기와의 비교를 통해 학습 간 적합한 접촉 경험을 제공하는 것의 중요성을 드러냈으며, 제안한 순환 신경망이 지반 성질에 따라 제어기의 보행 방식을 수정한다는 것을 입증했다.

연구팀이 개발한 시뮬레이션과 학습 방법론은 다양한 보행 로봇이 극복할 수 있는 지형의 범위를 넓힘으로써 로봇이 실제적 임무를 수행하는 데에 이바지할 수 있을 것으로 기대된다.

제1 저자인 최수영 박사과정은 "학습 기반 제어기에 실제의 변형하는 지반과 가까운 접촉 경험을 제공하는 것이 변형하는 지형에 적용하는 데 필수적이라는 것을 보였다ˮ 라며 "제시된 제어기는 지형에 대한 사전 정보 없이 기용될 수 있어 다양한 로봇 보행 연구에 접목될 수 있다ˮ 라고 말했다.

한편 이번 연구는 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

‘라이보’ 로봇, 해변을 거침없이 달리다

우리 대학 기계공학과 황보제민 교수 연구팀이 모래와 같이 변형하는 지형에서도 민첩하고 견고하게 보행할 수 있는 사족 로봇 제어기술을 개발했다고 26일 밝혔다.

황보 교수 연구팀은 모래와 같은 입상 물질로 이루어진 지반에서 로봇 보행체가 받는 힘을 모델링하고, 이를 사족 로봇에 시뮬레이션하는 기술을 개발했다. 또한, 사전 정보 없이도 다양한 지반 종류에 스스로 적응해가며 보행하기에 적합한 인공신경망 구조를 도입해 강화학습에 적용했다. 학습된 신경망 제어기는 해변 모래사장에서의 고속 이동과 에어 매트리스 위에서의 회전을 선보이는 등 변화하는 지형에서의 견고성을 입증해 사족 보행 로봇이 적용될 수 있는 영역을 넓힐 것으로 기대된다.

기계공학과 최수영 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `사이언스 로보틱스(Science Robotics)' 1월 8권 74호에 출판됐다. (논문명 : Learning quadrupedal locomotion on deformable terrain)

강화학습은 임의의 상황에서 여러 행동이 초래하는 결과들의 데이터를 수집하고 이를 사용해 임무를 수행하는 기계를 만드는 학습 방법이다. 이때 필요한 데이터의 양이 많아 실제 환경의 물리 현상을 근사하는 시뮬레이션으로 빠르게 데이터를 모으는 방법이 널리 사용되고 있다.

특히 보행 로봇 분야에서 학습 기반 제어기들은 시뮬레이션에서 수집한 데이터를 통해서 학습된 이후 실제 환경에 적용돼 다양한 지형에서 보행 제어를 성공적으로 수행해 온 바 있다.

다만 학습한 시뮬레이션 환경과 실제 마주친 환경이 다른 경우 학습 기반 제어기의 성능은 급격히 감소하기 때문에, 데이터 수집 단계에서 실제와 유사한 환경을 구현하는 것이 중요하다. 따라서, 변형하는 지형을 극복하는 학습 기반 제어기를 만들기 위해서는 시뮬레이터는 유사한 접촉 경험을 제공해야 한다.

연구팀은 기존 연구에서 밝혀진 입상 매체의 추가 질량 효과를 고려하는 지반 반력 모델을 기반으로 보행체의 운동 역학으로부터 접촉에서 발생하는 힘을 예측하는 접촉 모델을 정의했다.

나아가 시간 단계마다 하나 혹은 여러 개의 접촉에서 발생하는 힘을 풀이함으로써 효율적으로 변형하는 지형을 시뮬레이션했다.

연구팀은 또한 로봇의 센서에서 나오는 시계열 데이터를 분석하는 순환 신경망을 사용함으로써 암시적으로 지반 특성을 예측하는 인공신경망 구조를 도입했다.

학습이 완료된 제어기는 연구팀이 직접 제작한 로봇 `라이보'에 탑재돼 로봇의 발이 완전히 모래에 잠기는 해변 모래사장에서 최대 3.03 m/s의 고속 보행을 선보였으며, 추가 작업 없이 풀밭, 육상 트랙, 단단한 땅에 적용됐을 때도 지반 특성에 적응해 안정하게 주행할 수 있었다.

또한, 에어 매트리스에서 1.54 rad/s(초당 약 90°)의 회전을 안정적으로 수행했으며 갑작스럽게 지형이 부드러워지는 환경도 극복하며 빠른 적응력을 입증했다.

연구팀은 지면을 강체로 간주한 제어기와의 비교를 통해 학습 간 적합한 접촉 경험을 제공하는 것의 중요성을 드러냈으며, 제안한 순환 신경망이 지반 성질에 따라 제어기의 보행 방식을 수정한다는 것을 입증했다.

연구팀이 개발한 시뮬레이션과 학습 방법론은 다양한 보행 로봇이 극복할 수 있는 지형의 범위를 넓힘으로써 로봇이 실제적 임무를 수행하는 데에 이바지할 수 있을 것으로 기대된다.

제1 저자인 최수영 박사과정은 "학습 기반 제어기에 실제의 변형하는 지반과 가까운 접촉 경험을 제공하는 것이 변형하는 지형에 적용하는 데 필수적이라는 것을 보였다ˮ 라며 "제시된 제어기는 지형에 대한 사전 정보 없이 기용될 수 있어 다양한 로봇 보행 연구에 접목될 수 있다ˮ 라고 말했다.

한편 이번 연구는 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

2023.01.26

조회수 10055

-

레이블 없이 훈련 가능한 그래프 신경망 모델 기술 개발

최근 다양한 분야 (소셜 네트워크 분석, 추천시스템 등)에서 그래프 데이터 (그림 1) 의 중요성이 대두되고 있으며, 이에 따라 그래프 신경망(Graph Neural Network) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 소셜 네트워크의 특정 사용자에 `20대'라는 레이블을 부여하는 행위), 이 과정은 일반적으로 수작업으로 진행되므로 노동력과 시간이 소요된다. 따라서 그래프 신경망 모델 훈련 시 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법의 필요성이 대두되고 있다.

우리 대학 산업및시스템공학과 박찬영 교수 연구팀이 데이터의 레이블이 없는 상황에서도 높은 예측 정확도를 달성할 수 있는 새로운 그래프 신경망 모델 훈련 기술을 개발했다고 25일 밝혔다.

정점의 레이블이 없는 상황에서 그래프 신경망 모델의 훈련은 데이터 증강을 통해 생성된 정점들의 공통된 특성을 학습하는 과정으로 볼 수 있다. 하지만 이러한 정점의 공통된 특성을 학습하는 과정에서, 기존 훈련 방법은 표상 공간에서 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 하지만 그래프 데이터가 정점들 사이의 관계를 나타내는 데이터 구조라는 점을 고려했을 때, 이런 일차원적인 방법론은 정점 간의 관계를 정확히 반영하지 못하게 된다.

박 교수팀이 개발한 기술은 그래프 신경망 모델에서 정점들 사이의 관계를 보존해 정점의 레이블이 없는 상황에서 모델을 훈련시켜 높은 예측 정확도를 달성할 수 있게 해준다.

KAIST 산업및시스템공학과 이남경 석사과정이 제1 저자, 현동민 박사, 이준석 석사과정 학생이 제2, 제3 저자로 참여한 이번 연구는 최고권위 국제학술대회 `정보지식관리 콘퍼런스(CIKM) 2022'에서 올 10월 발표될 예정이다. (논문명: Relational Self-Supervised Learning on Graphs)

기존 연구에서는 정점의 레이블이 없는 상황에서 정점에 대한 표상을 훈련하기 위해 표상 공간 내에서 자기 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 예를 들어서, 소셜 네트워크에 A, B, C 라는 사용자가 존재할 때, A, B와 C가 표상 공간에서 서로 간의 유사도가 모두 작아지도록 모델을 훈련하는 것이다. 이때 박 교수팀이 착안한 점은 그래프 데이터가 정점 간의 관계를 나타내는 데이터이므로 정점 간의 관계를 포착하도록 정점의 표상을 훈련할 필요가 있다는 점이었다.

즉, A, B와 C 서로 간의 유사도가 모두 작아지게 하는 훈련 메커니즘과는 달리, 실제 그래프상에서는 이들이 연관이 있을 수 있다는 점이다. 따라서 A, B와 C 사이의 관계를 긍정/부정의 이진 분류를 통해 표상 공간에서 유사도가 작아지도록 훈련을 하는 것이 아닌, 이들의 관계를 정의해 그 관계를 보존하도록 학습하는 모델을 연구팀은 개발했다(그림 2). 연구팀은 정점 간의 관계를 기반으로 정점의 표상을 훈련함으로써, 기존 연구가 갖는 엄격한 규제들을 완화해 그래프 데이터를 더 유연하게 모델링했다.

연구팀은 이 학습 방법론을 `관계 보존 학습'이라고 명명했으며, 그래프 데이터 분석의 주요 문제(정점 분류, 간선 예측)에 적용했다(그림 3). 그 결과 최신 연구 방법론과 비교했을 때, 정점 분류 문제에서 최대 3% 예측 정확도를 향상했고, 간선 예측 문제에서 6%의 성능 향상, 다중 연결 네트워크 (Multiplex network)의 정점 분류 문제에서 3%의 성능 향상을 보였다.

제1 저자인 이남경 석사과정은 "이번 기술은 데이터의 레이블이 부재한 상황에서도 그래프 신경망을 학습할 수 있는 새로운 방법ˮ 이라면서 "그래프 기반의 데이터뿐만이 아닌 이미지 텍스트 음성 데이터 등에 폭넓게 적용될 수 있어, 심층 학습 전반적인 성능 개선에 기여할 수 있다ˮ고 밝혔다.

연구팀을 지도한 박찬영 교수도 "이번 기술은 그래프 데이터상에 레이블이 부재한 상황에서 표상 학습 모델을 훈련하는 기존 모델들의 단점들을 `관계 보존`이라는 개념을 통해 보완해 새로운 학습 패러다임을 제시하여 학계에 큰 파급효과를 낼 수 있다ˮ라고 말했다.

한편, 이번 연구는 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 사람중심인공지능핵심원천기술개발 과제로 개발한 연구성과 결과물(No. 2022-0-00157, 강건하고 공정하며 확장 가능한 데이터 중심의 연속 학습)이다.

레이블 없이 훈련 가능한 그래프 신경망 모델 기술 개발

최근 다양한 분야 (소셜 네트워크 분석, 추천시스템 등)에서 그래프 데이터 (그림 1) 의 중요성이 대두되고 있으며, 이에 따라 그래프 신경망(Graph Neural Network) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 소셜 네트워크의 특정 사용자에 `20대'라는 레이블을 부여하는 행위), 이 과정은 일반적으로 수작업으로 진행되므로 노동력과 시간이 소요된다. 따라서 그래프 신경망 모델 훈련 시 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법의 필요성이 대두되고 있다.

우리 대학 산업및시스템공학과 박찬영 교수 연구팀이 데이터의 레이블이 없는 상황에서도 높은 예측 정확도를 달성할 수 있는 새로운 그래프 신경망 모델 훈련 기술을 개발했다고 25일 밝혔다.

정점의 레이블이 없는 상황에서 그래프 신경망 모델의 훈련은 데이터 증강을 통해 생성된 정점들의 공통된 특성을 학습하는 과정으로 볼 수 있다. 하지만 이러한 정점의 공통된 특성을 학습하는 과정에서, 기존 훈련 방법은 표상 공간에서 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 하지만 그래프 데이터가 정점들 사이의 관계를 나타내는 데이터 구조라는 점을 고려했을 때, 이런 일차원적인 방법론은 정점 간의 관계를 정확히 반영하지 못하게 된다.

박 교수팀이 개발한 기술은 그래프 신경망 모델에서 정점들 사이의 관계를 보존해 정점의 레이블이 없는 상황에서 모델을 훈련시켜 높은 예측 정확도를 달성할 수 있게 해준다.

KAIST 산업및시스템공학과 이남경 석사과정이 제1 저자, 현동민 박사, 이준석 석사과정 학생이 제2, 제3 저자로 참여한 이번 연구는 최고권위 국제학술대회 `정보지식관리 콘퍼런스(CIKM) 2022'에서 올 10월 발표될 예정이다. (논문명: Relational Self-Supervised Learning on Graphs)

기존 연구에서는 정점의 레이블이 없는 상황에서 정점에 대한 표상을 훈련하기 위해 표상 공간 내에서 자기 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 예를 들어서, 소셜 네트워크에 A, B, C 라는 사용자가 존재할 때, A, B와 C가 표상 공간에서 서로 간의 유사도가 모두 작아지도록 모델을 훈련하는 것이다. 이때 박 교수팀이 착안한 점은 그래프 데이터가 정점 간의 관계를 나타내는 데이터이므로 정점 간의 관계를 포착하도록 정점의 표상을 훈련할 필요가 있다는 점이었다.

즉, A, B와 C 서로 간의 유사도가 모두 작아지게 하는 훈련 메커니즘과는 달리, 실제 그래프상에서는 이들이 연관이 있을 수 있다는 점이다. 따라서 A, B와 C 사이의 관계를 긍정/부정의 이진 분류를 통해 표상 공간에서 유사도가 작아지도록 훈련을 하는 것이 아닌, 이들의 관계를 정의해 그 관계를 보존하도록 학습하는 모델을 연구팀은 개발했다(그림 2). 연구팀은 정점 간의 관계를 기반으로 정점의 표상을 훈련함으로써, 기존 연구가 갖는 엄격한 규제들을 완화해 그래프 데이터를 더 유연하게 모델링했다.

연구팀은 이 학습 방법론을 `관계 보존 학습'이라고 명명했으며, 그래프 데이터 분석의 주요 문제(정점 분류, 간선 예측)에 적용했다(그림 3). 그 결과 최신 연구 방법론과 비교했을 때, 정점 분류 문제에서 최대 3% 예측 정확도를 향상했고, 간선 예측 문제에서 6%의 성능 향상, 다중 연결 네트워크 (Multiplex network)의 정점 분류 문제에서 3%의 성능 향상을 보였다.

제1 저자인 이남경 석사과정은 "이번 기술은 데이터의 레이블이 부재한 상황에서도 그래프 신경망을 학습할 수 있는 새로운 방법ˮ 이라면서 "그래프 기반의 데이터뿐만이 아닌 이미지 텍스트 음성 데이터 등에 폭넓게 적용될 수 있어, 심층 학습 전반적인 성능 개선에 기여할 수 있다ˮ고 밝혔다.

연구팀을 지도한 박찬영 교수도 "이번 기술은 그래프 데이터상에 레이블이 부재한 상황에서 표상 학습 모델을 훈련하는 기존 모델들의 단점들을 `관계 보존`이라는 개념을 통해 보완해 새로운 학습 패러다임을 제시하여 학계에 큰 파급효과를 낼 수 있다ˮ라고 말했다.

한편, 이번 연구는 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 사람중심인공지능핵심원천기술개발 과제로 개발한 연구성과 결과물(No. 2022-0-00157, 강건하고 공정하며 확장 가능한 데이터 중심의 연속 학습)이다.

2022.10.25

조회수 8492

-

상상만으로 원하는 방향으로 사용가능한 로봇 팔 뇌-기계 인터페이스 개발

우리 대학 뇌인지과학과 정재승 교수 연구팀이 인간의 뇌 신호를 해독해 장기간의 훈련 없이 생각만으로 로봇 팔을 원하는 방향으로 제어하는 뇌-기계 인터페이스 시스템을 개발했다고 24일 밝혔다.

서울의대 신경외과 정천기 교수 연구팀과 공동연구로 진행된 이번 연구에서 정 교수 연구팀은 뇌전증 환자를 대상으로 팔을 뻗는 동작을 상상할 때 관측되는 대뇌 피질 신호를 분석해 환자가 의도한 팔 움직임을 예측하는 팔 동작 방향 상상 뇌 신호 디코딩 기술을 개발했다. 이러한 디코딩 기술은 실제 움직임이나 복잡한 운동 상상이 필요하지 않기 때문에 운동장애를 겪는 환자가 장기간 훈련 없이도 자연스럽고 쉽게 로봇 팔을 제어할 수 있어 앞으로 다양한 의료기기에 폭넓게 적용되리라 기대된다.

바이오및뇌공학과 장상진 박사과정이 제1 저자로 참여한 이번 연구는 뇌공학 분야의 세계적인 국제 학술지 `저널 오브 뉴럴 엔지니어링 (Journal of Neural Engineering)' 9월 19권 5호에 출판됐다. (논문명 : Decoding trajectories of imagined hand movement using electrocorticograms for brain-machine interface).

뇌-기계 인터페이스는 인간이 생각만으로 기계를 제어할 수 있는 기술로, 팔을 움직이는 데 장애가 있거나 절단된 환자가 로봇 팔을 제어해 일상에 필요한 팔 동작을 회복할 수 있는 보조기술로 크게 주목받고 있다.

로봇 팔 제어를 위한 뇌-기계 인터페이스를 구현하기 위해서는 인간이 팔을 움직일 때 뇌에서 발생하는 전기신호를 측정하고 기계학습 등 다양한 인공지능 분석기법으로 뇌 신호를 해독해 의도한 움직임을 뇌 신호로부터 예측할 수 있는 디코딩 기술이 필요하다.

그러나 상지 절단 등으로 운동장애를 겪는 환자는 팔을 실제로 움직이기 어려우므로, 상상만으로 로봇 팔의 방향을 지시할 수 있는 인터페이스가 절실히 요구된다. 뇌 신호 디코딩 기술은 팔의 실제 움직임이 아닌 상상 뇌 신호에서 어느 방향으로 사용자가 상상했는지 예측할 수 있어야 하는데, 상상 뇌 신호는 실제 움직임 뇌 신호보다 신호대잡음비(signal to noise ratio)가 현저히 낮아 팔의 정확한 방향을 예측하기 어려운 문제점이 오랫동안 난제였다. 이러한 문제점을 극복하고자 기존 연구들에서는 팔을 움직이기 위해 신호대잡음비가 더 높은 다른 신체 동작을 상상하는 방법을 시도했으나, 의도하고자 하는 팔 뻗기와 인지적 동작 간의 부자연스러운 괴리로 인해 사용자가 장기간 훈련해야 하는 불편함을 초래했다.

따라서 팔을 뻗는 상상을 할 때 어느 방향으로 뻗었는지 예측하는 디코딩 기술은 정확도가 떨어지고 환자가 사용법을 습득하기 어려운 문제점이 있다. 이 문제가 오랫동안 뇌-기계 인터페이스 분야에서 해결해야 할 난제였다.

연구팀은 문제 해결을 위해 사용자의 자연스러운 팔 동작 상상을 공간해상도가 우수한 대뇌 피질 신호(electrocorticogram)로 측정하고, 변분 베이지안 최소제곱(variational Bayesian least square) 기계학습 기법을 활용해 직접 측정이 어려운 팔 동작의 방향 정보를 계산할 수 있는 디코딩 기술을 처음으로 개발했다.

연구팀의 팔 동작 상상 신호 분석기술은 운동피질을 비롯한 특정 대뇌 영역에 국한되지 않아, 사용자마다 상이할 수 있는 상상 신호와 대뇌 영역 특성을 맞춤형으로 학습해 최적의 계산모델 파라미터 결괏값을 출력할 수 있다.

연구팀은 대뇌 피질 신호 디코딩을 통해 환자가 상상한 팔 뻗기 방향을 최대 80% 이상의 정확도로 예측할 수 있음을 확인했다.

나아가 계산모델을 분석함으로써 방향 상상에 중요한 대뇌의 시공간적 특성을 밝혔고, 상상하는 인지적 과정이 팔을 실제로 뻗는 과정에 근접할수록 방향 예측정확도가 상당히 더 높아질 수 있음을 연구팀은 확인했다.

연구팀은 지난 2월 인공지능과 유전자 알고리즘 기반 고 정확도 로봇 팔 제어 뇌-기계 인터페이스 선행 연구 결과를 세계적인 학술지 `어플라이드 소프트 컴퓨팅(Applied soft computing)'에 발표한 바 있다. 이번 후속 연구는 그에 기반해 계산 알고리즘 간소화, 로봇 팔 구동 테스트, 환자의 상상 전략 개선 등 실전에 근접한 사용환경을 조성해 실제로 로봇 팔을 구동하고 의도한 방향으로 로봇 팔이 이동하는지 테스트를 진행했고, 네 가지 방향에 대한 의도를 읽어 정확하게 목표물에 도달하는 시연에 성공했다.

연구팀이 개발한 팔 동작 방향 상상 뇌 신호 분석기술은 향후 사지마비 환자를 비롯한 운동장애를 겪는 환자를 대상으로 로봇 팔을 제어할 수 있는 뇌-기계 인터페이스 정확도 향상, 효율성 개선 등에 이바지할 수 있을 것으로 기대된다.

연구책임자 정재승 교수는 "장애인마다 상이한 뇌 신호를 맞춤형으로 분석해 장기간 훈련을 받지 않더라도 로봇 팔을 제어할 수 있는 기술은 혁신적인 결과이며, 이번 기술은 향후 의수를 대신할 로봇팔을 상용화하는 데에도 크게 기여할 것으로 기대된다ˮ고 말했다.

상상만으로 원하는 방향으로 사용가능한 로봇 팔 뇌-기계 인터페이스 개발

우리 대학 뇌인지과학과 정재승 교수 연구팀이 인간의 뇌 신호를 해독해 장기간의 훈련 없이 생각만으로 로봇 팔을 원하는 방향으로 제어하는 뇌-기계 인터페이스 시스템을 개발했다고 24일 밝혔다.

서울의대 신경외과 정천기 교수 연구팀과 공동연구로 진행된 이번 연구에서 정 교수 연구팀은 뇌전증 환자를 대상으로 팔을 뻗는 동작을 상상할 때 관측되는 대뇌 피질 신호를 분석해 환자가 의도한 팔 움직임을 예측하는 팔 동작 방향 상상 뇌 신호 디코딩 기술을 개발했다. 이러한 디코딩 기술은 실제 움직임이나 복잡한 운동 상상이 필요하지 않기 때문에 운동장애를 겪는 환자가 장기간 훈련 없이도 자연스럽고 쉽게 로봇 팔을 제어할 수 있어 앞으로 다양한 의료기기에 폭넓게 적용되리라 기대된다.

바이오및뇌공학과 장상진 박사과정이 제1 저자로 참여한 이번 연구는 뇌공학 분야의 세계적인 국제 학술지 `저널 오브 뉴럴 엔지니어링 (Journal of Neural Engineering)' 9월 19권 5호에 출판됐다. (논문명 : Decoding trajectories of imagined hand movement using electrocorticograms for brain-machine interface).

뇌-기계 인터페이스는 인간이 생각만으로 기계를 제어할 수 있는 기술로, 팔을 움직이는 데 장애가 있거나 절단된 환자가 로봇 팔을 제어해 일상에 필요한 팔 동작을 회복할 수 있는 보조기술로 크게 주목받고 있다.

로봇 팔 제어를 위한 뇌-기계 인터페이스를 구현하기 위해서는 인간이 팔을 움직일 때 뇌에서 발생하는 전기신호를 측정하고 기계학습 등 다양한 인공지능 분석기법으로 뇌 신호를 해독해 의도한 움직임을 뇌 신호로부터 예측할 수 있는 디코딩 기술이 필요하다.

그러나 상지 절단 등으로 운동장애를 겪는 환자는 팔을 실제로 움직이기 어려우므로, 상상만으로 로봇 팔의 방향을 지시할 수 있는 인터페이스가 절실히 요구된다. 뇌 신호 디코딩 기술은 팔의 실제 움직임이 아닌 상상 뇌 신호에서 어느 방향으로 사용자가 상상했는지 예측할 수 있어야 하는데, 상상 뇌 신호는 실제 움직임 뇌 신호보다 신호대잡음비(signal to noise ratio)가 현저히 낮아 팔의 정확한 방향을 예측하기 어려운 문제점이 오랫동안 난제였다. 이러한 문제점을 극복하고자 기존 연구들에서는 팔을 움직이기 위해 신호대잡음비가 더 높은 다른 신체 동작을 상상하는 방법을 시도했으나, 의도하고자 하는 팔 뻗기와 인지적 동작 간의 부자연스러운 괴리로 인해 사용자가 장기간 훈련해야 하는 불편함을 초래했다.

따라서 팔을 뻗는 상상을 할 때 어느 방향으로 뻗었는지 예측하는 디코딩 기술은 정확도가 떨어지고 환자가 사용법을 습득하기 어려운 문제점이 있다. 이 문제가 오랫동안 뇌-기계 인터페이스 분야에서 해결해야 할 난제였다.

연구팀은 문제 해결을 위해 사용자의 자연스러운 팔 동작 상상을 공간해상도가 우수한 대뇌 피질 신호(electrocorticogram)로 측정하고, 변분 베이지안 최소제곱(variational Bayesian least square) 기계학습 기법을 활용해 직접 측정이 어려운 팔 동작의 방향 정보를 계산할 수 있는 디코딩 기술을 처음으로 개발했다.

연구팀의 팔 동작 상상 신호 분석기술은 운동피질을 비롯한 특정 대뇌 영역에 국한되지 않아, 사용자마다 상이할 수 있는 상상 신호와 대뇌 영역 특성을 맞춤형으로 학습해 최적의 계산모델 파라미터 결괏값을 출력할 수 있다.

연구팀은 대뇌 피질 신호 디코딩을 통해 환자가 상상한 팔 뻗기 방향을 최대 80% 이상의 정확도로 예측할 수 있음을 확인했다.

나아가 계산모델을 분석함으로써 방향 상상에 중요한 대뇌의 시공간적 특성을 밝혔고, 상상하는 인지적 과정이 팔을 실제로 뻗는 과정에 근접할수록 방향 예측정확도가 상당히 더 높아질 수 있음을 연구팀은 확인했다.

연구팀은 지난 2월 인공지능과 유전자 알고리즘 기반 고 정확도 로봇 팔 제어 뇌-기계 인터페이스 선행 연구 결과를 세계적인 학술지 `어플라이드 소프트 컴퓨팅(Applied soft computing)'에 발표한 바 있다. 이번 후속 연구는 그에 기반해 계산 알고리즘 간소화, 로봇 팔 구동 테스트, 환자의 상상 전략 개선 등 실전에 근접한 사용환경을 조성해 실제로 로봇 팔을 구동하고 의도한 방향으로 로봇 팔이 이동하는지 테스트를 진행했고, 네 가지 방향에 대한 의도를 읽어 정확하게 목표물에 도달하는 시연에 성공했다.

연구팀이 개발한 팔 동작 방향 상상 뇌 신호 분석기술은 향후 사지마비 환자를 비롯한 운동장애를 겪는 환자를 대상으로 로봇 팔을 제어할 수 있는 뇌-기계 인터페이스 정확도 향상, 효율성 개선 등에 이바지할 수 있을 것으로 기대된다.

연구책임자 정재승 교수는 "장애인마다 상이한 뇌 신호를 맞춤형으로 분석해 장기간 훈련을 받지 않더라도 로봇 팔을 제어할 수 있는 기술은 혁신적인 결과이며, 이번 기술은 향후 의수를 대신할 로봇팔을 상용화하는 데에도 크게 기여할 것으로 기대된다ˮ고 말했다.

2022.10.24

조회수 10756

-

인공지능 심층 학습(딥러닝) 서비스 구축 비용 최소화 가능한 데이터 정제 기술 개발

최근 다양한 분야에서 인공지능 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서 인공지능은 심층신경망을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 고양이 사진에 `고양이'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간적 비용이 소요된다. 따라서 훈련 데이터 구축 비용을 최소화하는 방법 개발이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 심층 학습 훈련 데이터 구축 비용을 최소화할 수 있는 새로운 데이터 동시 정제 및 선택 기술을 개발했다고 12일 밝혔다.

일반적으로 심층 학습용 훈련 데이터 구축 과정은 수집, 정제, 선택 및 레이블링 단계로 이뤄진다. 수집 단계에서는 웹, 카메라, 센서 등으로부터 대용량의 데이터가 정제되지 않은 채로 수집된다. 따라서 수집된 데이터에는 목표 서비스와 관련이 없어서 주어진 레이블에 해당하지 않는 분포 외(out-of-distribution) 데이터가 포함된다 (예를 들어, 동물 사진을 수집할 때 재규어 `자동차'가 포함됨). 이러한 분포 외 데이터는 데이터 정제 단계에서 정제돼야 한다. 모든 정제된 데이터에 정답지를 만들기 위해서는 막대한 비용이 소모되는데, 이를 최소화하기 위해 심층 학습 성능 향상에 가장 도움이 되는 훈련 데이터를 먼저 선택해 레이블링하는 능동 학습(active learning)이 큰 주목을 받고 있다. 그러나 정제와 레이블링을 별도로 진행하는 것은 데이터 검사 측면에서 중복적인 비용을 초래한다. 또한 아직 정제되지 않고 남아 있는 분포 외 데이터가 레이블링 단계에서 선택된다면 레이블링 노력을 낭비할 수 있다.

이재길 교수팀이 개발한 기술은 훈련 데이터 구축 단계에서 데이터의 정제 및 선택을 동시에 수행해 심층 학습용 훈련 데이터 구축 비용을 최소화할 수 있도록 해준다.

우리 대학 데이터사이언스대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 신유주 박사과정, 이영준 박사과정 학생이 제2, 제4 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2022'에서 올 12월 발표될 예정이다. (논문명 : Meta-Query-Net: Resolving Purity-Informativeness Dilemma in Open-set Active Learning)

데이터의 정제 및 선택을 동시에 고려하기 위해서 구체적으로 가장 분포 외 데이터가 아닐 것 같은 데이터 중에서 가장 심층 학습 성능 향상에 도움이 될 데이터를 선택한다. 즉, 주어진 훈련 데이터 구축 비용 내에서 최고의 효과를 내도록 데이터의 순도(purity) 지표와 정보도(informativeness) 지표의 최적 균형(trade-off)을 찾는다. 순도와 정보도는 일반적으로 서로 상충하므로 최적 균형을 찾는 것이 간단하지 않다. 이 교수팀은 이러한 최적 균형이 정제 전 데이터의 분포 외 데이터 비율과 현재 심층신경망 훈련 정도에 따라 달라진다는 점을 발견했다.

이 교수팀은 이러한 최적 균형을 찾아내기 위해 추가적인 작은 신경망 모델을 도입했다. 연구팀은 추가된 모델을 훈련하기 위해 능동 학습에서 여러 단계에 걸쳐 데이터를 선별하는 과정을 활용했다. 즉, 새롭게 선택돼 레이블링 된 데이터를 순도-정보도 최적 균형을 찾기 위한 훈련 데이터로 활용했고, 레이블이 추가될 때마다 최적 균형을 갱신했다. 이러한 방법은 목표 심층신경망의 성능 향상을 위해 추가적인 상위 레벨의 신경망을 사용하였다는 점에서 메타학습(meta-learning)의 일종이라 볼 수 있다.

연구팀은 이 메타학습 방법론을 `메타 질의 네트워크'라고 이름 붙이고 이미지 분류 문제에 대해 다양한 데이터와 광범위한 분포 외 데이터 비율에 걸쳐 방법론을 검증했다. 그 결과, 기존 최신 방법론과 비교했을 때 최대 20% 향상된 최종 예측 정확도를 향상했고, 모든 범위의 분포 외 데이터 비율에서 일관되게 최고 성능을 보였다. 또한, `메타 질의 네트워크'의 최적 균형 분석을 통해, 분포 외 데이터의 비율이 낮고 현재 심층신경망의 성능이 높을수록 정보도에 높은 가중치를 둬야 함을 연구팀은 밝혀냈다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 실세계 능동 학습에서의 순도-정보도 딜레마를 발견하고 해결한 획기적인 방법ˮ 이라면서 "다양한 데이터 분포 상황에서의 강건성이 검증됐기 때문에, 실생활의 기계 학습 문제에 폭넓게 적용될 수 있어 전반적인 심층 학습의 훈련 데이터 준비 비용 절감에 기여할 것ˮ 이라고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

인공지능 심층 학습(딥러닝) 서비스 구축 비용 최소화 가능한 데이터 정제 기술 개발

최근 다양한 분야에서 인공지능 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서 인공지능은 심층신경망을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 고양이 사진에 `고양이'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간적 비용이 소요된다. 따라서 훈련 데이터 구축 비용을 최소화하는 방법 개발이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 심층 학습 훈련 데이터 구축 비용을 최소화할 수 있는 새로운 데이터 동시 정제 및 선택 기술을 개발했다고 12일 밝혔다.

일반적으로 심층 학습용 훈련 데이터 구축 과정은 수집, 정제, 선택 및 레이블링 단계로 이뤄진다. 수집 단계에서는 웹, 카메라, 센서 등으로부터 대용량의 데이터가 정제되지 않은 채로 수집된다. 따라서 수집된 데이터에는 목표 서비스와 관련이 없어서 주어진 레이블에 해당하지 않는 분포 외(out-of-distribution) 데이터가 포함된다 (예를 들어, 동물 사진을 수집할 때 재규어 `자동차'가 포함됨). 이러한 분포 외 데이터는 데이터 정제 단계에서 정제돼야 한다. 모든 정제된 데이터에 정답지를 만들기 위해서는 막대한 비용이 소모되는데, 이를 최소화하기 위해 심층 학습 성능 향상에 가장 도움이 되는 훈련 데이터를 먼저 선택해 레이블링하는 능동 학습(active learning)이 큰 주목을 받고 있다. 그러나 정제와 레이블링을 별도로 진행하는 것은 데이터 검사 측면에서 중복적인 비용을 초래한다. 또한 아직 정제되지 않고 남아 있는 분포 외 데이터가 레이블링 단계에서 선택된다면 레이블링 노력을 낭비할 수 있다.

이재길 교수팀이 개발한 기술은 훈련 데이터 구축 단계에서 데이터의 정제 및 선택을 동시에 수행해 심층 학습용 훈련 데이터 구축 비용을 최소화할 수 있도록 해준다.

우리 대학 데이터사이언스대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 신유주 박사과정, 이영준 박사과정 학생이 제2, 제4 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2022'에서 올 12월 발표될 예정이다. (논문명 : Meta-Query-Net: Resolving Purity-Informativeness Dilemma in Open-set Active Learning)

데이터의 정제 및 선택을 동시에 고려하기 위해서 구체적으로 가장 분포 외 데이터가 아닐 것 같은 데이터 중에서 가장 심층 학습 성능 향상에 도움이 될 데이터를 선택한다. 즉, 주어진 훈련 데이터 구축 비용 내에서 최고의 효과를 내도록 데이터의 순도(purity) 지표와 정보도(informativeness) 지표의 최적 균형(trade-off)을 찾는다. 순도와 정보도는 일반적으로 서로 상충하므로 최적 균형을 찾는 것이 간단하지 않다. 이 교수팀은 이러한 최적 균형이 정제 전 데이터의 분포 외 데이터 비율과 현재 심층신경망 훈련 정도에 따라 달라진다는 점을 발견했다.

이 교수팀은 이러한 최적 균형을 찾아내기 위해 추가적인 작은 신경망 모델을 도입했다. 연구팀은 추가된 모델을 훈련하기 위해 능동 학습에서 여러 단계에 걸쳐 데이터를 선별하는 과정을 활용했다. 즉, 새롭게 선택돼 레이블링 된 데이터를 순도-정보도 최적 균형을 찾기 위한 훈련 데이터로 활용했고, 레이블이 추가될 때마다 최적 균형을 갱신했다. 이러한 방법은 목표 심층신경망의 성능 향상을 위해 추가적인 상위 레벨의 신경망을 사용하였다는 점에서 메타학습(meta-learning)의 일종이라 볼 수 있다.

연구팀은 이 메타학습 방법론을 `메타 질의 네트워크'라고 이름 붙이고 이미지 분류 문제에 대해 다양한 데이터와 광범위한 분포 외 데이터 비율에 걸쳐 방법론을 검증했다. 그 결과, 기존 최신 방법론과 비교했을 때 최대 20% 향상된 최종 예측 정확도를 향상했고, 모든 범위의 분포 외 데이터 비율에서 일관되게 최고 성능을 보였다. 또한, `메타 질의 네트워크'의 최적 균형 분석을 통해, 분포 외 데이터의 비율이 낮고 현재 심층신경망의 성능이 높을수록 정보도에 높은 가중치를 둬야 함을 연구팀은 밝혀냈다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 실세계 능동 학습에서의 순도-정보도 딜레마를 발견하고 해결한 획기적인 방법ˮ 이라면서 "다양한 데이터 분포 상황에서의 강건성이 검증됐기 때문에, 실생활의 기계 학습 문제에 폭넓게 적용될 수 있어 전반적인 심층 학습의 훈련 데이터 준비 비용 절감에 기여할 것ˮ 이라고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2022.10.12

조회수 9575

-

스마트폰 위 인공지능(AI) 연합학습 속도 4.5배 획기적 향상기법 개발

우리 대학 전기및전자공학부 이성주 교수 연구팀이 국제공동연구를 통해 다수의 모바일 기기 위에서 인공지능(AI) 모델을 학습할 수 있는 연합학습 기술의 학습 속도를 4.5배 가속할 수 있는 방법론을 개발했다고 2일 밝혔다.

이성주 교수 연구팀은 지난 6/27~7/1에 열린 세계컴퓨터연합회(ACM) 주최로 진행된 제20회 모바일 시스템, 어플리케이션, 및 서비스 국제학술대회(MobiSys, International Conference on Mobile Systems, Applications, and Services)에서 연합학습(Federated Learning)의 학습 속도 향상(4.5배 가속)을 위한 데이터 샘플 최적 선택 및 데드라인 조절 방법론을 발표했다. 이 학회는 2003년에 시작됐으며 모바일 시스템, 소프트웨어, 어플리케이션, 서비스를 위한 최신 연구를 소개하는 데 초점을 맞추고 있으며, 모바일 컴퓨팅 및 시스템 분야의 최우수 학회 중 하나로 오랫동안 주목받고 있다.

이번 논문(FedBalancer: Data and Pace Control for Efficient Federated Learning on Heterogeneous Clients)은 KAIST 전산학부 신재민 박사과정이 제1 저자로 참여했으며, 중국 칭화대학과의 국제협력으로 이루어진 성과다 (칭화대학교 위안춘 리(Yuanchun Li) 교수, 윤신 리우(Yunxin Liu) 교수 참여).

최근 구글에 의해 제안된 연합학습은 새로운 기계학습 기술로, 개인정보의 유출 없이 방대한 사용자 기기 위 데이터를 활용할 수 있게 하여 의료 인공지능 기술 등 새로운 인공지능 서비스를 개발할 수 있게 해 각광받고 있다. 연합학습은 구글을 비롯해 애플, 타오바오 등 세계적 빅테크 기업들이 널리 도입하고 있으나, 실제로는 인공지능 모델 학습이 사용자의 스마트폰 위에서 이뤄져, 기기에 과부하를 일으켜 배터리 소모, 성능 저하 등이 발생할 수 있는 우려를 안고 있다.

이성주 교수 연구팀은 연합학습에 참여하는 사용자 기기 위 데이터 샘플 각각의 학습 기여도 측정을 기반으로 최적의 샘플을 선택함으로써 연합학습 속도 향상을 달성했다. 또한, 샘플 선택으로 줄어든 학습 시간에 대응해, 연합학습 라운드의 데드라인 또한 최적으로 조절하는 기법을 제안해 모델 정확도의 저하 없이 학습 속도를 무려 4.5배 높였다. 이러한 방법론의 적용을 통해 연합학습으로 인한 사용자 스마트폰 과부하 문제를 최소화할 수 있을 것으로 기대된다.

이성주 교수는 "연합학습은 많은 세계적 기업들이 사용하는 중요한 기술이다ˮ며 "이번 연구 결과는 연합학습의 학습 속도를 향상하고 활용도를 높여 의미가 있으며, 컴퓨터 비전, 자연어 처리, 모바일 센서 데이터 등 다양한 응용에서 모두 좋은 성능을 보여, 빠른 파급효과를 기대한다ˮ라고 소감을 밝혔다.

한편 이 연구는 과학기술정보통신부의 재원으로 한국연구재단과 정보통신기술진흥센터의 지원을 받아 수행됐다.

스마트폰 위 인공지능(AI) 연합학습 속도 4.5배 획기적 향상기법 개발

우리 대학 전기및전자공학부 이성주 교수 연구팀이 국제공동연구를 통해 다수의 모바일 기기 위에서 인공지능(AI) 모델을 학습할 수 있는 연합학습 기술의 학습 속도를 4.5배 가속할 수 있는 방법론을 개발했다고 2일 밝혔다.

이성주 교수 연구팀은 지난 6/27~7/1에 열린 세계컴퓨터연합회(ACM) 주최로 진행된 제20회 모바일 시스템, 어플리케이션, 및 서비스 국제학술대회(MobiSys, International Conference on Mobile Systems, Applications, and Services)에서 연합학습(Federated Learning)의 학습 속도 향상(4.5배 가속)을 위한 데이터 샘플 최적 선택 및 데드라인 조절 방법론을 발표했다. 이 학회는 2003년에 시작됐으며 모바일 시스템, 소프트웨어, 어플리케이션, 서비스를 위한 최신 연구를 소개하는 데 초점을 맞추고 있으며, 모바일 컴퓨팅 및 시스템 분야의 최우수 학회 중 하나로 오랫동안 주목받고 있다.

이번 논문(FedBalancer: Data and Pace Control for Efficient Federated Learning on Heterogeneous Clients)은 KAIST 전산학부 신재민 박사과정이 제1 저자로 참여했으며, 중국 칭화대학과의 국제협력으로 이루어진 성과다 (칭화대학교 위안춘 리(Yuanchun Li) 교수, 윤신 리우(Yunxin Liu) 교수 참여).

최근 구글에 의해 제안된 연합학습은 새로운 기계학습 기술로, 개인정보의 유출 없이 방대한 사용자 기기 위 데이터를 활용할 수 있게 하여 의료 인공지능 기술 등 새로운 인공지능 서비스를 개발할 수 있게 해 각광받고 있다. 연합학습은 구글을 비롯해 애플, 타오바오 등 세계적 빅테크 기업들이 널리 도입하고 있으나, 실제로는 인공지능 모델 학습이 사용자의 스마트폰 위에서 이뤄져, 기기에 과부하를 일으켜 배터리 소모, 성능 저하 등이 발생할 수 있는 우려를 안고 있다.

이성주 교수 연구팀은 연합학습에 참여하는 사용자 기기 위 데이터 샘플 각각의 학습 기여도 측정을 기반으로 최적의 샘플을 선택함으로써 연합학습 속도 향상을 달성했다. 또한, 샘플 선택으로 줄어든 학습 시간에 대응해, 연합학습 라운드의 데드라인 또한 최적으로 조절하는 기법을 제안해 모델 정확도의 저하 없이 학습 속도를 무려 4.5배 높였다. 이러한 방법론의 적용을 통해 연합학습으로 인한 사용자 스마트폰 과부하 문제를 최소화할 수 있을 것으로 기대된다.

이성주 교수는 "연합학습은 많은 세계적 기업들이 사용하는 중요한 기술이다ˮ며 "이번 연구 결과는 연합학습의 학습 속도를 향상하고 활용도를 높여 의미가 있으며, 컴퓨터 비전, 자연어 처리, 모바일 센서 데이터 등 다양한 응용에서 모두 좋은 성능을 보여, 빠른 파급효과를 기대한다ˮ라고 소감을 밝혔다.

한편 이 연구는 과학기술정보통신부의 재원으로 한국연구재단과 정보통신기술진흥센터의 지원을 받아 수행됐다.

2022.08.02

조회수 12871

-

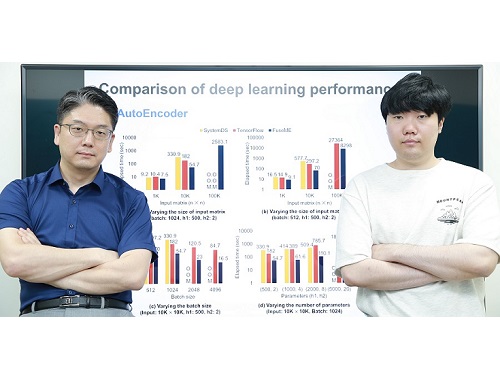

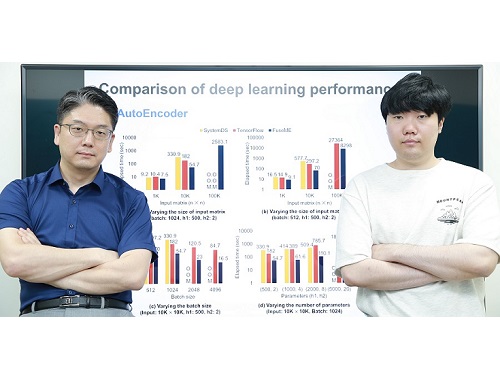

초대규모 인공지능 모델 처리하기 위한 세계 최고 성능의 기계학습 시스템 기술 개발

우리 연구진이 오늘날 인공지능 딥러닝 모델들을 처리하기 위해 필수적으로 사용되는 기계학습 시스템을 세계 최고 수준의 성능으로 끌어올렸다.

우리 대학 전산학부 김민수 교수 연구팀이 딥러닝 모델을 비롯한 기계학습 모델을 학습하거나 추론하기 위해 필수적으로 사용되는 기계학습 시스템의 성능을 대폭 높일 수 있는 세계 최고 수준의 행렬 연산자 융합 기술(일명 FuseME)을 개발했다고 20일 밝혔다.

오늘날 광범위한 산업 분야들에서 사용되고 있는 딥러닝 모델들은 대부분 구글 텐서플로우(TensorFlow)나 IBM 시스템DS와 같은 기계학습 시스템을 이용해 처리되는데, 딥러닝 모델의 규모가 점점 더 커지고, 그 모델에 사용되는 데이터의 규모가 점점 더 커짐에 따라, 이들을 원활히 처리할 수 있는 고성능 기계학습 시스템에 대한 중요성도 점점 더 커지고 있다.

일반적으로 딥러닝 모델은 행렬 곱셈, 행렬 합, 행렬 집계 등의 많은 행렬 연산자들로 구성된 방향성 비순환 그래프(Directed Acyclic Graph; 이하 DAG) 형태의 질의 계획으로 표현돼 기계학습 시스템에 의해 처리된다. 모델과 데이터의 규모가 클 때는 일반적으로 DAG 질의 계획은 수많은 컴퓨터로 구성된 클러스터에서 처리된다. 클러스터의 사양에 비해 모델과 데이터의 규모가 커지면 처리에 실패하거나 시간이 오래 걸리는 근본적인 문제가 있었다.

지금까지는 더 큰 규모의 모델이나 데이터를 처리하기 위해 단순히 컴퓨터 클러스터의 규모를 증가시키는 방식을 주로 사용했다. 그러나, 김 교수팀은 DAG 질의 계획을 구성하는 각 행렬 연산자로부터 생성되는 일종의 `중간 데이터'를 메모리에 저장하거나 네트워크 통신을 통해 다른 컴퓨터로 전송하는 것이 문제의 원인임에 착안해, 중간 데이터를 저장하지 않거나 다른 컴퓨터로 전송하지 않도록 여러 행렬 연산자들을 하나의 연산자로 융합(fusion)하는 세계 최고 성능의 융합 기술인 FuseME(Fused Matrix Engine)을 개발해 문제를 해결했다.

현재까지의 기계학습 시스템들은 낮은 수준의 연산자 융합 기술만을 사용하고 있었다. 가장 복잡한 행렬 연산자인 행렬 곱을 제외한 나머지 연산자들만 융합해 성능이 별로 개선되지 않거나, 전체 DAG 질의 계획을 단순히 하나의 연산자처럼 실행해 메모리 부족으로 처리에 실패하는 한계를 지니고 있었다.

김 교수팀이 개발한 FuseME 기술은 수십 개 이상의 행렬 연산자들로 구성되는 DAG 질의 계획에서 어떤 연산자들끼리 서로 융합하는 것이 더 우수한 성능을 내는지 비용 기반으로 판별해 그룹으로 묶고, 클러스터의 사양, 네트워크 통신 속도, 입력 데이터 크기 등을 모두 고려해 각 융합 연산자 그룹을 메모리 부족으로 처리에 실패하지 않으면서 이론적으로 최적 성능을 낼 수 있는 CFO(Cuboid-based Fused Operator)라 불리는 연산자로 융합함으로써 한계를 극복했다. 이때, 행렬 곱 연산자까지 포함해 연산자들을 융합하는 것이 핵심이다.

김민수 교수 연구팀은 FuseME 기술을 종래 최고 기술로 알려진 구글의 텐서플로우나 IBM의 시스템DS와 비교 평가한 결과, 딥러닝 모델의 처리 속도를 최대 8.8배 향상하고, 텐서플로우나 시스템DS가 처리할 수 없는 훨씬 더 큰 규모의 모델 및 데이터를 처리하는 데 성공함을 보였다. 또한, FuseME의 CFO 융합 연산자는 종래의 최고 수준 융합 연산자와 비교해 처리 속도를 최대 238배 향상시키고, 네트워크 통신 비용을 최대 64배 감소시키는 사실을 확인했다.

김 교수팀은 이미 지난 2019년에 초대규모 행렬 곱 연산에 대해 종래 세계 최고 기술이었던 IBM 시스템ML과 슈퍼컴퓨팅 분야의 스칼라팩(ScaLAPACK) 대비 성능과 처리 규모를 훨씬 향상시킨 DistME라는 기술을 개발해 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표한 바 있다. 이번 FuseME 기술은 연산자 융합이 가능하도록 DistME를 한층 더 발전시킨 것으로, 해당 분야를 세계 최고 수준의 기술력을 바탕으로 지속적으로 선도하는 쾌거를 보여준 것이다.

교신저자로 참여한 김민수 교수는 "연구팀이 개발한 새로운 기술은 딥러닝 등 기계학습 모델의 처리 규모와 성능을 획기적으로 높일 수 있어 산업적 측면에서 파급 효과가 매우 클 것으로 기대한다ˮ 라고 말했다.

이번 연구에는 김 교수의 제자이자 현재 GraphAI(그래파이) 스타트업의 공동 창업자인 한동형 박사가 제1 저자로, 김 교수가 교신저자로 참여했으며 지난 16일 미국 필라델피아에서 열린 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표됐다. (논문명 : FuseME: Distributed Matrix Computation Engine based on Cuboid-based Fused Operator and Plan Generation).

한편, 이번 연구는 한국연구재단 선도연구센터 사업 및 중견연구자 지원사업, 과기정통부 IITP SW스타랩 사업의 지원을 받아 수행됐다.

초대규모 인공지능 모델 처리하기 위한 세계 최고 성능의 기계학습 시스템 기술 개발

우리 연구진이 오늘날 인공지능 딥러닝 모델들을 처리하기 위해 필수적으로 사용되는 기계학습 시스템을 세계 최고 수준의 성능으로 끌어올렸다.

우리 대학 전산학부 김민수 교수 연구팀이 딥러닝 모델을 비롯한 기계학습 모델을 학습하거나 추론하기 위해 필수적으로 사용되는 기계학습 시스템의 성능을 대폭 높일 수 있는 세계 최고 수준의 행렬 연산자 융합 기술(일명 FuseME)을 개발했다고 20일 밝혔다.

오늘날 광범위한 산업 분야들에서 사용되고 있는 딥러닝 모델들은 대부분 구글 텐서플로우(TensorFlow)나 IBM 시스템DS와 같은 기계학습 시스템을 이용해 처리되는데, 딥러닝 모델의 규모가 점점 더 커지고, 그 모델에 사용되는 데이터의 규모가 점점 더 커짐에 따라, 이들을 원활히 처리할 수 있는 고성능 기계학습 시스템에 대한 중요성도 점점 더 커지고 있다.

일반적으로 딥러닝 모델은 행렬 곱셈, 행렬 합, 행렬 집계 등의 많은 행렬 연산자들로 구성된 방향성 비순환 그래프(Directed Acyclic Graph; 이하 DAG) 형태의 질의 계획으로 표현돼 기계학습 시스템에 의해 처리된다. 모델과 데이터의 규모가 클 때는 일반적으로 DAG 질의 계획은 수많은 컴퓨터로 구성된 클러스터에서 처리된다. 클러스터의 사양에 비해 모델과 데이터의 규모가 커지면 처리에 실패하거나 시간이 오래 걸리는 근본적인 문제가 있었다.

지금까지는 더 큰 규모의 모델이나 데이터를 처리하기 위해 단순히 컴퓨터 클러스터의 규모를 증가시키는 방식을 주로 사용했다. 그러나, 김 교수팀은 DAG 질의 계획을 구성하는 각 행렬 연산자로부터 생성되는 일종의 `중간 데이터'를 메모리에 저장하거나 네트워크 통신을 통해 다른 컴퓨터로 전송하는 것이 문제의 원인임에 착안해, 중간 데이터를 저장하지 않거나 다른 컴퓨터로 전송하지 않도록 여러 행렬 연산자들을 하나의 연산자로 융합(fusion)하는 세계 최고 성능의 융합 기술인 FuseME(Fused Matrix Engine)을 개발해 문제를 해결했다.

현재까지의 기계학습 시스템들은 낮은 수준의 연산자 융합 기술만을 사용하고 있었다. 가장 복잡한 행렬 연산자인 행렬 곱을 제외한 나머지 연산자들만 융합해 성능이 별로 개선되지 않거나, 전체 DAG 질의 계획을 단순히 하나의 연산자처럼 실행해 메모리 부족으로 처리에 실패하는 한계를 지니고 있었다.

김 교수팀이 개발한 FuseME 기술은 수십 개 이상의 행렬 연산자들로 구성되는 DAG 질의 계획에서 어떤 연산자들끼리 서로 융합하는 것이 더 우수한 성능을 내는지 비용 기반으로 판별해 그룹으로 묶고, 클러스터의 사양, 네트워크 통신 속도, 입력 데이터 크기 등을 모두 고려해 각 융합 연산자 그룹을 메모리 부족으로 처리에 실패하지 않으면서 이론적으로 최적 성능을 낼 수 있는 CFO(Cuboid-based Fused Operator)라 불리는 연산자로 융합함으로써 한계를 극복했다. 이때, 행렬 곱 연산자까지 포함해 연산자들을 융합하는 것이 핵심이다.

김민수 교수 연구팀은 FuseME 기술을 종래 최고 기술로 알려진 구글의 텐서플로우나 IBM의 시스템DS와 비교 평가한 결과, 딥러닝 모델의 처리 속도를 최대 8.8배 향상하고, 텐서플로우나 시스템DS가 처리할 수 없는 훨씬 더 큰 규모의 모델 및 데이터를 처리하는 데 성공함을 보였다. 또한, FuseME의 CFO 융합 연산자는 종래의 최고 수준 융합 연산자와 비교해 처리 속도를 최대 238배 향상시키고, 네트워크 통신 비용을 최대 64배 감소시키는 사실을 확인했다.

김 교수팀은 이미 지난 2019년에 초대규모 행렬 곱 연산에 대해 종래 세계 최고 기술이었던 IBM 시스템ML과 슈퍼컴퓨팅 분야의 스칼라팩(ScaLAPACK) 대비 성능과 처리 규모를 훨씬 향상시킨 DistME라는 기술을 개발해 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표한 바 있다. 이번 FuseME 기술은 연산자 융합이 가능하도록 DistME를 한층 더 발전시킨 것으로, 해당 분야를 세계 최고 수준의 기술력을 바탕으로 지속적으로 선도하는 쾌거를 보여준 것이다.

교신저자로 참여한 김민수 교수는 "연구팀이 개발한 새로운 기술은 딥러닝 등 기계학습 모델의 처리 규모와 성능을 획기적으로 높일 수 있어 산업적 측면에서 파급 효과가 매우 클 것으로 기대한다ˮ 라고 말했다.

이번 연구에는 김 교수의 제자이자 현재 GraphAI(그래파이) 스타트업의 공동 창업자인 한동형 박사가 제1 저자로, 김 교수가 교신저자로 참여했으며 지난 16일 미국 필라델피아에서 열린 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표됐다. (논문명 : FuseME: Distributed Matrix Computation Engine based on Cuboid-based Fused Operator and Plan Generation).

한편, 이번 연구는 한국연구재단 선도연구센터 사업 및 중견연구자 지원사업, 과기정통부 IITP SW스타랩 사업의 지원을 받아 수행됐다.

2022.06.20

조회수 8908

-

최초 머신러닝 기반 유전체 정렬 소프트웨어 개발

우리 대학 전기및전자공학부 한동수 교수 연구팀이 머신러닝(기계학습)에 기반한 *유전체 정렬 소프트웨어를 개발했다고 12일 밝혔다.

☞ 유전체(genome): 생명체가 가지고 있는 염기서열 정보의 총합이며, 유전자는 생물학적 특징을 발현하는 염기서열들을 지칭한다. 유전체를 한 권의 책이라고 비유하면 유전자는 공백을 제외한 모든 글자라고 비유할 수 있다.

차세대 염기서열 분석은 유전체 정보를 해독하는 방법으로 유전체를 무수히 많은 조각으로 잘라낸 후 각 조각을 참조 유전체(reference genome)에 기반해 조립하는 과정을 거친다. 조립된 유전체 정보는 암을 포함한 여러 질병의 예측과 맞춤형 치료, 백신 개발 등 다양한 분야에서 사용된다.

유전체 정렬 소프트웨어는 차세대 염기서열 분석 방법으로 생성한 유전체 조각 데이터를 온전한 유전체 정보로 조립하기 위해 사용되는 소프트웨어다. 유전체 정렬 작업에는 많은 연산이 들어가며, 속도를 높이고 비용을 낮추는 방법에 관한 관심이 계속해서 증가하고 있다. 머신러닝(기계학습) 기반의 인덱싱(색인) 기법(Learned-index)을 유전체 정렬 소프트웨어에 적용한 사례는 이번이 최초다.

전기및전자공학부 정영목 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `옥스포드 바이오인포메틱스(Oxford Bioinformatics)' 2022년 3월에 공개됐다. (논문명 : BWA-MEME: BWA-MEM emulated with a machine learning approach)

유전체 정렬 작업은 정렬해야 하는 유전체 조각의 양이 많고 참조 유전체의 길이도 길어 많은 연산량이 요구되는 작업이다. 또한, 유전체 정렬 소프트웨어에서 정렬 결과의 정확도에 따라 추후의 유전체 분석의 정확도가 영향을 받는다. 이러한 특성 때문에 유전체 정렬 소프트웨어는 높은 정확성을 유지하며 빠르게 연산하는 것이 중요하다.

일반적으로 유전체 분석에는 하버드 브로드 연구소(Broad Institute)에서 개발한 유전체 분석 도구 키트(Genome Analysis Tool Kit, 이하 GATK)를 이용한 데이터 처리 방법을 표준으로 사용한다. 이들 키트 중 BWA-MEM은 GATK에서 표준으로 채택한 유전체 정렬 소프트웨어이며, 2019년에 하버드 대학과 인텔(Intel)의 공동 연구로 BWA-MEM2가 개발됐다.

연구팀이 개발한 머신러닝 기반의 유전체 정렬 소프트웨어는 연산량을 대폭 줄이면서도 표준 유전체 정렬 소프트웨어 BWA-MEM2과 동일한 결과를 만들어 정확도를 유지했다. 사용한 머신러닝 기반의 인덱싱 기법은 주어진 데이터의 분포를 머신러닝 모델이 학습해, 데이터 분포에 최적화된 인덱싱을 찾는 방법론이다. 데이터에 적합하다고 생각되는 인덱싱 방법을 사람이 정하던 기존의 방법과 대비된다.

BWA-MEM과 BWA-MEM2에서 사용하는 인덱싱 기법(FM-index)은 유전자 조각의 위치를 찾기 위해 유전자 조각 길이만큼의 연산이 필요하지만, 연구팀이 제안한 알고리즘은 머신러닝 기반의 인덱싱 기법(Learned-index)을 활용해, 유전자 조각 길이와 상관없이 적은 연산량으로도 유전자 조각의 위치를 찾을 수 있다. 연구팀이 제안한 인덱싱 기법은 기존 인덱싱 기법과 비교해 3.4배 정도 가속화됐고, 이로 인해 유전체 정렬 소프트웨어는 1.4 배 가속화됐다.

연구팀이 이번 연구에서 개발한 유전체 정렬 소프트웨어는 오픈소스 (https://github.com/kaist-ina/BWA-MEME)로 공개돼 많은 분야에 사용될 것으로 기대되며, 유전체 분석에서 사용되는 다양한 소프트웨어를 머신러닝 기술로 가속화하는 연구들의 초석이 될 것으로 기대된다.

한동수 교수는 "이번 연구를 통해 기계학습 기술을 접목해 전장 유전체 빅데이터 분석을 기존 방식보다 빠르고 적은 비용으로 할 수 있다는 것을 보여줬으며, 앞으로 인공지능 기술을 활용해 전장 유전체 빅데이터 분석을 효율화, 고도화할 수 있을 것이라 기대된다ˮ고 말했다.

한편 이번 연구는 과학기술정보통신부의 재원으로 한국연구재단의 지원을 받아 데이터 스테이션 구축·운영 사업으로서 수행됐다.

최초 머신러닝 기반 유전체 정렬 소프트웨어 개발

우리 대학 전기및전자공학부 한동수 교수 연구팀이 머신러닝(기계학습)에 기반한 *유전체 정렬 소프트웨어를 개발했다고 12일 밝혔다.

☞ 유전체(genome): 생명체가 가지고 있는 염기서열 정보의 총합이며, 유전자는 생물학적 특징을 발현하는 염기서열들을 지칭한다. 유전체를 한 권의 책이라고 비유하면 유전자는 공백을 제외한 모든 글자라고 비유할 수 있다.

차세대 염기서열 분석은 유전체 정보를 해독하는 방법으로 유전체를 무수히 많은 조각으로 잘라낸 후 각 조각을 참조 유전체(reference genome)에 기반해 조립하는 과정을 거친다. 조립된 유전체 정보는 암을 포함한 여러 질병의 예측과 맞춤형 치료, 백신 개발 등 다양한 분야에서 사용된다.

유전체 정렬 소프트웨어는 차세대 염기서열 분석 방법으로 생성한 유전체 조각 데이터를 온전한 유전체 정보로 조립하기 위해 사용되는 소프트웨어다. 유전체 정렬 작업에는 많은 연산이 들어가며, 속도를 높이고 비용을 낮추는 방법에 관한 관심이 계속해서 증가하고 있다. 머신러닝(기계학습) 기반의 인덱싱(색인) 기법(Learned-index)을 유전체 정렬 소프트웨어에 적용한 사례는 이번이 최초다.

전기및전자공학부 정영목 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `옥스포드 바이오인포메틱스(Oxford Bioinformatics)' 2022년 3월에 공개됐다. (논문명 : BWA-MEME: BWA-MEM emulated with a machine learning approach)

유전체 정렬 작업은 정렬해야 하는 유전체 조각의 양이 많고 참조 유전체의 길이도 길어 많은 연산량이 요구되는 작업이다. 또한, 유전체 정렬 소프트웨어에서 정렬 결과의 정확도에 따라 추후의 유전체 분석의 정확도가 영향을 받는다. 이러한 특성 때문에 유전체 정렬 소프트웨어는 높은 정확성을 유지하며 빠르게 연산하는 것이 중요하다.

일반적으로 유전체 분석에는 하버드 브로드 연구소(Broad Institute)에서 개발한 유전체 분석 도구 키트(Genome Analysis Tool Kit, 이하 GATK)를 이용한 데이터 처리 방법을 표준으로 사용한다. 이들 키트 중 BWA-MEM은 GATK에서 표준으로 채택한 유전체 정렬 소프트웨어이며, 2019년에 하버드 대학과 인텔(Intel)의 공동 연구로 BWA-MEM2가 개발됐다.

연구팀이 개발한 머신러닝 기반의 유전체 정렬 소프트웨어는 연산량을 대폭 줄이면서도 표준 유전체 정렬 소프트웨어 BWA-MEM2과 동일한 결과를 만들어 정확도를 유지했다. 사용한 머신러닝 기반의 인덱싱 기법은 주어진 데이터의 분포를 머신러닝 모델이 학습해, 데이터 분포에 최적화된 인덱싱을 찾는 방법론이다. 데이터에 적합하다고 생각되는 인덱싱 방법을 사람이 정하던 기존의 방법과 대비된다.

BWA-MEM과 BWA-MEM2에서 사용하는 인덱싱 기법(FM-index)은 유전자 조각의 위치를 찾기 위해 유전자 조각 길이만큼의 연산이 필요하지만, 연구팀이 제안한 알고리즘은 머신러닝 기반의 인덱싱 기법(Learned-index)을 활용해, 유전자 조각 길이와 상관없이 적은 연산량으로도 유전자 조각의 위치를 찾을 수 있다. 연구팀이 제안한 인덱싱 기법은 기존 인덱싱 기법과 비교해 3.4배 정도 가속화됐고, 이로 인해 유전체 정렬 소프트웨어는 1.4 배 가속화됐다.

연구팀이 이번 연구에서 개발한 유전체 정렬 소프트웨어는 오픈소스 (https://github.com/kaist-ina/BWA-MEME)로 공개돼 많은 분야에 사용될 것으로 기대되며, 유전체 분석에서 사용되는 다양한 소프트웨어를 머신러닝 기술로 가속화하는 연구들의 초석이 될 것으로 기대된다.

한동수 교수는 "이번 연구를 통해 기계학습 기술을 접목해 전장 유전체 빅데이터 분석을 기존 방식보다 빠르고 적은 비용으로 할 수 있다는 것을 보여줬으며, 앞으로 인공지능 기술을 활용해 전장 유전체 빅데이터 분석을 효율화, 고도화할 수 있을 것이라 기대된다ˮ고 말했다.

한편 이번 연구는 과학기술정보통신부의 재원으로 한국연구재단의 지원을 받아 데이터 스테이션 구축·운영 사업으로서 수행됐다.

2022.04.17

조회수 12218

-

강화학습을 활용한 인공지능으로 자유구조 메타표면 최적화 성공

우리 대학 전기및전자공학부 장민석 교수 연구팀이 KC ML2(반도체 제조 솔루션 기업 KC에서 설립한 연구조직) 박찬연 박사와 공동연구를 통해 강화학습에 기반한 자유 구조의 메타 표면 구조 설계 방법을 제안했다고 25일 밝혔다.

메타 표면은 빛의 파장보다 훨씬 작은 크기의 구조를 이용해 이전에 없던 빛의 성질을 달성하는 나노광학 소자를 뜻한다. 나노광학 소자는 빛의 특성을 미시 단위에서 제어하여, 자율주행에 쓰이는 라이다(LiDAR) 빔조향 장치, 초고해상도 이미징 기술, 디스플레이에 활용되는 발광소자의 광특성 제어, 홀로그램 생성 등에 활용될 수 있다. 최근 나노광학 소자에 대한 기대 성능이 높아지면서, 이전에 있던 소자구조를 훨씬 뛰어넘는 성능을 달성하기 위해 자유 구조를 가지는 소자의 최적화에 관한 관심이 증가하고 있다. 자유 구조와 같이 넓은 설계공간을 가진 문제에 대해 강화학습을 적용해 해결한 사례는 이번이 최초다.

우리 대학 서동진 연구원 및 ML2 남원태 연구원이 공동 제1 저자로 참여한 이번 연구는 국제 학술지 `ACS 포토닉스(ACS Photonics)' 2022년 2월호 전면 표지논문으로 게재됐다. (논문명 : Structural Optimization of a One-Dimensional Freeform Metagrating Deflector via Deep Reinforcement Learning)

강화학습은 동물이 학습하는 방법을 모방한 인공지능 방법론이다. 동물 행동 심리학에서 `스키너의 상자'라고 알려진 실험이 그 모티브가 되었는데, 해당 실험은 상자 내부에 쥐를 넣고 누르면 먹이가 나오는 지렛대를 함께 두는 방식으로 진행된다. 처음에 무작위 행동을 하던 쥐는 지렛대를 누르면 먹이가 나오는 것을 확인한다. 시간이 지날수록 더 높은 빈도수로 지렛대를 누르게 되는데, 이렇게 어떠한 보상(먹이)이 행동(지렛대를 누르는 행위)을 `강화'하는 것을 관찰할 수 있다. 해당 실험과 매우 유사한 구조를 갖는 강화학습은 행동 주체가 자기를 둘러싼 `환경'으로부터 `보상'을 받으면서 환경에 대해 배워나가는 인공지능 방법론이다.

2016년 이세돌 9단과의 대국에서 승리한 구글 딥마인드의 `알파고(AlphaGo)'가 그 대표적 사례다. 알파고는 바둑판으로 표현되는 환경과의 상호작용을 통해 바둑의 복잡한 규칙을 학습했고, 우주에 있는 원자보다 많다고 알려진 경우의 수 중 최적에 가까운 선택을 할 수 있었다. 최근 인공지능 학계에서 강화학습은 인간의 지능과 가장 유사한 형태의 인공지능 방법론으로 크게 주목받고 있다.

연구팀은 복잡한 환경을 쉽게 학습할 수 있는 강화학습의 특징을 메타 표면 자유 구조의 최적화에 활용하는 아이디어를 제안했다. 이전에 메타 표면 자유 구조 최적화 기술은 너무 많은 경우의 수로 인해 해결하기 어려운 것으로 여겨졌다. 따라서 기존 연구 방향은 주로 간단한 기본도형 등으로 구조를 단순화한 방식을 활용했다. 하지만 해당 방식은 기하학적 구조가 제한된다는 한계가 있었고, 더욱 복잡한 구조에 대한 최적화 기술은 달성하기 어려운 것으로 여겨졌다.

연구팀이 제안한 알고리즘은 아주 간단한 아이디어에서 출발한다. 강화학습의 `행동'을 구조의 구성요소를 하나씩 `뒤집는' 것으로 정의하는 것이다. 이것은 기존에 구조를 전체적으로 생성하는 방식으로만 생각되었던 자유 구조의 최적화에 대한 발상을 뒤집는 것이었다. 연구팀은 해당 방법을 이용해 메타 표면에 대한 특별한 사전지식 없이도 가능한 구조를 넓게 탐색하고 최적 구조를 발견할 수 있음을 보였다. 또한, 많은 입사 조건에서 최신 성능과 비슷하거나 앞서며 특정 조건에서는 100%에 가까운 효율을 달성했다.

이번 연구를 통해 자유 구조 최적화 분야의 새로운 돌파구를 찾을 것으로 기대되며, 광소자뿐 아니라 많은 분야의 소자 구조 최적화에도 활용될 수 있을 것으로 기대된다.

제1 저자인 서동진 연구원은 "강화학습은 복잡한 환경에서 최적의 경우를 찾는 데에 효과적인 알고리즘이다. 이번 연구에서 해당 방법으로 자유 구조의 최적화를 수행하는 것에 성공하는 사례를 남겨 기쁘다ˮ고 말했다.

장민석 교수는 "광공학에 인공지능 기술을 적용하는 분야에서 좋은 결과가 나와 과학의 위상을 높이는 데 기여하기를 희망한다ˮ고 말했다.

한편 이번 연구는 한국연구재단의 중견연구자지원사업(전략연구), 한-스위스 이노베이션프로그램, 그리고 미래소재디스커버리 사업의 지원을 받아 수행됐다.

강화학습을 활용한 인공지능으로 자유구조 메타표면 최적화 성공

우리 대학 전기및전자공학부 장민석 교수 연구팀이 KC ML2(반도체 제조 솔루션 기업 KC에서 설립한 연구조직) 박찬연 박사와 공동연구를 통해 강화학습에 기반한 자유 구조의 메타 표면 구조 설계 방법을 제안했다고 25일 밝혔다.

메타 표면은 빛의 파장보다 훨씬 작은 크기의 구조를 이용해 이전에 없던 빛의 성질을 달성하는 나노광학 소자를 뜻한다. 나노광학 소자는 빛의 특성을 미시 단위에서 제어하여, 자율주행에 쓰이는 라이다(LiDAR) 빔조향 장치, 초고해상도 이미징 기술, 디스플레이에 활용되는 발광소자의 광특성 제어, 홀로그램 생성 등에 활용될 수 있다. 최근 나노광학 소자에 대한 기대 성능이 높아지면서, 이전에 있던 소자구조를 훨씬 뛰어넘는 성능을 달성하기 위해 자유 구조를 가지는 소자의 최적화에 관한 관심이 증가하고 있다. 자유 구조와 같이 넓은 설계공간을 가진 문제에 대해 강화학습을 적용해 해결한 사례는 이번이 최초다.

우리 대학 서동진 연구원 및 ML2 남원태 연구원이 공동 제1 저자로 참여한 이번 연구는 국제 학술지 `ACS 포토닉스(ACS Photonics)' 2022년 2월호 전면 표지논문으로 게재됐다. (논문명 : Structural Optimization of a One-Dimensional Freeform Metagrating Deflector via Deep Reinforcement Learning)

강화학습은 동물이 학습하는 방법을 모방한 인공지능 방법론이다. 동물 행동 심리학에서 `스키너의 상자'라고 알려진 실험이 그 모티브가 되었는데, 해당 실험은 상자 내부에 쥐를 넣고 누르면 먹이가 나오는 지렛대를 함께 두는 방식으로 진행된다. 처음에 무작위 행동을 하던 쥐는 지렛대를 누르면 먹이가 나오는 것을 확인한다. 시간이 지날수록 더 높은 빈도수로 지렛대를 누르게 되는데, 이렇게 어떠한 보상(먹이)이 행동(지렛대를 누르는 행위)을 `강화'하는 것을 관찰할 수 있다. 해당 실험과 매우 유사한 구조를 갖는 강화학습은 행동 주체가 자기를 둘러싼 `환경'으로부터 `보상'을 받으면서 환경에 대해 배워나가는 인공지능 방법론이다.

2016년 이세돌 9단과의 대국에서 승리한 구글 딥마인드의 `알파고(AlphaGo)'가 그 대표적 사례다. 알파고는 바둑판으로 표현되는 환경과의 상호작용을 통해 바둑의 복잡한 규칙을 학습했고, 우주에 있는 원자보다 많다고 알려진 경우의 수 중 최적에 가까운 선택을 할 수 있었다. 최근 인공지능 학계에서 강화학습은 인간의 지능과 가장 유사한 형태의 인공지능 방법론으로 크게 주목받고 있다.

연구팀은 복잡한 환경을 쉽게 학습할 수 있는 강화학습의 특징을 메타 표면 자유 구조의 최적화에 활용하는 아이디어를 제안했다. 이전에 메타 표면 자유 구조 최적화 기술은 너무 많은 경우의 수로 인해 해결하기 어려운 것으로 여겨졌다. 따라서 기존 연구 방향은 주로 간단한 기본도형 등으로 구조를 단순화한 방식을 활용했다. 하지만 해당 방식은 기하학적 구조가 제한된다는 한계가 있었고, 더욱 복잡한 구조에 대한 최적화 기술은 달성하기 어려운 것으로 여겨졌다.

연구팀이 제안한 알고리즘은 아주 간단한 아이디어에서 출발한다. 강화학습의 `행동'을 구조의 구성요소를 하나씩 `뒤집는' 것으로 정의하는 것이다. 이것은 기존에 구조를 전체적으로 생성하는 방식으로만 생각되었던 자유 구조의 최적화에 대한 발상을 뒤집는 것이었다. 연구팀은 해당 방법을 이용해 메타 표면에 대한 특별한 사전지식 없이도 가능한 구조를 넓게 탐색하고 최적 구조를 발견할 수 있음을 보였다. 또한, 많은 입사 조건에서 최신 성능과 비슷하거나 앞서며 특정 조건에서는 100%에 가까운 효율을 달성했다.

이번 연구를 통해 자유 구조 최적화 분야의 새로운 돌파구를 찾을 것으로 기대되며, 광소자뿐 아니라 많은 분야의 소자 구조 최적화에도 활용될 수 있을 것으로 기대된다.

제1 저자인 서동진 연구원은 "강화학습은 복잡한 환경에서 최적의 경우를 찾는 데에 효과적인 알고리즘이다. 이번 연구에서 해당 방법으로 자유 구조의 최적화를 수행하는 것에 성공하는 사례를 남겨 기쁘다ˮ고 말했다.

장민석 교수는 "광공학에 인공지능 기술을 적용하는 분야에서 좋은 결과가 나와 과학의 위상을 높이는 데 기여하기를 희망한다ˮ고 말했다.

한편 이번 연구는 한국연구재단의 중견연구자지원사업(전략연구), 한-스위스 이노베이션프로그램, 그리고 미래소재디스커버리 사업의 지원을 받아 수행됐다.

2022.02.25

조회수 12718

-

세계 최초 그래프 기반 인공지능 추론 가능한 SSD 개발

우리 대학 전기및전자공학부 정명수 교수 연구팀(컴퓨터 아키텍처 및 메모리 시스템 연구실)이 세계 최초로 그래프 기계학습 추론의 그래프처리, 그래프 샘플링 그리고 신경망 가속을 스토리지/SSD 장치 근처에서 수행하는 `전체론적 그래프 기반 신경망 기계학습 기술(이하 홀리스틱 GNN)'을 개발하는데 성공했다고 10일 밝혔다.

연구팀은 자체 제작한 프로그래밍 가능 반도체(FPGA)를 동반한 새로운 형태의 계산형 스토리지/SSD 시스템에 기계학습 전용 신경망 가속 하드웨어와 그래프 전용 처리 컨트롤러/소프트웨어를 시제작했다. 이는 이상적 상황에서 최신 고성능 엔비디아 GPU를 이용한 기계학습 가속 컴퓨팅 대비 7배의 속도 향상과 33배의 에너지 절약을 가져올 수 있다고 밝혔다.

그래프 자료구조가 적용된 새로운 기계학습 모델은 기존 신경망 기반 기계학습 기법들과 달리, 데이터 사이의 연관 관계를 표현할 수 있어 페이스북, 구글, 링크드인, 우버 등, 대규모 소셜 네트워크 서비스(SNS)부터, 내비게이션, 신약개발 등 광범위한 분야와 응용에서 사용된다. 예를 들면 그래프 구조로 저장된 사용자 네트워크를 분석하는 경우 일반적인 기계학습으로는 불가능했던 현실적인 상품 및 아이템 추천, 사람이 추론한 것 같은 친구 추천 등이 가능하다. 이러한 신흥 그래프 기반 신경망 기계학습은 그간 GPU와 같은 일반 기계학습의 가속 시스템을 재이용해 연산 되어왔는데, 이는 그래프 데이터를 스토리지로부터 메모리로 적재하고 샘플링하는 등의 데이터 전처리 과정에서 심각한 성능 병목현상과 함께 장치 메모리 부족 현상으로 실제 시스템 적용에 한계를 보여 왔다.

정명수 교수 연구팀이 개발한 홀리스틱 GNN 기술은 그래프 데이터 자체가 저장된 스토리지 근처에서 사용자 요청에 따른 추론의 모든 과정을 직접 가속한다. 구체적으로는 프로그래밍 가능한 반도체를 스토리지 근처에 배치한 새로운 계산형 스토리지(Computational SSD) 구조를 활용해 대규모 그래프 데이터의 이동을 제거하고 데이터 근처(Near Storage)에서 그래프처리 및 그래프 샘플링 등을 가속해 그래프 기계학습 전처리 과정에서의 병목현상을 해결했다.

일반적인 계산형 스토리지는 장치 내 고정된 펌웨어와 하드웨어 구성을 통해서 데이터를 처리해야 했기 때문에 그 사용에 제한이 있었다. 그래프처리 및 그래프샘플링 외에도, 연구팀의 홀리스틱 GNN 기술은 인공지능 추론 가속에 필요한 다양한 하드웨어 구조, 그리고 소프트웨어를 후원할 수 있도록 다수 그래프 기계학습 모델을 프로그래밍할 수 있는 장치수준의 소프트웨어와 사용자가 자유롭게 변경할 수 있는 신경망 가속 하드웨어 프레임워크 구조를 제공한다.

연구팀은 홀리스틱 GNN 기술의 실효성을 검증하기 위해 계산형 스토리지의 프로토타입을 자체 제작한 후, 그 위에 개발된 그래프 기계학습용 하드웨어 *RTL과 소프트웨어 프레임워크를 구현해 탑재했다. 그래프 기계학습 추론 성능을 제작된 계산형 스토리지 가속기 프로토타입과 최신 고성능 엔비디아 GPU 가속 시스템(RTX 3090)에서 평가한 결과, 홀리스틱 GNN 기술이 이상적인 상황에서 기존 엔비디아 GPU를 이용해 그래프 기계학습을 가속하는 시스템의 경우에 비해 평균 7배 빠르고 33배 에너지를 감소시킴을 확인했다. 특히, 그래프 규모가 점차 커질수록 전처리 병목현상 완화 효과가 증가해 기존 GPU 대비 최대 201배 향상된 속도와 453배 에너지를 감소할 수 있었다.

☞ RTL (Registor Transistor Logic): 저항과 트랜지스터로 구성한 컴퓨터에 사용되는 회로

정명수 교수는 "대규모 그래프에 대해 스토리지 근처에서 그래프 기계학습을 고속으로 추론할 뿐만 아니라 에너지 절약에 최적화된 계산형 스토리지 가속 시스템을 확보했다ˮ며 "기존 고성능 가속 시스템을 대체해 초대형 추천시스템, 교통 예측 시스템, 신약 개발 등의 광범위한 실제 응용에 적용될 수 있을 것ˮ이라고 말했다.

한편 이번 연구는 미국 산호세에서 오는 2월에 열릴 스토리지 시스템 분야 최우수 학술대회인 `유즈닉스 패스트(USENIX Conference on File and Storage Technologies, FAST), 2022'에 관련 논문(논문명: Hardware/Software Co-Programmable Framework for Computational SSDs to Accelerate Deep Learning Service on Large-Scale Graphs)으로 발표될 예정이다.

해당 연구는 삼성미래기술육성사업 지원을 받아 진행됐고 자세한 내용은 연구실 웹사이트(http://camelab.org)에서 확인할 수 있다.

세계 최초 그래프 기반 인공지능 추론 가능한 SSD 개발

우리 대학 전기및전자공학부 정명수 교수 연구팀(컴퓨터 아키텍처 및 메모리 시스템 연구실)이 세계 최초로 그래프 기계학습 추론의 그래프처리, 그래프 샘플링 그리고 신경망 가속을 스토리지/SSD 장치 근처에서 수행하는 `전체론적 그래프 기반 신경망 기계학습 기술(이하 홀리스틱 GNN)'을 개발하는데 성공했다고 10일 밝혔다.

연구팀은 자체 제작한 프로그래밍 가능 반도체(FPGA)를 동반한 새로운 형태의 계산형 스토리지/SSD 시스템에 기계학습 전용 신경망 가속 하드웨어와 그래프 전용 처리 컨트롤러/소프트웨어를 시제작했다. 이는 이상적 상황에서 최신 고성능 엔비디아 GPU를 이용한 기계학습 가속 컴퓨팅 대비 7배의 속도 향상과 33배의 에너지 절약을 가져올 수 있다고 밝혔다.

그래프 자료구조가 적용된 새로운 기계학습 모델은 기존 신경망 기반 기계학습 기법들과 달리, 데이터 사이의 연관 관계를 표현할 수 있어 페이스북, 구글, 링크드인, 우버 등, 대규모 소셜 네트워크 서비스(SNS)부터, 내비게이션, 신약개발 등 광범위한 분야와 응용에서 사용된다. 예를 들면 그래프 구조로 저장된 사용자 네트워크를 분석하는 경우 일반적인 기계학습으로는 불가능했던 현실적인 상품 및 아이템 추천, 사람이 추론한 것 같은 친구 추천 등이 가능하다. 이러한 신흥 그래프 기반 신경망 기계학습은 그간 GPU와 같은 일반 기계학습의 가속 시스템을 재이용해 연산 되어왔는데, 이는 그래프 데이터를 스토리지로부터 메모리로 적재하고 샘플링하는 등의 데이터 전처리 과정에서 심각한 성능 병목현상과 함께 장치 메모리 부족 현상으로 실제 시스템 적용에 한계를 보여 왔다.

정명수 교수 연구팀이 개발한 홀리스틱 GNN 기술은 그래프 데이터 자체가 저장된 스토리지 근처에서 사용자 요청에 따른 추론의 모든 과정을 직접 가속한다. 구체적으로는 프로그래밍 가능한 반도체를 스토리지 근처에 배치한 새로운 계산형 스토리지(Computational SSD) 구조를 활용해 대규모 그래프 데이터의 이동을 제거하고 데이터 근처(Near Storage)에서 그래프처리 및 그래프 샘플링 등을 가속해 그래프 기계학습 전처리 과정에서의 병목현상을 해결했다.

일반적인 계산형 스토리지는 장치 내 고정된 펌웨어와 하드웨어 구성을 통해서 데이터를 처리해야 했기 때문에 그 사용에 제한이 있었다. 그래프처리 및 그래프샘플링 외에도, 연구팀의 홀리스틱 GNN 기술은 인공지능 추론 가속에 필요한 다양한 하드웨어 구조, 그리고 소프트웨어를 후원할 수 있도록 다수 그래프 기계학습 모델을 프로그래밍할 수 있는 장치수준의 소프트웨어와 사용자가 자유롭게 변경할 수 있는 신경망 가속 하드웨어 프레임워크 구조를 제공한다.

연구팀은 홀리스틱 GNN 기술의 실효성을 검증하기 위해 계산형 스토리지의 프로토타입을 자체 제작한 후, 그 위에 개발된 그래프 기계학습용 하드웨어 *RTL과 소프트웨어 프레임워크를 구현해 탑재했다. 그래프 기계학습 추론 성능을 제작된 계산형 스토리지 가속기 프로토타입과 최신 고성능 엔비디아 GPU 가속 시스템(RTX 3090)에서 평가한 결과, 홀리스틱 GNN 기술이 이상적인 상황에서 기존 엔비디아 GPU를 이용해 그래프 기계학습을 가속하는 시스템의 경우에 비해 평균 7배 빠르고 33배 에너지를 감소시킴을 확인했다. 특히, 그래프 규모가 점차 커질수록 전처리 병목현상 완화 효과가 증가해 기존 GPU 대비 최대 201배 향상된 속도와 453배 에너지를 감소할 수 있었다.

☞ RTL (Registor Transistor Logic): 저항과 트랜지스터로 구성한 컴퓨터에 사용되는 회로

정명수 교수는 "대규모 그래프에 대해 스토리지 근처에서 그래프 기계학습을 고속으로 추론할 뿐만 아니라 에너지 절약에 최적화된 계산형 스토리지 가속 시스템을 확보했다ˮ며 "기존 고성능 가속 시스템을 대체해 초대형 추천시스템, 교통 예측 시스템, 신약 개발 등의 광범위한 실제 응용에 적용될 수 있을 것ˮ이라고 말했다.

한편 이번 연구는 미국 산호세에서 오는 2월에 열릴 스토리지 시스템 분야 최우수 학술대회인 `유즈닉스 패스트(USENIX Conference on File and Storage Technologies, FAST), 2022'에 관련 논문(논문명: Hardware/Software Co-Programmable Framework for Computational SSDs to Accelerate Deep Learning Service on Large-Scale Graphs)으로 발표될 예정이다.

해당 연구는 삼성미래기술육성사업 지원을 받아 진행됐고 자세한 내용은 연구실 웹사이트(http://camelab.org)에서 확인할 수 있다.

2022.01.10

조회수 11391

트랜스포머 대체할 차세대 월드모델 기술 세계 최초 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스 대학교와 협력하여 트랜스포머 및 재귀신경망 기반의 월드모델을 대체할 차세대 에이전트 월드모델 기술을 세계 최초로 개발했다.

월드모델은 인간의 뇌가 현실 세계의 경험을 바탕으로 환경 모델을 구축하는 과정과 유사하다. 이러한 월드모델을 활용하는 인공지능은 특정 행동의 결과를 미리 시뮬레이션해보고 다양한 가설을 검증할 수 있어, 범용 인공지능의 핵심 구성 요소로 여겨진다.

특히, 로봇이나 자율주행 차량과 같은 인공지능 에이전트는 학습을 위해 여러 가지 행동을 시도해 보아야하는데, 이는 위험성과 고장 가능성을 높인다는 단점을 갖는다. 이에 반해, 월드모델을 갖춘 인공지능은 실세계 상호작용 없이도 상상모델 속에서 학습을 가능케 해 큰 이점을 제공한다.

그러나 월드모델은 자연어처리 등에서 큰 발전을 가능하게 한 트랜스포머와 S4와 같은 새로운 시퀀스 모델링 아키텍처의 적용에 한계가 있었다. 이로 인해, 대부분의 월드모델이 성능과 효율성 면에서 제약이 있는 고전적인 재귀적 신경망에 의존하고 있었고 안성진 교수팀은 작년 세계최초로 트랜스포머 기반의 월드모델을 개발하였으나 추론 계산속도나 메모리능력에서 여전히 개선할 문제를 갖고 있었다.

이러한 문제를 해결하기 위해, 안성진 교수가 이끄는 KAIST와 럿거스 대학교 공동연구팀은 재귀적 신경망과 트랜스포머 기반 월드모델의 단점을 극복한 새로운 월드모델의 개발에 성공했다. 연구팀은 S4 시퀀스 모델에 기반한 S4 World Model (S4WM)을 개발하여, 재귀적 신경망의 최대 단점인 병렬처리가 가능한 시퀀스 학습이 불가능하다는 문제를 해결하였다. 또한, 재귀적 신경망의 장점인 빠른 추론시간을 유지하도록 하여 느린 추론 시간을 제공하는 트랜스포머 기반 월드모델의 단점을 극복했다.

연구를 주도한 안성진 교수는 "병렬 학습과 빠른 추론이 가능한 에이전트 월드모델을 세계 최초로 개발했다ˮ며, 이는 "모델기반 강화학습 능력을 획기적으로 개선해 지능형 로봇, 자율주행 차량, 그리고 자율형 인공지능 에이전트 기술 전반에 비용절감과 성능 향상이 예상된다ˮ고 밝혔다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 세계 최고 수준의 인공지능 학회인 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Facing off World Model Backbones: RNNs, Transformers, and S4”Fei Deng, Junyeong Park, Sungjin Ahn, NeurIPS 23, https://arxiv.org/abs/2307.02064

2023.11.09 조회수 7049

트랜스포머 대체할 차세대 월드모델 기술 세계 최초 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스 대학교와 협력하여 트랜스포머 및 재귀신경망 기반의 월드모델을 대체할 차세대 에이전트 월드모델 기술을 세계 최초로 개발했다.

월드모델은 인간의 뇌가 현실 세계의 경험을 바탕으로 환경 모델을 구축하는 과정과 유사하다. 이러한 월드모델을 활용하는 인공지능은 특정 행동의 결과를 미리 시뮬레이션해보고 다양한 가설을 검증할 수 있어, 범용 인공지능의 핵심 구성 요소로 여겨진다.

특히, 로봇이나 자율주행 차량과 같은 인공지능 에이전트는 학습을 위해 여러 가지 행동을 시도해 보아야하는데, 이는 위험성과 고장 가능성을 높인다는 단점을 갖는다. 이에 반해, 월드모델을 갖춘 인공지능은 실세계 상호작용 없이도 상상모델 속에서 학습을 가능케 해 큰 이점을 제공한다.

그러나 월드모델은 자연어처리 등에서 큰 발전을 가능하게 한 트랜스포머와 S4와 같은 새로운 시퀀스 모델링 아키텍처의 적용에 한계가 있었다. 이로 인해, 대부분의 월드모델이 성능과 효율성 면에서 제약이 있는 고전적인 재귀적 신경망에 의존하고 있었고 안성진 교수팀은 작년 세계최초로 트랜스포머 기반의 월드모델을 개발하였으나 추론 계산속도나 메모리능력에서 여전히 개선할 문제를 갖고 있었다.

이러한 문제를 해결하기 위해, 안성진 교수가 이끄는 KAIST와 럿거스 대학교 공동연구팀은 재귀적 신경망과 트랜스포머 기반 월드모델의 단점을 극복한 새로운 월드모델의 개발에 성공했다. 연구팀은 S4 시퀀스 모델에 기반한 S4 World Model (S4WM)을 개발하여, 재귀적 신경망의 최대 단점인 병렬처리가 가능한 시퀀스 학습이 불가능하다는 문제를 해결하였다. 또한, 재귀적 신경망의 장점인 빠른 추론시간을 유지하도록 하여 느린 추론 시간을 제공하는 트랜스포머 기반 월드모델의 단점을 극복했다.

연구를 주도한 안성진 교수는 "병렬 학습과 빠른 추론이 가능한 에이전트 월드모델을 세계 최초로 개발했다ˮ며, 이는 "모델기반 강화학습 능력을 획기적으로 개선해 지능형 로봇, 자율주행 차량, 그리고 자율형 인공지능 에이전트 기술 전반에 비용절감과 성능 향상이 예상된다ˮ고 밝혔다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 세계 최고 수준의 인공지능 학회인 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Facing off World Model Backbones: RNNs, Transformers, and S4”Fei Deng, Junyeong Park, Sungjin Ahn, NeurIPS 23, https://arxiv.org/abs/2307.02064

2023.11.09 조회수 7049 강수 관측 오차범위 42.5% 줄인 알고리즘 개발

강수량의 정확한 파악은 지구의 물 순환을 이해하고 수자원과 재해 대응을 위해 중요하다. 강수량 추정을 위한 알고리즘에는 다양한 방법들이 제안되어 왔으며, 최근에는 기계학습을 이용한 방법들이 많이 제안되고 있다.

우리 대학 문술미래전략대학원(건설및환경공학과 및 녹색성장지속가능대학원 겸임) 김형준 교수와 도쿄대 등으로 구성된 국제 공동연구팀이 인공위성에 탑재된 마이크로파 라디오미터의 관측값을 이용해 지상 강수량을 추정하는 새로운 기계학습 방법을 제안했다고 25일 밝혔다. 연구팀은 기존의 방법과 비교해 전 강수량에 대해 오차(RMSE)를 최소 15.9%에서 최대 42.5%까지 줄이는 데 성공했다.

단순한 데이터 주도(data-driven)모델은 대량의 훈련 데이터가 필요하고 물리적인 일관성이 보장되지 않으며 결과의 원인 분석이 어렵다는 등의 문제가 있었다. 연구팀은 이번 연구에서 위성 강수량 추정에 대한 분야 지식을 명시적으로 포함함으로써 학습 모델 내의 상호 의존적인 지식 교환을 구현했다. 구체적으로, 멀티태스크 학습(multitask learning)이라는 심층 학습 기법을 사용해 강수 여부를 인식하는 분류 모델과 강수 강도를 추정하는 회귀 모델을 통합하고 동시에 학습시켰다.

이번 연구에서 제안한 기계학습 모델에는 이번에 포함된 메커니즘 외에도 다양한 물리적 메커니즘을 포함할 수 있다. 예를 들어, 비 또는 눈, 진눈깨비 등 강수 종류의 분류 및 상승 기류 또는 층상 구름 유형 등 강수를 일으키는 구름 유형의 분류를 포함함으로써 앞으로 추정의 정확도가 더욱 향상될 것으로 기대된다.

김형준 교수의 이번 연구 결과는 국제 학술지 ‘지구물리 연구 레터(Geophysical Research Letters)’에 지난 4월 16일 출판됐다. (논문명: Multi-Task Learning for Simultaneous Retrievals of Passive Microwave Precipitation Estimates and Rain/No-Rain Classification; doi:10.1029/2022GL102283)

한편 이번 연구는 한국연구재단 해외우수과학자유치사업(BP+)와 정보통신기획평가원 인공지능대학원지원(한국과학기술원)지원을 받아 수행됐다.

2023.04.25 조회수 8777

강수 관측 오차범위 42.5% 줄인 알고리즘 개발

강수량의 정확한 파악은 지구의 물 순환을 이해하고 수자원과 재해 대응을 위해 중요하다. 강수량 추정을 위한 알고리즘에는 다양한 방법들이 제안되어 왔으며, 최근에는 기계학습을 이용한 방법들이 많이 제안되고 있다.

우리 대학 문술미래전략대학원(건설및환경공학과 및 녹색성장지속가능대학원 겸임) 김형준 교수와 도쿄대 등으로 구성된 국제 공동연구팀이 인공위성에 탑재된 마이크로파 라디오미터의 관측값을 이용해 지상 강수량을 추정하는 새로운 기계학습 방법을 제안했다고 25일 밝혔다. 연구팀은 기존의 방법과 비교해 전 강수량에 대해 오차(RMSE)를 최소 15.9%에서 최대 42.5%까지 줄이는 데 성공했다.

단순한 데이터 주도(data-driven)모델은 대량의 훈련 데이터가 필요하고 물리적인 일관성이 보장되지 않으며 결과의 원인 분석이 어렵다는 등의 문제가 있었다. 연구팀은 이번 연구에서 위성 강수량 추정에 대한 분야 지식을 명시적으로 포함함으로써 학습 모델 내의 상호 의존적인 지식 교환을 구현했다. 구체적으로, 멀티태스크 학습(multitask learning)이라는 심층 학습 기법을 사용해 강수 여부를 인식하는 분류 모델과 강수 강도를 추정하는 회귀 모델을 통합하고 동시에 학습시켰다.

이번 연구에서 제안한 기계학습 모델에는 이번에 포함된 메커니즘 외에도 다양한 물리적 메커니즘을 포함할 수 있다. 예를 들어, 비 또는 눈, 진눈깨비 등 강수 종류의 분류 및 상승 기류 또는 층상 구름 유형 등 강수를 일으키는 구름 유형의 분류를 포함함으로써 앞으로 추정의 정확도가 더욱 향상될 것으로 기대된다.

김형준 교수의 이번 연구 결과는 국제 학술지 ‘지구물리 연구 레터(Geophysical Research Letters)’에 지난 4월 16일 출판됐다. (논문명: Multi-Task Learning for Simultaneous Retrievals of Passive Microwave Precipitation Estimates and Rain/No-Rain Classification; doi:10.1029/2022GL102283)

한편 이번 연구는 한국연구재단 해외우수과학자유치사업(BP+)와 정보통신기획평가원 인공지능대학원지원(한국과학기술원)지원을 받아 수행됐다.

2023.04.25 조회수 8777 드림워커, 안 보고도 계단을 성큼성큼 걷다

연기가 자욱해 앞이 안보이는 재난 상황에서 별도의 시각이나 촉각 센서의 도움 없이 계단을 오르내리고 나무뿌리와 같은 울퉁불퉁한 환경 등에서 넘어지지 않고 움직이는 사족보행 로봇 기술이 국내 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 명현 교수 연구팀(미래도시 로봇연구실)이 다양한 비정형 환경에서도 강인한 `블라인드 보행(blind locomotion)'을 가능케 하는 보행 로봇 제어 기술을 개발했다고 29일 밝혔다.

연구팀은 사람이 수면 중 깨어서 깜깜한 상태에서 화장실을 갈 때 시각적인 도움이 거의 없이 보행이 가능한 것처럼, 블라인드 보행이 가능하다고 해서 붙여진 ‘드림워크(DreamWaQ)’기술을 개발하였고 이 기술이 적용된 로봇을 ‘드림워커(DreamWaQer)’라고 명명했다. 즉 이 기술을 탑재하면 다양한 형태의 사족보행 로봇 드림워커를 만들어낼 수 있게 되는 것이다.

기존 보행 로봇 제어기는 기구학 또는 동역학 모델을 기반으로 한다. 이를 모델 기반 제어 방식이라고 표현하는데, 특히 야지와 같은 비정형 환경에서 안정적인 보행을 하기 위해서는 모델의 특징 정보를 더욱 빠르게 얻을 수 있어야 한다. 그러나 이는 주변 환경의 인지 능력에 많이 의존하는 모습을 보여 왔다.

이에 비해, 명현 교수 연구팀이 개발한 인공지능 학습 방법 중 하나인 심층 강화학습 기반의 제어기는 시뮬레이터로부터 얻어진 다양한 환경의 데이터를 통해 보행 로봇의 각 모터에 적절한 제어 명령을 빠르게 계산해 줄 수 있다. 시뮬레이션에서 학습된 제어기가 실제 로봇에서 잘 작동하려면 별도의 튜닝 과정이 필요했다면, 연구팀이 개발한 제어기는 별도의 튜닝을 요구하지 않는다는 장점도 있어 다양한 보행 로봇에 쉽게 적용될 수 있을 것으로 기대된다.

연구팀이 개발한 제어기인 드림워크는 크게 지면과 로봇의 정보를 추정하는 상황(context) 추정 네트워크와 제어 명령을 산출하는 정책(policy) 네트워크로 구성된다. 상황추정 네트워크는 관성 정보와 관절 정보들을 통해 암시적으로 지면의 정보를, 명시적으로 로봇의 상태를 추정한다. 이 정보는 정책 네트워크에 입력돼 최적의 제어 명령을 산출하는 데 사용된다. 두 네트워크는 시뮬레이션에서 함께 학습된다.

상황추정 네트워크는 지도학습을 통해 학습되는 반면, 정책 네트워크는 심층 강화학습 방법론인 행동자-비평자(actor-critic) 방식을 통해 학습된다. 행동자 네트워크는 주변 지형 정보를 오직 암시적으로 추정할 수 있다. 시뮬레이션에서는 주변 지형 정보를 알 수 있는데, 지형 정보를 알고 있는 비평자 네트워크가 행동자 네트워크의 정책을 평가한다.

이 모든 학습 과정에는 단 1시간 정도만 소요되며, 실제 로봇에는 학습된 행동자 네트워크만 탑재된다. 주변 지형을 보지 않고도, 오직 로봇 내부의 관성 센서(IMU)와 관절 각도의 측정치를 활용해 시뮬레이션에서 학습한 다양한 환경 중 어느 환경과 유사한지 상상하는 과정을 거친다. 갑자기 계단과 같은 단차를 맞이하는 경우, 발이 단차에 닿기 전까지는 알 수 없지만 발이 닿는 순간 빠르게 지형 정보를 상상한다. 그리고 이렇게 추측된 지형 정보에 알맞은 제어 명령을 각 모터에 전달해 재빠른 적응 보행이 가능하다.

드림워커(DreamWaQer) 로봇은 실험실 환경뿐 아니라, 연석과 과속방지턱이 많은 대학 캠퍼스 환경, 나무뿌리와 자갈이 많은 야지 환경 등에서 보행 시 지면으로부터 몸체까지 높이의 3분의 2 (2/3) 정도의 계단 등을 극복함으로써 강인한 성능을 입증했다. 또한 환경과 무관하게, 0.3m/s의 느린 속도부터 1.0m/s의 다소 빠른 속도까지도 안정적인 보행이 가능함을 연구팀은 확인했다.

이번 연구 결과는 이 마데 아스윈 나렌드라(I Made Aswin Nahrendra) 박사과정이 제1 저자로, 유병호 박사과정이 공동 저자로 참여했으며, 오는 5월 말 영국 런던에서 개최되는 로보틱스 분야의 세계 최고 권위 학회인 ICRA(IEEE International Conference on Robotics and Automation)에 채택되어 발표될 예정이다. (논문명: DreamWaQ: Learning Robust Quadrupedal Locomotion With Implicit Terrain Imagination via Deep Reinforcement Learning)

개발된 드림워크를 탑재한 보행 로봇 드림워커의 구동 및 보행 영상은 아래 주소에서 확인할 수 있다.

메인 영상: https://youtu.be/JC1_bnTxPiQ

쿠키 영상: https://youtu.be/mhUUZVbeDA0

한편, 이번 연구는 산업통상자원부 로봇산업핵심기술개발 사업의 지원을 받아 수행되었다. (과제명: 동적, 비정형 환경에서의 보행 로봇의 자율이동을 위한 이동지능 SW 개발 및 실현장 적용)

2023.03.29 조회수 11005

드림워커, 안 보고도 계단을 성큼성큼 걷다

연기가 자욱해 앞이 안보이는 재난 상황에서 별도의 시각이나 촉각 센서의 도움 없이 계단을 오르내리고 나무뿌리와 같은 울퉁불퉁한 환경 등에서 넘어지지 않고 움직이는 사족보행 로봇 기술이 국내 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 명현 교수 연구팀(미래도시 로봇연구실)이 다양한 비정형 환경에서도 강인한 `블라인드 보행(blind locomotion)'을 가능케 하는 보행 로봇 제어 기술을 개발했다고 29일 밝혔다.

연구팀은 사람이 수면 중 깨어서 깜깜한 상태에서 화장실을 갈 때 시각적인 도움이 거의 없이 보행이 가능한 것처럼, 블라인드 보행이 가능하다고 해서 붙여진 ‘드림워크(DreamWaQ)’기술을 개발하였고 이 기술이 적용된 로봇을 ‘드림워커(DreamWaQer)’라고 명명했다. 즉 이 기술을 탑재하면 다양한 형태의 사족보행 로봇 드림워커를 만들어낼 수 있게 되는 것이다.

기존 보행 로봇 제어기는 기구학 또는 동역학 모델을 기반으로 한다. 이를 모델 기반 제어 방식이라고 표현하는데, 특히 야지와 같은 비정형 환경에서 안정적인 보행을 하기 위해서는 모델의 특징 정보를 더욱 빠르게 얻을 수 있어야 한다. 그러나 이는 주변 환경의 인지 능력에 많이 의존하는 모습을 보여 왔다.

이에 비해, 명현 교수 연구팀이 개발한 인공지능 학습 방법 중 하나인 심층 강화학습 기반의 제어기는 시뮬레이터로부터 얻어진 다양한 환경의 데이터를 통해 보행 로봇의 각 모터에 적절한 제어 명령을 빠르게 계산해 줄 수 있다. 시뮬레이션에서 학습된 제어기가 실제 로봇에서 잘 작동하려면 별도의 튜닝 과정이 필요했다면, 연구팀이 개발한 제어기는 별도의 튜닝을 요구하지 않는다는 장점도 있어 다양한 보행 로봇에 쉽게 적용될 수 있을 것으로 기대된다.

연구팀이 개발한 제어기인 드림워크는 크게 지면과 로봇의 정보를 추정하는 상황(context) 추정 네트워크와 제어 명령을 산출하는 정책(policy) 네트워크로 구성된다. 상황추정 네트워크는 관성 정보와 관절 정보들을 통해 암시적으로 지면의 정보를, 명시적으로 로봇의 상태를 추정한다. 이 정보는 정책 네트워크에 입력돼 최적의 제어 명령을 산출하는 데 사용된다. 두 네트워크는 시뮬레이션에서 함께 학습된다.

상황추정 네트워크는 지도학습을 통해 학습되는 반면, 정책 네트워크는 심층 강화학습 방법론인 행동자-비평자(actor-critic) 방식을 통해 학습된다. 행동자 네트워크는 주변 지형 정보를 오직 암시적으로 추정할 수 있다. 시뮬레이션에서는 주변 지형 정보를 알 수 있는데, 지형 정보를 알고 있는 비평자 네트워크가 행동자 네트워크의 정책을 평가한다.

이 모든 학습 과정에는 단 1시간 정도만 소요되며, 실제 로봇에는 학습된 행동자 네트워크만 탑재된다. 주변 지형을 보지 않고도, 오직 로봇 내부의 관성 센서(IMU)와 관절 각도의 측정치를 활용해 시뮬레이션에서 학습한 다양한 환경 중 어느 환경과 유사한지 상상하는 과정을 거친다. 갑자기 계단과 같은 단차를 맞이하는 경우, 발이 단차에 닿기 전까지는 알 수 없지만 발이 닿는 순간 빠르게 지형 정보를 상상한다. 그리고 이렇게 추측된 지형 정보에 알맞은 제어 명령을 각 모터에 전달해 재빠른 적응 보행이 가능하다.

드림워커(DreamWaQer) 로봇은 실험실 환경뿐 아니라, 연석과 과속방지턱이 많은 대학 캠퍼스 환경, 나무뿌리와 자갈이 많은 야지 환경 등에서 보행 시 지면으로부터 몸체까지 높이의 3분의 2 (2/3) 정도의 계단 등을 극복함으로써 강인한 성능을 입증했다. 또한 환경과 무관하게, 0.3m/s의 느린 속도부터 1.0m/s의 다소 빠른 속도까지도 안정적인 보행이 가능함을 연구팀은 확인했다.

이번 연구 결과는 이 마데 아스윈 나렌드라(I Made Aswin Nahrendra) 박사과정이 제1 저자로, 유병호 박사과정이 공동 저자로 참여했으며, 오는 5월 말 영국 런던에서 개최되는 로보틱스 분야의 세계 최고 권위 학회인 ICRA(IEEE International Conference on Robotics and Automation)에 채택되어 발표될 예정이다. (논문명: DreamWaQ: Learning Robust Quadrupedal Locomotion With Implicit Terrain Imagination via Deep Reinforcement Learning)

개발된 드림워크를 탑재한 보행 로봇 드림워커의 구동 및 보행 영상은 아래 주소에서 확인할 수 있다.

메인 영상: https://youtu.be/JC1_bnTxPiQ

쿠키 영상: https://youtu.be/mhUUZVbeDA0

한편, 이번 연구는 산업통상자원부 로봇산업핵심기술개발 사업의 지원을 받아 수행되었다. (과제명: 동적, 비정형 환경에서의 보행 로봇의 자율이동을 위한 이동지능 SW 개발 및 실현장 적용)

2023.03.29 조회수 11005 ‘라이보’ 로봇, 해변을 거침없이 달리다

우리 대학 기계공학과 황보제민 교수 연구팀이 모래와 같이 변형하는 지형에서도 민첩하고 견고하게 보행할 수 있는 사족 로봇 제어기술을 개발했다고 26일 밝혔다.

황보 교수 연구팀은 모래와 같은 입상 물질로 이루어진 지반에서 로봇 보행체가 받는 힘을 모델링하고, 이를 사족 로봇에 시뮬레이션하는 기술을 개발했다. 또한, 사전 정보 없이도 다양한 지반 종류에 스스로 적응해가며 보행하기에 적합한 인공신경망 구조를 도입해 강화학습에 적용했다. 학습된 신경망 제어기는 해변 모래사장에서의 고속 이동과 에어 매트리스 위에서의 회전을 선보이는 등 변화하는 지형에서의 견고성을 입증해 사족 보행 로봇이 적용될 수 있는 영역을 넓힐 것으로 기대된다.

기계공학과 최수영 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `사이언스 로보틱스(Science Robotics)' 1월 8권 74호에 출판됐다. (논문명 : Learning quadrupedal locomotion on deformable terrain)

강화학습은 임의의 상황에서 여러 행동이 초래하는 결과들의 데이터를 수집하고 이를 사용해 임무를 수행하는 기계를 만드는 학습 방법이다. 이때 필요한 데이터의 양이 많아 실제 환경의 물리 현상을 근사하는 시뮬레이션으로 빠르게 데이터를 모으는 방법이 널리 사용되고 있다.

특히 보행 로봇 분야에서 학습 기반 제어기들은 시뮬레이션에서 수집한 데이터를 통해서 학습된 이후 실제 환경에 적용돼 다양한 지형에서 보행 제어를 성공적으로 수행해 온 바 있다.

다만 학습한 시뮬레이션 환경과 실제 마주친 환경이 다른 경우 학습 기반 제어기의 성능은 급격히 감소하기 때문에, 데이터 수집 단계에서 실제와 유사한 환경을 구현하는 것이 중요하다. 따라서, 변형하는 지형을 극복하는 학습 기반 제어기를 만들기 위해서는 시뮬레이터는 유사한 접촉 경험을 제공해야 한다.

연구팀은 기존 연구에서 밝혀진 입상 매체의 추가 질량 효과를 고려하는 지반 반력 모델을 기반으로 보행체의 운동 역학으로부터 접촉에서 발생하는 힘을 예측하는 접촉 모델을 정의했다.

나아가 시간 단계마다 하나 혹은 여러 개의 접촉에서 발생하는 힘을 풀이함으로써 효율적으로 변형하는 지형을 시뮬레이션했다.

연구팀은 또한 로봇의 센서에서 나오는 시계열 데이터를 분석하는 순환 신경망을 사용함으로써 암시적으로 지반 특성을 예측하는 인공신경망 구조를 도입했다.

학습이 완료된 제어기는 연구팀이 직접 제작한 로봇 `라이보'에 탑재돼 로봇의 발이 완전히 모래에 잠기는 해변 모래사장에서 최대 3.03 m/s의 고속 보행을 선보였으며, 추가 작업 없이 풀밭, 육상 트랙, 단단한 땅에 적용됐을 때도 지반 특성에 적응해 안정하게 주행할 수 있었다.

또한, 에어 매트리스에서 1.54 rad/s(초당 약 90°)의 회전을 안정적으로 수행했으며 갑작스럽게 지형이 부드러워지는 환경도 극복하며 빠른 적응력을 입증했다.

연구팀은 지면을 강체로 간주한 제어기와의 비교를 통해 학습 간 적합한 접촉 경험을 제공하는 것의 중요성을 드러냈으며, 제안한 순환 신경망이 지반 성질에 따라 제어기의 보행 방식을 수정한다는 것을 입증했다.

연구팀이 개발한 시뮬레이션과 학습 방법론은 다양한 보행 로봇이 극복할 수 있는 지형의 범위를 넓힘으로써 로봇이 실제적 임무를 수행하는 데에 이바지할 수 있을 것으로 기대된다.

제1 저자인 최수영 박사과정은 "학습 기반 제어기에 실제의 변형하는 지반과 가까운 접촉 경험을 제공하는 것이 변형하는 지형에 적용하는 데 필수적이라는 것을 보였다ˮ 라며 "제시된 제어기는 지형에 대한 사전 정보 없이 기용될 수 있어 다양한 로봇 보행 연구에 접목될 수 있다ˮ 라고 말했다.

한편 이번 연구는 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

2023.01.26 조회수 10055

‘라이보’ 로봇, 해변을 거침없이 달리다

우리 대학 기계공학과 황보제민 교수 연구팀이 모래와 같이 변형하는 지형에서도 민첩하고 견고하게 보행할 수 있는 사족 로봇 제어기술을 개발했다고 26일 밝혔다.

황보 교수 연구팀은 모래와 같은 입상 물질로 이루어진 지반에서 로봇 보행체가 받는 힘을 모델링하고, 이를 사족 로봇에 시뮬레이션하는 기술을 개발했다. 또한, 사전 정보 없이도 다양한 지반 종류에 스스로 적응해가며 보행하기에 적합한 인공신경망 구조를 도입해 강화학습에 적용했다. 학습된 신경망 제어기는 해변 모래사장에서의 고속 이동과 에어 매트리스 위에서의 회전을 선보이는 등 변화하는 지형에서의 견고성을 입증해 사족 보행 로봇이 적용될 수 있는 영역을 넓힐 것으로 기대된다.

기계공학과 최수영 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `사이언스 로보틱스(Science Robotics)' 1월 8권 74호에 출판됐다. (논문명 : Learning quadrupedal locomotion on deformable terrain)

강화학습은 임의의 상황에서 여러 행동이 초래하는 결과들의 데이터를 수집하고 이를 사용해 임무를 수행하는 기계를 만드는 학습 방법이다. 이때 필요한 데이터의 양이 많아 실제 환경의 물리 현상을 근사하는 시뮬레이션으로 빠르게 데이터를 모으는 방법이 널리 사용되고 있다.

특히 보행 로봇 분야에서 학습 기반 제어기들은 시뮬레이션에서 수집한 데이터를 통해서 학습된 이후 실제 환경에 적용돼 다양한 지형에서 보행 제어를 성공적으로 수행해 온 바 있다.

다만 학습한 시뮬레이션 환경과 실제 마주친 환경이 다른 경우 학습 기반 제어기의 성능은 급격히 감소하기 때문에, 데이터 수집 단계에서 실제와 유사한 환경을 구현하는 것이 중요하다. 따라서, 변형하는 지형을 극복하는 학습 기반 제어기를 만들기 위해서는 시뮬레이터는 유사한 접촉 경험을 제공해야 한다.

연구팀은 기존 연구에서 밝혀진 입상 매체의 추가 질량 효과를 고려하는 지반 반력 모델을 기반으로 보행체의 운동 역학으로부터 접촉에서 발생하는 힘을 예측하는 접촉 모델을 정의했다.

나아가 시간 단계마다 하나 혹은 여러 개의 접촉에서 발생하는 힘을 풀이함으로써 효율적으로 변형하는 지형을 시뮬레이션했다.

연구팀은 또한 로봇의 센서에서 나오는 시계열 데이터를 분석하는 순환 신경망을 사용함으로써 암시적으로 지반 특성을 예측하는 인공신경망 구조를 도입했다.

학습이 완료된 제어기는 연구팀이 직접 제작한 로봇 `라이보'에 탑재돼 로봇의 발이 완전히 모래에 잠기는 해변 모래사장에서 최대 3.03 m/s의 고속 보행을 선보였으며, 추가 작업 없이 풀밭, 육상 트랙, 단단한 땅에 적용됐을 때도 지반 특성에 적응해 안정하게 주행할 수 있었다.

또한, 에어 매트리스에서 1.54 rad/s(초당 약 90°)의 회전을 안정적으로 수행했으며 갑작스럽게 지형이 부드러워지는 환경도 극복하며 빠른 적응력을 입증했다.

연구팀은 지면을 강체로 간주한 제어기와의 비교를 통해 학습 간 적합한 접촉 경험을 제공하는 것의 중요성을 드러냈으며, 제안한 순환 신경망이 지반 성질에 따라 제어기의 보행 방식을 수정한다는 것을 입증했다.

연구팀이 개발한 시뮬레이션과 학습 방법론은 다양한 보행 로봇이 극복할 수 있는 지형의 범위를 넓힘으로써 로봇이 실제적 임무를 수행하는 데에 이바지할 수 있을 것으로 기대된다.

제1 저자인 최수영 박사과정은 "학습 기반 제어기에 실제의 변형하는 지반과 가까운 접촉 경험을 제공하는 것이 변형하는 지형에 적용하는 데 필수적이라는 것을 보였다ˮ 라며 "제시된 제어기는 지형에 대한 사전 정보 없이 기용될 수 있어 다양한 로봇 보행 연구에 접목될 수 있다ˮ 라고 말했다.

한편 이번 연구는 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

2023.01.26 조회수 10055 레이블 없이 훈련 가능한 그래프 신경망 모델 기술 개발

최근 다양한 분야 (소셜 네트워크 분석, 추천시스템 등)에서 그래프 데이터 (그림 1) 의 중요성이 대두되고 있으며, 이에 따라 그래프 신경망(Graph Neural Network) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 소셜 네트워크의 특정 사용자에 `20대'라는 레이블을 부여하는 행위), 이 과정은 일반적으로 수작업으로 진행되므로 노동력과 시간이 소요된다. 따라서 그래프 신경망 모델 훈련 시 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법의 필요성이 대두되고 있다.

우리 대학 산업및시스템공학과 박찬영 교수 연구팀이 데이터의 레이블이 없는 상황에서도 높은 예측 정확도를 달성할 수 있는 새로운 그래프 신경망 모델 훈련 기술을 개발했다고 25일 밝혔다.

정점의 레이블이 없는 상황에서 그래프 신경망 모델의 훈련은 데이터 증강을 통해 생성된 정점들의 공통된 특성을 학습하는 과정으로 볼 수 있다. 하지만 이러한 정점의 공통된 특성을 학습하는 과정에서, 기존 훈련 방법은 표상 공간에서 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 하지만 그래프 데이터가 정점들 사이의 관계를 나타내는 데이터 구조라는 점을 고려했을 때, 이런 일차원적인 방법론은 정점 간의 관계를 정확히 반영하지 못하게 된다.

박 교수팀이 개발한 기술은 그래프 신경망 모델에서 정점들 사이의 관계를 보존해 정점의 레이블이 없는 상황에서 모델을 훈련시켜 높은 예측 정확도를 달성할 수 있게 해준다.

KAIST 산업및시스템공학과 이남경 석사과정이 제1 저자, 현동민 박사, 이준석 석사과정 학생이 제2, 제3 저자로 참여한 이번 연구는 최고권위 국제학술대회 `정보지식관리 콘퍼런스(CIKM) 2022'에서 올 10월 발표될 예정이다. (논문명: Relational Self-Supervised Learning on Graphs)

기존 연구에서는 정점의 레이블이 없는 상황에서 정점에 대한 표상을 훈련하기 위해 표상 공간 내에서 자기 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 예를 들어서, 소셜 네트워크에 A, B, C 라는 사용자가 존재할 때, A, B와 C가 표상 공간에서 서로 간의 유사도가 모두 작아지도록 모델을 훈련하는 것이다. 이때 박 교수팀이 착안한 점은 그래프 데이터가 정점 간의 관계를 나타내는 데이터이므로 정점 간의 관계를 포착하도록 정점의 표상을 훈련할 필요가 있다는 점이었다.

즉, A, B와 C 서로 간의 유사도가 모두 작아지게 하는 훈련 메커니즘과는 달리, 실제 그래프상에서는 이들이 연관이 있을 수 있다는 점이다. 따라서 A, B와 C 사이의 관계를 긍정/부정의 이진 분류를 통해 표상 공간에서 유사도가 작아지도록 훈련을 하는 것이 아닌, 이들의 관계를 정의해 그 관계를 보존하도록 학습하는 모델을 연구팀은 개발했다(그림 2). 연구팀은 정점 간의 관계를 기반으로 정점의 표상을 훈련함으로써, 기존 연구가 갖는 엄격한 규제들을 완화해 그래프 데이터를 더 유연하게 모델링했다.

연구팀은 이 학습 방법론을 `관계 보존 학습'이라고 명명했으며, 그래프 데이터 분석의 주요 문제(정점 분류, 간선 예측)에 적용했다(그림 3). 그 결과 최신 연구 방법론과 비교했을 때, 정점 분류 문제에서 최대 3% 예측 정확도를 향상했고, 간선 예측 문제에서 6%의 성능 향상, 다중 연결 네트워크 (Multiplex network)의 정점 분류 문제에서 3%의 성능 향상을 보였다.

제1 저자인 이남경 석사과정은 "이번 기술은 데이터의 레이블이 부재한 상황에서도 그래프 신경망을 학습할 수 있는 새로운 방법ˮ 이라면서 "그래프 기반의 데이터뿐만이 아닌 이미지 텍스트 음성 데이터 등에 폭넓게 적용될 수 있어, 심층 학습 전반적인 성능 개선에 기여할 수 있다ˮ고 밝혔다.

연구팀을 지도한 박찬영 교수도 "이번 기술은 그래프 데이터상에 레이블이 부재한 상황에서 표상 학습 모델을 훈련하는 기존 모델들의 단점들을 `관계 보존`이라는 개념을 통해 보완해 새로운 학습 패러다임을 제시하여 학계에 큰 파급효과를 낼 수 있다ˮ라고 말했다.

한편, 이번 연구는 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 사람중심인공지능핵심원천기술개발 과제로 개발한 연구성과 결과물(No. 2022-0-00157, 강건하고 공정하며 확장 가능한 데이터 중심의 연속 학습)이다.

2022.10.25 조회수 8492

레이블 없이 훈련 가능한 그래프 신경망 모델 기술 개발

최근 다양한 분야 (소셜 네트워크 분석, 추천시스템 등)에서 그래프 데이터 (그림 1) 의 중요성이 대두되고 있으며, 이에 따라 그래프 신경망(Graph Neural Network) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 소셜 네트워크의 특정 사용자에 `20대'라는 레이블을 부여하는 행위), 이 과정은 일반적으로 수작업으로 진행되므로 노동력과 시간이 소요된다. 따라서 그래프 신경망 모델 훈련 시 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법의 필요성이 대두되고 있다.

우리 대학 산업및시스템공학과 박찬영 교수 연구팀이 데이터의 레이블이 없는 상황에서도 높은 예측 정확도를 달성할 수 있는 새로운 그래프 신경망 모델 훈련 기술을 개발했다고 25일 밝혔다.

정점의 레이블이 없는 상황에서 그래프 신경망 모델의 훈련은 데이터 증강을 통해 생성된 정점들의 공통된 특성을 학습하는 과정으로 볼 수 있다. 하지만 이러한 정점의 공통된 특성을 학습하는 과정에서, 기존 훈련 방법은 표상 공간에서 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 하지만 그래프 데이터가 정점들 사이의 관계를 나타내는 데이터 구조라는 점을 고려했을 때, 이런 일차원적인 방법론은 정점 간의 관계를 정확히 반영하지 못하게 된다.

박 교수팀이 개발한 기술은 그래프 신경망 모델에서 정점들 사이의 관계를 보존해 정점의 레이블이 없는 상황에서 모델을 훈련시켜 높은 예측 정확도를 달성할 수 있게 해준다.

KAIST 산업및시스템공학과 이남경 석사과정이 제1 저자, 현동민 박사, 이준석 석사과정 학생이 제2, 제3 저자로 참여한 이번 연구는 최고권위 국제학술대회 `정보지식관리 콘퍼런스(CIKM) 2022'에서 올 10월 발표될 예정이다. (논문명: Relational Self-Supervised Learning on Graphs)

기존 연구에서는 정점의 레이블이 없는 상황에서 정점에 대한 표상을 훈련하기 위해 표상 공간 내에서 자기 자신을 제외한 다른 정점들과의 유사도가 작아지도록 훈련을 한다. 예를 들어서, 소셜 네트워크에 A, B, C 라는 사용자가 존재할 때, A, B와 C가 표상 공간에서 서로 간의 유사도가 모두 작아지도록 모델을 훈련하는 것이다. 이때 박 교수팀이 착안한 점은 그래프 데이터가 정점 간의 관계를 나타내는 데이터이므로 정점 간의 관계를 포착하도록 정점의 표상을 훈련할 필요가 있다는 점이었다.

즉, A, B와 C 서로 간의 유사도가 모두 작아지게 하는 훈련 메커니즘과는 달리, 실제 그래프상에서는 이들이 연관이 있을 수 있다는 점이다. 따라서 A, B와 C 사이의 관계를 긍정/부정의 이진 분류를 통해 표상 공간에서 유사도가 작아지도록 훈련을 하는 것이 아닌, 이들의 관계를 정의해 그 관계를 보존하도록 학습하는 모델을 연구팀은 개발했다(그림 2). 연구팀은 정점 간의 관계를 기반으로 정점의 표상을 훈련함으로써, 기존 연구가 갖는 엄격한 규제들을 완화해 그래프 데이터를 더 유연하게 모델링했다.

연구팀은 이 학습 방법론을 `관계 보존 학습'이라고 명명했으며, 그래프 데이터 분석의 주요 문제(정점 분류, 간선 예측)에 적용했다(그림 3). 그 결과 최신 연구 방법론과 비교했을 때, 정점 분류 문제에서 최대 3% 예측 정확도를 향상했고, 간선 예측 문제에서 6%의 성능 향상, 다중 연결 네트워크 (Multiplex network)의 정점 분류 문제에서 3%의 성능 향상을 보였다.

제1 저자인 이남경 석사과정은 "이번 기술은 데이터의 레이블이 부재한 상황에서도 그래프 신경망을 학습할 수 있는 새로운 방법ˮ 이라면서 "그래프 기반의 데이터뿐만이 아닌 이미지 텍스트 음성 데이터 등에 폭넓게 적용될 수 있어, 심층 학습 전반적인 성능 개선에 기여할 수 있다ˮ고 밝혔다.

연구팀을 지도한 박찬영 교수도 "이번 기술은 그래프 데이터상에 레이블이 부재한 상황에서 표상 학습 모델을 훈련하는 기존 모델들의 단점들을 `관계 보존`이라는 개념을 통해 보완해 새로운 학습 패러다임을 제시하여 학계에 큰 파급효과를 낼 수 있다ˮ라고 말했다.

한편, 이번 연구는 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 사람중심인공지능핵심원천기술개발 과제로 개발한 연구성과 결과물(No. 2022-0-00157, 강건하고 공정하며 확장 가능한 데이터 중심의 연속 학습)이다.

2022.10.25 조회수 8492 상상만으로 원하는 방향으로 사용가능한 로봇 팔 뇌-기계 인터페이스 개발

우리 대학 뇌인지과학과 정재승 교수 연구팀이 인간의 뇌 신호를 해독해 장기간의 훈련 없이 생각만으로 로봇 팔을 원하는 방향으로 제어하는 뇌-기계 인터페이스 시스템을 개발했다고 24일 밝혔다.

서울의대 신경외과 정천기 교수 연구팀과 공동연구로 진행된 이번 연구에서 정 교수 연구팀은 뇌전증 환자를 대상으로 팔을 뻗는 동작을 상상할 때 관측되는 대뇌 피질 신호를 분석해 환자가 의도한 팔 움직임을 예측하는 팔 동작 방향 상상 뇌 신호 디코딩 기술을 개발했다. 이러한 디코딩 기술은 실제 움직임이나 복잡한 운동 상상이 필요하지 않기 때문에 운동장애를 겪는 환자가 장기간 훈련 없이도 자연스럽고 쉽게 로봇 팔을 제어할 수 있어 앞으로 다양한 의료기기에 폭넓게 적용되리라 기대된다.

바이오및뇌공학과 장상진 박사과정이 제1 저자로 참여한 이번 연구는 뇌공학 분야의 세계적인 국제 학술지 `저널 오브 뉴럴 엔지니어링 (Journal of Neural Engineering)' 9월 19권 5호에 출판됐다. (논문명 : Decoding trajectories of imagined hand movement using electrocorticograms for brain-machine interface).

뇌-기계 인터페이스는 인간이 생각만으로 기계를 제어할 수 있는 기술로, 팔을 움직이는 데 장애가 있거나 절단된 환자가 로봇 팔을 제어해 일상에 필요한 팔 동작을 회복할 수 있는 보조기술로 크게 주목받고 있다.

로봇 팔 제어를 위한 뇌-기계 인터페이스를 구현하기 위해서는 인간이 팔을 움직일 때 뇌에서 발생하는 전기신호를 측정하고 기계학습 등 다양한 인공지능 분석기법으로 뇌 신호를 해독해 의도한 움직임을 뇌 신호로부터 예측할 수 있는 디코딩 기술이 필요하다.

그러나 상지 절단 등으로 운동장애를 겪는 환자는 팔을 실제로 움직이기 어려우므로, 상상만으로 로봇 팔의 방향을 지시할 수 있는 인터페이스가 절실히 요구된다. 뇌 신호 디코딩 기술은 팔의 실제 움직임이 아닌 상상 뇌 신호에서 어느 방향으로 사용자가 상상했는지 예측할 수 있어야 하는데, 상상 뇌 신호는 실제 움직임 뇌 신호보다 신호대잡음비(signal to noise ratio)가 현저히 낮아 팔의 정확한 방향을 예측하기 어려운 문제점이 오랫동안 난제였다. 이러한 문제점을 극복하고자 기존 연구들에서는 팔을 움직이기 위해 신호대잡음비가 더 높은 다른 신체 동작을 상상하는 방법을 시도했으나, 의도하고자 하는 팔 뻗기와 인지적 동작 간의 부자연스러운 괴리로 인해 사용자가 장기간 훈련해야 하는 불편함을 초래했다.

따라서 팔을 뻗는 상상을 할 때 어느 방향으로 뻗었는지 예측하는 디코딩 기술은 정확도가 떨어지고 환자가 사용법을 습득하기 어려운 문제점이 있다. 이 문제가 오랫동안 뇌-기계 인터페이스 분야에서 해결해야 할 난제였다.

연구팀은 문제 해결을 위해 사용자의 자연스러운 팔 동작 상상을 공간해상도가 우수한 대뇌 피질 신호(electrocorticogram)로 측정하고, 변분 베이지안 최소제곱(variational Bayesian least square) 기계학습 기법을 활용해 직접 측정이 어려운 팔 동작의 방향 정보를 계산할 수 있는 디코딩 기술을 처음으로 개발했다.

연구팀의 팔 동작 상상 신호 분석기술은 운동피질을 비롯한 특정 대뇌 영역에 국한되지 않아, 사용자마다 상이할 수 있는 상상 신호와 대뇌 영역 특성을 맞춤형으로 학습해 최적의 계산모델 파라미터 결괏값을 출력할 수 있다.

연구팀은 대뇌 피질 신호 디코딩을 통해 환자가 상상한 팔 뻗기 방향을 최대 80% 이상의 정확도로 예측할 수 있음을 확인했다.

나아가 계산모델을 분석함으로써 방향 상상에 중요한 대뇌의 시공간적 특성을 밝혔고, 상상하는 인지적 과정이 팔을 실제로 뻗는 과정에 근접할수록 방향 예측정확도가 상당히 더 높아질 수 있음을 연구팀은 확인했다.

연구팀은 지난 2월 인공지능과 유전자 알고리즘 기반 고 정확도 로봇 팔 제어 뇌-기계 인터페이스 선행 연구 결과를 세계적인 학술지 `어플라이드 소프트 컴퓨팅(Applied soft computing)'에 발표한 바 있다. 이번 후속 연구는 그에 기반해 계산 알고리즘 간소화, 로봇 팔 구동 테스트, 환자의 상상 전략 개선 등 실전에 근접한 사용환경을 조성해 실제로 로봇 팔을 구동하고 의도한 방향으로 로봇 팔이 이동하는지 테스트를 진행했고, 네 가지 방향에 대한 의도를 읽어 정확하게 목표물에 도달하는 시연에 성공했다.

연구팀이 개발한 팔 동작 방향 상상 뇌 신호 분석기술은 향후 사지마비 환자를 비롯한 운동장애를 겪는 환자를 대상으로 로봇 팔을 제어할 수 있는 뇌-기계 인터페이스 정확도 향상, 효율성 개선 등에 이바지할 수 있을 것으로 기대된다.

연구책임자 정재승 교수는 "장애인마다 상이한 뇌 신호를 맞춤형으로 분석해 장기간 훈련을 받지 않더라도 로봇 팔을 제어할 수 있는 기술은 혁신적인 결과이며, 이번 기술은 향후 의수를 대신할 로봇팔을 상용화하는 데에도 크게 기여할 것으로 기대된다ˮ고 말했다.

2022.10.24 조회수 10756

상상만으로 원하는 방향으로 사용가능한 로봇 팔 뇌-기계 인터페이스 개발

우리 대학 뇌인지과학과 정재승 교수 연구팀이 인간의 뇌 신호를 해독해 장기간의 훈련 없이 생각만으로 로봇 팔을 원하는 방향으로 제어하는 뇌-기계 인터페이스 시스템을 개발했다고 24일 밝혔다.

서울의대 신경외과 정천기 교수 연구팀과 공동연구로 진행된 이번 연구에서 정 교수 연구팀은 뇌전증 환자를 대상으로 팔을 뻗는 동작을 상상할 때 관측되는 대뇌 피질 신호를 분석해 환자가 의도한 팔 움직임을 예측하는 팔 동작 방향 상상 뇌 신호 디코딩 기술을 개발했다. 이러한 디코딩 기술은 실제 움직임이나 복잡한 운동 상상이 필요하지 않기 때문에 운동장애를 겪는 환자가 장기간 훈련 없이도 자연스럽고 쉽게 로봇 팔을 제어할 수 있어 앞으로 다양한 의료기기에 폭넓게 적용되리라 기대된다.

바이오및뇌공학과 장상진 박사과정이 제1 저자로 참여한 이번 연구는 뇌공학 분야의 세계적인 국제 학술지 `저널 오브 뉴럴 엔지니어링 (Journal of Neural Engineering)' 9월 19권 5호에 출판됐다. (논문명 : Decoding trajectories of imagined hand movement using electrocorticograms for brain-machine interface).

뇌-기계 인터페이스는 인간이 생각만으로 기계를 제어할 수 있는 기술로, 팔을 움직이는 데 장애가 있거나 절단된 환자가 로봇 팔을 제어해 일상에 필요한 팔 동작을 회복할 수 있는 보조기술로 크게 주목받고 있다.

로봇 팔 제어를 위한 뇌-기계 인터페이스를 구현하기 위해서는 인간이 팔을 움직일 때 뇌에서 발생하는 전기신호를 측정하고 기계학습 등 다양한 인공지능 분석기법으로 뇌 신호를 해독해 의도한 움직임을 뇌 신호로부터 예측할 수 있는 디코딩 기술이 필요하다.

그러나 상지 절단 등으로 운동장애를 겪는 환자는 팔을 실제로 움직이기 어려우므로, 상상만으로 로봇 팔의 방향을 지시할 수 있는 인터페이스가 절실히 요구된다. 뇌 신호 디코딩 기술은 팔의 실제 움직임이 아닌 상상 뇌 신호에서 어느 방향으로 사용자가 상상했는지 예측할 수 있어야 하는데, 상상 뇌 신호는 실제 움직임 뇌 신호보다 신호대잡음비(signal to noise ratio)가 현저히 낮아 팔의 정확한 방향을 예측하기 어려운 문제점이 오랫동안 난제였다. 이러한 문제점을 극복하고자 기존 연구들에서는 팔을 움직이기 위해 신호대잡음비가 더 높은 다른 신체 동작을 상상하는 방법을 시도했으나, 의도하고자 하는 팔 뻗기와 인지적 동작 간의 부자연스러운 괴리로 인해 사용자가 장기간 훈련해야 하는 불편함을 초래했다.

따라서 팔을 뻗는 상상을 할 때 어느 방향으로 뻗었는지 예측하는 디코딩 기술은 정확도가 떨어지고 환자가 사용법을 습득하기 어려운 문제점이 있다. 이 문제가 오랫동안 뇌-기계 인터페이스 분야에서 해결해야 할 난제였다.

연구팀은 문제 해결을 위해 사용자의 자연스러운 팔 동작 상상을 공간해상도가 우수한 대뇌 피질 신호(electrocorticogram)로 측정하고, 변분 베이지안 최소제곱(variational Bayesian least square) 기계학습 기법을 활용해 직접 측정이 어려운 팔 동작의 방향 정보를 계산할 수 있는 디코딩 기술을 처음으로 개발했다.

연구팀의 팔 동작 상상 신호 분석기술은 운동피질을 비롯한 특정 대뇌 영역에 국한되지 않아, 사용자마다 상이할 수 있는 상상 신호와 대뇌 영역 특성을 맞춤형으로 학습해 최적의 계산모델 파라미터 결괏값을 출력할 수 있다.

연구팀은 대뇌 피질 신호 디코딩을 통해 환자가 상상한 팔 뻗기 방향을 최대 80% 이상의 정확도로 예측할 수 있음을 확인했다.

나아가 계산모델을 분석함으로써 방향 상상에 중요한 대뇌의 시공간적 특성을 밝혔고, 상상하는 인지적 과정이 팔을 실제로 뻗는 과정에 근접할수록 방향 예측정확도가 상당히 더 높아질 수 있음을 연구팀은 확인했다.

연구팀은 지난 2월 인공지능과 유전자 알고리즘 기반 고 정확도 로봇 팔 제어 뇌-기계 인터페이스 선행 연구 결과를 세계적인 학술지 `어플라이드 소프트 컴퓨팅(Applied soft computing)'에 발표한 바 있다. 이번 후속 연구는 그에 기반해 계산 알고리즘 간소화, 로봇 팔 구동 테스트, 환자의 상상 전략 개선 등 실전에 근접한 사용환경을 조성해 실제로 로봇 팔을 구동하고 의도한 방향으로 로봇 팔이 이동하는지 테스트를 진행했고, 네 가지 방향에 대한 의도를 읽어 정확하게 목표물에 도달하는 시연에 성공했다.

연구팀이 개발한 팔 동작 방향 상상 뇌 신호 분석기술은 향후 사지마비 환자를 비롯한 운동장애를 겪는 환자를 대상으로 로봇 팔을 제어할 수 있는 뇌-기계 인터페이스 정확도 향상, 효율성 개선 등에 이바지할 수 있을 것으로 기대된다.

연구책임자 정재승 교수는 "장애인마다 상이한 뇌 신호를 맞춤형으로 분석해 장기간 훈련을 받지 않더라도 로봇 팔을 제어할 수 있는 기술은 혁신적인 결과이며, 이번 기술은 향후 의수를 대신할 로봇팔을 상용화하는 데에도 크게 기여할 것으로 기대된다ˮ고 말했다.

2022.10.24 조회수 10756 인공지능 심층 학습(딥러닝) 서비스 구축 비용 최소화 가능한 데이터 정제 기술 개발

최근 다양한 분야에서 인공지능 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서 인공지능은 심층신경망을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 고양이 사진에 `고양이'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간적 비용이 소요된다. 따라서 훈련 데이터 구축 비용을 최소화하는 방법 개발이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 심층 학습 훈련 데이터 구축 비용을 최소화할 수 있는 새로운 데이터 동시 정제 및 선택 기술을 개발했다고 12일 밝혔다.

일반적으로 심층 학습용 훈련 데이터 구축 과정은 수집, 정제, 선택 및 레이블링 단계로 이뤄진다. 수집 단계에서는 웹, 카메라, 센서 등으로부터 대용량의 데이터가 정제되지 않은 채로 수집된다. 따라서 수집된 데이터에는 목표 서비스와 관련이 없어서 주어진 레이블에 해당하지 않는 분포 외(out-of-distribution) 데이터가 포함된다 (예를 들어, 동물 사진을 수집할 때 재규어 `자동차'가 포함됨). 이러한 분포 외 데이터는 데이터 정제 단계에서 정제돼야 한다. 모든 정제된 데이터에 정답지를 만들기 위해서는 막대한 비용이 소모되는데, 이를 최소화하기 위해 심층 학습 성능 향상에 가장 도움이 되는 훈련 데이터를 먼저 선택해 레이블링하는 능동 학습(active learning)이 큰 주목을 받고 있다. 그러나 정제와 레이블링을 별도로 진행하는 것은 데이터 검사 측면에서 중복적인 비용을 초래한다. 또한 아직 정제되지 않고 남아 있는 분포 외 데이터가 레이블링 단계에서 선택된다면 레이블링 노력을 낭비할 수 있다.

이재길 교수팀이 개발한 기술은 훈련 데이터 구축 단계에서 데이터의 정제 및 선택을 동시에 수행해 심층 학습용 훈련 데이터 구축 비용을 최소화할 수 있도록 해준다.

우리 대학 데이터사이언스대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 신유주 박사과정, 이영준 박사과정 학생이 제2, 제4 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2022'에서 올 12월 발표될 예정이다. (논문명 : Meta-Query-Net: Resolving Purity-Informativeness Dilemma in Open-set Active Learning)

데이터의 정제 및 선택을 동시에 고려하기 위해서 구체적으로 가장 분포 외 데이터가 아닐 것 같은 데이터 중에서 가장 심층 학습 성능 향상에 도움이 될 데이터를 선택한다. 즉, 주어진 훈련 데이터 구축 비용 내에서 최고의 효과를 내도록 데이터의 순도(purity) 지표와 정보도(informativeness) 지표의 최적 균형(trade-off)을 찾는다. 순도와 정보도는 일반적으로 서로 상충하므로 최적 균형을 찾는 것이 간단하지 않다. 이 교수팀은 이러한 최적 균형이 정제 전 데이터의 분포 외 데이터 비율과 현재 심층신경망 훈련 정도에 따라 달라진다는 점을 발견했다.

이 교수팀은 이러한 최적 균형을 찾아내기 위해 추가적인 작은 신경망 모델을 도입했다. 연구팀은 추가된 모델을 훈련하기 위해 능동 학습에서 여러 단계에 걸쳐 데이터를 선별하는 과정을 활용했다. 즉, 새롭게 선택돼 레이블링 된 데이터를 순도-정보도 최적 균형을 찾기 위한 훈련 데이터로 활용했고, 레이블이 추가될 때마다 최적 균형을 갱신했다. 이러한 방법은 목표 심층신경망의 성능 향상을 위해 추가적인 상위 레벨의 신경망을 사용하였다는 점에서 메타학습(meta-learning)의 일종이라 볼 수 있다.

연구팀은 이 메타학습 방법론을 `메타 질의 네트워크'라고 이름 붙이고 이미지 분류 문제에 대해 다양한 데이터와 광범위한 분포 외 데이터 비율에 걸쳐 방법론을 검증했다. 그 결과, 기존 최신 방법론과 비교했을 때 최대 20% 향상된 최종 예측 정확도를 향상했고, 모든 범위의 분포 외 데이터 비율에서 일관되게 최고 성능을 보였다. 또한, `메타 질의 네트워크'의 최적 균형 분석을 통해, 분포 외 데이터의 비율이 낮고 현재 심층신경망의 성능이 높을수록 정보도에 높은 가중치를 둬야 함을 연구팀은 밝혀냈다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 실세계 능동 학습에서의 순도-정보도 딜레마를 발견하고 해결한 획기적인 방법ˮ 이라면서 "다양한 데이터 분포 상황에서의 강건성이 검증됐기 때문에, 실생활의 기계 학습 문제에 폭넓게 적용될 수 있어 전반적인 심층 학습의 훈련 데이터 준비 비용 절감에 기여할 것ˮ 이라고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2022.10.12 조회수 9575

인공지능 심층 학습(딥러닝) 서비스 구축 비용 최소화 가능한 데이터 정제 기술 개발

최근 다양한 분야에서 인공지능 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서 인공지능은 심층신경망을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 고양이 사진에 `고양이'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간적 비용이 소요된다. 따라서 훈련 데이터 구축 비용을 최소화하는 방법 개발이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 심층 학습 훈련 데이터 구축 비용을 최소화할 수 있는 새로운 데이터 동시 정제 및 선택 기술을 개발했다고 12일 밝혔다.

일반적으로 심층 학습용 훈련 데이터 구축 과정은 수집, 정제, 선택 및 레이블링 단계로 이뤄진다. 수집 단계에서는 웹, 카메라, 센서 등으로부터 대용량의 데이터가 정제되지 않은 채로 수집된다. 따라서 수집된 데이터에는 목표 서비스와 관련이 없어서 주어진 레이블에 해당하지 않는 분포 외(out-of-distribution) 데이터가 포함된다 (예를 들어, 동물 사진을 수집할 때 재규어 `자동차'가 포함됨). 이러한 분포 외 데이터는 데이터 정제 단계에서 정제돼야 한다. 모든 정제된 데이터에 정답지를 만들기 위해서는 막대한 비용이 소모되는데, 이를 최소화하기 위해 심층 학습 성능 향상에 가장 도움이 되는 훈련 데이터를 먼저 선택해 레이블링하는 능동 학습(active learning)이 큰 주목을 받고 있다. 그러나 정제와 레이블링을 별도로 진행하는 것은 데이터 검사 측면에서 중복적인 비용을 초래한다. 또한 아직 정제되지 않고 남아 있는 분포 외 데이터가 레이블링 단계에서 선택된다면 레이블링 노력을 낭비할 수 있다.

이재길 교수팀이 개발한 기술은 훈련 데이터 구축 단계에서 데이터의 정제 및 선택을 동시에 수행해 심층 학습용 훈련 데이터 구축 비용을 최소화할 수 있도록 해준다.

우리 대학 데이터사이언스대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 신유주 박사과정, 이영준 박사과정 학생이 제2, 제4 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2022'에서 올 12월 발표될 예정이다. (논문명 : Meta-Query-Net: Resolving Purity-Informativeness Dilemma in Open-set Active Learning)

데이터의 정제 및 선택을 동시에 고려하기 위해서 구체적으로 가장 분포 외 데이터가 아닐 것 같은 데이터 중에서 가장 심층 학습 성능 향상에 도움이 될 데이터를 선택한다. 즉, 주어진 훈련 데이터 구축 비용 내에서 최고의 효과를 내도록 데이터의 순도(purity) 지표와 정보도(informativeness) 지표의 최적 균형(trade-off)을 찾는다. 순도와 정보도는 일반적으로 서로 상충하므로 최적 균형을 찾는 것이 간단하지 않다. 이 교수팀은 이러한 최적 균형이 정제 전 데이터의 분포 외 데이터 비율과 현재 심층신경망 훈련 정도에 따라 달라진다는 점을 발견했다.