-

소량의 데이터로 딥러닝 정확도 향상기술 발표

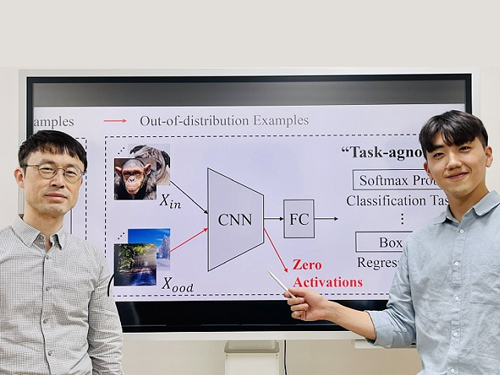

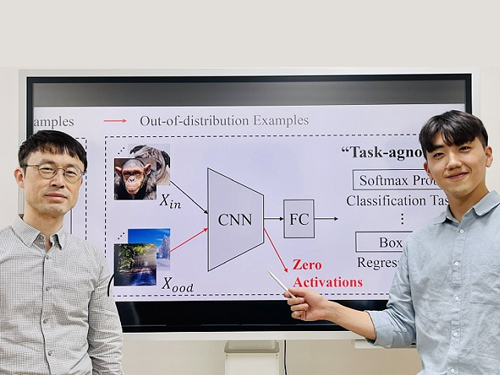

최근 다양한 분야에서 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 낙타 사진에 `낙타'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간이 소요된다. 따라서 훈련 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 적은 양의 훈련 데이터가 존재할 때도 높은 예측 정확도를 달성할 수 있는 새로운 모델 훈련 기술을 개발했다고 27일 밝혔다.

심층 학습 모델의 훈련은 주어진 훈련 데이터에서 레이블과 관련성이 높은 특성을 찾아내는 과정으로 볼 수 있다. 예를 들어, `낙타'의 주요 특성이 등에 있는 `혹'이라는 것을 알아내는 것이다. 그런데 훈련 데이터가 불충분할 경우 바람직하지 않은 특성까지도 같이 추출될 수 있는 문제가 발생한다. 예를 들어, 낙타 사진의 배경으로 종종 사막이 등장하기에 낙타에 대한 특성으로 `사막'이 추출되는 것도 가능하다. 사막은 낙타의 고유한 특성이 아닐뿐더러, 이러한 바람직하지 않은 특성으로 인해 사막이 아닌 곳(예: 동물원)에 있는 낙타는 인식하지 못할 수 있다.

이 교수팀이 개발한 기술은 심층 학습 모델의 훈련에서 바람직하지 않은 특성을 억제해 충분하지 않은 훈련 데이터를 가지고도 높은 예측 정확도를 달성할 수 있게 해준다.

우리 대학 지식서비스공학대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 송환준 박사, 김민석 박사과정 학생이 제2, 제3 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2021'에서 올 12월 발표될 예정이다. (논문명 : Task-Agnostic Undesirable Feature Deactivation Using Out-of-Distribution Data)

바람직하지 않은 특성을 억제하기 위해서 분포 外(out-of-distribution) 데이터를 활용한다. 예를 들어, 낙타와 호랑이 사진의 분류를 위한 훈련 데이터에 대해 여우 사진은 분포 외 데이터가 된다. 이때 이 교수팀이 착안한 점은 훈련 데이터에 존재하는 바람직하지 않은 특성은 분포 외 데이터에도 존재할 수 있다는 점이다.

즉, 위의 예에서 여우 사진의 배경으로도 사막이 나올 수 있다. 따라서 다량의 분포 외 데이터를 추가로 활용해 여기에서 추출된 특성은 영(0) 벡터가 되도록 심층 학습 모델의 훈련 과정을 규제해 바람직하지 않은 특성의 효과를 억제한다. 훈련 과정을 규제한다는 측면에서 정규화 방법론의 일종이라 볼 수 있다. 분포 외 데이터는 쓸모없는 것이라 여겨지고 있었으나, 이번 기술에 의해 훈련 데이터 부족을 해소할 수 있는 유용한 보완재로 탈바꿈될 수 있다.

연구팀은 이 정규화 방법론을 `비선호(比選好) 특성 억제'라고 이름 붙이고 이미지 데이터 분석의 세 가지 주요 문제에 적용했다. 그 결과, 기존 최신 방법론과 비교했을 때, 이미지 분류 문제에서 최대 12% 예측 정확도를 향상했고, 객체 검출 문제에서 최대 3% 예측 정확도를 향상했으며, 객체 지역화 문제에서 최대 8% 예측 정확도를 향상했다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 훈련 데이터 부족 현상을 해결할 수 있는 새로운 방법ˮ 이라면서 "분류, 회귀 분석을 비롯한 다양한 기계 학습 문제에 폭넓게 적용될 수 있어, 심층 학습의 전반적인 성능 개선에 기여할 수 있다ˮ 고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다. (끝).

소량의 데이터로 딥러닝 정확도 향상기술 발표

최근 다양한 분야에서 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 낙타 사진에 `낙타'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간이 소요된다. 따라서 훈련 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 적은 양의 훈련 데이터가 존재할 때도 높은 예측 정확도를 달성할 수 있는 새로운 모델 훈련 기술을 개발했다고 27일 밝혔다.

심층 학습 모델의 훈련은 주어진 훈련 데이터에서 레이블과 관련성이 높은 특성을 찾아내는 과정으로 볼 수 있다. 예를 들어, `낙타'의 주요 특성이 등에 있는 `혹'이라는 것을 알아내는 것이다. 그런데 훈련 데이터가 불충분할 경우 바람직하지 않은 특성까지도 같이 추출될 수 있는 문제가 발생한다. 예를 들어, 낙타 사진의 배경으로 종종 사막이 등장하기에 낙타에 대한 특성으로 `사막'이 추출되는 것도 가능하다. 사막은 낙타의 고유한 특성이 아닐뿐더러, 이러한 바람직하지 않은 특성으로 인해 사막이 아닌 곳(예: 동물원)에 있는 낙타는 인식하지 못할 수 있다.

이 교수팀이 개발한 기술은 심층 학습 모델의 훈련에서 바람직하지 않은 특성을 억제해 충분하지 않은 훈련 데이터를 가지고도 높은 예측 정확도를 달성할 수 있게 해준다.

우리 대학 지식서비스공학대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 송환준 박사, 김민석 박사과정 학생이 제2, 제3 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2021'에서 올 12월 발표될 예정이다. (논문명 : Task-Agnostic Undesirable Feature Deactivation Using Out-of-Distribution Data)

바람직하지 않은 특성을 억제하기 위해서 분포 外(out-of-distribution) 데이터를 활용한다. 예를 들어, 낙타와 호랑이 사진의 분류를 위한 훈련 데이터에 대해 여우 사진은 분포 외 데이터가 된다. 이때 이 교수팀이 착안한 점은 훈련 데이터에 존재하는 바람직하지 않은 특성은 분포 외 데이터에도 존재할 수 있다는 점이다.

즉, 위의 예에서 여우 사진의 배경으로도 사막이 나올 수 있다. 따라서 다량의 분포 외 데이터를 추가로 활용해 여기에서 추출된 특성은 영(0) 벡터가 되도록 심층 학습 모델의 훈련 과정을 규제해 바람직하지 않은 특성의 효과를 억제한다. 훈련 과정을 규제한다는 측면에서 정규화 방법론의 일종이라 볼 수 있다. 분포 외 데이터는 쓸모없는 것이라 여겨지고 있었으나, 이번 기술에 의해 훈련 데이터 부족을 해소할 수 있는 유용한 보완재로 탈바꿈될 수 있다.

연구팀은 이 정규화 방법론을 `비선호(比選好) 특성 억제'라고 이름 붙이고 이미지 데이터 분석의 세 가지 주요 문제에 적용했다. 그 결과, 기존 최신 방법론과 비교했을 때, 이미지 분류 문제에서 최대 12% 예측 정확도를 향상했고, 객체 검출 문제에서 최대 3% 예측 정확도를 향상했으며, 객체 지역화 문제에서 최대 8% 예측 정확도를 향상했다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 훈련 데이터 부족 현상을 해결할 수 있는 새로운 방법ˮ 이라면서 "분류, 회귀 분석을 비롯한 다양한 기계 학습 문제에 폭넓게 적용될 수 있어, 심층 학습의 전반적인 성능 개선에 기여할 수 있다ˮ 고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다. (끝).

2021.10.27

조회수 13029

-

우수한 소재를 설계하는 딥러닝 방법론 개발

우리 대학 기계공학과 유승화 교수 연구팀이 능동-전이 학습 (active-transfer learning)과 데이터 증강기법(Data augmentation)에 기반해, 심층신경망 초기 훈련에 쓰인 소재들과 형태와 조합이 매우 다른 우수한 특성을 지닌 소재를 효율적으로 탐색하고 설계하는 방법론을 개발했다고 16일 밝혔다.

인공신경망에 기반해 방대한 설계 공간에서 새로운 소재를 찾기 위한 역설계 연구는 최근 매우 활발하게 진행되고 있다. 하지만 이러한 기존 설계 방식은 목표로 하는 소재의 형태와 조합이 심층신경망 훈련에 활용된 소재들과 매우 다를 때 인공신경망이 가지는 낮은 예측능력으로 인해 극히 많은 수의 소재 데이터 검증이 요구되며, 이에 따라 제한적으로만 활용이 가능하다.

연구팀은 이번 연구에서 이를 극복하기 위해 초기 훈련 데이터 영역에서 벗어나 우수한 소재를 효율적으로 탐색할 수 있는 인공신경망 기반 전진 설계 (Forward design) 방법론을 제안했다. 이 방법론은, <그림 1>에 도시된 바와 같이 유전 알고리즘과 결합된 능동-전이 학습 및 데이터 증강기법을 통해 심층신경망을 점진적으로 업데이트함으로써, 초기 훈련데이터를 벗어난 영역에서 심층신경망의 낮은 예측능력을 적은 숫자의 데이터 검증 및 추가로 보완한다.

유전 알고리즘에 의해 제안되는 우수 소재 후보군은 기보유한 소재 데이터를 조합해 도출하기 때문에 심층신경망의 신뢰할 수 있는 예측 영역과 설계 공간 측면에서 상대적으로 가까워 예측정확도가 유지된다. 이 후보군과 능동-전이 학습을 활용해 점진적으로 심층신경망의 신뢰성 있는 예측 범위를 확장하면, 초기 훈련데이터 영역 밖에서도 적은 데이터를 생성해 효율적인 설계 과정이 가능하다.

이번 방법은 천문학적인 수의 설계 구성을 가지는 그리드 복합소재 최적화 문제에 적용해 검증했으며, 이를 통해 전체 가능한 복합재 구조의 1029분의 1 가량인 10만 개의 복합재들만 초기 훈련 데이터로 활용해 심층신경망을 학습한 후, 이후 약 500개에 미치지 못하는 데이터 검증을 통해 초기 훈련에 쓰인 복합재와 매우 다른 구조를 가지고 우수한 특성을 지닌 복합재 구조를 설계할 수 있음을 보였다.

연구진이 개발한 방법론은 국소 최적점(Local optima)에 수렴하는 문제를 완화하면서도 인공신경망의 신뢰할 수 있는 예측 영역을 점진적으로 확장하는 효율적인 방법을 제공하기 때문에, 큰 설계 공간을 다루는 다양한 분야의 최적화 문제에 적용할 수 있을 것으로 기대되며, 특히 설계에 요구되는 데이터 검증의 숫자가 적기 때문에 데이터 생성에 시간이 오래 걸리고 비용이 많이 드는 설계 문제에서 이 방법론이 크게 활용될 수 있을 것으로 기대된다.

이번 연구는 공동 제 1저자 김용태 박사과정, 김영수 박사(한국기계연구원) 주도하에 진행됐으며, 유승화 교수(우리 대학 기계공학과)가 교신저자로 참여해, 국제학술지인 `npj 컴퓨테이셔널 머터리얼(Computational Material, IF:12.241)'에 `Deep Learning Framework for Material Design Space Exploration using Active Transfer Learning and Data Augmentation' 라는 제목으로 게재됐다.

이번 연구는 한국연구재단의 중견 연구자지원사업(3D 프린팅 복합재의 최적설계기법 및 피로수명 예측기법 개발)과 미래소재 디스커버리 사업 (레이저-물질 상호작용 멀티스케일 모델링을 통한 분자디자인), KAIST 글로벌 특이점 프렙 사업의 지원을 통해 수행됐다.

우수한 소재를 설계하는 딥러닝 방법론 개발

우리 대학 기계공학과 유승화 교수 연구팀이 능동-전이 학습 (active-transfer learning)과 데이터 증강기법(Data augmentation)에 기반해, 심층신경망 초기 훈련에 쓰인 소재들과 형태와 조합이 매우 다른 우수한 특성을 지닌 소재를 효율적으로 탐색하고 설계하는 방법론을 개발했다고 16일 밝혔다.

인공신경망에 기반해 방대한 설계 공간에서 새로운 소재를 찾기 위한 역설계 연구는 최근 매우 활발하게 진행되고 있다. 하지만 이러한 기존 설계 방식은 목표로 하는 소재의 형태와 조합이 심층신경망 훈련에 활용된 소재들과 매우 다를 때 인공신경망이 가지는 낮은 예측능력으로 인해 극히 많은 수의 소재 데이터 검증이 요구되며, 이에 따라 제한적으로만 활용이 가능하다.

연구팀은 이번 연구에서 이를 극복하기 위해 초기 훈련 데이터 영역에서 벗어나 우수한 소재를 효율적으로 탐색할 수 있는 인공신경망 기반 전진 설계 (Forward design) 방법론을 제안했다. 이 방법론은, <그림 1>에 도시된 바와 같이 유전 알고리즘과 결합된 능동-전이 학습 및 데이터 증강기법을 통해 심층신경망을 점진적으로 업데이트함으로써, 초기 훈련데이터를 벗어난 영역에서 심층신경망의 낮은 예측능력을 적은 숫자의 데이터 검증 및 추가로 보완한다.

유전 알고리즘에 의해 제안되는 우수 소재 후보군은 기보유한 소재 데이터를 조합해 도출하기 때문에 심층신경망의 신뢰할 수 있는 예측 영역과 설계 공간 측면에서 상대적으로 가까워 예측정확도가 유지된다. 이 후보군과 능동-전이 학습을 활용해 점진적으로 심층신경망의 신뢰성 있는 예측 범위를 확장하면, 초기 훈련데이터 영역 밖에서도 적은 데이터를 생성해 효율적인 설계 과정이 가능하다.

이번 방법은 천문학적인 수의 설계 구성을 가지는 그리드 복합소재 최적화 문제에 적용해 검증했으며, 이를 통해 전체 가능한 복합재 구조의 1029분의 1 가량인 10만 개의 복합재들만 초기 훈련 데이터로 활용해 심층신경망을 학습한 후, 이후 약 500개에 미치지 못하는 데이터 검증을 통해 초기 훈련에 쓰인 복합재와 매우 다른 구조를 가지고 우수한 특성을 지닌 복합재 구조를 설계할 수 있음을 보였다.

연구진이 개발한 방법론은 국소 최적점(Local optima)에 수렴하는 문제를 완화하면서도 인공신경망의 신뢰할 수 있는 예측 영역을 점진적으로 확장하는 효율적인 방법을 제공하기 때문에, 큰 설계 공간을 다루는 다양한 분야의 최적화 문제에 적용할 수 있을 것으로 기대되며, 특히 설계에 요구되는 데이터 검증의 숫자가 적기 때문에 데이터 생성에 시간이 오래 걸리고 비용이 많이 드는 설계 문제에서 이 방법론이 크게 활용될 수 있을 것으로 기대된다.

이번 연구는 공동 제 1저자 김용태 박사과정, 김영수 박사(한국기계연구원) 주도하에 진행됐으며, 유승화 교수(우리 대학 기계공학과)가 교신저자로 참여해, 국제학술지인 `npj 컴퓨테이셔널 머터리얼(Computational Material, IF:12.241)'에 `Deep Learning Framework for Material Design Space Exploration using Active Transfer Learning and Data Augmentation' 라는 제목으로 게재됐다.

이번 연구는 한국연구재단의 중견 연구자지원사업(3D 프린팅 복합재의 최적설계기법 및 피로수명 예측기법 개발)과 미래소재 디스커버리 사업 (레이저-물질 상호작용 멀티스케일 모델링을 통한 분자디자인), KAIST 글로벌 특이점 프렙 사업의 지원을 통해 수행됐다.

2021.09.16

조회수 12897

-

정송 교수 연구팀, 아시아대학 최초 ACM MobiSys 2021 Best Paper Award 수상

우리 대학 AI대학원과 전기및전자공학부 소속 정송 교수 연구실의 김세연 박사과정생과 이경한 박사졸업생 (현 서울대 전기정보공학부 부교수)이 지난 주 COVID-19으로 인해 온라인으로 개최된 2021년도 ACM MobiSys 학회(https://www.sigmobile.org/mobisys/2021/)에서 Best Paper Award를 수상했다.

ACM MobiSys는 모바일시스템 분야의 최고 학회로서 올해 총 266편의 논문이 제출되어 36개의 논문이 억셉트되었으며 (논문게재율: 21.6%) 이번 정송 교수 연구팀의 Best Paper Award 수상은 19년의 MobiSys 역사상 첫 아시아권 대학의 수상이다. (제1저자 소속 대학 기준)

- 논문명: zTT: Learning-based DVFS with Zero Thermal Throttling for Mobile Devices

(모바일 기기의 열쓰로틀링 방지를 위한 강화 학습 기반의 동적 주파수 할당 기술)

- 논문 저자: 김세연 (KAIST), 빈경민 (서울대), 하상태 (U. of Colorado at Boulder), 이경한 (서울대), 정송 (KAIST)

- 논문 내용:

동적 전압/주파수 할당 기술(Dynamic Voltage and Frequency Scaling, DVFS)은 운영 체제(OS) 단에서 프로세서 성능을 보장하는 동시에 에너지 소모를 줄이기 위해 동적으로 프로세서의 전압과 주파수를 조절하는 기술이다. 하지만 모바일 기기의 동적 주파수 할당 기술은 두 가지 한계점을 가지고 있다. 첫째, OS 레벨에서 수행되기 때문에 어플리케이션의 성능을 보장하지 못한다. 둘째, 모바일 기기의 특성상 빈번하게 변하는 환경을 반영하지 못하여 과열을 일으켜 열쓰로틀링(Thermal Throttling)을 야기시켜 사용자 경험(QoE)를 크게 감소시킬 수 있다. 특히, 모바일 기기에서 발열 문제는 최신 스마트폰과 같은 고성능 기기의 성능을 크게 떨어뜨리는 고질적인 문제로 알려져 있다. 해당 연구에서는 이러한 기존 기술의 한계를 해결하기 위해 모바일 기기의 과열을 예방하고, 사용자 경험을 보장하는 동시에 에너지 소모를 최소화하기 위해 심층 강화 학습(Deep-Reinforcement Learning) 기반의 동적 주파수 할당 기술을 개발했다. 이는 실시간으로 수집되는 상태 정보를 바탕으로 어플리케이션과 모바일 기기의 동작 환경에 적응하여 안정된 성능을 보장하고, 전력 소모를 크게 줄일 수 있는 기술이다. 연구팀은 해당 연구 기술이 운영 체제나 어플리케이션이 보다 최적화된 성능으로 동작하기 위한 하나의 설정 옵션으로 패키징될 수 있을 것이라고 전망하고 있다.

위 상을 수상한 김세연 박사과정생은 논문에 대해 “5G 스마트폰과 같은 모바일 단말에서 과도한 발열로 인해 발생하는 열쓰로틀링에 따른 급격한 성능 저하 문제를 강화학습 기반의 동적 전압/주파수 스케일링을 통해 획기적으로 해결한 연구”라고 설명했다.

정송 교수는 “사용자 체감 성능을 높이면서 열쓰로틀링으로 인한 급격한 성능 저하를 방지하기 위해서는, 적정한 온도를 유지하기 위한 총전력 소모 범위 내에서 프로세서 컴포넌트 (CPU, GPU 등) 간 최적의 전력 분배를 수행하는 것이 관건이지만, 주변 환경 (주변 온도, 쿨링 상황 등)과 사용자 애플리케이션 특성에 따라 허용 가능한 총 전력 소모 범위와 최적의 전력 분배가 실시간으로 변화하기 때문에 전통적인 제어기법으로는 해결하기 매우 어려운 문제였다”고 부연 설명했다.

연구팀의 이러한 결과는 전력소모 문제로 인공지능 기법의 도입이 어려울 것으로 예상되었던 모바일 플랫폼에서 조차 강화학습 기반의 시스템 제어가 성능 개선에 크게 이바지 할 수 있음을 보임으로써, 차세대 운영체제에 AI/ML 기반 제어 기법들을 적극적으로 도입하기 위한 계기를 마련한 것으로 평가받았다.

정송 교수 연구팀, 아시아대학 최초 ACM MobiSys 2021 Best Paper Award 수상

우리 대학 AI대학원과 전기및전자공학부 소속 정송 교수 연구실의 김세연 박사과정생과 이경한 박사졸업생 (현 서울대 전기정보공학부 부교수)이 지난 주 COVID-19으로 인해 온라인으로 개최된 2021년도 ACM MobiSys 학회(https://www.sigmobile.org/mobisys/2021/)에서 Best Paper Award를 수상했다.

ACM MobiSys는 모바일시스템 분야의 최고 학회로서 올해 총 266편의 논문이 제출되어 36개의 논문이 억셉트되었으며 (논문게재율: 21.6%) 이번 정송 교수 연구팀의 Best Paper Award 수상은 19년의 MobiSys 역사상 첫 아시아권 대학의 수상이다. (제1저자 소속 대학 기준)

- 논문명: zTT: Learning-based DVFS with Zero Thermal Throttling for Mobile Devices

(모바일 기기의 열쓰로틀링 방지를 위한 강화 학습 기반의 동적 주파수 할당 기술)

- 논문 저자: 김세연 (KAIST), 빈경민 (서울대), 하상태 (U. of Colorado at Boulder), 이경한 (서울대), 정송 (KAIST)

- 논문 내용:

동적 전압/주파수 할당 기술(Dynamic Voltage and Frequency Scaling, DVFS)은 운영 체제(OS) 단에서 프로세서 성능을 보장하는 동시에 에너지 소모를 줄이기 위해 동적으로 프로세서의 전압과 주파수를 조절하는 기술이다. 하지만 모바일 기기의 동적 주파수 할당 기술은 두 가지 한계점을 가지고 있다. 첫째, OS 레벨에서 수행되기 때문에 어플리케이션의 성능을 보장하지 못한다. 둘째, 모바일 기기의 특성상 빈번하게 변하는 환경을 반영하지 못하여 과열을 일으켜 열쓰로틀링(Thermal Throttling)을 야기시켜 사용자 경험(QoE)를 크게 감소시킬 수 있다. 특히, 모바일 기기에서 발열 문제는 최신 스마트폰과 같은 고성능 기기의 성능을 크게 떨어뜨리는 고질적인 문제로 알려져 있다. 해당 연구에서는 이러한 기존 기술의 한계를 해결하기 위해 모바일 기기의 과열을 예방하고, 사용자 경험을 보장하는 동시에 에너지 소모를 최소화하기 위해 심층 강화 학습(Deep-Reinforcement Learning) 기반의 동적 주파수 할당 기술을 개발했다. 이는 실시간으로 수집되는 상태 정보를 바탕으로 어플리케이션과 모바일 기기의 동작 환경에 적응하여 안정된 성능을 보장하고, 전력 소모를 크게 줄일 수 있는 기술이다. 연구팀은 해당 연구 기술이 운영 체제나 어플리케이션이 보다 최적화된 성능으로 동작하기 위한 하나의 설정 옵션으로 패키징될 수 있을 것이라고 전망하고 있다.

위 상을 수상한 김세연 박사과정생은 논문에 대해 “5G 스마트폰과 같은 모바일 단말에서 과도한 발열로 인해 발생하는 열쓰로틀링에 따른 급격한 성능 저하 문제를 강화학습 기반의 동적 전압/주파수 스케일링을 통해 획기적으로 해결한 연구”라고 설명했다.

정송 교수는 “사용자 체감 성능을 높이면서 열쓰로틀링으로 인한 급격한 성능 저하를 방지하기 위해서는, 적정한 온도를 유지하기 위한 총전력 소모 범위 내에서 프로세서 컴포넌트 (CPU, GPU 등) 간 최적의 전력 분배를 수행하는 것이 관건이지만, 주변 환경 (주변 온도, 쿨링 상황 등)과 사용자 애플리케이션 특성에 따라 허용 가능한 총 전력 소모 범위와 최적의 전력 분배가 실시간으로 변화하기 때문에 전통적인 제어기법으로는 해결하기 매우 어려운 문제였다”고 부연 설명했다.

연구팀의 이러한 결과는 전력소모 문제로 인공지능 기법의 도입이 어려울 것으로 예상되었던 모바일 플랫폼에서 조차 강화학습 기반의 시스템 제어가 성능 개선에 크게 이바지 할 수 있음을 보임으로써, 차세대 운영체제에 AI/ML 기반 제어 기법들을 적극적으로 도입하기 위한 계기를 마련한 것으로 평가받았다.

2021.07.09

조회수 14125

-

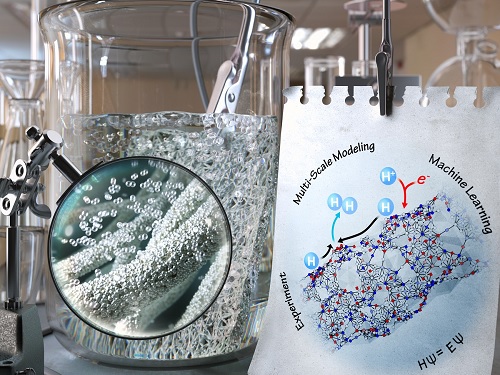

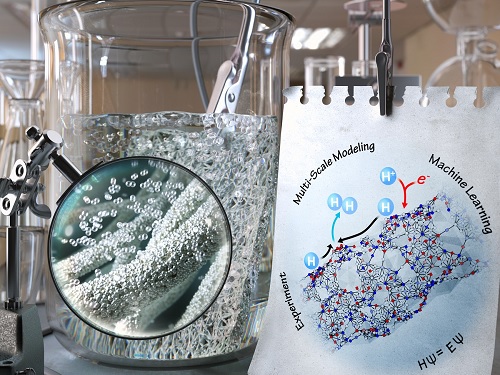

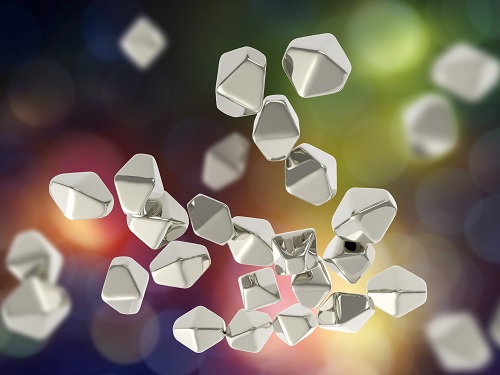

딥러닝 통해 수소 발생 메커니즘 규명

우리 대학 생명화학공학과 정유성 교수 연구팀이 심층 학습(딥러닝)을 통해 고활성 백금 와이어의 수소 발생 메커니즘을 규명하는 데 성공했다고 29일 밝혔다.

백금은 전기차 등에 사용되는 연료 전지에 쓰이거나, 물의 전기 분해를 통해 수소를 얻는 데 사용되는 중요한 촉매이지만 가격이 비싸 기술 보급에 걸림돌이 되고 있다. 이를 해결하는 방법의 하나로 최근 백금을 톱니 와이어 모양으로 합성해 백금의 양을 10배 정도 절약하는 연구들이 발표돼 큰 파장을 불러일으켰지만, 아직 그 메커니즘이 규명되지 않았다.

정유성 교수 연구팀은 복잡한 촉매 표면의 성질을 빠르게 예측하는 딥러닝 방법들을 고안했는데, 이번에 이를 톱니 백금 와이어에 적용해 해당 촉매의 높은 수소 활성 메커니즘을 규명할 수 있었다.

연구팀이 규명한 톱니 백금 와이어에서의 수소 발생 메커니즘은 기존에 알려진 촉매 직관을 깨는 새로운 메커니즘인 것으로 밝혀졌다. 수소 발생은 물에서 양성자를 받아 수소를 흡착시키는 흡착반응과 흡착된 수소 원자들이 결합해 수소 분자가 형성되는 짝지음 반응의 2단계를 거쳐 일어나는데, 이 두 반응은 일반적으로 같은 반응 자리(reaction site)에서 일어난다.

하지만, 이번에 새롭게 발견된 메커니즘에 의하면, 톱니 백금 표면에서는 울퉁불퉁한 구조로 인해 흡착반응이 잘 일으키는 반응 자리와 짝지음 반응을 잘 일으키는 반응 자리가 따로 존재하고, 이 두 자리의 상승 작용으로 인해 촉매 활성이 400% 이상 증가한다. 마치 분업화를 통해 일의 효율을 높이는 것과 같은 개념이 분자 세계에서도 존재하는 것이다.

정유성 교수는 "분자 수준에서 분업을 통해 전체 반응 효율을 높이는 개념들이 기존에도 있긴 했지만, 단일성분인 백금에서 구조에 따른 분업 현상이 규명된 것은 이번이 처음ˮ이라면서, "단일성분 촉매의 구조를 변화시킴으로써 촉매의 효율을 높일 수 있는 새로운 관점과 설계원리를 제시했다는 점에서 의미가 있다ˮ고 했다.

우리 대학 구근호 박사후연구원이 제1 저자로 참여하고, 톱니 백금 와이어를 합성한 캘리포니아대학교 로스엔젤리스(UCLA)의 듀안 교수 연구팀과 캘리포니아 공과대학교(Caltech)의 고다드 교수 연구팀이 함께 참여한 이번 연구성과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 3월 17일 字에 실렸다. (논문명: Autobifunctional Mechanism of Jagged Pt Nanowires for Hydrogen Evolution Kinetics via End-to-End Simulation)

이번 연구는 과학기술정보통신부 산하 한국연구재단의 중견연구자 기초연구사업과 PEMWE용 저가의 고성능 수소 발생반응 촉매 개발 사업의 지원을 받아 수행됐고, KISTI의 슈퍼컴퓨터 자원이 활용됐다.

딥러닝 통해 수소 발생 메커니즘 규명

우리 대학 생명화학공학과 정유성 교수 연구팀이 심층 학습(딥러닝)을 통해 고활성 백금 와이어의 수소 발생 메커니즘을 규명하는 데 성공했다고 29일 밝혔다.

백금은 전기차 등에 사용되는 연료 전지에 쓰이거나, 물의 전기 분해를 통해 수소를 얻는 데 사용되는 중요한 촉매이지만 가격이 비싸 기술 보급에 걸림돌이 되고 있다. 이를 해결하는 방법의 하나로 최근 백금을 톱니 와이어 모양으로 합성해 백금의 양을 10배 정도 절약하는 연구들이 발표돼 큰 파장을 불러일으켰지만, 아직 그 메커니즘이 규명되지 않았다.

정유성 교수 연구팀은 복잡한 촉매 표면의 성질을 빠르게 예측하는 딥러닝 방법들을 고안했는데, 이번에 이를 톱니 백금 와이어에 적용해 해당 촉매의 높은 수소 활성 메커니즘을 규명할 수 있었다.

연구팀이 규명한 톱니 백금 와이어에서의 수소 발생 메커니즘은 기존에 알려진 촉매 직관을 깨는 새로운 메커니즘인 것으로 밝혀졌다. 수소 발생은 물에서 양성자를 받아 수소를 흡착시키는 흡착반응과 흡착된 수소 원자들이 결합해 수소 분자가 형성되는 짝지음 반응의 2단계를 거쳐 일어나는데, 이 두 반응은 일반적으로 같은 반응 자리(reaction site)에서 일어난다.

하지만, 이번에 새롭게 발견된 메커니즘에 의하면, 톱니 백금 표면에서는 울퉁불퉁한 구조로 인해 흡착반응이 잘 일으키는 반응 자리와 짝지음 반응을 잘 일으키는 반응 자리가 따로 존재하고, 이 두 자리의 상승 작용으로 인해 촉매 활성이 400% 이상 증가한다. 마치 분업화를 통해 일의 효율을 높이는 것과 같은 개념이 분자 세계에서도 존재하는 것이다.

정유성 교수는 "분자 수준에서 분업을 통해 전체 반응 효율을 높이는 개념들이 기존에도 있긴 했지만, 단일성분인 백금에서 구조에 따른 분업 현상이 규명된 것은 이번이 처음ˮ이라면서, "단일성분 촉매의 구조를 변화시킴으로써 촉매의 효율을 높일 수 있는 새로운 관점과 설계원리를 제시했다는 점에서 의미가 있다ˮ고 했다.

우리 대학 구근호 박사후연구원이 제1 저자로 참여하고, 톱니 백금 와이어를 합성한 캘리포니아대학교 로스엔젤리스(UCLA)의 듀안 교수 연구팀과 캘리포니아 공과대학교(Caltech)의 고다드 교수 연구팀이 함께 참여한 이번 연구성과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 3월 17일 字에 실렸다. (논문명: Autobifunctional Mechanism of Jagged Pt Nanowires for Hydrogen Evolution Kinetics via End-to-End Simulation)

이번 연구는 과학기술정보통신부 산하 한국연구재단의 중견연구자 기초연구사업과 PEMWE용 저가의 고성능 수소 발생반응 촉매 개발 사업의 지원을 받아 수행됐고, KISTI의 슈퍼컴퓨터 자원이 활용됐다.

2021.04.29

조회수 29676

-

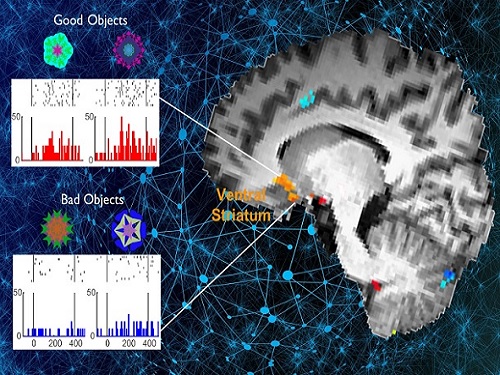

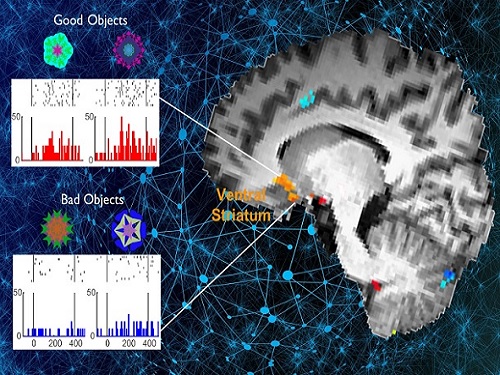

이수현 교수팀, 뇌 복부선조영역의 새로운 기억관련 기능 규명

우리 대학 바이오및뇌공학과 이수현 교수 연구팀과 서울대학교 생명과학부 김형 교수 연구팀이 공동연구를 통해 복부선조영역(ventral striatum)에서 습관행동을 제어하는데 필요한 장기기억이 자동적으로 인출된다는 사실을 밝혔다. 이러한 복부선조영역의 기능을 그 영역과 회로별로 규명하는 것은 인간에게 직접 적용할 수 있는 뇌질환 치료방법 개발과 뇌영역 맞춤형 치료의 이론적 기반이 될 수 있다.

뇌의 복부선조영역은 새로운 가치학습에 중요하며, 중독행동과 조현병 관련 행동에도 연관된 것으로 알려져 왔지만 이러한 행동에 기반이 될 수 있는 기억정보를 처리하고 있는지에 대해서는 불분명했다.

이에 연구팀은 기능적 자기공명뇌영상과 전기생리학적 뇌세포 활성측정법을 모두 이용해 과거에 학습한 물체를 의식적으로 인지하고 있지 않는 상황에서도 복부선조에서 과거에 배운 좋은 물체에 대한 장기기억정보가 활발하게 처리되고 있다는 사실을 밝혀냈다.

또한 자동적으로 인출된 좋은 물체에 대한 기억은 무의식적이며 자동적인 행동, 즉 습관행동을 제어하고, 이를 통해 동물이 장기기억을 기반으로 최대이익을 얻을 수 있는 자동적 의사결정(automatic decision-making) 과정에 사용된다는 실험적 증거를 제시했다.

바이오및뇌공학과 뇌인지공학프로그램 강준영 석박사통합과정 학생이 제1 저자로 참여한 이번 연구는 국제학술지 네이쳐 커뮤니케이션즈(Nature Communications)에 4월 8일(목) 게재됐다.

복부선조영역에서 기억의 자동적 인출과정을 이해함으로써 자동적 행동인 습관과 중독행동 제어의 이론적 기반을 다지고, 나아가 기억의 자동인출(automatic retrieval)과 연관된 현저성(salience) 이상으로 조현병을 이해할 수 있는 이론적 발판을 마련한 것에 이번 연구의 의의가 있다고 볼 수 있다.

이번 연구는 한국연구재단 뇌질환극복사업 및 개인기초연구지원사업 등의 지원을 받아 수행됐다.

이수현 교수팀, 뇌 복부선조영역의 새로운 기억관련 기능 규명

우리 대학 바이오및뇌공학과 이수현 교수 연구팀과 서울대학교 생명과학부 김형 교수 연구팀이 공동연구를 통해 복부선조영역(ventral striatum)에서 습관행동을 제어하는데 필요한 장기기억이 자동적으로 인출된다는 사실을 밝혔다. 이러한 복부선조영역의 기능을 그 영역과 회로별로 규명하는 것은 인간에게 직접 적용할 수 있는 뇌질환 치료방법 개발과 뇌영역 맞춤형 치료의 이론적 기반이 될 수 있다.

뇌의 복부선조영역은 새로운 가치학습에 중요하며, 중독행동과 조현병 관련 행동에도 연관된 것으로 알려져 왔지만 이러한 행동에 기반이 될 수 있는 기억정보를 처리하고 있는지에 대해서는 불분명했다.

이에 연구팀은 기능적 자기공명뇌영상과 전기생리학적 뇌세포 활성측정법을 모두 이용해 과거에 학습한 물체를 의식적으로 인지하고 있지 않는 상황에서도 복부선조에서 과거에 배운 좋은 물체에 대한 장기기억정보가 활발하게 처리되고 있다는 사실을 밝혀냈다.

또한 자동적으로 인출된 좋은 물체에 대한 기억은 무의식적이며 자동적인 행동, 즉 습관행동을 제어하고, 이를 통해 동물이 장기기억을 기반으로 최대이익을 얻을 수 있는 자동적 의사결정(automatic decision-making) 과정에 사용된다는 실험적 증거를 제시했다.

바이오및뇌공학과 뇌인지공학프로그램 강준영 석박사통합과정 학생이 제1 저자로 참여한 이번 연구는 국제학술지 네이쳐 커뮤니케이션즈(Nature Communications)에 4월 8일(목) 게재됐다.

복부선조영역에서 기억의 자동적 인출과정을 이해함으로써 자동적 행동인 습관과 중독행동 제어의 이론적 기반을 다지고, 나아가 기억의 자동인출(automatic retrieval)과 연관된 현저성(salience) 이상으로 조현병을 이해할 수 있는 이론적 발판을 마련한 것에 이번 연구의 의의가 있다고 볼 수 있다.

이번 연구는 한국연구재단 뇌질환극복사업 및 개인기초연구지원사업 등의 지원을 받아 수행됐다.

2021.04.09

조회수 73546

-

인공지능으로 3차원 고해상도 나노입자 영상화 기술 개발

우리 대학 바이오및뇌공학과 예종철 교수 연구팀이 삼성전자 종합기술원과 공동연구를 통해 나노입자의 3차원 형상과 조성 분포의 복원 성능을 획기적으로 향상한 인공지능 기술을 개발했다고 16일 밝혔다. 공동연구팀은 에너지 분산형 X선 분광법(EDX)을 주사 투과전자현미경(STEM)과 결합한 시스템을 활용했다.

이번 연구를 통해 나노입자를 형성하고 있는 물질의 형상과 조성 분포를 정확하게 재구성함으로써, 실제 상용 디스플레이를 구성하는 양자점(퀀텀닷)과 같은 반도체 입자의 정확한 분석에 도움을 줄 것으로 기대된다.

예종철 교수 연구팀의 한요섭 박사, 차은주 박사과정, 정형진 석사과정과 삼성종합기술원의 이은하 전문연구원팀의 장재덕, 이준호 전문연구원이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)' 2월 8일 字 온라인판에 게재됐다. (논문명 : Deep learning STEM-EDX tomography of nanocrystals)

에너지 분산형 X선 분광법(이하 EDX)은 나노입자의 성분 분석에 주로 이용되며, X선과 반응한 물체의 성분에 따라 고유한 방출 스펙트럼을 보인다는 점에서 화학적인 분석이 가능하다. 퀀텀닷 및 배터리 등 다양한 나노 소재의 열화 메커니즘과 결함을 해석하기 위해 형상 및 조성 분포 분석이 가능한 이 분광법의 필요성과 중요도가 급증하고 있다.

그러나 EDX 측정 신호의 해상도를 향상하기 위해, 나노 소재를 오랜 시간 전자빔에 노출하면 소재의 영구적인 피해가 발생한다. 이로 인해 나노입자의 3차원 영상화를 위한 투사(projection) 데이터 획득 시간이 제한되며, 한 각도에서의 스캔 시간을 단축하거나 측정하는 각도를 줄이는 방식이 사용된다. 기존의 방식으로 획득된 투사 데이터를 이용해 3차원 영상을 복원할 시, 미량 존재하는 원자 신호의 측정이 불가능하거나 복원 영상의 정밀도와 해상도가 매우 낮다.

그러나 공동 연구팀이 자체 개발한 인공지능 기반의 커널 회귀(kernel regression)와 투사 데이터 향상(projection enhancement)은 정밀도와 해상도를 획기적으로 발전시켰다. 연구팀은 측정된 데이터의 분포를 네트워크가 스스로 학습하는 인공지능 기반의 커널 회귀를 통해 스캔 시간이 단축된 투사 데이터의 신호 대 잡음비(SNR)를 높인 데이터를 제공하는 네트워크를 개발했다. 그리고 개선된 고화질의 EDX 투사 데이터를 기반으로 기존의 방법으로는 불가능했던 적은 수의 투사 데이터로부터 더욱 정확한 3차원 복원 영상을 제공하는 데 성공했다.

연구팀이 개발한 알고리즘은 기존의 EDX 측정 신호 기반 3차원 재구성 기법과 비교해 나노입자를 형성하고 있는 원자의 형상과 경계를 뚜렷하게 구별했으며, 복원된 다양한 코어-쉘(core-shell) 구조의 퀀텀닷 3차원 영상이 샘플의 광학적 특성과 높은 상관관계를 나타내는 것이 확인됐다.

예종철 교수는 "연구에서 개발한 인공지능 기술을 통해 상용 디스플레이의 핵심 기반이 되는 퀀텀닷 및 반도체 소자의 양자 효율과 화학적 안정성을 더욱 정밀하게 분석할 수 있다ˮ고 말했다.

인공지능으로 3차원 고해상도 나노입자 영상화 기술 개발

우리 대학 바이오및뇌공학과 예종철 교수 연구팀이 삼성전자 종합기술원과 공동연구를 통해 나노입자의 3차원 형상과 조성 분포의 복원 성능을 획기적으로 향상한 인공지능 기술을 개발했다고 16일 밝혔다. 공동연구팀은 에너지 분산형 X선 분광법(EDX)을 주사 투과전자현미경(STEM)과 결합한 시스템을 활용했다.

이번 연구를 통해 나노입자를 형성하고 있는 물질의 형상과 조성 분포를 정확하게 재구성함으로써, 실제 상용 디스플레이를 구성하는 양자점(퀀텀닷)과 같은 반도체 입자의 정확한 분석에 도움을 줄 것으로 기대된다.

예종철 교수 연구팀의 한요섭 박사, 차은주 박사과정, 정형진 석사과정과 삼성종합기술원의 이은하 전문연구원팀의 장재덕, 이준호 전문연구원이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)' 2월 8일 字 온라인판에 게재됐다. (논문명 : Deep learning STEM-EDX tomography of nanocrystals)

에너지 분산형 X선 분광법(이하 EDX)은 나노입자의 성분 분석에 주로 이용되며, X선과 반응한 물체의 성분에 따라 고유한 방출 스펙트럼을 보인다는 점에서 화학적인 분석이 가능하다. 퀀텀닷 및 배터리 등 다양한 나노 소재의 열화 메커니즘과 결함을 해석하기 위해 형상 및 조성 분포 분석이 가능한 이 분광법의 필요성과 중요도가 급증하고 있다.

그러나 EDX 측정 신호의 해상도를 향상하기 위해, 나노 소재를 오랜 시간 전자빔에 노출하면 소재의 영구적인 피해가 발생한다. 이로 인해 나노입자의 3차원 영상화를 위한 투사(projection) 데이터 획득 시간이 제한되며, 한 각도에서의 스캔 시간을 단축하거나 측정하는 각도를 줄이는 방식이 사용된다. 기존의 방식으로 획득된 투사 데이터를 이용해 3차원 영상을 복원할 시, 미량 존재하는 원자 신호의 측정이 불가능하거나 복원 영상의 정밀도와 해상도가 매우 낮다.

그러나 공동 연구팀이 자체 개발한 인공지능 기반의 커널 회귀(kernel regression)와 투사 데이터 향상(projection enhancement)은 정밀도와 해상도를 획기적으로 발전시켰다. 연구팀은 측정된 데이터의 분포를 네트워크가 스스로 학습하는 인공지능 기반의 커널 회귀를 통해 스캔 시간이 단축된 투사 데이터의 신호 대 잡음비(SNR)를 높인 데이터를 제공하는 네트워크를 개발했다. 그리고 개선된 고화질의 EDX 투사 데이터를 기반으로 기존의 방법으로는 불가능했던 적은 수의 투사 데이터로부터 더욱 정확한 3차원 복원 영상을 제공하는 데 성공했다.

연구팀이 개발한 알고리즘은 기존의 EDX 측정 신호 기반 3차원 재구성 기법과 비교해 나노입자를 형성하고 있는 원자의 형상과 경계를 뚜렷하게 구별했으며, 복원된 다양한 코어-쉘(core-shell) 구조의 퀀텀닷 3차원 영상이 샘플의 광학적 특성과 높은 상관관계를 나타내는 것이 확인됐다.

예종철 교수는 "연구에서 개발한 인공지능 기술을 통해 상용 디스플레이의 핵심 기반이 되는 퀀텀닷 및 반도체 소자의 양자 효율과 화학적 안정성을 더욱 정밀하게 분석할 수 있다ˮ고 말했다.

2021.02.16

조회수 86239

-

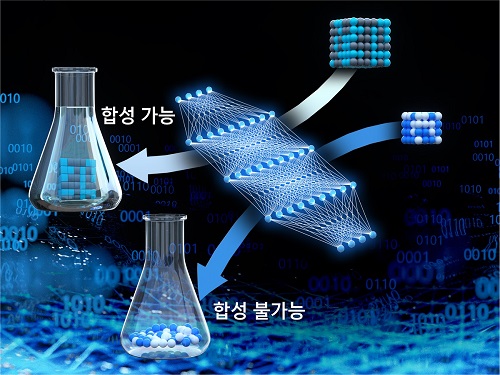

딥러닝으로 소재 합성 가능성 예측 기술 개발

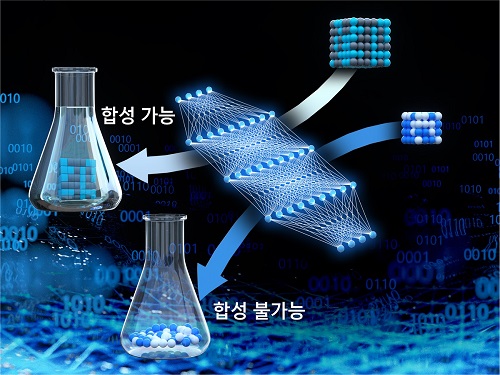

우리 대학 생명화학공학과 정유성 교수 연구팀이 딥러닝을 활용해 소재의 합성 가능성을 높은 정확도로 예측하는 기술을 개발했다고 22일 밝혔다.

신소재 설계의 궁극적인 목표는 소재를 설계하고 그것을 실험적으로 합성하는 것이지만 현실적으로는 새롭게 설계된 대부분의 소재가 실제 합성 단계에서 성공하지 못하고 버려지는 경우가 많다. 이는 불필요한 시간과 자원의 낭비를 초래한다. 소재의 합성 여부는 반응 조건, 열역학, 반응 속도, 소재 구조 등 다양한 요인에 의해서 결정되기 때문에, 소재의 합성 가능성을 예측하는 것은 매우 도전적인 과제로 여겨져 왔다.

이런 문제 해결을 위한 방안으로 간단한 열역학적 안정성만을 고려해 고체 소재의 합성 가능성을 추정하지만 정확도는 매우 떨어지는 편이다. 일례로 에너지적으로 안정된 물질이라 하더라도 합성이 안 되는 경우가 아주 빈번하고, 또 반대로 *준안정 상태의 물질들도 합성되는 경우가 많기 때문이다. 따라서, 합성 가능성에 대한 예측 정확도를 획기적으로 높일 수 있는 방법론의 개발이 시급한 과제로 여겨져 왔다.

☞ 준안정(metastable) 상태 : 어떤 물질이 열역학적으로 안정된 ‘바닥 상태’가 아닌 상태

정유성 교수 연구팀이 개발한 소재 합성 가능성 예측기술은, 기존 합성이 보고된 고체 소재들의 구조적 유사성을 그래프 합성 곱 신경망(GCN, Graph Convolutional Neural Network)으로 학습해 새로운 소재의 합성 가능성을 예측할 수 있다. 특히, 현재까지 합성이 안 된 물질이라 하더라도 합성이 성공할 가능성은 여전히 존재하기 때문에 참값(레이블)을 이미 알고 학습을 진행하는 일반적인 지도학습과는 달리 양의 레이블(+)을 가진 데이터와 레이블이 없는 데이터(Positive-Unlabeled, P-U)를 이용한 분류 모델 기반의 준 지도학습을 사용했다.

정 교수팀은 5만여 종에 달하는 이미 합성이 보고된 물질과 8만여 종의 *가상 물질로 이뤄진 `머터리얼스 프로젝트(Materials Project, MP)'라는 소재 관련 데이터베이스를 이용해 모델을 구축했다. 연구팀 관계자는 이 신기술을 활용한 결과, 소재들의 합성 가능성을 약 87% 정확하게 예측할 수 있다고 설명했다. 정 교수팀은 또 이미 합성된 소재들의 열역학적 특성을 분석한 결과, 열역학적 안정성만으로는 실제 소재의 합성 가능성을 예측할 수 없다는 사실도 알아냈다.

☞ 가상 물질(hypothetical materials) : 기존에 합성되어 보고된 물질들을 원소 치환해서 얻어지는 가상의 물질들로 아직 실험적으로 합성 보고가 이루어지지 않은 물질

이와 함께 머터리얼스 프로젝트(MP) 데이터베이스 내에 합성 가능성 점수가 가장 높은 100개의 가상 물질에 대해 문헌조사를 실시한 결과, 이들 중 머터리얼스 프로젝트(MP) 데이터베이스에는 합성 여부가 아직 알려지지 않았지만 실제로 합성돼 논문에 보고된 소재만도 71개에 달하는 것을 확인했고 이를 통해 모델의 높은 정확도를 추가로 입증했다.

정유성 교수는 "빠른 신소재 발견을 위해 다양한 소재 설계 프레임워크가 존재하지만 정작 설계된 소재의 합성 가능성에 관한 판단은 전문가 직관의 영역으로 남아 있다ˮ면서 "이번에 개발한 합성 가능성 예측 모델은 새로운 소재를 설계할 때 실제로 합성 가능성을 실험 전에 미리 판단할 수 있어 새로운 소재의 개발시간을 단축하는 데 큰 도움이 될 것ˮ이라고 말했다.

생명화학공학과 장지돈 박사과정과 구근호 박사후연구원이 공동 제1 저자로 참여한 이번 연구결과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 10월 26일 자에 실렸다. (논문명: Structure-Based Synthesizability Prediction of Crystals Using Partially Supervised Learing)

한편 이번 연구는 과학기술정보통신부 산하 한국연구재단의 기초연구사업(중견연구)과 미래소재 디스커버리 사업 지원을 받아 수행됐고, 연구에 KISTI의 슈퍼컴퓨터를 활용했다.

딥러닝으로 소재 합성 가능성 예측 기술 개발

우리 대학 생명화학공학과 정유성 교수 연구팀이 딥러닝을 활용해 소재의 합성 가능성을 높은 정확도로 예측하는 기술을 개발했다고 22일 밝혔다.

신소재 설계의 궁극적인 목표는 소재를 설계하고 그것을 실험적으로 합성하는 것이지만 현실적으로는 새롭게 설계된 대부분의 소재가 실제 합성 단계에서 성공하지 못하고 버려지는 경우가 많다. 이는 불필요한 시간과 자원의 낭비를 초래한다. 소재의 합성 여부는 반응 조건, 열역학, 반응 속도, 소재 구조 등 다양한 요인에 의해서 결정되기 때문에, 소재의 합성 가능성을 예측하는 것은 매우 도전적인 과제로 여겨져 왔다.

이런 문제 해결을 위한 방안으로 간단한 열역학적 안정성만을 고려해 고체 소재의 합성 가능성을 추정하지만 정확도는 매우 떨어지는 편이다. 일례로 에너지적으로 안정된 물질이라 하더라도 합성이 안 되는 경우가 아주 빈번하고, 또 반대로 *준안정 상태의 물질들도 합성되는 경우가 많기 때문이다. 따라서, 합성 가능성에 대한 예측 정확도를 획기적으로 높일 수 있는 방법론의 개발이 시급한 과제로 여겨져 왔다.

☞ 준안정(metastable) 상태 : 어떤 물질이 열역학적으로 안정된 ‘바닥 상태’가 아닌 상태

정유성 교수 연구팀이 개발한 소재 합성 가능성 예측기술은, 기존 합성이 보고된 고체 소재들의 구조적 유사성을 그래프 합성 곱 신경망(GCN, Graph Convolutional Neural Network)으로 학습해 새로운 소재의 합성 가능성을 예측할 수 있다. 특히, 현재까지 합성이 안 된 물질이라 하더라도 합성이 성공할 가능성은 여전히 존재하기 때문에 참값(레이블)을 이미 알고 학습을 진행하는 일반적인 지도학습과는 달리 양의 레이블(+)을 가진 데이터와 레이블이 없는 데이터(Positive-Unlabeled, P-U)를 이용한 분류 모델 기반의 준 지도학습을 사용했다.

정 교수팀은 5만여 종에 달하는 이미 합성이 보고된 물질과 8만여 종의 *가상 물질로 이뤄진 `머터리얼스 프로젝트(Materials Project, MP)'라는 소재 관련 데이터베이스를 이용해 모델을 구축했다. 연구팀 관계자는 이 신기술을 활용한 결과, 소재들의 합성 가능성을 약 87% 정확하게 예측할 수 있다고 설명했다. 정 교수팀은 또 이미 합성된 소재들의 열역학적 특성을 분석한 결과, 열역학적 안정성만으로는 실제 소재의 합성 가능성을 예측할 수 없다는 사실도 알아냈다.

☞ 가상 물질(hypothetical materials) : 기존에 합성되어 보고된 물질들을 원소 치환해서 얻어지는 가상의 물질들로 아직 실험적으로 합성 보고가 이루어지지 않은 물질

이와 함께 머터리얼스 프로젝트(MP) 데이터베이스 내에 합성 가능성 점수가 가장 높은 100개의 가상 물질에 대해 문헌조사를 실시한 결과, 이들 중 머터리얼스 프로젝트(MP) 데이터베이스에는 합성 여부가 아직 알려지지 않았지만 실제로 합성돼 논문에 보고된 소재만도 71개에 달하는 것을 확인했고 이를 통해 모델의 높은 정확도를 추가로 입증했다.

정유성 교수는 "빠른 신소재 발견을 위해 다양한 소재 설계 프레임워크가 존재하지만 정작 설계된 소재의 합성 가능성에 관한 판단은 전문가 직관의 영역으로 남아 있다ˮ면서 "이번에 개발한 합성 가능성 예측 모델은 새로운 소재를 설계할 때 실제로 합성 가능성을 실험 전에 미리 판단할 수 있어 새로운 소재의 개발시간을 단축하는 데 큰 도움이 될 것ˮ이라고 말했다.

생명화학공학과 장지돈 박사과정과 구근호 박사후연구원이 공동 제1 저자로 참여한 이번 연구결과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 10월 26일 자에 실렸다. (논문명: Structure-Based Synthesizability Prediction of Crystals Using Partially Supervised Learing)

한편 이번 연구는 과학기술정보통신부 산하 한국연구재단의 기초연구사업(중견연구)과 미래소재 디스커버리 사업 지원을 받아 수행됐고, 연구에 KISTI의 슈퍼컴퓨터를 활용했다.

2020.12.22

조회수 54542

-

딥러닝 기반 실시간 기침 인식 카메라 개발

우리 대학 기계공학과 박용화 교수 연구팀이 ㈜에스엠 인스트루먼트와 공동으로 실시간으로 기침 소리를 인식하고 기침하는 사람의 위치를 이미지로 표시해주는 '기침 인식 카메라'를 개발했다고 3일 밝혔다.

작년 말부터 시작된 세계적 유행성 전염병인 코로나19가 최근 미국·중국·유럽 등 세계 각국에서 재확산되는 추세로 접어들면서 비접촉방식으로 전염병을 감지하는 기술에 대한 수요가 증가하고 있다.

코로나19의 대표적인 증상이 발열과 기침인데, 현재 발열은 열화상 카메라를 이용해 직접 접촉을 하지 않고도 체온을 쉽게 판별할 수 있다. 문제는 비접촉방식으로는 기침하는 사람의 증상을 쉽사리 파악하기 어렵다는 점이다. 박 교수 연구팀은 이런 문제를 해결하기 위해 기침 소리를 실시간으로 인식하는 딥러닝 기반의 기침 인식 모델을 개발했다. 또한 열화상 카메라와 같은 원리로 기침 소리와 기침하는 사람의 시각화를 위해 기침 인식 모델을 음향 카메라에 적용, 기침 소리와 기침하는 사람의 위치, 심지어 기침 횟수까지를 실시간으로 추적하고 기록이 가능한 '기침 인식 카메라'를 개발했다.

연구팀은 기침 인식 카메라가 사람이 밀집한 공공장소에서 전염병의 유행을 감지하거나 병원에서 환자의 상태를 상시 모니터링 가능한 의료용 장비로 활용될 것으로 기대하고 있다.

연구팀은 기침 인식 모델 개발을 위해 *합성 곱 신경망(convolutional neural network, CNN)을 기반으로 *지도학습(supervised learning)을 적용했다. 1초 길이 음향신호의 특징(feature)을 입력 신호로 받아, 1(기침) 또는 0(그 외)의 2진 신호를 출력하고 학습률의 최적화를 위해 일정 기간 학습률이 정체되면 학습률 값을 낮추도록 설정했다.

이어서 기침 인식 모델의 훈련 및 평가를 위해 구글과 유튜브 등에서 연구용으로 활발히 사용 중인 공개 음성데이터 세트인 `오디오세트(Audioset)'를 비롯해 `디맨드(DEMAND)'와 `이티에스아이(ETSI)', `티미트(TIMIT)' 등에서 데이터 세트를 수집했다. 이 중 `오디오세트'는 훈련 및 평가 데이터 세트 구성을 위해 사용했고 다른 데이터 세트의 경우 기침 인식 모델이 다양한 배경 소음을 학습할 수 있도록 데이터 증강(data augmentation)을 위한 배경 소음으로 사용했다.

☞ 합성 곱 신경망(convolutional neural network): 시각적 이미지를 분석하는 데 사용되는 인공신경망(생물학의 신경망에서 영감을 얻은 통계학적 학습 알고리즘)의 한 종류

☞ 지도학습(Supervised Learning): 훈련 데이터(Training Data)로부터 하나의 함수를 유추해내기 위한 기계 학습(Machine Learning)의 한 방법

데이터 증강을 위해 배경 소음을 15%~75%의 비율로 `오디오세트'에 섞은 후, 다양한 거리에 적응할 수 있게 음량을 0.25~1.0배로 조정했다. 훈련 및 평가 데이터 세트는 증강된 데이터 세트를 9:1 비율로 나눠 구성했으며, 시험 데이터 세트는 따로 사무실에서 녹음한 것을 사용했다.

모델 최적화를 위해서는 '스펙트로그램(spectrogram)' 등 5개의 음향 특징과 7개의 최적화 기기(optimizer)를 사용해 학습을 진행하고 시험 데이터 세트의 정확도를 측정, 성능을 확인한 결과 87.4%의 시험 정확도를 얻을 수 있었다.

연구팀은 이어 학습된 기침 인식 모델을 소리를 수집하는 마이크로폰 어레이와 카메라 모듈로 구성되는 음향 카메라에 적용했다. 그 결과 수집된 데이터는 음원의 위치를 계산하는 빔 형성 과정을 거쳐 기침 인식 모델이 기침 소리로 인식할 경우 기침 소리가 난 위치에 기침 소리임을 나타내는 등고선과 라벨이 각각 표시된다.

박 교수팀은 마지막 단계로 기침 인식 카메라의 예비 테스트를 진행한 결과, 여러 잡음 환경에서도 기침 소리와 그 이외의 소리로 구분이 가능하며 기침하는 사람과 그 사람의 위치, 횟수 등을 실시간으로 추적해 현장에서의 적용 가능성을 확인했다. 이들은 추후 병원 등 실사용 환경에서 추가 학습이 이뤄진다면 정확도는 87.4%보다 더 높아질 것으로 기대하고 있다.

박용화 교수는 "코로나19가 지속적으로 전파되고 있는 상황에서 공공장소와 다수 밀집 시설에 기침 인식 카메라를 활용하면 전염병의 방역 및 조기 감지에 큰 도움이 될 것ˮ이라고 말했다. 박 교수는 이어 "특히 병실에 적용하면 환자의 상태를 24시간 기록해 치료에 활용할 수 있기 때문에 의료진의 수고를 줄이고 환자 상태를 더 정밀하게 파악할 수 있을 것ˮ 이라고 강조했다.

한편, 이번 연구는 에너지기술평가원(산업통상자원부)의 지원을 받아 수행됐다.

딥러닝 기반 실시간 기침 인식 카메라 개발

우리 대학 기계공학과 박용화 교수 연구팀이 ㈜에스엠 인스트루먼트와 공동으로 실시간으로 기침 소리를 인식하고 기침하는 사람의 위치를 이미지로 표시해주는 '기침 인식 카메라'를 개발했다고 3일 밝혔다.

작년 말부터 시작된 세계적 유행성 전염병인 코로나19가 최근 미국·중국·유럽 등 세계 각국에서 재확산되는 추세로 접어들면서 비접촉방식으로 전염병을 감지하는 기술에 대한 수요가 증가하고 있다.

코로나19의 대표적인 증상이 발열과 기침인데, 현재 발열은 열화상 카메라를 이용해 직접 접촉을 하지 않고도 체온을 쉽게 판별할 수 있다. 문제는 비접촉방식으로는 기침하는 사람의 증상을 쉽사리 파악하기 어렵다는 점이다. 박 교수 연구팀은 이런 문제를 해결하기 위해 기침 소리를 실시간으로 인식하는 딥러닝 기반의 기침 인식 모델을 개발했다. 또한 열화상 카메라와 같은 원리로 기침 소리와 기침하는 사람의 시각화를 위해 기침 인식 모델을 음향 카메라에 적용, 기침 소리와 기침하는 사람의 위치, 심지어 기침 횟수까지를 실시간으로 추적하고 기록이 가능한 '기침 인식 카메라'를 개발했다.

연구팀은 기침 인식 카메라가 사람이 밀집한 공공장소에서 전염병의 유행을 감지하거나 병원에서 환자의 상태를 상시 모니터링 가능한 의료용 장비로 활용될 것으로 기대하고 있다.

연구팀은 기침 인식 모델 개발을 위해 *합성 곱 신경망(convolutional neural network, CNN)을 기반으로 *지도학습(supervised learning)을 적용했다. 1초 길이 음향신호의 특징(feature)을 입력 신호로 받아, 1(기침) 또는 0(그 외)의 2진 신호를 출력하고 학습률의 최적화를 위해 일정 기간 학습률이 정체되면 학습률 값을 낮추도록 설정했다.

이어서 기침 인식 모델의 훈련 및 평가를 위해 구글과 유튜브 등에서 연구용으로 활발히 사용 중인 공개 음성데이터 세트인 `오디오세트(Audioset)'를 비롯해 `디맨드(DEMAND)'와 `이티에스아이(ETSI)', `티미트(TIMIT)' 등에서 데이터 세트를 수집했다. 이 중 `오디오세트'는 훈련 및 평가 데이터 세트 구성을 위해 사용했고 다른 데이터 세트의 경우 기침 인식 모델이 다양한 배경 소음을 학습할 수 있도록 데이터 증강(data augmentation)을 위한 배경 소음으로 사용했다.

☞ 합성 곱 신경망(convolutional neural network): 시각적 이미지를 분석하는 데 사용되는 인공신경망(생물학의 신경망에서 영감을 얻은 통계학적 학습 알고리즘)의 한 종류

☞ 지도학습(Supervised Learning): 훈련 데이터(Training Data)로부터 하나의 함수를 유추해내기 위한 기계 학습(Machine Learning)의 한 방법

데이터 증강을 위해 배경 소음을 15%~75%의 비율로 `오디오세트'에 섞은 후, 다양한 거리에 적응할 수 있게 음량을 0.25~1.0배로 조정했다. 훈련 및 평가 데이터 세트는 증강된 데이터 세트를 9:1 비율로 나눠 구성했으며, 시험 데이터 세트는 따로 사무실에서 녹음한 것을 사용했다.

모델 최적화를 위해서는 '스펙트로그램(spectrogram)' 등 5개의 음향 특징과 7개의 최적화 기기(optimizer)를 사용해 학습을 진행하고 시험 데이터 세트의 정확도를 측정, 성능을 확인한 결과 87.4%의 시험 정확도를 얻을 수 있었다.

연구팀은 이어 학습된 기침 인식 모델을 소리를 수집하는 마이크로폰 어레이와 카메라 모듈로 구성되는 음향 카메라에 적용했다. 그 결과 수집된 데이터는 음원의 위치를 계산하는 빔 형성 과정을 거쳐 기침 인식 모델이 기침 소리로 인식할 경우 기침 소리가 난 위치에 기침 소리임을 나타내는 등고선과 라벨이 각각 표시된다.

박 교수팀은 마지막 단계로 기침 인식 카메라의 예비 테스트를 진행한 결과, 여러 잡음 환경에서도 기침 소리와 그 이외의 소리로 구분이 가능하며 기침하는 사람과 그 사람의 위치, 횟수 등을 실시간으로 추적해 현장에서의 적용 가능성을 확인했다. 이들은 추후 병원 등 실사용 환경에서 추가 학습이 이뤄진다면 정확도는 87.4%보다 더 높아질 것으로 기대하고 있다.

박용화 교수는 "코로나19가 지속적으로 전파되고 있는 상황에서 공공장소와 다수 밀집 시설에 기침 인식 카메라를 활용하면 전염병의 방역 및 조기 감지에 큰 도움이 될 것ˮ이라고 말했다. 박 교수는 이어 "특히 병실에 적용하면 환자의 상태를 24시간 기록해 치료에 활용할 수 있기 때문에 의료진의 수고를 줄이고 환자 상태를 더 정밀하게 파악할 수 있을 것ˮ 이라고 강조했다.

한편, 이번 연구는 에너지기술평가원(산업통상자원부)의 지원을 받아 수행됐다.

2020.08.03

조회수 32000

-

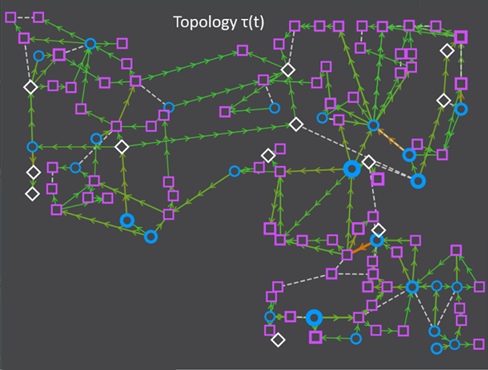

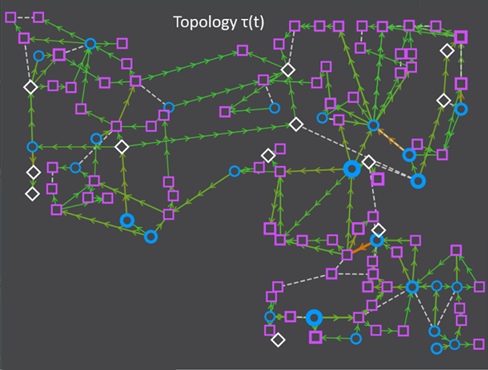

AI대학원 김기응 교수 연구팀, 인공지능 전력망 운영관리 국제대회 1위 달성

우리 대학 AI대학원 김기응 교수 연구팀(홍성훈, 윤든솔 석사과정, 이병준 박사과정)이 인공지능 기반 전력망 운영관리 기술을 겨루는 국제경진대회인 'L2RPN 챌린지(Learning to Run a Power Network Challenge 2020 WCCI)'에서 최종 1위를 차지했다. 이 대회는 기계학습 연구를 촉진하기 위한 각종 경진대회를 주관하는 비영리단체 ChaLearn, 유럽 최대 전력망을 운영관리하는 프랑스 전력공사의 자회사 RTE(Réseau de Transport d'Électricité)社 및 세계 최대 규모의 전력 회사 SGCC(State Grid of China)의 자회사인 GEIRI North America(Global Energy Interconnection Research Institute)에서 공동주최해, 세계 각국의 약 50팀이 약 40일간 (2020.05.20.~06.30) 온라인으로 참여해 성황리에 마감됐다.

단순한 전력망이 스마트 그리드를 넘어서 에너지 클라우드 및 네트워크로 진화하려면 신재생 에너지의 비율이 30% 이상이 돼야 하고, 신재생 에너지 비율이 높아지면 전력망 운영의 복잡도가 매우 증가한다. 실제로 독일의 경우 신재생 에너지 비율이 30%가 넘어가면서 전력사고가 3,000건 이상 증가할 정도로 심각하며, 미국의 ENRON 사태 직전에도 에너지 발전과 수요 사이의 수급 조절에 문제가 생기면서 잦은 정전 사태가 났던 사례도 있다.

전력망 운영에 인공지능 기술 도입은 아직 초기 단계이며, 현재 사용되고 있는 전력망은 관리자의 개입 없이 1시간 이상 운영되기 힘든 실정이다. 이에 프랑스의 RTE(Réseau de Transport d'Électricité) 社는 전력망 운영에 인공지능 기술을 접목하는 경진대회 'L2RPN'을 2019년 처음 개최했다. 2019년 대회는 IEEE-14라는 14개의 변전소를 포함하는 가상의 전력망에서 단순한 운영을 목표로 열렸다. 2020년 대회는 L2RPN 2020 WCCI 챌린지라는 이름으로 특정 국가 수도 규모의 복잡한 전력망을 72시간 동안 관리자의 개입 없이 스스로 안전하고 효율적으로 운영될 수 있는 인공지능 전력망 관리 에이전트를 개발하는 것을 목표로 열렸다. 시간에 따른 공급-수요의 변화, 시설 유지보수 및 재난에 따른 급작스러운 단전 등 다양한 시나리오에 대해 전력망 운영관리 능력의 평가가 이뤄졌다.

김 교수 연구팀은 이번 2020년 대회에서 전력망 구조를 효과적으로 반영할 수 있는 그래프 신경망 모델 기반의 강화학습 에이전트를 개발해 참가했다. 기존의 에이전트들은 소규모의 전력망에서만 적용 가능하다는 한계가 있었지만, 김 교수 연구팀은 국가 수도 규모의 복잡한 전력망에도 적용 가능한 에이전트를 개발했다. 연구팀이 개발한 인공지능 전력망 운영관리 에이전트는 주어진 모든 테스트 시나리오에 대해 안전하고 효율적으로 전력망을 운영해 최종 1위의 성적을 거뒀다. 우승팀에게는 상금으로 미국 실리콘밸리에 있는 GEIRI North America를 방문할 수 있는 여행경비와 학회참가 비용 3,000달러가 주어진다. 연구진은 앞으로도 기술을 고도화해 국가 규모의 전력망과 다양한 신재생 에너지원을 다룰 수 있도록 확장할 계획이다.

한편 이번 연구는 과기정통부 에너지 클라우드 기술개발 사업의 지원으로 설치된 개방형 에너지 클라우드 플랫폼 연구단과제로 수행됐다. (연구단장 KAIST 전산학부 문수복 교수)

※ 대회 결과 사이트 관련 링크: https://l2rpn.chalearn.org/competitions

※ 개방형 에너지 클라우드 플랫폼 연구단 사이트: https://www.oecp.kaist.ac.kr

AI대학원 김기응 교수 연구팀, 인공지능 전력망 운영관리 국제대회 1위 달성

우리 대학 AI대학원 김기응 교수 연구팀(홍성훈, 윤든솔 석사과정, 이병준 박사과정)이 인공지능 기반 전력망 운영관리 기술을 겨루는 국제경진대회인 'L2RPN 챌린지(Learning to Run a Power Network Challenge 2020 WCCI)'에서 최종 1위를 차지했다. 이 대회는 기계학습 연구를 촉진하기 위한 각종 경진대회를 주관하는 비영리단체 ChaLearn, 유럽 최대 전력망을 운영관리하는 프랑스 전력공사의 자회사 RTE(Réseau de Transport d'Électricité)社 및 세계 최대 규모의 전력 회사 SGCC(State Grid of China)의 자회사인 GEIRI North America(Global Energy Interconnection Research Institute)에서 공동주최해, 세계 각국의 약 50팀이 약 40일간 (2020.05.20.~06.30) 온라인으로 참여해 성황리에 마감됐다.

단순한 전력망이 스마트 그리드를 넘어서 에너지 클라우드 및 네트워크로 진화하려면 신재생 에너지의 비율이 30% 이상이 돼야 하고, 신재생 에너지 비율이 높아지면 전력망 운영의 복잡도가 매우 증가한다. 실제로 독일의 경우 신재생 에너지 비율이 30%가 넘어가면서 전력사고가 3,000건 이상 증가할 정도로 심각하며, 미국의 ENRON 사태 직전에도 에너지 발전과 수요 사이의 수급 조절에 문제가 생기면서 잦은 정전 사태가 났던 사례도 있다.

전력망 운영에 인공지능 기술 도입은 아직 초기 단계이며, 현재 사용되고 있는 전력망은 관리자의 개입 없이 1시간 이상 운영되기 힘든 실정이다. 이에 프랑스의 RTE(Réseau de Transport d'Électricité) 社는 전력망 운영에 인공지능 기술을 접목하는 경진대회 'L2RPN'을 2019년 처음 개최했다. 2019년 대회는 IEEE-14라는 14개의 변전소를 포함하는 가상의 전력망에서 단순한 운영을 목표로 열렸다. 2020년 대회는 L2RPN 2020 WCCI 챌린지라는 이름으로 특정 국가 수도 규모의 복잡한 전력망을 72시간 동안 관리자의 개입 없이 스스로 안전하고 효율적으로 운영될 수 있는 인공지능 전력망 관리 에이전트를 개발하는 것을 목표로 열렸다. 시간에 따른 공급-수요의 변화, 시설 유지보수 및 재난에 따른 급작스러운 단전 등 다양한 시나리오에 대해 전력망 운영관리 능력의 평가가 이뤄졌다.

김 교수 연구팀은 이번 2020년 대회에서 전력망 구조를 효과적으로 반영할 수 있는 그래프 신경망 모델 기반의 강화학습 에이전트를 개발해 참가했다. 기존의 에이전트들은 소규모의 전력망에서만 적용 가능하다는 한계가 있었지만, 김 교수 연구팀은 국가 수도 규모의 복잡한 전력망에도 적용 가능한 에이전트를 개발했다. 연구팀이 개발한 인공지능 전력망 운영관리 에이전트는 주어진 모든 테스트 시나리오에 대해 안전하고 효율적으로 전력망을 운영해 최종 1위의 성적을 거뒀다. 우승팀에게는 상금으로 미국 실리콘밸리에 있는 GEIRI North America를 방문할 수 있는 여행경비와 학회참가 비용 3,000달러가 주어진다. 연구진은 앞으로도 기술을 고도화해 국가 규모의 전력망과 다양한 신재생 에너지원을 다룰 수 있도록 확장할 계획이다.

한편 이번 연구는 과기정통부 에너지 클라우드 기술개발 사업의 지원으로 설치된 개방형 에너지 클라우드 플랫폼 연구단과제로 수행됐다. (연구단장 KAIST 전산학부 문수복 교수)

※ 대회 결과 사이트 관련 링크: https://l2rpn.chalearn.org/competitions

※ 개방형 에너지 클라우드 플랫폼 연구단 사이트: https://www.oecp.kaist.ac.kr

2020.07.28

조회수 31374

-

기존 인공지능 기술을 뛰어넘는 양자 인공지능 알고리즘 개발

우리 대학 전기및전자공학부 및 AI 양자컴퓨팅 IT 인력양성연구센터장 이준구 교수 연구팀이 독일 및 남아공 연구팀과의 협력 연구를 통해 비선형 양자 기계학습 인공지능 알고리즘을 개발했다고 7일 밝혔다.

양자 인공지능은 양자컴퓨터의 발전과 함께 현재의 인공지능을 앞설 것으로 크게 기대되고 있으나 연산 방법이 전혀 달라 새로운 양자 알고리즘의 개발이 절실하다. 특히 양자컴퓨터는 본질적으로 일차방정식을 잘 푸는 선형적 성질을 가지고 있어 복잡한 데이터를 다루는 비선형적 기계학습에 어려움이 존재했다. 하지만 이번 연구를 통해 비선형 커널이 고안되어 복잡한 데이터에 대한 양자 기계학습이 가능하게 됐다. 특히 이준구 교수팀이 개발한 양자 지도학습 알고리즘은 학습에 있어 매우 적은 계산량으로 연산이 가능하다. 따라서 대규모 계산량이 필요한 현재의 인공지능 기술을 추월할 가능성을 제시한 것으로 평가를 받고 있다.

이준구 교수팀은 학습데이터와 테스트데이터를 양자 정보로 생성한 후 양자 정보의 병렬연산을 가능하게 하는 양자포킹 기술과 간단한 양자 측정기술을 조합해 양자 데이터 간의 유사성을 효율적으로 계산하는 비선형 커널 기반의 지도학습을 구현하는 양자 알고리즘 체계를 만들었다. 이후 IBM 클라우드 서비스를 통해 실제 양자컴퓨터에서 양자 지도학습을 실제 시연하는 데 성공했다.

KAIST 박경덕 연구교수가 공동 제1 저자로 참여한 이번 연구결과는 국제 학술지 네이처 자매지인 `npj Quantum Information' 誌 2020년 5월 6권에 게재됐다. (논문명: Quantum classifier with tailored quantum kernel).

기계학습에 있어 중요한 문제 중 하나는 주어진 데이터의 특징(feature)을 구분해 분류하는 것이다. 간단한 예로 동물 이미지 학습데이터에서 입, 귀 등의 특징을 바탕으로 분류하기 위한 결정 경계(decision boundary)를 학습하고 새로운 이미지가 입력되었을 때 개 또는 고양이로 분류하는 작업을 생각해볼 수 있다. 데이터의 특징들이 잘 나타나는 경우에는 선형적 결정 경계만으로 분류할 수 있다. 그러나 입과 귀 모양의 특징으로만 개와 고양이를 분류하기 쉽지 않다면 새로운 결정 경계를 찾기 위해 특징에 관한 정보 공간의 차원을 확장해야 하는데 이러한 과정에서 비선형 커널 기술이 필요하다.

양자컴퓨팅은 고전 컴퓨팅과는 달리 큐비트(quantum bit, 양자컴퓨팅 정보처리의 기본 단위)의 개수에 따라 정보 공간의 차원이 기하급수적으로 증가하기 때문에 이론적으로 고차원 정보처리에 있어 기하급수적으로 뛰어난 성능을 낼 수 있다.

연구팀은 이러한 양자컴퓨팅의 장점을 활용해 데이터 특징 대비 기하급수적인 계산 효율성을 달성하는 양자 기계학습 알고리즘을 개발했다. 이 교수 연구팀이 개발한 이 알고리즘은 저차원 입력 공간에 존재하는 데이터들을 큐비트로 표현되는 고차원 데이터 특징 공간(feature space)으로 옮긴 후, 양자화된 모든 학습데이터와 테스트데이터 간의 커널 함수를 양자 중첩을 활용해 동시에 계산하고 테스트데이터의 분류를 효율적으로 결정한다. 이때 사용되는 양자 회로의 계산 복잡도는 학습 데이터양에 대해서는 선형적으로 증가하나, 데이터 특징 개수에 대해서는 불과 로그(log)함수로 매우 천천히 증가하는 장점이 있다.

연구팀은 이와 함께 양자 회로의 체계적 설계를 통해 다양한 양자 커널 구현이 가능함을 이론적으로 증명했다. 커널 기반 기계학습에서는 주어진 입력 데이터에 따라 최적 커널이 달라질 수 있으므로, 다양한 양자 커널을 효율적으로 구현할 수 있게 된 점은 양자 커널 기반 기계학습의 실제 응용에 있어 매우 중요한 성과다.

연구팀은 IBM이 클라우드 서비스로 제공하는 다섯 개의 큐비트로 구성된 초전도 기반 양자 컴퓨터에서 이번에 개발에 성공한 양자 기계학습 알고리즘을 실험적으로 구현해 양자 커널 기반 기계학습의 성능을 실제 시연을 통해 이를 입증하는 데 성공했다.

이 연구에 참여한 박경덕 연구교수는 "연구팀이 개발한 커널 기반 양자 기계학습 알고리즘은 수년 안에 상용화될 것으로 예측되는 수백 큐비트의 NISQ(Noisy Intermediate-Scale Quantum) 컴퓨팅의 시대가 되면 기존의 고전 커널 기반 지도학습을 뛰어넘을 것ˮ이라면서 "복잡한 비선형 데이터의 패턴 인식 등을 위한 양자 기계학습 알고리즘으로 활발히 사용될 것ˮ이라고 말했다.

한편 이번 연구는 각각 한국연구재단의 창의 도전 연구기반 지원 사업과 한국연구재단의 한-아프리카 협력기반 조성 사업, 정보통신기획평가원의 정보통신기술인력 양성사업(ITRC)의 지원을 받아 수행됐다.

관련 논문: https://www.nature.com/articles/s41534-020-0272-6

기존 인공지능 기술을 뛰어넘는 양자 인공지능 알고리즘 개발

우리 대학 전기및전자공학부 및 AI 양자컴퓨팅 IT 인력양성연구센터장 이준구 교수 연구팀이 독일 및 남아공 연구팀과의 협력 연구를 통해 비선형 양자 기계학습 인공지능 알고리즘을 개발했다고 7일 밝혔다.

양자 인공지능은 양자컴퓨터의 발전과 함께 현재의 인공지능을 앞설 것으로 크게 기대되고 있으나 연산 방법이 전혀 달라 새로운 양자 알고리즘의 개발이 절실하다. 특히 양자컴퓨터는 본질적으로 일차방정식을 잘 푸는 선형적 성질을 가지고 있어 복잡한 데이터를 다루는 비선형적 기계학습에 어려움이 존재했다. 하지만 이번 연구를 통해 비선형 커널이 고안되어 복잡한 데이터에 대한 양자 기계학습이 가능하게 됐다. 특히 이준구 교수팀이 개발한 양자 지도학습 알고리즘은 학습에 있어 매우 적은 계산량으로 연산이 가능하다. 따라서 대규모 계산량이 필요한 현재의 인공지능 기술을 추월할 가능성을 제시한 것으로 평가를 받고 있다.

이준구 교수팀은 학습데이터와 테스트데이터를 양자 정보로 생성한 후 양자 정보의 병렬연산을 가능하게 하는 양자포킹 기술과 간단한 양자 측정기술을 조합해 양자 데이터 간의 유사성을 효율적으로 계산하는 비선형 커널 기반의 지도학습을 구현하는 양자 알고리즘 체계를 만들었다. 이후 IBM 클라우드 서비스를 통해 실제 양자컴퓨터에서 양자 지도학습을 실제 시연하는 데 성공했다.

KAIST 박경덕 연구교수가 공동 제1 저자로 참여한 이번 연구결과는 국제 학술지 네이처 자매지인 `npj Quantum Information' 誌 2020년 5월 6권에 게재됐다. (논문명: Quantum classifier with tailored quantum kernel).

기계학습에 있어 중요한 문제 중 하나는 주어진 데이터의 특징(feature)을 구분해 분류하는 것이다. 간단한 예로 동물 이미지 학습데이터에서 입, 귀 등의 특징을 바탕으로 분류하기 위한 결정 경계(decision boundary)를 학습하고 새로운 이미지가 입력되었을 때 개 또는 고양이로 분류하는 작업을 생각해볼 수 있다. 데이터의 특징들이 잘 나타나는 경우에는 선형적 결정 경계만으로 분류할 수 있다. 그러나 입과 귀 모양의 특징으로만 개와 고양이를 분류하기 쉽지 않다면 새로운 결정 경계를 찾기 위해 특징에 관한 정보 공간의 차원을 확장해야 하는데 이러한 과정에서 비선형 커널 기술이 필요하다.

양자컴퓨팅은 고전 컴퓨팅과는 달리 큐비트(quantum bit, 양자컴퓨팅 정보처리의 기본 단위)의 개수에 따라 정보 공간의 차원이 기하급수적으로 증가하기 때문에 이론적으로 고차원 정보처리에 있어 기하급수적으로 뛰어난 성능을 낼 수 있다.

연구팀은 이러한 양자컴퓨팅의 장점을 활용해 데이터 특징 대비 기하급수적인 계산 효율성을 달성하는 양자 기계학습 알고리즘을 개발했다. 이 교수 연구팀이 개발한 이 알고리즘은 저차원 입력 공간에 존재하는 데이터들을 큐비트로 표현되는 고차원 데이터 특징 공간(feature space)으로 옮긴 후, 양자화된 모든 학습데이터와 테스트데이터 간의 커널 함수를 양자 중첩을 활용해 동시에 계산하고 테스트데이터의 분류를 효율적으로 결정한다. 이때 사용되는 양자 회로의 계산 복잡도는 학습 데이터양에 대해서는 선형적으로 증가하나, 데이터 특징 개수에 대해서는 불과 로그(log)함수로 매우 천천히 증가하는 장점이 있다.

연구팀은 이와 함께 양자 회로의 체계적 설계를 통해 다양한 양자 커널 구현이 가능함을 이론적으로 증명했다. 커널 기반 기계학습에서는 주어진 입력 데이터에 따라 최적 커널이 달라질 수 있으므로, 다양한 양자 커널을 효율적으로 구현할 수 있게 된 점은 양자 커널 기반 기계학습의 실제 응용에 있어 매우 중요한 성과다.

연구팀은 IBM이 클라우드 서비스로 제공하는 다섯 개의 큐비트로 구성된 초전도 기반 양자 컴퓨터에서 이번에 개발에 성공한 양자 기계학습 알고리즘을 실험적으로 구현해 양자 커널 기반 기계학습의 성능을 실제 시연을 통해 이를 입증하는 데 성공했다.

이 연구에 참여한 박경덕 연구교수는 "연구팀이 개발한 커널 기반 양자 기계학습 알고리즘은 수년 안에 상용화될 것으로 예측되는 수백 큐비트의 NISQ(Noisy Intermediate-Scale Quantum) 컴퓨팅의 시대가 되면 기존의 고전 커널 기반 지도학습을 뛰어넘을 것ˮ이라면서 "복잡한 비선형 데이터의 패턴 인식 등을 위한 양자 기계학습 알고리즘으로 활발히 사용될 것ˮ이라고 말했다.

한편 이번 연구는 각각 한국연구재단의 창의 도전 연구기반 지원 사업과 한국연구재단의 한-아프리카 협력기반 조성 사업, 정보통신기획평가원의 정보통신기술인력 양성사업(ITRC)의 지원을 받아 수행됐다.

관련 논문: https://www.nature.com/articles/s41534-020-0272-6

2020.07.07

조회수 24330

-

학습되지 않은 환경에서 스스로 학습하는 모바일 센싱 기술 개발

우리 대학 전산학부 이성주 교수 연구팀이 학습되지 않은 환경에 적은 양의 데이터로 스스로 적응하는 모바일 센싱 학습 기술 <메타센스(MetaSense)>를 개발했다.

모바일 센싱이란 스마트폰과 같은 모바일 기기의 다양한 센서를 이용하여 서비스(예: 수면의 질 평가, 걸음 수 추적 등)를 제공하는 기술이다. 최근 학계에서는 기계학습 기술의 발전과 더불어 우울증 진단, 운동 자세 관리 등 진보된 모바일 센싱의 가능성을 보여줌으로써 모바일 센싱의 범위를 더욱 확장하고 있다.

하지만 이러한 센싱 기술은 아직 널리 쓰이지 못하고 있다. 사용자 개인마다 가지고 있는 모바일 센싱의 환경이 다르기 때문이다. 사람마다 가지고 있는 고유한 생활패턴과 행동방식, 서로 다른 모바일 기기와 그 사양은 센서의 값에 큰 영향을 미친다. 다른 센서 값은 사람마다 고유한 센싱 환경을 만들고, 이는 센싱 모델이 미리 학습되지 않은 새로운 환경에서 작동할 때 사용이 어려울 만큼 성능 저하를 일으킨다.

연구팀은 이런 학습되지 않는 환경에서 적은 양의 데이터 (최소 1-2 샘플)만 가지고 적응할 수 있는 '메타러닝 프레임워크'를 제시했다. 메타러닝 (meta learning) 이란 적은 양의 데이터를 가지고도 새로운 지식을 학습할 수 있도록 하는 기계학습 원리다. 연구팀이 제시한 기술은 최신 전이학습 (transfer learning) 기술과 비교하여 18%, 메타러닝 기술과 비교하여 15%의 정확도 성능향상을 보였다.

이성주 교수는 ”최근 활발히 제안되고 있는 다양한 모바일 센싱 서비스가 특정 환경에 의존하지 않고 수많은 실제 사용 환경에서 우수한 성능을 보일 수 있게 해주는 연구다. 모바일 센싱 서비스가 연구에 그치지 않고 실제 많은 사람들에게 사용될 수 있는 가능성을 제시해 의미가 있다“라고 했다. 또한 신진우 교수는 “최근 메타러닝 방법론들이 기계학습 분야에서 크게 각광을 받고 있는데 주로 영상 데이터에 국한되어 왔었다. 본 연구에서 비영상 데이터에도 범용적으로 동작하는 메터러닝 기술을 개발하여 성공한 것은 앞으로도 관련 분야 연구에 큰 영향을 주리라 기대한다“라고 덧붙였다.

연구에 대한 설명이 담긴 비디오를 다음 링크에서 확인할 수 있고, (https://youtu.be/-6y0I1pd6XI) 자세한 정보는 프로젝트 웹사이트에서 볼 수 있다.

(https://nmsl.kaist.ac.kr/projects/metasense/)

이성주 교수, 신진우 AI대학원 교수, 공태식 박사과정, 김연수 학사과정이 참여한 이번 연구 결과는 2019년 11월 11일 센싱 컴퓨팅 분야 국제 최우수학회 ACM SenSys에서 발표됐다. (논문명: MetaSense: Few-Shot Adaptation to Untrained Conditions in Deep Mobile Sensing). 이 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단과 정보통신기술진흥센터, 한국연구재단 차세대 정보 컴퓨팅 기술개발사업의 지원을 받아 수행됐다.

학습되지 않은 환경에서 스스로 학습하는 모바일 센싱 기술 개발

우리 대학 전산학부 이성주 교수 연구팀이 학습되지 않은 환경에 적은 양의 데이터로 스스로 적응하는 모바일 센싱 학습 기술 <메타센스(MetaSense)>를 개발했다.

모바일 센싱이란 스마트폰과 같은 모바일 기기의 다양한 센서를 이용하여 서비스(예: 수면의 질 평가, 걸음 수 추적 등)를 제공하는 기술이다. 최근 학계에서는 기계학습 기술의 발전과 더불어 우울증 진단, 운동 자세 관리 등 진보된 모바일 센싱의 가능성을 보여줌으로써 모바일 센싱의 범위를 더욱 확장하고 있다.

하지만 이러한 센싱 기술은 아직 널리 쓰이지 못하고 있다. 사용자 개인마다 가지고 있는 모바일 센싱의 환경이 다르기 때문이다. 사람마다 가지고 있는 고유한 생활패턴과 행동방식, 서로 다른 모바일 기기와 그 사양은 센서의 값에 큰 영향을 미친다. 다른 센서 값은 사람마다 고유한 센싱 환경을 만들고, 이는 센싱 모델이 미리 학습되지 않은 새로운 환경에서 작동할 때 사용이 어려울 만큼 성능 저하를 일으킨다.

연구팀은 이런 학습되지 않는 환경에서 적은 양의 데이터 (최소 1-2 샘플)만 가지고 적응할 수 있는 '메타러닝 프레임워크'를 제시했다. 메타러닝 (meta learning) 이란 적은 양의 데이터를 가지고도 새로운 지식을 학습할 수 있도록 하는 기계학습 원리다. 연구팀이 제시한 기술은 최신 전이학습 (transfer learning) 기술과 비교하여 18%, 메타러닝 기술과 비교하여 15%의 정확도 성능향상을 보였다.

이성주 교수는 ”최근 활발히 제안되고 있는 다양한 모바일 센싱 서비스가 특정 환경에 의존하지 않고 수많은 실제 사용 환경에서 우수한 성능을 보일 수 있게 해주는 연구다. 모바일 센싱 서비스가 연구에 그치지 않고 실제 많은 사람들에게 사용될 수 있는 가능성을 제시해 의미가 있다“라고 했다. 또한 신진우 교수는 “최근 메타러닝 방법론들이 기계학습 분야에서 크게 각광을 받고 있는데 주로 영상 데이터에 국한되어 왔었다. 본 연구에서 비영상 데이터에도 범용적으로 동작하는 메터러닝 기술을 개발하여 성공한 것은 앞으로도 관련 분야 연구에 큰 영향을 주리라 기대한다“라고 덧붙였다.

연구에 대한 설명이 담긴 비디오를 다음 링크에서 확인할 수 있고, (https://youtu.be/-6y0I1pd6XI) 자세한 정보는 프로젝트 웹사이트에서 볼 수 있다.

(https://nmsl.kaist.ac.kr/projects/metasense/)

이성주 교수, 신진우 AI대학원 교수, 공태식 박사과정, 김연수 학사과정이 참여한 이번 연구 결과는 2019년 11월 11일 센싱 컴퓨팅 분야 국제 최우수학회 ACM SenSys에서 발표됐다. (논문명: MetaSense: Few-Shot Adaptation to Untrained Conditions in Deep Mobile Sensing). 이 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단과 정보통신기술진흥센터, 한국연구재단 차세대 정보 컴퓨팅 기술개발사업의 지원을 받아 수행됐다.

2020.06.09

조회수 18262

-

정확성이 획기적으로 향상된 코로나19 영상 진단 기술 개발

우리 대학 바이오및뇌공학과 예종철 교수 연구팀이 흉부 단순 방사선 촬영 영상으로 신종 코로나바이러스 감염증(이하 코로나19) 진단의 정확성을 획기적으로 개선한 인공지능(AI) 기술을 개발했다.

예 교수 연구팀이 개발한 인공지능 기술을 사용해 코로나19 감염 여부를 진단한 결과, 영상 판독 전문가의 69%보다 17%가 향상된 86%이상의 우수한 정확성을 보였다고 KAIST 관계자는 설명했다.

이 기술을 세계적으로 대유행하는 코로나19 선별 진료(Triage)체계에 도입하면 상시 신속한 진단이 가능할 뿐만 아니라 한정된 의료 자원의 효율적인 사용에 큰 도움을 줄 것으로 기대된다.

오유진 박사과정과 박상준 박사과정이 공동 1저자로 참여한 이 연구 결과는 국제 학술지 `아이트리플이 트랜잭션 온 메디컬 이미징(IEEE transactions on medical imaging)'의 `영상기반 코로나19 진단 인공지능기술' 특집호 5월 8일 字 온라인판에 게재됐다. (논문명 : Deep Learning COVID-19 Features on CXR using Limited Training Data Sets)

현재 전 세계적으로 확진자 500만 명을 넘긴 코로나19 진단검사에는 통상 역전사 중합 효소 연쇄 반응(RT-PCR, Reverse Transcription Polymerase Chain Reaction)을 이용한 장비가 사용된다. RT-PCR 검사의 정확성은 90% 이상으로 알려져 있으나, 검사 결과가 나오기까지는 많은 시간이 걸리며 모든 환자에게 시행하기에 비용이 많이 든다는 단점이 있다.

컴퓨터 단층촬영(CT, Computed Tomography)을 이용한 검사도 비교적 높은 정확성을 보이지만 일반적인 X선 단순촬영 검사에 비해 많은 시간이 소요되고 바이러스에 의한 장비의 오염 가능성 때문에 선별 진료에 사용되기 어렵다.

흉부 단순 방사선 촬영(CXR, Chest X-ray)은 여러 폐 질환에서 표준 선별 검사로 활용되고 있지만 코로나19에는 RT-PCR와 CT 검사에 비해 정확성이 현저하게 떨어진다. 그러나, 최근 팬데믹으로 세계 각국에서 확진자 수가 급증함에 따라 비용이 적게 들어가고 검사방법이 용이한 CXR 검사를 정확성을 높여 활용하자는 요구가 증가하고 있다.

그동안 심층 학습(Deep Learning) 기법을 적용해 CXR 영상을 통해 코로나19를 진단하는 여러 연구사례가 보고되고 있지만 진단 정확성을 높이기 위해서는 많은 양의 데이터 확보가 필수적이며 현재와 같은 비상 상황에서는 일관되게 정제된 대량의 데이터를 수집하기가 극히 어렵다.

예 교수 연구팀은 자체 개발한 전처리(Preprocessing)와 국소 패치 기반 방식(Local Patch-based Approach)을 통해 이런 문제점을 해결했다. 적은 데이터 세트에서 발생할 수 있는 영상 간 이질성(Heterogeneity)을 일관된 전처리 과정으로 정규화한 뒤, 국소 패치 기반 방식으로 하나의 영상에서 다양한 패치 영상들을 얻어냄으로써 이미지의 다양성을 확보했다.

또 국소 패치 기반 방식의 장점을 활용한 새로운 인공지능 기술인 `확률적 특징 지도 시각화(Probabilistic Saliency Map Visualization)' 방식을 활용해 CXR 영상에서 코로나19 진단에 중요한 부분을 고화질로 강조해주는 특징 지도를 만들었는데 이 지도가 진단 영상학적 특징과 일치하는 것을 확인했다.

예종철 교수는 "인공지능 알고리즘 기술을 환자의 선별 진료에 활용하면 코로나19 감염 여부를 상시 신속하게 진단할 수 있고 이를 통해 가능성이 낮은 환자를 배제함으로써 한정된 의료 자원을 보다 우선순위가 높은 대상에게 효율적으로 배분할 수 있게 해줄 것ˮ 이라고 말했다.

한편, 이 연구는 한국연구재단 중견연구자지원사업의 지원을 받아 수행됐다.

정확성이 획기적으로 향상된 코로나19 영상 진단 기술 개발

우리 대학 바이오및뇌공학과 예종철 교수 연구팀이 흉부 단순 방사선 촬영 영상으로 신종 코로나바이러스 감염증(이하 코로나19) 진단의 정확성을 획기적으로 개선한 인공지능(AI) 기술을 개발했다.

예 교수 연구팀이 개발한 인공지능 기술을 사용해 코로나19 감염 여부를 진단한 결과, 영상 판독 전문가의 69%보다 17%가 향상된 86%이상의 우수한 정확성을 보였다고 KAIST 관계자는 설명했다.

이 기술을 세계적으로 대유행하는 코로나19 선별 진료(Triage)체계에 도입하면 상시 신속한 진단이 가능할 뿐만 아니라 한정된 의료 자원의 효율적인 사용에 큰 도움을 줄 것으로 기대된다.

오유진 박사과정과 박상준 박사과정이 공동 1저자로 참여한 이 연구 결과는 국제 학술지 `아이트리플이 트랜잭션 온 메디컬 이미징(IEEE transactions on medical imaging)'의 `영상기반 코로나19 진단 인공지능기술' 특집호 5월 8일 字 온라인판에 게재됐다. (논문명 : Deep Learning COVID-19 Features on CXR using Limited Training Data Sets)

현재 전 세계적으로 확진자 500만 명을 넘긴 코로나19 진단검사에는 통상 역전사 중합 효소 연쇄 반응(RT-PCR, Reverse Transcription Polymerase Chain Reaction)을 이용한 장비가 사용된다. RT-PCR 검사의 정확성은 90% 이상으로 알려져 있으나, 검사 결과가 나오기까지는 많은 시간이 걸리며 모든 환자에게 시행하기에 비용이 많이 든다는 단점이 있다.

컴퓨터 단층촬영(CT, Computed Tomography)을 이용한 검사도 비교적 높은 정확성을 보이지만 일반적인 X선 단순촬영 검사에 비해 많은 시간이 소요되고 바이러스에 의한 장비의 오염 가능성 때문에 선별 진료에 사용되기 어렵다.

흉부 단순 방사선 촬영(CXR, Chest X-ray)은 여러 폐 질환에서 표준 선별 검사로 활용되고 있지만 코로나19에는 RT-PCR와 CT 검사에 비해 정확성이 현저하게 떨어진다. 그러나, 최근 팬데믹으로 세계 각국에서 확진자 수가 급증함에 따라 비용이 적게 들어가고 검사방법이 용이한 CXR 검사를 정확성을 높여 활용하자는 요구가 증가하고 있다.

그동안 심층 학습(Deep Learning) 기법을 적용해 CXR 영상을 통해 코로나19를 진단하는 여러 연구사례가 보고되고 있지만 진단 정확성을 높이기 위해서는 많은 양의 데이터 확보가 필수적이며 현재와 같은 비상 상황에서는 일관되게 정제된 대량의 데이터를 수집하기가 극히 어렵다.

예 교수 연구팀은 자체 개발한 전처리(Preprocessing)와 국소 패치 기반 방식(Local Patch-based Approach)을 통해 이런 문제점을 해결했다. 적은 데이터 세트에서 발생할 수 있는 영상 간 이질성(Heterogeneity)을 일관된 전처리 과정으로 정규화한 뒤, 국소 패치 기반 방식으로 하나의 영상에서 다양한 패치 영상들을 얻어냄으로써 이미지의 다양성을 확보했다.

또 국소 패치 기반 방식의 장점을 활용한 새로운 인공지능 기술인 `확률적 특징 지도 시각화(Probabilistic Saliency Map Visualization)' 방식을 활용해 CXR 영상에서 코로나19 진단에 중요한 부분을 고화질로 강조해주는 특징 지도를 만들었는데 이 지도가 진단 영상학적 특징과 일치하는 것을 확인했다.

예종철 교수는 "인공지능 알고리즘 기술을 환자의 선별 진료에 활용하면 코로나19 감염 여부를 상시 신속하게 진단할 수 있고 이를 통해 가능성이 낮은 환자를 배제함으로써 한정된 의료 자원을 보다 우선순위가 높은 대상에게 효율적으로 배분할 수 있게 해줄 것ˮ 이라고 말했다.

한편, 이 연구는 한국연구재단 중견연구자지원사업의 지원을 받아 수행됐다.

2020.05.25

조회수 17460

소량의 데이터로 딥러닝 정확도 향상기술 발표

최근 다양한 분야에서 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 낙타 사진에 `낙타'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간이 소요된다. 따라서 훈련 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 적은 양의 훈련 데이터가 존재할 때도 높은 예측 정확도를 달성할 수 있는 새로운 모델 훈련 기술을 개발했다고 27일 밝혔다.

심층 학습 모델의 훈련은 주어진 훈련 데이터에서 레이블과 관련성이 높은 특성을 찾아내는 과정으로 볼 수 있다. 예를 들어, `낙타'의 주요 특성이 등에 있는 `혹'이라는 것을 알아내는 것이다. 그런데 훈련 데이터가 불충분할 경우 바람직하지 않은 특성까지도 같이 추출될 수 있는 문제가 발생한다. 예를 들어, 낙타 사진의 배경으로 종종 사막이 등장하기에 낙타에 대한 특성으로 `사막'이 추출되는 것도 가능하다. 사막은 낙타의 고유한 특성이 아닐뿐더러, 이러한 바람직하지 않은 특성으로 인해 사막이 아닌 곳(예: 동물원)에 있는 낙타는 인식하지 못할 수 있다.

이 교수팀이 개발한 기술은 심층 학습 모델의 훈련에서 바람직하지 않은 특성을 억제해 충분하지 않은 훈련 데이터를 가지고도 높은 예측 정확도를 달성할 수 있게 해준다.

우리 대학 지식서비스공학대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 송환준 박사, 김민석 박사과정 학생이 제2, 제3 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2021'에서 올 12월 발표될 예정이다. (논문명 : Task-Agnostic Undesirable Feature Deactivation Using Out-of-Distribution Data)

바람직하지 않은 특성을 억제하기 위해서 분포 外(out-of-distribution) 데이터를 활용한다. 예를 들어, 낙타와 호랑이 사진의 분류를 위한 훈련 데이터에 대해 여우 사진은 분포 외 데이터가 된다. 이때 이 교수팀이 착안한 점은 훈련 데이터에 존재하는 바람직하지 않은 특성은 분포 외 데이터에도 존재할 수 있다는 점이다.

즉, 위의 예에서 여우 사진의 배경으로도 사막이 나올 수 있다. 따라서 다량의 분포 외 데이터를 추가로 활용해 여기에서 추출된 특성은 영(0) 벡터가 되도록 심층 학습 모델의 훈련 과정을 규제해 바람직하지 않은 특성의 효과를 억제한다. 훈련 과정을 규제한다는 측면에서 정규화 방법론의 일종이라 볼 수 있다. 분포 외 데이터는 쓸모없는 것이라 여겨지고 있었으나, 이번 기술에 의해 훈련 데이터 부족을 해소할 수 있는 유용한 보완재로 탈바꿈될 수 있다.

연구팀은 이 정규화 방법론을 `비선호(比選好) 특성 억제'라고 이름 붙이고 이미지 데이터 분석의 세 가지 주요 문제에 적용했다. 그 결과, 기존 최신 방법론과 비교했을 때, 이미지 분류 문제에서 최대 12% 예측 정확도를 향상했고, 객체 검출 문제에서 최대 3% 예측 정확도를 향상했으며, 객체 지역화 문제에서 최대 8% 예측 정확도를 향상했다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 훈련 데이터 부족 현상을 해결할 수 있는 새로운 방법ˮ 이라면서 "분류, 회귀 분석을 비롯한 다양한 기계 학습 문제에 폭넓게 적용될 수 있어, 심층 학습의 전반적인 성능 개선에 기여할 수 있다ˮ 고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다. (끝).

2021.10.27 조회수 13029

소량의 데이터로 딥러닝 정확도 향상기술 발표

최근 다양한 분야에서 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서는 심층 학습 모델을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 낙타 사진에 `낙타'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간이 소요된다. 따라서 훈련 데이터가 충분하지 않은 상황을 효과적으로 타개하는 방법이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 적은 양의 훈련 데이터가 존재할 때도 높은 예측 정확도를 달성할 수 있는 새로운 모델 훈련 기술을 개발했다고 27일 밝혔다.

심층 학습 모델의 훈련은 주어진 훈련 데이터에서 레이블과 관련성이 높은 특성을 찾아내는 과정으로 볼 수 있다. 예를 들어, `낙타'의 주요 특성이 등에 있는 `혹'이라는 것을 알아내는 것이다. 그런데 훈련 데이터가 불충분할 경우 바람직하지 않은 특성까지도 같이 추출될 수 있는 문제가 발생한다. 예를 들어, 낙타 사진의 배경으로 종종 사막이 등장하기에 낙타에 대한 특성으로 `사막'이 추출되는 것도 가능하다. 사막은 낙타의 고유한 특성이 아닐뿐더러, 이러한 바람직하지 않은 특성으로 인해 사막이 아닌 곳(예: 동물원)에 있는 낙타는 인식하지 못할 수 있다.

이 교수팀이 개발한 기술은 심층 학습 모델의 훈련에서 바람직하지 않은 특성을 억제해 충분하지 않은 훈련 데이터를 가지고도 높은 예측 정확도를 달성할 수 있게 해준다.

우리 대학 지식서비스공학대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 송환준 박사, 김민석 박사과정 학생이 제2, 제3 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2021'에서 올 12월 발표될 예정이다. (논문명 : Task-Agnostic Undesirable Feature Deactivation Using Out-of-Distribution Data)

바람직하지 않은 특성을 억제하기 위해서 분포 外(out-of-distribution) 데이터를 활용한다. 예를 들어, 낙타와 호랑이 사진의 분류를 위한 훈련 데이터에 대해 여우 사진은 분포 외 데이터가 된다. 이때 이 교수팀이 착안한 점은 훈련 데이터에 존재하는 바람직하지 않은 특성은 분포 외 데이터에도 존재할 수 있다는 점이다.

즉, 위의 예에서 여우 사진의 배경으로도 사막이 나올 수 있다. 따라서 다량의 분포 외 데이터를 추가로 활용해 여기에서 추출된 특성은 영(0) 벡터가 되도록 심층 학습 모델의 훈련 과정을 규제해 바람직하지 않은 특성의 효과를 억제한다. 훈련 과정을 규제한다는 측면에서 정규화 방법론의 일종이라 볼 수 있다. 분포 외 데이터는 쓸모없는 것이라 여겨지고 있었으나, 이번 기술에 의해 훈련 데이터 부족을 해소할 수 있는 유용한 보완재로 탈바꿈될 수 있다.

연구팀은 이 정규화 방법론을 `비선호(比選好) 특성 억제'라고 이름 붙이고 이미지 데이터 분석의 세 가지 주요 문제에 적용했다. 그 결과, 기존 최신 방법론과 비교했을 때, 이미지 분류 문제에서 최대 12% 예측 정확도를 향상했고, 객체 검출 문제에서 최대 3% 예측 정확도를 향상했으며, 객체 지역화 문제에서 최대 8% 예측 정확도를 향상했다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 훈련 데이터 부족 현상을 해결할 수 있는 새로운 방법ˮ 이라면서 "분류, 회귀 분석을 비롯한 다양한 기계 학습 문제에 폭넓게 적용될 수 있어, 심층 학습의 전반적인 성능 개선에 기여할 수 있다ˮ 고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다. (끝).

2021.10.27 조회수 13029 우수한 소재를 설계하는 딥러닝 방법론 개발

우리 대학 기계공학과 유승화 교수 연구팀이 능동-전이 학습 (active-transfer learning)과 데이터 증강기법(Data augmentation)에 기반해, 심층신경망 초기 훈련에 쓰인 소재들과 형태와 조합이 매우 다른 우수한 특성을 지닌 소재를 효율적으로 탐색하고 설계하는 방법론을 개발했다고 16일 밝혔다.

인공신경망에 기반해 방대한 설계 공간에서 새로운 소재를 찾기 위한 역설계 연구는 최근 매우 활발하게 진행되고 있다. 하지만 이러한 기존 설계 방식은 목표로 하는 소재의 형태와 조합이 심층신경망 훈련에 활용된 소재들과 매우 다를 때 인공신경망이 가지는 낮은 예측능력으로 인해 극히 많은 수의 소재 데이터 검증이 요구되며, 이에 따라 제한적으로만 활용이 가능하다.

연구팀은 이번 연구에서 이를 극복하기 위해 초기 훈련 데이터 영역에서 벗어나 우수한 소재를 효율적으로 탐색할 수 있는 인공신경망 기반 전진 설계 (Forward design) 방법론을 제안했다. 이 방법론은, <그림 1>에 도시된 바와 같이 유전 알고리즘과 결합된 능동-전이 학습 및 데이터 증강기법을 통해 심층신경망을 점진적으로 업데이트함으로써, 초기 훈련데이터를 벗어난 영역에서 심층신경망의 낮은 예측능력을 적은 숫자의 데이터 검증 및 추가로 보완한다.

유전 알고리즘에 의해 제안되는 우수 소재 후보군은 기보유한 소재 데이터를 조합해 도출하기 때문에 심층신경망의 신뢰할 수 있는 예측 영역과 설계 공간 측면에서 상대적으로 가까워 예측정확도가 유지된다. 이 후보군과 능동-전이 학습을 활용해 점진적으로 심층신경망의 신뢰성 있는 예측 범위를 확장하면, 초기 훈련데이터 영역 밖에서도 적은 데이터를 생성해 효율적인 설계 과정이 가능하다.

이번 방법은 천문학적인 수의 설계 구성을 가지는 그리드 복합소재 최적화 문제에 적용해 검증했으며, 이를 통해 전체 가능한 복합재 구조의 1029분의 1 가량인 10만 개의 복합재들만 초기 훈련 데이터로 활용해 심층신경망을 학습한 후, 이후 약 500개에 미치지 못하는 데이터 검증을 통해 초기 훈련에 쓰인 복합재와 매우 다른 구조를 가지고 우수한 특성을 지닌 복합재 구조를 설계할 수 있음을 보였다.

연구진이 개발한 방법론은 국소 최적점(Local optima)에 수렴하는 문제를 완화하면서도 인공신경망의 신뢰할 수 있는 예측 영역을 점진적으로 확장하는 효율적인 방법을 제공하기 때문에, 큰 설계 공간을 다루는 다양한 분야의 최적화 문제에 적용할 수 있을 것으로 기대되며, 특히 설계에 요구되는 데이터 검증의 숫자가 적기 때문에 데이터 생성에 시간이 오래 걸리고 비용이 많이 드는 설계 문제에서 이 방법론이 크게 활용될 수 있을 것으로 기대된다.

이번 연구는 공동 제 1저자 김용태 박사과정, 김영수 박사(한국기계연구원) 주도하에 진행됐으며, 유승화 교수(우리 대학 기계공학과)가 교신저자로 참여해, 국제학술지인 `npj 컴퓨테이셔널 머터리얼(Computational Material, IF:12.241)'에 `Deep Learning Framework for Material Design Space Exploration using Active Transfer Learning and Data Augmentation' 라는 제목으로 게재됐다.

이번 연구는 한국연구재단의 중견 연구자지원사업(3D 프린팅 복합재의 최적설계기법 및 피로수명 예측기법 개발)과 미래소재 디스커버리 사업 (레이저-물질 상호작용 멀티스케일 모델링을 통한 분자디자인), KAIST 글로벌 특이점 프렙 사업의 지원을 통해 수행됐다.

2021.09.16 조회수 12897

우수한 소재를 설계하는 딥러닝 방법론 개발

우리 대학 기계공학과 유승화 교수 연구팀이 능동-전이 학습 (active-transfer learning)과 데이터 증강기법(Data augmentation)에 기반해, 심층신경망 초기 훈련에 쓰인 소재들과 형태와 조합이 매우 다른 우수한 특성을 지닌 소재를 효율적으로 탐색하고 설계하는 방법론을 개발했다고 16일 밝혔다.

인공신경망에 기반해 방대한 설계 공간에서 새로운 소재를 찾기 위한 역설계 연구는 최근 매우 활발하게 진행되고 있다. 하지만 이러한 기존 설계 방식은 목표로 하는 소재의 형태와 조합이 심층신경망 훈련에 활용된 소재들과 매우 다를 때 인공신경망이 가지는 낮은 예측능력으로 인해 극히 많은 수의 소재 데이터 검증이 요구되며, 이에 따라 제한적으로만 활용이 가능하다.

연구팀은 이번 연구에서 이를 극복하기 위해 초기 훈련 데이터 영역에서 벗어나 우수한 소재를 효율적으로 탐색할 수 있는 인공신경망 기반 전진 설계 (Forward design) 방법론을 제안했다. 이 방법론은, <그림 1>에 도시된 바와 같이 유전 알고리즘과 결합된 능동-전이 학습 및 데이터 증강기법을 통해 심층신경망을 점진적으로 업데이트함으로써, 초기 훈련데이터를 벗어난 영역에서 심층신경망의 낮은 예측능력을 적은 숫자의 데이터 검증 및 추가로 보완한다.

유전 알고리즘에 의해 제안되는 우수 소재 후보군은 기보유한 소재 데이터를 조합해 도출하기 때문에 심층신경망의 신뢰할 수 있는 예측 영역과 설계 공간 측면에서 상대적으로 가까워 예측정확도가 유지된다. 이 후보군과 능동-전이 학습을 활용해 점진적으로 심층신경망의 신뢰성 있는 예측 범위를 확장하면, 초기 훈련데이터 영역 밖에서도 적은 데이터를 생성해 효율적인 설계 과정이 가능하다.

이번 방법은 천문학적인 수의 설계 구성을 가지는 그리드 복합소재 최적화 문제에 적용해 검증했으며, 이를 통해 전체 가능한 복합재 구조의 1029분의 1 가량인 10만 개의 복합재들만 초기 훈련 데이터로 활용해 심층신경망을 학습한 후, 이후 약 500개에 미치지 못하는 데이터 검증을 통해 초기 훈련에 쓰인 복합재와 매우 다른 구조를 가지고 우수한 특성을 지닌 복합재 구조를 설계할 수 있음을 보였다.

연구진이 개발한 방법론은 국소 최적점(Local optima)에 수렴하는 문제를 완화하면서도 인공신경망의 신뢰할 수 있는 예측 영역을 점진적으로 확장하는 효율적인 방법을 제공하기 때문에, 큰 설계 공간을 다루는 다양한 분야의 최적화 문제에 적용할 수 있을 것으로 기대되며, 특히 설계에 요구되는 데이터 검증의 숫자가 적기 때문에 데이터 생성에 시간이 오래 걸리고 비용이 많이 드는 설계 문제에서 이 방법론이 크게 활용될 수 있을 것으로 기대된다.

이번 연구는 공동 제 1저자 김용태 박사과정, 김영수 박사(한국기계연구원) 주도하에 진행됐으며, 유승화 교수(우리 대학 기계공학과)가 교신저자로 참여해, 국제학술지인 `npj 컴퓨테이셔널 머터리얼(Computational Material, IF:12.241)'에 `Deep Learning Framework for Material Design Space Exploration using Active Transfer Learning and Data Augmentation' 라는 제목으로 게재됐다.

이번 연구는 한국연구재단의 중견 연구자지원사업(3D 프린팅 복합재의 최적설계기법 및 피로수명 예측기법 개발)과 미래소재 디스커버리 사업 (레이저-물질 상호작용 멀티스케일 모델링을 통한 분자디자인), KAIST 글로벌 특이점 프렙 사업의 지원을 통해 수행됐다.

2021.09.16 조회수 12897 정송 교수 연구팀, 아시아대학 최초 ACM MobiSys 2021 Best Paper Award 수상

우리 대학 AI대학원과 전기및전자공학부 소속 정송 교수 연구실의 김세연 박사과정생과 이경한 박사졸업생 (현 서울대 전기정보공학부 부교수)이 지난 주 COVID-19으로 인해 온라인으로 개최된 2021년도 ACM MobiSys 학회(https://www.sigmobile.org/mobisys/2021/)에서 Best Paper Award를 수상했다.

ACM MobiSys는 모바일시스템 분야의 최고 학회로서 올해 총 266편의 논문이 제출되어 36개의 논문이 억셉트되었으며 (논문게재율: 21.6%) 이번 정송 교수 연구팀의 Best Paper Award 수상은 19년의 MobiSys 역사상 첫 아시아권 대학의 수상이다. (제1저자 소속 대학 기준)

- 논문명: zTT: Learning-based DVFS with Zero Thermal Throttling for Mobile Devices

(모바일 기기의 열쓰로틀링 방지를 위한 강화 학습 기반의 동적 주파수 할당 기술)

- 논문 저자: 김세연 (KAIST), 빈경민 (서울대), 하상태 (U. of Colorado at Boulder), 이경한 (서울대), 정송 (KAIST)

- 논문 내용:

동적 전압/주파수 할당 기술(Dynamic Voltage and Frequency Scaling, DVFS)은 운영 체제(OS) 단에서 프로세서 성능을 보장하는 동시에 에너지 소모를 줄이기 위해 동적으로 프로세서의 전압과 주파수를 조절하는 기술이다. 하지만 모바일 기기의 동적 주파수 할당 기술은 두 가지 한계점을 가지고 있다. 첫째, OS 레벨에서 수행되기 때문에 어플리케이션의 성능을 보장하지 못한다. 둘째, 모바일 기기의 특성상 빈번하게 변하는 환경을 반영하지 못하여 과열을 일으켜 열쓰로틀링(Thermal Throttling)을 야기시켜 사용자 경험(QoE)를 크게 감소시킬 수 있다. 특히, 모바일 기기에서 발열 문제는 최신 스마트폰과 같은 고성능 기기의 성능을 크게 떨어뜨리는 고질적인 문제로 알려져 있다. 해당 연구에서는 이러한 기존 기술의 한계를 해결하기 위해 모바일 기기의 과열을 예방하고, 사용자 경험을 보장하는 동시에 에너지 소모를 최소화하기 위해 심층 강화 학습(Deep-Reinforcement Learning) 기반의 동적 주파수 할당 기술을 개발했다. 이는 실시간으로 수집되는 상태 정보를 바탕으로 어플리케이션과 모바일 기기의 동작 환경에 적응하여 안정된 성능을 보장하고, 전력 소모를 크게 줄일 수 있는 기술이다. 연구팀은 해당 연구 기술이 운영 체제나 어플리케이션이 보다 최적화된 성능으로 동작하기 위한 하나의 설정 옵션으로 패키징될 수 있을 것이라고 전망하고 있다.

위 상을 수상한 김세연 박사과정생은 논문에 대해 “5G 스마트폰과 같은 모바일 단말에서 과도한 발열로 인해 발생하는 열쓰로틀링에 따른 급격한 성능 저하 문제를 강화학습 기반의 동적 전압/주파수 스케일링을 통해 획기적으로 해결한 연구”라고 설명했다.

정송 교수는 “사용자 체감 성능을 높이면서 열쓰로틀링으로 인한 급격한 성능 저하를 방지하기 위해서는, 적정한 온도를 유지하기 위한 총전력 소모 범위 내에서 프로세서 컴포넌트 (CPU, GPU 등) 간 최적의 전력 분배를 수행하는 것이 관건이지만, 주변 환경 (주변 온도, 쿨링 상황 등)과 사용자 애플리케이션 특성에 따라 허용 가능한 총 전력 소모 범위와 최적의 전력 분배가 실시간으로 변화하기 때문에 전통적인 제어기법으로는 해결하기 매우 어려운 문제였다”고 부연 설명했다.

연구팀의 이러한 결과는 전력소모 문제로 인공지능 기법의 도입이 어려울 것으로 예상되었던 모바일 플랫폼에서 조차 강화학습 기반의 시스템 제어가 성능 개선에 크게 이바지 할 수 있음을 보임으로써, 차세대 운영체제에 AI/ML 기반 제어 기법들을 적극적으로 도입하기 위한 계기를 마련한 것으로 평가받았다.

2021.07.09 조회수 14125

정송 교수 연구팀, 아시아대학 최초 ACM MobiSys 2021 Best Paper Award 수상

우리 대학 AI대학원과 전기및전자공학부 소속 정송 교수 연구실의 김세연 박사과정생과 이경한 박사졸업생 (현 서울대 전기정보공학부 부교수)이 지난 주 COVID-19으로 인해 온라인으로 개최된 2021년도 ACM MobiSys 학회(https://www.sigmobile.org/mobisys/2021/)에서 Best Paper Award를 수상했다.

ACM MobiSys는 모바일시스템 분야의 최고 학회로서 올해 총 266편의 논문이 제출되어 36개의 논문이 억셉트되었으며 (논문게재율: 21.6%) 이번 정송 교수 연구팀의 Best Paper Award 수상은 19년의 MobiSys 역사상 첫 아시아권 대학의 수상이다. (제1저자 소속 대학 기준)

- 논문명: zTT: Learning-based DVFS with Zero Thermal Throttling for Mobile Devices

(모바일 기기의 열쓰로틀링 방지를 위한 강화 학습 기반의 동적 주파수 할당 기술)

- 논문 저자: 김세연 (KAIST), 빈경민 (서울대), 하상태 (U. of Colorado at Boulder), 이경한 (서울대), 정송 (KAIST)

- 논문 내용:

동적 전압/주파수 할당 기술(Dynamic Voltage and Frequency Scaling, DVFS)은 운영 체제(OS) 단에서 프로세서 성능을 보장하는 동시에 에너지 소모를 줄이기 위해 동적으로 프로세서의 전압과 주파수를 조절하는 기술이다. 하지만 모바일 기기의 동적 주파수 할당 기술은 두 가지 한계점을 가지고 있다. 첫째, OS 레벨에서 수행되기 때문에 어플리케이션의 성능을 보장하지 못한다. 둘째, 모바일 기기의 특성상 빈번하게 변하는 환경을 반영하지 못하여 과열을 일으켜 열쓰로틀링(Thermal Throttling)을 야기시켜 사용자 경험(QoE)를 크게 감소시킬 수 있다. 특히, 모바일 기기에서 발열 문제는 최신 스마트폰과 같은 고성능 기기의 성능을 크게 떨어뜨리는 고질적인 문제로 알려져 있다. 해당 연구에서는 이러한 기존 기술의 한계를 해결하기 위해 모바일 기기의 과열을 예방하고, 사용자 경험을 보장하는 동시에 에너지 소모를 최소화하기 위해 심층 강화 학습(Deep-Reinforcement Learning) 기반의 동적 주파수 할당 기술을 개발했다. 이는 실시간으로 수집되는 상태 정보를 바탕으로 어플리케이션과 모바일 기기의 동작 환경에 적응하여 안정된 성능을 보장하고, 전력 소모를 크게 줄일 수 있는 기술이다. 연구팀은 해당 연구 기술이 운영 체제나 어플리케이션이 보다 최적화된 성능으로 동작하기 위한 하나의 설정 옵션으로 패키징될 수 있을 것이라고 전망하고 있다.

위 상을 수상한 김세연 박사과정생은 논문에 대해 “5G 스마트폰과 같은 모바일 단말에서 과도한 발열로 인해 발생하는 열쓰로틀링에 따른 급격한 성능 저하 문제를 강화학습 기반의 동적 전압/주파수 스케일링을 통해 획기적으로 해결한 연구”라고 설명했다.

정송 교수는 “사용자 체감 성능을 높이면서 열쓰로틀링으로 인한 급격한 성능 저하를 방지하기 위해서는, 적정한 온도를 유지하기 위한 총전력 소모 범위 내에서 프로세서 컴포넌트 (CPU, GPU 등) 간 최적의 전력 분배를 수행하는 것이 관건이지만, 주변 환경 (주변 온도, 쿨링 상황 등)과 사용자 애플리케이션 특성에 따라 허용 가능한 총 전력 소모 범위와 최적의 전력 분배가 실시간으로 변화하기 때문에 전통적인 제어기법으로는 해결하기 매우 어려운 문제였다”고 부연 설명했다.

연구팀의 이러한 결과는 전력소모 문제로 인공지능 기법의 도입이 어려울 것으로 예상되었던 모바일 플랫폼에서 조차 강화학습 기반의 시스템 제어가 성능 개선에 크게 이바지 할 수 있음을 보임으로써, 차세대 운영체제에 AI/ML 기반 제어 기법들을 적극적으로 도입하기 위한 계기를 마련한 것으로 평가받았다.

2021.07.09 조회수 14125 딥러닝 통해 수소 발생 메커니즘 규명

우리 대학 생명화학공학과 정유성 교수 연구팀이 심층 학습(딥러닝)을 통해 고활성 백금 와이어의 수소 발생 메커니즘을 규명하는 데 성공했다고 29일 밝혔다.

백금은 전기차 등에 사용되는 연료 전지에 쓰이거나, 물의 전기 분해를 통해 수소를 얻는 데 사용되는 중요한 촉매이지만 가격이 비싸 기술 보급에 걸림돌이 되고 있다. 이를 해결하는 방법의 하나로 최근 백금을 톱니 와이어 모양으로 합성해 백금의 양을 10배 정도 절약하는 연구들이 발표돼 큰 파장을 불러일으켰지만, 아직 그 메커니즘이 규명되지 않았다.

정유성 교수 연구팀은 복잡한 촉매 표면의 성질을 빠르게 예측하는 딥러닝 방법들을 고안했는데, 이번에 이를 톱니 백금 와이어에 적용해 해당 촉매의 높은 수소 활성 메커니즘을 규명할 수 있었다.

연구팀이 규명한 톱니 백금 와이어에서의 수소 발생 메커니즘은 기존에 알려진 촉매 직관을 깨는 새로운 메커니즘인 것으로 밝혀졌다. 수소 발생은 물에서 양성자를 받아 수소를 흡착시키는 흡착반응과 흡착된 수소 원자들이 결합해 수소 분자가 형성되는 짝지음 반응의 2단계를 거쳐 일어나는데, 이 두 반응은 일반적으로 같은 반응 자리(reaction site)에서 일어난다.

하지만, 이번에 새롭게 발견된 메커니즘에 의하면, 톱니 백금 표면에서는 울퉁불퉁한 구조로 인해 흡착반응이 잘 일으키는 반응 자리와 짝지음 반응을 잘 일으키는 반응 자리가 따로 존재하고, 이 두 자리의 상승 작용으로 인해 촉매 활성이 400% 이상 증가한다. 마치 분업화를 통해 일의 효율을 높이는 것과 같은 개념이 분자 세계에서도 존재하는 것이다.

정유성 교수는 "분자 수준에서 분업을 통해 전체 반응 효율을 높이는 개념들이 기존에도 있긴 했지만, 단일성분인 백금에서 구조에 따른 분업 현상이 규명된 것은 이번이 처음ˮ이라면서, "단일성분 촉매의 구조를 변화시킴으로써 촉매의 효율을 높일 수 있는 새로운 관점과 설계원리를 제시했다는 점에서 의미가 있다ˮ고 했다.

우리 대학 구근호 박사후연구원이 제1 저자로 참여하고, 톱니 백금 와이어를 합성한 캘리포니아대학교 로스엔젤리스(UCLA)의 듀안 교수 연구팀과 캘리포니아 공과대학교(Caltech)의 고다드 교수 연구팀이 함께 참여한 이번 연구성과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 3월 17일 字에 실렸다. (논문명: Autobifunctional Mechanism of Jagged Pt Nanowires for Hydrogen Evolution Kinetics via End-to-End Simulation)

이번 연구는 과학기술정보통신부 산하 한국연구재단의 중견연구자 기초연구사업과 PEMWE용 저가의 고성능 수소 발생반응 촉매 개발 사업의 지원을 받아 수행됐고, KISTI의 슈퍼컴퓨터 자원이 활용됐다.

2021.04.29 조회수 29676

딥러닝 통해 수소 발생 메커니즘 규명

우리 대학 생명화학공학과 정유성 교수 연구팀이 심층 학습(딥러닝)을 통해 고활성 백금 와이어의 수소 발생 메커니즘을 규명하는 데 성공했다고 29일 밝혔다.

백금은 전기차 등에 사용되는 연료 전지에 쓰이거나, 물의 전기 분해를 통해 수소를 얻는 데 사용되는 중요한 촉매이지만 가격이 비싸 기술 보급에 걸림돌이 되고 있다. 이를 해결하는 방법의 하나로 최근 백금을 톱니 와이어 모양으로 합성해 백금의 양을 10배 정도 절약하는 연구들이 발표돼 큰 파장을 불러일으켰지만, 아직 그 메커니즘이 규명되지 않았다.

정유성 교수 연구팀은 복잡한 촉매 표면의 성질을 빠르게 예측하는 딥러닝 방법들을 고안했는데, 이번에 이를 톱니 백금 와이어에 적용해 해당 촉매의 높은 수소 활성 메커니즘을 규명할 수 있었다.

연구팀이 규명한 톱니 백금 와이어에서의 수소 발생 메커니즘은 기존에 알려진 촉매 직관을 깨는 새로운 메커니즘인 것으로 밝혀졌다. 수소 발생은 물에서 양성자를 받아 수소를 흡착시키는 흡착반응과 흡착된 수소 원자들이 결합해 수소 분자가 형성되는 짝지음 반응의 2단계를 거쳐 일어나는데, 이 두 반응은 일반적으로 같은 반응 자리(reaction site)에서 일어난다.

하지만, 이번에 새롭게 발견된 메커니즘에 의하면, 톱니 백금 표면에서는 울퉁불퉁한 구조로 인해 흡착반응이 잘 일으키는 반응 자리와 짝지음 반응을 잘 일으키는 반응 자리가 따로 존재하고, 이 두 자리의 상승 작용으로 인해 촉매 활성이 400% 이상 증가한다. 마치 분업화를 통해 일의 효율을 높이는 것과 같은 개념이 분자 세계에서도 존재하는 것이다.

정유성 교수는 "분자 수준에서 분업을 통해 전체 반응 효율을 높이는 개념들이 기존에도 있긴 했지만, 단일성분인 백금에서 구조에 따른 분업 현상이 규명된 것은 이번이 처음ˮ이라면서, "단일성분 촉매의 구조를 변화시킴으로써 촉매의 효율을 높일 수 있는 새로운 관점과 설계원리를 제시했다는 점에서 의미가 있다ˮ고 했다.

우리 대학 구근호 박사후연구원이 제1 저자로 참여하고, 톱니 백금 와이어를 합성한 캘리포니아대학교 로스엔젤리스(UCLA)의 듀안 교수 연구팀과 캘리포니아 공과대학교(Caltech)의 고다드 교수 연구팀이 함께 참여한 이번 연구성과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 3월 17일 字에 실렸다. (논문명: Autobifunctional Mechanism of Jagged Pt Nanowires for Hydrogen Evolution Kinetics via End-to-End Simulation)

이번 연구는 과학기술정보통신부 산하 한국연구재단의 중견연구자 기초연구사업과 PEMWE용 저가의 고성능 수소 발생반응 촉매 개발 사업의 지원을 받아 수행됐고, KISTI의 슈퍼컴퓨터 자원이 활용됐다.

2021.04.29 조회수 29676 이수현 교수팀, 뇌 복부선조영역의 새로운 기억관련 기능 규명

우리 대학 바이오및뇌공학과 이수현 교수 연구팀과 서울대학교 생명과학부 김형 교수 연구팀이 공동연구를 통해 복부선조영역(ventral striatum)에서 습관행동을 제어하는데 필요한 장기기억이 자동적으로 인출된다는 사실을 밝혔다. 이러한 복부선조영역의 기능을 그 영역과 회로별로 규명하는 것은 인간에게 직접 적용할 수 있는 뇌질환 치료방법 개발과 뇌영역 맞춤형 치료의 이론적 기반이 될 수 있다.

뇌의 복부선조영역은 새로운 가치학습에 중요하며, 중독행동과 조현병 관련 행동에도 연관된 것으로 알려져 왔지만 이러한 행동에 기반이 될 수 있는 기억정보를 처리하고 있는지에 대해서는 불분명했다.

이에 연구팀은 기능적 자기공명뇌영상과 전기생리학적 뇌세포 활성측정법을 모두 이용해 과거에 학습한 물체를 의식적으로 인지하고 있지 않는 상황에서도 복부선조에서 과거에 배운 좋은 물체에 대한 장기기억정보가 활발하게 처리되고 있다는 사실을 밝혀냈다.

또한 자동적으로 인출된 좋은 물체에 대한 기억은 무의식적이며 자동적인 행동, 즉 습관행동을 제어하고, 이를 통해 동물이 장기기억을 기반으로 최대이익을 얻을 수 있는 자동적 의사결정(automatic decision-making) 과정에 사용된다는 실험적 증거를 제시했다.

바이오및뇌공학과 뇌인지공학프로그램 강준영 석박사통합과정 학생이 제1 저자로 참여한 이번 연구는 국제학술지 네이쳐 커뮤니케이션즈(Nature Communications)에 4월 8일(목) 게재됐다.

복부선조영역에서 기억의 자동적 인출과정을 이해함으로써 자동적 행동인 습관과 중독행동 제어의 이론적 기반을 다지고, 나아가 기억의 자동인출(automatic retrieval)과 연관된 현저성(salience) 이상으로 조현병을 이해할 수 있는 이론적 발판을 마련한 것에 이번 연구의 의의가 있다고 볼 수 있다.

이번 연구는 한국연구재단 뇌질환극복사업 및 개인기초연구지원사업 등의 지원을 받아 수행됐다.

2021.04.09 조회수 73546

이수현 교수팀, 뇌 복부선조영역의 새로운 기억관련 기능 규명

우리 대학 바이오및뇌공학과 이수현 교수 연구팀과 서울대학교 생명과학부 김형 교수 연구팀이 공동연구를 통해 복부선조영역(ventral striatum)에서 습관행동을 제어하는데 필요한 장기기억이 자동적으로 인출된다는 사실을 밝혔다. 이러한 복부선조영역의 기능을 그 영역과 회로별로 규명하는 것은 인간에게 직접 적용할 수 있는 뇌질환 치료방법 개발과 뇌영역 맞춤형 치료의 이론적 기반이 될 수 있다.

뇌의 복부선조영역은 새로운 가치학습에 중요하며, 중독행동과 조현병 관련 행동에도 연관된 것으로 알려져 왔지만 이러한 행동에 기반이 될 수 있는 기억정보를 처리하고 있는지에 대해서는 불분명했다.

이에 연구팀은 기능적 자기공명뇌영상과 전기생리학적 뇌세포 활성측정법을 모두 이용해 과거에 학습한 물체를 의식적으로 인지하고 있지 않는 상황에서도 복부선조에서 과거에 배운 좋은 물체에 대한 장기기억정보가 활발하게 처리되고 있다는 사실을 밝혀냈다.

또한 자동적으로 인출된 좋은 물체에 대한 기억은 무의식적이며 자동적인 행동, 즉 습관행동을 제어하고, 이를 통해 동물이 장기기억을 기반으로 최대이익을 얻을 수 있는 자동적 의사결정(automatic decision-making) 과정에 사용된다는 실험적 증거를 제시했다.

바이오및뇌공학과 뇌인지공학프로그램 강준영 석박사통합과정 학생이 제1 저자로 참여한 이번 연구는 국제학술지 네이쳐 커뮤니케이션즈(Nature Communications)에 4월 8일(목) 게재됐다.

복부선조영역에서 기억의 자동적 인출과정을 이해함으로써 자동적 행동인 습관과 중독행동 제어의 이론적 기반을 다지고, 나아가 기억의 자동인출(automatic retrieval)과 연관된 현저성(salience) 이상으로 조현병을 이해할 수 있는 이론적 발판을 마련한 것에 이번 연구의 의의가 있다고 볼 수 있다.

이번 연구는 한국연구재단 뇌질환극복사업 및 개인기초연구지원사업 등의 지원을 받아 수행됐다.

2021.04.09 조회수 73546 인공지능으로 3차원 고해상도 나노입자 영상화 기술 개발

우리 대학 바이오및뇌공학과 예종철 교수 연구팀이 삼성전자 종합기술원과 공동연구를 통해 나노입자의 3차원 형상과 조성 분포의 복원 성능을 획기적으로 향상한 인공지능 기술을 개발했다고 16일 밝혔다. 공동연구팀은 에너지 분산형 X선 분광법(EDX)을 주사 투과전자현미경(STEM)과 결합한 시스템을 활용했다.

이번 연구를 통해 나노입자를 형성하고 있는 물질의 형상과 조성 분포를 정확하게 재구성함으로써, 실제 상용 디스플레이를 구성하는 양자점(퀀텀닷)과 같은 반도체 입자의 정확한 분석에 도움을 줄 것으로 기대된다.

예종철 교수 연구팀의 한요섭 박사, 차은주 박사과정, 정형진 석사과정과 삼성종합기술원의 이은하 전문연구원팀의 장재덕, 이준호 전문연구원이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)' 2월 8일 字 온라인판에 게재됐다. (논문명 : Deep learning STEM-EDX tomography of nanocrystals)

에너지 분산형 X선 분광법(이하 EDX)은 나노입자의 성분 분석에 주로 이용되며, X선과 반응한 물체의 성분에 따라 고유한 방출 스펙트럼을 보인다는 점에서 화학적인 분석이 가능하다. 퀀텀닷 및 배터리 등 다양한 나노 소재의 열화 메커니즘과 결함을 해석하기 위해 형상 및 조성 분포 분석이 가능한 이 분광법의 필요성과 중요도가 급증하고 있다.

그러나 EDX 측정 신호의 해상도를 향상하기 위해, 나노 소재를 오랜 시간 전자빔에 노출하면 소재의 영구적인 피해가 발생한다. 이로 인해 나노입자의 3차원 영상화를 위한 투사(projection) 데이터 획득 시간이 제한되며, 한 각도에서의 스캔 시간을 단축하거나 측정하는 각도를 줄이는 방식이 사용된다. 기존의 방식으로 획득된 투사 데이터를 이용해 3차원 영상을 복원할 시, 미량 존재하는 원자 신호의 측정이 불가능하거나 복원 영상의 정밀도와 해상도가 매우 낮다.

그러나 공동 연구팀이 자체 개발한 인공지능 기반의 커널 회귀(kernel regression)와 투사 데이터 향상(projection enhancement)은 정밀도와 해상도를 획기적으로 발전시켰다. 연구팀은 측정된 데이터의 분포를 네트워크가 스스로 학습하는 인공지능 기반의 커널 회귀를 통해 스캔 시간이 단축된 투사 데이터의 신호 대 잡음비(SNR)를 높인 데이터를 제공하는 네트워크를 개발했다. 그리고 개선된 고화질의 EDX 투사 데이터를 기반으로 기존의 방법으로는 불가능했던 적은 수의 투사 데이터로부터 더욱 정확한 3차원 복원 영상을 제공하는 데 성공했다.

연구팀이 개발한 알고리즘은 기존의 EDX 측정 신호 기반 3차원 재구성 기법과 비교해 나노입자를 형성하고 있는 원자의 형상과 경계를 뚜렷하게 구별했으며, 복원된 다양한 코어-쉘(core-shell) 구조의 퀀텀닷 3차원 영상이 샘플의 광학적 특성과 높은 상관관계를 나타내는 것이 확인됐다.

예종철 교수는 "연구에서 개발한 인공지능 기술을 통해 상용 디스플레이의 핵심 기반이 되는 퀀텀닷 및 반도체 소자의 양자 효율과 화학적 안정성을 더욱 정밀하게 분석할 수 있다ˮ고 말했다.

2021.02.16 조회수 86239

인공지능으로 3차원 고해상도 나노입자 영상화 기술 개발

우리 대학 바이오및뇌공학과 예종철 교수 연구팀이 삼성전자 종합기술원과 공동연구를 통해 나노입자의 3차원 형상과 조성 분포의 복원 성능을 획기적으로 향상한 인공지능 기술을 개발했다고 16일 밝혔다. 공동연구팀은 에너지 분산형 X선 분광법(EDX)을 주사 투과전자현미경(STEM)과 결합한 시스템을 활용했다.

이번 연구를 통해 나노입자를 형성하고 있는 물질의 형상과 조성 분포를 정확하게 재구성함으로써, 실제 상용 디스플레이를 구성하는 양자점(퀀텀닷)과 같은 반도체 입자의 정확한 분석에 도움을 줄 것으로 기대된다.

예종철 교수 연구팀의 한요섭 박사, 차은주 박사과정, 정형진 석사과정과 삼성종합기술원의 이은하 전문연구원팀의 장재덕, 이준호 전문연구원이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)' 2월 8일 字 온라인판에 게재됐다. (논문명 : Deep learning STEM-EDX tomography of nanocrystals)

에너지 분산형 X선 분광법(이하 EDX)은 나노입자의 성분 분석에 주로 이용되며, X선과 반응한 물체의 성분에 따라 고유한 방출 스펙트럼을 보인다는 점에서 화학적인 분석이 가능하다. 퀀텀닷 및 배터리 등 다양한 나노 소재의 열화 메커니즘과 결함을 해석하기 위해 형상 및 조성 분포 분석이 가능한 이 분광법의 필요성과 중요도가 급증하고 있다.

그러나 EDX 측정 신호의 해상도를 향상하기 위해, 나노 소재를 오랜 시간 전자빔에 노출하면 소재의 영구적인 피해가 발생한다. 이로 인해 나노입자의 3차원 영상화를 위한 투사(projection) 데이터 획득 시간이 제한되며, 한 각도에서의 스캔 시간을 단축하거나 측정하는 각도를 줄이는 방식이 사용된다. 기존의 방식으로 획득된 투사 데이터를 이용해 3차원 영상을 복원할 시, 미량 존재하는 원자 신호의 측정이 불가능하거나 복원 영상의 정밀도와 해상도가 매우 낮다.

그러나 공동 연구팀이 자체 개발한 인공지능 기반의 커널 회귀(kernel regression)와 투사 데이터 향상(projection enhancement)은 정밀도와 해상도를 획기적으로 발전시켰다. 연구팀은 측정된 데이터의 분포를 네트워크가 스스로 학습하는 인공지능 기반의 커널 회귀를 통해 스캔 시간이 단축된 투사 데이터의 신호 대 잡음비(SNR)를 높인 데이터를 제공하는 네트워크를 개발했다. 그리고 개선된 고화질의 EDX 투사 데이터를 기반으로 기존의 방법으로는 불가능했던 적은 수의 투사 데이터로부터 더욱 정확한 3차원 복원 영상을 제공하는 데 성공했다.

연구팀이 개발한 알고리즘은 기존의 EDX 측정 신호 기반 3차원 재구성 기법과 비교해 나노입자를 형성하고 있는 원자의 형상과 경계를 뚜렷하게 구별했으며, 복원된 다양한 코어-쉘(core-shell) 구조의 퀀텀닷 3차원 영상이 샘플의 광학적 특성과 높은 상관관계를 나타내는 것이 확인됐다.

예종철 교수는 "연구에서 개발한 인공지능 기술을 통해 상용 디스플레이의 핵심 기반이 되는 퀀텀닷 및 반도체 소자의 양자 효율과 화학적 안정성을 더욱 정밀하게 분석할 수 있다ˮ고 말했다.

2021.02.16 조회수 86239 딥러닝으로 소재 합성 가능성 예측 기술 개발

우리 대학 생명화학공학과 정유성 교수 연구팀이 딥러닝을 활용해 소재의 합성 가능성을 높은 정확도로 예측하는 기술을 개발했다고 22일 밝혔다.

신소재 설계의 궁극적인 목표는 소재를 설계하고 그것을 실험적으로 합성하는 것이지만 현실적으로는 새롭게 설계된 대부분의 소재가 실제 합성 단계에서 성공하지 못하고 버려지는 경우가 많다. 이는 불필요한 시간과 자원의 낭비를 초래한다. 소재의 합성 여부는 반응 조건, 열역학, 반응 속도, 소재 구조 등 다양한 요인에 의해서 결정되기 때문에, 소재의 합성 가능성을 예측하는 것은 매우 도전적인 과제로 여겨져 왔다.

이런 문제 해결을 위한 방안으로 간단한 열역학적 안정성만을 고려해 고체 소재의 합성 가능성을 추정하지만 정확도는 매우 떨어지는 편이다. 일례로 에너지적으로 안정된 물질이라 하더라도 합성이 안 되는 경우가 아주 빈번하고, 또 반대로 *준안정 상태의 물질들도 합성되는 경우가 많기 때문이다. 따라서, 합성 가능성에 대한 예측 정확도를 획기적으로 높일 수 있는 방법론의 개발이 시급한 과제로 여겨져 왔다.

☞ 준안정(metastable) 상태 : 어떤 물질이 열역학적으로 안정된 ‘바닥 상태’가 아닌 상태

정유성 교수 연구팀이 개발한 소재 합성 가능성 예측기술은, 기존 합성이 보고된 고체 소재들의 구조적 유사성을 그래프 합성 곱 신경망(GCN, Graph Convolutional Neural Network)으로 학습해 새로운 소재의 합성 가능성을 예측할 수 있다. 특히, 현재까지 합성이 안 된 물질이라 하더라도 합성이 성공할 가능성은 여전히 존재하기 때문에 참값(레이블)을 이미 알고 학습을 진행하는 일반적인 지도학습과는 달리 양의 레이블(+)을 가진 데이터와 레이블이 없는 데이터(Positive-Unlabeled, P-U)를 이용한 분류 모델 기반의 준 지도학습을 사용했다.

정 교수팀은 5만여 종에 달하는 이미 합성이 보고된 물질과 8만여 종의 *가상 물질로 이뤄진 `머터리얼스 프로젝트(Materials Project, MP)'라는 소재 관련 데이터베이스를 이용해 모델을 구축했다. 연구팀 관계자는 이 신기술을 활용한 결과, 소재들의 합성 가능성을 약 87% 정확하게 예측할 수 있다고 설명했다. 정 교수팀은 또 이미 합성된 소재들의 열역학적 특성을 분석한 결과, 열역학적 안정성만으로는 실제 소재의 합성 가능성을 예측할 수 없다는 사실도 알아냈다.

☞ 가상 물질(hypothetical materials) : 기존에 합성되어 보고된 물질들을 원소 치환해서 얻어지는 가상의 물질들로 아직 실험적으로 합성 보고가 이루어지지 않은 물질

이와 함께 머터리얼스 프로젝트(MP) 데이터베이스 내에 합성 가능성 점수가 가장 높은 100개의 가상 물질에 대해 문헌조사를 실시한 결과, 이들 중 머터리얼스 프로젝트(MP) 데이터베이스에는 합성 여부가 아직 알려지지 않았지만 실제로 합성돼 논문에 보고된 소재만도 71개에 달하는 것을 확인했고 이를 통해 모델의 높은 정확도를 추가로 입증했다.

정유성 교수는 "빠른 신소재 발견을 위해 다양한 소재 설계 프레임워크가 존재하지만 정작 설계된 소재의 합성 가능성에 관한 판단은 전문가 직관의 영역으로 남아 있다ˮ면서 "이번에 개발한 합성 가능성 예측 모델은 새로운 소재를 설계할 때 실제로 합성 가능성을 실험 전에 미리 판단할 수 있어 새로운 소재의 개발시간을 단축하는 데 큰 도움이 될 것ˮ이라고 말했다.

생명화학공학과 장지돈 박사과정과 구근호 박사후연구원이 공동 제1 저자로 참여한 이번 연구결과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 10월 26일 자에 실렸다. (논문명: Structure-Based Synthesizability Prediction of Crystals Using Partially Supervised Learing)

한편 이번 연구는 과학기술정보통신부 산하 한국연구재단의 기초연구사업(중견연구)과 미래소재 디스커버리 사업 지원을 받아 수행됐고, 연구에 KISTI의 슈퍼컴퓨터를 활용했다.

2020.12.22 조회수 54542

딥러닝으로 소재 합성 가능성 예측 기술 개발

우리 대학 생명화학공학과 정유성 교수 연구팀이 딥러닝을 활용해 소재의 합성 가능성을 높은 정확도로 예측하는 기술을 개발했다고 22일 밝혔다.

신소재 설계의 궁극적인 목표는 소재를 설계하고 그것을 실험적으로 합성하는 것이지만 현실적으로는 새롭게 설계된 대부분의 소재가 실제 합성 단계에서 성공하지 못하고 버려지는 경우가 많다. 이는 불필요한 시간과 자원의 낭비를 초래한다. 소재의 합성 여부는 반응 조건, 열역학, 반응 속도, 소재 구조 등 다양한 요인에 의해서 결정되기 때문에, 소재의 합성 가능성을 예측하는 것은 매우 도전적인 과제로 여겨져 왔다.

이런 문제 해결을 위한 방안으로 간단한 열역학적 안정성만을 고려해 고체 소재의 합성 가능성을 추정하지만 정확도는 매우 떨어지는 편이다. 일례로 에너지적으로 안정된 물질이라 하더라도 합성이 안 되는 경우가 아주 빈번하고, 또 반대로 *준안정 상태의 물질들도 합성되는 경우가 많기 때문이다. 따라서, 합성 가능성에 대한 예측 정확도를 획기적으로 높일 수 있는 방법론의 개발이 시급한 과제로 여겨져 왔다.

☞ 준안정(metastable) 상태 : 어떤 물질이 열역학적으로 안정된 ‘바닥 상태’가 아닌 상태

정유성 교수 연구팀이 개발한 소재 합성 가능성 예측기술은, 기존 합성이 보고된 고체 소재들의 구조적 유사성을 그래프 합성 곱 신경망(GCN, Graph Convolutional Neural Network)으로 학습해 새로운 소재의 합성 가능성을 예측할 수 있다. 특히, 현재까지 합성이 안 된 물질이라 하더라도 합성이 성공할 가능성은 여전히 존재하기 때문에 참값(레이블)을 이미 알고 학습을 진행하는 일반적인 지도학습과는 달리 양의 레이블(+)을 가진 데이터와 레이블이 없는 데이터(Positive-Unlabeled, P-U)를 이용한 분류 모델 기반의 준 지도학습을 사용했다.

정 교수팀은 5만여 종에 달하는 이미 합성이 보고된 물질과 8만여 종의 *가상 물질로 이뤄진 `머터리얼스 프로젝트(Materials Project, MP)'라는 소재 관련 데이터베이스를 이용해 모델을 구축했다. 연구팀 관계자는 이 신기술을 활용한 결과, 소재들의 합성 가능성을 약 87% 정확하게 예측할 수 있다고 설명했다. 정 교수팀은 또 이미 합성된 소재들의 열역학적 특성을 분석한 결과, 열역학적 안정성만으로는 실제 소재의 합성 가능성을 예측할 수 없다는 사실도 알아냈다.

☞ 가상 물질(hypothetical materials) : 기존에 합성되어 보고된 물질들을 원소 치환해서 얻어지는 가상의 물질들로 아직 실험적으로 합성 보고가 이루어지지 않은 물질

이와 함께 머터리얼스 프로젝트(MP) 데이터베이스 내에 합성 가능성 점수가 가장 높은 100개의 가상 물질에 대해 문헌조사를 실시한 결과, 이들 중 머터리얼스 프로젝트(MP) 데이터베이스에는 합성 여부가 아직 알려지지 않았지만 실제로 합성돼 논문에 보고된 소재만도 71개에 달하는 것을 확인했고 이를 통해 모델의 높은 정확도를 추가로 입증했다.

정유성 교수는 "빠른 신소재 발견을 위해 다양한 소재 설계 프레임워크가 존재하지만 정작 설계된 소재의 합성 가능성에 관한 판단은 전문가 직관의 영역으로 남아 있다ˮ면서 "이번에 개발한 합성 가능성 예측 모델은 새로운 소재를 설계할 때 실제로 합성 가능성을 실험 전에 미리 판단할 수 있어 새로운 소재의 개발시간을 단축하는 데 큰 도움이 될 것ˮ이라고 말했다.

생명화학공학과 장지돈 박사과정과 구근호 박사후연구원이 공동 제1 저자로 참여한 이번 연구결과는 미국화학회가 발행하는 국제학술지 미국화학회지(Journal of the American Chemical Society) 온라인 10월 26일 자에 실렸다. (논문명: Structure-Based Synthesizability Prediction of Crystals Using Partially Supervised Learing)

한편 이번 연구는 과학기술정보통신부 산하 한국연구재단의 기초연구사업(중견연구)과 미래소재 디스커버리 사업 지원을 받아 수행됐고, 연구에 KISTI의 슈퍼컴퓨터를 활용했다.

2020.12.22 조회수 54542 딥러닝 기반 실시간 기침 인식 카메라 개발

우리 대학 기계공학과 박용화 교수 연구팀이 ㈜에스엠 인스트루먼트와 공동으로 실시간으로 기침 소리를 인식하고 기침하는 사람의 위치를 이미지로 표시해주는 '기침 인식 카메라'를 개발했다고 3일 밝혔다.

작년 말부터 시작된 세계적 유행성 전염병인 코로나19가 최근 미국·중국·유럽 등 세계 각국에서 재확산되는 추세로 접어들면서 비접촉방식으로 전염병을 감지하는 기술에 대한 수요가 증가하고 있다.

코로나19의 대표적인 증상이 발열과 기침인데, 현재 발열은 열화상 카메라를 이용해 직접 접촉을 하지 않고도 체온을 쉽게 판별할 수 있다. 문제는 비접촉방식으로는 기침하는 사람의 증상을 쉽사리 파악하기 어렵다는 점이다. 박 교수 연구팀은 이런 문제를 해결하기 위해 기침 소리를 실시간으로 인식하는 딥러닝 기반의 기침 인식 모델을 개발했다. 또한 열화상 카메라와 같은 원리로 기침 소리와 기침하는 사람의 시각화를 위해 기침 인식 모델을 음향 카메라에 적용, 기침 소리와 기침하는 사람의 위치, 심지어 기침 횟수까지를 실시간으로 추적하고 기록이 가능한 '기침 인식 카메라'를 개발했다.

연구팀은 기침 인식 카메라가 사람이 밀집한 공공장소에서 전염병의 유행을 감지하거나 병원에서 환자의 상태를 상시 모니터링 가능한 의료용 장비로 활용될 것으로 기대하고 있다.

연구팀은 기침 인식 모델 개발을 위해 *합성 곱 신경망(convolutional neural network, CNN)을 기반으로 *지도학습(supervised learning)을 적용했다. 1초 길이 음향신호의 특징(feature)을 입력 신호로 받아, 1(기침) 또는 0(그 외)의 2진 신호를 출력하고 학습률의 최적화를 위해 일정 기간 학습률이 정체되면 학습률 값을 낮추도록 설정했다.

이어서 기침 인식 모델의 훈련 및 평가를 위해 구글과 유튜브 등에서 연구용으로 활발히 사용 중인 공개 음성데이터 세트인 `오디오세트(Audioset)'를 비롯해 `디맨드(DEMAND)'와 `이티에스아이(ETSI)', `티미트(TIMIT)' 등에서 데이터 세트를 수집했다. 이 중 `오디오세트'는 훈련 및 평가 데이터 세트 구성을 위해 사용했고 다른 데이터 세트의 경우 기침 인식 모델이 다양한 배경 소음을 학습할 수 있도록 데이터 증강(data augmentation)을 위한 배경 소음으로 사용했다.

☞ 합성 곱 신경망(convolutional neural network): 시각적 이미지를 분석하는 데 사용되는 인공신경망(생물학의 신경망에서 영감을 얻은 통계학적 학습 알고리즘)의 한 종류

☞ 지도학습(Supervised Learning): 훈련 데이터(Training Data)로부터 하나의 함수를 유추해내기 위한 기계 학습(Machine Learning)의 한 방법

데이터 증강을 위해 배경 소음을 15%~75%의 비율로 `오디오세트'에 섞은 후, 다양한 거리에 적응할 수 있게 음량을 0.25~1.0배로 조정했다. 훈련 및 평가 데이터 세트는 증강된 데이터 세트를 9:1 비율로 나눠 구성했으며, 시험 데이터 세트는 따로 사무실에서 녹음한 것을 사용했다.

모델 최적화를 위해서는 '스펙트로그램(spectrogram)' 등 5개의 음향 특징과 7개의 최적화 기기(optimizer)를 사용해 학습을 진행하고 시험 데이터 세트의 정확도를 측정, 성능을 확인한 결과 87.4%의 시험 정확도를 얻을 수 있었다.

연구팀은 이어 학습된 기침 인식 모델을 소리를 수집하는 마이크로폰 어레이와 카메라 모듈로 구성되는 음향 카메라에 적용했다. 그 결과 수집된 데이터는 음원의 위치를 계산하는 빔 형성 과정을 거쳐 기침 인식 모델이 기침 소리로 인식할 경우 기침 소리가 난 위치에 기침 소리임을 나타내는 등고선과 라벨이 각각 표시된다.

박 교수팀은 마지막 단계로 기침 인식 카메라의 예비 테스트를 진행한 결과, 여러 잡음 환경에서도 기침 소리와 그 이외의 소리로 구분이 가능하며 기침하는 사람과 그 사람의 위치, 횟수 등을 실시간으로 추적해 현장에서의 적용 가능성을 확인했다. 이들은 추후 병원 등 실사용 환경에서 추가 학습이 이뤄진다면 정확도는 87.4%보다 더 높아질 것으로 기대하고 있다.

박용화 교수는 "코로나19가 지속적으로 전파되고 있는 상황에서 공공장소와 다수 밀집 시설에 기침 인식 카메라를 활용하면 전염병의 방역 및 조기 감지에 큰 도움이 될 것ˮ이라고 말했다. 박 교수는 이어 "특히 병실에 적용하면 환자의 상태를 24시간 기록해 치료에 활용할 수 있기 때문에 의료진의 수고를 줄이고 환자 상태를 더 정밀하게 파악할 수 있을 것ˮ 이라고 강조했다.

한편, 이번 연구는 에너지기술평가원(산업통상자원부)의 지원을 받아 수행됐다.

2020.08.03 조회수 32000

딥러닝 기반 실시간 기침 인식 카메라 개발

우리 대학 기계공학과 박용화 교수 연구팀이 ㈜에스엠 인스트루먼트와 공동으로 실시간으로 기침 소리를 인식하고 기침하는 사람의 위치를 이미지로 표시해주는 '기침 인식 카메라'를 개발했다고 3일 밝혔다.

작년 말부터 시작된 세계적 유행성 전염병인 코로나19가 최근 미국·중국·유럽 등 세계 각국에서 재확산되는 추세로 접어들면서 비접촉방식으로 전염병을 감지하는 기술에 대한 수요가 증가하고 있다.

코로나19의 대표적인 증상이 발열과 기침인데, 현재 발열은 열화상 카메라를 이용해 직접 접촉을 하지 않고도 체온을 쉽게 판별할 수 있다. 문제는 비접촉방식으로는 기침하는 사람의 증상을 쉽사리 파악하기 어렵다는 점이다. 박 교수 연구팀은 이런 문제를 해결하기 위해 기침 소리를 실시간으로 인식하는 딥러닝 기반의 기침 인식 모델을 개발했다. 또한 열화상 카메라와 같은 원리로 기침 소리와 기침하는 사람의 시각화를 위해 기침 인식 모델을 음향 카메라에 적용, 기침 소리와 기침하는 사람의 위치, 심지어 기침 횟수까지를 실시간으로 추적하고 기록이 가능한 '기침 인식 카메라'를 개발했다.

연구팀은 기침 인식 카메라가 사람이 밀집한 공공장소에서 전염병의 유행을 감지하거나 병원에서 환자의 상태를 상시 모니터링 가능한 의료용 장비로 활용될 것으로 기대하고 있다.

연구팀은 기침 인식 모델 개발을 위해 *합성 곱 신경망(convolutional neural network, CNN)을 기반으로 *지도학습(supervised learning)을 적용했다. 1초 길이 음향신호의 특징(feature)을 입력 신호로 받아, 1(기침) 또는 0(그 외)의 2진 신호를 출력하고 학습률의 최적화를 위해 일정 기간 학습률이 정체되면 학습률 값을 낮추도록 설정했다.

이어서 기침 인식 모델의 훈련 및 평가를 위해 구글과 유튜브 등에서 연구용으로 활발히 사용 중인 공개 음성데이터 세트인 `오디오세트(Audioset)'를 비롯해 `디맨드(DEMAND)'와 `이티에스아이(ETSI)', `티미트(TIMIT)' 등에서 데이터 세트를 수집했다. 이 중 `오디오세트'는 훈련 및 평가 데이터 세트 구성을 위해 사용했고 다른 데이터 세트의 경우 기침 인식 모델이 다양한 배경 소음을 학습할 수 있도록 데이터 증강(data augmentation)을 위한 배경 소음으로 사용했다.

☞ 합성 곱 신경망(convolutional neural network): 시각적 이미지를 분석하는 데 사용되는 인공신경망(생물학의 신경망에서 영감을 얻은 통계학적 학습 알고리즘)의 한 종류

☞ 지도학습(Supervised Learning): 훈련 데이터(Training Data)로부터 하나의 함수를 유추해내기 위한 기계 학습(Machine Learning)의 한 방법

데이터 증강을 위해 배경 소음을 15%~75%의 비율로 `오디오세트'에 섞은 후, 다양한 거리에 적응할 수 있게 음량을 0.25~1.0배로 조정했다. 훈련 및 평가 데이터 세트는 증강된 데이터 세트를 9:1 비율로 나눠 구성했으며, 시험 데이터 세트는 따로 사무실에서 녹음한 것을 사용했다.

모델 최적화를 위해서는 '스펙트로그램(spectrogram)' 등 5개의 음향 특징과 7개의 최적화 기기(optimizer)를 사용해 학습을 진행하고 시험 데이터 세트의 정확도를 측정, 성능을 확인한 결과 87.4%의 시험 정확도를 얻을 수 있었다.

연구팀은 이어 학습된 기침 인식 모델을 소리를 수집하는 마이크로폰 어레이와 카메라 모듈로 구성되는 음향 카메라에 적용했다. 그 결과 수집된 데이터는 음원의 위치를 계산하는 빔 형성 과정을 거쳐 기침 인식 모델이 기침 소리로 인식할 경우 기침 소리가 난 위치에 기침 소리임을 나타내는 등고선과 라벨이 각각 표시된다.

박 교수팀은 마지막 단계로 기침 인식 카메라의 예비 테스트를 진행한 결과, 여러 잡음 환경에서도 기침 소리와 그 이외의 소리로 구분이 가능하며 기침하는 사람과 그 사람의 위치, 횟수 등을 실시간으로 추적해 현장에서의 적용 가능성을 확인했다. 이들은 추후 병원 등 실사용 환경에서 추가 학습이 이뤄진다면 정확도는 87.4%보다 더 높아질 것으로 기대하고 있다.

박용화 교수는 "코로나19가 지속적으로 전파되고 있는 상황에서 공공장소와 다수 밀집 시설에 기침 인식 카메라를 활용하면 전염병의 방역 및 조기 감지에 큰 도움이 될 것ˮ이라고 말했다. 박 교수는 이어 "특히 병실에 적용하면 환자의 상태를 24시간 기록해 치료에 활용할 수 있기 때문에 의료진의 수고를 줄이고 환자 상태를 더 정밀하게 파악할 수 있을 것ˮ 이라고 강조했다.

한편, 이번 연구는 에너지기술평가원(산업통상자원부)의 지원을 받아 수행됐다.

2020.08.03 조회수 32000 AI대학원 김기응 교수 연구팀, 인공지능 전력망 운영관리 국제대회 1위 달성

우리 대학 AI대학원 김기응 교수 연구팀(홍성훈, 윤든솔 석사과정, 이병준 박사과정)이 인공지능 기반 전력망 운영관리 기술을 겨루는 국제경진대회인 'L2RPN 챌린지(Learning to Run a Power Network Challenge 2020 WCCI)'에서 최종 1위를 차지했다. 이 대회는 기계학습 연구를 촉진하기 위한 각종 경진대회를 주관하는 비영리단체 ChaLearn, 유럽 최대 전력망을 운영관리하는 프랑스 전력공사의 자회사 RTE(Réseau de Transport d'Électricité)社 및 세계 최대 규모의 전력 회사 SGCC(State Grid of China)의 자회사인 GEIRI North America(Global Energy Interconnection Research Institute)에서 공동주최해, 세계 각국의 약 50팀이 약 40일간 (2020.05.20.~06.30) 온라인으로 참여해 성황리에 마감됐다.

단순한 전력망이 스마트 그리드를 넘어서 에너지 클라우드 및 네트워크로 진화하려면 신재생 에너지의 비율이 30% 이상이 돼야 하고, 신재생 에너지 비율이 높아지면 전력망 운영의 복잡도가 매우 증가한다. 실제로 독일의 경우 신재생 에너지 비율이 30%가 넘어가면서 전력사고가 3,000건 이상 증가할 정도로 심각하며, 미국의 ENRON 사태 직전에도 에너지 발전과 수요 사이의 수급 조절에 문제가 생기면서 잦은 정전 사태가 났던 사례도 있다.

전력망 운영에 인공지능 기술 도입은 아직 초기 단계이며, 현재 사용되고 있는 전력망은 관리자의 개입 없이 1시간 이상 운영되기 힘든 실정이다. 이에 프랑스의 RTE(Réseau de Transport d'Électricité) 社는 전력망 운영에 인공지능 기술을 접목하는 경진대회 'L2RPN'을 2019년 처음 개최했다. 2019년 대회는 IEEE-14라는 14개의 변전소를 포함하는 가상의 전력망에서 단순한 운영을 목표로 열렸다. 2020년 대회는 L2RPN 2020 WCCI 챌린지라는 이름으로 특정 국가 수도 규모의 복잡한 전력망을 72시간 동안 관리자의 개입 없이 스스로 안전하고 효율적으로 운영될 수 있는 인공지능 전력망 관리 에이전트를 개발하는 것을 목표로 열렸다. 시간에 따른 공급-수요의 변화, 시설 유지보수 및 재난에 따른 급작스러운 단전 등 다양한 시나리오에 대해 전력망 운영관리 능력의 평가가 이뤄졌다.

김 교수 연구팀은 이번 2020년 대회에서 전력망 구조를 효과적으로 반영할 수 있는 그래프 신경망 모델 기반의 강화학습 에이전트를 개발해 참가했다. 기존의 에이전트들은 소규모의 전력망에서만 적용 가능하다는 한계가 있었지만, 김 교수 연구팀은 국가 수도 규모의 복잡한 전력망에도 적용 가능한 에이전트를 개발했다. 연구팀이 개발한 인공지능 전력망 운영관리 에이전트는 주어진 모든 테스트 시나리오에 대해 안전하고 효율적으로 전력망을 운영해 최종 1위의 성적을 거뒀다. 우승팀에게는 상금으로 미국 실리콘밸리에 있는 GEIRI North America를 방문할 수 있는 여행경비와 학회참가 비용 3,000달러가 주어진다. 연구진은 앞으로도 기술을 고도화해 국가 규모의 전력망과 다양한 신재생 에너지원을 다룰 수 있도록 확장할 계획이다.

한편 이번 연구는 과기정통부 에너지 클라우드 기술개발 사업의 지원으로 설치된 개방형 에너지 클라우드 플랫폼 연구단과제로 수행됐다. (연구단장 KAIST 전산학부 문수복 교수)

※ 대회 결과 사이트 관련 링크: https://l2rpn.chalearn.org/competitions

※ 개방형 에너지 클라우드 플랫폼 연구단 사이트: https://www.oecp.kaist.ac.kr

2020.07.28 조회수 31374

AI대학원 김기응 교수 연구팀, 인공지능 전력망 운영관리 국제대회 1위 달성

우리 대학 AI대학원 김기응 교수 연구팀(홍성훈, 윤든솔 석사과정, 이병준 박사과정)이 인공지능 기반 전력망 운영관리 기술을 겨루는 국제경진대회인 'L2RPN 챌린지(Learning to Run a Power Network Challenge 2020 WCCI)'에서 최종 1위를 차지했다. 이 대회는 기계학습 연구를 촉진하기 위한 각종 경진대회를 주관하는 비영리단체 ChaLearn, 유럽 최대 전력망을 운영관리하는 프랑스 전력공사의 자회사 RTE(Réseau de Transport d'Électricité)社 및 세계 최대 규모의 전력 회사 SGCC(State Grid of China)의 자회사인 GEIRI North America(Global Energy Interconnection Research Institute)에서 공동주최해, 세계 각국의 약 50팀이 약 40일간 (2020.05.20.~06.30) 온라인으로 참여해 성황리에 마감됐다.

단순한 전력망이 스마트 그리드를 넘어서 에너지 클라우드 및 네트워크로 진화하려면 신재생 에너지의 비율이 30% 이상이 돼야 하고, 신재생 에너지 비율이 높아지면 전력망 운영의 복잡도가 매우 증가한다. 실제로 독일의 경우 신재생 에너지 비율이 30%가 넘어가면서 전력사고가 3,000건 이상 증가할 정도로 심각하며, 미국의 ENRON 사태 직전에도 에너지 발전과 수요 사이의 수급 조절에 문제가 생기면서 잦은 정전 사태가 났던 사례도 있다.

전력망 운영에 인공지능 기술 도입은 아직 초기 단계이며, 현재 사용되고 있는 전력망은 관리자의 개입 없이 1시간 이상 운영되기 힘든 실정이다. 이에 프랑스의 RTE(Réseau de Transport d'Électricité) 社는 전력망 운영에 인공지능 기술을 접목하는 경진대회 'L2RPN'을 2019년 처음 개최했다. 2019년 대회는 IEEE-14라는 14개의 변전소를 포함하는 가상의 전력망에서 단순한 운영을 목표로 열렸다. 2020년 대회는 L2RPN 2020 WCCI 챌린지라는 이름으로 특정 국가 수도 규모의 복잡한 전력망을 72시간 동안 관리자의 개입 없이 스스로 안전하고 효율적으로 운영될 수 있는 인공지능 전력망 관리 에이전트를 개발하는 것을 목표로 열렸다. 시간에 따른 공급-수요의 변화, 시설 유지보수 및 재난에 따른 급작스러운 단전 등 다양한 시나리오에 대해 전력망 운영관리 능력의 평가가 이뤄졌다.

김 교수 연구팀은 이번 2020년 대회에서 전력망 구조를 효과적으로 반영할 수 있는 그래프 신경망 모델 기반의 강화학습 에이전트를 개발해 참가했다. 기존의 에이전트들은 소규모의 전력망에서만 적용 가능하다는 한계가 있었지만, 김 교수 연구팀은 국가 수도 규모의 복잡한 전력망에도 적용 가능한 에이전트를 개발했다. 연구팀이 개발한 인공지능 전력망 운영관리 에이전트는 주어진 모든 테스트 시나리오에 대해 안전하고 효율적으로 전력망을 운영해 최종 1위의 성적을 거뒀다. 우승팀에게는 상금으로 미국 실리콘밸리에 있는 GEIRI North America를 방문할 수 있는 여행경비와 학회참가 비용 3,000달러가 주어진다. 연구진은 앞으로도 기술을 고도화해 국가 규모의 전력망과 다양한 신재생 에너지원을 다룰 수 있도록 확장할 계획이다.

한편 이번 연구는 과기정통부 에너지 클라우드 기술개발 사업의 지원으로 설치된 개방형 에너지 클라우드 플랫폼 연구단과제로 수행됐다. (연구단장 KAIST 전산학부 문수복 교수)

※ 대회 결과 사이트 관련 링크: https://l2rpn.chalearn.org/competitions

※ 개방형 에너지 클라우드 플랫폼 연구단 사이트: https://www.oecp.kaist.ac.kr

2020.07.28 조회수 31374 기존 인공지능 기술을 뛰어넘는 양자 인공지능 알고리즘 개발

우리 대학 전기및전자공학부 및 AI 양자컴퓨팅 IT 인력양성연구센터장 이준구 교수 연구팀이 독일 및 남아공 연구팀과의 협력 연구를 통해 비선형 양자 기계학습 인공지능 알고리즘을 개발했다고 7일 밝혔다.

양자 인공지능은 양자컴퓨터의 발전과 함께 현재의 인공지능을 앞설 것으로 크게 기대되고 있으나 연산 방법이 전혀 달라 새로운 양자 알고리즘의 개발이 절실하다. 특히 양자컴퓨터는 본질적으로 일차방정식을 잘 푸는 선형적 성질을 가지고 있어 복잡한 데이터를 다루는 비선형적 기계학습에 어려움이 존재했다. 하지만 이번 연구를 통해 비선형 커널이 고안되어 복잡한 데이터에 대한 양자 기계학습이 가능하게 됐다. 특히 이준구 교수팀이 개발한 양자 지도학습 알고리즘은 학습에 있어 매우 적은 계산량으로 연산이 가능하다. 따라서 대규모 계산량이 필요한 현재의 인공지능 기술을 추월할 가능성을 제시한 것으로 평가를 받고 있다.

이준구 교수팀은 학습데이터와 테스트데이터를 양자 정보로 생성한 후 양자 정보의 병렬연산을 가능하게 하는 양자포킹 기술과 간단한 양자 측정기술을 조합해 양자 데이터 간의 유사성을 효율적으로 계산하는 비선형 커널 기반의 지도학습을 구현하는 양자 알고리즘 체계를 만들었다. 이후 IBM 클라우드 서비스를 통해 실제 양자컴퓨터에서 양자 지도학습을 실제 시연하는 데 성공했다.

KAIST 박경덕 연구교수가 공동 제1 저자로 참여한 이번 연구결과는 국제 학술지 네이처 자매지인 `npj Quantum Information' 誌 2020년 5월 6권에 게재됐다. (논문명: Quantum classifier with tailored quantum kernel).