%EC%9D%B8%EA%B3%B5%EC%A7%80%EB%8A%A5

-

인공지능으로 인간 추론 능력 극대화시키다

최근 인공지능 기술이 인식, 생성, 제어, 대화와 같은 실제 문제를 빠르게 해결해 나감에 따라 인간의 역할과 일자리 생태계가 변화하고 있다. 인공지능의 발전 속도를 본다면 가까운 미래에는 인공지능이 인간보다 똑똑해질 수도 있다. 이와 반대로 인공지능을 이용해 인간의 사고력 자체를 향상시킬 순 없을까?

우리 대학 뇌인지과학과 이상완 교수(신경과학-인공지능 융합연구센터장) 연구팀이 인간의 빠른 추론 능력을 유도해 인과관계의 학습 효율을 향상할 수 있는 뇌 기반 인공지능 기술 개발에 성공했다고 31일 밝혔다.

우리는 일상생활에서 다양한 사건을 경험하며 세상의 다양한 요소에 대한 인과관계를 학습해 나가고, 공부할 때는 지식 조각들을 조합하며 통합적인 지식을 습득한다. 이러한 과정은 점진적으로 추론하는 베이시안 모델 또는 특정한 상황에서 한 번의 경험으로부터 빠르게 결론을 도출하는 고속추론 또는 원샷 추론이 있다.

연구팀은 이전 연구에서 인간의 원샷 추론 과정을 모델링하고 전두엽과 해마가 이러한 과정에 관여하고 있음을 규명한 바 있다. 이번 연구에서 이 모델에 인간의 원샷 추론 과정을 특정한 상태로 유도하기 위해 알파고에 사용된 바 있는 심층 강화학습 기술을 접목했다. 이는 강화학습 알고리즘이 인간의 원샷 추론 과정을 수없이 시뮬레이션하면서 전두엽과 해마가 가장 효율적으로 학습할 수 있는 최적의 조건을 탐색하는 과정으로 볼 수 있다.

연구팀은 126명의 인간 피험자를 대상으로 한 인과관계 학습 및 추론 실험에서 제안 기술을 사용해 학습했을 때 단순 반복 학습 대비 최대 약 40%까지 학습 효율이 향상됨을 보였다. 더 나아가 오랜 시간에 걸쳐 신중하게 학습하거나 몇 가지 단서만을 조합해 빠르게 결론을 도출하는 것 같은 개인별 학습 성향을 고려한 맞춤형 설계가 가능함을 보였다.

인간의 사고체계에 대한 뇌과학적인 이해를 바탕으로 원샷 추론과 같은 인간의 잠재적 능력을 극대화하는 이 기술은 차세대 인공지능의 중요한 도전과제 중 하나이며, 뇌 기반 인공지능 기술은 인간과 유사한 사고체계를 바탕으로 가치판단을 할 수 있으므로 장기적으로 인간과 인공지능이 협업하는 분야에서 인공지능의 신뢰성 및 윤리성을 높이는 데도 기여할 수 있을 것으로 기대된다.

개발 기술은 스마트 교육, 게임 콘텐츠 개발, 추론 능력 측정, 인지훈련 등 인간의 추론 학습과 관련된 모든 분야에 적용될 수 있다. 기존 기술은 단편적인 기억회상, 특정 인지기능, 정답률 증가와 같은 행동적 측면에 집중해 왔다면, 이번 기술은 인공지능을 이용해 과거의 경험을 일반화시키는 인간의 사고체계 자체를 높이는 가능성을 확인한 최초의 사례로 평가된다.

KAIST에서 연구를 주도한 제1 저자 이지항 교수(현 상명대 서울캠퍼스 조교수)는 "이번 연구를 통해 인간의 인지기능을 인공지능에 이식하여 뇌 기반 인공지능을 실현하는 사례를 보였고, 이를 통해 인간의 고위 수준 인지를 적절한 방향으로 유도할 수 있는 새로운 인간-인공지능 상호작용 패러다임을 제시했다ˮ라고 강조하며, 추후 "인간중심 인공지능 연구 개발뿐만 아니라 바이오메디컬 분야, 특히 정신 건강과 관련된 디지털 치료 분야에 적용했을 때 큰 파급력을 보일 것ˮ이라고 말했다.

연구 책임자인 이상완 교수는 "이번 기술의 잠재력은 인공지능의 방대한 지식을 인간이 빠르게 흡수할 수 있는 형태로 변환할 수 있다는 데 있다ˮ며, "챗 GPT, GPT-4와 같은 언어 인공지능에서 추출되는 다양한 정보를 인간이 빠르게 추론 학습할 수 있게 변환하거나, 게임이나 가상현실의 콘텐츠를 인간의 추론 과정에 맞게 최적화해 몰입도를 높일 수 있고, 반대로 몰입도를 적절한 수준에서 제어할 경우 중독을 완화하는 효과를 기대할 수 있다ˮ라고 말했다.

관련 기술은 국내 및 해외에 특허 출원된 상태이며, KAIST 기술설명회(테크페어)에 소개된 바 있다. 이상완 교수 연구팀은 이러한 뇌 기반 인공지능 원천기술의 파급력을 높이기 위해 2019년 KAIST 신경과학-인공지능 융합연구센터를 설립하고, 구글 딥마인드, 마이크로소프트 연구소, IBM 연구소, 옥스퍼드 대학 등 다양한 해외 연구팀들과 함께 국제공동연구를 수행해 오고 있다.

이번 연구는 `시뮬레이션 기반 실험 디자인을 이용한 인간의 인과관계 추론과정 제어'라는 제목으로 국제 학술지 셀(Cell)의 오픈 액세스 저널인 `셀 리포트(Cell Reports)'에 1월 호 온라인판에 1월 30일 자 게재됐다. (논문명: Controlling human causal inference through in-silico task design)

한편 이번 연구는 삼성전자 미래기술육성센터, 과학기술정보통신부 정보통신기획평가원 SW스타랩 및 한국연구재단의 지원을 받아 수행됐다.

2024.01.31 조회수 7152

인공지능으로 인간 추론 능력 극대화시키다

최근 인공지능 기술이 인식, 생성, 제어, 대화와 같은 실제 문제를 빠르게 해결해 나감에 따라 인간의 역할과 일자리 생태계가 변화하고 있다. 인공지능의 발전 속도를 본다면 가까운 미래에는 인공지능이 인간보다 똑똑해질 수도 있다. 이와 반대로 인공지능을 이용해 인간의 사고력 자체를 향상시킬 순 없을까?

우리 대학 뇌인지과학과 이상완 교수(신경과학-인공지능 융합연구센터장) 연구팀이 인간의 빠른 추론 능력을 유도해 인과관계의 학습 효율을 향상할 수 있는 뇌 기반 인공지능 기술 개발에 성공했다고 31일 밝혔다.

우리는 일상생활에서 다양한 사건을 경험하며 세상의 다양한 요소에 대한 인과관계를 학습해 나가고, 공부할 때는 지식 조각들을 조합하며 통합적인 지식을 습득한다. 이러한 과정은 점진적으로 추론하는 베이시안 모델 또는 특정한 상황에서 한 번의 경험으로부터 빠르게 결론을 도출하는 고속추론 또는 원샷 추론이 있다.

연구팀은 이전 연구에서 인간의 원샷 추론 과정을 모델링하고 전두엽과 해마가 이러한 과정에 관여하고 있음을 규명한 바 있다. 이번 연구에서 이 모델에 인간의 원샷 추론 과정을 특정한 상태로 유도하기 위해 알파고에 사용된 바 있는 심층 강화학습 기술을 접목했다. 이는 강화학습 알고리즘이 인간의 원샷 추론 과정을 수없이 시뮬레이션하면서 전두엽과 해마가 가장 효율적으로 학습할 수 있는 최적의 조건을 탐색하는 과정으로 볼 수 있다.

연구팀은 126명의 인간 피험자를 대상으로 한 인과관계 학습 및 추론 실험에서 제안 기술을 사용해 학습했을 때 단순 반복 학습 대비 최대 약 40%까지 학습 효율이 향상됨을 보였다. 더 나아가 오랜 시간에 걸쳐 신중하게 학습하거나 몇 가지 단서만을 조합해 빠르게 결론을 도출하는 것 같은 개인별 학습 성향을 고려한 맞춤형 설계가 가능함을 보였다.

인간의 사고체계에 대한 뇌과학적인 이해를 바탕으로 원샷 추론과 같은 인간의 잠재적 능력을 극대화하는 이 기술은 차세대 인공지능의 중요한 도전과제 중 하나이며, 뇌 기반 인공지능 기술은 인간과 유사한 사고체계를 바탕으로 가치판단을 할 수 있으므로 장기적으로 인간과 인공지능이 협업하는 분야에서 인공지능의 신뢰성 및 윤리성을 높이는 데도 기여할 수 있을 것으로 기대된다.

개발 기술은 스마트 교육, 게임 콘텐츠 개발, 추론 능력 측정, 인지훈련 등 인간의 추론 학습과 관련된 모든 분야에 적용될 수 있다. 기존 기술은 단편적인 기억회상, 특정 인지기능, 정답률 증가와 같은 행동적 측면에 집중해 왔다면, 이번 기술은 인공지능을 이용해 과거의 경험을 일반화시키는 인간의 사고체계 자체를 높이는 가능성을 확인한 최초의 사례로 평가된다.

KAIST에서 연구를 주도한 제1 저자 이지항 교수(현 상명대 서울캠퍼스 조교수)는 "이번 연구를 통해 인간의 인지기능을 인공지능에 이식하여 뇌 기반 인공지능을 실현하는 사례를 보였고, 이를 통해 인간의 고위 수준 인지를 적절한 방향으로 유도할 수 있는 새로운 인간-인공지능 상호작용 패러다임을 제시했다ˮ라고 강조하며, 추후 "인간중심 인공지능 연구 개발뿐만 아니라 바이오메디컬 분야, 특히 정신 건강과 관련된 디지털 치료 분야에 적용했을 때 큰 파급력을 보일 것ˮ이라고 말했다.

연구 책임자인 이상완 교수는 "이번 기술의 잠재력은 인공지능의 방대한 지식을 인간이 빠르게 흡수할 수 있는 형태로 변환할 수 있다는 데 있다ˮ며, "챗 GPT, GPT-4와 같은 언어 인공지능에서 추출되는 다양한 정보를 인간이 빠르게 추론 학습할 수 있게 변환하거나, 게임이나 가상현실의 콘텐츠를 인간의 추론 과정에 맞게 최적화해 몰입도를 높일 수 있고, 반대로 몰입도를 적절한 수준에서 제어할 경우 중독을 완화하는 효과를 기대할 수 있다ˮ라고 말했다.

관련 기술은 국내 및 해외에 특허 출원된 상태이며, KAIST 기술설명회(테크페어)에 소개된 바 있다. 이상완 교수 연구팀은 이러한 뇌 기반 인공지능 원천기술의 파급력을 높이기 위해 2019년 KAIST 신경과학-인공지능 융합연구센터를 설립하고, 구글 딥마인드, 마이크로소프트 연구소, IBM 연구소, 옥스퍼드 대학 등 다양한 해외 연구팀들과 함께 국제공동연구를 수행해 오고 있다.

이번 연구는 `시뮬레이션 기반 실험 디자인을 이용한 인간의 인과관계 추론과정 제어'라는 제목으로 국제 학술지 셀(Cell)의 오픈 액세스 저널인 `셀 리포트(Cell Reports)'에 1월 호 온라인판에 1월 30일 자 게재됐다. (논문명: Controlling human causal inference through in-silico task design)

한편 이번 연구는 삼성전자 미래기술육성센터, 과학기술정보통신부 정보통신기획평가원 SW스타랩 및 한국연구재단의 지원을 받아 수행됐다.

2024.01.31 조회수 7152 -

‘당신 우울한가요?’ 스마트폰으로 진단하다

요즘 현대인들에게 많이 찾아오는 우울증을 진단하기 위한 스마트폰으로 진단하는 연구가 개발되어 화제다.

우리 대학 전기및전자공학부 이성주 교수 연구팀이 사용자의 언어 사용 패턴을 개인정보 유출 없이 스마트폰에서 자동으로 분석해 사용자의 정신건강 상태를 모니터링하는 인공지능 기술을 개발했다고 21일 밝혔다. 사용자가 스마트폰을 소지하고 일상적으로 사용하기만 해도 스마트폰이 사용자의 정신건강 상태를 분석 및 진단할 수 있는 것이다.

연구팀은 임상적으로 이뤄지는 정신질환 진단이 환자와의 상담을 통한 언어 사용 분석에서 이루어진다는 점에 착안해 연구를 진행했다. 이번 기술에서는 (1) 사용자가 직접 작성한 문자 메시지 등의 키보드 입력 내용과, (2) 스마트폰 위 마이크에서 실시간으로 수집되는 사용자의 음성 데이터를 기반으로 정신건강 진단을 수행한다.

이러한 언어 데이터는 사용자의 민감한 정보를 담고 있을 수 있어 기존에는 활용이 어려웠다. 이러한 문제의 해결을 위해 이번 기술에는 연합학습 인공지능 기술이 적용됐는데, 이는 사용자 기기 외부로의 데이터 유출 없이 인공지능 모델을 학습해 사생활 침해의 우려가 없다는 것이 특징이다.

인공지능 모델은 일상 대화 내용과 화자의 정신건강을 바탕으로 한 데이터셋을 기반으로 학습되었다. 모델은 스마트폰에서 입력으로 주어지는 대화를 실시간으로 분석하여 학습된 내용을 바탕으로 사용자의 정신건강 척도를 예측한다.

더 나아가, 연구팀은 스마트폰 위 대량으로 주어지는 사용자 언어 데이터로부터 효과적인 정신건강 진단을 수행하는 방법론을 개발했다. 연구팀은 사용자들이 언어를 사용하는 패턴이 실생활 속 다양한 상황에 따라 다르다는 것에 착안해, 스마트폰 위에서 주어지는 현재 상황에 대한 단서를 기반으로, 인공지능 모델이 상대적으로 중요한 언어 데이터에 집중하도록 설계했다. 예를 들어, 업무 시간보다는 저녁 시간에 가족 또는 친구들과 나누는 대화에 정신건강을 모니터링 할 수 있는 단서가 많다고 인공지능 모델이 판단해 중점을 두고 분석하는 식이다.

이번 논문은 전산학부 신재민 박사과정, 전기및전자공학부 윤형준 박사과정, 이승주 석사과정, 이성주 교수와 박성준 SoftlyAI 대표(KAIST 졸업생), 중국 칭화대학교 윤신 리우(Yunxin Liu) 교수, 그리고 미국 에모리(Emory) 대학교 최진호 교수의 공동연구로 이뤄졌다.

이번 논문은 올해 12월 6일부터 10일까지 싱가폴에서 열린 자연어 처리 분야 최고 권위 학회인 EMNLP(Conference on Empirical Methods in Natural Language Processing)에서 발표됐다.

※ 논문명(FedTherapist: Mental Health Monitoring with User-Generated Linguistic Expressions on Smartphones via Federated Learning)

이성주 교수는 "이번 연구는 모바일 센싱, 자연어 처리, 인공지능, 심리학 전문가들의 협력으로 이루어져서 의미가 깊으며, 정신질환으로 어려워하는 사람들이 많은데, 개인정보 유출이나 사생활 침범의 걱정 없이 스마트폰 사용만으로 정신건강 상태를 조기진단 할 수 있게 되었다ˮ라며, "이번 연구가 서비스화되어 사회에 도움이 되면 좋겠다ˮ라고 소감을 밝혔다.

이 연구는 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행됐다. (No. 2022-0-00495, 휴대폰 단말에서의 보이스피싱 탐지 예방 기술 개발, No. 2022-0-00064, 감정노동자의 정신건강 위험 예측 및 관리를 위한 휴먼 디지털 트윈 기술 개발)

2023.12.21 조회수 9811

‘당신 우울한가요?’ 스마트폰으로 진단하다

요즘 현대인들에게 많이 찾아오는 우울증을 진단하기 위한 스마트폰으로 진단하는 연구가 개발되어 화제다.

우리 대학 전기및전자공학부 이성주 교수 연구팀이 사용자의 언어 사용 패턴을 개인정보 유출 없이 스마트폰에서 자동으로 분석해 사용자의 정신건강 상태를 모니터링하는 인공지능 기술을 개발했다고 21일 밝혔다. 사용자가 스마트폰을 소지하고 일상적으로 사용하기만 해도 스마트폰이 사용자의 정신건강 상태를 분석 및 진단할 수 있는 것이다.

연구팀은 임상적으로 이뤄지는 정신질환 진단이 환자와의 상담을 통한 언어 사용 분석에서 이루어진다는 점에 착안해 연구를 진행했다. 이번 기술에서는 (1) 사용자가 직접 작성한 문자 메시지 등의 키보드 입력 내용과, (2) 스마트폰 위 마이크에서 실시간으로 수집되는 사용자의 음성 데이터를 기반으로 정신건강 진단을 수행한다.

이러한 언어 데이터는 사용자의 민감한 정보를 담고 있을 수 있어 기존에는 활용이 어려웠다. 이러한 문제의 해결을 위해 이번 기술에는 연합학습 인공지능 기술이 적용됐는데, 이는 사용자 기기 외부로의 데이터 유출 없이 인공지능 모델을 학습해 사생활 침해의 우려가 없다는 것이 특징이다.

인공지능 모델은 일상 대화 내용과 화자의 정신건강을 바탕으로 한 데이터셋을 기반으로 학습되었다. 모델은 스마트폰에서 입력으로 주어지는 대화를 실시간으로 분석하여 학습된 내용을 바탕으로 사용자의 정신건강 척도를 예측한다.

더 나아가, 연구팀은 스마트폰 위 대량으로 주어지는 사용자 언어 데이터로부터 효과적인 정신건강 진단을 수행하는 방법론을 개발했다. 연구팀은 사용자들이 언어를 사용하는 패턴이 실생활 속 다양한 상황에 따라 다르다는 것에 착안해, 스마트폰 위에서 주어지는 현재 상황에 대한 단서를 기반으로, 인공지능 모델이 상대적으로 중요한 언어 데이터에 집중하도록 설계했다. 예를 들어, 업무 시간보다는 저녁 시간에 가족 또는 친구들과 나누는 대화에 정신건강을 모니터링 할 수 있는 단서가 많다고 인공지능 모델이 판단해 중점을 두고 분석하는 식이다.

이번 논문은 전산학부 신재민 박사과정, 전기및전자공학부 윤형준 박사과정, 이승주 석사과정, 이성주 교수와 박성준 SoftlyAI 대표(KAIST 졸업생), 중국 칭화대학교 윤신 리우(Yunxin Liu) 교수, 그리고 미국 에모리(Emory) 대학교 최진호 교수의 공동연구로 이뤄졌다.

이번 논문은 올해 12월 6일부터 10일까지 싱가폴에서 열린 자연어 처리 분야 최고 권위 학회인 EMNLP(Conference on Empirical Methods in Natural Language Processing)에서 발표됐다.

※ 논문명(FedTherapist: Mental Health Monitoring with User-Generated Linguistic Expressions on Smartphones via Federated Learning)

이성주 교수는 "이번 연구는 모바일 센싱, 자연어 처리, 인공지능, 심리학 전문가들의 협력으로 이루어져서 의미가 깊으며, 정신질환으로 어려워하는 사람들이 많은데, 개인정보 유출이나 사생활 침범의 걱정 없이 스마트폰 사용만으로 정신건강 상태를 조기진단 할 수 있게 되었다ˮ라며, "이번 연구가 서비스화되어 사회에 도움이 되면 좋겠다ˮ라고 소감을 밝혔다.

이 연구는 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행됐다. (No. 2022-0-00495, 휴대폰 단말에서의 보이스피싱 탐지 예방 기술 개발, No. 2022-0-00064, 감정노동자의 정신건강 위험 예측 및 관리를 위한 휴먼 디지털 트윈 기술 개발)

2023.12.21 조회수 9811 -

혹시 나도 수면 질환? AI로 간단히 검사해 보세요

각종 장비를 몸에 부착한 채 병원에서 하룻밤을 보내야 하는 번거로운 검사 없이 웹사이트를 통해 간단히 수면 질환 위험도를 파악할 방법이 나왔다. 우리 대학 수리과학과 김재경 교수 연구팀이 삼성서울병원 주은연‧최수정 교수팀, 이화여대 서울병원 김지현 교수팀과 공동 연구를 통해 개발한 세 가지 수면 질환을 예측할 수 있는 알고리즘 ‘슬립스(SLEEPS‧SimpLe quEstionnairE Predicting Sleep disorders)’를 12일 공개했다.

‘잠이 보약’이라는 말처럼 수면은 정신적‧신체적 건강에 주요한 영향을 미친다. 성인의 60%가량이 수면 질환을 앓고 있지만, 관련하여 전문 의료진에게 문의한 비율은 6% 수준에 불과하다. 병원 방문을 꺼리는 원인 중 하나로는 수면 질환 진단을 받기 위해 시행하는 수면다원검사가 번거롭다는 이유가 있다.

공동연구진은 약 5,000명의 수면다원검사 결과를 기계 학습을 통해 학습시켜 수면 질환 위험도를 예측하는 알고리즘 ‘슬립스’를 개발했다. 슬립스에서 나이, 성별, 키, 체중, 최근 2주간의 수면 시 어려움, 수면 유지 어려움, 기상 시 어려움, 수면 패턴에 대한 만족도, 수면이 일상 기능에 미치는 영향 등 간단한 9개의 질문에 답하는 것만으로 만성불면증, 수면호흡장애, 수면호흡장애를 동반한 불면증의 위험도를 90%의 정확도로 예측할 수 있다. 가령, 슬립스 검사 결과 수면호흡장애 위험도가 50%라는 결과가 나왔다면, 실제 수면다원검사를 시행했을 때 수면호흡장애가 발견될 확률이 50%임을 의미한다.

제1 저자인 하석민 미국 MIT 박사과정생(前 IBS 의생명 수학 그룹 연구원)은 “미국 하버드대 연구팀도 AI 기반 수면 질환 검사 알고리즘을 개발한 바 있으나, 이 시스템은 목둘레, 혈압 등 쉽게 답하기 어려운 문항이 포함되어 있어 사용이 까다로웠다”며 “또한, 하버드대 연구팀의 시스템은 예측 정확도도 70% 정도에 그쳤다”고 말했다.

슬립스 사이트(www.sleep-math.com)를 통해 누구나 수면 질환 여부를 예측해볼 수 있다. 현재 본인의 상태를 기준으로 몸무게 변화나 나이가 듦에 따른 수면 질환 위험도 변화도 살펴볼 수 있다.

김재경 교수는 “이번 연구는 수학으로 우리가 직면한 건강 문제를 해결해보고자 하는 시도에서 시작됐고, 중요하지만 쉽게 간과할 수 있는 수면 질환에 기계 학습을 접목했다”며 “수면 질환 진단의 복잡한 과정을 줄인 만큼, 많은 사람이 슬립스를 통해 자신의 수면 건강을 알 수 있는 계기가 되길 바란다”고 말했다.

주은연 삼성서울병원 교수는 “슬립스는 간편한 수면 질환 자가 검진 시스템”이라며 “향후 건강검진 항목에 AI 기반 자가 검진 시스템을 포함한다면 잠재적인 수면 질환 환자들을 스크리닝하여 수면 질환으로 인해 발생하는 수많은 질병을 선제적으로 예방할 수 있을 것”이라고 말했다.

슬립스 개발 성과는 지난 9월 의료 건강 분야 국제학술지 ‘Journal of Medical Internet Research’에 실린 바 있다.

2023.12.14 조회수 13490

혹시 나도 수면 질환? AI로 간단히 검사해 보세요

각종 장비를 몸에 부착한 채 병원에서 하룻밤을 보내야 하는 번거로운 검사 없이 웹사이트를 통해 간단히 수면 질환 위험도를 파악할 방법이 나왔다. 우리 대학 수리과학과 김재경 교수 연구팀이 삼성서울병원 주은연‧최수정 교수팀, 이화여대 서울병원 김지현 교수팀과 공동 연구를 통해 개발한 세 가지 수면 질환을 예측할 수 있는 알고리즘 ‘슬립스(SLEEPS‧SimpLe quEstionnairE Predicting Sleep disorders)’를 12일 공개했다.

‘잠이 보약’이라는 말처럼 수면은 정신적‧신체적 건강에 주요한 영향을 미친다. 성인의 60%가량이 수면 질환을 앓고 있지만, 관련하여 전문 의료진에게 문의한 비율은 6% 수준에 불과하다. 병원 방문을 꺼리는 원인 중 하나로는 수면 질환 진단을 받기 위해 시행하는 수면다원검사가 번거롭다는 이유가 있다.

공동연구진은 약 5,000명의 수면다원검사 결과를 기계 학습을 통해 학습시켜 수면 질환 위험도를 예측하는 알고리즘 ‘슬립스’를 개발했다. 슬립스에서 나이, 성별, 키, 체중, 최근 2주간의 수면 시 어려움, 수면 유지 어려움, 기상 시 어려움, 수면 패턴에 대한 만족도, 수면이 일상 기능에 미치는 영향 등 간단한 9개의 질문에 답하는 것만으로 만성불면증, 수면호흡장애, 수면호흡장애를 동반한 불면증의 위험도를 90%의 정확도로 예측할 수 있다. 가령, 슬립스 검사 결과 수면호흡장애 위험도가 50%라는 결과가 나왔다면, 실제 수면다원검사를 시행했을 때 수면호흡장애가 발견될 확률이 50%임을 의미한다.

제1 저자인 하석민 미국 MIT 박사과정생(前 IBS 의생명 수학 그룹 연구원)은 “미국 하버드대 연구팀도 AI 기반 수면 질환 검사 알고리즘을 개발한 바 있으나, 이 시스템은 목둘레, 혈압 등 쉽게 답하기 어려운 문항이 포함되어 있어 사용이 까다로웠다”며 “또한, 하버드대 연구팀의 시스템은 예측 정확도도 70% 정도에 그쳤다”고 말했다.

슬립스 사이트(www.sleep-math.com)를 통해 누구나 수면 질환 여부를 예측해볼 수 있다. 현재 본인의 상태를 기준으로 몸무게 변화나 나이가 듦에 따른 수면 질환 위험도 변화도 살펴볼 수 있다.

김재경 교수는 “이번 연구는 수학으로 우리가 직면한 건강 문제를 해결해보고자 하는 시도에서 시작됐고, 중요하지만 쉽게 간과할 수 있는 수면 질환에 기계 학습을 접목했다”며 “수면 질환 진단의 복잡한 과정을 줄인 만큼, 많은 사람이 슬립스를 통해 자신의 수면 건강을 알 수 있는 계기가 되길 바란다”고 말했다.

주은연 삼성서울병원 교수는 “슬립스는 간편한 수면 질환 자가 검진 시스템”이라며 “향후 건강검진 항목에 AI 기반 자가 검진 시스템을 포함한다면 잠재적인 수면 질환 환자들을 스크리닝하여 수면 질환으로 인해 발생하는 수많은 질병을 선제적으로 예방할 수 있을 것”이라고 말했다.

슬립스 개발 성과는 지난 9월 의료 건강 분야 국제학술지 ‘Journal of Medical Internet Research’에 실린 바 있다.

2023.12.14 조회수 13490 -

구글딥마인드와 공동연구를 통해 인공지능으로 시각을 상상하다

‘노란 포도'나 `보라색 바나나'와 같이 본 적 없는 시각 개념을 이해하고 상상하는 인공지능 능력 구현이 가능해졌다.

우리 대학 전산학부 안성진 교수 연구팀이 구글 딥마인드 및 미국 럿거스 대학교와의 국제 공동 연구를 통해 시각적 지식을 체계적으로 조합해 새로운 개념을 이해하는 인공지능 새로운 모델과 프로그램을 수행하는 벤치마크를 개발했다고 30일 밝혔다.

인간은 `보라색 포도'와 `노란 바나나' 같은 개념을 학습하고, 이를 분리한 뒤 재조합해 `노란 포도'나 `보라색 바나나'와 같이 본 적 없는 개념을 상상하는 능력이 있다. 이런 능력은 체계적 일반화 혹은 조합적 일반화라고 불리며, 범용 인공지능을 구현하는 데 있어 핵심적인 요소로 여겨진다.

체계적 일반화 문제는 1988년 미국의 저명한 인지과학자 제리 포더(Jerry Fodor)와 제논 필리쉰(Zenon Pylyshyn)이 인공신경망이 이 문제를 해결할 수 없다고 주장한 이후, 35년 동안 인공지능 딥러닝 분야에서 큰 도전 과제로 남아 있다. 이 문제는 언어뿐만 아니라 시각 정보에서도 발생하지만, 지금까지는 주로 언어의 체계적 일반화에만 초점이 맞춰져 있었고, 시각 정보에 관한 연구는 상대적으로 부족했다.

안성진 교수가 이끄는 국제 공동 연구팀은 이러한 공백을 메우고자 시각 정보에 대한 체계적 일반화를 연구할 수 있는 벤치마크를 개발했다. 시각 정보는 언어와는 달리 명확한 `단어'나 `토큰'의 구조가 없어, 이 구조를 학습하고 체계적 일반화를 달성하는 것이 큰 도전이다.

연구를 주도한 안성진 교수는 “시각 정보의 체계적 일반화가 범용 인공지능을 달성하기 위해 필수적인 능력이며 이 연구를 통해 인공지능의 추론능력과 상상능력 관련 분야의 발전을 가속할 것으로 기대한다”고 말했다.

또한, 딥마인드의 책임 연구원으로 연구에 참여한 연구원이자 현재 스위스 로잔연방공과대학교(EPFL)의 찰라 걸셔(Caglar Gulcehre) 교수는 “체계적 일반화가 가능해지면 현재보다 훨씬 적은 데이터로 더 높은 성능을 낼 수 있게 될 것이다”라고 전했다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Imagine the Unseen World: A Benchmark for Systematic Generalization in Visual World Models”, Yeongbin Kim, Gautam Singh, Junyeong Park, Caglar Gulcehre, Sungjin Ahn, NeurIPS 23

2023.11.30 조회수 8001

구글딥마인드와 공동연구를 통해 인공지능으로 시각을 상상하다

‘노란 포도'나 `보라색 바나나'와 같이 본 적 없는 시각 개념을 이해하고 상상하는 인공지능 능력 구현이 가능해졌다.

우리 대학 전산학부 안성진 교수 연구팀이 구글 딥마인드 및 미국 럿거스 대학교와의 국제 공동 연구를 통해 시각적 지식을 체계적으로 조합해 새로운 개념을 이해하는 인공지능 새로운 모델과 프로그램을 수행하는 벤치마크를 개발했다고 30일 밝혔다.

인간은 `보라색 포도'와 `노란 바나나' 같은 개념을 학습하고, 이를 분리한 뒤 재조합해 `노란 포도'나 `보라색 바나나'와 같이 본 적 없는 개념을 상상하는 능력이 있다. 이런 능력은 체계적 일반화 혹은 조합적 일반화라고 불리며, 범용 인공지능을 구현하는 데 있어 핵심적인 요소로 여겨진다.

체계적 일반화 문제는 1988년 미국의 저명한 인지과학자 제리 포더(Jerry Fodor)와 제논 필리쉰(Zenon Pylyshyn)이 인공신경망이 이 문제를 해결할 수 없다고 주장한 이후, 35년 동안 인공지능 딥러닝 분야에서 큰 도전 과제로 남아 있다. 이 문제는 언어뿐만 아니라 시각 정보에서도 발생하지만, 지금까지는 주로 언어의 체계적 일반화에만 초점이 맞춰져 있었고, 시각 정보에 관한 연구는 상대적으로 부족했다.

안성진 교수가 이끄는 국제 공동 연구팀은 이러한 공백을 메우고자 시각 정보에 대한 체계적 일반화를 연구할 수 있는 벤치마크를 개발했다. 시각 정보는 언어와는 달리 명확한 `단어'나 `토큰'의 구조가 없어, 이 구조를 학습하고 체계적 일반화를 달성하는 것이 큰 도전이다.

연구를 주도한 안성진 교수는 “시각 정보의 체계적 일반화가 범용 인공지능을 달성하기 위해 필수적인 능력이며 이 연구를 통해 인공지능의 추론능력과 상상능력 관련 분야의 발전을 가속할 것으로 기대한다”고 말했다.

또한, 딥마인드의 책임 연구원으로 연구에 참여한 연구원이자 현재 스위스 로잔연방공과대학교(EPFL)의 찰라 걸셔(Caglar Gulcehre) 교수는 “체계적 일반화가 가능해지면 현재보다 훨씬 적은 데이터로 더 높은 성능을 낼 수 있게 될 것이다”라고 전했다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Imagine the Unseen World: A Benchmark for Systematic Generalization in Visual World Models”, Yeongbin Kim, Gautam Singh, Junyeong Park, Caglar Gulcehre, Sungjin Ahn, NeurIPS 23

2023.11.30 조회수 8001 -

인공지능으로 북한 등 경제지표 추정하다

유엔기구(UN)의 지속가능발전목표(SDGs)에 따르면 하루 2달러 이하로 생활하는 절대빈곤 인구가 7억 명에 달하지만 그 빈곤의 현황을 제대로 파악하기는 쉽지 않다. 전 세계 중 53개국은 지난 15년 동안 농업 관련 현황 조사를 하지 못했으며, 17개국은 인구 센서스(인구주택 총조사)조차 진행하지 못했다. 이러한 데이터 부족을 극복하려는 시도로, 누구나 웹에서 받아볼 수 있는 인공위성 영상을 활용해 경제 지표를 추정하는 기술이 주목받고 있다.

우리 대학 차미영-김지희 교수 연구팀이 기초과학연구원, 서강대, 홍콩과기대(HKUST), 싱가포르국립대(NUS)와 국제공동연구를 통해 주간 위성영상을 활용해 경제 상황을 분석하는 새로운 인공지능(AI) 기법을 개발했다고 21일 밝혔다. 연구팀이 주목한 것은 기존 통계자료를 기반으로 학습하는 일반적인 환경이 아닌, 기초 통계도 미비한 최빈국(最貧國)까지 모니터링할 수 있는 범용적인 모델이다.

연구팀은 유럽우주국(ESA)이 운용하며 무료로 공개하는 센티넬-2(Sentinel-2) 위성영상을 활용했다. 연구팀은 먼저 위성영상을 약 6제곱킬로미터(2.5×2.5㎢)의 작은 구역으로 세밀하게 분할한 후, 각 구역의 경제 지표를 건물, 도로, 녹지 등의 시각적 정보를 기반으로 AI 기법을 통해 수치화했다.

이번 연구 모델이 이전 연구와 차별화된 점은 기초 데이터가 부족한 지역에도 적용할 수 있게끔 인간이 제시하는 정보를 인공지능의 예측에 반영하는 `인간-기계 협업 알고리즘'에 있다. 즉, 인간이 위성영상을 보고 경제 활동의 많고 적음을 비교하면, 기계는 이러한 인간이 제공한 정보를 학습하여 각각의 영상자료에 경제 점수를 부여한다. 검증 결과, 기계학습만 사용했을 때보다 인간과 협업할 경우 성능이 월등히 우수했다.

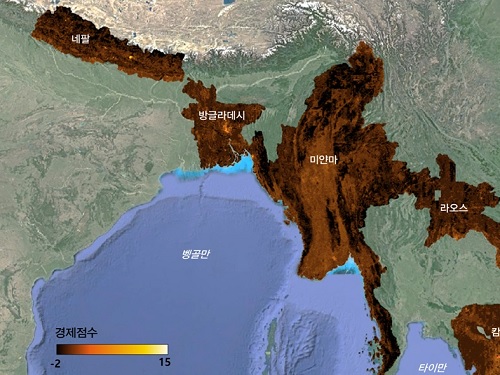

이번 연구를 통해 연구팀은 기존 통계자료가 부족한 지역까지 경제분석의 범위를 확장하고, 북한 및 아시아 5개국(네팔, 라오스, 미얀마, 방글라데시, 캄보디아)에도 같은 기술을 적용하여 세밀한 경제 지표 점수를 공개했다. (그림 1) 이 연구가 제시한 경제 지표는 기존의 인구밀도, 고용 수, 사업체 수 등의 사회경제지표와 높은 상관관계를 보였으며, 데이터가 부족한 저개발국가에 적용 가능함을 연구팀은 확인했다.

이러한 변화탐지를 북한에 적용한 결과, 대북 경제제재가 심화된 2016년과 2019년 사이에 북한 경제에서 세 가지 경향을 발견할 수 있었다. 첫째, 북한의 경제 발전은 평양과 대도시에 더욱 집중되어 도시와 농촌 간 격차가 심화됐다. 둘째, 경제제재와 달러 외환의 부족을 극복하기 위해 설치한 관광 경제개발구에서는 새로운 건물 건설 등 유의미한 변화가 위성영상 이미지와 연구의 경제 지표 점수 변화에서 드러났다. 셋째, 전통적인 공업 및 수출 경제개발구 유형에서는 반대로 변화가 미미한 것으로 확인됐다.

연구에 참여한 우리 대학 전산학부·IBS 데이터사이언스그룹 CI 차미영 교수는 "전산학, 경제학, 지리학이 융합된 이번 연구는 범지구적 차원의 빈곤 문제를 다룬다는 점에서 중요한 의미가 있으며, 이번에 개발한 인공지능 알고리즘을 앞으로 이산화탄소 배출량, 재해재난 피해 탐지, 기후 변화로 인한 영향 등 다양한 국제사회 문제에 적용해 볼 계획이다ˮ 라고 말했다.

이 연구에는 경제학자인 우리 대학 기술경영학부 김지희 교수, 서강대 경제학과 양현주 교수, 홍콩과기대 박상윤 교수도 함께 참여하였다. 이들은 “이 모델은 저비용으로 개발도상국의 경제 상황을 상세하게 확인할 수 있어 국제개발협력(ODA) 사업에 도움을 줄 수 있을 것으로 예상된다”며 “이번 연구가 선진국과 후진국 간의 데이터 격차를 줄이고 유엔과 국제사회의 공동목표인 지속가능한 발전을 달성하는 데 기여할 수 있기를 바란다ˮ고 밝혔다.

위성영상과 인공지능을 활용한 SDGs 지표의 개발과 이의 정책적 활용은 국제적인 주목을 받고 있는 기술 분야 중 하나이며 한국이 앞으로 주도권을 가지고 이끌 수 있는 연구 분야이다. 이에 연구팀은 개발한 모델 코드를 무료로 공개하며, 측정한 지표가 여러 국가의 정책 설계 및 평가에 유용하게 사용될 수 있도록 앞으로도 기술을 개선하고 매해 새롭게 업데이트되는 인공위성 영상에 적용하여 공개할 계획이다.

한편 이번 연구 결과는 전산학부 안동현 박사과정, 싱가포르 국립대 양재석 박사과정이 공동 1저자로 국제 학술지 네이처 출판 그룹의 `네이처 커뮤니케이션즈(Nature Communications)'에 지난 10월 26일 자 게재됐다. (논문명: A human-machine collaborative approach measures economic development using satellite imagery, 인간-기계 협업과 위성영상 분석에 기반한 경제 발전 측정).

논문링크: https://www.nature.com/articles/s41467-023-42122-8

2023.11.21 조회수 9200

인공지능으로 북한 등 경제지표 추정하다

유엔기구(UN)의 지속가능발전목표(SDGs)에 따르면 하루 2달러 이하로 생활하는 절대빈곤 인구가 7억 명에 달하지만 그 빈곤의 현황을 제대로 파악하기는 쉽지 않다. 전 세계 중 53개국은 지난 15년 동안 농업 관련 현황 조사를 하지 못했으며, 17개국은 인구 센서스(인구주택 총조사)조차 진행하지 못했다. 이러한 데이터 부족을 극복하려는 시도로, 누구나 웹에서 받아볼 수 있는 인공위성 영상을 활용해 경제 지표를 추정하는 기술이 주목받고 있다.

우리 대학 차미영-김지희 교수 연구팀이 기초과학연구원, 서강대, 홍콩과기대(HKUST), 싱가포르국립대(NUS)와 국제공동연구를 통해 주간 위성영상을 활용해 경제 상황을 분석하는 새로운 인공지능(AI) 기법을 개발했다고 21일 밝혔다. 연구팀이 주목한 것은 기존 통계자료를 기반으로 학습하는 일반적인 환경이 아닌, 기초 통계도 미비한 최빈국(最貧國)까지 모니터링할 수 있는 범용적인 모델이다.

연구팀은 유럽우주국(ESA)이 운용하며 무료로 공개하는 센티넬-2(Sentinel-2) 위성영상을 활용했다. 연구팀은 먼저 위성영상을 약 6제곱킬로미터(2.5×2.5㎢)의 작은 구역으로 세밀하게 분할한 후, 각 구역의 경제 지표를 건물, 도로, 녹지 등의 시각적 정보를 기반으로 AI 기법을 통해 수치화했다.

이번 연구 모델이 이전 연구와 차별화된 점은 기초 데이터가 부족한 지역에도 적용할 수 있게끔 인간이 제시하는 정보를 인공지능의 예측에 반영하는 `인간-기계 협업 알고리즘'에 있다. 즉, 인간이 위성영상을 보고 경제 활동의 많고 적음을 비교하면, 기계는 이러한 인간이 제공한 정보를 학습하여 각각의 영상자료에 경제 점수를 부여한다. 검증 결과, 기계학습만 사용했을 때보다 인간과 협업할 경우 성능이 월등히 우수했다.

이번 연구를 통해 연구팀은 기존 통계자료가 부족한 지역까지 경제분석의 범위를 확장하고, 북한 및 아시아 5개국(네팔, 라오스, 미얀마, 방글라데시, 캄보디아)에도 같은 기술을 적용하여 세밀한 경제 지표 점수를 공개했다. (그림 1) 이 연구가 제시한 경제 지표는 기존의 인구밀도, 고용 수, 사업체 수 등의 사회경제지표와 높은 상관관계를 보였으며, 데이터가 부족한 저개발국가에 적용 가능함을 연구팀은 확인했다.

이러한 변화탐지를 북한에 적용한 결과, 대북 경제제재가 심화된 2016년과 2019년 사이에 북한 경제에서 세 가지 경향을 발견할 수 있었다. 첫째, 북한의 경제 발전은 평양과 대도시에 더욱 집중되어 도시와 농촌 간 격차가 심화됐다. 둘째, 경제제재와 달러 외환의 부족을 극복하기 위해 설치한 관광 경제개발구에서는 새로운 건물 건설 등 유의미한 변화가 위성영상 이미지와 연구의 경제 지표 점수 변화에서 드러났다. 셋째, 전통적인 공업 및 수출 경제개발구 유형에서는 반대로 변화가 미미한 것으로 확인됐다.

연구에 참여한 우리 대학 전산학부·IBS 데이터사이언스그룹 CI 차미영 교수는 "전산학, 경제학, 지리학이 융합된 이번 연구는 범지구적 차원의 빈곤 문제를 다룬다는 점에서 중요한 의미가 있으며, 이번에 개발한 인공지능 알고리즘을 앞으로 이산화탄소 배출량, 재해재난 피해 탐지, 기후 변화로 인한 영향 등 다양한 국제사회 문제에 적용해 볼 계획이다ˮ 라고 말했다.

이 연구에는 경제학자인 우리 대학 기술경영학부 김지희 교수, 서강대 경제학과 양현주 교수, 홍콩과기대 박상윤 교수도 함께 참여하였다. 이들은 “이 모델은 저비용으로 개발도상국의 경제 상황을 상세하게 확인할 수 있어 국제개발협력(ODA) 사업에 도움을 줄 수 있을 것으로 예상된다”며 “이번 연구가 선진국과 후진국 간의 데이터 격차를 줄이고 유엔과 국제사회의 공동목표인 지속가능한 발전을 달성하는 데 기여할 수 있기를 바란다ˮ고 밝혔다.

위성영상과 인공지능을 활용한 SDGs 지표의 개발과 이의 정책적 활용은 국제적인 주목을 받고 있는 기술 분야 중 하나이며 한국이 앞으로 주도권을 가지고 이끌 수 있는 연구 분야이다. 이에 연구팀은 개발한 모델 코드를 무료로 공개하며, 측정한 지표가 여러 국가의 정책 설계 및 평가에 유용하게 사용될 수 있도록 앞으로도 기술을 개선하고 매해 새롭게 업데이트되는 인공위성 영상에 적용하여 공개할 계획이다.

한편 이번 연구 결과는 전산학부 안동현 박사과정, 싱가포르 국립대 양재석 박사과정이 공동 1저자로 국제 학술지 네이처 출판 그룹의 `네이처 커뮤니케이션즈(Nature Communications)'에 지난 10월 26일 자 게재됐다. (논문명: A human-machine collaborative approach measures economic development using satellite imagery, 인간-기계 협업과 위성영상 분석에 기반한 경제 발전 측정).

논문링크: https://www.nature.com/articles/s41467-023-42122-8

2023.11.21 조회수 9200 -

인공지능 결합한 홀로그래픽 현미경 기술 총망라

의생명공학 연구에 일반적으로 사용되는 현미경 기술들은 염색이나 유전자 조작을 해야만 관찰할 수 있다는 한계가 있다. 하지만 염색이 된 세포들은 치료 목적으로 활용할 수 없어 세포나 조직을 살아있는 상태 그대로 관찰할 수 있는 홀로그래픽 현미경과 이를 체계적으로 분석할 수 있는 인공지능을 결합한 의생명공학 연구의 활용 방안 및 문제점에 대한 분석이 필요하다.

우리 대학 물리학과 박용근 교수 연구팀이 국제 학술지 `네이처 메소드(Nature Methods)'에 홀로그래픽 현미경과 인공지능 융합 연구 방법론을 조망한 견해 (perspective)를 게재했다고 14일 전했다.

연구팀은 기존 현미경 기술 대비 홀로그래픽 현미경의 이미지 복원 기술이 시간을 많이 필요하고 전처리 없이 세포나 조직을 찍을 수 있다는 장점이 있지만, 대신에 그만큼 결과물 분석에 많은 시간과 노력을 들여야 한다고도 분석했다.

박용근 교수 연구팀은 이런 문제점을 홀로그래픽 현미경과 인공지능과의 통합을 통해 해결할 수 있다는 방법론을 제시했다. 지난 수년간, 홀로그래픽 현미경과 인공지능을 결합해 의생명공학 연구에 혁신을 일으킨 내용들이 잇달아 국제 학술지에 발표됐다. 인공지능을 통해 홀로그래픽 이미지를 복원하고, 세포의 종류와 상태를 구분하고, 염색 없이 측정된 결과물에 가상으로 염색 정보를 재생산 해내는 등의 연구를 통해 연구팀은 기존의 홀로그래픽 현미경 기술의 효율을 극대화했다.

홀로그래픽 현미경 기술 소개에 더불어 인공지능의 결합이 광범위한 의생명공학 연구에 활용돼 온 내용을 총망라한 이번 리뷰 논문은 제시된 방법론의 혁신성을 인정받아 생명과학 분야의 권위 학술지인 `네이처 메소드(Nature Methods)'에 지난 10월 24일 자 출판됐다. (논문명: Artificial intelligence-enabled Quantitative Phase Imaging Methods for Life Sciences)

제1 저자인 물리학과 박주연 학생은 "홀로그래픽 현미경에 인공지능을 결합하면, 의생명공학 연구의 효율을 기하급수적으로 높일 수 있다ˮ며, "이번 리뷰 논문을 통해 이 융합 기술이 더욱 활발하게 개발됨과 동시에 더욱 다양한 의생명공학 연구에 활용될 것ˮ이라고 기대했다.

한편 이번 논문은 캘리포니아대학교 로스앤젤레스(UCLA) 아이도간 오즈칸(Aydogan Ozcan) 교수팀, 토모큐브(Tomocube) 인공지능 연구팀과 공동 집필했으며, 연구재단의 리더연구사업, 과학기술정보통신부의 홀로그램핵심기술지원사업, 나노 및 소재 기술개발사업의 지원을 받아 수행됐다.

2023.11.14 조회수 9859

인공지능 결합한 홀로그래픽 현미경 기술 총망라

의생명공학 연구에 일반적으로 사용되는 현미경 기술들은 염색이나 유전자 조작을 해야만 관찰할 수 있다는 한계가 있다. 하지만 염색이 된 세포들은 치료 목적으로 활용할 수 없어 세포나 조직을 살아있는 상태 그대로 관찰할 수 있는 홀로그래픽 현미경과 이를 체계적으로 분석할 수 있는 인공지능을 결합한 의생명공학 연구의 활용 방안 및 문제점에 대한 분석이 필요하다.

우리 대학 물리학과 박용근 교수 연구팀이 국제 학술지 `네이처 메소드(Nature Methods)'에 홀로그래픽 현미경과 인공지능 융합 연구 방법론을 조망한 견해 (perspective)를 게재했다고 14일 전했다.

연구팀은 기존 현미경 기술 대비 홀로그래픽 현미경의 이미지 복원 기술이 시간을 많이 필요하고 전처리 없이 세포나 조직을 찍을 수 있다는 장점이 있지만, 대신에 그만큼 결과물 분석에 많은 시간과 노력을 들여야 한다고도 분석했다.

박용근 교수 연구팀은 이런 문제점을 홀로그래픽 현미경과 인공지능과의 통합을 통해 해결할 수 있다는 방법론을 제시했다. 지난 수년간, 홀로그래픽 현미경과 인공지능을 결합해 의생명공학 연구에 혁신을 일으킨 내용들이 잇달아 국제 학술지에 발표됐다. 인공지능을 통해 홀로그래픽 이미지를 복원하고, 세포의 종류와 상태를 구분하고, 염색 없이 측정된 결과물에 가상으로 염색 정보를 재생산 해내는 등의 연구를 통해 연구팀은 기존의 홀로그래픽 현미경 기술의 효율을 극대화했다.

홀로그래픽 현미경 기술 소개에 더불어 인공지능의 결합이 광범위한 의생명공학 연구에 활용돼 온 내용을 총망라한 이번 리뷰 논문은 제시된 방법론의 혁신성을 인정받아 생명과학 분야의 권위 학술지인 `네이처 메소드(Nature Methods)'에 지난 10월 24일 자 출판됐다. (논문명: Artificial intelligence-enabled Quantitative Phase Imaging Methods for Life Sciences)

제1 저자인 물리학과 박주연 학생은 "홀로그래픽 현미경에 인공지능을 결합하면, 의생명공학 연구의 효율을 기하급수적으로 높일 수 있다ˮ며, "이번 리뷰 논문을 통해 이 융합 기술이 더욱 활발하게 개발됨과 동시에 더욱 다양한 의생명공학 연구에 활용될 것ˮ이라고 기대했다.

한편 이번 논문은 캘리포니아대학교 로스앤젤레스(UCLA) 아이도간 오즈칸(Aydogan Ozcan) 교수팀, 토모큐브(Tomocube) 인공지능 연구팀과 공동 집필했으며, 연구재단의 리더연구사업, 과학기술정보통신부의 홀로그램핵심기술지원사업, 나노 및 소재 기술개발사업의 지원을 받아 수행됐다.

2023.11.14 조회수 9859 -

트랜스포머 대체할 차세대 월드모델 기술 세계 최초 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스 대학교와 협력하여 트랜스포머 및 재귀신경망 기반의 월드모델을 대체할 차세대 에이전트 월드모델 기술을 세계 최초로 개발했다.

월드모델은 인간의 뇌가 현실 세계의 경험을 바탕으로 환경 모델을 구축하는 과정과 유사하다. 이러한 월드모델을 활용하는 인공지능은 특정 행동의 결과를 미리 시뮬레이션해보고 다양한 가설을 검증할 수 있어, 범용 인공지능의 핵심 구성 요소로 여겨진다.

특히, 로봇이나 자율주행 차량과 같은 인공지능 에이전트는 학습을 위해 여러 가지 행동을 시도해 보아야하는데, 이는 위험성과 고장 가능성을 높인다는 단점을 갖는다. 이에 반해, 월드모델을 갖춘 인공지능은 실세계 상호작용 없이도 상상모델 속에서 학습을 가능케 해 큰 이점을 제공한다.

그러나 월드모델은 자연어처리 등에서 큰 발전을 가능하게 한 트랜스포머와 S4와 같은 새로운 시퀀스 모델링 아키텍처의 적용에 한계가 있었다. 이로 인해, 대부분의 월드모델이 성능과 효율성 면에서 제약이 있는 고전적인 재귀적 신경망에 의존하고 있었고 안성진 교수팀은 작년 세계최초로 트랜스포머 기반의 월드모델을 개발하였으나 추론 계산속도나 메모리능력에서 여전히 개선할 문제를 갖고 있었다.

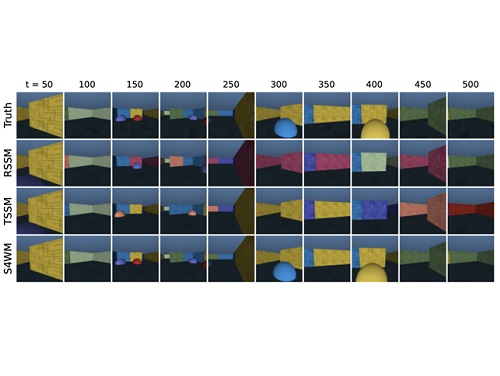

이러한 문제를 해결하기 위해, 안성진 교수가 이끄는 KAIST와 럿거스 대학교 공동연구팀은 재귀적 신경망과 트랜스포머 기반 월드모델의 단점을 극복한 새로운 월드모델의 개발에 성공했다. 연구팀은 S4 시퀀스 모델에 기반한 S4 World Model (S4WM)을 개발하여, 재귀적 신경망의 최대 단점인 병렬처리가 가능한 시퀀스 학습이 불가능하다는 문제를 해결하였다. 또한, 재귀적 신경망의 장점인 빠른 추론시간을 유지하도록 하여 느린 추론 시간을 제공하는 트랜스포머 기반 월드모델의 단점을 극복했다.

연구를 주도한 안성진 교수는 "병렬 학습과 빠른 추론이 가능한 에이전트 월드모델을 세계 최초로 개발했다ˮ며, 이는 "모델기반 강화학습 능력을 획기적으로 개선해 지능형 로봇, 자율주행 차량, 그리고 자율형 인공지능 에이전트 기술 전반에 비용절감과 성능 향상이 예상된다ˮ고 밝혔다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 세계 최고 수준의 인공지능 학회인 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Facing off World Model Backbones: RNNs, Transformers, and S4”Fei Deng, Junyeong Park, Sungjin Ahn, NeurIPS 23, https://arxiv.org/abs/2307.02064

2023.11.09 조회수 6953

트랜스포머 대체할 차세대 월드모델 기술 세계 최초 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스 대학교와 협력하여 트랜스포머 및 재귀신경망 기반의 월드모델을 대체할 차세대 에이전트 월드모델 기술을 세계 최초로 개발했다.

월드모델은 인간의 뇌가 현실 세계의 경험을 바탕으로 환경 모델을 구축하는 과정과 유사하다. 이러한 월드모델을 활용하는 인공지능은 특정 행동의 결과를 미리 시뮬레이션해보고 다양한 가설을 검증할 수 있어, 범용 인공지능의 핵심 구성 요소로 여겨진다.

특히, 로봇이나 자율주행 차량과 같은 인공지능 에이전트는 학습을 위해 여러 가지 행동을 시도해 보아야하는데, 이는 위험성과 고장 가능성을 높인다는 단점을 갖는다. 이에 반해, 월드모델을 갖춘 인공지능은 실세계 상호작용 없이도 상상모델 속에서 학습을 가능케 해 큰 이점을 제공한다.

그러나 월드모델은 자연어처리 등에서 큰 발전을 가능하게 한 트랜스포머와 S4와 같은 새로운 시퀀스 모델링 아키텍처의 적용에 한계가 있었다. 이로 인해, 대부분의 월드모델이 성능과 효율성 면에서 제약이 있는 고전적인 재귀적 신경망에 의존하고 있었고 안성진 교수팀은 작년 세계최초로 트랜스포머 기반의 월드모델을 개발하였으나 추론 계산속도나 메모리능력에서 여전히 개선할 문제를 갖고 있었다.

이러한 문제를 해결하기 위해, 안성진 교수가 이끄는 KAIST와 럿거스 대학교 공동연구팀은 재귀적 신경망과 트랜스포머 기반 월드모델의 단점을 극복한 새로운 월드모델의 개발에 성공했다. 연구팀은 S4 시퀀스 모델에 기반한 S4 World Model (S4WM)을 개발하여, 재귀적 신경망의 최대 단점인 병렬처리가 가능한 시퀀스 학습이 불가능하다는 문제를 해결하였다. 또한, 재귀적 신경망의 장점인 빠른 추론시간을 유지하도록 하여 느린 추론 시간을 제공하는 트랜스포머 기반 월드모델의 단점을 극복했다.

연구를 주도한 안성진 교수는 "병렬 학습과 빠른 추론이 가능한 에이전트 월드모델을 세계 최초로 개발했다ˮ며, 이는 "모델기반 강화학습 능력을 획기적으로 개선해 지능형 로봇, 자율주행 차량, 그리고 자율형 인공지능 에이전트 기술 전반에 비용절감과 성능 향상이 예상된다ˮ고 밝혔다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 세계 최고 수준의 인공지능 학회인 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Facing off World Model Backbones: RNNs, Transformers, and S4”Fei Deng, Junyeong Park, Sungjin Ahn, NeurIPS 23, https://arxiv.org/abs/2307.02064

2023.11.09 조회수 6953 -

변화된 데이터에서 인공지능 공정성 찾아내다

인공지능 기술이 사회 전반에 걸쳐 광범위하게 활용되며 인간의 삶에 많은 영향을 미치고 있다. 최근 인공지능의 긍정적인 효과 이면에 범죄자의 재범 예측을 위해 머신러닝 학습에 사용되는 콤파스(COMPAS) 시스템을 기반으로 학습된 모델이 인종 별로 서로 다른 재범 확률을 부여할 수 있다는 심각한 편향성이 관찰되었다. 이 밖에도 채용, 대출 시스템 등 사회의 중요 영역에서 인공지능의 다양한 편향성 문제가 밝혀지며, 공정성(fairness)을 고려한 머신러닝 학습의 필요성이 커지고 있다.

우리 대학 전기및전자공학부 황의종 교수 연구팀이 학습 상황과 달라진 새로운 분포의 테스트 데이터에 대해서도 편향되지 않은 판단을 내리도록 돕는 새로운 모델 훈련 기술을 개발했다고 30일 밝혔다.

최근 전 세계의 연구자들이 인공지능의 공정성을 높이기 위한 다양한 학습 방법론을 제안하고 있지만, 대부분의 연구는 인공지능 모델을 훈련시킬 때 사용되는 데이터와 실제 테스트 상황에서 사용될 데이터가 같은 분포를 갖는다고 가정한다. 하지만 실제 상황에서는 이러한 가정이 대체로 성립하지 않으며, 최근 다양한 어플리케이션에서 학습 데이터와 테스트 데이터 내의 편향 패턴이 크게 변화할 수 있음이 관측되고 있다.

이때, 테스트 환경에서 데이터의 정답 레이블과 특정 그룹 정보 간의 편향 패턴이 변경되면, 사전에 공정하게 학습되었던 인공지능 모델의 공정성이 직접적인 영향을 받고 다시금 악화된 편향성을 가질 수 있다. 일례로 과거에 특정 인종 위주로 채용하던 기관이 이제는 인종에 관계없이 채용한다면, 과거의 데이터를 기반으로 공정하게 학습된 인공지능 채용 모델이 현대의 데이터에는 오히려 불공정한 판단을 내릴 수 있다.

연구팀은 이러한 문제를 해결하기 위해, 먼저 `상관관계 변화(correlation shifts)' 개념을 도입해 기존의 공정성을 위한 학습 알고리즘들이 가지는 정확성과 공정성 성능에 대한 근본적인 한계를 이론적으로 분석했다. 예를 들어 특정 인종만 주로 채용한 과거 데이터의 경우 인종과 채용의 상관관계가 강해서 아무리 공정한 모델을 학습을 시켜도 현재의 약한 상관관계를 반영하는 정확하면서도 공정한 채용 예측을 하기가 근본적으로 어려운 것이다. 이러한 이론적인 분석을 바탕으로, 새로운 학습 데이터 샘플링 기법을 제안해 테스트 시에 데이터의 편향 패턴이 변화해도 모델을 공정하게 학습할 수 있도록 하는 새로운 학습 프레임워크를 제안했다. 이는 과거 데이터에서 우세하였던 특정 인종 데이터를 상대적으로 줄임으로써 채용과의 상관관계를 낮출 수 있다.

제안된 기법의 주요 이점은 데이터 전처리만 하기 때문에 기존에 제안된 알고리즘 기반 공정한 학습 기법을 그대로 활용하면서 개선할 수 있다는 것이다. 즉 이미 사용되고 있는 공정한 학습 알고리즘이 위에서 설명한 상관관계 변화에 취약하다면 제안된 기법을 함께 사용해서 해결할 수 있다.

제1 저자인 전기및전자공학부 노유지 박사과정 학생은 "이번 연구를 통해 인공지능 기술의 실제 적용 환경에서, 모델이 더욱 신뢰 가능하고 공정한 판단을 하도록 도울 것으로 기대한다ˮ고 밝혔다.

연구팀을 지도한 황의종 교수는 "기존 인공지능이 변화하는 데이터에 대해서도 공정성이 저하되지 않도록 하는 데 도움이 되기를 기대한다ˮ고 말했다.

이번 연구에는 노유지 박사과정이 제1 저자, 황의종 교수(KAIST)가 교신 저자, 서창호 교수(KAIST)와 이강욱 교수(위스콘신-매디슨 대학)가 공동 저자로 참여했다. 이번 연구는 지난 7월 미국 하와이에서 열린 머신러닝 최고권위 국제학술 대회인 `국제 머신러닝 학회 International Conference on Machine Learning (ICML)'에서 발표됐다. (논문명 : Improving Fair Training under Correlation Shifts)

한편, 이 기술은 정보통신기획평가원의 지원을 받은 `강건하고 공정하며 확장가능한 데이터 중심의 연속 학습' 과제 (2022-0-00157)와 한국연구재단 지원을 받은 `데이터 중심의 신뢰 가능한 인공지능' 과제의 성과다.

2023.10.30 조회수 7960

변화된 데이터에서 인공지능 공정성 찾아내다

인공지능 기술이 사회 전반에 걸쳐 광범위하게 활용되며 인간의 삶에 많은 영향을 미치고 있다. 최근 인공지능의 긍정적인 효과 이면에 범죄자의 재범 예측을 위해 머신러닝 학습에 사용되는 콤파스(COMPAS) 시스템을 기반으로 학습된 모델이 인종 별로 서로 다른 재범 확률을 부여할 수 있다는 심각한 편향성이 관찰되었다. 이 밖에도 채용, 대출 시스템 등 사회의 중요 영역에서 인공지능의 다양한 편향성 문제가 밝혀지며, 공정성(fairness)을 고려한 머신러닝 학습의 필요성이 커지고 있다.

우리 대학 전기및전자공학부 황의종 교수 연구팀이 학습 상황과 달라진 새로운 분포의 테스트 데이터에 대해서도 편향되지 않은 판단을 내리도록 돕는 새로운 모델 훈련 기술을 개발했다고 30일 밝혔다.

최근 전 세계의 연구자들이 인공지능의 공정성을 높이기 위한 다양한 학습 방법론을 제안하고 있지만, 대부분의 연구는 인공지능 모델을 훈련시킬 때 사용되는 데이터와 실제 테스트 상황에서 사용될 데이터가 같은 분포를 갖는다고 가정한다. 하지만 실제 상황에서는 이러한 가정이 대체로 성립하지 않으며, 최근 다양한 어플리케이션에서 학습 데이터와 테스트 데이터 내의 편향 패턴이 크게 변화할 수 있음이 관측되고 있다.

이때, 테스트 환경에서 데이터의 정답 레이블과 특정 그룹 정보 간의 편향 패턴이 변경되면, 사전에 공정하게 학습되었던 인공지능 모델의 공정성이 직접적인 영향을 받고 다시금 악화된 편향성을 가질 수 있다. 일례로 과거에 특정 인종 위주로 채용하던 기관이 이제는 인종에 관계없이 채용한다면, 과거의 데이터를 기반으로 공정하게 학습된 인공지능 채용 모델이 현대의 데이터에는 오히려 불공정한 판단을 내릴 수 있다.

연구팀은 이러한 문제를 해결하기 위해, 먼저 `상관관계 변화(correlation shifts)' 개념을 도입해 기존의 공정성을 위한 학습 알고리즘들이 가지는 정확성과 공정성 성능에 대한 근본적인 한계를 이론적으로 분석했다. 예를 들어 특정 인종만 주로 채용한 과거 데이터의 경우 인종과 채용의 상관관계가 강해서 아무리 공정한 모델을 학습을 시켜도 현재의 약한 상관관계를 반영하는 정확하면서도 공정한 채용 예측을 하기가 근본적으로 어려운 것이다. 이러한 이론적인 분석을 바탕으로, 새로운 학습 데이터 샘플링 기법을 제안해 테스트 시에 데이터의 편향 패턴이 변화해도 모델을 공정하게 학습할 수 있도록 하는 새로운 학습 프레임워크를 제안했다. 이는 과거 데이터에서 우세하였던 특정 인종 데이터를 상대적으로 줄임으로써 채용과의 상관관계를 낮출 수 있다.

제안된 기법의 주요 이점은 데이터 전처리만 하기 때문에 기존에 제안된 알고리즘 기반 공정한 학습 기법을 그대로 활용하면서 개선할 수 있다는 것이다. 즉 이미 사용되고 있는 공정한 학습 알고리즘이 위에서 설명한 상관관계 변화에 취약하다면 제안된 기법을 함께 사용해서 해결할 수 있다.

제1 저자인 전기및전자공학부 노유지 박사과정 학생은 "이번 연구를 통해 인공지능 기술의 실제 적용 환경에서, 모델이 더욱 신뢰 가능하고 공정한 판단을 하도록 도울 것으로 기대한다ˮ고 밝혔다.

연구팀을 지도한 황의종 교수는 "기존 인공지능이 변화하는 데이터에 대해서도 공정성이 저하되지 않도록 하는 데 도움이 되기를 기대한다ˮ고 말했다.

이번 연구에는 노유지 박사과정이 제1 저자, 황의종 교수(KAIST)가 교신 저자, 서창호 교수(KAIST)와 이강욱 교수(위스콘신-매디슨 대학)가 공동 저자로 참여했다. 이번 연구는 지난 7월 미국 하와이에서 열린 머신러닝 최고권위 국제학술 대회인 `국제 머신러닝 학회 International Conference on Machine Learning (ICML)'에서 발표됐다. (논문명 : Improving Fair Training under Correlation Shifts)

한편, 이 기술은 정보통신기획평가원의 지원을 받은 `강건하고 공정하며 확장가능한 데이터 중심의 연속 학습' 과제 (2022-0-00157)와 한국연구재단 지원을 받은 `데이터 중심의 신뢰 가능한 인공지능' 과제의 성과다.

2023.10.30 조회수 7960 -

인공지능으로 조현병 원인치료의 실마리 찾다

정신분열증으로도 알려진 조현병은 환청, 환영, 인지장애 등의 증상으로 대표되는 정신질환이다. 국내 연구진이 인공지능을 활용해 그동안 증상 억제만이 가능했던 조현병의 원인을 치료할 수 있는 실마리를 찾았다.

우리 대학 바이오및뇌공학과 이도헌 교수 및 한국한의학연구원(원장 이진용) 공동연구팀이 미국 스탠리 의과학연구소(이하 스탠리연구소) 와의 국제공동연구를 통해 인공지능으로 개인의 유전형과 조현병 사이의 선천적 병리 모델과 조현병 예측 마커를 발굴했다고 27일 밝혔다.

조현병은 2016년 강남역 살인사건, 2019년 진주 방화사건, 2023년 대전 칼부림 사건 등 일부 환자들의 강력범죄와 환자에 대한 사회적 낙인으로 인해 조현병은 심각한 사회적 문제가 되었다. 그러나 이러한 심각성에도 불구하고 조현병의 원인은 명확히 밝혀지지 않아, 리스페리돈(risperidone), 클로자핀(clozapine) 등 항정신병제에 의한 증상의 억제만이 가능한 실정이다.

이도헌 교수 연구팀은 미 스탠리연구소의 다수준 뇌 조직 데이터에 최근 주목받는 인공지능 기술인 `설명가능한 심층학습' 기술을 접목해, 선천적 유전형과 조현병 사이의 병리를 설명하는 인공신경망 모델을 구축했다. 그리고 모델을 해석하여, 선천적 유전형이 유전자·단백질 발현 조절을 통해 뇌의 전전두엽피질, 안와전두엽피질 신경세포의 발생을 변화시켜 조현병 취약성을 결정한다는 사실을 밝혀냈다. 또한, 뇌의 신경세포 밀도를 감소시키는 유전형 조합을 조현병 예측 마커로 제시해, 개인화된 조현병 예측과 세포 치료 등을 통한 조현병 원인치료의 가능성을 열었다.

이도헌 교수는 바이오의료 분야는 `속내를 알 수 없는 인공지능'보다는 `속내를 해석가능한 인공지능'이 꼭 필요한 분야라고 강조하면서, “기존의 인공지능과 비교했을 때 이번 연구에서는 인공신경망의 중간 노드에 유전자 이름, 세포의 상태와 같은 구체적인 생물학적 의미가 부여된 노드를 배치하고 그들간의 연결관계를 기계학습기법으로 분석했다”라고 말했다.

바이오및뇌공학과 이도헌 교수, 조유상 박사(現 한국한의학연구원 선임연구원), 미 스탠리연구소 김상현 박사, 마리 웹스터 박사가 공동으로 진행한 이번 연구는 영국 옥스퍼드대학교에서 발간하는 세계적 학술지인 `기능유전체학 브리핑(Briefings in Functional Genomics)'지 2023년 9월호에 게재됐다.

2023.09.27 조회수 9950

인공지능으로 조현병 원인치료의 실마리 찾다

정신분열증으로도 알려진 조현병은 환청, 환영, 인지장애 등의 증상으로 대표되는 정신질환이다. 국내 연구진이 인공지능을 활용해 그동안 증상 억제만이 가능했던 조현병의 원인을 치료할 수 있는 실마리를 찾았다.

우리 대학 바이오및뇌공학과 이도헌 교수 및 한국한의학연구원(원장 이진용) 공동연구팀이 미국 스탠리 의과학연구소(이하 스탠리연구소) 와의 국제공동연구를 통해 인공지능으로 개인의 유전형과 조현병 사이의 선천적 병리 모델과 조현병 예측 마커를 발굴했다고 27일 밝혔다.

조현병은 2016년 강남역 살인사건, 2019년 진주 방화사건, 2023년 대전 칼부림 사건 등 일부 환자들의 강력범죄와 환자에 대한 사회적 낙인으로 인해 조현병은 심각한 사회적 문제가 되었다. 그러나 이러한 심각성에도 불구하고 조현병의 원인은 명확히 밝혀지지 않아, 리스페리돈(risperidone), 클로자핀(clozapine) 등 항정신병제에 의한 증상의 억제만이 가능한 실정이다.

이도헌 교수 연구팀은 미 스탠리연구소의 다수준 뇌 조직 데이터에 최근 주목받는 인공지능 기술인 `설명가능한 심층학습' 기술을 접목해, 선천적 유전형과 조현병 사이의 병리를 설명하는 인공신경망 모델을 구축했다. 그리고 모델을 해석하여, 선천적 유전형이 유전자·단백질 발현 조절을 통해 뇌의 전전두엽피질, 안와전두엽피질 신경세포의 발생을 변화시켜 조현병 취약성을 결정한다는 사실을 밝혀냈다. 또한, 뇌의 신경세포 밀도를 감소시키는 유전형 조합을 조현병 예측 마커로 제시해, 개인화된 조현병 예측과 세포 치료 등을 통한 조현병 원인치료의 가능성을 열었다.

이도헌 교수는 바이오의료 분야는 `속내를 알 수 없는 인공지능'보다는 `속내를 해석가능한 인공지능'이 꼭 필요한 분야라고 강조하면서, “기존의 인공지능과 비교했을 때 이번 연구에서는 인공신경망의 중간 노드에 유전자 이름, 세포의 상태와 같은 구체적인 생물학적 의미가 부여된 노드를 배치하고 그들간의 연결관계를 기계학습기법으로 분석했다”라고 말했다.

바이오및뇌공학과 이도헌 교수, 조유상 박사(現 한국한의학연구원 선임연구원), 미 스탠리연구소 김상현 박사, 마리 웹스터 박사가 공동으로 진행한 이번 연구는 영국 옥스퍼드대학교에서 발간하는 세계적 학술지인 `기능유전체학 브리핑(Briefings in Functional Genomics)'지 2023년 9월호에 게재됐다.

2023.09.27 조회수 9950 -

10배 이상 생체신호 정밀 측정 ‘SUPPORT’ 개발

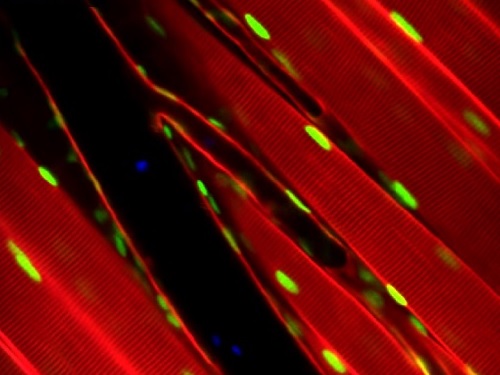

최근 유전공학 기술의 발전으로 형광현미경을 활용해 살아있는 생체조직 내 신호를 형광신호로 변환하여 연속적으로 촬영하고 측정하는 기술들이 개발되어 활용되고 있다. 그러나, 생체조직에서 방출되는 형광신호가 미약하기 때문에 빠르게 변화하는 신경세포의 전기신호 등의 신호를 측정할 경우, 매우 낮은 신호대잡음비를 가지게 되어 정밀한 측정이 어려워지게 된다.

우리 대학 전기및전자공학부 윤영규 교수 연구팀이 기존 기술 대비 10배 이상 정밀하게 생체 형광 신호 측정을 가능하게 하는 인공지능(AI) 영상 분석 기술을 개발했다고 20일 밝혔다.

윤 교수 연구팀은 별도의 학습 데이터 없이, 낮은 신호대잡음비를 가지는 형광현미경 영상으로부터 데이터의 통계적 분포를 스스로 학습해 영상의 신호대잡음비를 10배 이상 높여 생체신호를 정밀 측정할 수 있는 기술을 개발했다. 이를 활용하면 각종 생체 신호의 측정 정밀도가 크게 향상될 수 있어 생명과학 연구 전반과 뇌 질환 치료제 개발에 폭넓게 활용될 수 있을 것으로 기대된다.

윤 교수는 “이 기술이 다양한 뇌과학, 생명과학 연구에 도움이 되길 바라는 마음을 담아 ‘서포트(SUPPORT, Statistically Unbiased Prediction utilizing sPatiOtempoRal information in imaging daTa)라는 이름을 붙였다”며, “다양한 형광 이미징 장비를 활용하는 연구자들이 별도의 학습 데이터 없이도 쉽게 활용가능한 기술로, 새로운 생명현상 규명에 폭넓게 활용될 수 있을 것”이라고 말했다.

공동 제1 저자인 엄민호 연구원은 "서포트(SUPPORT) 기술을 통해 관측이 어려웠던 생체 신호의 빠른 변화를 정밀하게 측정하는 것에 성공하였고, 특히 밀리초 단위로 변하는 신경세포의 활동전위를 광학적으로 정밀하게 측정할 수 있어 뇌과학 연구에 매우 유용할 것이다”라고 하였으며, 공동 제1 저자인 한승재 연구원은 “서포트 기술은 형광현미경 영상 내 생체 신호의 정밀 측정을 위해 개발됐지만, 일반적인 타임랩스 영상의 품질을 높이기 위해서도 폭넓게 활용가능하다”라고 말했다.

이 기술은 전기및전자공학부 윤영규 교수팀의 주도하에 신소재공학과 장재범 교수, 의과학대학원 김필한 교수, 충남대학교, 서울대학교, 하버드대학(Harvard University), 보스턴대학(Boston University), 앨런 연구소(Allen Institute), 웨스트레이크대학(Westlake University) 연구진들과 다국적, 다학제간 협력을 통해서 개발됐다.

이번 연구는 한국연구재단의 지원을 받아 수행됐으며 국제 학술지 `네이처 메소드(Nature Methods)'에 9월 19일 자로 온라인 게재되었으며 10월호 표지 논문으로 선정됐다. (논문명 : Statistically unbiased prediction enables accurate denoising of voltage imaging data)

2023.09.20 조회수 6101

10배 이상 생체신호 정밀 측정 ‘SUPPORT’ 개발

최근 유전공학 기술의 발전으로 형광현미경을 활용해 살아있는 생체조직 내 신호를 형광신호로 변환하여 연속적으로 촬영하고 측정하는 기술들이 개발되어 활용되고 있다. 그러나, 생체조직에서 방출되는 형광신호가 미약하기 때문에 빠르게 변화하는 신경세포의 전기신호 등의 신호를 측정할 경우, 매우 낮은 신호대잡음비를 가지게 되어 정밀한 측정이 어려워지게 된다.

우리 대학 전기및전자공학부 윤영규 교수 연구팀이 기존 기술 대비 10배 이상 정밀하게 생체 형광 신호 측정을 가능하게 하는 인공지능(AI) 영상 분석 기술을 개발했다고 20일 밝혔다.

윤 교수 연구팀은 별도의 학습 데이터 없이, 낮은 신호대잡음비를 가지는 형광현미경 영상으로부터 데이터의 통계적 분포를 스스로 학습해 영상의 신호대잡음비를 10배 이상 높여 생체신호를 정밀 측정할 수 있는 기술을 개발했다. 이를 활용하면 각종 생체 신호의 측정 정밀도가 크게 향상될 수 있어 생명과학 연구 전반과 뇌 질환 치료제 개발에 폭넓게 활용될 수 있을 것으로 기대된다.

윤 교수는 “이 기술이 다양한 뇌과학, 생명과학 연구에 도움이 되길 바라는 마음을 담아 ‘서포트(SUPPORT, Statistically Unbiased Prediction utilizing sPatiOtempoRal information in imaging daTa)라는 이름을 붙였다”며, “다양한 형광 이미징 장비를 활용하는 연구자들이 별도의 학습 데이터 없이도 쉽게 활용가능한 기술로, 새로운 생명현상 규명에 폭넓게 활용될 수 있을 것”이라고 말했다.

공동 제1 저자인 엄민호 연구원은 "서포트(SUPPORT) 기술을 통해 관측이 어려웠던 생체 신호의 빠른 변화를 정밀하게 측정하는 것에 성공하였고, 특히 밀리초 단위로 변하는 신경세포의 활동전위를 광학적으로 정밀하게 측정할 수 있어 뇌과학 연구에 매우 유용할 것이다”라고 하였으며, 공동 제1 저자인 한승재 연구원은 “서포트 기술은 형광현미경 영상 내 생체 신호의 정밀 측정을 위해 개발됐지만, 일반적인 타임랩스 영상의 품질을 높이기 위해서도 폭넓게 활용가능하다”라고 말했다.

이 기술은 전기및전자공학부 윤영규 교수팀의 주도하에 신소재공학과 장재범 교수, 의과학대학원 김필한 교수, 충남대학교, 서울대학교, 하버드대학(Harvard University), 보스턴대학(Boston University), 앨런 연구소(Allen Institute), 웨스트레이크대학(Westlake University) 연구진들과 다국적, 다학제간 협력을 통해서 개발됐다.

이번 연구는 한국연구재단의 지원을 받아 수행됐으며 국제 학술지 `네이처 메소드(Nature Methods)'에 9월 19일 자로 온라인 게재되었으며 10월호 표지 논문으로 선정됐다. (논문명 : Statistically unbiased prediction enables accurate denoising of voltage imaging data)

2023.09.20 조회수 6101 -

인공지능으로 파킨슨병 맞춤형 치료 가능

파킨슨병 같은 만성 퇴행성 뇌 질환의 경우, 생존 환자의 뇌세포에 직접 접근이 제한적이기 때문에, 뇌 질환 환자의 세포 데이터를 토대로 환자 질병의 메커니즘 하위 유형을 인공지능으로 예측하는 것은 시도된 바가 없다.

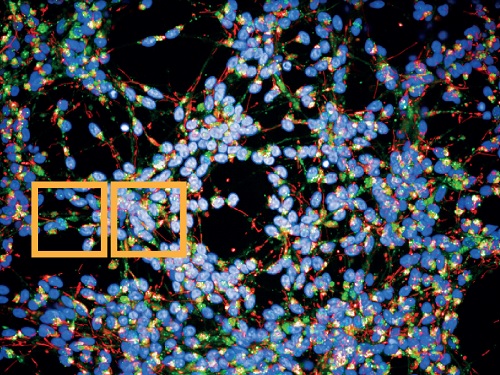

우리 대학 뇌인지과학과 최민이 교수 연구팀이 영국 프랜시스 크릭 연구소(Francis Crick Institute)와의 공동 연구로 파킨슨병 환자의 개인별 질병 하위 유형을 예측하는 인공지능 기반의 플랫폼을 개발했다고 15일 밝혔다.

최민이 교수 연구팀이 개발한 플랫폼은 파킨슨병 환자의 역분화 만능 줄기세포(hiPSC)에서 분화된 신경 세포의 핵, 미토콘드리아, 리보솜 이미지 정보만 학습해 파킨슨 환자의 병리적 하위 유형을 정확하게 예측한다.

이 기술을 활용하면 환자별로 다르게 나타나는 파킨슨병 양상을 겉으로 보이는 발현형이 아닌 생물학적 메커니즘별로 분류할 수 있다. 이를 통해 원인 미상의 파킨슨병 환자가 속한 분자 세포적 하위 유형별로 진단이 가능해져 환자 맞춤형 치료의 길을 열 수 있다. 또 이 플랫폼은 고속의 대량 스크리닝 시스템을 사용하기 때문에 병리적 하위 유형에 적합한 맞춤형 약물 개발 파이프라인으로도 활용될 수 있다.

지금까지 파킨슨병의 치료는 환자 개별의 병리 상태를 고려하지 않고 확률에 기댄 ‘일률적 접근’ 방식을 사용해 왔다. 이러한 접근 방식은 병리적 원인과 치료 방법 사이의 불일치로 인해 치료 효과를 향상하기 어려웠다.

최민이 교수 연구팀이 개발한 플랫폼을 사용하면 개별 환자 뇌세포의 분자 및 세포 정보를 정밀하게 프로파일링할 수 있다. 이를 토대로 환자들의 질병 하위 유형을 정확히 진단할 수 있어서 궁극적으로 ‘정밀 의학 (Precise medicine)’이 가능해진다. 이는 각 개인에게 맞춤화된 치료 (Personalized medicine)로 이어져 치료 효과를 크게 향상할 수 있을 것으로 기대된다.

이 플랫폼은 2012년 노벨의학상 수상 기술인 유도만능줄기세포(iPSC: 성인 피부세포나 혈액에서 얻은 체세포를 태아기의 미분화 상태로 리프로그래밍한 세포. 어떤 장기 세포로도 분화가 가능)를 분화시켜 얻은 뇌세포를 사용하는 ‘접시 속 질병(disease in a dish)’ 패러다임이다. 이는 퇴행성 뇌 질환처럼 병변을 직접 얻을 수 없거나, 인간의 뇌를 정확하게 모사할 수 없는 동물 모델의 한계점을 극복할 수 있는 기술 중 하나로 주목받고 있다. 특히, 접시 속에 배양한 자신의 표적 질병 세포를 순차적으로 이미징하면 일련의 병리적 사건을 추적할 수 있어 질병 진행에 따른 약물 반응 결과를 예측할 수 있다는 이점이 있다.

교신 저자인 최민이 교수는 "이번 연구는 실험실에서 얻은 생물학적 데이터를 인공지능에 효과적으로 학습시켜, 정확도가 높은 질병 하위 유형 분류 모델을 생성하는 방법을 구체적으로 소개했다”며, "이 플랫폼은 자폐 스펙트럼과 같이 환자 개인별 증상이 뚜렷하게 다른 뇌 질환의 하위 유형을 분류하는 데에도 유용할 것이며, 이를 통해 효과적인 치료법 개발도 가능해질 것이다”라고 연구의 의의를 설명했다.

이번 논문은 영국 Medical Research Council (MRC)와 대교-KAIST 인지 향상 연구센터의 지원으로 수행됐으며, 국제 학술지 ‘네이처 머신 인텔리젼스 (Nature Machine Intelligence, IF = 25.8) 8월호에 출판됐다 (논문명: Prediction of mechanistic subtypes of Parkinson’s using patient-derived stem cell model)

2023.08.16 조회수 9388

인공지능으로 파킨슨병 맞춤형 치료 가능

파킨슨병 같은 만성 퇴행성 뇌 질환의 경우, 생존 환자의 뇌세포에 직접 접근이 제한적이기 때문에, 뇌 질환 환자의 세포 데이터를 토대로 환자 질병의 메커니즘 하위 유형을 인공지능으로 예측하는 것은 시도된 바가 없다.

우리 대학 뇌인지과학과 최민이 교수 연구팀이 영국 프랜시스 크릭 연구소(Francis Crick Institute)와의 공동 연구로 파킨슨병 환자의 개인별 질병 하위 유형을 예측하는 인공지능 기반의 플랫폼을 개발했다고 15일 밝혔다.

최민이 교수 연구팀이 개발한 플랫폼은 파킨슨병 환자의 역분화 만능 줄기세포(hiPSC)에서 분화된 신경 세포의 핵, 미토콘드리아, 리보솜 이미지 정보만 학습해 파킨슨 환자의 병리적 하위 유형을 정확하게 예측한다.

이 기술을 활용하면 환자별로 다르게 나타나는 파킨슨병 양상을 겉으로 보이는 발현형이 아닌 생물학적 메커니즘별로 분류할 수 있다. 이를 통해 원인 미상의 파킨슨병 환자가 속한 분자 세포적 하위 유형별로 진단이 가능해져 환자 맞춤형 치료의 길을 열 수 있다. 또 이 플랫폼은 고속의 대량 스크리닝 시스템을 사용하기 때문에 병리적 하위 유형에 적합한 맞춤형 약물 개발 파이프라인으로도 활용될 수 있다.

지금까지 파킨슨병의 치료는 환자 개별의 병리 상태를 고려하지 않고 확률에 기댄 ‘일률적 접근’ 방식을 사용해 왔다. 이러한 접근 방식은 병리적 원인과 치료 방법 사이의 불일치로 인해 치료 효과를 향상하기 어려웠다.

최민이 교수 연구팀이 개발한 플랫폼을 사용하면 개별 환자 뇌세포의 분자 및 세포 정보를 정밀하게 프로파일링할 수 있다. 이를 토대로 환자들의 질병 하위 유형을 정확히 진단할 수 있어서 궁극적으로 ‘정밀 의학 (Precise medicine)’이 가능해진다. 이는 각 개인에게 맞춤화된 치료 (Personalized medicine)로 이어져 치료 효과를 크게 향상할 수 있을 것으로 기대된다.

이 플랫폼은 2012년 노벨의학상 수상 기술인 유도만능줄기세포(iPSC: 성인 피부세포나 혈액에서 얻은 체세포를 태아기의 미분화 상태로 리프로그래밍한 세포. 어떤 장기 세포로도 분화가 가능)를 분화시켜 얻은 뇌세포를 사용하는 ‘접시 속 질병(disease in a dish)’ 패러다임이다. 이는 퇴행성 뇌 질환처럼 병변을 직접 얻을 수 없거나, 인간의 뇌를 정확하게 모사할 수 없는 동물 모델의 한계점을 극복할 수 있는 기술 중 하나로 주목받고 있다. 특히, 접시 속에 배양한 자신의 표적 질병 세포를 순차적으로 이미징하면 일련의 병리적 사건을 추적할 수 있어 질병 진행에 따른 약물 반응 결과를 예측할 수 있다는 이점이 있다.

교신 저자인 최민이 교수는 "이번 연구는 실험실에서 얻은 생물학적 데이터를 인공지능에 효과적으로 학습시켜, 정확도가 높은 질병 하위 유형 분류 모델을 생성하는 방법을 구체적으로 소개했다”며, "이 플랫폼은 자폐 스펙트럼과 같이 환자 개인별 증상이 뚜렷하게 다른 뇌 질환의 하위 유형을 분류하는 데에도 유용할 것이며, 이를 통해 효과적인 치료법 개발도 가능해질 것이다”라고 연구의 의의를 설명했다.

이번 논문은 영국 Medical Research Council (MRC)와 대교-KAIST 인지 향상 연구센터의 지원으로 수행됐으며, 국제 학술지 ‘네이처 머신 인텔리젼스 (Nature Machine Intelligence, IF = 25.8) 8월호에 출판됐다 (논문명: Prediction of mechanistic subtypes of Parkinson’s using patient-derived stem cell model)

2023.08.16 조회수 9388 -

뇌의 선천적 수량 비교 원리 규명

뇌의 선천적 인지 기능들은 학습이나 훈련 없이 신경망의 구조적 특성으로부터 자발적으로 발생할 수 있는 것인가?

우리 대학 뇌인지과학과 백세범 교수 연구팀이 두뇌에서 발견되는 선천적 수량 비교 능력이 자발적으로 형성되는 원리를 설명했다고 7일 밝혔다.

주어진 사물들의 수량을 비교하는 기능은 동물이나 인간의 생존에 필수적인 능력이다. 동물 그룹 간 다툼, 사냥, 먹이 수집 등 많은 상황에서 주어진 변수들의 수량 비율이나 차이에 따라 동물들의 의사결정 및 행동이 달라져야 하기 때문이다. 학습을 거치지 않은 어린 개체들의 행동 관찰로부터 수량 비교 능력은 두뇌의 선천적 기능이라는 가능성이 제기됐지만 이러한 능력이 학습 없이 발생하는 원리에 대한 설명은 아직 제시되지 않았다.

백세범 교수 연구팀은 두뇌 모사 인공신경망 모델을 활용해, 학습이 전혀 이뤄지지 않은 심층신경망 구조에서 시각적 수량 비율 및 차이 정보의 인지 기능이 자발적으로 발생할 수 있음을 증명했다. 또한 두 수량의 비율과 차이라는 서로 다른 종류의 정보를 비교하는 기능이 하나의 공통적인 발생 원리로부터 파생될 수 있다고 설명했다.

우리 대학 바이오및뇌공학과 이현수 박사과정, NYU 신경과학과 최우철 박사가 공동 제1 저자로 참여한 이번 연구는 국제 학술지 ‘셀(Cell)’의 온라인 자매지 ‘셀 리포츠(Cell Reports)’ 7월 29일 자에 게재됐다. (논문명: Comparison of visual quantities in untrained neural networks)

연구팀은 먼저 전혀 학습을 거치지 않은 신경망에서 두 수량의 비율과 차이에 선택적으로 반응하는 개별 신경세포가 자발적으로 발생하는 것을 발견했다. 초기화된 심층신경망에서 다양한 비율 혹은 차이를 가지는 시각적 수량 정보가 주어졌을 때, 이에 선택적으로 반응하는 신경세포들이 다수 발견되며, 이들로부터 측정된 신경 활동은 실제 동물 실험에서 관측된 신경 활동 특성과 매우 유사함을 확인하였다. 또한 연구팀은 이를 이용하여 지금까지 보고되어 온 동물들의 수량 비교 행동 특성을 상당 부분 재현할 수 있음을 확인했다.

이에 더해, 연구팀은 수량 비교 기능 신경세포 회로 구조의 발생 원리를 계산신경과학적 모델을 통해 설명하고 검증했다. 신경망에서 발견된 비율/차이 선택적 신경세포의 특징적 연결구조를 분석해, 특정 값에 대한 선택성이 신경망 하위 계층에서 자발적으로 발생된 단순 증가, 단순 감소 신경 활동의 결합을 통해 형성될 수 있음을 보였다. 또한 이러한 신경 활동이 증가, 감소할 때 관찰되는 비선형성의 타입에 따라 각각 수량 비율 또는 수량 차이를 인지하는 신경세포로 분화될 수 있음을 연구팀은 확인했다.

이러한 결과들을 통해 연구팀은 학습이 전혀 이뤄지지 않은 두뇌에서 비율/차이 인지와 같은 선천적 수량 비교 기능이 발생하는 원리에 대한 근본적인 이해를 제시했다.

백세범 교수는 “이번 연구는 상당한 정도의 학습 과정이 필요할 것이라 여겨지던 두뇌의 수량 인지 및 비교, 연산 기능이 그 어떤 학습도 이뤄지지 않은 초기 두뇌의 구조에서 자발적으로 발생할 수 있음을 보이는 연구”라며, “발생 초기 신경망의 구조적/물리적 특성으로부터 다양한 선천적 고등 인지 기능이 발생할 수 있음을 시사함으로써 뇌신경과학 연구뿐 아니라 새로운 개념의 인공지능 연구에도 의미있는 방향을 제시할 수 있을 것이라 기대한다”고 언급했다.

한편 이번 연구는 한국연구재단의 이공분야기초연구사업 및 원천기술개발사업, KAIST 특이점교수 사업의 지원을 받아 수행됐다.

2023.08.07 조회수 7074

뇌의 선천적 수량 비교 원리 규명

뇌의 선천적 인지 기능들은 학습이나 훈련 없이 신경망의 구조적 특성으로부터 자발적으로 발생할 수 있는 것인가?

우리 대학 뇌인지과학과 백세범 교수 연구팀이 두뇌에서 발견되는 선천적 수량 비교 능력이 자발적으로 형성되는 원리를 설명했다고 7일 밝혔다.

주어진 사물들의 수량을 비교하는 기능은 동물이나 인간의 생존에 필수적인 능력이다. 동물 그룹 간 다툼, 사냥, 먹이 수집 등 많은 상황에서 주어진 변수들의 수량 비율이나 차이에 따라 동물들의 의사결정 및 행동이 달라져야 하기 때문이다. 학습을 거치지 않은 어린 개체들의 행동 관찰로부터 수량 비교 능력은 두뇌의 선천적 기능이라는 가능성이 제기됐지만 이러한 능력이 학습 없이 발생하는 원리에 대한 설명은 아직 제시되지 않았다.

백세범 교수 연구팀은 두뇌 모사 인공신경망 모델을 활용해, 학습이 전혀 이뤄지지 않은 심층신경망 구조에서 시각적 수량 비율 및 차이 정보의 인지 기능이 자발적으로 발생할 수 있음을 증명했다. 또한 두 수량의 비율과 차이라는 서로 다른 종류의 정보를 비교하는 기능이 하나의 공통적인 발생 원리로부터 파생될 수 있다고 설명했다.

우리 대학 바이오및뇌공학과 이현수 박사과정, NYU 신경과학과 최우철 박사가 공동 제1 저자로 참여한 이번 연구는 국제 학술지 ‘셀(Cell)’의 온라인 자매지 ‘셀 리포츠(Cell Reports)’ 7월 29일 자에 게재됐다. (논문명: Comparison of visual quantities in untrained neural networks)

연구팀은 먼저 전혀 학습을 거치지 않은 신경망에서 두 수량의 비율과 차이에 선택적으로 반응하는 개별 신경세포가 자발적으로 발생하는 것을 발견했다. 초기화된 심층신경망에서 다양한 비율 혹은 차이를 가지는 시각적 수량 정보가 주어졌을 때, 이에 선택적으로 반응하는 신경세포들이 다수 발견되며, 이들로부터 측정된 신경 활동은 실제 동물 실험에서 관측된 신경 활동 특성과 매우 유사함을 확인하였다. 또한 연구팀은 이를 이용하여 지금까지 보고되어 온 동물들의 수량 비교 행동 특성을 상당 부분 재현할 수 있음을 확인했다.

이에 더해, 연구팀은 수량 비교 기능 신경세포 회로 구조의 발생 원리를 계산신경과학적 모델을 통해 설명하고 검증했다. 신경망에서 발견된 비율/차이 선택적 신경세포의 특징적 연결구조를 분석해, 특정 값에 대한 선택성이 신경망 하위 계층에서 자발적으로 발생된 단순 증가, 단순 감소 신경 활동의 결합을 통해 형성될 수 있음을 보였다. 또한 이러한 신경 활동이 증가, 감소할 때 관찰되는 비선형성의 타입에 따라 각각 수량 비율 또는 수량 차이를 인지하는 신경세포로 분화될 수 있음을 연구팀은 확인했다.

이러한 결과들을 통해 연구팀은 학습이 전혀 이뤄지지 않은 두뇌에서 비율/차이 인지와 같은 선천적 수량 비교 기능이 발생하는 원리에 대한 근본적인 이해를 제시했다.

백세범 교수는 “이번 연구는 상당한 정도의 학습 과정이 필요할 것이라 여겨지던 두뇌의 수량 인지 및 비교, 연산 기능이 그 어떤 학습도 이뤄지지 않은 초기 두뇌의 구조에서 자발적으로 발생할 수 있음을 보이는 연구”라며, “발생 초기 신경망의 구조적/물리적 특성으로부터 다양한 선천적 고등 인지 기능이 발생할 수 있음을 시사함으로써 뇌신경과학 연구뿐 아니라 새로운 개념의 인공지능 연구에도 의미있는 방향을 제시할 수 있을 것이라 기대한다”고 언급했다.

한편 이번 연구는 한국연구재단의 이공분야기초연구사업 및 원천기술개발사업, KAIST 특이점교수 사업의 지원을 받아 수행됐다.

2023.08.07 조회수 7074