%EC%9D%B8%EA%B3%B5%EC%A7%80%EB%8A%A5

-

KAIST, 인공지능 반도체 생태계를 선도하다

인공지능 반도체(이하 AI 반도체)가 국가적인 전략기술로 두드러지면서 KAIST의 관련 성과도 주목받고 있다. 과학기술정보통신부는 지난해 2030년 세계 AI 반도체 시장 20% 점유를 목표로 인공지능 반도체 지원사업에 본격적으로 착수한 바 있다. 올해에는 산학연 논의를 거쳐 5년간 1조 200억 원을 투입하는 `인공지능 반도체 산업 성장 지원대책'으로 지원을 확대했다. 이에 따라 AI 반도체 전문가 양성을 위해 주요 대학들의 행보도 분주해졌다.

KAIST는 반도체와 인공지능 양대 핵심 분야에서 최상급의 교육, 연구 역량을 쌓아 왔다. 반도체 분야에서는 지난 17년 동안 메사추세츠 공과대학(이하 MIT), 스탠퍼드(Stanford)와 같은 세계적인 학교를 제치고 국제반도체회로학회(이하 ISSCC, International Solid State Circuit Conference)에서 대학 중 1위를 지켜 왔다는 점이 돋보인다. ISSCC는 1954년 설립된 반도체 집적회로 설계 분야 세계 최고 권위 학회다. 참가자 중 60% 이상이 삼성, 퀄컴, TSMC, 인텔을 비롯한 산업계 소속일만큼 산업적인 실용성을 중시해서 `반도체 설계 올림픽'이라는 별명도 있다.

KAIST는 ISSCC에서 채택 논문 수 기준 매년 전 세계 대학교 중 1~2위를 유지했다. 최근 17년간 평균 채택 논문 수를 살펴보면 압도적인 선두다. 해당 기간 채택된 KAIST의 논문은 평균 8.4편으로, 경쟁자인 MIT(4.6편)와 캘리포니아대학교 로스앤젤레스(UCLA)(3.6편)에 비해 두 배 가까운 성과다. 국내에서는 반도체 설계 분야 부동의 1위인 삼성에 이어 종합 2위 자리를 유지하고 있다. 그럴 뿐만 아니라 ISSCC와 쌍벽을 이루는 집적회로 분야 학술대회인 초고밀도집적회로학회에서도 KAIST는 2022년 전 세계 대학 중 1위를 기록했다.

KAIST의 연구진들이 반도체 산업 핵심 분야 전반에서 신기술을 발표해 연구의 질적인 수준도 높다. 전기및전자공학부 정명수 교수 연구팀은 고성능 저전력을 추구하는 현재 업계의 수요에 대응해 전력 공급 없이도 동작을 유지하는 컴퓨터를 개발했다. 소재 분야에서는 신소재공학과의 박병국 교수 연구팀이 기존의 메모리에 비해 동작 속도가 10배 이상 빠른 `스핀궤도토크 자성메모리' 소자를 개발해서 기존 `폰노이만 구조'의 한계를 극복하는 방안을 제시하기도 했다.

이처럼 현재 반도체 산업의 주요 과제에 솔루션을 제공하는 한편으로 미래의 새로운 반도체 분야를 선점하는 데 필요한 신기술 개발도 활발하다. 암호 및 비선형 연산 분야에서 차세대 컴퓨팅으로 주목받는 양자컴퓨팅 분야에서는 전기및전자공학부 김상현 교수 연구팀이 3차원 집적 기술을 세계 최초로 선보였다. 신경계의 원리를 활용해 인공지능 분야에서 발군의 성능을 보일 것으로 기대되는 뉴로모픽 컴퓨팅에서는 전기및전자공학부 최신현 교수 연구팀이 신경세포를 모사하는 차세대 멤리스터를 개발 중이다.

인공지능 분야에서도 비약적으로 성장했다. 인공지능 분야의 양대 세계 최고 권위 학회인 국제머신러닝학회(ICML)과 인공신경망학회(NeurIPS) 논문 수 기준으로 KAIST는 2020년 세계 6위, 아시아에서는 1위를 기록했다. KAIST의 순위는 2012년부터 꾸준히 우상향 그래프를 그려 8년만에 37위에서 6위로, 무려 31계단이나 도약했다. 2021년에는 인공지능 분야 톱 학회 11개에 발표된 한국 논문 중 약 40%에 달하는 129편이 KAIST에서 나왔다. KAIST의 이러한 활약에 힘입어 2021년 한국은 글로벌 인공지능 톱 학회 등재 논문 수 기준으로 미국, 중국, 영국, 캐나다, 독일에 이어 6위에 올랐다.

내용 면에서도 KAIST의 인공지능 연구는 최전선에 있다. 전기및전자공학부 유회준 교수 연구팀은 모바일기기에서 인공지능 실시간 학습을 구현해 에지 네트워크의 단점을 보완했다. 인공지능을 구현하려면 데이터 축적관 막대한 양의 연산이 필요한데, 이를 위해 고성능 서버가 방대한 연산을 담당하고 사용자 단말은 데이터 수집과 간단한 연산만 하는 `에지 네트워크'가 사용된다. 유 교수의 연구는 사용자 단말에 학습 능력을 부여함으로써 인공지능의 처리 속도와 성능을 크게 높일 수 있다.

지난 6월에는 전산학부 김민수 교수 연구팀이 초대규모 인공지능 모델 처리에 꼭 필요한 솔루션을 제시했다. 연구팀이 개발한 초대규모 기계학습 시스템은 현재 업계에서 주로 사용되는 구글의 텐서플로우(Tensorflow)나 IBM의 시스템DS 대비 최대 8.8배나 빠른 속도를 달성할 수 있을 것으로 기대된다.

KAIST는 반도체와 인공지능이 결합된 AI 반도체 분야에서도 주목할만한 성과를 내고 있다. 2020년 전기및전자공학부 유민수 교수 연구팀은 세계 최초로 추천시스템에 최적화된 AI 반도체를 개발하는 데 성공했다. 인공지능 추천시스템은 방대한 콘텐츠와 사용자 정보를 다룬다는 특성상 범용 인공지능 시스템으로 운영하면 병목현상으로 성능에 한계가 있다. 유민수 교수팀은 `프로세싱-인-메모리(이하 PIM, Processing-In-Memory)' 기술을 기반으로 기존 시스템 대비 최대 21배 빠른 속도를 낼 수 있는 반도체를 개발했다. PIM은 처리할 데이터를 임시로 저장하기만 하던 `램'에서 연산까지 수행해 효율을 높이는 기술이다. PIM 기술이 본격적으로 상용화되면 메모리 분야에서 강세인 한국 기업의 AI 반도체 시장 경쟁력이 비약적으로 높아질 것으로 기대된다.

KAIST는 그간의 성과에 안주하지 않고 인공지능 및 반도체, 그리고 AI 반도체 분야 초격차를 유지하고자 다각적인 노력을 기울이고 있다. 1990년 국내 최초로 인공지능연구센터를 설립한 데 이어 2019년에는 김재철AI대학원을 개설해 전문인력을 양성 중이다. 2020년에는 인공지능과 반도체 연구를 융합해 ITRC 인공지능반도체시스템 연구센터가 출범했으며, 2021년에는 인공지능을 다양한 분야에 접목하는 `AI+X' 연구를 활성화하고자 김재철AI대학원과 별도로 AI 연구원을 설립했다.

KAIST는 이러한 노력으로 축적된 내적 역량을 바탕으로 네이버 등 기업과 공동연구센터를 설립하는 한편, 화성시와 같은 지자체와 협력해 동시다발적인 전문인력 양성에 나섰다. 지난 2021년에는 삼성전자와 함께 반도체시스템공학과 설립 협약을 체결하고 새로운 반도체 전문인력 교육과정을 준비하고 있다. 새로 설립되는 반도체시스템공학과는 2023년부터 매년 100명 내외의 신입생을 선발하고, 이들이 전문역량을 꽃피울 수 있도록 학생 전원에게 특별장학금을 지급할 예정이다. 또한 산업계와의 긴밀한 협력을 통해 삼성전자 견학과 인턴십, 공동 워크숍을 지원해 현장에 밀착한 교육을 제공할 예정이다.

KAIST는 국내 반도체 분야 박사 인력의 25%, 박사 출신 중견 및 벤처기업 CEO의 20%를 배출하며 한국 반도체 산업 생태계가 성장하는 데 중대한 공헌을 했다. 본격적으로 열린 AI 반도체 경쟁 체제를 앞두고 KAIST가 다시 산업 생태계의 구심점 역할을 할지 귀추가 주목된다.

2022.08.04 조회수 18826

KAIST, 인공지능 반도체 생태계를 선도하다

인공지능 반도체(이하 AI 반도체)가 국가적인 전략기술로 두드러지면서 KAIST의 관련 성과도 주목받고 있다. 과학기술정보통신부는 지난해 2030년 세계 AI 반도체 시장 20% 점유를 목표로 인공지능 반도체 지원사업에 본격적으로 착수한 바 있다. 올해에는 산학연 논의를 거쳐 5년간 1조 200억 원을 투입하는 `인공지능 반도체 산업 성장 지원대책'으로 지원을 확대했다. 이에 따라 AI 반도체 전문가 양성을 위해 주요 대학들의 행보도 분주해졌다.

KAIST는 반도체와 인공지능 양대 핵심 분야에서 최상급의 교육, 연구 역량을 쌓아 왔다. 반도체 분야에서는 지난 17년 동안 메사추세츠 공과대학(이하 MIT), 스탠퍼드(Stanford)와 같은 세계적인 학교를 제치고 국제반도체회로학회(이하 ISSCC, International Solid State Circuit Conference)에서 대학 중 1위를 지켜 왔다는 점이 돋보인다. ISSCC는 1954년 설립된 반도체 집적회로 설계 분야 세계 최고 권위 학회다. 참가자 중 60% 이상이 삼성, 퀄컴, TSMC, 인텔을 비롯한 산업계 소속일만큼 산업적인 실용성을 중시해서 `반도체 설계 올림픽'이라는 별명도 있다.

KAIST는 ISSCC에서 채택 논문 수 기준 매년 전 세계 대학교 중 1~2위를 유지했다. 최근 17년간 평균 채택 논문 수를 살펴보면 압도적인 선두다. 해당 기간 채택된 KAIST의 논문은 평균 8.4편으로, 경쟁자인 MIT(4.6편)와 캘리포니아대학교 로스앤젤레스(UCLA)(3.6편)에 비해 두 배 가까운 성과다. 국내에서는 반도체 설계 분야 부동의 1위인 삼성에 이어 종합 2위 자리를 유지하고 있다. 그럴 뿐만 아니라 ISSCC와 쌍벽을 이루는 집적회로 분야 학술대회인 초고밀도집적회로학회에서도 KAIST는 2022년 전 세계 대학 중 1위를 기록했다.

KAIST의 연구진들이 반도체 산업 핵심 분야 전반에서 신기술을 발표해 연구의 질적인 수준도 높다. 전기및전자공학부 정명수 교수 연구팀은 고성능 저전력을 추구하는 현재 업계의 수요에 대응해 전력 공급 없이도 동작을 유지하는 컴퓨터를 개발했다. 소재 분야에서는 신소재공학과의 박병국 교수 연구팀이 기존의 메모리에 비해 동작 속도가 10배 이상 빠른 `스핀궤도토크 자성메모리' 소자를 개발해서 기존 `폰노이만 구조'의 한계를 극복하는 방안을 제시하기도 했다.

이처럼 현재 반도체 산업의 주요 과제에 솔루션을 제공하는 한편으로 미래의 새로운 반도체 분야를 선점하는 데 필요한 신기술 개발도 활발하다. 암호 및 비선형 연산 분야에서 차세대 컴퓨팅으로 주목받는 양자컴퓨팅 분야에서는 전기및전자공학부 김상현 교수 연구팀이 3차원 집적 기술을 세계 최초로 선보였다. 신경계의 원리를 활용해 인공지능 분야에서 발군의 성능을 보일 것으로 기대되는 뉴로모픽 컴퓨팅에서는 전기및전자공학부 최신현 교수 연구팀이 신경세포를 모사하는 차세대 멤리스터를 개발 중이다.

인공지능 분야에서도 비약적으로 성장했다. 인공지능 분야의 양대 세계 최고 권위 학회인 국제머신러닝학회(ICML)과 인공신경망학회(NeurIPS) 논문 수 기준으로 KAIST는 2020년 세계 6위, 아시아에서는 1위를 기록했다. KAIST의 순위는 2012년부터 꾸준히 우상향 그래프를 그려 8년만에 37위에서 6위로, 무려 31계단이나 도약했다. 2021년에는 인공지능 분야 톱 학회 11개에 발표된 한국 논문 중 약 40%에 달하는 129편이 KAIST에서 나왔다. KAIST의 이러한 활약에 힘입어 2021년 한국은 글로벌 인공지능 톱 학회 등재 논문 수 기준으로 미국, 중국, 영국, 캐나다, 독일에 이어 6위에 올랐다.

내용 면에서도 KAIST의 인공지능 연구는 최전선에 있다. 전기및전자공학부 유회준 교수 연구팀은 모바일기기에서 인공지능 실시간 학습을 구현해 에지 네트워크의 단점을 보완했다. 인공지능을 구현하려면 데이터 축적관 막대한 양의 연산이 필요한데, 이를 위해 고성능 서버가 방대한 연산을 담당하고 사용자 단말은 데이터 수집과 간단한 연산만 하는 `에지 네트워크'가 사용된다. 유 교수의 연구는 사용자 단말에 학습 능력을 부여함으로써 인공지능의 처리 속도와 성능을 크게 높일 수 있다.

지난 6월에는 전산학부 김민수 교수 연구팀이 초대규모 인공지능 모델 처리에 꼭 필요한 솔루션을 제시했다. 연구팀이 개발한 초대규모 기계학습 시스템은 현재 업계에서 주로 사용되는 구글의 텐서플로우(Tensorflow)나 IBM의 시스템DS 대비 최대 8.8배나 빠른 속도를 달성할 수 있을 것으로 기대된다.

KAIST는 반도체와 인공지능이 결합된 AI 반도체 분야에서도 주목할만한 성과를 내고 있다. 2020년 전기및전자공학부 유민수 교수 연구팀은 세계 최초로 추천시스템에 최적화된 AI 반도체를 개발하는 데 성공했다. 인공지능 추천시스템은 방대한 콘텐츠와 사용자 정보를 다룬다는 특성상 범용 인공지능 시스템으로 운영하면 병목현상으로 성능에 한계가 있다. 유민수 교수팀은 `프로세싱-인-메모리(이하 PIM, Processing-In-Memory)' 기술을 기반으로 기존 시스템 대비 최대 21배 빠른 속도를 낼 수 있는 반도체를 개발했다. PIM은 처리할 데이터를 임시로 저장하기만 하던 `램'에서 연산까지 수행해 효율을 높이는 기술이다. PIM 기술이 본격적으로 상용화되면 메모리 분야에서 강세인 한국 기업의 AI 반도체 시장 경쟁력이 비약적으로 높아질 것으로 기대된다.

KAIST는 그간의 성과에 안주하지 않고 인공지능 및 반도체, 그리고 AI 반도체 분야 초격차를 유지하고자 다각적인 노력을 기울이고 있다. 1990년 국내 최초로 인공지능연구센터를 설립한 데 이어 2019년에는 김재철AI대학원을 개설해 전문인력을 양성 중이다. 2020년에는 인공지능과 반도체 연구를 융합해 ITRC 인공지능반도체시스템 연구센터가 출범했으며, 2021년에는 인공지능을 다양한 분야에 접목하는 `AI+X' 연구를 활성화하고자 김재철AI대학원과 별도로 AI 연구원을 설립했다.

KAIST는 이러한 노력으로 축적된 내적 역량을 바탕으로 네이버 등 기업과 공동연구센터를 설립하는 한편, 화성시와 같은 지자체와 협력해 동시다발적인 전문인력 양성에 나섰다. 지난 2021년에는 삼성전자와 함께 반도체시스템공학과 설립 협약을 체결하고 새로운 반도체 전문인력 교육과정을 준비하고 있다. 새로 설립되는 반도체시스템공학과는 2023년부터 매년 100명 내외의 신입생을 선발하고, 이들이 전문역량을 꽃피울 수 있도록 학생 전원에게 특별장학금을 지급할 예정이다. 또한 산업계와의 긴밀한 협력을 통해 삼성전자 견학과 인턴십, 공동 워크숍을 지원해 현장에 밀착한 교육을 제공할 예정이다.

KAIST는 국내 반도체 분야 박사 인력의 25%, 박사 출신 중견 및 벤처기업 CEO의 20%를 배출하며 한국 반도체 산업 생태계가 성장하는 데 중대한 공헌을 했다. 본격적으로 열린 AI 반도체 경쟁 체제를 앞두고 KAIST가 다시 산업 생태계의 구심점 역할을 할지 귀추가 주목된다.

2022.08.04 조회수 18826 -

스마트폰 위 인공지능(AI) 연합학습 속도 4.5배 획기적 향상기법 개발

우리 대학 전기및전자공학부 이성주 교수 연구팀이 국제공동연구를 통해 다수의 모바일 기기 위에서 인공지능(AI) 모델을 학습할 수 있는 연합학습 기술의 학습 속도를 4.5배 가속할 수 있는 방법론을 개발했다고 2일 밝혔다.

이성주 교수 연구팀은 지난 6/27~7/1에 열린 세계컴퓨터연합회(ACM) 주최로 진행된 제20회 모바일 시스템, 어플리케이션, 및 서비스 국제학술대회(MobiSys, International Conference on Mobile Systems, Applications, and Services)에서 연합학습(Federated Learning)의 학습 속도 향상(4.5배 가속)을 위한 데이터 샘플 최적 선택 및 데드라인 조절 방법론을 발표했다. 이 학회는 2003년에 시작됐으며 모바일 시스템, 소프트웨어, 어플리케이션, 서비스를 위한 최신 연구를 소개하는 데 초점을 맞추고 있으며, 모바일 컴퓨팅 및 시스템 분야의 최우수 학회 중 하나로 오랫동안 주목받고 있다.

이번 논문(FedBalancer: Data and Pace Control for Efficient Federated Learning on Heterogeneous Clients)은 KAIST 전산학부 신재민 박사과정이 제1 저자로 참여했으며, 중국 칭화대학과의 국제협력으로 이루어진 성과다 (칭화대학교 위안춘 리(Yuanchun Li) 교수, 윤신 리우(Yunxin Liu) 교수 참여).

최근 구글에 의해 제안된 연합학습은 새로운 기계학습 기술로, 개인정보의 유출 없이 방대한 사용자 기기 위 데이터를 활용할 수 있게 하여 의료 인공지능 기술 등 새로운 인공지능 서비스를 개발할 수 있게 해 각광받고 있다. 연합학습은 구글을 비롯해 애플, 타오바오 등 세계적 빅테크 기업들이 널리 도입하고 있으나, 실제로는 인공지능 모델 학습이 사용자의 스마트폰 위에서 이뤄져, 기기에 과부하를 일으켜 배터리 소모, 성능 저하 등이 발생할 수 있는 우려를 안고 있다.

이성주 교수 연구팀은 연합학습에 참여하는 사용자 기기 위 데이터 샘플 각각의 학습 기여도 측정을 기반으로 최적의 샘플을 선택함으로써 연합학습 속도 향상을 달성했다. 또한, 샘플 선택으로 줄어든 학습 시간에 대응해, 연합학습 라운드의 데드라인 또한 최적으로 조절하는 기법을 제안해 모델 정확도의 저하 없이 학습 속도를 무려 4.5배 높였다. 이러한 방법론의 적용을 통해 연합학습으로 인한 사용자 스마트폰 과부하 문제를 최소화할 수 있을 것으로 기대된다.

이성주 교수는 "연합학습은 많은 세계적 기업들이 사용하는 중요한 기술이다ˮ며 "이번 연구 결과는 연합학습의 학습 속도를 향상하고 활용도를 높여 의미가 있으며, 컴퓨터 비전, 자연어 처리, 모바일 센서 데이터 등 다양한 응용에서 모두 좋은 성능을 보여, 빠른 파급효과를 기대한다ˮ라고 소감을 밝혔다.

한편 이 연구는 과학기술정보통신부의 재원으로 한국연구재단과 정보통신기술진흥센터의 지원을 받아 수행됐다.

2022.08.02 조회수 12764

스마트폰 위 인공지능(AI) 연합학습 속도 4.5배 획기적 향상기법 개발

우리 대학 전기및전자공학부 이성주 교수 연구팀이 국제공동연구를 통해 다수의 모바일 기기 위에서 인공지능(AI) 모델을 학습할 수 있는 연합학습 기술의 학습 속도를 4.5배 가속할 수 있는 방법론을 개발했다고 2일 밝혔다.

이성주 교수 연구팀은 지난 6/27~7/1에 열린 세계컴퓨터연합회(ACM) 주최로 진행된 제20회 모바일 시스템, 어플리케이션, 및 서비스 국제학술대회(MobiSys, International Conference on Mobile Systems, Applications, and Services)에서 연합학습(Federated Learning)의 학습 속도 향상(4.5배 가속)을 위한 데이터 샘플 최적 선택 및 데드라인 조절 방법론을 발표했다. 이 학회는 2003년에 시작됐으며 모바일 시스템, 소프트웨어, 어플리케이션, 서비스를 위한 최신 연구를 소개하는 데 초점을 맞추고 있으며, 모바일 컴퓨팅 및 시스템 분야의 최우수 학회 중 하나로 오랫동안 주목받고 있다.

이번 논문(FedBalancer: Data and Pace Control for Efficient Federated Learning on Heterogeneous Clients)은 KAIST 전산학부 신재민 박사과정이 제1 저자로 참여했으며, 중국 칭화대학과의 국제협력으로 이루어진 성과다 (칭화대학교 위안춘 리(Yuanchun Li) 교수, 윤신 리우(Yunxin Liu) 교수 참여).

최근 구글에 의해 제안된 연합학습은 새로운 기계학습 기술로, 개인정보의 유출 없이 방대한 사용자 기기 위 데이터를 활용할 수 있게 하여 의료 인공지능 기술 등 새로운 인공지능 서비스를 개발할 수 있게 해 각광받고 있다. 연합학습은 구글을 비롯해 애플, 타오바오 등 세계적 빅테크 기업들이 널리 도입하고 있으나, 실제로는 인공지능 모델 학습이 사용자의 스마트폰 위에서 이뤄져, 기기에 과부하를 일으켜 배터리 소모, 성능 저하 등이 발생할 수 있는 우려를 안고 있다.

이성주 교수 연구팀은 연합학습에 참여하는 사용자 기기 위 데이터 샘플 각각의 학습 기여도 측정을 기반으로 최적의 샘플을 선택함으로써 연합학습 속도 향상을 달성했다. 또한, 샘플 선택으로 줄어든 학습 시간에 대응해, 연합학습 라운드의 데드라인 또한 최적으로 조절하는 기법을 제안해 모델 정확도의 저하 없이 학습 속도를 무려 4.5배 높였다. 이러한 방법론의 적용을 통해 연합학습으로 인한 사용자 스마트폰 과부하 문제를 최소화할 수 있을 것으로 기대된다.

이성주 교수는 "연합학습은 많은 세계적 기업들이 사용하는 중요한 기술이다ˮ며 "이번 연구 결과는 연합학습의 학습 속도를 향상하고 활용도를 높여 의미가 있으며, 컴퓨터 비전, 자연어 처리, 모바일 센서 데이터 등 다양한 응용에서 모두 좋은 성능을 보여, 빠른 파급효과를 기대한다ˮ라고 소감을 밝혔다.

한편 이 연구는 과학기술정보통신부의 재원으로 한국연구재단과 정보통신기술진흥센터의 지원을 받아 수행됐다.

2022.08.02 조회수 12764 -

인공지능 및 빅데이터 시대를 이끌어갈 차세대 CXL2.0 메모리 확장 플랫폼 세계 최초 개발

우리 대학 전기및전자공학부 정명수 교수 연구팀(컴퓨터 아키텍처 및 메모리 시스템 연구실)이 대용량 메모리 장치부터 프로세스를 포함한 컴퓨트 익스프레스 링크(CXL) 2.0 기반의 차세대 메모리 확장 플랫폼 ‘다이렉트CXL(이하 DirectCXL)’을 세계 최초로 프로토타입 제작, 운영체제가 실장된 단대단(End-to-End) 시연에 성공했다고 1일 밝혔다.

오늘날 빅데이터 분석, 그래프 분석, 인메모리 데이터베이스 등 대규모 데이터에 기반한 응용처리가 증가함에 따라, 데이터 센터에서는 이를 더 빠르고 효율적으로 처리하기 위해 시스템의 메모리 확장에 많은 투자를 하고 있다.

그러나 우리가 흔히 알고 있는 메모리 확장 방식인 더블 데이터 대역폭(DDR) 인터페이스를 통한 메모리 확장은 추가할 수 있는 메모리 개수의 제한이 있어, 대규모 데이터 기반의 응용을 처리하기에 충분치 않다. 따라서 데이터 센터에서는 CPU와 메모리로 이루어진 메모리 노드들을 따로 구성하고, 응용을 수행하는 호스트의 메모리가 부족하면 네트워크로 연결된 메모리 노드를 자신의 메모리 공간으로 사용하는 원격 데이터 전송 기술(이하 RDMA) 기반의 메모리 확장을 사용한다.

여러 메모리 노드를 사용하는 RDMA 기반의 메모리 확장을 통해 데이터센터는 시스템의 메모리 크기를 늘릴 수 있었지만, 여전히 해결해야 할 문제들이 남아있었다. 우선 RDMA 기반 메모리 확장 시스템에서는 노드 간 데이터 이동 시 불필요한 데이터 복사, 소프트웨어의 개입 그리고 프로토콜 전환으로 인한 지연을 발생시켜 성능 저하가 발생했다. 또한 시스템의 메모리 확장 시 메모리만을 추가할 수 있는 것이 아닌, 메모리와 메모리를 제어할 CPU가 하나의 메모리 노드를 이루어 시스템에 추가되어야 했기 때문에, 추가적인 비용 소모가 발생했다.

최근 컴퓨트 익스프레스 링크(Compute Express Link, 이하 CXL) 프로토콜의 등장으로 많은 메모리 고객사와 제조사가 이러한 문제를 해결할 가능성을 확인하고 있다. CXL은 PCI 익스프레스(PCIe) 인터페이스 기반의 CPU-장치(Device) 간 연결을 위한 프로토콜로, 이를 기반으로 한 장치 연결은 기존보다 높은 성능과 확장성을 지원하는 것이 특징이다.

국내외 유수 기업들이 모여 CXL 인터페이스 표준 규약을 제안하는 CXL 컨소시엄은 지난 2019년 CXL 1.0/1.1을 처음 제안했고, 이후 CXL 2.0을 발표하며 CXL 1.0/1.1에서 하나의 포트당 하나의 지역 메모리 장치만을 연결할 수 있었던 확장성 문제를 스위치 네트워크를 통해 개선, 하나의 포트를 여러 포트로 확장할 수 있도록 했다. 따라서 CXL 1.0/1.1과 달리 CXL 2.0에서는 확장된 포트에 다수의 원격 CXL 메모리 장치를 연결하는 것이 가능해 더 높은 확장성을 지원할 수 있게 됐다.

그러나 CXL 2.0의 높은 확장성에도 불구하고, 아직 CXL 연구의 방향성을 제시해줄 수 있는 시제품 개발 및 연구들이 진행되지 않아, 메모리 업계와 학계에서는 여전히 CXL1.0/1.1을 기반으로 지역 메모리 확장 장치, 시제품 개발 및 연구를 진행하고 있는 실정이다. 따라서 새로운 CXL 2.0을 통한 메모리 확장 연구의 방향성 초석을 제시할 필요성이 커졌다.

정명수 교수 연구팀이 전 세계 최초로 프로토타입한 CXL 2.0 기반 메모리 확장 플랫폼 ‘DirectCXL’은 높은 수준의 메모리 확장성을 제공하며, 빠른 속도로 대규모 데이터 처리를 가능케 한다. 이를 위해 연구팀은 메모리를 확장해 줄 장치인 ‘CXL 메모리 장치’와 호스트 ‘CXL 프로세서 (CPU)’, 여러 호스트를 다수의 CXL 메모리 장치에 연결해주는 ‘CXL 네트워크 스위치’ 그리고 메모리 확장 플랫폼 전반을 제어할 리눅스 운영체제 기반의‘CXL 소프트웨어 모듈’을 개발해 플랫폼을 구성했다.

구성된 ‘DirectCXL’ 플랫폼을 사용한 시스템에서는 확장된 메모리 공간에 직접 접근해 데이터를 CPU의 캐시로 가져와 불필요한 메모리 복사와 소프트웨어의 개입이 없으며, PCIe 인터페이스만을 사용해 프로토콜 전환을 없애 지연시간을 최대한 줄였다. 또한 추가적인 CPU가 필요 없는 CXL 메모리 장치를 CXL 스위치에 연결하는 것만으로 메모리 확장이 가능해 효율적인 시스템의 구성이 가능했다. 국내외 소수 대기업에서 메모리 장치 일부 단품에 대한 구성을 보여준 준 사례는 있지만, CXL 2.0 기반, CPU부터 CXL 스위치, 메모리 장치가 장착된 시스템에서 운영체제를 동작시키고 데이터 센터와 응용을 실행하고 시연한 것은 정명수 교수 연구팀이 처음이다.

연구팀은 자체 제작한 메모리 확장 플랫폼 ‘DirectCXL’의 성능을 검증하기 위해 CXL 동작이 가능한 다수의 자체 개발 호스트 컴퓨터가 CXL 네트워크 스위치를 통해 연결된 다수 CXL 메모리 장치들을 제어하는 환경을 구성했다. 이후 구성된 플랫폼을 통해 CXL 메모리 장치의 성능을 기존 RDMA 기반 메모리 확장 솔루션과 비교했다. 연구팀이 제안한 ‘DirectCXL’은 확장된 메모리에 대한 접근 시간 검증에서 기존 RDMA 기반의 메모리 확장 솔루션 대비 8.3배의 성능 향상을 보였으며, 많은 메모리 접근을 요구하는 그래프 응용처리 및 인 메모리 데이터베이스 응용처리에서도 각각 2.3배, 2배의 성능 향상을 이뤄냈다.

정명수 교수는 "이번에 개발된 ‘DirectCXL’은 기존 RDMA기반 메모리 확장 솔루션보다 훨씬 적은 비용으로도 뛰어난 성능과 높은 확장성을 제공하는 만큼 데이터센터나 고성능 컴퓨팅 시스템에서의 수요가 클 것으로 기대한다ˮ며, "세계 최초로 개발된 CXL 2.0 기반의 단대단 프로토타입 플랫폼을 활용해 CXL이 적용된 새로운 운영체제(OS)는 물론 시스템 소프트웨어, 솔루션 시제품 고도화를 통해 향후 CXL을 활용한 시스템 구축에 초석을 제공할 것이다ˮ라고 말했다.

한편 이번 연구는 미국 칼스배드에서 지난 7월에 11에 열린 시스템 분야 최우수 학술대회인 유즈닉스 연례 회의 `USENIX Annual Technical Conference, 2022'에 ‘DirectCXL’이라는 논문명(Direct Access, High-performance Memory Disaggregation with DirectCXL)으로 발표되었다. 또한 미국 산호세에서 열리는 8월 2/3일에 플래시 메모리 정상회담(Flash Memory Summit)에서 CXL 컨소시움이 이끄는 CXL포럼에 발표될 예정이다.

‘DirectCXL’의 자세한 내용은 연구실 웹사이트(http://camelab.org)에서 확인할 수 있다. DirectCXL은 데이터센터와 클라우드 시스템에서 다양한 응용에 쉽게 적용 가능하며, 하나의 실시예로 메타(페이스북) 추천시스템 기계학습 데이터 가속에 대한 시연 영상을 연구실 유튜브(https://youtu.be/jm8k-JM0qbM) 에서 확인할 수 있다. 해당 영상은 각 개인의 대규모 특성 자료들(텐서)을 CXL 메모리 풀에 올려두고 빅데이터를 활용한 인공지능이 친구나 광고 등 개인 특성에 맞는 자료들을 추천하게 하는 시스템으로 기존 데이터 센터의 원격메모리에 비해 3.2배 이상의 사용자 수준 성능 향상을 보여주고 있다.

2022.08.01 조회수 10956

인공지능 및 빅데이터 시대를 이끌어갈 차세대 CXL2.0 메모리 확장 플랫폼 세계 최초 개발

우리 대학 전기및전자공학부 정명수 교수 연구팀(컴퓨터 아키텍처 및 메모리 시스템 연구실)이 대용량 메모리 장치부터 프로세스를 포함한 컴퓨트 익스프레스 링크(CXL) 2.0 기반의 차세대 메모리 확장 플랫폼 ‘다이렉트CXL(이하 DirectCXL)’을 세계 최초로 프로토타입 제작, 운영체제가 실장된 단대단(End-to-End) 시연에 성공했다고 1일 밝혔다.

오늘날 빅데이터 분석, 그래프 분석, 인메모리 데이터베이스 등 대규모 데이터에 기반한 응용처리가 증가함에 따라, 데이터 센터에서는 이를 더 빠르고 효율적으로 처리하기 위해 시스템의 메모리 확장에 많은 투자를 하고 있다.

그러나 우리가 흔히 알고 있는 메모리 확장 방식인 더블 데이터 대역폭(DDR) 인터페이스를 통한 메모리 확장은 추가할 수 있는 메모리 개수의 제한이 있어, 대규모 데이터 기반의 응용을 처리하기에 충분치 않다. 따라서 데이터 센터에서는 CPU와 메모리로 이루어진 메모리 노드들을 따로 구성하고, 응용을 수행하는 호스트의 메모리가 부족하면 네트워크로 연결된 메모리 노드를 자신의 메모리 공간으로 사용하는 원격 데이터 전송 기술(이하 RDMA) 기반의 메모리 확장을 사용한다.

여러 메모리 노드를 사용하는 RDMA 기반의 메모리 확장을 통해 데이터센터는 시스템의 메모리 크기를 늘릴 수 있었지만, 여전히 해결해야 할 문제들이 남아있었다. 우선 RDMA 기반 메모리 확장 시스템에서는 노드 간 데이터 이동 시 불필요한 데이터 복사, 소프트웨어의 개입 그리고 프로토콜 전환으로 인한 지연을 발생시켜 성능 저하가 발생했다. 또한 시스템의 메모리 확장 시 메모리만을 추가할 수 있는 것이 아닌, 메모리와 메모리를 제어할 CPU가 하나의 메모리 노드를 이루어 시스템에 추가되어야 했기 때문에, 추가적인 비용 소모가 발생했다.

최근 컴퓨트 익스프레스 링크(Compute Express Link, 이하 CXL) 프로토콜의 등장으로 많은 메모리 고객사와 제조사가 이러한 문제를 해결할 가능성을 확인하고 있다. CXL은 PCI 익스프레스(PCIe) 인터페이스 기반의 CPU-장치(Device) 간 연결을 위한 프로토콜로, 이를 기반으로 한 장치 연결은 기존보다 높은 성능과 확장성을 지원하는 것이 특징이다.

국내외 유수 기업들이 모여 CXL 인터페이스 표준 규약을 제안하는 CXL 컨소시엄은 지난 2019년 CXL 1.0/1.1을 처음 제안했고, 이후 CXL 2.0을 발표하며 CXL 1.0/1.1에서 하나의 포트당 하나의 지역 메모리 장치만을 연결할 수 있었던 확장성 문제를 스위치 네트워크를 통해 개선, 하나의 포트를 여러 포트로 확장할 수 있도록 했다. 따라서 CXL 1.0/1.1과 달리 CXL 2.0에서는 확장된 포트에 다수의 원격 CXL 메모리 장치를 연결하는 것이 가능해 더 높은 확장성을 지원할 수 있게 됐다.

그러나 CXL 2.0의 높은 확장성에도 불구하고, 아직 CXL 연구의 방향성을 제시해줄 수 있는 시제품 개발 및 연구들이 진행되지 않아, 메모리 업계와 학계에서는 여전히 CXL1.0/1.1을 기반으로 지역 메모리 확장 장치, 시제품 개발 및 연구를 진행하고 있는 실정이다. 따라서 새로운 CXL 2.0을 통한 메모리 확장 연구의 방향성 초석을 제시할 필요성이 커졌다.

정명수 교수 연구팀이 전 세계 최초로 프로토타입한 CXL 2.0 기반 메모리 확장 플랫폼 ‘DirectCXL’은 높은 수준의 메모리 확장성을 제공하며, 빠른 속도로 대규모 데이터 처리를 가능케 한다. 이를 위해 연구팀은 메모리를 확장해 줄 장치인 ‘CXL 메모리 장치’와 호스트 ‘CXL 프로세서 (CPU)’, 여러 호스트를 다수의 CXL 메모리 장치에 연결해주는 ‘CXL 네트워크 스위치’ 그리고 메모리 확장 플랫폼 전반을 제어할 리눅스 운영체제 기반의‘CXL 소프트웨어 모듈’을 개발해 플랫폼을 구성했다.

구성된 ‘DirectCXL’ 플랫폼을 사용한 시스템에서는 확장된 메모리 공간에 직접 접근해 데이터를 CPU의 캐시로 가져와 불필요한 메모리 복사와 소프트웨어의 개입이 없으며, PCIe 인터페이스만을 사용해 프로토콜 전환을 없애 지연시간을 최대한 줄였다. 또한 추가적인 CPU가 필요 없는 CXL 메모리 장치를 CXL 스위치에 연결하는 것만으로 메모리 확장이 가능해 효율적인 시스템의 구성이 가능했다. 국내외 소수 대기업에서 메모리 장치 일부 단품에 대한 구성을 보여준 준 사례는 있지만, CXL 2.0 기반, CPU부터 CXL 스위치, 메모리 장치가 장착된 시스템에서 운영체제를 동작시키고 데이터 센터와 응용을 실행하고 시연한 것은 정명수 교수 연구팀이 처음이다.

연구팀은 자체 제작한 메모리 확장 플랫폼 ‘DirectCXL’의 성능을 검증하기 위해 CXL 동작이 가능한 다수의 자체 개발 호스트 컴퓨터가 CXL 네트워크 스위치를 통해 연결된 다수 CXL 메모리 장치들을 제어하는 환경을 구성했다. 이후 구성된 플랫폼을 통해 CXL 메모리 장치의 성능을 기존 RDMA 기반 메모리 확장 솔루션과 비교했다. 연구팀이 제안한 ‘DirectCXL’은 확장된 메모리에 대한 접근 시간 검증에서 기존 RDMA 기반의 메모리 확장 솔루션 대비 8.3배의 성능 향상을 보였으며, 많은 메모리 접근을 요구하는 그래프 응용처리 및 인 메모리 데이터베이스 응용처리에서도 각각 2.3배, 2배의 성능 향상을 이뤄냈다.

정명수 교수는 "이번에 개발된 ‘DirectCXL’은 기존 RDMA기반 메모리 확장 솔루션보다 훨씬 적은 비용으로도 뛰어난 성능과 높은 확장성을 제공하는 만큼 데이터센터나 고성능 컴퓨팅 시스템에서의 수요가 클 것으로 기대한다ˮ며, "세계 최초로 개발된 CXL 2.0 기반의 단대단 프로토타입 플랫폼을 활용해 CXL이 적용된 새로운 운영체제(OS)는 물론 시스템 소프트웨어, 솔루션 시제품 고도화를 통해 향후 CXL을 활용한 시스템 구축에 초석을 제공할 것이다ˮ라고 말했다.

한편 이번 연구는 미국 칼스배드에서 지난 7월에 11에 열린 시스템 분야 최우수 학술대회인 유즈닉스 연례 회의 `USENIX Annual Technical Conference, 2022'에 ‘DirectCXL’이라는 논문명(Direct Access, High-performance Memory Disaggregation with DirectCXL)으로 발표되었다. 또한 미국 산호세에서 열리는 8월 2/3일에 플래시 메모리 정상회담(Flash Memory Summit)에서 CXL 컨소시움이 이끄는 CXL포럼에 발표될 예정이다.

‘DirectCXL’의 자세한 내용은 연구실 웹사이트(http://camelab.org)에서 확인할 수 있다. DirectCXL은 데이터센터와 클라우드 시스템에서 다양한 응용에 쉽게 적용 가능하며, 하나의 실시예로 메타(페이스북) 추천시스템 기계학습 데이터 가속에 대한 시연 영상을 연구실 유튜브(https://youtu.be/jm8k-JM0qbM) 에서 확인할 수 있다. 해당 영상은 각 개인의 대규모 특성 자료들(텐서)을 CXL 메모리 풀에 올려두고 빅데이터를 활용한 인공지능이 친구나 광고 등 개인 특성에 맞는 자료들을 추천하게 하는 시스템으로 기존 데이터 센터의 원격메모리에 비해 3.2배 이상의 사용자 수준 성능 향상을 보여주고 있다.

2022.08.01 조회수 10956 -

스스로 진화하는 흉부 엑스선 인공지능 진단기술 개발

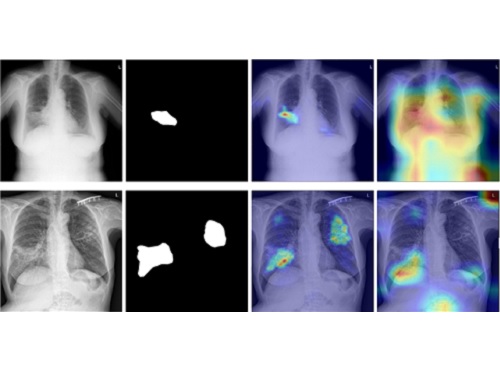

우리 대학 김재철AI대학원 예종철 교수 연구팀이 서울대학교 병원, 서울 아산병원, 충남대학교 병원, 영남대학교 병원, 경북대학교 병원과의 공동연구를 통해 결핵, 기흉, 코로나-19 등의 흉부 엑스선 영상을 이용한 폐 질환의 자동 판독 능력을 스스로 향상할 수 있는 자기 진화형 인공지능 기술을 개발했다고 27일 밝혔다.

현재 사용되는 대부분의 의료 인공지능 기법은 지도학습 방식 (Supervised learning)으로서 인공지능 모델을 학습하기 위해서는 전문가에 의한 다량의 라벨이 필수적이나, 실제 임상 현장에서 전문가에 의해 라벨링 된 대규모의 데이터를 지속해서 얻는 것이 비용과 시간이 많이 들어 이러한 문제가 의료 인공지능 발전의 걸림돌이 돼왔다.

이러한 문제를 해결하기 위해, 예종철 교수팀은 병원 현장에서 영상의학과 전문의들이 영상 판독을 학습하는 과정과 유사하게, 자기 학습과 선생-학생 간의 지식전달 기법을 묘사한 지식 증류 기법을 활용한 자기 지도학습 및 자기 훈련 방식(Distillation for self-supervised and self-train learning, 이하 DISTL) 인공지능 알고리즘을 개발했다. 제안하는 인공지능 알고리즘은 적은 수의 라벨데이터만 갖고 초기 모델을 학습시키면 시간이 지남에 따라 축적되는 라벨 없는 데이터 자체만을 가지고 해당 모델이 스스로 성능을 향상해 나갈 수 있는 것을 보였다.

실제 의료 영상 분야에서 전문가들이 판독한 정제된 라벨 획득의 어려움은 영상 양식이나 작업과 관계없이 빈번하게 발생하는 문제점이고, 이러한 영상 전문의의 부족 현상은 저소득 국가들과 개발도상국과 같이 결핵과 같은 다양한 전염성 질환이 많이 발생하는 지역에 많다는 점을 고려할 때, 예 교수팀에서 개발한 인공지능 알고리즘은 해당 지역에서 인공지능 모델을 자기 진화시키는 방식으로 진단 정확도를 향상하는 데 큰 도움을 줄 것으로 기대된다.

예종철 교수는 “지도학습 방식으로 성능을 향상하기 위해서는 전문가 라벨을 지속해서 획득해야 하고, 비 지도학습 방식으로는 성능이 낮다는 문제점을 극복한 DISTL 모델은 영상 전문의들의 인공지능 학습을 위한 레이블 생성 비용과 수고를 줄이면서도 지도학습 성능을 뛰어넘었다는 점에서 의미가 있고, 다양한 영상 양식 및 작업에 활용할 수 있을 것으로 기대된다”라고 말했다.

예종철 교수 연구팀의 박상준 박사과정이 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 커뮤니케이션스(Nature Communications)'에 7월 4일 자로 게재됐다.

한편 이번 연구는 중견연구자지원사업, 범부처전주기의료기기연구개발사업 및 한국과학기술원 중점연구소 사업등의 지원을 받아 수행됐다.

*논문명: Self-evolving vision transformer for chest X-ray diagnosis through knowledge distillation

논문 링크: https://www.nature.com/articles/s41467-022-31514-x

2022.07.27 조회수 10254

스스로 진화하는 흉부 엑스선 인공지능 진단기술 개발

우리 대학 김재철AI대학원 예종철 교수 연구팀이 서울대학교 병원, 서울 아산병원, 충남대학교 병원, 영남대학교 병원, 경북대학교 병원과의 공동연구를 통해 결핵, 기흉, 코로나-19 등의 흉부 엑스선 영상을 이용한 폐 질환의 자동 판독 능력을 스스로 향상할 수 있는 자기 진화형 인공지능 기술을 개발했다고 27일 밝혔다.

현재 사용되는 대부분의 의료 인공지능 기법은 지도학습 방식 (Supervised learning)으로서 인공지능 모델을 학습하기 위해서는 전문가에 의한 다량의 라벨이 필수적이나, 실제 임상 현장에서 전문가에 의해 라벨링 된 대규모의 데이터를 지속해서 얻는 것이 비용과 시간이 많이 들어 이러한 문제가 의료 인공지능 발전의 걸림돌이 돼왔다.

이러한 문제를 해결하기 위해, 예종철 교수팀은 병원 현장에서 영상의학과 전문의들이 영상 판독을 학습하는 과정과 유사하게, 자기 학습과 선생-학생 간의 지식전달 기법을 묘사한 지식 증류 기법을 활용한 자기 지도학습 및 자기 훈련 방식(Distillation for self-supervised and self-train learning, 이하 DISTL) 인공지능 알고리즘을 개발했다. 제안하는 인공지능 알고리즘은 적은 수의 라벨데이터만 갖고 초기 모델을 학습시키면 시간이 지남에 따라 축적되는 라벨 없는 데이터 자체만을 가지고 해당 모델이 스스로 성능을 향상해 나갈 수 있는 것을 보였다.

실제 의료 영상 분야에서 전문가들이 판독한 정제된 라벨 획득의 어려움은 영상 양식이나 작업과 관계없이 빈번하게 발생하는 문제점이고, 이러한 영상 전문의의 부족 현상은 저소득 국가들과 개발도상국과 같이 결핵과 같은 다양한 전염성 질환이 많이 발생하는 지역에 많다는 점을 고려할 때, 예 교수팀에서 개발한 인공지능 알고리즘은 해당 지역에서 인공지능 모델을 자기 진화시키는 방식으로 진단 정확도를 향상하는 데 큰 도움을 줄 것으로 기대된다.

예종철 교수는 “지도학습 방식으로 성능을 향상하기 위해서는 전문가 라벨을 지속해서 획득해야 하고, 비 지도학습 방식으로는 성능이 낮다는 문제점을 극복한 DISTL 모델은 영상 전문의들의 인공지능 학습을 위한 레이블 생성 비용과 수고를 줄이면서도 지도학습 성능을 뛰어넘었다는 점에서 의미가 있고, 다양한 영상 양식 및 작업에 활용할 수 있을 것으로 기대된다”라고 말했다.

예종철 교수 연구팀의 박상준 박사과정이 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 커뮤니케이션스(Nature Communications)'에 7월 4일 자로 게재됐다.

한편 이번 연구는 중견연구자지원사업, 범부처전주기의료기기연구개발사업 및 한국과학기술원 중점연구소 사업등의 지원을 받아 수행됐다.

*논문명: Self-evolving vision transformer for chest X-ray diagnosis through knowledge distillation

논문 링크: https://www.nature.com/articles/s41467-022-31514-x

2022.07.27 조회수 10254 -

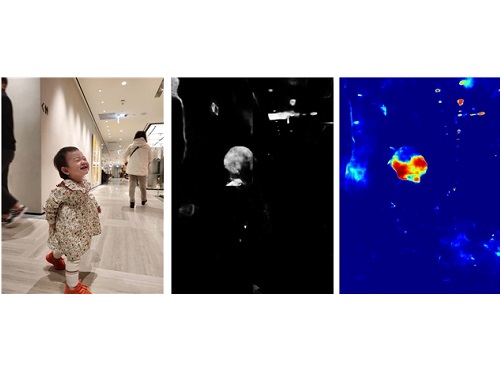

위치인식 기술의 혁신, 인공지능 활용한 실내외 통합 GPS 시스템 개발

우리 대학 전산학부 한동수 교수 연구팀(지능형 서비스 통합 연구실)이 실내외 환경 구분 없이 정밀한 위치인식이 가능한 `실내외 통합 GPS 시스템'을 개발했다고 8일 밝혔다.

이번에 개발된 실내외 통합 GPS 시스템은 실외에서는 GPS 신호를 사용해 위치를 추정하고 실내에서는 관성센서, 기압센서, 지자기센서, 조도센서에서 얻어지는 신호를 복합적으로 사용해 위치를 인식한다. 이를 위해 연구팀은 인공지능 기법을 활용한 실내외 탐지, 건물 출입구 탐지, 건물 진입 층 탐지, 계단/엘리베이터 탐지, 층 탐지 기법 등을 개발했다. 아울러 개발된 각종 랜드마크 탐지 기법들을 보행자 항법 기법(PDR)과 연계시킨 소위 센서 퓨전 위치인식 알고리즘도 새롭게 개발했다.

지금까지는 GPS 신호가 도달하지 않는 공간에서는 무선랜 신호나 기지국 신호를 기반으로 위치를 인식하는 것이 보통이었다. 하지만 이번에 개발된 실내외 통합 GPS 시스템은 신호가 존재하지 않고 실내지도가 제공되지 않는 건물에서도 위치인식을 가능하게 하는 최초의 기술이다.

연구팀이 개발한 알고리즘은 구글, 애플의 위치인식 서비스에서는 제공하지 않는 건물 내에서의 정확한 층 정보를 제공할 수 있다. 비전이나 지구 자기장, 무선랜 측위 방식과 달리 사전 준비 작업이 필요치 않은 장점도 있다. 전 세계 어디에서나 사용할 수 있는 범용적인 실내외 통합 GPS 시스템을 구축할 수 있는 기반이 마련됐다.

연구팀은 GPS, 와이파이, 블루투스 신호 수신 칩과 관성센서, 기압센서, 지자기센서, 조도센서 등을 탑재시킨 실내외 통합 GPS 전용 보드도 제작했다. 또한 제작된 하드웨어(HW) 보드에 개발된 센서퓨전 위치인식 알고리즘을 탑재했다. 제작된 실내외 통합 GPS 전용 하드웨어(HW) 보드의 위치인식 정확도를 대전 KAIST 본원 N1 건물에서 측정한 결과, 층 추정에 있어서는 약 95%의 정확도를, 수평 방향으로는 약 3~6미터의 정확도를 달성했다. 실내외 전환에 있어서는 약 0.3초의 전환 속도를 달성했다. 보행자 항법(PDR) 기법을 통합시켰을 때는 1미터 내외의 정확도를 달성하였다.

연구팀은 위치인식 보드가 내장된 태그를 제작하고 박물관, 과학관, 미술관 방문객들을 위한 위치기반 전시 안내 서비스에 적용할 예정이다. 개발된 실내외 통합 GPS 태그는 어린이나 노약자를 보호하는 목적으로도 활용할 수 있으며 소방관 혹은 작업장 작업자의 위치 파악에도 활용할 수 있다. 한편 지하 주차장과 같은 실내로 진입하는 차량의 위치를 추정하는 차량용 센서 퓨전 위치인식 알고리즘과 위치인식 보드도 개발하고 있다.

연구팀은 차량용 실내외 통합 GPS 위치인식 보드가 제작되면 자동차 제조사, 차량 대여 업체들과의 협력을 모색할 예정이며, 스마트폰에 탑재될 센서 퓨전 위치인식 알고리즘도 개발할 예정이다. 개발된 알고리즘이 내장된 실내외 통합 GPS 앱이 개발되면 위치인식 분야에서 다양한 사업화를 모색하는 통신사와의 협력도 가능할 것으로 기대된다.

연구팀을 이끄는 전산학부 한동수 교수는 "무선 신호가 존재하지 않고 실내지도도 주어지지 않는 건물에서 위치인식이 가능한 실내외 통합 GPS 시스템 개발은 이번이 처음이며, 그 응용 분야도 무궁무진하다. 2022년부터 개발이 시작된 한국형 GPS(KPS) 시스템, 한국형 항공위성서비스(Korea Augmentation Satellite System, KASS)와 통합되면 한국이 실내외 통합 GPS 분야에서 선도 국가로 나설 수 있으며 향후 기술 격차를 더 벌릴 수 있도록 실내외 통합 GPS 반도체 칩도 제작할 계획이다ˮ라고 말했다.

또 "개발된 실내외 통합 GPS 태그를 사용한 과학관, 박물관, 미술관 위치기반 안내 서비스는 관람객의 동선 분석에도 유용하게 활용될 수 있다. 전시물 교체를 결정할 때 요구되는 꼭 필요한 유용한 정보다. 국립중앙과학관에 우선 적용될 수 있도록 노력하겠다”라고 말했다.

한편 실내외 통합 GPS 시스템, 그리고 위치기반 관람객 동선 분석 시스템 개발은 과기정통부의 과학문화전시서비스 역량강화지원사업의 지원으로 개발됐다.

2022.07.08 조회수 12426

위치인식 기술의 혁신, 인공지능 활용한 실내외 통합 GPS 시스템 개발

우리 대학 전산학부 한동수 교수 연구팀(지능형 서비스 통합 연구실)이 실내외 환경 구분 없이 정밀한 위치인식이 가능한 `실내외 통합 GPS 시스템'을 개발했다고 8일 밝혔다.

이번에 개발된 실내외 통합 GPS 시스템은 실외에서는 GPS 신호를 사용해 위치를 추정하고 실내에서는 관성센서, 기압센서, 지자기센서, 조도센서에서 얻어지는 신호를 복합적으로 사용해 위치를 인식한다. 이를 위해 연구팀은 인공지능 기법을 활용한 실내외 탐지, 건물 출입구 탐지, 건물 진입 층 탐지, 계단/엘리베이터 탐지, 층 탐지 기법 등을 개발했다. 아울러 개발된 각종 랜드마크 탐지 기법들을 보행자 항법 기법(PDR)과 연계시킨 소위 센서 퓨전 위치인식 알고리즘도 새롭게 개발했다.

지금까지는 GPS 신호가 도달하지 않는 공간에서는 무선랜 신호나 기지국 신호를 기반으로 위치를 인식하는 것이 보통이었다. 하지만 이번에 개발된 실내외 통합 GPS 시스템은 신호가 존재하지 않고 실내지도가 제공되지 않는 건물에서도 위치인식을 가능하게 하는 최초의 기술이다.

연구팀이 개발한 알고리즘은 구글, 애플의 위치인식 서비스에서는 제공하지 않는 건물 내에서의 정확한 층 정보를 제공할 수 있다. 비전이나 지구 자기장, 무선랜 측위 방식과 달리 사전 준비 작업이 필요치 않은 장점도 있다. 전 세계 어디에서나 사용할 수 있는 범용적인 실내외 통합 GPS 시스템을 구축할 수 있는 기반이 마련됐다.

연구팀은 GPS, 와이파이, 블루투스 신호 수신 칩과 관성센서, 기압센서, 지자기센서, 조도센서 등을 탑재시킨 실내외 통합 GPS 전용 보드도 제작했다. 또한 제작된 하드웨어(HW) 보드에 개발된 센서퓨전 위치인식 알고리즘을 탑재했다. 제작된 실내외 통합 GPS 전용 하드웨어(HW) 보드의 위치인식 정확도를 대전 KAIST 본원 N1 건물에서 측정한 결과, 층 추정에 있어서는 약 95%의 정확도를, 수평 방향으로는 약 3~6미터의 정확도를 달성했다. 실내외 전환에 있어서는 약 0.3초의 전환 속도를 달성했다. 보행자 항법(PDR) 기법을 통합시켰을 때는 1미터 내외의 정확도를 달성하였다.

연구팀은 위치인식 보드가 내장된 태그를 제작하고 박물관, 과학관, 미술관 방문객들을 위한 위치기반 전시 안내 서비스에 적용할 예정이다. 개발된 실내외 통합 GPS 태그는 어린이나 노약자를 보호하는 목적으로도 활용할 수 있으며 소방관 혹은 작업장 작업자의 위치 파악에도 활용할 수 있다. 한편 지하 주차장과 같은 실내로 진입하는 차량의 위치를 추정하는 차량용 센서 퓨전 위치인식 알고리즘과 위치인식 보드도 개발하고 있다.

연구팀은 차량용 실내외 통합 GPS 위치인식 보드가 제작되면 자동차 제조사, 차량 대여 업체들과의 협력을 모색할 예정이며, 스마트폰에 탑재될 센서 퓨전 위치인식 알고리즘도 개발할 예정이다. 개발된 알고리즘이 내장된 실내외 통합 GPS 앱이 개발되면 위치인식 분야에서 다양한 사업화를 모색하는 통신사와의 협력도 가능할 것으로 기대된다.

연구팀을 이끄는 전산학부 한동수 교수는 "무선 신호가 존재하지 않고 실내지도도 주어지지 않는 건물에서 위치인식이 가능한 실내외 통합 GPS 시스템 개발은 이번이 처음이며, 그 응용 분야도 무궁무진하다. 2022년부터 개발이 시작된 한국형 GPS(KPS) 시스템, 한국형 항공위성서비스(Korea Augmentation Satellite System, KASS)와 통합되면 한국이 실내외 통합 GPS 분야에서 선도 국가로 나설 수 있으며 향후 기술 격차를 더 벌릴 수 있도록 실내외 통합 GPS 반도체 칩도 제작할 계획이다ˮ라고 말했다.

또 "개발된 실내외 통합 GPS 태그를 사용한 과학관, 박물관, 미술관 위치기반 안내 서비스는 관람객의 동선 분석에도 유용하게 활용될 수 있다. 전시물 교체를 결정할 때 요구되는 꼭 필요한 유용한 정보다. 국립중앙과학관에 우선 적용될 수 있도록 노력하겠다”라고 말했다.

한편 실내외 통합 GPS 시스템, 그리고 위치기반 관람객 동선 분석 시스템 개발은 과기정통부의 과학문화전시서비스 역량강화지원사업의 지원으로 개발됐다.

2022.07.08 조회수 12426 -

새로운 인공지능 형광 현미경 적용, 뇌 신경세포 등 3차원 고화질 영상기술 개발

우리 대학 김재철 AI 대학원 예종철 교수 연구팀이 서울대학교 장성호 교수팀, 포스텍 김기현 교수팀과 공동연구를 통해 형광 현미경의 오랜 문제인 이방성(Anisotropy)을 해결해, 3차원 영상 화질을 획기적으로 끌어올리는 인공지능 기술을 개발했다고 29일 밝혔다.

이방성 문제란 형광 현미경으로 3차원 영상을 획득하는 데 있어 빛의 성질로 인해 영상 공간 방향 간에 적게는 2~3배, 많게는 10배까지도 화질 차이가 발생하는 문제를 뜻한다. 예를 들면 3차원 영상을 보는 각도마다 화질의 차이가 발생하는 것이다.

연구팀은 수학적 기법인 최적 수송이론 기반을 둔 새로운 인공지능 시스템을 개발해 공초점 현미경과 광 시트 현미경에 적용했다. 기존 인공지능 기법들과는 다르게, 인공지능 학습 데이터가 따로 필요하지 않고, 하나의 3차원 영상만으로도 인공지능 학습에 적용할 수 있다는 점에서 획기적이라 볼 수 있으며, 생물학 연구자들에게 생물 표본의 3차원 고화질 영상 획득에 큰 도움을 줄 것으로 기대된다.

예종철 교수는 "3차원 영상 획득에 있어 극복하기 어려웠던 현미경의 물리적 한계를 인공지능 기술을 통해 뛰어넘었다는 점에서 의미가 있고, 비지도 학습 기반으로 훈련이 진행되기 때문에, 다양한 많은 종류의 3차원 영상 촬영 기법에도 확장 적용 가능하며, 또한 인공지능 연구의 새로운 응용을 개척했다는 데 의미가 있다ˮ 고 말했다.

김재철 AI 대학원의 예종철 교수가 주도하고, 박형준 연구원이 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 커뮤니케이션스(Nature Communications)' 6월 8일 字 온라인판에 게재됐다.

*논문명 : Deep learning enables reference-free isotropic super-resolution for volumetric fluorescence microscopy

논문 링크: https://www.nature.com/articles/s41467-022-30949-6

2022.06.29 조회수 11549

새로운 인공지능 형광 현미경 적용, 뇌 신경세포 등 3차원 고화질 영상기술 개발

우리 대학 김재철 AI 대학원 예종철 교수 연구팀이 서울대학교 장성호 교수팀, 포스텍 김기현 교수팀과 공동연구를 통해 형광 현미경의 오랜 문제인 이방성(Anisotropy)을 해결해, 3차원 영상 화질을 획기적으로 끌어올리는 인공지능 기술을 개발했다고 29일 밝혔다.

이방성 문제란 형광 현미경으로 3차원 영상을 획득하는 데 있어 빛의 성질로 인해 영상 공간 방향 간에 적게는 2~3배, 많게는 10배까지도 화질 차이가 발생하는 문제를 뜻한다. 예를 들면 3차원 영상을 보는 각도마다 화질의 차이가 발생하는 것이다.

연구팀은 수학적 기법인 최적 수송이론 기반을 둔 새로운 인공지능 시스템을 개발해 공초점 현미경과 광 시트 현미경에 적용했다. 기존 인공지능 기법들과는 다르게, 인공지능 학습 데이터가 따로 필요하지 않고, 하나의 3차원 영상만으로도 인공지능 학습에 적용할 수 있다는 점에서 획기적이라 볼 수 있으며, 생물학 연구자들에게 생물 표본의 3차원 고화질 영상 획득에 큰 도움을 줄 것으로 기대된다.

예종철 교수는 "3차원 영상 획득에 있어 극복하기 어려웠던 현미경의 물리적 한계를 인공지능 기술을 통해 뛰어넘었다는 점에서 의미가 있고, 비지도 학습 기반으로 훈련이 진행되기 때문에, 다양한 많은 종류의 3차원 영상 촬영 기법에도 확장 적용 가능하며, 또한 인공지능 연구의 새로운 응용을 개척했다는 데 의미가 있다ˮ 고 말했다.

김재철 AI 대학원의 예종철 교수가 주도하고, 박형준 연구원이 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 커뮤니케이션스(Nature Communications)' 6월 8일 字 온라인판에 게재됐다.

*논문명 : Deep learning enables reference-free isotropic super-resolution for volumetric fluorescence microscopy

논문 링크: https://www.nature.com/articles/s41467-022-30949-6

2022.06.29 조회수 11549 -

인공지능 이용해 3차원 홀로그래피 현미경의 박테리아 신속 식별 기술 개발

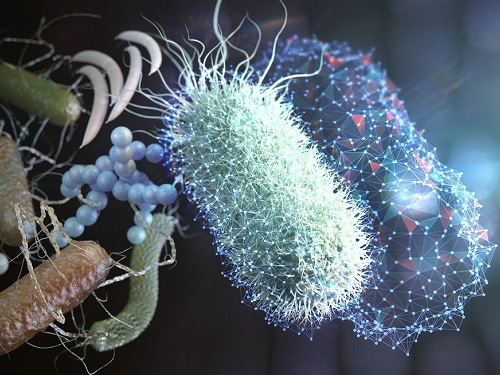

우리 대학 물리학과 박용근 교수 연구팀이 홀로그래피 현미경과 인공지능을 이용한 신속 박테리아 병원균 식별 기술을 개발했다고 27일 밝혔다.

병원균의 조기 식별은 감염질환 치료에 필수적이다. 치명적인 상태로 진행되기 전에 감염균에 맞는 효과적인 항생제의 선택과 투여가 가능해지기 때문이다. 하지만 현재의 일상적 병원균 식별은 통상 수일이 소요된다. 이로 인해 감염 초기 식별 결과 없이 실증적인 처방으로 항생제를 투여하는 사례가 빈번하며, 이로 인해 패혈증의 경우 치명률이 50%에 달하며 항생제 남용으로 인한 슈퍼박테리아 문제도 발생한다.

기존 방법으로 병원균 식별이 오래 걸리는 원인은 긴 박테리아 배양 시간이다. 질량 분석기로 대표되는 식별 기술들은 일정량 이상의 박테리아 표본이 확보되어야 균종과 관련된 분자적 신호를 검출할 수 있다. 이로 인해, 환자에서 추출한 시편을 하루 이상 배양해야만 검출이 될 정도의 박테리아 개수가 확보된다.

광학 분야의 저명 학술지인 `빛: 과학과 응용(Light: Science & Applications), (IF = 17.782)'에 게재된 이번 연구(논문명: Rapid species identification of pathogenic bacteria from a minute quantity exploiting three-dimensional quantitative phase imaging and artificial neural network)에서 박용근 교수 연구팀은 3차원 홀로그래피 현미경과 인공지능 알고리즘을 활용해서 단일 세포 수준의 표본으로도 병원균의 균종을 정확히 알아낼 수 있음을 입증했다.

홀로그래피 현미경으로 측정되는 3차원 굴절률 영상 정보에 내재된 균종과 관련된 특성을 인공지능 알고리즘으로 학습해 종을 구분하는 것이 핵심 아이디어다. 연구팀은 종별로 500개 이상의 박테리아의 3차원 굴절률 영상을 측정했고, 이를 인공지능 신경망을 통해 학습시켰다.

연구팀은 개발한 방법을 이용해 주요한 혈액 감염균을 신속하게 식별함으로써 실제 진단에도 응용될 가능성을 검증했다. 구체적으로 그람 음성 및 양성, 구균 및 간균을 모두 포함한 총 19가지 균종으로 혈액 감염 사례의 90% 이상의 원인이 되는 균들이다. 한 개의 병원균 혹은 병원균 덩어리를 측정한 단일 3차원 굴절률 영상에서는 약 82.5%의 정확도로 균종 판별이 가능했다. 연구팀은 또한 여러 영상을 확보할 수 있을 때 정확도가 증가해, 7개의 박테리아 영상이 확보된다면 99.9%의 정확도를 얻을 수 있었다.

연구진의 책임자이자 논문의 교신저자인 박용근 교수는 "홀로그래피 현미경의 세포 감별 능력을 인공지능으로 극대화해 감염 진단 기술로서의 가능성을 확인한 것이 의미ˮ라고 말했다. 제1 저자인 물리학과 김건 박사과정 학생은 "100,000분의 1 수준의 표본량으로도 질량 분석기의 균종 검출률과 비슷한 정확도를 얻었고 환자 시편에서 다양한 병원균을 식별하는 플랫폼 기술이 될 것으로 기대된다ˮ라고 덧붙였다.

이번 연구는 KAIST-삼성서울병원-토모큐브 팀의 수년간의 공동 연구를 통해 진행됐다. 물리학과 박용근 교수 연구팀의 기술에 다양한 기관의 경험과 비전을 반영함으로써 완성할 수 있었다. 삼성서울병원 진단검사의학과 이남용 교수, 진단검사의학과 허희재 교수, 감염내과 정두련 교수 연구팀, 서울성모병원 진단검사의학과 유인영 교수, 분당 차병원 응급의학과 김규석 교수, 우리 대학 나노과학기술대학원 정현정 교수 등 다양한 분야와 기관이 모여, 실험적 검증을 효과적으로 진행할 수 있었다. 또한 KAIST 교원 창업 기업인 ㈜토모큐브의 3차원 홀로그래피 기술 지원도 필수적인 역할을 했다.

한편 이번 연구는 한국연구재단 창의연구사업, 과학기술일자리진흥원의 지원을 받아 수행됐다.

2022.06.27 조회수 10657

인공지능 이용해 3차원 홀로그래피 현미경의 박테리아 신속 식별 기술 개발

우리 대학 물리학과 박용근 교수 연구팀이 홀로그래피 현미경과 인공지능을 이용한 신속 박테리아 병원균 식별 기술을 개발했다고 27일 밝혔다.

병원균의 조기 식별은 감염질환 치료에 필수적이다. 치명적인 상태로 진행되기 전에 감염균에 맞는 효과적인 항생제의 선택과 투여가 가능해지기 때문이다. 하지만 현재의 일상적 병원균 식별은 통상 수일이 소요된다. 이로 인해 감염 초기 식별 결과 없이 실증적인 처방으로 항생제를 투여하는 사례가 빈번하며, 이로 인해 패혈증의 경우 치명률이 50%에 달하며 항생제 남용으로 인한 슈퍼박테리아 문제도 발생한다.

기존 방법으로 병원균 식별이 오래 걸리는 원인은 긴 박테리아 배양 시간이다. 질량 분석기로 대표되는 식별 기술들은 일정량 이상의 박테리아 표본이 확보되어야 균종과 관련된 분자적 신호를 검출할 수 있다. 이로 인해, 환자에서 추출한 시편을 하루 이상 배양해야만 검출이 될 정도의 박테리아 개수가 확보된다.

광학 분야의 저명 학술지인 `빛: 과학과 응용(Light: Science & Applications), (IF = 17.782)'에 게재된 이번 연구(논문명: Rapid species identification of pathogenic bacteria from a minute quantity exploiting three-dimensional quantitative phase imaging and artificial neural network)에서 박용근 교수 연구팀은 3차원 홀로그래피 현미경과 인공지능 알고리즘을 활용해서 단일 세포 수준의 표본으로도 병원균의 균종을 정확히 알아낼 수 있음을 입증했다.

홀로그래피 현미경으로 측정되는 3차원 굴절률 영상 정보에 내재된 균종과 관련된 특성을 인공지능 알고리즘으로 학습해 종을 구분하는 것이 핵심 아이디어다. 연구팀은 종별로 500개 이상의 박테리아의 3차원 굴절률 영상을 측정했고, 이를 인공지능 신경망을 통해 학습시켰다.

연구팀은 개발한 방법을 이용해 주요한 혈액 감염균을 신속하게 식별함으로써 실제 진단에도 응용될 가능성을 검증했다. 구체적으로 그람 음성 및 양성, 구균 및 간균을 모두 포함한 총 19가지 균종으로 혈액 감염 사례의 90% 이상의 원인이 되는 균들이다. 한 개의 병원균 혹은 병원균 덩어리를 측정한 단일 3차원 굴절률 영상에서는 약 82.5%의 정확도로 균종 판별이 가능했다. 연구팀은 또한 여러 영상을 확보할 수 있을 때 정확도가 증가해, 7개의 박테리아 영상이 확보된다면 99.9%의 정확도를 얻을 수 있었다.

연구진의 책임자이자 논문의 교신저자인 박용근 교수는 "홀로그래피 현미경의 세포 감별 능력을 인공지능으로 극대화해 감염 진단 기술로서의 가능성을 확인한 것이 의미ˮ라고 말했다. 제1 저자인 물리학과 김건 박사과정 학생은 "100,000분의 1 수준의 표본량으로도 질량 분석기의 균종 검출률과 비슷한 정확도를 얻었고 환자 시편에서 다양한 병원균을 식별하는 플랫폼 기술이 될 것으로 기대된다ˮ라고 덧붙였다.

이번 연구는 KAIST-삼성서울병원-토모큐브 팀의 수년간의 공동 연구를 통해 진행됐다. 물리학과 박용근 교수 연구팀의 기술에 다양한 기관의 경험과 비전을 반영함으로써 완성할 수 있었다. 삼성서울병원 진단검사의학과 이남용 교수, 진단검사의학과 허희재 교수, 감염내과 정두련 교수 연구팀, 서울성모병원 진단검사의학과 유인영 교수, 분당 차병원 응급의학과 김규석 교수, 우리 대학 나노과학기술대학원 정현정 교수 등 다양한 분야와 기관이 모여, 실험적 검증을 효과적으로 진행할 수 있었다. 또한 KAIST 교원 창업 기업인 ㈜토모큐브의 3차원 홀로그래피 기술 지원도 필수적인 역할을 했다.

한편 이번 연구는 한국연구재단 창의연구사업, 과학기술일자리진흥원의 지원을 받아 수행됐다.

2022.06.27 조회수 10657 -

고정확도 실시간 학습 가능한 모바일 인공지능 반도체 칩 세계 최초 개발

우리 대학 전기및전자공학부 유회준 교수 연구팀이 인공지능의 실시간 학습을 모바일 기기에서 구현, 고정확도 인공지능(AI: Artificial Intelligent) 반도체*를 세계 최초로 개발했다고 23일 밝혔다.

* 인공지능 반도체 : 인식·추론·학습·판단 등 인공지능 처리 기능을 탑재하고, 초지능·초저전력·초신뢰 기반의 최적화된 기술로 구현한 반도체

연구팀이 개발한 인공지능 반도체는 저비트 학습과 저지연 학습 방식을 적용해, 모바일 기기에서도 학습할 수 있다. 특히 이번 반도체 칩은 인공지능의 예상치 못한 성능 저하를 막을 수 있는 실시간 학습 기술을 성공적으로 구현했다.

전기및전자공학부 한동현 박사과정이 제1 저자로 참여한 이번 연구는 지난 6월 12일부터 15일까지 인천 연수구 송도 컨벤시아에서 개최된 국제 인공지능 회로 및 시스템 학술대회(AICAS)에서 발표됐으며 응용 예시를 현장에서 시연했고, 최우수 논문상과 최우수 데모상을 모두 석권해 그 우수성을 널리 알렸다. (논문명 : A 0.95 mJ/frame DNN Training Processor for Robust Object Detection with Real-World Environmental Adaptation (저자: 한동현, 임동석, 박광태, 김영우, 송석찬, 이주형, 유회준))

인공지능 (AI) 반도체 기술을 망라하는 국제 학술 대회 ‘AICAS 2022’는 인공지능 반도체 분야 세계 최고 권위를 가진 IEEE(미국 전기 전자 기술자 협회)학회로 평가받으며, 삼성, SK를 필두로, 한국전자통신연구원(ETRI), 엔비디아(NVIDIA), 케이던스(Cadence) 등 국내외 저명한 기업과 기관 등이 참석해 인공지능 반도체 회로와 시스템 전 분야, 인공지능 반도체와 관련된 연구성과를 공유하는 행사다.

기존 인공지능은 사전에 학습된 지능만으로 추론을 진행했기 때문에 학습하지 않은 새로운 환경 혹은 물체에 대해서는 물체 검출이 어려웠다. 하지만 유회준 교수 연구팀이 개발한 실시간 학습은 추론만 수행하던 기존 모바일 인공지능 반도체에 학습 기능을 부여함으로써, 인공지능의 지능 수준을 크게 끌어올렸다.

유 교수팀의 새로운 인공지능 반도체는 사전에 학습한 지식과 애플리케이션 수행 중에 학습한 지식을 함께 활용해 고정확도 물체검출 성능을 보였다. 특히 유회준 교수 연구팀은 렌즈가 깨지거나, 기계 오류로 인한 인공지능의 예상치 못한 정확도 감소도 자동으로 인지하고 이를 실시간 학습을 통해 보정, 기존 인공지능의 문제점을 해결했다.

유 교수팀은 실시간 학습 기능에 더해, 모바일 기기에서 저전력으로 학습이 가능할 수 있도록, 저비트 인공지능 학습 방법, 직접 오류 전사 기반 저지연 학습 방식을 제안, 이를 최적화할 수 있는 반도체(HNPU) 와 응용 시스템을 모두 개발했다.

저전력, 실시간 학습을 수행할 수 있는 모바일 인공지능 전용 반도체, HNPU는 다음과 같이 6가지 핵심 기술이 도입됐다.

○ 확률적 동적 고정 소수점 활용 저비트 학습 방식 (SDFXP: Stochastic Dynamic Fixed-point Representation)

- 동적 고정 소수점에 확률적 표현을 결합하고 확률적 반올림을 도입하여 인공지능 학습에 필요한 비트 정밀도를 최소화 할 수 있는 방법

○ 레이어별 자동 정밀도 검색 알고리즘 및 하드웨어 (LAPS: Layer-wise Adaptive Precision Scaling)

- 학습의 난이도를 자동으로 파악하고 심층신경망의 레이어별로 최적의 비트수를 자동으로 찾아주는 알고리즘 및 이를 가속하는 하드웨어

○ 입력 비트 슬라이스 희소성 활용* (ISS: Input Slice Skipping or Bit-slice Level Sparsity Exploitation)

- 데이터를 이진수로 표현했을 때 중간중간 나타나는 ‘0’ 비트를 활용하여, 데이터 처리량을 높이는 방식

○ 내재적 순수 난수 생성기 (iTRNG: Intrinsic True Random Number Generator)

인공지능 연산을 활용한 순수 난수 생성기를 설계, 데이터의 암호화 및 확률적 반올림을 구현

○ 다중 학습 단계 할당을 통한 고속 학습 알고리즘 및 하드웨어 (MLTA: Multi Learning Task Allocation & Backward Unlocking)

기존 역전파 (Back-propagation) 알고리즘에서 탈피해, 직접 오류 전사를 통한 저지연 학습 구현

○ 실시간 인공지능 학습 기반 자동 오류 검출 기능 저하 보정 시스템 개발 (Real-time DNN Training based Automatic Performance Monitor and Performance Recovery System)

평상시 물체 검출 결과를 주기적으로 모니터링하면서, 갑작스러운 확률 변화를 자동으로 인식, 정확도 저하를 보정하기 위해 실시간 학습을 적용

* 희소성 활용 (Sparsity Exploitation) : 심층 신경망 모델의 연산은 수많은 곱셈누적(MAC: Multiply-And-Accumulate)연산의 연속이다. 연산자에 0이 존재할 시, 굳이 연산을 해보지 않아도 결과는 0임을 알기에 이를 뛰어넘는 방식으로 연산 속도를 높이는 방식.

이러한 기술을 사용해 HNPU는 저전력 물체검출을 구현하여, 다른 모바일 물체검출 시스템과 비교해 75% 높은 속도, 44% 낮은 에너지 소모를 달성하면서도, 실시간 학습으로 고정확도 물체검출을 개발해 주목을 받았다.

연구팀은 HNPU의 활용 예시로 카메라 렌즈가 깨지거나, 기계 오류, 조명, 밝기 변화로 인공지능의 추론 능력이 떨어졌을 때, 실시간 학습을 통해 다시 정확도를 높이는 고정확도 물체검출 시스템을 개발했다. 이는 이후 자율 주행, 로봇 등 다양한 곳에 활용될 것으로 기대된다.

특히 연구팀의 HNPU 연구는 2022 국제인공지능회로및시스템학술대회(AICAS 2022)에서 발표돼, 최우수 논문상과 최우수 데모상을 모두 석권하여 그 우수성을 널리 알렸다.

연구를 주도한 KAIST 전기및전자공학부 유회준 교수는 “현재 인공지능은 사전에 학습한 지식만으로 주어진 문제를 해결하고 있으며, 이는 변화하는 환경과 상황에 맞춰 계속 학습하는 인간의 지능과 뚜렷한 차이를 보인다”라며 “이번 연구는 실시간 학습 인공지능 반도체를 통해 인공지능의 지능 수준을 사람 수준으로 한층 더 끌어올리는 연구”라고 본 연구의 의의를 밝혔다.

2022.06.23 조회수 9818

고정확도 실시간 학습 가능한 모바일 인공지능 반도체 칩 세계 최초 개발

우리 대학 전기및전자공학부 유회준 교수 연구팀이 인공지능의 실시간 학습을 모바일 기기에서 구현, 고정확도 인공지능(AI: Artificial Intelligent) 반도체*를 세계 최초로 개발했다고 23일 밝혔다.

* 인공지능 반도체 : 인식·추론·학습·판단 등 인공지능 처리 기능을 탑재하고, 초지능·초저전력·초신뢰 기반의 최적화된 기술로 구현한 반도체

연구팀이 개발한 인공지능 반도체는 저비트 학습과 저지연 학습 방식을 적용해, 모바일 기기에서도 학습할 수 있다. 특히 이번 반도체 칩은 인공지능의 예상치 못한 성능 저하를 막을 수 있는 실시간 학습 기술을 성공적으로 구현했다.

전기및전자공학부 한동현 박사과정이 제1 저자로 참여한 이번 연구는 지난 6월 12일부터 15일까지 인천 연수구 송도 컨벤시아에서 개최된 국제 인공지능 회로 및 시스템 학술대회(AICAS)에서 발표됐으며 응용 예시를 현장에서 시연했고, 최우수 논문상과 최우수 데모상을 모두 석권해 그 우수성을 널리 알렸다. (논문명 : A 0.95 mJ/frame DNN Training Processor for Robust Object Detection with Real-World Environmental Adaptation (저자: 한동현, 임동석, 박광태, 김영우, 송석찬, 이주형, 유회준))

인공지능 (AI) 반도체 기술을 망라하는 국제 학술 대회 ‘AICAS 2022’는 인공지능 반도체 분야 세계 최고 권위를 가진 IEEE(미국 전기 전자 기술자 협회)학회로 평가받으며, 삼성, SK를 필두로, 한국전자통신연구원(ETRI), 엔비디아(NVIDIA), 케이던스(Cadence) 등 국내외 저명한 기업과 기관 등이 참석해 인공지능 반도체 회로와 시스템 전 분야, 인공지능 반도체와 관련된 연구성과를 공유하는 행사다.

기존 인공지능은 사전에 학습된 지능만으로 추론을 진행했기 때문에 학습하지 않은 새로운 환경 혹은 물체에 대해서는 물체 검출이 어려웠다. 하지만 유회준 교수 연구팀이 개발한 실시간 학습은 추론만 수행하던 기존 모바일 인공지능 반도체에 학습 기능을 부여함으로써, 인공지능의 지능 수준을 크게 끌어올렸다.

유 교수팀의 새로운 인공지능 반도체는 사전에 학습한 지식과 애플리케이션 수행 중에 학습한 지식을 함께 활용해 고정확도 물체검출 성능을 보였다. 특히 유회준 교수 연구팀은 렌즈가 깨지거나, 기계 오류로 인한 인공지능의 예상치 못한 정확도 감소도 자동으로 인지하고 이를 실시간 학습을 통해 보정, 기존 인공지능의 문제점을 해결했다.

유 교수팀은 실시간 학습 기능에 더해, 모바일 기기에서 저전력으로 학습이 가능할 수 있도록, 저비트 인공지능 학습 방법, 직접 오류 전사 기반 저지연 학습 방식을 제안, 이를 최적화할 수 있는 반도체(HNPU) 와 응용 시스템을 모두 개발했다.

저전력, 실시간 학습을 수행할 수 있는 모바일 인공지능 전용 반도체, HNPU는 다음과 같이 6가지 핵심 기술이 도입됐다.

○ 확률적 동적 고정 소수점 활용 저비트 학습 방식 (SDFXP: Stochastic Dynamic Fixed-point Representation)

- 동적 고정 소수점에 확률적 표현을 결합하고 확률적 반올림을 도입하여 인공지능 학습에 필요한 비트 정밀도를 최소화 할 수 있는 방법

○ 레이어별 자동 정밀도 검색 알고리즘 및 하드웨어 (LAPS: Layer-wise Adaptive Precision Scaling)

- 학습의 난이도를 자동으로 파악하고 심층신경망의 레이어별로 최적의 비트수를 자동으로 찾아주는 알고리즘 및 이를 가속하는 하드웨어

○ 입력 비트 슬라이스 희소성 활용* (ISS: Input Slice Skipping or Bit-slice Level Sparsity Exploitation)

- 데이터를 이진수로 표현했을 때 중간중간 나타나는 ‘0’ 비트를 활용하여, 데이터 처리량을 높이는 방식

○ 내재적 순수 난수 생성기 (iTRNG: Intrinsic True Random Number Generator)

인공지능 연산을 활용한 순수 난수 생성기를 설계, 데이터의 암호화 및 확률적 반올림을 구현

○ 다중 학습 단계 할당을 통한 고속 학습 알고리즘 및 하드웨어 (MLTA: Multi Learning Task Allocation & Backward Unlocking)

기존 역전파 (Back-propagation) 알고리즘에서 탈피해, 직접 오류 전사를 통한 저지연 학습 구현

○ 실시간 인공지능 학습 기반 자동 오류 검출 기능 저하 보정 시스템 개발 (Real-time DNN Training based Automatic Performance Monitor and Performance Recovery System)

평상시 물체 검출 결과를 주기적으로 모니터링하면서, 갑작스러운 확률 변화를 자동으로 인식, 정확도 저하를 보정하기 위해 실시간 학습을 적용

* 희소성 활용 (Sparsity Exploitation) : 심층 신경망 모델의 연산은 수많은 곱셈누적(MAC: Multiply-And-Accumulate)연산의 연속이다. 연산자에 0이 존재할 시, 굳이 연산을 해보지 않아도 결과는 0임을 알기에 이를 뛰어넘는 방식으로 연산 속도를 높이는 방식.

이러한 기술을 사용해 HNPU는 저전력 물체검출을 구현하여, 다른 모바일 물체검출 시스템과 비교해 75% 높은 속도, 44% 낮은 에너지 소모를 달성하면서도, 실시간 학습으로 고정확도 물체검출을 개발해 주목을 받았다.

연구팀은 HNPU의 활용 예시로 카메라 렌즈가 깨지거나, 기계 오류, 조명, 밝기 변화로 인공지능의 추론 능력이 떨어졌을 때, 실시간 학습을 통해 다시 정확도를 높이는 고정확도 물체검출 시스템을 개발했다. 이는 이후 자율 주행, 로봇 등 다양한 곳에 활용될 것으로 기대된다.

특히 연구팀의 HNPU 연구는 2022 국제인공지능회로및시스템학술대회(AICAS 2022)에서 발표돼, 최우수 논문상과 최우수 데모상을 모두 석권하여 그 우수성을 널리 알렸다.

연구를 주도한 KAIST 전기및전자공학부 유회준 교수는 “현재 인공지능은 사전에 학습한 지식만으로 주어진 문제를 해결하고 있으며, 이는 변화하는 환경과 상황에 맞춰 계속 학습하는 인간의 지능과 뚜렷한 차이를 보인다”라며 “이번 연구는 실시간 학습 인공지능 반도체를 통해 인공지능의 지능 수준을 사람 수준으로 한층 더 끌어올리는 연구”라고 본 연구의 의의를 밝혔다.

2022.06.23 조회수 9818 -

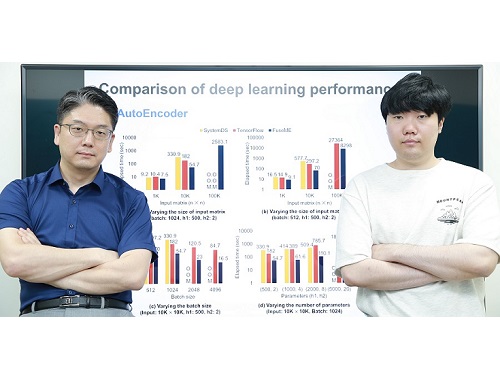

초대규모 인공지능 모델 처리하기 위한 세계 최고 성능의 기계학습 시스템 기술 개발

우리 연구진이 오늘날 인공지능 딥러닝 모델들을 처리하기 위해 필수적으로 사용되는 기계학습 시스템을 세계 최고 수준의 성능으로 끌어올렸다.

우리 대학 전산학부 김민수 교수 연구팀이 딥러닝 모델을 비롯한 기계학습 모델을 학습하거나 추론하기 위해 필수적으로 사용되는 기계학습 시스템의 성능을 대폭 높일 수 있는 세계 최고 수준의 행렬 연산자 융합 기술(일명 FuseME)을 개발했다고 20일 밝혔다.

오늘날 광범위한 산업 분야들에서 사용되고 있는 딥러닝 모델들은 대부분 구글 텐서플로우(TensorFlow)나 IBM 시스템DS와 같은 기계학습 시스템을 이용해 처리되는데, 딥러닝 모델의 규모가 점점 더 커지고, 그 모델에 사용되는 데이터의 규모가 점점 더 커짐에 따라, 이들을 원활히 처리할 수 있는 고성능 기계학습 시스템에 대한 중요성도 점점 더 커지고 있다.

일반적으로 딥러닝 모델은 행렬 곱셈, 행렬 합, 행렬 집계 등의 많은 행렬 연산자들로 구성된 방향성 비순환 그래프(Directed Acyclic Graph; 이하 DAG) 형태의 질의 계획으로 표현돼 기계학습 시스템에 의해 처리된다. 모델과 데이터의 규모가 클 때는 일반적으로 DAG 질의 계획은 수많은 컴퓨터로 구성된 클러스터에서 처리된다. 클러스터의 사양에 비해 모델과 데이터의 규모가 커지면 처리에 실패하거나 시간이 오래 걸리는 근본적인 문제가 있었다.

지금까지는 더 큰 규모의 모델이나 데이터를 처리하기 위해 단순히 컴퓨터 클러스터의 규모를 증가시키는 방식을 주로 사용했다. 그러나, 김 교수팀은 DAG 질의 계획을 구성하는 각 행렬 연산자로부터 생성되는 일종의 `중간 데이터'를 메모리에 저장하거나 네트워크 통신을 통해 다른 컴퓨터로 전송하는 것이 문제의 원인임에 착안해, 중간 데이터를 저장하지 않거나 다른 컴퓨터로 전송하지 않도록 여러 행렬 연산자들을 하나의 연산자로 융합(fusion)하는 세계 최고 성능의 융합 기술인 FuseME(Fused Matrix Engine)을 개발해 문제를 해결했다.

현재까지의 기계학습 시스템들은 낮은 수준의 연산자 융합 기술만을 사용하고 있었다. 가장 복잡한 행렬 연산자인 행렬 곱을 제외한 나머지 연산자들만 융합해 성능이 별로 개선되지 않거나, 전체 DAG 질의 계획을 단순히 하나의 연산자처럼 실행해 메모리 부족으로 처리에 실패하는 한계를 지니고 있었다.

김 교수팀이 개발한 FuseME 기술은 수십 개 이상의 행렬 연산자들로 구성되는 DAG 질의 계획에서 어떤 연산자들끼리 서로 융합하는 것이 더 우수한 성능을 내는지 비용 기반으로 판별해 그룹으로 묶고, 클러스터의 사양, 네트워크 통신 속도, 입력 데이터 크기 등을 모두 고려해 각 융합 연산자 그룹을 메모리 부족으로 처리에 실패하지 않으면서 이론적으로 최적 성능을 낼 수 있는 CFO(Cuboid-based Fused Operator)라 불리는 연산자로 융합함으로써 한계를 극복했다. 이때, 행렬 곱 연산자까지 포함해 연산자들을 융합하는 것이 핵심이다.

김민수 교수 연구팀은 FuseME 기술을 종래 최고 기술로 알려진 구글의 텐서플로우나 IBM의 시스템DS와 비교 평가한 결과, 딥러닝 모델의 처리 속도를 최대 8.8배 향상하고, 텐서플로우나 시스템DS가 처리할 수 없는 훨씬 더 큰 규모의 모델 및 데이터를 처리하는 데 성공함을 보였다. 또한, FuseME의 CFO 융합 연산자는 종래의 최고 수준 융합 연산자와 비교해 처리 속도를 최대 238배 향상시키고, 네트워크 통신 비용을 최대 64배 감소시키는 사실을 확인했다.

김 교수팀은 이미 지난 2019년에 초대규모 행렬 곱 연산에 대해 종래 세계 최고 기술이었던 IBM 시스템ML과 슈퍼컴퓨팅 분야의 스칼라팩(ScaLAPACK) 대비 성능과 처리 규모를 훨씬 향상시킨 DistME라는 기술을 개발해 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표한 바 있다. 이번 FuseME 기술은 연산자 융합이 가능하도록 DistME를 한층 더 발전시킨 것으로, 해당 분야를 세계 최고 수준의 기술력을 바탕으로 지속적으로 선도하는 쾌거를 보여준 것이다.

교신저자로 참여한 김민수 교수는 "연구팀이 개발한 새로운 기술은 딥러닝 등 기계학습 모델의 처리 규모와 성능을 획기적으로 높일 수 있어 산업적 측면에서 파급 효과가 매우 클 것으로 기대한다ˮ 라고 말했다.

이번 연구에는 김 교수의 제자이자 현재 GraphAI(그래파이) 스타트업의 공동 창업자인 한동형 박사가 제1 저자로, 김 교수가 교신저자로 참여했으며 지난 16일 미국 필라델피아에서 열린 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표됐다. (논문명 : FuseME: Distributed Matrix Computation Engine based on Cuboid-based Fused Operator and Plan Generation).

한편, 이번 연구는 한국연구재단 선도연구센터 사업 및 중견연구자 지원사업, 과기정통부 IITP SW스타랩 사업의 지원을 받아 수행됐다.

2022.06.20 조회수 8810

초대규모 인공지능 모델 처리하기 위한 세계 최고 성능의 기계학습 시스템 기술 개발

우리 연구진이 오늘날 인공지능 딥러닝 모델들을 처리하기 위해 필수적으로 사용되는 기계학습 시스템을 세계 최고 수준의 성능으로 끌어올렸다.

우리 대학 전산학부 김민수 교수 연구팀이 딥러닝 모델을 비롯한 기계학습 모델을 학습하거나 추론하기 위해 필수적으로 사용되는 기계학습 시스템의 성능을 대폭 높일 수 있는 세계 최고 수준의 행렬 연산자 융합 기술(일명 FuseME)을 개발했다고 20일 밝혔다.

오늘날 광범위한 산업 분야들에서 사용되고 있는 딥러닝 모델들은 대부분 구글 텐서플로우(TensorFlow)나 IBM 시스템DS와 같은 기계학습 시스템을 이용해 처리되는데, 딥러닝 모델의 규모가 점점 더 커지고, 그 모델에 사용되는 데이터의 규모가 점점 더 커짐에 따라, 이들을 원활히 처리할 수 있는 고성능 기계학습 시스템에 대한 중요성도 점점 더 커지고 있다.

일반적으로 딥러닝 모델은 행렬 곱셈, 행렬 합, 행렬 집계 등의 많은 행렬 연산자들로 구성된 방향성 비순환 그래프(Directed Acyclic Graph; 이하 DAG) 형태의 질의 계획으로 표현돼 기계학습 시스템에 의해 처리된다. 모델과 데이터의 규모가 클 때는 일반적으로 DAG 질의 계획은 수많은 컴퓨터로 구성된 클러스터에서 처리된다. 클러스터의 사양에 비해 모델과 데이터의 규모가 커지면 처리에 실패하거나 시간이 오래 걸리는 근본적인 문제가 있었다.

지금까지는 더 큰 규모의 모델이나 데이터를 처리하기 위해 단순히 컴퓨터 클러스터의 규모를 증가시키는 방식을 주로 사용했다. 그러나, 김 교수팀은 DAG 질의 계획을 구성하는 각 행렬 연산자로부터 생성되는 일종의 `중간 데이터'를 메모리에 저장하거나 네트워크 통신을 통해 다른 컴퓨터로 전송하는 것이 문제의 원인임에 착안해, 중간 데이터를 저장하지 않거나 다른 컴퓨터로 전송하지 않도록 여러 행렬 연산자들을 하나의 연산자로 융합(fusion)하는 세계 최고 성능의 융합 기술인 FuseME(Fused Matrix Engine)을 개발해 문제를 해결했다.

현재까지의 기계학습 시스템들은 낮은 수준의 연산자 융합 기술만을 사용하고 있었다. 가장 복잡한 행렬 연산자인 행렬 곱을 제외한 나머지 연산자들만 융합해 성능이 별로 개선되지 않거나, 전체 DAG 질의 계획을 단순히 하나의 연산자처럼 실행해 메모리 부족으로 처리에 실패하는 한계를 지니고 있었다.

김 교수팀이 개발한 FuseME 기술은 수십 개 이상의 행렬 연산자들로 구성되는 DAG 질의 계획에서 어떤 연산자들끼리 서로 융합하는 것이 더 우수한 성능을 내는지 비용 기반으로 판별해 그룹으로 묶고, 클러스터의 사양, 네트워크 통신 속도, 입력 데이터 크기 등을 모두 고려해 각 융합 연산자 그룹을 메모리 부족으로 처리에 실패하지 않으면서 이론적으로 최적 성능을 낼 수 있는 CFO(Cuboid-based Fused Operator)라 불리는 연산자로 융합함으로써 한계를 극복했다. 이때, 행렬 곱 연산자까지 포함해 연산자들을 융합하는 것이 핵심이다.

김민수 교수 연구팀은 FuseME 기술을 종래 최고 기술로 알려진 구글의 텐서플로우나 IBM의 시스템DS와 비교 평가한 결과, 딥러닝 모델의 처리 속도를 최대 8.8배 향상하고, 텐서플로우나 시스템DS가 처리할 수 없는 훨씬 더 큰 규모의 모델 및 데이터를 처리하는 데 성공함을 보였다. 또한, FuseME의 CFO 융합 연산자는 종래의 최고 수준 융합 연산자와 비교해 처리 속도를 최대 238배 향상시키고, 네트워크 통신 비용을 최대 64배 감소시키는 사실을 확인했다.

김 교수팀은 이미 지난 2019년에 초대규모 행렬 곱 연산에 대해 종래 세계 최고 기술이었던 IBM 시스템ML과 슈퍼컴퓨팅 분야의 스칼라팩(ScaLAPACK) 대비 성능과 처리 규모를 훨씬 향상시킨 DistME라는 기술을 개발해 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표한 바 있다. 이번 FuseME 기술은 연산자 융합이 가능하도록 DistME를 한층 더 발전시킨 것으로, 해당 분야를 세계 최고 수준의 기술력을 바탕으로 지속적으로 선도하는 쾌거를 보여준 것이다.

교신저자로 참여한 김민수 교수는 "연구팀이 개발한 새로운 기술은 딥러닝 등 기계학습 모델의 처리 규모와 성능을 획기적으로 높일 수 있어 산업적 측면에서 파급 효과가 매우 클 것으로 기대한다ˮ 라고 말했다.

이번 연구에는 김 교수의 제자이자 현재 GraphAI(그래파이) 스타트업의 공동 창업자인 한동형 박사가 제1 저자로, 김 교수가 교신저자로 참여했으며 지난 16일 미국 필라델피아에서 열린 데이터베이스 분야 최고 국제학술대회 중 하나인 ACM SIGMOD에서 발표됐다. (논문명 : FuseME: Distributed Matrix Computation Engine based on Cuboid-based Fused Operator and Plan Generation).

한편, 이번 연구는 한국연구재단 선도연구센터 사업 및 중견연구자 지원사업, 과기정통부 IITP SW스타랩 사업의 지원을 받아 수행됐다.

2022.06.20 조회수 8810 -

인공지능 엔진으로 영상 위변조 탐지 기술 개발

우리 연구진이 영상 내 변형 영역을 더욱 정밀하게 탐지하기 위해 영상내 색상 정보와 주파수 정보를 함께 활용하는 인공지능 엔진 기술을 학계 처음으로 개발했다. 이번 개발 기술은 기존 기술보다 정밀도와 정확도를 크게 높여 위변조 탐지 기술의 기술 유용성을 일정 수준 확보할 수 있는 기반을 제공한다는 점에서 그 의미가 크다. KAIST에서 각종 위변조 영상들을 잡아낸다는 의미를 지닌 `카이캐치(KaiCatch)' 소프트웨어는 이미지, 영상뿐만 아니라 CCTV 비디오 변형 여부도 분석할 수 있다.

우리 대학 전산학부 이흥규 교수 연구팀이 새로운 인공지능 구조와학습 방법론, 그리고 실험실 환경에서는 구하기 힘든 고급 변형 이미지 영상들을 사용해 영상 이미지 위변조 탐지 소프트웨어인 `카이캐치(KaiCatch)'의 영상 이미지 정밀도와 정확도를 크게 높일 뿐만 아니라 비디오 편집 변형도 탐지할 수 있는 카이캐치 2.1 버전을 개발했다고 13일 밝혔다.

카이캐치 소프트웨어는 `이상(異常) 유형 분석 엔진'과 `이상(異常) 영역 추정 엔진' 두 개의 인공지능 엔진으로 구성된다. `이상 유형 분석 엔진'은 블러링, 노이즈, 크기 변화, 명암 대비 변화, 모핑, 리샘플링 등을 필수 변이로 정의해 이를 탐지하며 `이상 영역 추정 엔진'은 이미지 짜깁기, 잘라 붙이기, 복사 붙이기, 복사 이동 등을 탐지한다. 이번에 새로 개발한 기술은 `이상 영역 추정 엔진'으로 기존 기술에서는 이상 영역 탐지 시 그레이 스케일(회색조)로 이상 유무를 탐지하였으나 분석 신호의 표현력이 낮고 탐지 오류가 많아 위변조 여부 판정에 어려움이 많았다. 이번에 개발된 기술은 색상 정보와 주파수 정보를 함께 활용해 정밀도(precision)와 재현율(recall)이 크게 향상되고 변형 영역을 컬러 스케일로 표현함으로써 해당 영역의 이상 유무뿐만 아니라 위변조 여부도 더욱 명확하게 판별이 가능해졌다.

연구팀은 이번 연구에서 영상 생성 시 발생하는 흔적과 압축 시 발생하는 흔적 신호들을 함께 분석하기 위해 색상 정보와 주파수 정보를 모두 활용하는 접근 방법을 학계 처음으로 제시했다. 또 이러한 방법론을 설계 구현하기 위해 주파수 정보를 하나의 분할 네트워크에서 직접 입력으로 받아들이는 방식의 ‘압축 왜곡신호 탐지 네트워크(Compression Artifact Tracing Network, 이하 CAT-Net)’을 학계 최초로 개발하고 기존 기법들과 비교해 탐지 성능이 크게 뛰어남을 입증했다. 개발한 기술은 기존에 제시된 기법들과 비교할 때 특히 원본과 변형본을 판별하는 평가 척도인 F1 점수, 평균 정밀도(average precision)에서 대단히 뛰어나 실환경 위변조 탐지 능력이 크게 강화됐다.

비디오 편집 변형의 경우도, 프레임 삭제, 추가 등에 의한 편집 변형이 흔히 CCTV 비디오 등에서 발생한다는데 착안해 이러한 비디오 편집 변형을 탐지하는 기능 역시 이번 카이캐치 2.1 버전에 탑재됐다.

이번에 카이캐치 2.1 소프트웨어를 연구 개발한 이흥규 교수는 "영상 이미지 위변조 소프트웨어인 카이캐치를 휴대폰에 탑재되는 안드로이드 앱 형태로 일반에 소개한 2021년 3월 이후 현재까지 카이캐치 앱을 통한 900여 건의 위변조 분석 의뢰와 개별적으로 60건이 넘는 정밀 위변조 분석 의뢰를 받았다. KAIST 발표 논문 수준이나 실험 결과 등을 감안할 때 위변조 분야 최고 기술로 만든 소프트웨어인데, 오탐지율이 높아 실제 탐지 정밀도가 이론치보다 매우 낮았다. 많은 경우 위변조나 변형 여부에 대한 명확한 기술 판정이 불가능했으나 이번에 개발한 카이캐치 2.1 은 CAT-Net이라는 새로운 네트워크 구조와 학습 방법론, 그리고 ‘색상 및 주파수 영역 왜곡 흔적 동시 분석’이라는 첨단 기술을 사용해 정밀도를 높여, 보다 명확한 판별이 가능하도록 개발됐다. 앞으로 영상 위변조 판단 여부가 어려운 경우가 많이 줄어들기를 기대한다”고 말했다.

이 교수는 이어 "비디오는 MP4 파일 포맷이, 그리고 영상 이미지는 JPEG 이미지들이 일반인들이 널리 사용한다는 점에서 해당 포맷을 주 개발 대상으로 삼았다. 영상 이미지의 경우 영상 편집 변형 시 영상에 남겨지는 인위적으로 발생하는 JPEG 압축 미세 신호 탐지에 주안점을 두어, 위변조 여부와 위변조 영역을 잡아내는 것에 집중했다. 비디오의 경우 특정 프레임들을 삭제하거나 삽입하는 경우, 프레임 부분 편집 후 재압축 하는 경우 등을 탐지한다. 최근 CCTV 비디오 편집 여부에 대한 분쟁이 많아 크게 도움을 줄 수 있을 것으로 기대하며 향후에도 지속적으로 연구 개발해 취약점들을 보완해 나갈 계획이다ˮ 고 덧붙였다.

현재 카이캐치 소프트웨어는 안드로이드 기반 휴대폰의 구글 플레이스토어에서 ‘카이캐치’를 검색하여 앱을 다운로드 받아 설치한 후, 영상 이미지들을 카이캐치에 업로드하면 위변조 여부를 간단하게 테스트해 볼 수 있다.

한편 이번 연구는 제1 저자로 참여한 우리 대학 전기및전자공학부 권명준 박사, 그리고 김창익 교수, 남승훈 박사, 유인재 박사 등과 공동으로 수행됐으며, `스프링거 네이처(Springer Nature)'에서 발간하는 컴퓨터 비전 분야 톱 국제저널인 `국제 컴퓨터 비전 저널(International Journal of Computer Vision, IF 7.410)'에 2022년 5월 25일 字 온라인판에 게재됐다. (논문명 : Learning JPEG Compression Artifacts for Image Manipulation Detection and Localization)

이번 연구는 한국연구재단 창의도전연구기반지원사업지원과 KAIST 창업기업인 ㈜디지탈이노텍(http://www.kaicatch.com/) 과의 산학협력 연구로 수행됐다.

2022.06.13 조회수 12227

인공지능 엔진으로 영상 위변조 탐지 기술 개발

우리 연구진이 영상 내 변형 영역을 더욱 정밀하게 탐지하기 위해 영상내 색상 정보와 주파수 정보를 함께 활용하는 인공지능 엔진 기술을 학계 처음으로 개발했다. 이번 개발 기술은 기존 기술보다 정밀도와 정확도를 크게 높여 위변조 탐지 기술의 기술 유용성을 일정 수준 확보할 수 있는 기반을 제공한다는 점에서 그 의미가 크다. KAIST에서 각종 위변조 영상들을 잡아낸다는 의미를 지닌 `카이캐치(KaiCatch)' 소프트웨어는 이미지, 영상뿐만 아니라 CCTV 비디오 변형 여부도 분석할 수 있다.

우리 대학 전산학부 이흥규 교수 연구팀이 새로운 인공지능 구조와학습 방법론, 그리고 실험실 환경에서는 구하기 힘든 고급 변형 이미지 영상들을 사용해 영상 이미지 위변조 탐지 소프트웨어인 `카이캐치(KaiCatch)'의 영상 이미지 정밀도와 정확도를 크게 높일 뿐만 아니라 비디오 편집 변형도 탐지할 수 있는 카이캐치 2.1 버전을 개발했다고 13일 밝혔다.

카이캐치 소프트웨어는 `이상(異常) 유형 분석 엔진'과 `이상(異常) 영역 추정 엔진' 두 개의 인공지능 엔진으로 구성된다. `이상 유형 분석 엔진'은 블러링, 노이즈, 크기 변화, 명암 대비 변화, 모핑, 리샘플링 등을 필수 변이로 정의해 이를 탐지하며 `이상 영역 추정 엔진'은 이미지 짜깁기, 잘라 붙이기, 복사 붙이기, 복사 이동 등을 탐지한다. 이번에 새로 개발한 기술은 `이상 영역 추정 엔진'으로 기존 기술에서는 이상 영역 탐지 시 그레이 스케일(회색조)로 이상 유무를 탐지하였으나 분석 신호의 표현력이 낮고 탐지 오류가 많아 위변조 여부 판정에 어려움이 많았다. 이번에 개발된 기술은 색상 정보와 주파수 정보를 함께 활용해 정밀도(precision)와 재현율(recall)이 크게 향상되고 변형 영역을 컬러 스케일로 표현함으로써 해당 영역의 이상 유무뿐만 아니라 위변조 여부도 더욱 명확하게 판별이 가능해졌다.

연구팀은 이번 연구에서 영상 생성 시 발생하는 흔적과 압축 시 발생하는 흔적 신호들을 함께 분석하기 위해 색상 정보와 주파수 정보를 모두 활용하는 접근 방법을 학계 처음으로 제시했다. 또 이러한 방법론을 설계 구현하기 위해 주파수 정보를 하나의 분할 네트워크에서 직접 입력으로 받아들이는 방식의 ‘압축 왜곡신호 탐지 네트워크(Compression Artifact Tracing Network, 이하 CAT-Net)’을 학계 최초로 개발하고 기존 기법들과 비교해 탐지 성능이 크게 뛰어남을 입증했다. 개발한 기술은 기존에 제시된 기법들과 비교할 때 특히 원본과 변형본을 판별하는 평가 척도인 F1 점수, 평균 정밀도(average precision)에서 대단히 뛰어나 실환경 위변조 탐지 능력이 크게 강화됐다.

비디오 편집 변형의 경우도, 프레임 삭제, 추가 등에 의한 편집 변형이 흔히 CCTV 비디오 등에서 발생한다는데 착안해 이러한 비디오 편집 변형을 탐지하는 기능 역시 이번 카이캐치 2.1 버전에 탑재됐다.

이번에 카이캐치 2.1 소프트웨어를 연구 개발한 이흥규 교수는 "영상 이미지 위변조 소프트웨어인 카이캐치를 휴대폰에 탑재되는 안드로이드 앱 형태로 일반에 소개한 2021년 3월 이후 현재까지 카이캐치 앱을 통한 900여 건의 위변조 분석 의뢰와 개별적으로 60건이 넘는 정밀 위변조 분석 의뢰를 받았다. KAIST 발표 논문 수준이나 실험 결과 등을 감안할 때 위변조 분야 최고 기술로 만든 소프트웨어인데, 오탐지율이 높아 실제 탐지 정밀도가 이론치보다 매우 낮았다. 많은 경우 위변조나 변형 여부에 대한 명확한 기술 판정이 불가능했으나 이번에 개발한 카이캐치 2.1 은 CAT-Net이라는 새로운 네트워크 구조와 학습 방법론, 그리고 ‘색상 및 주파수 영역 왜곡 흔적 동시 분석’이라는 첨단 기술을 사용해 정밀도를 높여, 보다 명확한 판별이 가능하도록 개발됐다. 앞으로 영상 위변조 판단 여부가 어려운 경우가 많이 줄어들기를 기대한다”고 말했다.

이 교수는 이어 "비디오는 MP4 파일 포맷이, 그리고 영상 이미지는 JPEG 이미지들이 일반인들이 널리 사용한다는 점에서 해당 포맷을 주 개발 대상으로 삼았다. 영상 이미지의 경우 영상 편집 변형 시 영상에 남겨지는 인위적으로 발생하는 JPEG 압축 미세 신호 탐지에 주안점을 두어, 위변조 여부와 위변조 영역을 잡아내는 것에 집중했다. 비디오의 경우 특정 프레임들을 삭제하거나 삽입하는 경우, 프레임 부분 편집 후 재압축 하는 경우 등을 탐지한다. 최근 CCTV 비디오 편집 여부에 대한 분쟁이 많아 크게 도움을 줄 수 있을 것으로 기대하며 향후에도 지속적으로 연구 개발해 취약점들을 보완해 나갈 계획이다ˮ 고 덧붙였다.

현재 카이캐치 소프트웨어는 안드로이드 기반 휴대폰의 구글 플레이스토어에서 ‘카이캐치’를 검색하여 앱을 다운로드 받아 설치한 후, 영상 이미지들을 카이캐치에 업로드하면 위변조 여부를 간단하게 테스트해 볼 수 있다.

한편 이번 연구는 제1 저자로 참여한 우리 대학 전기및전자공학부 권명준 박사, 그리고 김창익 교수, 남승훈 박사, 유인재 박사 등과 공동으로 수행됐으며, `스프링거 네이처(Springer Nature)'에서 발간하는 컴퓨터 비전 분야 톱 국제저널인 `국제 컴퓨터 비전 저널(International Journal of Computer Vision, IF 7.410)'에 2022년 5월 25일 字 온라인판에 게재됐다. (논문명 : Learning JPEG Compression Artifacts for Image Manipulation Detection and Localization)

이번 연구는 한국연구재단 창의도전연구기반지원사업지원과 KAIST 창업기업인 ㈜디지탈이노텍(http://www.kaicatch.com/) 과의 산학협력 연구로 수행됐다.

2022.06.13 조회수 12227 -

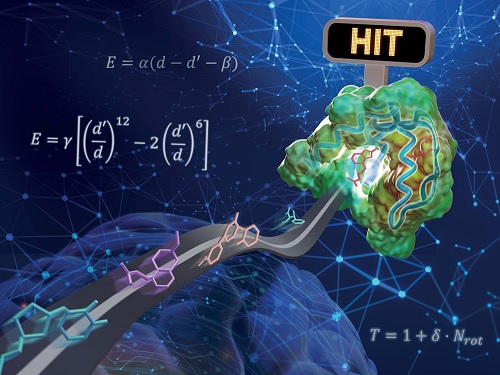

실제 약물로 개발되는 단백질-리간드 상호작용 예측 인공지능 모델 개발

우리 대학 연구진이 물리화학적 아이디어를 인공지능 딥러닝에 접목해 기존의 방법보다 일반화 성능이 높은 단백질-리간드 상호작용 예측 모델을 개발했다. 리간드란 수용체와 같은 큰 생체 분자에 특이적으로 결합하는 물질을 말하며, 생체 내의 중요한 요소이자 의약품의 개발 등에 큰 역할을 한다.

화학과 김우연 교수 연구팀이 교원창업 인공지능 신약 개발 스타트업 HITS 연구진과 함께 물리 기반 삼차원 그래프 심층 신경망을 이용해 일반화 성능을 높인 단백질-리간드 상호작용 예측 모델을 개발했다고 17일 밝혔다.

약물 후보 분자를 발굴하기 위해서 타깃 단백질과 강하게 결합하는 리간드를 찾는 것이 중요하다. 하지만 유효 물질을 찾기 위해 수백만에서 수천만 개의 무작위 리간드 라이브러리를 대상으로 실험 전수 조사를 수행하는 것은 천문학적인 시간과 비용이 필요하다. 이러한 시간과 비용을 절감하기 위해 최근 단백질-리간드 상호작용 예측에 기반한 가상탐색(virtual screening) 기술이 주목받고 있다.

기존의 상호작용 예측 인공지능 모델들은 학습에 사용한 구조에 대해서는 높은 예측 성능을 보여주지만, 새로운 단백질 구조에 대해서는 낮은 성능을 보이는 과적합(over-fitting)이 문제가 됐다. 과적합 문제는 일반적으로 모델의 복잡도에 비해 데이터가 적을 때 발생한다. 이번 연구는 이러한 과적합 문제를 해결함으로써 다양한 단백질에 대해 고른 성능을 보여주는 예측 모델을 개발하는데 주안점을 뒀다.

연구진은 물리화학적 아이디어들을 딥러닝 모델에 적용해 모델의 복잡도를 줄임과 동시에 물리 시뮬레이션을 통해 부족한 데이터를 보강함으로써 과적합 문제를 해결하고자 하였다. 단백질 원자와 리간드 원자 사이의 거리에 따른 반데르발스 힘, 수소 결합력 등을 물리화학적 방정식으로 모델링하고, 매개변수를 딥러닝으로 예측함으로써 물리 법칙을 만족하는 예측을 가능하게 했다.

또한, 학습에 사용한 단백질-리간드 결정 구조가 실험적으로 판명된 가장 안정한 구조임에 착안했다. 부족한 실험 데이터를 보강하기 위해 불안정한 단백질-리간드 구조로 이루어진 수십만 개의 인공 데이터를 생성해 학습에 활용했고, 그 결과 생성된 구조에 비해 실제 구조를 안정하게 예측하도록 모델을 학습할 수 있었다.

연구진은 개발된 모델의 성능을 검증하기 위해 대조군으로 `CASF-2016 벤치마크'를 활용했다. 이 벤치마크는 다양한 단백질-리간드 구조들 사이에서 실험적으로 판명된 결정 구조에 근접한 구조를 찾는 도킹과 상대적으로 결합력이 큰 단백질-리간드 쌍을 찾는 스크리닝 등 실제 약물을 개발하는 과정에 필수적인 과제를 포함하고 있다. 검증 테스트 결과 기존에 보고된 기술에 비해 높은 도킹 및 스크리닝 성공률을 보여줬으며, 특히 스크리닝 성능은 기존에 보고된 최고 성능 대비 약 두 배 높은 수치를 보였다.

연구진이 개발한 물리 기반 딥러닝 방법론의 또 다른 장점은 예측의 결과를 물리적으로 해석 가능하다는 것이다. 이는 딥러닝으로 최적화된 물리화학 식을 통해 최종 상호작용 값을 예측하기 때문이다. 리간드 분자 내 원자별 상호작용 에너지의 기여도를 분석함으로써 어떤 작용기가 단백질-리간드 결합에 있어서 중요한 역할을 했는지 파악할 수 있으며, 이와 같은 정보는 추후 약물 설계를 통해 성능을 높이는 데 직접 활용할 수 있다.

공동 제1 저자로 참여한 화학과 문석현, 정원호, 양수정(현재 MIT 박사과정) 박사과정 학생들은 "데이터가 적은 화학 및 바이오 분야에서 일반화 문제는 항상 중요한 문제로 강조돼왔다ˮ며 "이번 연구에서 사용한 물리 기반 딥러닝 방법론은 단백질-리간드 간 상호작용 예측 뿐 아니라 다양한 물리 문제에 적용될 수 있을 것ˮ이라고 말했다.

한국연구재단의 지원을 받아 수행된 이번 연구는 국제 학술지 `Chemical Science(IF=9.825)' 2022년 4월 13호에 표지 논문 및 `금주의 논문(Pick of the Week)'으로 선정됐다. (논문명 : PIGNet: a physics-informed deep learning model toward generalized drug–target interaction predictions, 논문 링크 : https://doi.org/10.1039/D1SC06946B)

2022.05.17 조회수 15715

실제 약물로 개발되는 단백질-리간드 상호작용 예측 인공지능 모델 개발

우리 대학 연구진이 물리화학적 아이디어를 인공지능 딥러닝에 접목해 기존의 방법보다 일반화 성능이 높은 단백질-리간드 상호작용 예측 모델을 개발했다. 리간드란 수용체와 같은 큰 생체 분자에 특이적으로 결합하는 물질을 말하며, 생체 내의 중요한 요소이자 의약품의 개발 등에 큰 역할을 한다.

화학과 김우연 교수 연구팀이 교원창업 인공지능 신약 개발 스타트업 HITS 연구진과 함께 물리 기반 삼차원 그래프 심층 신경망을 이용해 일반화 성능을 높인 단백질-리간드 상호작용 예측 모델을 개발했다고 17일 밝혔다.

약물 후보 분자를 발굴하기 위해서 타깃 단백질과 강하게 결합하는 리간드를 찾는 것이 중요하다. 하지만 유효 물질을 찾기 위해 수백만에서 수천만 개의 무작위 리간드 라이브러리를 대상으로 실험 전수 조사를 수행하는 것은 천문학적인 시간과 비용이 필요하다. 이러한 시간과 비용을 절감하기 위해 최근 단백질-리간드 상호작용 예측에 기반한 가상탐색(virtual screening) 기술이 주목받고 있다.

기존의 상호작용 예측 인공지능 모델들은 학습에 사용한 구조에 대해서는 높은 예측 성능을 보여주지만, 새로운 단백질 구조에 대해서는 낮은 성능을 보이는 과적합(over-fitting)이 문제가 됐다. 과적합 문제는 일반적으로 모델의 복잡도에 비해 데이터가 적을 때 발생한다. 이번 연구는 이러한 과적합 문제를 해결함으로써 다양한 단백질에 대해 고른 성능을 보여주는 예측 모델을 개발하는데 주안점을 뒀다.

연구진은 물리화학적 아이디어들을 딥러닝 모델에 적용해 모델의 복잡도를 줄임과 동시에 물리 시뮬레이션을 통해 부족한 데이터를 보강함으로써 과적합 문제를 해결하고자 하였다. 단백질 원자와 리간드 원자 사이의 거리에 따른 반데르발스 힘, 수소 결합력 등을 물리화학적 방정식으로 모델링하고, 매개변수를 딥러닝으로 예측함으로써 물리 법칙을 만족하는 예측을 가능하게 했다.

또한, 학습에 사용한 단백질-리간드 결정 구조가 실험적으로 판명된 가장 안정한 구조임에 착안했다. 부족한 실험 데이터를 보강하기 위해 불안정한 단백질-리간드 구조로 이루어진 수십만 개의 인공 데이터를 생성해 학습에 활용했고, 그 결과 생성된 구조에 비해 실제 구조를 안정하게 예측하도록 모델을 학습할 수 있었다.

연구진은 개발된 모델의 성능을 검증하기 위해 대조군으로 `CASF-2016 벤치마크'를 활용했다. 이 벤치마크는 다양한 단백질-리간드 구조들 사이에서 실험적으로 판명된 결정 구조에 근접한 구조를 찾는 도킹과 상대적으로 결합력이 큰 단백질-리간드 쌍을 찾는 스크리닝 등 실제 약물을 개발하는 과정에 필수적인 과제를 포함하고 있다. 검증 테스트 결과 기존에 보고된 기술에 비해 높은 도킹 및 스크리닝 성공률을 보여줬으며, 특히 스크리닝 성능은 기존에 보고된 최고 성능 대비 약 두 배 높은 수치를 보였다.

연구진이 개발한 물리 기반 딥러닝 방법론의 또 다른 장점은 예측의 결과를 물리적으로 해석 가능하다는 것이다. 이는 딥러닝으로 최적화된 물리화학 식을 통해 최종 상호작용 값을 예측하기 때문이다. 리간드 분자 내 원자별 상호작용 에너지의 기여도를 분석함으로써 어떤 작용기가 단백질-리간드 결합에 있어서 중요한 역할을 했는지 파악할 수 있으며, 이와 같은 정보는 추후 약물 설계를 통해 성능을 높이는 데 직접 활용할 수 있다.

공동 제1 저자로 참여한 화학과 문석현, 정원호, 양수정(현재 MIT 박사과정) 박사과정 학생들은 "데이터가 적은 화학 및 바이오 분야에서 일반화 문제는 항상 중요한 문제로 강조돼왔다ˮ며 "이번 연구에서 사용한 물리 기반 딥러닝 방법론은 단백질-리간드 간 상호작용 예측 뿐 아니라 다양한 물리 문제에 적용될 수 있을 것ˮ이라고 말했다.

한국연구재단의 지원을 받아 수행된 이번 연구는 국제 학술지 `Chemical Science(IF=9.825)' 2022년 4월 13호에 표지 논문 및 `금주의 논문(Pick of the Week)'으로 선정됐다. (논문명 : PIGNet: a physics-informed deep learning model toward generalized drug–target interaction predictions, 논문 링크 : https://doi.org/10.1039/D1SC06946B)

2022.05.17 조회수 15715 -

두뇌 신경 조율 활동을 모방한 저전력 인공지능 하드웨어 핵심기술 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 두뇌에서 일어나는 신경 조율 활동을 구현한 인공지능용 하드웨어와 관련 알고리즘의 개발에 성공했다고 19일 밝혔다.

4차 산업 혁명 시대를 맞아 인공지능 기술(Artificial Intelligence; AI)의 연구가 활발해지고 이에 따라 인공지능 기반 전자기기들의 개발 및 제품 출시가 가속화되고 있다. 인공지능을 전자기기에서 구현하기 위해서 맞춤형 하드웨어의 개발 또한 뒷받침돼야 하는데, 현재 대부분의 인공 지능용 전자기기들은 많은 연산량을 수행하기 위해 높은 전력 소모와 고도로 집적된 메모리 배열을 사용하고 있다.

인공 지능의 능력 향상을 위해 이러한 전력 소모 및 집적화 한계의 문제를 해결하는 것은 인공 지능 기술 분야의 커다란 과제이며, 인간의 뇌 활동에서 문제 해결의 단서를 찾고자 하는 노력이 계속돼왔다.

김경민 교수 연구팀은 인간의 두뇌 신경망이 신경 조율(Neuromodulation) 기능을 통해 연결 구조를 상황에 따라 지속적으로 변화시키는 것을 모방, 인공 지능을 위한 수학적 연산을 효율적으로 처리할 수 있는 기술을 개발했다. 두뇌에서는 학습하는 과정에서 실시간으로 신경망의 연결도를 변경해 필요에 따라 기억을 저장하거나 불러내는데, 이러한 신경 조율 기능을 하드웨어에서 직접 구현하는 새로운 방식의 인공 지능 학습 방식을 제시한 것이다.

연구팀은 개발된 기술의 효율성을 증명하기 위해 독자적인 전자 시냅스 소자가 탑재된 인공 신경망 하드웨어를 제작했으며, 여기에 개발한 알고리즘을 적용해 실제 인공지능 학습을 진행했고, 그 결과 인공지능 학습에 필요한 에너지를 37% 절약할 수 있었다.

공동 제1 저자인 신소재공학과 정운형 박사과정과 전재범 박사과정은 "인간의 두뇌는 생존을 위해 에너지 소모를 최소화하는 방향으로 진화해왔다. 이번 연구에서는 간단한 회로의 구성만으로 인간 두뇌의 학습 방식을 구현하였으며, 이를 통해 40%에 가까운 에너지를 줄일 수 있었다, 이는 범용성 있게 모든 SNN(스파이킹 뉴럴 네트워크) 인공 신경망에서 사용 가능한 장점을 가진다ˮ며 "뇌 활동을 모방해 개발한 새로운 학습 방식의 착안은 앞으로 인공 지능 분야의 소프트웨어·하드웨어 분야가 나아가야 할 길의 이정표가 될 것이다ˮ라고 말했다.

이러한 두뇌 신경 활동을 모방한 학습 알고리즘은 기존 전자기기 및 상용화된 반도체 하드웨어에 적용 및 호환을 할 수 있으며 차세대 인공 지능용 반도체 칩의 설계에 사용할 수 있을 것으로 기대된다.

이번 연구는 국제 학술지 `어드밴스드 펑셔널 머터리얼즈(Advanced Functional Materials)'에 지난 3월 31일 자에 게재됐으며 한국연구재단, ㈜SK Hynix, 나노종합기술원(NNFC) 및 KAIST의 지원을 받아 수행됐다. (논문명: Demonstration of Neuromodulation-inspired Stashing System for Energy-efficient Learning of Spiking Neural Network using a Self-Rectifying Memristor Array)

2022.04.19 조회수 13875

두뇌 신경 조율 활동을 모방한 저전력 인공지능 하드웨어 핵심기술 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 두뇌에서 일어나는 신경 조율 활동을 구현한 인공지능용 하드웨어와 관련 알고리즘의 개발에 성공했다고 19일 밝혔다.

4차 산업 혁명 시대를 맞아 인공지능 기술(Artificial Intelligence; AI)의 연구가 활발해지고 이에 따라 인공지능 기반 전자기기들의 개발 및 제품 출시가 가속화되고 있다. 인공지능을 전자기기에서 구현하기 위해서 맞춤형 하드웨어의 개발 또한 뒷받침돼야 하는데, 현재 대부분의 인공 지능용 전자기기들은 많은 연산량을 수행하기 위해 높은 전력 소모와 고도로 집적된 메모리 배열을 사용하고 있다.

인공 지능의 능력 향상을 위해 이러한 전력 소모 및 집적화 한계의 문제를 해결하는 것은 인공 지능 기술 분야의 커다란 과제이며, 인간의 뇌 활동에서 문제 해결의 단서를 찾고자 하는 노력이 계속돼왔다.

김경민 교수 연구팀은 인간의 두뇌 신경망이 신경 조율(Neuromodulation) 기능을 통해 연결 구조를 상황에 따라 지속적으로 변화시키는 것을 모방, 인공 지능을 위한 수학적 연산을 효율적으로 처리할 수 있는 기술을 개발했다. 두뇌에서는 학습하는 과정에서 실시간으로 신경망의 연결도를 변경해 필요에 따라 기억을 저장하거나 불러내는데, 이러한 신경 조율 기능을 하드웨어에서 직접 구현하는 새로운 방식의 인공 지능 학습 방식을 제시한 것이다.

연구팀은 개발된 기술의 효율성을 증명하기 위해 독자적인 전자 시냅스 소자가 탑재된 인공 신경망 하드웨어를 제작했으며, 여기에 개발한 알고리즘을 적용해 실제 인공지능 학습을 진행했고, 그 결과 인공지능 학습에 필요한 에너지를 37% 절약할 수 있었다.

공동 제1 저자인 신소재공학과 정운형 박사과정과 전재범 박사과정은 "인간의 두뇌는 생존을 위해 에너지 소모를 최소화하는 방향으로 진화해왔다. 이번 연구에서는 간단한 회로의 구성만으로 인간 두뇌의 학습 방식을 구현하였으며, 이를 통해 40%에 가까운 에너지를 줄일 수 있었다, 이는 범용성 있게 모든 SNN(스파이킹 뉴럴 네트워크) 인공 신경망에서 사용 가능한 장점을 가진다ˮ며 "뇌 활동을 모방해 개발한 새로운 학습 방식의 착안은 앞으로 인공 지능 분야의 소프트웨어·하드웨어 분야가 나아가야 할 길의 이정표가 될 것이다ˮ라고 말했다.

이러한 두뇌 신경 활동을 모방한 학습 알고리즘은 기존 전자기기 및 상용화된 반도체 하드웨어에 적용 및 호환을 할 수 있으며 차세대 인공 지능용 반도체 칩의 설계에 사용할 수 있을 것으로 기대된다.

이번 연구는 국제 학술지 `어드밴스드 펑셔널 머터리얼즈(Advanced Functional Materials)'에 지난 3월 31일 자에 게재됐으며 한국연구재단, ㈜SK Hynix, 나노종합기술원(NNFC) 및 KAIST의 지원을 받아 수행됐다. (논문명: Demonstration of Neuromodulation-inspired Stashing System for Energy-efficient Learning of Spiking Neural Network using a Self-Rectifying Memristor Array)

2022.04.19 조회수 13875