%EB%B9%84%EB%94%94%EC%98%A4

-

차세대 새로운 패러다임 동영상 인식기술 개발

챗GPT와 같은 거대 언어 모델의 근간이 되는 트랜스포머로 구축된 기존 비디오 모델보다 8배 낮은 연산량과 4배 낮은 메모리 사용량으로도 높은 정확도를 기록했으며, 추론 속도 또한 기존 트랜스포머 기반 모델 대비 4배의 매우 빠른 속도를 달성한 동영상 인식기술이 우리 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 김창익 교수 연구팀이 초고효율 동영상 인식 모델 ‘비디오맘바(VideoMamba)’를 개발했다고 23일 밝혔다.

비디오맘바는 기존 트랜스포머 기반 모델들이 가지고 있는 높은 계산 복잡성을 해결하기 위해 설계된 새로운 동영상 인식 모델이다. 기존의 트랜스포머 기반 모델들은 셀프-어텐션(self-attention)이라는 메커니즘에 의존해 계산 복잡도가 제곱으로 증가하는 문제를 가지고 있었다.

김창익 교수 연구팀의 비디오맘바는 선택적 상태 공간 모델(Selective State Space Model, Selective SSM)* 메커니즘을 활용해 선형 복잡도**로 효율적인 처리가 가능하다. 이를 통해 비디오맘바는 동영상의 시공간적 정보를 효과적으로 포착해 긴 종속성을 가진 동영상 데이터도 효율적으로 처리할 수 있다.

*선택적 상태 공간 모델(Selective SSM): 입력에 따라 동적으로 매개변수를 조정하여 시퀀스 데이터의 문맥을 더 잘 이해하는 상태 공간 모델

**선형 복잡도:입력 데이터의 크기에 비례하여 계산량이 증가하는 알고리즘 복잡도

김창익 교수 연구팀은 동영상 인식 모델의 효율성을 극대화하기 위해 비디오맘바에 1차원 데이터 처리에 국한된 기존 선택적 상태 공간 메커니즘을 3차원 시공간 데이터 분석이 가능하도록 고도화한 시공간적 전방 및 후방 선택적 상태 공간 모델(spatio-temporal forward and backward SSM)을 도입했다. 이 모델은 순서가 없는 공간 정보와 순차적인 시간 정보를 효과적으로 통합해 인식 성능을 향상한다. 연구팀은 다양한 동영상 인식 벤치마크에서 비디오맘바의 성능을 검증했다.

연구팀이 개발한 비디오맘바는 영상 분석이 필요한 다양한 응용 분야에서 효율적이고 실용적인 솔루션을 제공할 수 있다. 예를 들어, 자율주행에서는 주행 영상을 분석해 도로 상황을 정확하게 파악하고, 보행자와 장애물을 실시간으로 인식해 사고를 예방할 수 있다. 의료 분야에서는 수술 영상을 분석해 환자의 상태를 실시간으로 모니터링하고 긴급 상황 발생 시 신속히 대처할 수 있다. 스포츠 분야에서는 경기 중 선수들의 움직임과 전술을 분석해 전략을 개선하고, 훈련 중 피로도나 부상 가능성을 실시간으로 감지해 예방할 수 있다.

연구를 주도한 김창익 교수는 “비디오맘바의 빠른 처리 속도와 낮은 메모리 사용량, 그리고 뛰어난 성능은 우리 생활에서의 다양한 동영상 활용 분야에 큰 장점을 제공할 것이다”고 연구의 의의를 설명했다.

이번 연구에는 전기및전자공학부 박진영 석박사통합과정, 김희선 박사과정, 고강욱 박사과정이 공동 제1 저자, 김민범 박사과정이 공동 저자, 그리고 전기및전자공학부 김창익 교수가 교신 저자로 참여했다. 연구 결과는 올해 9월 이탈리아 밀라노에서 열리는 컴퓨터 비전 분야 최우수 국제 학회 중 하나인 ‘European Conference on Computer Vision(ECCV) 2024’에서 발표될 예정이다. (논문명: VideoMamba: Spatio-Temporal Selective State Space Model)

한편, 이번 연구는 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행됐다. (No. 2020-0-00153, 기계학습 모델 보안 역기능 취약점 자동 탐지 및 방어 기술 개발)

2024.07.23 조회수 1922

차세대 새로운 패러다임 동영상 인식기술 개발

챗GPT와 같은 거대 언어 모델의 근간이 되는 트랜스포머로 구축된 기존 비디오 모델보다 8배 낮은 연산량과 4배 낮은 메모리 사용량으로도 높은 정확도를 기록했으며, 추론 속도 또한 기존 트랜스포머 기반 모델 대비 4배의 매우 빠른 속도를 달성한 동영상 인식기술이 우리 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 김창익 교수 연구팀이 초고효율 동영상 인식 모델 ‘비디오맘바(VideoMamba)’를 개발했다고 23일 밝혔다.

비디오맘바는 기존 트랜스포머 기반 모델들이 가지고 있는 높은 계산 복잡성을 해결하기 위해 설계된 새로운 동영상 인식 모델이다. 기존의 트랜스포머 기반 모델들은 셀프-어텐션(self-attention)이라는 메커니즘에 의존해 계산 복잡도가 제곱으로 증가하는 문제를 가지고 있었다.

김창익 교수 연구팀의 비디오맘바는 선택적 상태 공간 모델(Selective State Space Model, Selective SSM)* 메커니즘을 활용해 선형 복잡도**로 효율적인 처리가 가능하다. 이를 통해 비디오맘바는 동영상의 시공간적 정보를 효과적으로 포착해 긴 종속성을 가진 동영상 데이터도 효율적으로 처리할 수 있다.

*선택적 상태 공간 모델(Selective SSM): 입력에 따라 동적으로 매개변수를 조정하여 시퀀스 데이터의 문맥을 더 잘 이해하는 상태 공간 모델

**선형 복잡도:입력 데이터의 크기에 비례하여 계산량이 증가하는 알고리즘 복잡도

김창익 교수 연구팀은 동영상 인식 모델의 효율성을 극대화하기 위해 비디오맘바에 1차원 데이터 처리에 국한된 기존 선택적 상태 공간 메커니즘을 3차원 시공간 데이터 분석이 가능하도록 고도화한 시공간적 전방 및 후방 선택적 상태 공간 모델(spatio-temporal forward and backward SSM)을 도입했다. 이 모델은 순서가 없는 공간 정보와 순차적인 시간 정보를 효과적으로 통합해 인식 성능을 향상한다. 연구팀은 다양한 동영상 인식 벤치마크에서 비디오맘바의 성능을 검증했다.

연구팀이 개발한 비디오맘바는 영상 분석이 필요한 다양한 응용 분야에서 효율적이고 실용적인 솔루션을 제공할 수 있다. 예를 들어, 자율주행에서는 주행 영상을 분석해 도로 상황을 정확하게 파악하고, 보행자와 장애물을 실시간으로 인식해 사고를 예방할 수 있다. 의료 분야에서는 수술 영상을 분석해 환자의 상태를 실시간으로 모니터링하고 긴급 상황 발생 시 신속히 대처할 수 있다. 스포츠 분야에서는 경기 중 선수들의 움직임과 전술을 분석해 전략을 개선하고, 훈련 중 피로도나 부상 가능성을 실시간으로 감지해 예방할 수 있다.

연구를 주도한 김창익 교수는 “비디오맘바의 빠른 처리 속도와 낮은 메모리 사용량, 그리고 뛰어난 성능은 우리 생활에서의 다양한 동영상 활용 분야에 큰 장점을 제공할 것이다”고 연구의 의의를 설명했다.

이번 연구에는 전기및전자공학부 박진영 석박사통합과정, 김희선 박사과정, 고강욱 박사과정이 공동 제1 저자, 김민범 박사과정이 공동 저자, 그리고 전기및전자공학부 김창익 교수가 교신 저자로 참여했다. 연구 결과는 올해 9월 이탈리아 밀라노에서 열리는 컴퓨터 비전 분야 최우수 국제 학회 중 하나인 ‘European Conference on Computer Vision(ECCV) 2024’에서 발표될 예정이다. (논문명: VideoMamba: Spatio-Temporal Selective State Space Model)

한편, 이번 연구는 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행됐다. (No. 2020-0-00153, 기계학습 모델 보안 역기능 취약점 자동 탐지 및 방어 기술 개발)

2024.07.23 조회수 1922 -

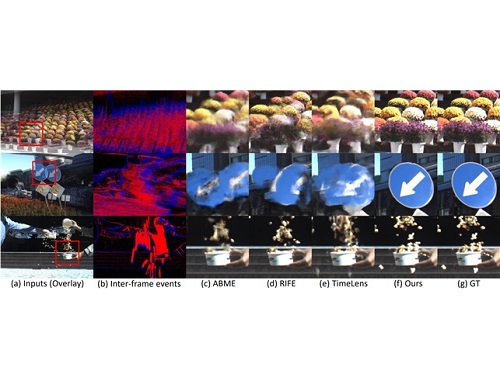

세계 최고 수준의 이벤트 카메라 기반 비디오 보간 기술 개발

비디오 보간은 비디오 사이의 새로운 프레임을 생성하여 프레임률을 높이고 비디오 내 부드러운 모션을 구현하는 기술이다. 전 세계적으로 많은 연구진이 RGB 카메라만을 사용하여 비디오 보간을 수행하였다. 하지만, 프레임 사이의 움직임 정보의 부재로 인하여 복잡한 상황에서 비디오 보간 성능의 한계를 지닌다. 특히, 현실적인 상황에서 발생하는 비선형적인 움직임에 대해서는 비디오 보간 성능이 크게 하락하는 문제점이 존재한다.

우리 대학 기계공학과 윤국진 교수팀은 인간의 시신경을 모방한 이벤트 카메라와 RGB 카메라를 동시에 사용할 수 있는 하이브리드 카메라 시스템을 구축하고 세계 최고 수준의 이벤트 카메라 기반 초고속 비디오 보간 기술을 개발했다. 본 연구는 기존의 비디오 보간 방법 대비 35% 이상의 세계 최고 성능을 달성하였고, 복잡하고 극심한 움직임 속에서도 높은 성능으로 30FPS 비디오를 10000FPS 이상의 초고속 비디오로 합성할 수 있다.

이벤트 카메라는 인간의 시신경을 모방한 카메라로서, 영상의 밝기 변화만을 감지한다. 이러한 특성으로 인하여 이벤트 카메라는 micro 초 단위의 시간 해상도와 높은 dynamic range의 정보를 제공하여 기존의 RGB 카메라가 가지지 못하는 장점을 가지고 있다. 따라서, 이벤트 카메라는 RGB video 프레임 사이의 정확한 움직임 정보를 포착할 수 있어 일반 RGB 카메라와 이벤트 카메라를 동시적으로 사용하면 정확도 높은 초고속 비디오를 생성할 수 있다.

기존의 이벤트 카메라 기반 비디오 보간 연구는 이벤트 카메라에서 나오는 이벤트 정보만을 사용하여 프레임 사이의 광학 흐름을 추정하거나 프레임 사이의 움직임을 근사하는 방법을 사용하였다. 하지만, 이벤트 정보는 공간적으로 희박하고 밝기 정보만을 기록하기 때문에 이벤트만을 사용한 광학 흐름 추정 방법의 결과가 좋지 못한 점을 연구팀은 주목했다. 이를 극복하기 위해 연구팀은 기존의 RGB 이미지와 이벤트 정보를 동시적으로 사용하는 이미지-이벤트 비대칭 양방향 움직임 추정 기법을 제안하였다. 이벤트는 풍부한 움직임의 궤적정보를 제공하는 장점과 이미지의 풍부한 시각 정보의 각 장점을 잘 융합하여 서로 다른 정보의 장단점을 보완 및 융합한 광학 흐름 추정 방법을 제안하여 그 우수성을 입증하였다.

또한, 설계 및 제작한 빔 스플리터 기반 이벤트-RGB 하이브리드 카메라 시스템을 사용하여 이벤트 카메라를 이용한 모션-기반 비디오 보간 기술 데이터셋을 구축하였다. 기존의 이벤트 카메라를 이용한 비디오 보간 데이터셋의 경우, 카메라 움직임이 존재하지 않는 문제와 낮은 프레임 레이트/해상도로 인하여 딥러닝 알고리즘의 학습 및 이벤트 카메라 기반 비디오 보간 기술 개발 및 평가에 한계점을 지닌다. 제안된 데이터셋의 경우 이벤트 카메라 기반 비디오 향상 연구 커뮤니티에 큰 기여를 할 수 있을 것으로 예상된다.

이번 연구는 고품질의 높은 프레임률을 가지는 비디오 생성이 가능하여, 기존의 초고속 카메라로 비디오 촬영이 어려운 광량이 부족한 환경 및 아주 빠른 물체의 움직임을 분석이 필요한 여러 상황 등에서 널리 사용될 수 있을 것으로 기대된다.

이번 연구는 윤국진 교수 연구실의 김태우 박사과정(제1 저자), 채유정 박사과정(제2 저자), 장현걸 석사과정(제3 저자)이 참여하였고, 올해 캐나다 밴쿠버에서 6월 18일에 열릴 컴퓨터 비전 및 패턴인식 분야의 국제 저명학술지인 CVPR 2023(IEEE Conference on Computer Vision and Pattern Recognition)에 highlight 논문(2.5% acceptance rate)으로 게재될 예정이다.

이 연구는 중견 연구자개발 과제의 지원을 받아 수행되었다. 윤국진 교수 연구팀은 다년간 이벤트 카메라에 관련된 연구를 수행해오면서 이벤트 카메라를 이용한 여러 가지 컴퓨터 비전 분야에 핵심 연구 들을 수행하여 오고 있으며, 앞으로도 이벤트 카메라 연구 커뮤니티에 이바지하기 위하여 지속적인 연구를 수행할 예정이다.

※ 논문명 : Event-based Video Frame Interpolation with Cross-Modal Asymmetric Bidirectional Motion Fields

※ 저자 정보 : 윤국진 (KAIST, 교신저자), 김태우(KAIST, 제1 저자), 채유정(KAIST, 제2 저자), 장현걸(KAIST, 제3 저자) - 총 4명

2023.04.05 조회수 4505

세계 최고 수준의 이벤트 카메라 기반 비디오 보간 기술 개발

비디오 보간은 비디오 사이의 새로운 프레임을 생성하여 프레임률을 높이고 비디오 내 부드러운 모션을 구현하는 기술이다. 전 세계적으로 많은 연구진이 RGB 카메라만을 사용하여 비디오 보간을 수행하였다. 하지만, 프레임 사이의 움직임 정보의 부재로 인하여 복잡한 상황에서 비디오 보간 성능의 한계를 지닌다. 특히, 현실적인 상황에서 발생하는 비선형적인 움직임에 대해서는 비디오 보간 성능이 크게 하락하는 문제점이 존재한다.

우리 대학 기계공학과 윤국진 교수팀은 인간의 시신경을 모방한 이벤트 카메라와 RGB 카메라를 동시에 사용할 수 있는 하이브리드 카메라 시스템을 구축하고 세계 최고 수준의 이벤트 카메라 기반 초고속 비디오 보간 기술을 개발했다. 본 연구는 기존의 비디오 보간 방법 대비 35% 이상의 세계 최고 성능을 달성하였고, 복잡하고 극심한 움직임 속에서도 높은 성능으로 30FPS 비디오를 10000FPS 이상의 초고속 비디오로 합성할 수 있다.

이벤트 카메라는 인간의 시신경을 모방한 카메라로서, 영상의 밝기 변화만을 감지한다. 이러한 특성으로 인하여 이벤트 카메라는 micro 초 단위의 시간 해상도와 높은 dynamic range의 정보를 제공하여 기존의 RGB 카메라가 가지지 못하는 장점을 가지고 있다. 따라서, 이벤트 카메라는 RGB video 프레임 사이의 정확한 움직임 정보를 포착할 수 있어 일반 RGB 카메라와 이벤트 카메라를 동시적으로 사용하면 정확도 높은 초고속 비디오를 생성할 수 있다.

기존의 이벤트 카메라 기반 비디오 보간 연구는 이벤트 카메라에서 나오는 이벤트 정보만을 사용하여 프레임 사이의 광학 흐름을 추정하거나 프레임 사이의 움직임을 근사하는 방법을 사용하였다. 하지만, 이벤트 정보는 공간적으로 희박하고 밝기 정보만을 기록하기 때문에 이벤트만을 사용한 광학 흐름 추정 방법의 결과가 좋지 못한 점을 연구팀은 주목했다. 이를 극복하기 위해 연구팀은 기존의 RGB 이미지와 이벤트 정보를 동시적으로 사용하는 이미지-이벤트 비대칭 양방향 움직임 추정 기법을 제안하였다. 이벤트는 풍부한 움직임의 궤적정보를 제공하는 장점과 이미지의 풍부한 시각 정보의 각 장점을 잘 융합하여 서로 다른 정보의 장단점을 보완 및 융합한 광학 흐름 추정 방법을 제안하여 그 우수성을 입증하였다.

또한, 설계 및 제작한 빔 스플리터 기반 이벤트-RGB 하이브리드 카메라 시스템을 사용하여 이벤트 카메라를 이용한 모션-기반 비디오 보간 기술 데이터셋을 구축하였다. 기존의 이벤트 카메라를 이용한 비디오 보간 데이터셋의 경우, 카메라 움직임이 존재하지 않는 문제와 낮은 프레임 레이트/해상도로 인하여 딥러닝 알고리즘의 학습 및 이벤트 카메라 기반 비디오 보간 기술 개발 및 평가에 한계점을 지닌다. 제안된 데이터셋의 경우 이벤트 카메라 기반 비디오 향상 연구 커뮤니티에 큰 기여를 할 수 있을 것으로 예상된다.

이번 연구는 고품질의 높은 프레임률을 가지는 비디오 생성이 가능하여, 기존의 초고속 카메라로 비디오 촬영이 어려운 광량이 부족한 환경 및 아주 빠른 물체의 움직임을 분석이 필요한 여러 상황 등에서 널리 사용될 수 있을 것으로 기대된다.

이번 연구는 윤국진 교수 연구실의 김태우 박사과정(제1 저자), 채유정 박사과정(제2 저자), 장현걸 석사과정(제3 저자)이 참여하였고, 올해 캐나다 밴쿠버에서 6월 18일에 열릴 컴퓨터 비전 및 패턴인식 분야의 국제 저명학술지인 CVPR 2023(IEEE Conference on Computer Vision and Pattern Recognition)에 highlight 논문(2.5% acceptance rate)으로 게재될 예정이다.

이 연구는 중견 연구자개발 과제의 지원을 받아 수행되었다. 윤국진 교수 연구팀은 다년간 이벤트 카메라에 관련된 연구를 수행해오면서 이벤트 카메라를 이용한 여러 가지 컴퓨터 비전 분야에 핵심 연구 들을 수행하여 오고 있으며, 앞으로도 이벤트 카메라 연구 커뮤니티에 이바지하기 위하여 지속적인 연구를 수행할 예정이다.

※ 논문명 : Event-based Video Frame Interpolation with Cross-Modal Asymmetric Bidirectional Motion Fields

※ 저자 정보 : 윤국진 (KAIST, 교신저자), 김태우(KAIST, 제1 저자), 채유정(KAIST, 제2 저자), 장현걸(KAIST, 제3 저자) - 총 4명

2023.04.05 조회수 4505 -

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 17089

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 17089 -

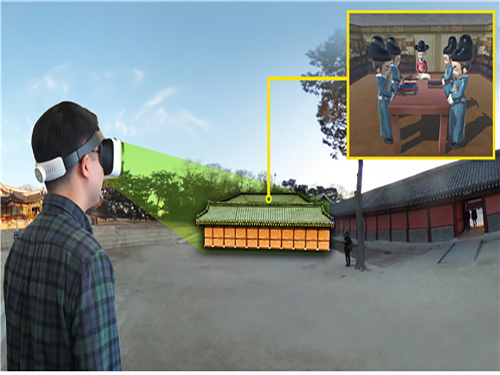

우운택 교수, 스마트 관광 증강현실 어플리케이션 개발

〈 우 운 택 교수 〉

우리 대학 문화기술대학원 우운택 교수 연구팀이 스마트 관광 지원을 위한 증강 및 가상현실 어플리케이션을 개발했다.

‘케이 컬처 타임머신(K-Culture Time Machine)’ 어플리케이션은 창덕궁을 대상으로 한 시범 서비스로 iOS 앱스토어에 5월 23일 공개됐다.

개발된 케이 컬처 타임머신은 웨어러블 360도 비디오를 통해 문화유산이나 유적지에 대한 시공간을 넘는 원격 체험을 제공한다.

사용자는 VR기기에 스마트폰을 장착해 제공되는 360도 비디오로 문화 유적지를 원격으로 체험하고 해당 문화유산 및 연관관계가 있는 인물, 장소, 사건 등에 대한 정보를 확인할 수 있다. 또한 소실된 문화유산에 대한 3차원 디지털 복원도 체험할 수 있다.

웨어러블 기기 활용 없이도 모바일 모드를 통해 사용자 주변 유적지 확인, 카메라에 인식된 문화유산을 인식하고 관련된 정보와 콘텐츠를 제공하는 증강현실 기반의 문화유산 가이드가 가능하다.

사용자는 자신의 위치에서 창덕궁 돈화문을 시작으로 인정문, 인정전, 희정당에 이르는 창덕궁 내부를 이동하며 360도 파노라마 이미지나 비디오를 통해 현장을 가상체험 할 수 있다.

현재는 존재하지 않는 인정전 동쪽의 궐내 곽사 지역에는 3D모델을 통한 승정원의 가상 복원을 확인할 수 있다.

위 기능은 웨어러블 기기 없이 스마트폰 상에서도 체험 가능하며 개발 중인 증강현실 기능이 완성되면 현장에서 활용 가능한 수준의 어플리케이션이 될 것으로 기대된다.

우 교수 연구팀은 문화유산 데이터베이스와 증강-가상현실 콘텐츠의 표준화된 메타데이터를 구축하고 이를 적용했다. 이를 활용해 일시적으로 개발 후 소비되는 기존 어플리케이션과는 달리 추가적인 콘텐츠 생성 및 추가가 가능하다.

우 교수는 “증강현실 콘텐츠의 상호 활용성과 재활용성을 증진해 스마트관광 분야의 새로운 시장을 선점할 수 있을 것이다”며 “콘텐츠 개발 비용 절감과 증강현실 콘텐츠 생태계 활성화를 가능하게 하는 다양한 부가 효과도 기대한다”고 말했다.

이번 연구는 ㈜포스트미디어(대표 홍승모)와 문화체육관광부 CT R&D 사업과의 공동 수행을 통해 이뤄졌으며, 관련 연구 성과는 올 7월 캐나다에서 진행되는 HCII 2017 학회를 통해 발표될 예정이다.

□ 그림 설명

그림1. 360 VR 서비스 개념도

그림2. K-Culture Time Machine의 모바일 증강현실 기능 구동 화면

그림3. K-Culture Time Machine의 360도 파노라마 이미지-비디오 기능 화면

2017.05.23 조회수 16393

우운택 교수, 스마트 관광 증강현실 어플리케이션 개발

〈 우 운 택 교수 〉

우리 대학 문화기술대학원 우운택 교수 연구팀이 스마트 관광 지원을 위한 증강 및 가상현실 어플리케이션을 개발했다.

‘케이 컬처 타임머신(K-Culture Time Machine)’ 어플리케이션은 창덕궁을 대상으로 한 시범 서비스로 iOS 앱스토어에 5월 23일 공개됐다.

개발된 케이 컬처 타임머신은 웨어러블 360도 비디오를 통해 문화유산이나 유적지에 대한 시공간을 넘는 원격 체험을 제공한다.

사용자는 VR기기에 스마트폰을 장착해 제공되는 360도 비디오로 문화 유적지를 원격으로 체험하고 해당 문화유산 및 연관관계가 있는 인물, 장소, 사건 등에 대한 정보를 확인할 수 있다. 또한 소실된 문화유산에 대한 3차원 디지털 복원도 체험할 수 있다.

웨어러블 기기 활용 없이도 모바일 모드를 통해 사용자 주변 유적지 확인, 카메라에 인식된 문화유산을 인식하고 관련된 정보와 콘텐츠를 제공하는 증강현실 기반의 문화유산 가이드가 가능하다.

사용자는 자신의 위치에서 창덕궁 돈화문을 시작으로 인정문, 인정전, 희정당에 이르는 창덕궁 내부를 이동하며 360도 파노라마 이미지나 비디오를 통해 현장을 가상체험 할 수 있다.

현재는 존재하지 않는 인정전 동쪽의 궐내 곽사 지역에는 3D모델을 통한 승정원의 가상 복원을 확인할 수 있다.

위 기능은 웨어러블 기기 없이 스마트폰 상에서도 체험 가능하며 개발 중인 증강현실 기능이 완성되면 현장에서 활용 가능한 수준의 어플리케이션이 될 것으로 기대된다.

우 교수 연구팀은 문화유산 데이터베이스와 증강-가상현실 콘텐츠의 표준화된 메타데이터를 구축하고 이를 적용했다. 이를 활용해 일시적으로 개발 후 소비되는 기존 어플리케이션과는 달리 추가적인 콘텐츠 생성 및 추가가 가능하다.

우 교수는 “증강현실 콘텐츠의 상호 활용성과 재활용성을 증진해 스마트관광 분야의 새로운 시장을 선점할 수 있을 것이다”며 “콘텐츠 개발 비용 절감과 증강현실 콘텐츠 생태계 활성화를 가능하게 하는 다양한 부가 효과도 기대한다”고 말했다.

이번 연구는 ㈜포스트미디어(대표 홍승모)와 문화체육관광부 CT R&D 사업과의 공동 수행을 통해 이뤄졌으며, 관련 연구 성과는 올 7월 캐나다에서 진행되는 HCII 2017 학회를 통해 발표될 예정이다.

□ 그림 설명

그림1. 360 VR 서비스 개념도

그림2. K-Culture Time Machine의 모바일 증강현실 기능 구동 화면

그림3. K-Culture Time Machine의 360도 파노라마 이미지-비디오 기능 화면

2017.05.23 조회수 16393