%ED%95%98%EB%93%9C%EC%9B%A8%EC%96%B4

-

세계 최대 컴퓨터학회에서 처음 5편 논문 발표

세계 최대 컴퓨터 학회에서 주간한 학술대회(PLDI)에서 2012년에 한국에서 처음 논문을 발표한 이래, KAIST 연구진이 처음으로 3편 이상의 논문을 발표하여 화제다.

우리 대학 전산학부 강지훈 교수, 류석영 교수 연구팀이 프로그래밍 언어 분야 최고 권위 학술대회인 PLDI에서 올해 발표될 89편의 논문 중 6.7%인 5편의 논문을 발표했다고 3일 밝혔다.

PLDI(Programming Language Design and Implementation)는 세계 최대 컴퓨터 학회인 ACM(Association for Computing Machinery)이 주관하는 학술대회로, 지난 45년간 전산학 전체에 깊은 영향을 미치는 중요한 논문이 다수 발표된 유서 깊은 학술대회다. 프로그래밍 언어와 컴파일러 등 소프트웨어 전반의 기초가 되는 핵심 기술을 발표하고 있다.

이번 학회에 발표되는 5개의 논문은 아래와 같다.

1) 멀티코어 컴퓨팅 시스템에서 동작하는 고성능 병렬 자료구조가 사용을 마친 메모리를 수집하기 위해 다양한 기법을 제안 2) 멀티코어 컴퓨팅 시스템에서 성능을 높이기 위해 운영체제, 데이터베이스 등 고성능 시스템 소프트웨어의 안전성을 현실적으로 증명할 수 있는 토대 마련 3) 시스템 반도체의 논리적인 청사진이라 할 수 있는 RTL(register-transfer level) 설계 및 검증비용을 획기적으로 줄일 수 있는 프로그래밍 언어 개발 4) 빠르지만 안정성이 취약한 C 언어로 작성된 프로그램을 더 안전한 러스트(Rust) 언어로 작성된 프로그램으로 자동 변환하는 연구 5) 산업계에서 가장 널리 사용하는 자바스크립트 프로그래밍 언어의 공식 개발 과정에 적용한 기술(https://www.kaist.ac.kr/news/html/news/?mode=V&mng_no=36610)을 기반으로 웹어셈블리 언어에 특화한 연구

강지훈 교수는 “5편의 논문은 각각 학생들이 오랫동안 정성껏 연구한 결과를 담아 뛰어난 독창성과 실용성을 동시에 갖춘 우수한 논문들”이라면서 “이 논문들이 앞으로 지속적으로 프로그래밍 언어와 인접 전산학 분야, 그리고 더 나아가서 산업계에 깊은 영향을 미칠 수 있도록 후속 연구에 정진할 것”이라고 포부를 밝혔다.

류석영 교수는 “반도체, 운영체제, 클라우드 등 인프라부터 사용자에게 제공하는 서비스까지 모두를 아우르는 풀 스택 소프트웨어를 안전하고 올바르게 동작하도록 설계하고 개발하는 세계적인 기술을 선보인 결과”라며, “소프트웨어가 이끄는 세상에서 더 안전하고 올바르게 동작하는 소프트웨어를 사용할 수 있기를 기대한다”고 말했다.

5편의 논문은 한국 시각으로 6월 21일에 PACMPL(Proceedings of the ACM on Programming Languages) 저널에 게재됐고 6월 25일부터 27일 사이에 진행된 PLDI 2024 학술대회에서 발표됐다.

(논문 제목: ① Concurrent Immediate Reference Counting, ② A Proof Recipe for Linearizability in Relaxed Memory Separation Logic, ③ Modular Hardware Design of Pipelined Circuits with Hazards, ④ Don't Write, but Return: Replacing Output Parameters with Algebraic Data Types in C-to-Rust Translation, ⑤ Bringing the WebAssembly Standard up to Speed with SpecTac)

한편 이번 연구는 한국연구재단 선도연구센터, 중견연구자지원사업 및 우수신진연구자지원사업, 정보통신기획평가원(IITP), 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

2024.07.03 조회수 5682

세계 최대 컴퓨터학회에서 처음 5편 논문 발표

세계 최대 컴퓨터 학회에서 주간한 학술대회(PLDI)에서 2012년에 한국에서 처음 논문을 발표한 이래, KAIST 연구진이 처음으로 3편 이상의 논문을 발표하여 화제다.

우리 대학 전산학부 강지훈 교수, 류석영 교수 연구팀이 프로그래밍 언어 분야 최고 권위 학술대회인 PLDI에서 올해 발표될 89편의 논문 중 6.7%인 5편의 논문을 발표했다고 3일 밝혔다.

PLDI(Programming Language Design and Implementation)는 세계 최대 컴퓨터 학회인 ACM(Association for Computing Machinery)이 주관하는 학술대회로, 지난 45년간 전산학 전체에 깊은 영향을 미치는 중요한 논문이 다수 발표된 유서 깊은 학술대회다. 프로그래밍 언어와 컴파일러 등 소프트웨어 전반의 기초가 되는 핵심 기술을 발표하고 있다.

이번 학회에 발표되는 5개의 논문은 아래와 같다.

1) 멀티코어 컴퓨팅 시스템에서 동작하는 고성능 병렬 자료구조가 사용을 마친 메모리를 수집하기 위해 다양한 기법을 제안 2) 멀티코어 컴퓨팅 시스템에서 성능을 높이기 위해 운영체제, 데이터베이스 등 고성능 시스템 소프트웨어의 안전성을 현실적으로 증명할 수 있는 토대 마련 3) 시스템 반도체의 논리적인 청사진이라 할 수 있는 RTL(register-transfer level) 설계 및 검증비용을 획기적으로 줄일 수 있는 프로그래밍 언어 개발 4) 빠르지만 안정성이 취약한 C 언어로 작성된 프로그램을 더 안전한 러스트(Rust) 언어로 작성된 프로그램으로 자동 변환하는 연구 5) 산업계에서 가장 널리 사용하는 자바스크립트 프로그래밍 언어의 공식 개발 과정에 적용한 기술(https://www.kaist.ac.kr/news/html/news/?mode=V&mng_no=36610)을 기반으로 웹어셈블리 언어에 특화한 연구

강지훈 교수는 “5편의 논문은 각각 학생들이 오랫동안 정성껏 연구한 결과를 담아 뛰어난 독창성과 실용성을 동시에 갖춘 우수한 논문들”이라면서 “이 논문들이 앞으로 지속적으로 프로그래밍 언어와 인접 전산학 분야, 그리고 더 나아가서 산업계에 깊은 영향을 미칠 수 있도록 후속 연구에 정진할 것”이라고 포부를 밝혔다.

류석영 교수는 “반도체, 운영체제, 클라우드 등 인프라부터 사용자에게 제공하는 서비스까지 모두를 아우르는 풀 스택 소프트웨어를 안전하고 올바르게 동작하도록 설계하고 개발하는 세계적인 기술을 선보인 결과”라며, “소프트웨어가 이끄는 세상에서 더 안전하고 올바르게 동작하는 소프트웨어를 사용할 수 있기를 기대한다”고 말했다.

5편의 논문은 한국 시각으로 6월 21일에 PACMPL(Proceedings of the ACM on Programming Languages) 저널에 게재됐고 6월 25일부터 27일 사이에 진행된 PLDI 2024 학술대회에서 발표됐다.

(논문 제목: ① Concurrent Immediate Reference Counting, ② A Proof Recipe for Linearizability in Relaxed Memory Separation Logic, ③ Modular Hardware Design of Pipelined Circuits with Hazards, ④ Don't Write, but Return: Replacing Output Parameters with Algebraic Data Types in C-to-Rust Translation, ⑤ Bringing the WebAssembly Standard up to Speed with SpecTac)

한편 이번 연구는 한국연구재단 선도연구센터, 중견연구자지원사업 및 우수신진연구자지원사업, 정보통신기획평가원(IITP), 삼성전자 미래기술육성센터의 지원을 받아 수행됐다.

2024.07.03 조회수 5682 -

설명해주는 인공지능 구현을 위한 초저전력 하드웨어 기술 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 다양한 멤리스터* 소자를 이용한 설명 가능한 인공지능 (XAI) 시스템을 구현하는데 성공했다고 25일 밝혔다.

*멤리스터 (Memristor): 메모리 (Memory)와 저항 (Resistor)의 합성어로, 입력 신호에 따라 소자의 저항 상태가 변하는 소자

최근 인공지능 (AI) 기술의 급속한 발전이 다양한 분야에서 성과를 이루고 있다. 이미지 인식, 음성 인식, 자연어 처리 등에서 AI의 적용 범위가 확대되며 우리의 일상생활에 깊숙이 자리 잡고 있다.

AI는 인간의 뉴런 구조를 모방해 만든 ‘인공신경망’을 기반으로, 적게는 수백만 개에서 많게는 수조 개에 달하는 매개변수를 통해 데이터를 분석하고 의사 결정을 내린다. 그러나 이 많은 매개변수로 인해 AI 모델의 동작 원리를 정확하게 이해하기 어렵고, 이는 통상적으로 블랙박스에 비유되곤 한다. AI가 어떤 기준으로 결정을 내는지 알 수 없다면, AI에 결함이나 오작동이 발생했을 때 이를 해결하기 어렵고, 이로 인해 AI가 적용되는 다양한 산업 분야에서 문제가 발생할 수 있다.

이에 대한 해답으로 제시된 것이 바로 설명 가능한 인공지능 (XAI)이다. XAI는 AI가 어떠한 결정을 내렸을 때, 그 근거가 무엇인지를 사람이 이해할 수 있도록 만드는 기술이다. <그림1> 생성형 AI 등 점점 더 복잡해지는 AI 기술의 등장으로 개발자, 사용자, 규제 기관 모두에게 XAI 시스템의 필요성이 강조되고 있다. 하지만, XAI는 일반적으로 엄청난 양의 데이터 처리를 요구하기 때문에, 이를 보다 효율적으로 동작할 수 있는 하드웨어 개발이 필요한 상황이다.

김경민 교수 연구팀은 교란(Perturbation) 기반 XAI 시스템을 서로 다른 멤리스터 소자를 이용해 하드웨어로 구현하는데 성공하였다. 세 가지 멤리스터 소자는 각각 휘발성 저항변화 특성, 아날로그 비휘발성 저항변화 특성, 아날로그 휘발성 저항변화 특성을 가지며 <그림 2>, 각 소자는 교란 기반 XAI 시스템의 필수적인 기능인 입력 데이터 교란, 벡터곱 연산, 그리고 신호 통합 기능을 수행한다.

연구팀은 개발된 XAI 하드웨어를 평가하기 위해, 흑백 패턴을 인식하는 신경망을 설계하였다. 여기에 개발한 XAI 하드웨어 시스템으로 설계한 신경망이 흑백 패턴을 인식하는 근거를 설명하였다. <그림3> 그 결과 기존 CMOS 기술 기반 시스템 대비 에너지 소비를 24배 감소하여 AI 판단의 이유를 제공하는 것을 확인하였다. <그림4>

KAIST 김경민 교수는 “AI 기술이 일상화되면서 AI 동작의 투명성 및 해석가능성이 중요해지고 있는데, 이번 연구는 다양한 종류의 멤리스터 소자를 이용해 AI 판단에 대한 근거를 제공하는 XAI 하드웨어 시스템을 구현할 수 있었다는 점에 큰 의의가 있다”며 “이 연구는 AI 의사 결정에 도달하는 과정을 이해하기 쉽게 설명을 제공함으로써 AI 시스템의 신뢰성 향상에 기여할 수 있어, 향후 의료, 금융, 법률 등 민감한 정보를 다루는 AI 기반 서비스에 적용될 수 있을 것으로 기대된다”고 밝혔다.

이번 연구는 KAIST 신소재공학과 송한찬 박사과정, 박우준 박사과정 학생이 공동 제1 저자로 참여했으며, 국제 학술지 ‘어드밴스드 머티리얼즈(Advanced Materials, IF: 29.4)’에 03월 20일 字 온라인 게재됐으며, 한국연구재단 중견연구사업, 차세대지능형반도체기술개발사업, PIM인공지능반도체핵심기술개발사업, 나노종합기술원 및 KAIST 도약연구사업의 지원을 받아 수행됐다. (논문명: Memristive Explainable Artificial Intelligence Hardware, 논문링크: https://doi.org/10.1002/adma.202400977)

2024.03.25 조회수 7223

설명해주는 인공지능 구현을 위한 초저전력 하드웨어 기술 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 다양한 멤리스터* 소자를 이용한 설명 가능한 인공지능 (XAI) 시스템을 구현하는데 성공했다고 25일 밝혔다.

*멤리스터 (Memristor): 메모리 (Memory)와 저항 (Resistor)의 합성어로, 입력 신호에 따라 소자의 저항 상태가 변하는 소자

최근 인공지능 (AI) 기술의 급속한 발전이 다양한 분야에서 성과를 이루고 있다. 이미지 인식, 음성 인식, 자연어 처리 등에서 AI의 적용 범위가 확대되며 우리의 일상생활에 깊숙이 자리 잡고 있다.

AI는 인간의 뉴런 구조를 모방해 만든 ‘인공신경망’을 기반으로, 적게는 수백만 개에서 많게는 수조 개에 달하는 매개변수를 통해 데이터를 분석하고 의사 결정을 내린다. 그러나 이 많은 매개변수로 인해 AI 모델의 동작 원리를 정확하게 이해하기 어렵고, 이는 통상적으로 블랙박스에 비유되곤 한다. AI가 어떤 기준으로 결정을 내는지 알 수 없다면, AI에 결함이나 오작동이 발생했을 때 이를 해결하기 어렵고, 이로 인해 AI가 적용되는 다양한 산업 분야에서 문제가 발생할 수 있다.

이에 대한 해답으로 제시된 것이 바로 설명 가능한 인공지능 (XAI)이다. XAI는 AI가 어떠한 결정을 내렸을 때, 그 근거가 무엇인지를 사람이 이해할 수 있도록 만드는 기술이다. <그림1> 생성형 AI 등 점점 더 복잡해지는 AI 기술의 등장으로 개발자, 사용자, 규제 기관 모두에게 XAI 시스템의 필요성이 강조되고 있다. 하지만, XAI는 일반적으로 엄청난 양의 데이터 처리를 요구하기 때문에, 이를 보다 효율적으로 동작할 수 있는 하드웨어 개발이 필요한 상황이다.

김경민 교수 연구팀은 교란(Perturbation) 기반 XAI 시스템을 서로 다른 멤리스터 소자를 이용해 하드웨어로 구현하는데 성공하였다. 세 가지 멤리스터 소자는 각각 휘발성 저항변화 특성, 아날로그 비휘발성 저항변화 특성, 아날로그 휘발성 저항변화 특성을 가지며 <그림 2>, 각 소자는 교란 기반 XAI 시스템의 필수적인 기능인 입력 데이터 교란, 벡터곱 연산, 그리고 신호 통합 기능을 수행한다.

연구팀은 개발된 XAI 하드웨어를 평가하기 위해, 흑백 패턴을 인식하는 신경망을 설계하였다. 여기에 개발한 XAI 하드웨어 시스템으로 설계한 신경망이 흑백 패턴을 인식하는 근거를 설명하였다. <그림3> 그 결과 기존 CMOS 기술 기반 시스템 대비 에너지 소비를 24배 감소하여 AI 판단의 이유를 제공하는 것을 확인하였다. <그림4>

KAIST 김경민 교수는 “AI 기술이 일상화되면서 AI 동작의 투명성 및 해석가능성이 중요해지고 있는데, 이번 연구는 다양한 종류의 멤리스터 소자를 이용해 AI 판단에 대한 근거를 제공하는 XAI 하드웨어 시스템을 구현할 수 있었다는 점에 큰 의의가 있다”며 “이 연구는 AI 의사 결정에 도달하는 과정을 이해하기 쉽게 설명을 제공함으로써 AI 시스템의 신뢰성 향상에 기여할 수 있어, 향후 의료, 금융, 법률 등 민감한 정보를 다루는 AI 기반 서비스에 적용될 수 있을 것으로 기대된다”고 밝혔다.

이번 연구는 KAIST 신소재공학과 송한찬 박사과정, 박우준 박사과정 학생이 공동 제1 저자로 참여했으며, 국제 학술지 ‘어드밴스드 머티리얼즈(Advanced Materials, IF: 29.4)’에 03월 20일 字 온라인 게재됐으며, 한국연구재단 중견연구사업, 차세대지능형반도체기술개발사업, PIM인공지능반도체핵심기술개발사업, 나노종합기술원 및 KAIST 도약연구사업의 지원을 받아 수행됐다. (논문명: Memristive Explainable Artificial Intelligence Hardware, 논문링크: https://doi.org/10.1002/adma.202400977)

2024.03.25 조회수 7223 -

두뇌 신경 조율 활동을 모방한 저전력 인공지능 하드웨어 핵심기술 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 두뇌에서 일어나는 신경 조율 활동을 구현한 인공지능용 하드웨어와 관련 알고리즘의 개발에 성공했다고 19일 밝혔다.

4차 산업 혁명 시대를 맞아 인공지능 기술(Artificial Intelligence; AI)의 연구가 활발해지고 이에 따라 인공지능 기반 전자기기들의 개발 및 제품 출시가 가속화되고 있다. 인공지능을 전자기기에서 구현하기 위해서 맞춤형 하드웨어의 개발 또한 뒷받침돼야 하는데, 현재 대부분의 인공 지능용 전자기기들은 많은 연산량을 수행하기 위해 높은 전력 소모와 고도로 집적된 메모리 배열을 사용하고 있다.

인공 지능의 능력 향상을 위해 이러한 전력 소모 및 집적화 한계의 문제를 해결하는 것은 인공 지능 기술 분야의 커다란 과제이며, 인간의 뇌 활동에서 문제 해결의 단서를 찾고자 하는 노력이 계속돼왔다.

김경민 교수 연구팀은 인간의 두뇌 신경망이 신경 조율(Neuromodulation) 기능을 통해 연결 구조를 상황에 따라 지속적으로 변화시키는 것을 모방, 인공 지능을 위한 수학적 연산을 효율적으로 처리할 수 있는 기술을 개발했다. 두뇌에서는 학습하는 과정에서 실시간으로 신경망의 연결도를 변경해 필요에 따라 기억을 저장하거나 불러내는데, 이러한 신경 조율 기능을 하드웨어에서 직접 구현하는 새로운 방식의 인공 지능 학습 방식을 제시한 것이다.

연구팀은 개발된 기술의 효율성을 증명하기 위해 독자적인 전자 시냅스 소자가 탑재된 인공 신경망 하드웨어를 제작했으며, 여기에 개발한 알고리즘을 적용해 실제 인공지능 학습을 진행했고, 그 결과 인공지능 학습에 필요한 에너지를 37% 절약할 수 있었다.

공동 제1 저자인 신소재공학과 정운형 박사과정과 전재범 박사과정은 "인간의 두뇌는 생존을 위해 에너지 소모를 최소화하는 방향으로 진화해왔다. 이번 연구에서는 간단한 회로의 구성만으로 인간 두뇌의 학습 방식을 구현하였으며, 이를 통해 40%에 가까운 에너지를 줄일 수 있었다, 이는 범용성 있게 모든 SNN(스파이킹 뉴럴 네트워크) 인공 신경망에서 사용 가능한 장점을 가진다ˮ며 "뇌 활동을 모방해 개발한 새로운 학습 방식의 착안은 앞으로 인공 지능 분야의 소프트웨어·하드웨어 분야가 나아가야 할 길의 이정표가 될 것이다ˮ라고 말했다.

이러한 두뇌 신경 활동을 모방한 학습 알고리즘은 기존 전자기기 및 상용화된 반도체 하드웨어에 적용 및 호환을 할 수 있으며 차세대 인공 지능용 반도체 칩의 설계에 사용할 수 있을 것으로 기대된다.

이번 연구는 국제 학술지 `어드밴스드 펑셔널 머터리얼즈(Advanced Functional Materials)'에 지난 3월 31일 자에 게재됐으며 한국연구재단, ㈜SK Hynix, 나노종합기술원(NNFC) 및 KAIST의 지원을 받아 수행됐다. (논문명: Demonstration of Neuromodulation-inspired Stashing System for Energy-efficient Learning of Spiking Neural Network using a Self-Rectifying Memristor Array)

2022.04.19 조회수 13940

두뇌 신경 조율 활동을 모방한 저전력 인공지능 하드웨어 핵심기술 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 두뇌에서 일어나는 신경 조율 활동을 구현한 인공지능용 하드웨어와 관련 알고리즘의 개발에 성공했다고 19일 밝혔다.

4차 산업 혁명 시대를 맞아 인공지능 기술(Artificial Intelligence; AI)의 연구가 활발해지고 이에 따라 인공지능 기반 전자기기들의 개발 및 제품 출시가 가속화되고 있다. 인공지능을 전자기기에서 구현하기 위해서 맞춤형 하드웨어의 개발 또한 뒷받침돼야 하는데, 현재 대부분의 인공 지능용 전자기기들은 많은 연산량을 수행하기 위해 높은 전력 소모와 고도로 집적된 메모리 배열을 사용하고 있다.

인공 지능의 능력 향상을 위해 이러한 전력 소모 및 집적화 한계의 문제를 해결하는 것은 인공 지능 기술 분야의 커다란 과제이며, 인간의 뇌 활동에서 문제 해결의 단서를 찾고자 하는 노력이 계속돼왔다.

김경민 교수 연구팀은 인간의 두뇌 신경망이 신경 조율(Neuromodulation) 기능을 통해 연결 구조를 상황에 따라 지속적으로 변화시키는 것을 모방, 인공 지능을 위한 수학적 연산을 효율적으로 처리할 수 있는 기술을 개발했다. 두뇌에서는 학습하는 과정에서 실시간으로 신경망의 연결도를 변경해 필요에 따라 기억을 저장하거나 불러내는데, 이러한 신경 조율 기능을 하드웨어에서 직접 구현하는 새로운 방식의 인공 지능 학습 방식을 제시한 것이다.

연구팀은 개발된 기술의 효율성을 증명하기 위해 독자적인 전자 시냅스 소자가 탑재된 인공 신경망 하드웨어를 제작했으며, 여기에 개발한 알고리즘을 적용해 실제 인공지능 학습을 진행했고, 그 결과 인공지능 학습에 필요한 에너지를 37% 절약할 수 있었다.

공동 제1 저자인 신소재공학과 정운형 박사과정과 전재범 박사과정은 "인간의 두뇌는 생존을 위해 에너지 소모를 최소화하는 방향으로 진화해왔다. 이번 연구에서는 간단한 회로의 구성만으로 인간 두뇌의 학습 방식을 구현하였으며, 이를 통해 40%에 가까운 에너지를 줄일 수 있었다, 이는 범용성 있게 모든 SNN(스파이킹 뉴럴 네트워크) 인공 신경망에서 사용 가능한 장점을 가진다ˮ며 "뇌 활동을 모방해 개발한 새로운 학습 방식의 착안은 앞으로 인공 지능 분야의 소프트웨어·하드웨어 분야가 나아가야 할 길의 이정표가 될 것이다ˮ라고 말했다.

이러한 두뇌 신경 활동을 모방한 학습 알고리즘은 기존 전자기기 및 상용화된 반도체 하드웨어에 적용 및 호환을 할 수 있으며 차세대 인공 지능용 반도체 칩의 설계에 사용할 수 있을 것으로 기대된다.

이번 연구는 국제 학술지 `어드밴스드 펑셔널 머터리얼즈(Advanced Functional Materials)'에 지난 3월 31일 자에 게재됐으며 한국연구재단, ㈜SK Hynix, 나노종합기술원(NNFC) 및 KAIST의 지원을 받아 수행됐다. (논문명: Demonstration of Neuromodulation-inspired Stashing System for Energy-efficient Learning of Spiking Neural Network using a Self-Rectifying Memristor Array)

2022.04.19 조회수 13940 -

인간의 뇌를 모방한 뉴로모픽 반도체 개발

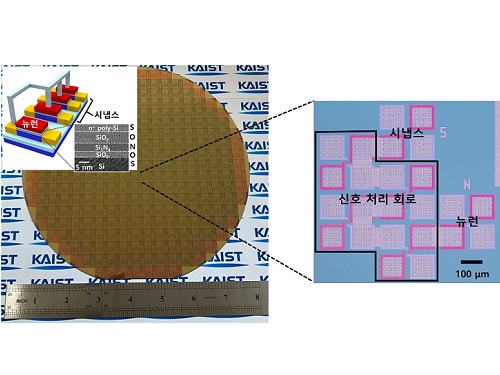

우리 대학 전기및전자공학부 최양규, 최성율 교수 공동연구팀이 인간의 뇌를 모방한 고집적 뉴로모픽 반도체를 개발했다고 5일 밝혔다.

뉴로모픽(neuromorphic) 하드웨어는, 인간의 뇌가 매우 복잡한 기능을 수행하지만 소비하는 에너지는 20와트(W) 밖에 되지 않는다는 것에 착안해, 인간의 뇌를 모방해 인공지능 기능을 하드웨어로 구현하는 방식이다. 뉴로모픽 하드웨어는 기존의 폰 노이만(von Neumann) 방식과 다르게 인공지능 기능을 초저전력으로 수행할 수 있어 많은 주목을 받고 있다.

공동연구팀은 단일 트랜지스터를 이용해 인간의 뇌를 모방한 뉴런과 시냅스로 구성된 뉴로모픽 반도체를 구현했다. 이 반도체는 상용화된 실리콘 표준 공정으로 제작되어, 뉴로모픽 하드웨어 시스템의 상용화 가능성을 획기적으로 높였다.

우리 대학 전기및전자공학부 한준규 박사과정이 제1 저자로, 같은 학부 오정엽 박사과정이 제2 저자로 참여한 이번 연구는 저명 국제 학술지 `사이언스 어드벤시스(Science Advances)' 8월 온라인판에 출판됐다. (논문명 : Co-integration of single transistor neurons and synapses by nanoscale CMOS fabrication for highly scalable neuromorphic hardware).

뉴로모픽 하드웨어를 구현하기 위해서는, 생물학적 뇌와 동일하게 일정 신호가 통합되었을 때 스파이크를 발생하는 뉴런과 두 뉴런 사이의 연결성을 기억하는 시냅스가 필요하다. 하지만, 디지털 또는 아날로그 회로를 기반으로 구성된 뉴런과 시냅스는 큰 면적을 차지하기 때문에 집적도 측면에서 한계가 있다. 인간의 뇌가 약 천억 개(1011)의 뉴런과 백조 개(1014)의 시냅스로 구성된다는 점에서, 실제 모바일 및 사물인터넷(IoT) 장치에 사용되기 위해서는 집적도를 개선할 필요가 있다.

이를 개선하기 위해 다양한 소재 및 구조 기반의 뉴런과 시냅스가 제안되었지만, 대부분 표준 실리콘 미세 공정 기술로 제작될 수 없어 상용화가 어렵고 양산 적용에 문제가 많았다.

연구팀은 문제 해결을 위해 이미 널리 쓰이고 있는 표준 실리콘 미세 공정 기술로 제작될 수 있는 단일 트랜지스터로 생물학적 뉴런과 시냅스의 동작을 모방했으며, 이를 동일 웨이퍼(8 인치) 상에 동시 집적해 뉴로모픽 반도체를 제작했다.

제작된 뉴로모픽 트랜지스터는 현재 양산되고 있는 메모리 및 시스템 반도체용 트랜지스터와 같은 구조로, 트랜지스터가 메모리 기능 및 논리 연산을 수행하는 것은 물론, 새로운 뉴로모픽 동작이 가능함을 실험적으로 보여 준 것에 가장 큰 의미가 있다. 기존 양산 트랜지스터에 새로운 동작원리를 적용해, 구조는 같으나 기능이 전혀 다른 뉴로모픽 트랜지스터를 제작했다. 뉴로모픽 트랜지스터는 마치 동전에 앞면과 뒷면이 동시에 있는 것처럼, 뉴런 기능도 하고 시냅스 기능도 수행하는 야누스(Janus) 구조로 구현 가능함을 세계 최초로 입증했다.

연구팀의 기술은 복잡한 디지털 및 아날로그 회로를 기반으로 구성되던 뉴런을 단일 트랜지스터로 대체 구현해 집적도를 획기적으로 높였고, 더 나아가 같은 구조의 시냅스와 함께 집적해 공정 단순화에 따른 비용 절감을 할 수 있는 신기술이다. 기존 뉴런 회로 구성에 필요한 평면적이 21,000 단위인 반면, 새로 개발된 뉴로모픽 트랜지스터는 6 단위 이하이므로 집적도가 약 3,500 배 이상 높다.

연구팀은 제작된 뉴로모픽 반도체를 바탕으로 증폭 이득 조절, 동시성 판단 등의 뇌의 기능을 일부 모방했고, 글자 이미지 및 얼굴 이미지 인식이 가능함을 보였다.

연구팀이 개발한 뉴로모픽 반도체는 집적도 개선과 비용 절감 등에 이바지하며, 뉴로모픽 하드웨어의 상용화를 앞당길 수 있을 것으로 기대된다.

한준규 박사과정은 "상보성 금속 산화막 반도체(CMOS) 기반 단일 트랜지스터를 이용해 뉴런과 시냅스 동작이 가능함을 보였다ˮ 라며 "상용화된 CMOS 공정을 이용해 뉴런, 시냅스, 그리고 부가적인 신호 처리 회로를 동일 웨이퍼 상에 동시에 집적함으로써, 뉴로모픽 반도체의 집적도를 개선했고, 이는 뉴로모픽 하드웨어의 상용화를 한 단계 앞당길 수 있을 것이다ˮ 라고 말했다.

한편 이번 연구는 한국연구재단 차세대지능형반도체기술개발사업, 중견연구사업, 미래반도체사업 및 반도체설계교육센터의 지원을 받아 수행됐다.

2021.08.06 조회수 15040

인간의 뇌를 모방한 뉴로모픽 반도체 개발

우리 대학 전기및전자공학부 최양규, 최성율 교수 공동연구팀이 인간의 뇌를 모방한 고집적 뉴로모픽 반도체를 개발했다고 5일 밝혔다.

뉴로모픽(neuromorphic) 하드웨어는, 인간의 뇌가 매우 복잡한 기능을 수행하지만 소비하는 에너지는 20와트(W) 밖에 되지 않는다는 것에 착안해, 인간의 뇌를 모방해 인공지능 기능을 하드웨어로 구현하는 방식이다. 뉴로모픽 하드웨어는 기존의 폰 노이만(von Neumann) 방식과 다르게 인공지능 기능을 초저전력으로 수행할 수 있어 많은 주목을 받고 있다.

공동연구팀은 단일 트랜지스터를 이용해 인간의 뇌를 모방한 뉴런과 시냅스로 구성된 뉴로모픽 반도체를 구현했다. 이 반도체는 상용화된 실리콘 표준 공정으로 제작되어, 뉴로모픽 하드웨어 시스템의 상용화 가능성을 획기적으로 높였다.

우리 대학 전기및전자공학부 한준규 박사과정이 제1 저자로, 같은 학부 오정엽 박사과정이 제2 저자로 참여한 이번 연구는 저명 국제 학술지 `사이언스 어드벤시스(Science Advances)' 8월 온라인판에 출판됐다. (논문명 : Co-integration of single transistor neurons and synapses by nanoscale CMOS fabrication for highly scalable neuromorphic hardware).

뉴로모픽 하드웨어를 구현하기 위해서는, 생물학적 뇌와 동일하게 일정 신호가 통합되었을 때 스파이크를 발생하는 뉴런과 두 뉴런 사이의 연결성을 기억하는 시냅스가 필요하다. 하지만, 디지털 또는 아날로그 회로를 기반으로 구성된 뉴런과 시냅스는 큰 면적을 차지하기 때문에 집적도 측면에서 한계가 있다. 인간의 뇌가 약 천억 개(1011)의 뉴런과 백조 개(1014)의 시냅스로 구성된다는 점에서, 실제 모바일 및 사물인터넷(IoT) 장치에 사용되기 위해서는 집적도를 개선할 필요가 있다.

이를 개선하기 위해 다양한 소재 및 구조 기반의 뉴런과 시냅스가 제안되었지만, 대부분 표준 실리콘 미세 공정 기술로 제작될 수 없어 상용화가 어렵고 양산 적용에 문제가 많았다.

연구팀은 문제 해결을 위해 이미 널리 쓰이고 있는 표준 실리콘 미세 공정 기술로 제작될 수 있는 단일 트랜지스터로 생물학적 뉴런과 시냅스의 동작을 모방했으며, 이를 동일 웨이퍼(8 인치) 상에 동시 집적해 뉴로모픽 반도체를 제작했다.

제작된 뉴로모픽 트랜지스터는 현재 양산되고 있는 메모리 및 시스템 반도체용 트랜지스터와 같은 구조로, 트랜지스터가 메모리 기능 및 논리 연산을 수행하는 것은 물론, 새로운 뉴로모픽 동작이 가능함을 실험적으로 보여 준 것에 가장 큰 의미가 있다. 기존 양산 트랜지스터에 새로운 동작원리를 적용해, 구조는 같으나 기능이 전혀 다른 뉴로모픽 트랜지스터를 제작했다. 뉴로모픽 트랜지스터는 마치 동전에 앞면과 뒷면이 동시에 있는 것처럼, 뉴런 기능도 하고 시냅스 기능도 수행하는 야누스(Janus) 구조로 구현 가능함을 세계 최초로 입증했다.

연구팀의 기술은 복잡한 디지털 및 아날로그 회로를 기반으로 구성되던 뉴런을 단일 트랜지스터로 대체 구현해 집적도를 획기적으로 높였고, 더 나아가 같은 구조의 시냅스와 함께 집적해 공정 단순화에 따른 비용 절감을 할 수 있는 신기술이다. 기존 뉴런 회로 구성에 필요한 평면적이 21,000 단위인 반면, 새로 개발된 뉴로모픽 트랜지스터는 6 단위 이하이므로 집적도가 약 3,500 배 이상 높다.

연구팀은 제작된 뉴로모픽 반도체를 바탕으로 증폭 이득 조절, 동시성 판단 등의 뇌의 기능을 일부 모방했고, 글자 이미지 및 얼굴 이미지 인식이 가능함을 보였다.

연구팀이 개발한 뉴로모픽 반도체는 집적도 개선과 비용 절감 등에 이바지하며, 뉴로모픽 하드웨어의 상용화를 앞당길 수 있을 것으로 기대된다.

한준규 박사과정은 "상보성 금속 산화막 반도체(CMOS) 기반 단일 트랜지스터를 이용해 뉴런과 시냅스 동작이 가능함을 보였다ˮ 라며 "상용화된 CMOS 공정을 이용해 뉴런, 시냅스, 그리고 부가적인 신호 처리 회로를 동일 웨이퍼 상에 동시에 집적함으로써, 뉴로모픽 반도체의 집적도를 개선했고, 이는 뉴로모픽 하드웨어의 상용화를 한 단계 앞당길 수 있을 것이다ˮ 라고 말했다.

한편 이번 연구는 한국연구재단 차세대지능형반도체기술개발사업, 중견연구사업, 미래반도체사업 및 반도체설계교육센터의 지원을 받아 수행됐다.

2021.08.06 조회수 15040 -

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 21891

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 21891