-

이의진 교수, 차량 대화형서비스 안전성 향상 기술 개발

〈 이의진 교수, 김아욱 박사과정 〉

우리 대학 산업및시스템공학과 이의진 교수 연구팀이 차량용 인공지능이 능동적으로 운전자에게 대화 서비스를 어느 시점에 제공해야 하는지 자동으로 판단할 수 있는 기술을 개발했다.

연구팀은 차량에서 수집되는 다양한 센서 데이터와 주변 환경 정보를 통합 분석해 언제 운전자에게 말을 걸어야 하는지 자동 판단하는 인공지능 기술을 개발했다.

차량 대화형서비스가 가진 문제를 해결하는 데 중점을 둔 이번 연구는 인공지능의 자동판단 기술을 통해 대화형서비스로 인한 운전자 주의분산 문제를 해결함으로써, 부적절한 시점에 운전자에게 대화를 시도하다가 발생할 수 있는 교통사고 등을 방지하는 기반기술이 될 것으로 기대된다.

이번 연구결과는 유비쿼터스 컴퓨팅 분야 국제 최우수학회인 ACM 유비콤(UbiComp)에서 9월 13일 발표됐다. 김아욱 박사과정이 1저자로 참여하고 최우혁 박사과정, 삼성리서치 박정미 연구원, 현대자동차 김계윤 연구원과의 공동 연구로 이뤄졌다. (논문명: Interrupting Drivers for Interactions: Predicting Opportune Moments for In-vehicle Proactive Auditory-verbal Tasks)

차량 대화형서비스는 편의와 안전을 동시에 제공해야 한다. 운전 중에 대화형서비스에만 집중하면 전방 주시에 소홀하거나 주변 상황에 주의를 기울이지 못하는 문제가 발생한다. 이는 운전뿐만 아니라 대화형서비스 사용 전반에도 부정적인 영향을 줄 수도 있다.

연구진은 말 걸기 적절한 시점 판단을 위해 ▲현재 운전상황의 안전도 ▲대화 서비스 수행의 성공률 ▲운전 중 대화 수행 중 운전자가 느끼는 주관적 어려움을 통합적으로 고려한 인지 모델을 제시했다.

연구팀의 인지 모델은 개별 척도를 다양하게 조합해 인공지능 에이전트가 제공하는 대화형서비스의 유형에 따른 개입 시점의 판단 기준을 설정할 수 있다.

일기예보 같은 단순 정보만을 전달하는 경우 현재 운전상황의 안전도만 고려해 개입 시점을 판단할 수 있고, ‘그래’, ‘아니’ 같은 간단한 대답을 해야 하는 질문에는 현재 운전상황의 안전도와 대화 서비스 수행의 성공률을 함께 고려한다. 매우 보수적으로 세 가지 척도를 모두 함께 고려해 판단할 수 있다. 이 방식은 에이전트와 운전자가 여러 차례의 상호작용을 통해 의사결정을 할 때 사용한다.

정확도 높은 자동판단 인공지능 기술 개발을 위해서는 실제 도로 운전 중 에이전트와의 상호작용 데이터가 필요하기 때문에 연구팀은 반복적인 시제품 제작 및 테스트를 수행해 실제 차량 주행환경에서 사용 가능한 내비게이션 앱 기반 모의 대화형서비스를 개발했다.

자동판단을 위해 대화형서비스 시스템과 차량을 연동해 운전대 조작, 브레이크 페달 조작 상태 등 차량 내 센서 데이터와 차간거리, 차량흐름 등 주변 환경 정보를 통합 수집했다.

연구팀은 모의 대화형서비스를 사용해 29명의 운전자가 실제 운전 중에 음성 에이전트와 수행한 1천 3백 88회의 상호작용 및 센서 데이터를 구축했고, 이를 활용해 기계학습 훈련 및 테스트를 수행한 결과 적절 시점 검출 정확도가 최대 87%에 달하는 것을 확인했다.

연구팀의 이번 기술 개발로 대화형서비스로 인한 운전자 주의분산 문제를 해결할 수 있을 것으로 전망된다. 이 기술은 대화형서비스를 제공하는 차량 인포테인먼트 시스템에 바로 적용할 수 있다. 운전 부주의 실시간 진단 및 중재에도 적용될 수 있을 것으로 기대된다.

이의진 교수는 “앞으로의 차량 서비스는 더욱더 능동적으로 서비스를 제공하는 형태로 거듭나게 될 것이다”라며 “자동차에서 생성되는 기본 센서 데이터만을 활용해 최적 개입 시점을 정확히 찾을 수가 있어 앞으로는 안전한 대화 서비스 제공이 가능할 것이다”라고 밝혔다.

이번 연구는 한국연구재단 차세대정보컴퓨팅기술개발사업과 현대NGV의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 실차 데이터 수집장비 및 실제 실험 모습

그림2. 모의 대화형서비스 개념도

그림3. 차량 대화형서비스의 안전성 증진 기술 개념도

이의진 교수, 차량 대화형서비스 안전성 향상 기술 개발

〈 이의진 교수, 김아욱 박사과정 〉

우리 대학 산업및시스템공학과 이의진 교수 연구팀이 차량용 인공지능이 능동적으로 운전자에게 대화 서비스를 어느 시점에 제공해야 하는지 자동으로 판단할 수 있는 기술을 개발했다.

연구팀은 차량에서 수집되는 다양한 센서 데이터와 주변 환경 정보를 통합 분석해 언제 운전자에게 말을 걸어야 하는지 자동 판단하는 인공지능 기술을 개발했다.

차량 대화형서비스가 가진 문제를 해결하는 데 중점을 둔 이번 연구는 인공지능의 자동판단 기술을 통해 대화형서비스로 인한 운전자 주의분산 문제를 해결함으로써, 부적절한 시점에 운전자에게 대화를 시도하다가 발생할 수 있는 교통사고 등을 방지하는 기반기술이 될 것으로 기대된다.

이번 연구결과는 유비쿼터스 컴퓨팅 분야 국제 최우수학회인 ACM 유비콤(UbiComp)에서 9월 13일 발표됐다. 김아욱 박사과정이 1저자로 참여하고 최우혁 박사과정, 삼성리서치 박정미 연구원, 현대자동차 김계윤 연구원과의 공동 연구로 이뤄졌다. (논문명: Interrupting Drivers for Interactions: Predicting Opportune Moments for In-vehicle Proactive Auditory-verbal Tasks)

차량 대화형서비스는 편의와 안전을 동시에 제공해야 한다. 운전 중에 대화형서비스에만 집중하면 전방 주시에 소홀하거나 주변 상황에 주의를 기울이지 못하는 문제가 발생한다. 이는 운전뿐만 아니라 대화형서비스 사용 전반에도 부정적인 영향을 줄 수도 있다.

연구진은 말 걸기 적절한 시점 판단을 위해 ▲현재 운전상황의 안전도 ▲대화 서비스 수행의 성공률 ▲운전 중 대화 수행 중 운전자가 느끼는 주관적 어려움을 통합적으로 고려한 인지 모델을 제시했다.

연구팀의 인지 모델은 개별 척도를 다양하게 조합해 인공지능 에이전트가 제공하는 대화형서비스의 유형에 따른 개입 시점의 판단 기준을 설정할 수 있다.

일기예보 같은 단순 정보만을 전달하는 경우 현재 운전상황의 안전도만 고려해 개입 시점을 판단할 수 있고, ‘그래’, ‘아니’ 같은 간단한 대답을 해야 하는 질문에는 현재 운전상황의 안전도와 대화 서비스 수행의 성공률을 함께 고려한다. 매우 보수적으로 세 가지 척도를 모두 함께 고려해 판단할 수 있다. 이 방식은 에이전트와 운전자가 여러 차례의 상호작용을 통해 의사결정을 할 때 사용한다.

정확도 높은 자동판단 인공지능 기술 개발을 위해서는 실제 도로 운전 중 에이전트와의 상호작용 데이터가 필요하기 때문에 연구팀은 반복적인 시제품 제작 및 테스트를 수행해 실제 차량 주행환경에서 사용 가능한 내비게이션 앱 기반 모의 대화형서비스를 개발했다.

자동판단을 위해 대화형서비스 시스템과 차량을 연동해 운전대 조작, 브레이크 페달 조작 상태 등 차량 내 센서 데이터와 차간거리, 차량흐름 등 주변 환경 정보를 통합 수집했다.

연구팀은 모의 대화형서비스를 사용해 29명의 운전자가 실제 운전 중에 음성 에이전트와 수행한 1천 3백 88회의 상호작용 및 센서 데이터를 구축했고, 이를 활용해 기계학습 훈련 및 테스트를 수행한 결과 적절 시점 검출 정확도가 최대 87%에 달하는 것을 확인했다.

연구팀의 이번 기술 개발로 대화형서비스로 인한 운전자 주의분산 문제를 해결할 수 있을 것으로 전망된다. 이 기술은 대화형서비스를 제공하는 차량 인포테인먼트 시스템에 바로 적용할 수 있다. 운전 부주의 실시간 진단 및 중재에도 적용될 수 있을 것으로 기대된다.

이의진 교수는 “앞으로의 차량 서비스는 더욱더 능동적으로 서비스를 제공하는 형태로 거듭나게 될 것이다”라며 “자동차에서 생성되는 기본 센서 데이터만을 활용해 최적 개입 시점을 정확히 찾을 수가 있어 앞으로는 안전한 대화 서비스 제공이 가능할 것이다”라고 밝혔다.

이번 연구는 한국연구재단 차세대정보컴퓨팅기술개발사업과 현대NGV의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 실차 데이터 수집장비 및 실제 실험 모습

그림2. 모의 대화형서비스 개념도

그림3. 차량 대화형서비스의 안전성 증진 기술 개념도

2019.11.12

조회수 16162

-

멀티프로젝션 상영관 기술 세계 첫 개발

- KAIST, CJ CGV와 공동개발해 전국 40개 상영관에서 상용화 완료 -- “3D 입체영상 기술 대체해 창조경제 이바지 할 것” -

영화 시장에서 멀티프로젝션을 상영관에 도입하는 연구가 진행되고 있다.

우리 학교 문화기술(CT)대학원 노준용(42) 교수 연구팀이 CJ CGV와 공동으로 몰입감을 제공하는 멀티프로젝션 기술 ‘CGV 스크린X(이하 CGV ScreenX)’를 개발했다.

‘CGV ScreenX’는 극장 화면의 경계를 넘어 전면 스크린은 물론 좌우 벽면에 확장된 영상을 투사해 관객들의 시야를 꽉 채우기 때문에 마치 영화 속에 들어온 것과 같은 미래형 상영관이다.

이 기술은 기존 3D 입체영화와 비교하면 △전용 안경이 필요 없고 △어지러움 증을 유발하지 않으며 △옆면을 스크린으로 활용해 영화 몰입감을 극대화하는 것이 특징이다.

특히, 세계 최초로 개발한 이 기술은 할리우드를 비롯한 전 세계 극장에 역수출 할 수 있다는 장점이 있으며, 기존의 극장 구조를 그대로 이용하면서 프로젝터만 추가하면 되기 때문에 높은 투자비 없이 도입할 수 있다.

노 교수팀과 CJ CGV는 몰입형 영상 기술을 구현하기 위해 멀티프로젝션 기술, 컨텐츠 재구성 기술, 시스템관리 기술 등 핵심적인 기술을 개발했다. 멀티프로젝션 기술은 기존의 극장 옆면을 스크린으로 활용해 자연스러운 영상을 표현할 수 있도록 최적화됐으며, 기존의 광고나 영화 상영 시스템과 동기화 되도록 설계됐다.

이와 함께 서로 다른 구조를 가진 다양한 극장 환경에서 동일한 컨텐츠를 효과적으로 재생할 수 있는 컨텐츠 재구성 기술, 복잡한 시스템을 적은 인력으로도 효율적으로 다수의 극장에 설치·운영하는 시스템 관리 기술을 개발했다.

노준용 교수는 “컨텐츠의 제작, 시스템 설치, 상영 등 전 과정에서 상영 환경의 영향을 많이 받는 멀티프로젝션을 극장 환경 내에서 일반화 시킬 수 있는 기술을 개발한 것이 핵심”이라며 “기존에 한정된 환경에서만 선보여지던 값비싼 멀티프로젝션 기술의 플랫폼화, 대중화를 실현함으로써 이 분야 기술적 우위를 선점한 점에서 의미가 크다”고 이번 기술에 대한 의미를 설명했다.

최근에는 CGV ScreenX 기술을 바탕으로 국내 최고의 비주얼리스트로 불리는 김지운 감독이 영화 를 제작해 화제를 모으고 있다. 는 제18회 부산국제영화제 갈라 프레젠테이션 섹션에 공식 초청되어 뜨거운 관심을 모았으며, 영화제 기간 내내 영화업계 관계자들로부터 영화의 새로운 가능성을 보여준다는 평가를 받았다.

참고로 CGV ScreenX는 현재 CGV여의도 9개관 전관 포함, 전국 22개 극장의 40개 상영관에서 지난 1월부터 선보이고 있으며 연내 50개 상영관으로 확대될 예정이다.

1. CGV ScreenX 기술 요약

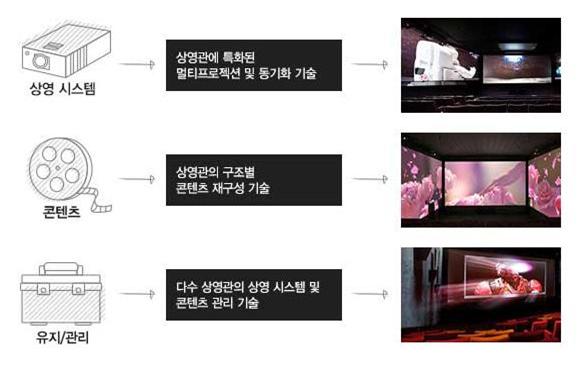

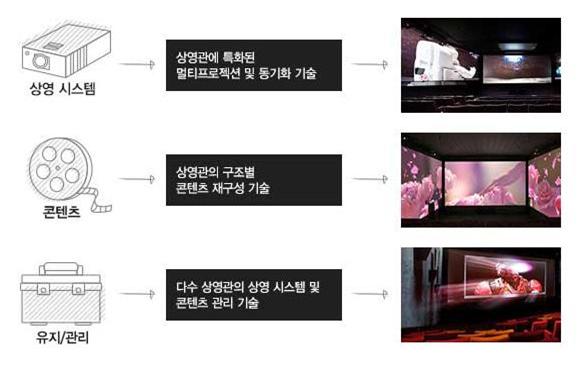

그림1. CGV ScreenX 기술 요약- 하드웨어(상영시스템), 소프트웨어(콘텐츠), 관리 기술을 포함한 기술 개발로 다양한 상영관에서의 동시운용을 실질적으로 가능하게 함

2. CGV ScreenX 주요 기술

① 표준 콘텐츠 제작

- 상영관의 통계적인 분석을 통하여 다수의 상영관을 커버할 수 있는 적절한 형태의 콘텐츠 템플릿 제공

② 상영관 특화영상 재구성

- 각 상영관의 구조를 고려하여 상영관에 적합한 형태로 표준 콘텐츠를 자동으로 재구성하여 배포하는 기술

③ 프로젝터별 보정 영상 생성

- 데이터베이스로부터 각 상영관에 설치된 다수의 프로젝터별 보정정보를 입력 받아 재구성 된 특화영상을 실시간으로 보정하여 재생하는 기술

- 상영관의 특성에 기반 한 설계를 통해 보정 과정의 많은 부분이 자동화

되어있어 기존의 방법에 비해 매우 간편함

④ 동기화 재생- 각각의 옆면 보조 프로젝터 뿐만 아니라, 중앙 프로젝터 및 광고, 영화 재생 서버와 실시간 동기화하여 재생하는 기술

멀티프로젝션 상영관 기술 세계 첫 개발

- KAIST, CJ CGV와 공동개발해 전국 40개 상영관에서 상용화 완료 -- “3D 입체영상 기술 대체해 창조경제 이바지 할 것” -

영화 시장에서 멀티프로젝션을 상영관에 도입하는 연구가 진행되고 있다.

우리 학교 문화기술(CT)대학원 노준용(42) 교수 연구팀이 CJ CGV와 공동으로 몰입감을 제공하는 멀티프로젝션 기술 ‘CGV 스크린X(이하 CGV ScreenX)’를 개발했다.

‘CGV ScreenX’는 극장 화면의 경계를 넘어 전면 스크린은 물론 좌우 벽면에 확장된 영상을 투사해 관객들의 시야를 꽉 채우기 때문에 마치 영화 속에 들어온 것과 같은 미래형 상영관이다.

이 기술은 기존 3D 입체영화와 비교하면 △전용 안경이 필요 없고 △어지러움 증을 유발하지 않으며 △옆면을 스크린으로 활용해 영화 몰입감을 극대화하는 것이 특징이다.

특히, 세계 최초로 개발한 이 기술은 할리우드를 비롯한 전 세계 극장에 역수출 할 수 있다는 장점이 있으며, 기존의 극장 구조를 그대로 이용하면서 프로젝터만 추가하면 되기 때문에 높은 투자비 없이 도입할 수 있다.

노 교수팀과 CJ CGV는 몰입형 영상 기술을 구현하기 위해 멀티프로젝션 기술, 컨텐츠 재구성 기술, 시스템관리 기술 등 핵심적인 기술을 개발했다. 멀티프로젝션 기술은 기존의 극장 옆면을 스크린으로 활용해 자연스러운 영상을 표현할 수 있도록 최적화됐으며, 기존의 광고나 영화 상영 시스템과 동기화 되도록 설계됐다.

이와 함께 서로 다른 구조를 가진 다양한 극장 환경에서 동일한 컨텐츠를 효과적으로 재생할 수 있는 컨텐츠 재구성 기술, 복잡한 시스템을 적은 인력으로도 효율적으로 다수의 극장에 설치·운영하는 시스템 관리 기술을 개발했다.

노준용 교수는 “컨텐츠의 제작, 시스템 설치, 상영 등 전 과정에서 상영 환경의 영향을 많이 받는 멀티프로젝션을 극장 환경 내에서 일반화 시킬 수 있는 기술을 개발한 것이 핵심”이라며 “기존에 한정된 환경에서만 선보여지던 값비싼 멀티프로젝션 기술의 플랫폼화, 대중화를 실현함으로써 이 분야 기술적 우위를 선점한 점에서 의미가 크다”고 이번 기술에 대한 의미를 설명했다.

최근에는 CGV ScreenX 기술을 바탕으로 국내 최고의 비주얼리스트로 불리는 김지운 감독이 영화 를 제작해 화제를 모으고 있다. 는 제18회 부산국제영화제 갈라 프레젠테이션 섹션에 공식 초청되어 뜨거운 관심을 모았으며, 영화제 기간 내내 영화업계 관계자들로부터 영화의 새로운 가능성을 보여준다는 평가를 받았다.

참고로 CGV ScreenX는 현재 CGV여의도 9개관 전관 포함, 전국 22개 극장의 40개 상영관에서 지난 1월부터 선보이고 있으며 연내 50개 상영관으로 확대될 예정이다.

1. CGV ScreenX 기술 요약

그림1. CGV ScreenX 기술 요약- 하드웨어(상영시스템), 소프트웨어(콘텐츠), 관리 기술을 포함한 기술 개발로 다양한 상영관에서의 동시운용을 실질적으로 가능하게 함

2. CGV ScreenX 주요 기술

① 표준 콘텐츠 제작

- 상영관의 통계적인 분석을 통하여 다수의 상영관을 커버할 수 있는 적절한 형태의 콘텐츠 템플릿 제공

② 상영관 특화영상 재구성

- 각 상영관의 구조를 고려하여 상영관에 적합한 형태로 표준 콘텐츠를 자동으로 재구성하여 배포하는 기술

③ 프로젝터별 보정 영상 생성

- 데이터베이스로부터 각 상영관에 설치된 다수의 프로젝터별 보정정보를 입력 받아 재구성 된 특화영상을 실시간으로 보정하여 재생하는 기술

- 상영관의 특성에 기반 한 설계를 통해 보정 과정의 많은 부분이 자동화

되어있어 기존의 방법에 비해 매우 간편함

④ 동기화 재생- 각각의 옆면 보조 프로젝터 뿐만 아니라, 중앙 프로젝터 및 광고, 영화 재생 서버와 실시간 동기화하여 재생하는 기술

2013.10.21

조회수 13739

이의진 교수, 차량 대화형서비스 안전성 향상 기술 개발

〈 이의진 교수, 김아욱 박사과정 〉

우리 대학 산업및시스템공학과 이의진 교수 연구팀이 차량용 인공지능이 능동적으로 운전자에게 대화 서비스를 어느 시점에 제공해야 하는지 자동으로 판단할 수 있는 기술을 개발했다.

연구팀은 차량에서 수집되는 다양한 센서 데이터와 주변 환경 정보를 통합 분석해 언제 운전자에게 말을 걸어야 하는지 자동 판단하는 인공지능 기술을 개발했다.

차량 대화형서비스가 가진 문제를 해결하는 데 중점을 둔 이번 연구는 인공지능의 자동판단 기술을 통해 대화형서비스로 인한 운전자 주의분산 문제를 해결함으로써, 부적절한 시점에 운전자에게 대화를 시도하다가 발생할 수 있는 교통사고 등을 방지하는 기반기술이 될 것으로 기대된다.

이번 연구결과는 유비쿼터스 컴퓨팅 분야 국제 최우수학회인 ACM 유비콤(UbiComp)에서 9월 13일 발표됐다. 김아욱 박사과정이 1저자로 참여하고 최우혁 박사과정, 삼성리서치 박정미 연구원, 현대자동차 김계윤 연구원과의 공동 연구로 이뤄졌다. (논문명: Interrupting Drivers for Interactions: Predicting Opportune Moments for In-vehicle Proactive Auditory-verbal Tasks)

차량 대화형서비스는 편의와 안전을 동시에 제공해야 한다. 운전 중에 대화형서비스에만 집중하면 전방 주시에 소홀하거나 주변 상황에 주의를 기울이지 못하는 문제가 발생한다. 이는 운전뿐만 아니라 대화형서비스 사용 전반에도 부정적인 영향을 줄 수도 있다.

연구진은 말 걸기 적절한 시점 판단을 위해 ▲현재 운전상황의 안전도 ▲대화 서비스 수행의 성공률 ▲운전 중 대화 수행 중 운전자가 느끼는 주관적 어려움을 통합적으로 고려한 인지 모델을 제시했다.

연구팀의 인지 모델은 개별 척도를 다양하게 조합해 인공지능 에이전트가 제공하는 대화형서비스의 유형에 따른 개입 시점의 판단 기준을 설정할 수 있다.

일기예보 같은 단순 정보만을 전달하는 경우 현재 운전상황의 안전도만 고려해 개입 시점을 판단할 수 있고, ‘그래’, ‘아니’ 같은 간단한 대답을 해야 하는 질문에는 현재 운전상황의 안전도와 대화 서비스 수행의 성공률을 함께 고려한다. 매우 보수적으로 세 가지 척도를 모두 함께 고려해 판단할 수 있다. 이 방식은 에이전트와 운전자가 여러 차례의 상호작용을 통해 의사결정을 할 때 사용한다.

정확도 높은 자동판단 인공지능 기술 개발을 위해서는 실제 도로 운전 중 에이전트와의 상호작용 데이터가 필요하기 때문에 연구팀은 반복적인 시제품 제작 및 테스트를 수행해 실제 차량 주행환경에서 사용 가능한 내비게이션 앱 기반 모의 대화형서비스를 개발했다.

자동판단을 위해 대화형서비스 시스템과 차량을 연동해 운전대 조작, 브레이크 페달 조작 상태 등 차량 내 센서 데이터와 차간거리, 차량흐름 등 주변 환경 정보를 통합 수집했다.

연구팀은 모의 대화형서비스를 사용해 29명의 운전자가 실제 운전 중에 음성 에이전트와 수행한 1천 3백 88회의 상호작용 및 센서 데이터를 구축했고, 이를 활용해 기계학습 훈련 및 테스트를 수행한 결과 적절 시점 검출 정확도가 최대 87%에 달하는 것을 확인했다.

연구팀의 이번 기술 개발로 대화형서비스로 인한 운전자 주의분산 문제를 해결할 수 있을 것으로 전망된다. 이 기술은 대화형서비스를 제공하는 차량 인포테인먼트 시스템에 바로 적용할 수 있다. 운전 부주의 실시간 진단 및 중재에도 적용될 수 있을 것으로 기대된다.

이의진 교수는 “앞으로의 차량 서비스는 더욱더 능동적으로 서비스를 제공하는 형태로 거듭나게 될 것이다”라며 “자동차에서 생성되는 기본 센서 데이터만을 활용해 최적 개입 시점을 정확히 찾을 수가 있어 앞으로는 안전한 대화 서비스 제공이 가능할 것이다”라고 밝혔다.

이번 연구는 한국연구재단 차세대정보컴퓨팅기술개발사업과 현대NGV의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 실차 데이터 수집장비 및 실제 실험 모습

그림2. 모의 대화형서비스 개념도

그림3. 차량 대화형서비스의 안전성 증진 기술 개념도

2019.11.12 조회수 16162

이의진 교수, 차량 대화형서비스 안전성 향상 기술 개발

〈 이의진 교수, 김아욱 박사과정 〉

우리 대학 산업및시스템공학과 이의진 교수 연구팀이 차량용 인공지능이 능동적으로 운전자에게 대화 서비스를 어느 시점에 제공해야 하는지 자동으로 판단할 수 있는 기술을 개발했다.

연구팀은 차량에서 수집되는 다양한 센서 데이터와 주변 환경 정보를 통합 분석해 언제 운전자에게 말을 걸어야 하는지 자동 판단하는 인공지능 기술을 개발했다.

차량 대화형서비스가 가진 문제를 해결하는 데 중점을 둔 이번 연구는 인공지능의 자동판단 기술을 통해 대화형서비스로 인한 운전자 주의분산 문제를 해결함으로써, 부적절한 시점에 운전자에게 대화를 시도하다가 발생할 수 있는 교통사고 등을 방지하는 기반기술이 될 것으로 기대된다.

이번 연구결과는 유비쿼터스 컴퓨팅 분야 국제 최우수학회인 ACM 유비콤(UbiComp)에서 9월 13일 발표됐다. 김아욱 박사과정이 1저자로 참여하고 최우혁 박사과정, 삼성리서치 박정미 연구원, 현대자동차 김계윤 연구원과의 공동 연구로 이뤄졌다. (논문명: Interrupting Drivers for Interactions: Predicting Opportune Moments for In-vehicle Proactive Auditory-verbal Tasks)

차량 대화형서비스는 편의와 안전을 동시에 제공해야 한다. 운전 중에 대화형서비스에만 집중하면 전방 주시에 소홀하거나 주변 상황에 주의를 기울이지 못하는 문제가 발생한다. 이는 운전뿐만 아니라 대화형서비스 사용 전반에도 부정적인 영향을 줄 수도 있다.

연구진은 말 걸기 적절한 시점 판단을 위해 ▲현재 운전상황의 안전도 ▲대화 서비스 수행의 성공률 ▲운전 중 대화 수행 중 운전자가 느끼는 주관적 어려움을 통합적으로 고려한 인지 모델을 제시했다.

연구팀의 인지 모델은 개별 척도를 다양하게 조합해 인공지능 에이전트가 제공하는 대화형서비스의 유형에 따른 개입 시점의 판단 기준을 설정할 수 있다.

일기예보 같은 단순 정보만을 전달하는 경우 현재 운전상황의 안전도만 고려해 개입 시점을 판단할 수 있고, ‘그래’, ‘아니’ 같은 간단한 대답을 해야 하는 질문에는 현재 운전상황의 안전도와 대화 서비스 수행의 성공률을 함께 고려한다. 매우 보수적으로 세 가지 척도를 모두 함께 고려해 판단할 수 있다. 이 방식은 에이전트와 운전자가 여러 차례의 상호작용을 통해 의사결정을 할 때 사용한다.

정확도 높은 자동판단 인공지능 기술 개발을 위해서는 실제 도로 운전 중 에이전트와의 상호작용 데이터가 필요하기 때문에 연구팀은 반복적인 시제품 제작 및 테스트를 수행해 실제 차량 주행환경에서 사용 가능한 내비게이션 앱 기반 모의 대화형서비스를 개발했다.

자동판단을 위해 대화형서비스 시스템과 차량을 연동해 운전대 조작, 브레이크 페달 조작 상태 등 차량 내 센서 데이터와 차간거리, 차량흐름 등 주변 환경 정보를 통합 수집했다.

연구팀은 모의 대화형서비스를 사용해 29명의 운전자가 실제 운전 중에 음성 에이전트와 수행한 1천 3백 88회의 상호작용 및 센서 데이터를 구축했고, 이를 활용해 기계학습 훈련 및 테스트를 수행한 결과 적절 시점 검출 정확도가 최대 87%에 달하는 것을 확인했다.

연구팀의 이번 기술 개발로 대화형서비스로 인한 운전자 주의분산 문제를 해결할 수 있을 것으로 전망된다. 이 기술은 대화형서비스를 제공하는 차량 인포테인먼트 시스템에 바로 적용할 수 있다. 운전 부주의 실시간 진단 및 중재에도 적용될 수 있을 것으로 기대된다.

이의진 교수는 “앞으로의 차량 서비스는 더욱더 능동적으로 서비스를 제공하는 형태로 거듭나게 될 것이다”라며 “자동차에서 생성되는 기본 센서 데이터만을 활용해 최적 개입 시점을 정확히 찾을 수가 있어 앞으로는 안전한 대화 서비스 제공이 가능할 것이다”라고 밝혔다.

이번 연구는 한국연구재단 차세대정보컴퓨팅기술개발사업과 현대NGV의 지원을 통해 수행됐다.

□ 그림 설명

그림1. 실차 데이터 수집장비 및 실제 실험 모습

그림2. 모의 대화형서비스 개념도

그림3. 차량 대화형서비스의 안전성 증진 기술 개념도

2019.11.12 조회수 16162 멀티프로젝션 상영관 기술 세계 첫 개발

- KAIST, CJ CGV와 공동개발해 전국 40개 상영관에서 상용화 완료 -- “3D 입체영상 기술 대체해 창조경제 이바지 할 것” -

영화 시장에서 멀티프로젝션을 상영관에 도입하는 연구가 진행되고 있다.

우리 학교 문화기술(CT)대학원 노준용(42) 교수 연구팀이 CJ CGV와 공동으로 몰입감을 제공하는 멀티프로젝션 기술 ‘CGV 스크린X(이하 CGV ScreenX)’를 개발했다.

‘CGV ScreenX’는 극장 화면의 경계를 넘어 전면 스크린은 물론 좌우 벽면에 확장된 영상을 투사해 관객들의 시야를 꽉 채우기 때문에 마치 영화 속에 들어온 것과 같은 미래형 상영관이다.

이 기술은 기존 3D 입체영화와 비교하면 △전용 안경이 필요 없고 △어지러움 증을 유발하지 않으며 △옆면을 스크린으로 활용해 영화 몰입감을 극대화하는 것이 특징이다.

특히, 세계 최초로 개발한 이 기술은 할리우드를 비롯한 전 세계 극장에 역수출 할 수 있다는 장점이 있으며, 기존의 극장 구조를 그대로 이용하면서 프로젝터만 추가하면 되기 때문에 높은 투자비 없이 도입할 수 있다.

노 교수팀과 CJ CGV는 몰입형 영상 기술을 구현하기 위해 멀티프로젝션 기술, 컨텐츠 재구성 기술, 시스템관리 기술 등 핵심적인 기술을 개발했다. 멀티프로젝션 기술은 기존의 극장 옆면을 스크린으로 활용해 자연스러운 영상을 표현할 수 있도록 최적화됐으며, 기존의 광고나 영화 상영 시스템과 동기화 되도록 설계됐다.

이와 함께 서로 다른 구조를 가진 다양한 극장 환경에서 동일한 컨텐츠를 효과적으로 재생할 수 있는 컨텐츠 재구성 기술, 복잡한 시스템을 적은 인력으로도 효율적으로 다수의 극장에 설치·운영하는 시스템 관리 기술을 개발했다.

노준용 교수는 “컨텐츠의 제작, 시스템 설치, 상영 등 전 과정에서 상영 환경의 영향을 많이 받는 멀티프로젝션을 극장 환경 내에서 일반화 시킬 수 있는 기술을 개발한 것이 핵심”이라며 “기존에 한정된 환경에서만 선보여지던 값비싼 멀티프로젝션 기술의 플랫폼화, 대중화를 실현함으로써 이 분야 기술적 우위를 선점한 점에서 의미가 크다”고 이번 기술에 대한 의미를 설명했다.

최근에는 CGV ScreenX 기술을 바탕으로 국내 최고의 비주얼리스트로 불리는 김지운 감독이 영화 를 제작해 화제를 모으고 있다. 는 제18회 부산국제영화제 갈라 프레젠테이션 섹션에 공식 초청되어 뜨거운 관심을 모았으며, 영화제 기간 내내 영화업계 관계자들로부터 영화의 새로운 가능성을 보여준다는 평가를 받았다.

참고로 CGV ScreenX는 현재 CGV여의도 9개관 전관 포함, 전국 22개 극장의 40개 상영관에서 지난 1월부터 선보이고 있으며 연내 50개 상영관으로 확대될 예정이다.

1. CGV ScreenX 기술 요약

그림1. CGV ScreenX 기술 요약- 하드웨어(상영시스템), 소프트웨어(콘텐츠), 관리 기술을 포함한 기술 개발로 다양한 상영관에서의 동시운용을 실질적으로 가능하게 함

2. CGV ScreenX 주요 기술

① 표준 콘텐츠 제작

- 상영관의 통계적인 분석을 통하여 다수의 상영관을 커버할 수 있는 적절한 형태의 콘텐츠 템플릿 제공

② 상영관 특화영상 재구성

- 각 상영관의 구조를 고려하여 상영관에 적합한 형태로 표준 콘텐츠를 자동으로 재구성하여 배포하는 기술

③ 프로젝터별 보정 영상 생성

- 데이터베이스로부터 각 상영관에 설치된 다수의 프로젝터별 보정정보를 입력 받아 재구성 된 특화영상을 실시간으로 보정하여 재생하는 기술

- 상영관의 특성에 기반 한 설계를 통해 보정 과정의 많은 부분이 자동화

되어있어 기존의 방법에 비해 매우 간편함

④ 동기화 재생- 각각의 옆면 보조 프로젝터 뿐만 아니라, 중앙 프로젝터 및 광고, 영화 재생 서버와 실시간 동기화하여 재생하는 기술

2013.10.21 조회수 13739

멀티프로젝션 상영관 기술 세계 첫 개발

- KAIST, CJ CGV와 공동개발해 전국 40개 상영관에서 상용화 완료 -- “3D 입체영상 기술 대체해 창조경제 이바지 할 것” -

영화 시장에서 멀티프로젝션을 상영관에 도입하는 연구가 진행되고 있다.

우리 학교 문화기술(CT)대학원 노준용(42) 교수 연구팀이 CJ CGV와 공동으로 몰입감을 제공하는 멀티프로젝션 기술 ‘CGV 스크린X(이하 CGV ScreenX)’를 개발했다.

‘CGV ScreenX’는 극장 화면의 경계를 넘어 전면 스크린은 물론 좌우 벽면에 확장된 영상을 투사해 관객들의 시야를 꽉 채우기 때문에 마치 영화 속에 들어온 것과 같은 미래형 상영관이다.

이 기술은 기존 3D 입체영화와 비교하면 △전용 안경이 필요 없고 △어지러움 증을 유발하지 않으며 △옆면을 스크린으로 활용해 영화 몰입감을 극대화하는 것이 특징이다.

특히, 세계 최초로 개발한 이 기술은 할리우드를 비롯한 전 세계 극장에 역수출 할 수 있다는 장점이 있으며, 기존의 극장 구조를 그대로 이용하면서 프로젝터만 추가하면 되기 때문에 높은 투자비 없이 도입할 수 있다.

노 교수팀과 CJ CGV는 몰입형 영상 기술을 구현하기 위해 멀티프로젝션 기술, 컨텐츠 재구성 기술, 시스템관리 기술 등 핵심적인 기술을 개발했다. 멀티프로젝션 기술은 기존의 극장 옆면을 스크린으로 활용해 자연스러운 영상을 표현할 수 있도록 최적화됐으며, 기존의 광고나 영화 상영 시스템과 동기화 되도록 설계됐다.

이와 함께 서로 다른 구조를 가진 다양한 극장 환경에서 동일한 컨텐츠를 효과적으로 재생할 수 있는 컨텐츠 재구성 기술, 복잡한 시스템을 적은 인력으로도 효율적으로 다수의 극장에 설치·운영하는 시스템 관리 기술을 개발했다.

노준용 교수는 “컨텐츠의 제작, 시스템 설치, 상영 등 전 과정에서 상영 환경의 영향을 많이 받는 멀티프로젝션을 극장 환경 내에서 일반화 시킬 수 있는 기술을 개발한 것이 핵심”이라며 “기존에 한정된 환경에서만 선보여지던 값비싼 멀티프로젝션 기술의 플랫폼화, 대중화를 실현함으로써 이 분야 기술적 우위를 선점한 점에서 의미가 크다”고 이번 기술에 대한 의미를 설명했다.

최근에는 CGV ScreenX 기술을 바탕으로 국내 최고의 비주얼리스트로 불리는 김지운 감독이 영화 를 제작해 화제를 모으고 있다. 는 제18회 부산국제영화제 갈라 프레젠테이션 섹션에 공식 초청되어 뜨거운 관심을 모았으며, 영화제 기간 내내 영화업계 관계자들로부터 영화의 새로운 가능성을 보여준다는 평가를 받았다.

참고로 CGV ScreenX는 현재 CGV여의도 9개관 전관 포함, 전국 22개 극장의 40개 상영관에서 지난 1월부터 선보이고 있으며 연내 50개 상영관으로 확대될 예정이다.

1. CGV ScreenX 기술 요약

그림1. CGV ScreenX 기술 요약- 하드웨어(상영시스템), 소프트웨어(콘텐츠), 관리 기술을 포함한 기술 개발로 다양한 상영관에서의 동시운용을 실질적으로 가능하게 함

2. CGV ScreenX 주요 기술

① 표준 콘텐츠 제작

- 상영관의 통계적인 분석을 통하여 다수의 상영관을 커버할 수 있는 적절한 형태의 콘텐츠 템플릿 제공

② 상영관 특화영상 재구성

- 각 상영관의 구조를 고려하여 상영관에 적합한 형태로 표준 콘텐츠를 자동으로 재구성하여 배포하는 기술

③ 프로젝터별 보정 영상 생성

- 데이터베이스로부터 각 상영관에 설치된 다수의 프로젝터별 보정정보를 입력 받아 재구성 된 특화영상을 실시간으로 보정하여 재생하는 기술

- 상영관의 특성에 기반 한 설계를 통해 보정 과정의 많은 부분이 자동화

되어있어 기존의 방법에 비해 매우 간편함

④ 동기화 재생- 각각의 옆면 보조 프로젝터 뿐만 아니라, 중앙 프로젝터 및 광고, 영화 재생 서버와 실시간 동기화하여 재생하는 기술

2013.10.21 조회수 13739