%EC%9D%B8%EA%B3%B5%EC%A7%80%EB%8A%A5

-

인공지능 기반 대장암 3차원 게놈 지도 최초 해독

세계 최초로 예전에 비해 최대 규모로 한국인 대장암 환자 3차원 게놈 지도를 작성하여 화제다.

우리 대학 생명과학과 정인경 교수 연구팀이 서울대학교 암연구소 김태유 교수 연구팀과의 공동연구를 통해 인공지능 기반 알고리즘을 활용, 한국인 대장암 환자의 3차원 게놈 지도를 최초로 제시했으며 이를 토대로 암 세포 특이적인 유전자 조절 기전을 통해 특정 종양유전자들이 과발현되는 현상을 규명했다고 24일 밝혔다.

1차원적 게놈 서열 분석에 기반한 현재의 암 유전체 연구는 종양유전자들의 과발현 기작을 설명하는데 한계가 있었다. 하지만 3차원 공간상에 게놈이 어떻게 배열되는지를 분석하는 3차원 게놈 (3D genome) 구조 연구는 이러한 한계를 극복 가능케 하고 있다. 본 연구에서는 정상 세포에서는 존재하지 않는 암 세포 특이적 염색질 고리(chromatin loop) 구조가 유전자 발현 촉진 인자인 인핸서와 종양유전자 사이의 상호작용을 형성하여 과발현을 유도하는 인핸서 납치(enhancer-hijacking) 현상에 초점을 두어 연구하였다.

우리 대학 생명과학과 김규광 박사과정이 주도한 이번 연구는 게놈간의 공간상 상호작용을 측정할 수 있는 대용량 염색체 구조 포착 Hi-C (High-throughput Chromosome Conformation Capture) 실험 기법을 활용하여 대장암 3차원 게놈 지도를 작성하고 대장암 특이적 3차원 게놈 변화를 환자 개개인별로 분석할 수 있는 인공지능 기반 알고리즘을 개발했다. 그 결과 공동연구팀은 광범위한 규모의 3차원 게놈 구조 변화와 이로 인한 다양한 종양유전자의 활성화를 확인했다.

연구팀은 이번 연구를 통해 암 특이적 3차원 게놈 구조의 변화로 인한 종양유전자 활성 기작을 명확히 제시하였으며 이로 인한 환자 예후와 약물 반응 등 임상적인 특성과의 연관성까지 제시해 맞춤 치료 원천기술 확보에 기여했다.

지금까지 암 세포주에 대한 3차원 게놈 구조 연구는 일부 보고 되었으나, 대규모 환자 암조직에 대한 연구는 조직 내 세포 이질성, 종양 순도, 암세포 이질성 등의 문제로 인한 정밀 암 특이적 3차원 게놈 구조 분석의 한계로 수행되지 못하였다.

반면에 이번 연구에서 연구팀은 AI 기반 알고리즘으로 환자 개인 종양 조직으로부터 얻어진 복잡한 신호를 해석할 수 있었으며 그 결과 최대 규모인 환자 40명의 종양 조직과 인접한 정상 대장 조직을 사용해 3차원 게놈 지도를 작성할 수 있었다. 또한 DNA 서열정보를 보여주는 전장유전체 지도의 경우 다양한 인종에 대해 생산되고 있고 한국인의 전장유전체 지도 또한 개발되었으나 한국인 3차원 게놈 지도, 특히 종양 조직에 대한 3차원 게놈 지도는 이번 연구에서 최초로 제시됐다.

이번 연구 결과는 국제 학술지, `셀 리포츠(Cell Reports, IF=9.995)'에 7월 13일 자로 출판됐다. (논문명: Spatial and clonality-resolved 3D cancer genome alterations reveal enhancer-hijacking as a potential prognostic marker for colorectal cancer)

서울대학교병원 혈액종양내과 김태유 교수는 “이러한 결과는 개별 암 환자들마다 서로 다르게 나타나는 종양 이질성을 이해하는 데 매우 중요한 요소가 될 수 있으며, 이를 이용한 환자 맞춤형 치료 연구의 시발점이 될 것이다”라고 말했다. 생명과학과 정인경 교수는 “기존의 점돌연변이나 유전체 변이만으로는 설명이 어려운 암 유전체를 3차원 게놈 구조 관점에서 재해독하고 신규 암 타겟을 발굴할 수 있는 수 있는 새로운 접근법을 제시했다”라고 밝혔다.

한편 이번 연구는 과학기술정보통신부와 서경배과학재단의 지원을 받아 수행됐다.

2023.07.24 조회수 8510

인공지능 기반 대장암 3차원 게놈 지도 최초 해독

세계 최초로 예전에 비해 최대 규모로 한국인 대장암 환자 3차원 게놈 지도를 작성하여 화제다.

우리 대학 생명과학과 정인경 교수 연구팀이 서울대학교 암연구소 김태유 교수 연구팀과의 공동연구를 통해 인공지능 기반 알고리즘을 활용, 한국인 대장암 환자의 3차원 게놈 지도를 최초로 제시했으며 이를 토대로 암 세포 특이적인 유전자 조절 기전을 통해 특정 종양유전자들이 과발현되는 현상을 규명했다고 24일 밝혔다.

1차원적 게놈 서열 분석에 기반한 현재의 암 유전체 연구는 종양유전자들의 과발현 기작을 설명하는데 한계가 있었다. 하지만 3차원 공간상에 게놈이 어떻게 배열되는지를 분석하는 3차원 게놈 (3D genome) 구조 연구는 이러한 한계를 극복 가능케 하고 있다. 본 연구에서는 정상 세포에서는 존재하지 않는 암 세포 특이적 염색질 고리(chromatin loop) 구조가 유전자 발현 촉진 인자인 인핸서와 종양유전자 사이의 상호작용을 형성하여 과발현을 유도하는 인핸서 납치(enhancer-hijacking) 현상에 초점을 두어 연구하였다.

우리 대학 생명과학과 김규광 박사과정이 주도한 이번 연구는 게놈간의 공간상 상호작용을 측정할 수 있는 대용량 염색체 구조 포착 Hi-C (High-throughput Chromosome Conformation Capture) 실험 기법을 활용하여 대장암 3차원 게놈 지도를 작성하고 대장암 특이적 3차원 게놈 변화를 환자 개개인별로 분석할 수 있는 인공지능 기반 알고리즘을 개발했다. 그 결과 공동연구팀은 광범위한 규모의 3차원 게놈 구조 변화와 이로 인한 다양한 종양유전자의 활성화를 확인했다.

연구팀은 이번 연구를 통해 암 특이적 3차원 게놈 구조의 변화로 인한 종양유전자 활성 기작을 명확히 제시하였으며 이로 인한 환자 예후와 약물 반응 등 임상적인 특성과의 연관성까지 제시해 맞춤 치료 원천기술 확보에 기여했다.

지금까지 암 세포주에 대한 3차원 게놈 구조 연구는 일부 보고 되었으나, 대규모 환자 암조직에 대한 연구는 조직 내 세포 이질성, 종양 순도, 암세포 이질성 등의 문제로 인한 정밀 암 특이적 3차원 게놈 구조 분석의 한계로 수행되지 못하였다.

반면에 이번 연구에서 연구팀은 AI 기반 알고리즘으로 환자 개인 종양 조직으로부터 얻어진 복잡한 신호를 해석할 수 있었으며 그 결과 최대 규모인 환자 40명의 종양 조직과 인접한 정상 대장 조직을 사용해 3차원 게놈 지도를 작성할 수 있었다. 또한 DNA 서열정보를 보여주는 전장유전체 지도의 경우 다양한 인종에 대해 생산되고 있고 한국인의 전장유전체 지도 또한 개발되었으나 한국인 3차원 게놈 지도, 특히 종양 조직에 대한 3차원 게놈 지도는 이번 연구에서 최초로 제시됐다.

이번 연구 결과는 국제 학술지, `셀 리포츠(Cell Reports, IF=9.995)'에 7월 13일 자로 출판됐다. (논문명: Spatial and clonality-resolved 3D cancer genome alterations reveal enhancer-hijacking as a potential prognostic marker for colorectal cancer)

서울대학교병원 혈액종양내과 김태유 교수는 “이러한 결과는 개별 암 환자들마다 서로 다르게 나타나는 종양 이질성을 이해하는 데 매우 중요한 요소가 될 수 있으며, 이를 이용한 환자 맞춤형 치료 연구의 시발점이 될 것이다”라고 말했다. 생명과학과 정인경 교수는 “기존의 점돌연변이나 유전체 변이만으로는 설명이 어려운 암 유전체를 3차원 게놈 구조 관점에서 재해독하고 신규 암 타겟을 발굴할 수 있는 수 있는 새로운 접근법을 제시했다”라고 밝혔다.

한편 이번 연구는 과학기술정보통신부와 서경배과학재단의 지원을 받아 수행됐다.

2023.07.24 조회수 8510 -

약물 부작용 및 용해도 예측 그래프 신경망 기술 개발

최근 화학, 생명과학 등 다양한 기초과학 분야의 문제를 해결하기 위해 그래프 신경망 (Graph Neural Network) 기술이 널리 활용되고 있다. 그 중에서도 특히 두 물질의 상호작용에 의해 발생하는 물리적 성질을 예측하는 것은 다양한 화학, 소재 및 의학 분야에서 각광을 받고 있다. 예를 들어, 어떠한 약물 (Drug)이 용매 (Solvent)에 얼마나 잘 용해되는지 정확히 예측하고, 동시에 여러 가지 약물을 투여하는 다중약물요법 (Polypharmacy)의 부작용을 예측하는 것이 신약 개발 등에 매우 중요하다.

우리 대학 산업및시스템공학과 박찬영 교수 연구팀이 한국화학연구원(원장 이영국)과 공동연구를 통해 물질 내의 중요한 하부 구조(Substructure)를 탐지하여 두 물질의 상호작용에 의해 발생하는 물리적 성질 예측의 높은 정확도를 달성할 수 있는 새로운 그래프 신경망 기법을 개발했다고 18일 밝혔다.

기존 연구에서는 두 분자 쌍이 있을 때, 각 분자내에 존재하는 원자들 사이의 상호 작용만을 고려해 그래프 신경망 모델을 학습하였다. 예를 들어 특정 발색체의 물(H2O)에 대한 용해도를 예측하고자 할 때, 발색체 내의 각 원자들에 대해 물 분자의 원자들 (즉, H, O)이 갖는 영향력을 고려하는 것이다. 연구팀이 이에 반해, 연구팀이 착안한 점은 분자 구조의 화학적 특성을 결정하는 데 있어서 원자뿐만 아니라 작용기(Functional group)와 같은 분자내 하부 구조들이 중요한 역할을 한다는 점이었다. 예를 들어, 알코올이나 예를 들어, 알코올이나 포도당과 같이 하이드록실기 (Hydroxyl group)를 포함하는 분자들은 일반적으로 물에 대한 용해도가 높은 것으로 알려져 있다. 즉, 하이드록실기라는 작용기가 물에 대한 용해도를 결정하는데 중요한 역할을 한다는 것이다.

연구팀은 분자의 특성을 결정하는데 큰 영향을 끼치는 하부 구조를 추론하는 기술을 분자내의 중요한 정보를 최대한 압축하여 보존하는 ‘정보 병목 이론’과, 분자 내의 어떤 하부 구조가 분자의 고유한 특성을 결정 짓는데 큰 역할을 했는지 대한 인과 관계를 추론하는 ‘인과 추론 모형’을 활용하여 개발했다. 이를 통해 분자의 고유한 특성에 가장 큰 영향을 미치는 하부 구조를 찾아내었다. 또한 분자 간 관계를 추론하는 문제에서는 상대방 분자에 따라 대상 분자의 중요한 하부 구조가 달라질 수 있다는 점을 착안하여 물질 간 관계를 예측하는 모델을 제안했다.

이번 새로운 그래프 신경망 기법을 의학에 적용하여 정보 병목 현상을 기반으로 한 연구는 기존 연구에 비해 약물 용해도 예측에서 11%의 성능 향상, 다중약물요법 부작용 예측에서 4%의 정확도 향상을 이뤄냈다. 또한, 인과 추론 모형을 기반으로 한 연구는 약물 용해도 예측에서 17%의 성능 향상, 약물 부작용 예측에서 2%의 정확도 향상을 이뤄냈다.

박찬영 교수팀은 정보 병목 이론을 기반으로 중요한 하부 구조를 탐지해 분자 구조 관계의 높은 예측 정확도를 달성할 수 있는 그래프 신경망 모델을 개발해 기계학습 분야 최고권위 국제학술대회 ‘국제 기계 학습 학회 International Conference on Machine Learning (ICML 2023)’에서 올 7월 발표할 예정이다. (논문명: Conditional Graph Information Bottleneck for Molecular Relational Learning). 또한 인과 추론 모형을 기반으로 중요한 하부 구조를 탐지해 분포 변화에도 모델의 성능이 강건하게 유지되는 그래프 신경망 모델을 개발해 데이터마이닝 최고권위 국제학술 대회 ‘국제 데이터 마이닝 학회 ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2023)’에서 올 8월에 발표할 예정이다. (논문명: Shift-Robust Molecular Relational Learning with Causal Substructure). 두 연구 모두 KAIST 산업및시스템공학과 대학원에 재학 중인 이남경 박사과정 학생이 제1 저자, 화학연구원의 나경석 연구원이 공동 저자, 우리 대학 산업및시스템공학과의 박찬영 교수가 교신저자로 참여했다.

두 연구의 제1 저자인 이남경 박사과정은 “제안한 기술은 분자의 성질을 결정하는 데 있어 큰 영향을 미치는 하부 구조가 존재한다는 화학적 지식에 기반해 그래프 신경망을 학습할 수 있는 새로운 방법”이라면서 “상대편 분자를 고려해 대상 분자의 중요한 구조를 찾는 방법론은 이미지-텍스트 멀티 모달 학습 방법에서도 적용될 수 있어, 심층 학습 전반적인 성능 개선에 기여할 수 있다”고 밝혔다.

연구팀을 지도한 박찬영 교수도 “제안한 기술은 화학과 생명과학을 포함한 다양한 분야에서 새로운 물질을 발견하는데 널리 사용될 것으로 기대하며, 특히 환경 친화적인 소재 개발, 질병 치료를 위한 신약 발굴 등에 있어서 본 기술의 가치가 더욱 부각될 것으로 보인다”라고 밝혔다.

한편 이번 연구는 정보통신기획평가원의 지원을 받은 사람중심 인공지능 핵심원천기술개발 사업과 한국화학연구원 기본사업 (KK2351-10)의 지원을 받아 수행됐다.

2023.07.18 조회수 9731

약물 부작용 및 용해도 예측 그래프 신경망 기술 개발

최근 화학, 생명과학 등 다양한 기초과학 분야의 문제를 해결하기 위해 그래프 신경망 (Graph Neural Network) 기술이 널리 활용되고 있다. 그 중에서도 특히 두 물질의 상호작용에 의해 발생하는 물리적 성질을 예측하는 것은 다양한 화학, 소재 및 의학 분야에서 각광을 받고 있다. 예를 들어, 어떠한 약물 (Drug)이 용매 (Solvent)에 얼마나 잘 용해되는지 정확히 예측하고, 동시에 여러 가지 약물을 투여하는 다중약물요법 (Polypharmacy)의 부작용을 예측하는 것이 신약 개발 등에 매우 중요하다.

우리 대학 산업및시스템공학과 박찬영 교수 연구팀이 한국화학연구원(원장 이영국)과 공동연구를 통해 물질 내의 중요한 하부 구조(Substructure)를 탐지하여 두 물질의 상호작용에 의해 발생하는 물리적 성질 예측의 높은 정확도를 달성할 수 있는 새로운 그래프 신경망 기법을 개발했다고 18일 밝혔다.

기존 연구에서는 두 분자 쌍이 있을 때, 각 분자내에 존재하는 원자들 사이의 상호 작용만을 고려해 그래프 신경망 모델을 학습하였다. 예를 들어 특정 발색체의 물(H2O)에 대한 용해도를 예측하고자 할 때, 발색체 내의 각 원자들에 대해 물 분자의 원자들 (즉, H, O)이 갖는 영향력을 고려하는 것이다. 연구팀이 이에 반해, 연구팀이 착안한 점은 분자 구조의 화학적 특성을 결정하는 데 있어서 원자뿐만 아니라 작용기(Functional group)와 같은 분자내 하부 구조들이 중요한 역할을 한다는 점이었다. 예를 들어, 알코올이나 예를 들어, 알코올이나 포도당과 같이 하이드록실기 (Hydroxyl group)를 포함하는 분자들은 일반적으로 물에 대한 용해도가 높은 것으로 알려져 있다. 즉, 하이드록실기라는 작용기가 물에 대한 용해도를 결정하는데 중요한 역할을 한다는 것이다.

연구팀은 분자의 특성을 결정하는데 큰 영향을 끼치는 하부 구조를 추론하는 기술을 분자내의 중요한 정보를 최대한 압축하여 보존하는 ‘정보 병목 이론’과, 분자 내의 어떤 하부 구조가 분자의 고유한 특성을 결정 짓는데 큰 역할을 했는지 대한 인과 관계를 추론하는 ‘인과 추론 모형’을 활용하여 개발했다. 이를 통해 분자의 고유한 특성에 가장 큰 영향을 미치는 하부 구조를 찾아내었다. 또한 분자 간 관계를 추론하는 문제에서는 상대방 분자에 따라 대상 분자의 중요한 하부 구조가 달라질 수 있다는 점을 착안하여 물질 간 관계를 예측하는 모델을 제안했다.

이번 새로운 그래프 신경망 기법을 의학에 적용하여 정보 병목 현상을 기반으로 한 연구는 기존 연구에 비해 약물 용해도 예측에서 11%의 성능 향상, 다중약물요법 부작용 예측에서 4%의 정확도 향상을 이뤄냈다. 또한, 인과 추론 모형을 기반으로 한 연구는 약물 용해도 예측에서 17%의 성능 향상, 약물 부작용 예측에서 2%의 정확도 향상을 이뤄냈다.

박찬영 교수팀은 정보 병목 이론을 기반으로 중요한 하부 구조를 탐지해 분자 구조 관계의 높은 예측 정확도를 달성할 수 있는 그래프 신경망 모델을 개발해 기계학습 분야 최고권위 국제학술대회 ‘국제 기계 학습 학회 International Conference on Machine Learning (ICML 2023)’에서 올 7월 발표할 예정이다. (논문명: Conditional Graph Information Bottleneck for Molecular Relational Learning). 또한 인과 추론 모형을 기반으로 중요한 하부 구조를 탐지해 분포 변화에도 모델의 성능이 강건하게 유지되는 그래프 신경망 모델을 개발해 데이터마이닝 최고권위 국제학술 대회 ‘국제 데이터 마이닝 학회 ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2023)’에서 올 8월에 발표할 예정이다. (논문명: Shift-Robust Molecular Relational Learning with Causal Substructure). 두 연구 모두 KAIST 산업및시스템공학과 대학원에 재학 중인 이남경 박사과정 학생이 제1 저자, 화학연구원의 나경석 연구원이 공동 저자, 우리 대학 산업및시스템공학과의 박찬영 교수가 교신저자로 참여했다.

두 연구의 제1 저자인 이남경 박사과정은 “제안한 기술은 분자의 성질을 결정하는 데 있어 큰 영향을 미치는 하부 구조가 존재한다는 화학적 지식에 기반해 그래프 신경망을 학습할 수 있는 새로운 방법”이라면서 “상대편 분자를 고려해 대상 분자의 중요한 구조를 찾는 방법론은 이미지-텍스트 멀티 모달 학습 방법에서도 적용될 수 있어, 심층 학습 전반적인 성능 개선에 기여할 수 있다”고 밝혔다.

연구팀을 지도한 박찬영 교수도 “제안한 기술은 화학과 생명과학을 포함한 다양한 분야에서 새로운 물질을 발견하는데 널리 사용될 것으로 기대하며, 특히 환경 친화적인 소재 개발, 질병 치료를 위한 신약 발굴 등에 있어서 본 기술의 가치가 더욱 부각될 것으로 보인다”라고 밝혔다.

한편 이번 연구는 정보통신기획평가원의 지원을 받은 사람중심 인공지능 핵심원천기술개발 사업과 한국화학연구원 기본사업 (KK2351-10)의 지원을 받아 수행됐다.

2023.07.18 조회수 9731 -

면역항암치료 부작용 인공지능으로 예측

면역항암치료는 환자의 면역 시스템을 활성화해 암을 치료하는 혁신적인 3세대 항암 치료 방법으로 알려져 있다. 하지만 면역항암 치료제는 면역활성화에 의해 기존 항암제와는 구분되는 자가면역질환과 유사한 부작용을 유발할 수 있다는 새로운 문제가 제기됐다. 이러한 부작용은 심각한 경우 환자를 죽음에까지 이르게 할 수 있기에 부작용에 대한 연구가 절실한 상황에 놓여있다.

우리 대학 바이오및뇌공학과 최정균 교수팀과 서울아산병원 종양내과 박숙련 교수팀은 면역항암제 치료를 받은 고형암 환자에 대한 대규모 전향적 코호트를 구축하고, 다차원적 분석을 통해 면역항암제 부작용의 위험요인을 규명했다고 22일 밝혔다. 또한 인공지능 딥러닝을 이용해 치료 전 환자에게서 부작용이 나타날지를 예측할 수 있는 모델까지도 개발했다고 알렸다.

기존의 관련 연구들은 소규모로 진행이 되거나, 적은 수의 지표로 국한된 범위에 대해서만 행해졌다. 또한 수행된 연구들은 면역 관련 부작용을 위해 디자인된 연구 설계가 아닌, 다른 목적을 위해 모집된 환자군을 모아 수행하는 후향적 연구 설계로 진행됐다는 한계점이 있었다.

연구팀은 이러한 한계점을 극복하기 위해, 서울아산병원을 필두로 국내 9개 기관과 협력하여 면역 관련 부작용의 포괄적인 위험요인을 밝히기 위한 대규모 전향적 코호트를 구축했다. 또한 환자의 유전체, 전사체, 혈액 지표 등 폭넓은 범위에서 면역 관련 부작용에 대한 위험요인을 밝혀냄으로써, 궁극적으로는 치료 전 미리 환자가 면역항암치료에 대한 부작용을 보일지 알아낼 수 있는 딥러닝 예측 모델을 개발했다. 해당 연구 결과는 다양한 고형암 환자의 임상데이터와 혈액 유전체 데이터에 기반했기에, 향후 환자의 암종과 상관없이 폭넓게 적용될 수 있을 것으로 기대된다.

우리 대학 바이오및뇌공학과 성창환 박사(現 : 서울아산병원 핵의학과)와 안진현 박사과정이 공동 제1 저자로 참여한 이번 연구는 국제 학술지 ‘네이처 캔서(Nature Cancer)’ 에 게재됐다. (논문명 : Integrative analysis of risk factors for immune-related adverse events of checkpoint blockade therapy in cancer).

이번 연구에는 고려대학교 안암병원, 인제대학교 해운대백병원, 국립암센터, 서울삼성병원, 분당서울대학교병원, 고려대학교 구로병원, 연세대학교 세브란스병원, 서울대학교병원의 연구자들도 참여했다.

최정균 교수는 “이번 연구를 통해 면역항암 치료의 아킬레스건이라고 할 수 있는 면역관련 부작용에 대한 폭넓은 분석과 예측모델의 제시를 통해 향후 전세계 연구진이 사용할 수 있는 대규모 면역관련 부작용 리소스를 제공할 수 있을 것이라 기대한다”라고 말했다.

임상연구를 총괄한 서울아산병원 박숙련 교수는 “현재 면역항암제가 임상에서 광범위하게 사용되고 있고 그 치료 영역을 완치적 세팅으로까지 확장하고 있어 치료 효과뿐 아니라 환자 안전성이 더욱 중요한데 그동안 치료 부작용을 예측할 수 있는 좋은 지표가 없던 상황에서, 이번 연구 결과는 개별 환자의 임상데이터와 유전체 데이터에 기반해 면역항암제의 부작용 발생을 예측할 수 있어 암 환자의 정밀 의료 치료를 실현할 수 있는 기반이 될 것으로 기대한다”고 전했다.

이번 연구는 과학기술정보통신부 인공지능 신약개발 플랫폼 구축 사업의 지원을 받아 수행됐다.

2023.06.22 조회수 8274

면역항암치료 부작용 인공지능으로 예측

면역항암치료는 환자의 면역 시스템을 활성화해 암을 치료하는 혁신적인 3세대 항암 치료 방법으로 알려져 있다. 하지만 면역항암 치료제는 면역활성화에 의해 기존 항암제와는 구분되는 자가면역질환과 유사한 부작용을 유발할 수 있다는 새로운 문제가 제기됐다. 이러한 부작용은 심각한 경우 환자를 죽음에까지 이르게 할 수 있기에 부작용에 대한 연구가 절실한 상황에 놓여있다.

우리 대학 바이오및뇌공학과 최정균 교수팀과 서울아산병원 종양내과 박숙련 교수팀은 면역항암제 치료를 받은 고형암 환자에 대한 대규모 전향적 코호트를 구축하고, 다차원적 분석을 통해 면역항암제 부작용의 위험요인을 규명했다고 22일 밝혔다. 또한 인공지능 딥러닝을 이용해 치료 전 환자에게서 부작용이 나타날지를 예측할 수 있는 모델까지도 개발했다고 알렸다.

기존의 관련 연구들은 소규모로 진행이 되거나, 적은 수의 지표로 국한된 범위에 대해서만 행해졌다. 또한 수행된 연구들은 면역 관련 부작용을 위해 디자인된 연구 설계가 아닌, 다른 목적을 위해 모집된 환자군을 모아 수행하는 후향적 연구 설계로 진행됐다는 한계점이 있었다.

연구팀은 이러한 한계점을 극복하기 위해, 서울아산병원을 필두로 국내 9개 기관과 협력하여 면역 관련 부작용의 포괄적인 위험요인을 밝히기 위한 대규모 전향적 코호트를 구축했다. 또한 환자의 유전체, 전사체, 혈액 지표 등 폭넓은 범위에서 면역 관련 부작용에 대한 위험요인을 밝혀냄으로써, 궁극적으로는 치료 전 미리 환자가 면역항암치료에 대한 부작용을 보일지 알아낼 수 있는 딥러닝 예측 모델을 개발했다. 해당 연구 결과는 다양한 고형암 환자의 임상데이터와 혈액 유전체 데이터에 기반했기에, 향후 환자의 암종과 상관없이 폭넓게 적용될 수 있을 것으로 기대된다.

우리 대학 바이오및뇌공학과 성창환 박사(現 : 서울아산병원 핵의학과)와 안진현 박사과정이 공동 제1 저자로 참여한 이번 연구는 국제 학술지 ‘네이처 캔서(Nature Cancer)’ 에 게재됐다. (논문명 : Integrative analysis of risk factors for immune-related adverse events of checkpoint blockade therapy in cancer).

이번 연구에는 고려대학교 안암병원, 인제대학교 해운대백병원, 국립암센터, 서울삼성병원, 분당서울대학교병원, 고려대학교 구로병원, 연세대학교 세브란스병원, 서울대학교병원의 연구자들도 참여했다.

최정균 교수는 “이번 연구를 통해 면역항암 치료의 아킬레스건이라고 할 수 있는 면역관련 부작용에 대한 폭넓은 분석과 예측모델의 제시를 통해 향후 전세계 연구진이 사용할 수 있는 대규모 면역관련 부작용 리소스를 제공할 수 있을 것이라 기대한다”라고 말했다.

임상연구를 총괄한 서울아산병원 박숙련 교수는 “현재 면역항암제가 임상에서 광범위하게 사용되고 있고 그 치료 영역을 완치적 세팅으로까지 확장하고 있어 치료 효과뿐 아니라 환자 안전성이 더욱 중요한데 그동안 치료 부작용을 예측할 수 있는 좋은 지표가 없던 상황에서, 이번 연구 결과는 개별 환자의 임상데이터와 유전체 데이터에 기반해 면역항암제의 부작용 발생을 예측할 수 있어 암 환자의 정밀 의료 치료를 실현할 수 있는 기반이 될 것으로 기대한다”고 전했다.

이번 연구는 과학기술정보통신부 인공지능 신약개발 플랫폼 구축 사업의 지원을 받아 수행됐다.

2023.06.22 조회수 8274 -

고성능 조립형 SSD 시스템반도체 최초 개발

최근 인공지능을 훈련하기 위해 더 많은 데이터가 필요해지면서 그 중요성은 더욱 증가하고 있으며, 이에 데이터 센터 및 클라우드 서비스를 위한 주요 저장장치인 고성능 SSD(Solid State Drive, 반도체 기억소자를 사용하는 저장장치) 제품의 필요성이 높아지고 있다. 하지만, 고성능 SSD 제품일수록 SSD 내부의 구성요소들이 서로의 성능에 크게 영향을 미치는 상호-결합형(tightly-coupled) 구조의 한계에 부딪혀 성능을 극대화하기 어려웠다.

우리 대학 전기및전자공학부 김동준 교수 연구팀이 고성능 조립형 SSD 시스템 개발을 통해 차세대 SSD의 읽기/쓰기 성능을 비약적으로 높일 뿐 아니라 SSD 수명연장에도 적용 가능한 SSD 시스템 반도체 구조를 세계 최초로 개발했다고 15일 밝혔다.

김동준 교수 연구팀은 기존 SSD 설계가 갖는 상호-결합형 구조의 한계를 밝히고, CPU, GPU 등의 비메모리 시스템 반도체 설계에서 주로 활용되는 칩 내부에서 패킷-기반 데이터를 자유롭게 전송하는 온-칩 네트워크 기술을 바탕으로 SSD 내부에 플래시 메모리 전용 온-칩 네트워크를 구성함으로써 성능을 극대화하는 상호-분리형(de-coupled) 구조를 제안했으며, 이를 통해 SSD의 프론트-엔드 설계와 백-엔드 설계의 상호 의존도를 줄여 독립적으로 설계하고 조립 가능한 ‘조립형 SSD’를 개발했다.

※온-칩 네트워크(on-chip network): CPU/GPU등의 시스템 반도체 설계에 쓰이는 칩 내부의 요소에 대한 패킷-기반 연결구조를 말한다. 온-칩 네트워크는 고성능 시스템 반도체를 위한 필수적인 설계 요소중 하나로서 반도체칩의 규모가 증가할수록 더욱 중요해지는 특징이 있다.

김동준 교수팀이 개발한 조립형 SSD 시스템 구조는 내부 구성요소 중 SSD 컨트롤러 내부, 플래시 메모리 인터페이스를 기점으로 CPU에 가까운 부분을 프론트-엔드(front-end), 플래시 메모리에 가까운 부분을 백-엔드(back-end)로 구분하고, 백-엔드의 플래시 컨트롤러 사이 간 데이터 이동이 가능한 플래시 메모리 전용 온-칩 네트워크를 새롭게 구성해, 성능 감소를 최소화하는 상호-분리형 구조를 제안했다.

SSD를 구동하는 핵심 요소인 플래시 변환 계층의 일부 기능을 하드웨어로 가속하여 플래시 메모리가 갖는 한계를 능동적으로 극복할 수 있는 계기를 마련하였고 상호-분리형 구조는 플래시 변환 계층이 특정 플래시 메모리의 특성에 국한되지 않고, 프론트-엔드 설계와 백-엔드 설계를 독립적으로 수행하는 설계의 용이성을 가지는 점이 ‘조립형’ SSD 구조의 장점이라고 밝혔다. 이를 통해, 기존 시스템 대비 응답시간을 31배 줄일 수 있었고 SSD 불량 블록 관리기법에도 적용해 약 23%의 SSD 수명을 연장할 수 있다고 연구팀 관계자는 설명했다.

전기및전자공학부 김지호 박사과정이 제1 저자, 전기및전자공학부 정명수 교수가 공동 저자로 참여한 이번 연구는 미국 플로리다주 올랜도에서 열리는 컴퓨터 구조 분야 최우수 국제 학술대회인 `제50회 국제 컴퓨터 구조 심포지엄(50th IEEE/ACM International Symposium on Computer Architecture, ISCA 2023)'에서 6월 19일 발표될 예정이다. (논문명: Decoupled SSD: Rethinking SSD Architecture through Network-based Flash Controllers).

연구를 주도한 김동준 교수는 “이번 연구는 기존의 SSD가 가지는 구조적 한계를 규명했다는 점과 CPU와 같은 시스템 메모리 반도체 중심의 온-칩 네트워크 기술을 적용해 하드웨어가 능동적으로 필요한 일을 수행할 수 있다는 점에서 의의가 있으며 차세대 고성능 SSD 시장에 기여할 것으로 보인다”며, “상호-분리형 구조는 수명연장을 위해서도 능동적으로 동작하는 SSD 구조로써 그 가치가 성능에만 국한되지 않아 다양한 쓰임새를 가진다며”연구의 의의를 설명했다.

이번 연구는 컴퓨터 시스템 저장장치 분야의 저명한 연구자인 KAIST 정명수 교수와 컴퓨터 구조 및 인터커넥션 네트워크(Interconnection Network) 분야의 권위자인 김동준 교수, 두 세계적인 연구자의 융합연구를 통해 이루어낸 연구라는 의미가 있다고 관계자는 설명했다.

한편 이번 연구는 한국연구재단, 삼성전자, 반도체설계교육센터(IDEC), 정보통신기획평가원 차세대지능형반도체기술개발사업의 지원을 받아 수행됐다.

2023.06.15 조회수 7686

고성능 조립형 SSD 시스템반도체 최초 개발

최근 인공지능을 훈련하기 위해 더 많은 데이터가 필요해지면서 그 중요성은 더욱 증가하고 있으며, 이에 데이터 센터 및 클라우드 서비스를 위한 주요 저장장치인 고성능 SSD(Solid State Drive, 반도체 기억소자를 사용하는 저장장치) 제품의 필요성이 높아지고 있다. 하지만, 고성능 SSD 제품일수록 SSD 내부의 구성요소들이 서로의 성능에 크게 영향을 미치는 상호-결합형(tightly-coupled) 구조의 한계에 부딪혀 성능을 극대화하기 어려웠다.

우리 대학 전기및전자공학부 김동준 교수 연구팀이 고성능 조립형 SSD 시스템 개발을 통해 차세대 SSD의 읽기/쓰기 성능을 비약적으로 높일 뿐 아니라 SSD 수명연장에도 적용 가능한 SSD 시스템 반도체 구조를 세계 최초로 개발했다고 15일 밝혔다.

김동준 교수 연구팀은 기존 SSD 설계가 갖는 상호-결합형 구조의 한계를 밝히고, CPU, GPU 등의 비메모리 시스템 반도체 설계에서 주로 활용되는 칩 내부에서 패킷-기반 데이터를 자유롭게 전송하는 온-칩 네트워크 기술을 바탕으로 SSD 내부에 플래시 메모리 전용 온-칩 네트워크를 구성함으로써 성능을 극대화하는 상호-분리형(de-coupled) 구조를 제안했으며, 이를 통해 SSD의 프론트-엔드 설계와 백-엔드 설계의 상호 의존도를 줄여 독립적으로 설계하고 조립 가능한 ‘조립형 SSD’를 개발했다.

※온-칩 네트워크(on-chip network): CPU/GPU등의 시스템 반도체 설계에 쓰이는 칩 내부의 요소에 대한 패킷-기반 연결구조를 말한다. 온-칩 네트워크는 고성능 시스템 반도체를 위한 필수적인 설계 요소중 하나로서 반도체칩의 규모가 증가할수록 더욱 중요해지는 특징이 있다.

김동준 교수팀이 개발한 조립형 SSD 시스템 구조는 내부 구성요소 중 SSD 컨트롤러 내부, 플래시 메모리 인터페이스를 기점으로 CPU에 가까운 부분을 프론트-엔드(front-end), 플래시 메모리에 가까운 부분을 백-엔드(back-end)로 구분하고, 백-엔드의 플래시 컨트롤러 사이 간 데이터 이동이 가능한 플래시 메모리 전용 온-칩 네트워크를 새롭게 구성해, 성능 감소를 최소화하는 상호-분리형 구조를 제안했다.

SSD를 구동하는 핵심 요소인 플래시 변환 계층의 일부 기능을 하드웨어로 가속하여 플래시 메모리가 갖는 한계를 능동적으로 극복할 수 있는 계기를 마련하였고 상호-분리형 구조는 플래시 변환 계층이 특정 플래시 메모리의 특성에 국한되지 않고, 프론트-엔드 설계와 백-엔드 설계를 독립적으로 수행하는 설계의 용이성을 가지는 점이 ‘조립형’ SSD 구조의 장점이라고 밝혔다. 이를 통해, 기존 시스템 대비 응답시간을 31배 줄일 수 있었고 SSD 불량 블록 관리기법에도 적용해 약 23%의 SSD 수명을 연장할 수 있다고 연구팀 관계자는 설명했다.

전기및전자공학부 김지호 박사과정이 제1 저자, 전기및전자공학부 정명수 교수가 공동 저자로 참여한 이번 연구는 미국 플로리다주 올랜도에서 열리는 컴퓨터 구조 분야 최우수 국제 학술대회인 `제50회 국제 컴퓨터 구조 심포지엄(50th IEEE/ACM International Symposium on Computer Architecture, ISCA 2023)'에서 6월 19일 발표될 예정이다. (논문명: Decoupled SSD: Rethinking SSD Architecture through Network-based Flash Controllers).

연구를 주도한 김동준 교수는 “이번 연구는 기존의 SSD가 가지는 구조적 한계를 규명했다는 점과 CPU와 같은 시스템 메모리 반도체 중심의 온-칩 네트워크 기술을 적용해 하드웨어가 능동적으로 필요한 일을 수행할 수 있다는 점에서 의의가 있으며 차세대 고성능 SSD 시장에 기여할 것으로 보인다”며, “상호-분리형 구조는 수명연장을 위해서도 능동적으로 동작하는 SSD 구조로써 그 가치가 성능에만 국한되지 않아 다양한 쓰임새를 가진다며”연구의 의의를 설명했다.

이번 연구는 컴퓨터 시스템 저장장치 분야의 저명한 연구자인 KAIST 정명수 교수와 컴퓨터 구조 및 인터커넥션 네트워크(Interconnection Network) 분야의 권위자인 김동준 교수, 두 세계적인 연구자의 융합연구를 통해 이루어낸 연구라는 의미가 있다고 관계자는 설명했다.

한편 이번 연구는 한국연구재단, 삼성전자, 반도체설계교육센터(IDEC), 정보통신기획평가원 차세대지능형반도체기술개발사업의 지원을 받아 수행됐다.

2023.06.15 조회수 7686 -

항암 백신 찾는 ‘딥네오(DeepNeo)’ 개발

신생항원이란 암세포의 돌연변이에서 나온 단백질 조각 중 면역반응을 유도할 수 있는 항원들로서 항암 백신 개발의 이상적인 대상으로 주목받고 있다. 모더나 및 바이오엔텍은 암 치료를 위한 신생항원 백신용으로 개발하던 mRNA 플랫폼을 사용해 COVID-19 백신을 성공적으로 개발한 바 있으며, 현재 대규모 제약회사들과 함께 신생항원 암 백신 임상시험을 진행하고 있다. 이런 암 백신 개발을 위해 핵심적인 단계인 환자 맞춤형 신생항원 발굴에 활용될 인공지능 플랫폼이 개발되어 화제다.

우리 대학 바이오및뇌공학과 최정균 교수가 ㈜펜타메딕스와의 공동연구를 통해 개인 맞춤 치료용 암 백신에 사용될 수 있는 신생항원을 예측하는 인공지능(AI) 모델을 개발하고 웹서비스를 구축했다고 17일 밝혔다.

최정균 교수 연구팀은 딥러닝을 이용해 실제로 T 세포 면역반응을 유도할 수 있는 신생항원을 발굴하는 AI 모델을 개발했으며, 연구자들이 손쉽게 활용할 수 있는 웹서비스를 구축해 DeepNeo라는 이름으로 공개했다 (https://deepneo.net).

기존의 신생항원 발굴 방법론은 MHC* 단백질과 결합할 수 있는 돌연변이를 예측하는 데에 한정되어 있었다. 그러나 암 백신이 효과가 있으려면 돌연변이가 MHC와 결합할 뿐만 아니라 그 결합체가 실제로 T 세포 면역반응을 유발할 수 있어야 하는데, 기존 기술로는 그것이 불가능했다. 따라서 현재 암 백신 임상시험들은 이 결합체들이 실제로 면역반응을 자극할 수 있는지를 알 수 없는 상태로 진행되고 있다.

*MHC란 외부에서 들어온 병원균이나 암세포에서 발생한 항원과 결합하여 우리 몸의 면역세포에 제시해 줌으로써 면역반응을 활성화시키는 역할을 하는 단백질을 일컬음

연구팀은 이러한 문제를 해결하기 위해 새로운 개념의 딥러닝 모델을 구축했고, 여러 빅데이터 분석을 통하여 면역성 및 항암 반응성이 뛰어난 신생항원을 발굴할 수 있음을 확인했다. 따라서 이번에 웹서비스 형태로 구축한 방법론은T 세포 반응을 효과적으로 유도할 수 있는 항암 백신 개발에 활용될 수 있다.

우리 대학 바이오및뇌공학과 김정연 박사과정이 제1 저자로 개발한 핵심 알고리즘은 지난 1월 국제 학술지 ‘네이처 지네틱스(Nature Genetics)’ 에 출판됐으며, 이후 ㈜펜타메딕스의 노승재 박사, 방효은 연구원과의 공동연구를 통해 딥러닝 성능이 더욱 개선된 AI 모델이 웹서비스 형태로 개발돼 이번 4월 국제 학술지 ‘핵산 연구(Nucleic Acids Research)’를 통해 공개됐다.

최정균 교수는 “코로나 백신에서 mRNA 플랫폼이 검증된 만큼 이번에 개발된 AI 기술이 암 백신의 상용화에도 도움이 되기를 희망한다.”고 밝혔다. ㈜펜타메딕스 조대연 대표는 “이번 공동연구를 통해 개발된 플랫폼을 적용한 개인맞춤형 암 백신의 사업화에 박차를 가하겠다”고 전했다.

이번 연구는 한국연구재단 기초연구실지원사업의 지원을 받아 수행됐다.

2023.05.17 조회수 10226

항암 백신 찾는 ‘딥네오(DeepNeo)’ 개발

신생항원이란 암세포의 돌연변이에서 나온 단백질 조각 중 면역반응을 유도할 수 있는 항원들로서 항암 백신 개발의 이상적인 대상으로 주목받고 있다. 모더나 및 바이오엔텍은 암 치료를 위한 신생항원 백신용으로 개발하던 mRNA 플랫폼을 사용해 COVID-19 백신을 성공적으로 개발한 바 있으며, 현재 대규모 제약회사들과 함께 신생항원 암 백신 임상시험을 진행하고 있다. 이런 암 백신 개발을 위해 핵심적인 단계인 환자 맞춤형 신생항원 발굴에 활용될 인공지능 플랫폼이 개발되어 화제다.

우리 대학 바이오및뇌공학과 최정균 교수가 ㈜펜타메딕스와의 공동연구를 통해 개인 맞춤 치료용 암 백신에 사용될 수 있는 신생항원을 예측하는 인공지능(AI) 모델을 개발하고 웹서비스를 구축했다고 17일 밝혔다.

최정균 교수 연구팀은 딥러닝을 이용해 실제로 T 세포 면역반응을 유도할 수 있는 신생항원을 발굴하는 AI 모델을 개발했으며, 연구자들이 손쉽게 활용할 수 있는 웹서비스를 구축해 DeepNeo라는 이름으로 공개했다 (https://deepneo.net).

기존의 신생항원 발굴 방법론은 MHC* 단백질과 결합할 수 있는 돌연변이를 예측하는 데에 한정되어 있었다. 그러나 암 백신이 효과가 있으려면 돌연변이가 MHC와 결합할 뿐만 아니라 그 결합체가 실제로 T 세포 면역반응을 유발할 수 있어야 하는데, 기존 기술로는 그것이 불가능했다. 따라서 현재 암 백신 임상시험들은 이 결합체들이 실제로 면역반응을 자극할 수 있는지를 알 수 없는 상태로 진행되고 있다.

*MHC란 외부에서 들어온 병원균이나 암세포에서 발생한 항원과 결합하여 우리 몸의 면역세포에 제시해 줌으로써 면역반응을 활성화시키는 역할을 하는 단백질을 일컬음

연구팀은 이러한 문제를 해결하기 위해 새로운 개념의 딥러닝 모델을 구축했고, 여러 빅데이터 분석을 통하여 면역성 및 항암 반응성이 뛰어난 신생항원을 발굴할 수 있음을 확인했다. 따라서 이번에 웹서비스 형태로 구축한 방법론은T 세포 반응을 효과적으로 유도할 수 있는 항암 백신 개발에 활용될 수 있다.

우리 대학 바이오및뇌공학과 김정연 박사과정이 제1 저자로 개발한 핵심 알고리즘은 지난 1월 국제 학술지 ‘네이처 지네틱스(Nature Genetics)’ 에 출판됐으며, 이후 ㈜펜타메딕스의 노승재 박사, 방효은 연구원과의 공동연구를 통해 딥러닝 성능이 더욱 개선된 AI 모델이 웹서비스 형태로 개발돼 이번 4월 국제 학술지 ‘핵산 연구(Nucleic Acids Research)’를 통해 공개됐다.

최정균 교수는 “코로나 백신에서 mRNA 플랫폼이 검증된 만큼 이번에 개발된 AI 기술이 암 백신의 상용화에도 도움이 되기를 희망한다.”고 밝혔다. ㈜펜타메딕스 조대연 대표는 “이번 공동연구를 통해 개발된 플랫폼을 적용한 개인맞춤형 암 백신의 사업화에 박차를 가하겠다”고 전했다.

이번 연구는 한국연구재단 기초연구실지원사업의 지원을 받아 수행됐다.

2023.05.17 조회수 10226 -

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05 조회수 11954

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05 조회수 11954 -

인공지능으로 코로나19 치료제 팍스로비드와 기존 약물간 반응 예측 고도화

우리 대학 생명화학공학과 이상엽 특훈교수 연구팀이 인공지능 기반 약물 상호작용 예측 기술을 고도화해, 코로나19 치료제로 사용되는 팍스로비드(PaxlovidTM) 성분과 기존 승인된 약물 간의 상호작용 분석 결과를 논문으로 발표했다고 16일 밝혔다. 이번 논문은 국제저명학술지인 「미국국립과학원회보 (PNAS)」誌’ 3월 13일자 온라인판에 게재됐다.

※ 논문명 : Computational prediction of interactions between Paxlovid and prescription drugs

※ 저자 정보 : 김예지(한국과학기술원, 공동 제1 저자), 류재용(덕성여자대학교, 공동 제1 저자), 김현욱(한국과학기술원, 공동 제1 저자), 이상엽(한국과학기술원, 교신저자) 포함 총 4명

연구팀은 이번 연구에서 2018년에 개발한 인공지능 기반의 약물 상호작용 예측 모델인 딥디디아이(DeepDDI)를 고도화한 딥디디아이2(DeepDDI2)를 개발했다. 딥디디아이2는 기존 딥디디아이가 예측하는 86가지 약물 상호작용 종류보다 더 많은, 총 113가지의 약물 상호작용 종류를 예측한다.

연구팀은 딥디디아이2를 이용하여 코로나19 치료제인 팍스로비드*의 성분(리토나비르, 니르마트렐비르)과 기존에 승인된 약물 간의 상호작용 가능성을 예측하였다. 연구팀은 코로나19 환자 중 고위험군인 고혈압, 당뇨병 등을 앓고 있는 만성질환자가 이미 약물을 복용하고 있어, 약물 상호작용 및 약물 이상 반응이 충분히 분석되지 않은 팍스로비드를 복용 시 문제가 될 수 있다는 점에 착안해 이번 연구를 수행했다.

* 팍스로비드 : 팍스로비드는 미국 제약사인 화이자가 개발한 코로나19 치료제로, 2021년 12월 미국 식품의약국(FDA)의 긴급사용승인을 받았다.

연구팀은 팍스로비드의 성분인 리토나비르와 니르마트렐비르가 2,248개의 승인된 약물과 어떤 상호작용을 하는지, 딥디디아이2를 이용해 예측했다. 예측 결과 리토나비르는 1,403개의 승인된 약물과, 니르마트렐비르는 673개의 승인된 약물과 상호작용이 있을 것으로 예측됐다.

또한, 연구팀은 예측 결과를 활용해, 약물 상호작용 가능성이 높은 승인 약물에 대해, 동일 기전을 갖되 약물 상호작용 가능성이 낮은 대체 약물들을 제안했다. 이에 따라, 리토나비르와의 약물 상호작용 가능성을 낮출 수 있는 대체 약물 124개와 니르마트렐비르와의 약물 상호작용 가능성을 낮출 수 있는 대체 약물 239개를 제안했다.

이번 연구 성과를 통해 약물 상호작용을 정확하게 예측할 수 있는 인공지능 모델을 활용하는 것이 가능해졌으며, 이는 신약 개발 및 약물 처방 시 유용한 정보를 제공함으로써, 디지털 헬스케어, 정밀의료 산업 및 제약 산업에서 중요한 역할을 할 것으로 기대된다.

이상엽 특훈교수는 "이번 연구 결과는 실험과 임상을 통해 검증된 것은 아니므로 100% 의존해서는 안된다“고 강조하면서 ”팬데믹과 같이 긴급한 상황에서 신속하게 개발된 약물을 사용할 때, 예측된 약물 상호작용 유래 약물 이상 반응결과를 전문의가 미리 검토하여 약을 처방할 때 도움을 줄 수 있다는 점에서 의미가 있다"고 말했다.

한편 이번 연구는 과기정통부가 지원하는 KAIST 코로나대응 과학기술 뉴딜사업과 바이오·의료기술개발사업의 지원을 받아 수행됐다.

2023.03.16 조회수 9376

인공지능으로 코로나19 치료제 팍스로비드와 기존 약물간 반응 예측 고도화

우리 대학 생명화학공학과 이상엽 특훈교수 연구팀이 인공지능 기반 약물 상호작용 예측 기술을 고도화해, 코로나19 치료제로 사용되는 팍스로비드(PaxlovidTM) 성분과 기존 승인된 약물 간의 상호작용 분석 결과를 논문으로 발표했다고 16일 밝혔다. 이번 논문은 국제저명학술지인 「미국국립과학원회보 (PNAS)」誌’ 3월 13일자 온라인판에 게재됐다.

※ 논문명 : Computational prediction of interactions between Paxlovid and prescription drugs

※ 저자 정보 : 김예지(한국과학기술원, 공동 제1 저자), 류재용(덕성여자대학교, 공동 제1 저자), 김현욱(한국과학기술원, 공동 제1 저자), 이상엽(한국과학기술원, 교신저자) 포함 총 4명

연구팀은 이번 연구에서 2018년에 개발한 인공지능 기반의 약물 상호작용 예측 모델인 딥디디아이(DeepDDI)를 고도화한 딥디디아이2(DeepDDI2)를 개발했다. 딥디디아이2는 기존 딥디디아이가 예측하는 86가지 약물 상호작용 종류보다 더 많은, 총 113가지의 약물 상호작용 종류를 예측한다.

연구팀은 딥디디아이2를 이용하여 코로나19 치료제인 팍스로비드*의 성분(리토나비르, 니르마트렐비르)과 기존에 승인된 약물 간의 상호작용 가능성을 예측하였다. 연구팀은 코로나19 환자 중 고위험군인 고혈압, 당뇨병 등을 앓고 있는 만성질환자가 이미 약물을 복용하고 있어, 약물 상호작용 및 약물 이상 반응이 충분히 분석되지 않은 팍스로비드를 복용 시 문제가 될 수 있다는 점에 착안해 이번 연구를 수행했다.

* 팍스로비드 : 팍스로비드는 미국 제약사인 화이자가 개발한 코로나19 치료제로, 2021년 12월 미국 식품의약국(FDA)의 긴급사용승인을 받았다.

연구팀은 팍스로비드의 성분인 리토나비르와 니르마트렐비르가 2,248개의 승인된 약물과 어떤 상호작용을 하는지, 딥디디아이2를 이용해 예측했다. 예측 결과 리토나비르는 1,403개의 승인된 약물과, 니르마트렐비르는 673개의 승인된 약물과 상호작용이 있을 것으로 예측됐다.

또한, 연구팀은 예측 결과를 활용해, 약물 상호작용 가능성이 높은 승인 약물에 대해, 동일 기전을 갖되 약물 상호작용 가능성이 낮은 대체 약물들을 제안했다. 이에 따라, 리토나비르와의 약물 상호작용 가능성을 낮출 수 있는 대체 약물 124개와 니르마트렐비르와의 약물 상호작용 가능성을 낮출 수 있는 대체 약물 239개를 제안했다.

이번 연구 성과를 통해 약물 상호작용을 정확하게 예측할 수 있는 인공지능 모델을 활용하는 것이 가능해졌으며, 이는 신약 개발 및 약물 처방 시 유용한 정보를 제공함으로써, 디지털 헬스케어, 정밀의료 산업 및 제약 산업에서 중요한 역할을 할 것으로 기대된다.

이상엽 특훈교수는 "이번 연구 결과는 실험과 임상을 통해 검증된 것은 아니므로 100% 의존해서는 안된다“고 강조하면서 ”팬데믹과 같이 긴급한 상황에서 신속하게 개발된 약물을 사용할 때, 예측된 약물 상호작용 유래 약물 이상 반응결과를 전문의가 미리 검토하여 약을 처방할 때 도움을 줄 수 있다는 점에서 의미가 있다"고 말했다.

한편 이번 연구는 과기정통부가 지원하는 KAIST 코로나대응 과학기술 뉴딜사업과 바이오·의료기술개발사업의 지원을 받아 수행됐다.

2023.03.16 조회수 9376 -

생생한 3차원 실사 이미지 구현하는 ‘메타브레인’ 개발

우리 대학 전기및전자공학부 유회준 교수 연구팀이 실사에 가까운 이미지를 렌더링할 수 있는 인공지능 기반 3D 렌더링을 모바일 기기에서 구현, 고속, 저전력 인공지능(AI: Artificial Intelligent) 반도체*인 메타브레인(MetaVRain)’을 세계 최초로 개발했다고 7일 밝혔다.

* 인공지능 반도체 : 인식·추론·학습·판단 등 인공지능 처리 기능을 탑재하고, 초지능·초저전력·초신뢰 기반의 최적화된 기술로 구현한 반도체

연구팀이 개발한 인공지능 반도체는 GPU로 구동되는 기존 레이 트레이싱 (ray-tracing)* 기반 3D 렌더링을 새로 제작된 AI 반도체 상에서 인공지능 기반 3차원으로 만들어, 기존의 막대한 비용이 들어가는 3차원 영상 캡쳐 스튜디오가 필요없게 되므로 3D 모델 제작에 드는 비용을 크게 줄이고, 사용되는 메모리를 180배 이상 줄일 수 있다. 특히 블렌더(Blender) 등의 복잡한 소프트웨어를 사용하던 기존 3D 그래픽 편집과 디자인을 간단한 인공지능 학습만으로 대체하여, 일반인도 손쉽게 원하는 스타일을 입히고 편집할 수 있다는 장점이 있다.

*레이 트레이싱 (ray-tracing): 광원, 물체의 형태, 질감에 따라 바뀌는 모든 광선의 궤적을 추적함으로써 실사에 가까운 이미지를 얻도록 하는 기술

한동현 박사과정이 제1 저자로 참여한 이번 연구는 지난 2월 18일부터 22일까지 전 세계 반도체 연구자들이 미국 샌프란시스코에 모여 개최한 국제고체회로설계학회(ISSCC)에서 발표됐다. (논문번호 2.7, 논문명: 메타브레인: A 133mW Real-time Hyper-realistic 3D NeRF Processor with 1D-2D Hybrid Neural Engines for Metaverse on Mobile Devices (저자: 한동현, 류준하, 김상엽, 김상진, 유회준))

유 교수팀은 인공지능을 통해 3D 렌더링을 구현할 때 발생하는 비효율적인 연산들을 발견하고 이를 줄이기 위해 사람의 시각적 인식 방식을 결합한 새로운 컨셉의 반도체를 개발했다. 사람은 사물을 기억할 때, 대략적인 윤곽에서 시작하여, 점점 그 형태를 구체화하는 과정과 바로 직전에 보았던 물체라면 이를 토대로 현재의 물체가 어떻게 생겼는지 바로 추측하는 인지능을 가지고 있다. 이러한 사람의 인지 과정을 모방하여, 새롭게 개발한 반도체는 저해상도 복셀을 통해 미리 사물의 대략적인 형태를 파악하고, 과거 렌더링했던 결과를 토대로, 현재 렌더링할 때 필요한 연산량을 최소화하는 연산 방식을 채택하였다.

유 교수팀이 개발한 메타브레인은 사람의 시각적 인식 과정을 모방한 하드웨어 아키텍처뿐만 아니라 최첨단 CMOS 칩을 함께 개발하여, 세계 최고의 성능을 달성하였다. 메타브레인은 인공지능 기반 3D 렌더링 기술에 최적화되어, 최대 100 FPS 이상의 렌더링 속도를 달성하였으며, 이는 기존 GPU보다 911배 빠른 속도다. 뿐만아니라, 1개 영상화면 처리 당 소모에너지를 나타내는 에너지효율 역시 GPU 대비 26,400배 높인 연구 결과로 VR/AR 헤드셋, 모바일 기기에서도 인공지능 기반 실시간 렌더링의 가능성을 열었다.

연구팀은 메타브레인의 활용 예시를 보여주고자, 스마트 3D 렌더링 응용시스템을 함께 개발하였으며, 사용자가 선호하는 스타일에 맞춰, 3D 모델의 스타일을 바꾸는 예제를 보여주었다. 인공지능에게 원하는 스타일의 이미지를 주고 재학습만 수행하면 되기 때문에, 복잡한 소프트웨어의 도움 없이도 손쉽게 3D 모델의 스타일을 손쉽게 바꿀 수 있다. 유 교수팀이 구현한 응용시스템의 예시 이외에도, 사용자의 얼굴을 본떠 만든 실제에 가까운 3D 아바타를 만들거나, 각종 구조물들의 3D 모델을 만들고 영화 제작 환경에 맞춰 날씨를 바꾸는 등 다양한 응용 예시가 가능할 것으로 기대된다.

연구팀은 메타브레인을 시작으로, 앞으로의 3D 그래픽스 분야 역시 인공지능으로 대체되기 시작할 것으로 기대한다며, 인공지능과 3D 그래픽스의 결합은 메타버스 실현을 위한 큰 기술적 혁신이라는 점을 밝혔다.

연구를 주도한 KAIST 전기및전자공학부 유회준 교수는 “현재 3D 그래픽스는 사람이 사물을 어떻게 보고 있는지가 아니라, 사물이 어떻게 생겼는지를 묘사하는데 집중하고 있다”라며 “이번 연구는 인공지능이 사람의 공간 인지 능력을 모방하여 사람이 사물을 인식하고 표현하는 방법을 차용함으로써 효율적인 3D 그래픽스를 가능케 한 연구”라고 본 연구의 의의를 밝혔다. 또한 “메타버스의 실현은 본 연구에서 보인 것처럼 인공지능 기술의 혁신과 인공지능 반도체의 혁신이 함께 이루어질 것”이라 미래를 전망하였다.

데모 동영상 유튜브 주소: https://www.youtube.com/watch?v=m-aqnZhALv0

2023.03.07 조회수 8929

생생한 3차원 실사 이미지 구현하는 ‘메타브레인’ 개발

우리 대학 전기및전자공학부 유회준 교수 연구팀이 실사에 가까운 이미지를 렌더링할 수 있는 인공지능 기반 3D 렌더링을 모바일 기기에서 구현, 고속, 저전력 인공지능(AI: Artificial Intelligent) 반도체*인 메타브레인(MetaVRain)’을 세계 최초로 개발했다고 7일 밝혔다.

* 인공지능 반도체 : 인식·추론·학습·판단 등 인공지능 처리 기능을 탑재하고, 초지능·초저전력·초신뢰 기반의 최적화된 기술로 구현한 반도체

연구팀이 개발한 인공지능 반도체는 GPU로 구동되는 기존 레이 트레이싱 (ray-tracing)* 기반 3D 렌더링을 새로 제작된 AI 반도체 상에서 인공지능 기반 3차원으로 만들어, 기존의 막대한 비용이 들어가는 3차원 영상 캡쳐 스튜디오가 필요없게 되므로 3D 모델 제작에 드는 비용을 크게 줄이고, 사용되는 메모리를 180배 이상 줄일 수 있다. 특히 블렌더(Blender) 등의 복잡한 소프트웨어를 사용하던 기존 3D 그래픽 편집과 디자인을 간단한 인공지능 학습만으로 대체하여, 일반인도 손쉽게 원하는 스타일을 입히고 편집할 수 있다는 장점이 있다.

*레이 트레이싱 (ray-tracing): 광원, 물체의 형태, 질감에 따라 바뀌는 모든 광선의 궤적을 추적함으로써 실사에 가까운 이미지를 얻도록 하는 기술

한동현 박사과정이 제1 저자로 참여한 이번 연구는 지난 2월 18일부터 22일까지 전 세계 반도체 연구자들이 미국 샌프란시스코에 모여 개최한 국제고체회로설계학회(ISSCC)에서 발표됐다. (논문번호 2.7, 논문명: 메타브레인: A 133mW Real-time Hyper-realistic 3D NeRF Processor with 1D-2D Hybrid Neural Engines for Metaverse on Mobile Devices (저자: 한동현, 류준하, 김상엽, 김상진, 유회준))

유 교수팀은 인공지능을 통해 3D 렌더링을 구현할 때 발생하는 비효율적인 연산들을 발견하고 이를 줄이기 위해 사람의 시각적 인식 방식을 결합한 새로운 컨셉의 반도체를 개발했다. 사람은 사물을 기억할 때, 대략적인 윤곽에서 시작하여, 점점 그 형태를 구체화하는 과정과 바로 직전에 보았던 물체라면 이를 토대로 현재의 물체가 어떻게 생겼는지 바로 추측하는 인지능을 가지고 있다. 이러한 사람의 인지 과정을 모방하여, 새롭게 개발한 반도체는 저해상도 복셀을 통해 미리 사물의 대략적인 형태를 파악하고, 과거 렌더링했던 결과를 토대로, 현재 렌더링할 때 필요한 연산량을 최소화하는 연산 방식을 채택하였다.

유 교수팀이 개발한 메타브레인은 사람의 시각적 인식 과정을 모방한 하드웨어 아키텍처뿐만 아니라 최첨단 CMOS 칩을 함께 개발하여, 세계 최고의 성능을 달성하였다. 메타브레인은 인공지능 기반 3D 렌더링 기술에 최적화되어, 최대 100 FPS 이상의 렌더링 속도를 달성하였으며, 이는 기존 GPU보다 911배 빠른 속도다. 뿐만아니라, 1개 영상화면 처리 당 소모에너지를 나타내는 에너지효율 역시 GPU 대비 26,400배 높인 연구 결과로 VR/AR 헤드셋, 모바일 기기에서도 인공지능 기반 실시간 렌더링의 가능성을 열었다.

연구팀은 메타브레인의 활용 예시를 보여주고자, 스마트 3D 렌더링 응용시스템을 함께 개발하였으며, 사용자가 선호하는 스타일에 맞춰, 3D 모델의 스타일을 바꾸는 예제를 보여주었다. 인공지능에게 원하는 스타일의 이미지를 주고 재학습만 수행하면 되기 때문에, 복잡한 소프트웨어의 도움 없이도 손쉽게 3D 모델의 스타일을 손쉽게 바꿀 수 있다. 유 교수팀이 구현한 응용시스템의 예시 이외에도, 사용자의 얼굴을 본떠 만든 실제에 가까운 3D 아바타를 만들거나, 각종 구조물들의 3D 모델을 만들고 영화 제작 환경에 맞춰 날씨를 바꾸는 등 다양한 응용 예시가 가능할 것으로 기대된다.

연구팀은 메타브레인을 시작으로, 앞으로의 3D 그래픽스 분야 역시 인공지능으로 대체되기 시작할 것으로 기대한다며, 인공지능과 3D 그래픽스의 결합은 메타버스 실현을 위한 큰 기술적 혁신이라는 점을 밝혔다.

연구를 주도한 KAIST 전기및전자공학부 유회준 교수는 “현재 3D 그래픽스는 사람이 사물을 어떻게 보고 있는지가 아니라, 사물이 어떻게 생겼는지를 묘사하는데 집중하고 있다”라며 “이번 연구는 인공지능이 사람의 공간 인지 능력을 모방하여 사람이 사물을 인식하고 표현하는 방법을 차용함으로써 효율적인 3D 그래픽스를 가능케 한 연구”라고 본 연구의 의의를 밝혔다. 또한 “메타버스의 실현은 본 연구에서 보인 것처럼 인공지능 기술의 혁신과 인공지능 반도체의 혁신이 함께 이루어질 것”이라 미래를 전망하였다.

데모 동영상 유튜브 주소: https://www.youtube.com/watch?v=m-aqnZhALv0

2023.03.07 조회수 8929 -

암세포만 공략하는 스마트 면역세포 시스템 개발

우리 대학 바이오및뇌공학과 최정균 교수와 의과학대학원 박종은 교수 공동연구팀이 인공지능과 빅데이터 분석을 기반으로 스마트 면역세포를 통한 암 치료의 핵심 기술을 개발했다고 밝혔다. 이 기술은 키메라 항원 수용체(Chimeric antigen receptor, CAR)가 논리회로를 통해 작동하게 함으로써 정확하게 암세포만 공략할 수 있도록 하는 차세대 면역항암 치료법으로 기대가 모아진다. 이번 연구는 분당차병원 안희정 교수와 가톨릭의대 이혜옥 교수가 공동연구로 참여했다.

최정균 교수 연구팀은 수백만개의 세포에 대한 유전자 발현 데이터베이스를 구축하고 이를 이용해 종양세포와 정상세포 간의 유전자 발현 양상 차이를 논리회로 기반으로 찾아낼 수 있는 딥러닝 알고리즘을 개발하고 검증하는 데 성공했다. 이 방법론으로 찾아진 논리회로를 장착한 CAR 면역세포는 마치 컴퓨터처럼 암과 정상 세포를 구별하여 작동함으로써 부작용없이 암세포만 정확하게 공략하는 것이 가능하다.

바이오및뇌공학과 권준하 박사, 의과학대학원 강준호 박사과정 학생이 공동 제1 저자로 참여한 이번 연구는 국제 학술지 '네이처 바이오테크놀로지(Nature Biotechnology)'에 지난 2월 16일 출판됐다. (논문명: Single-cell mapping of combinatorial target antigens for CAR switches using logic gates)

최근의 암 연구에서 가장 많은 시도와 진전이 있었던 분야는 바로 면역항암치료이다. 암환자가 갖고 있는 면역체계를 활용하여 암을 극복하는 이 치료 분야에는 몇 가지 방법이 있는데, 면역관문억제제 및 암백신과 더불어 세포치료 또한 해당된다. 특히, 키메라 항원 수용체를 장착한 CAR-T 혹은 CAR-NK라고 하는 면역세포들은 암항원을 인식하여 암세포를 직접 파괴할 수 있다.

CAR 세포치료는 현재 혈액암에서의 성공을 시작으로 고형암으로 그 적용 범위를 넓히고자 하는 중인데, 혈액암과 달리 고형암에서는 부작용을 최소화하면서 효과적인 암 살상 능력을 보유하는 CAR 세포 개발에 어려움이 있었다. 이에 따라 최근에는 한 단계 진보된 CAR 엔지니어링 기술, 즉 AND, OR, NOT 과 같은 컴퓨터 연산 논리회로를 활용해 효과적으로 암세포를 공략할 수 있는 스마트 면역세포 개발이 활발히 진행되고 있다.

이러한 시점에서, 연구진은 세포 단위에서 정확히 암세포들에서만 발현하는 유전자들을 발굴하기 위해 대규모 암 및 정상 단일세포 데이터베이스를 구축했다. 이어서 연구진은 암세포들과 정상세포들을 가장 잘 구별할 수 있는 유전자 조합을 검색하는 인공지능 알고리즘을 개발했다. 특히 이 알고리즘은, 모든 유전자 조합에 대한 세포 단위 시뮬레이션을 통해 암세포만을 특이적으로 공략할 수 있는 논리회로를 찾아내는데 사용되었다. 이 방법론으로 찾아진 논리회로를 장착한 CAR 면역세포는 마치 컴퓨터처럼 암과 정상 세포를 구별하여 작동함으로써 부작용은 최소화하면서도 항암치료의 효과는 극대화시킬 수 있을 것으로 기대된다.

제1 저자인 권준하 박사는 "이번 연구는 이전에 시도된 적이 없는 방법론을 제시했는데, 특히 주목할 점은 수백만개의 개별 암세포 및 정상세포들에 대한 시뮬레이션을 통해 최적의 CAR 세포용 회로들을 찾아낸 과정이다ˮ라며 "인공지능과 컴퓨터 논리회로를 면역세포 엔지니어링에 적용하는 획기적인 기술로서 혈액암에서 성공적으로 사용되고 있는 CAR 세포치료가 고형암으로 확대되는데 중요한 역할을 할 것으로 기대된다"고 설명했다.ᅠ

이번 연구는 한국연구재단 원천기술개발사업-차세대응용오믹스사업의 지원을 받아 수행됐다.

2023.03.02 조회수 14183

암세포만 공략하는 스마트 면역세포 시스템 개발

우리 대학 바이오및뇌공학과 최정균 교수와 의과학대학원 박종은 교수 공동연구팀이 인공지능과 빅데이터 분석을 기반으로 스마트 면역세포를 통한 암 치료의 핵심 기술을 개발했다고 밝혔다. 이 기술은 키메라 항원 수용체(Chimeric antigen receptor, CAR)가 논리회로를 통해 작동하게 함으로써 정확하게 암세포만 공략할 수 있도록 하는 차세대 면역항암 치료법으로 기대가 모아진다. 이번 연구는 분당차병원 안희정 교수와 가톨릭의대 이혜옥 교수가 공동연구로 참여했다.

최정균 교수 연구팀은 수백만개의 세포에 대한 유전자 발현 데이터베이스를 구축하고 이를 이용해 종양세포와 정상세포 간의 유전자 발현 양상 차이를 논리회로 기반으로 찾아낼 수 있는 딥러닝 알고리즘을 개발하고 검증하는 데 성공했다. 이 방법론으로 찾아진 논리회로를 장착한 CAR 면역세포는 마치 컴퓨터처럼 암과 정상 세포를 구별하여 작동함으로써 부작용없이 암세포만 정확하게 공략하는 것이 가능하다.

바이오및뇌공학과 권준하 박사, 의과학대학원 강준호 박사과정 학생이 공동 제1 저자로 참여한 이번 연구는 국제 학술지 '네이처 바이오테크놀로지(Nature Biotechnology)'에 지난 2월 16일 출판됐다. (논문명: Single-cell mapping of combinatorial target antigens for CAR switches using logic gates)

최근의 암 연구에서 가장 많은 시도와 진전이 있었던 분야는 바로 면역항암치료이다. 암환자가 갖고 있는 면역체계를 활용하여 암을 극복하는 이 치료 분야에는 몇 가지 방법이 있는데, 면역관문억제제 및 암백신과 더불어 세포치료 또한 해당된다. 특히, 키메라 항원 수용체를 장착한 CAR-T 혹은 CAR-NK라고 하는 면역세포들은 암항원을 인식하여 암세포를 직접 파괴할 수 있다.

CAR 세포치료는 현재 혈액암에서의 성공을 시작으로 고형암으로 그 적용 범위를 넓히고자 하는 중인데, 혈액암과 달리 고형암에서는 부작용을 최소화하면서 효과적인 암 살상 능력을 보유하는 CAR 세포 개발에 어려움이 있었다. 이에 따라 최근에는 한 단계 진보된 CAR 엔지니어링 기술, 즉 AND, OR, NOT 과 같은 컴퓨터 연산 논리회로를 활용해 효과적으로 암세포를 공략할 수 있는 스마트 면역세포 개발이 활발히 진행되고 있다.

이러한 시점에서, 연구진은 세포 단위에서 정확히 암세포들에서만 발현하는 유전자들을 발굴하기 위해 대규모 암 및 정상 단일세포 데이터베이스를 구축했다. 이어서 연구진은 암세포들과 정상세포들을 가장 잘 구별할 수 있는 유전자 조합을 검색하는 인공지능 알고리즘을 개발했다. 특히 이 알고리즘은, 모든 유전자 조합에 대한 세포 단위 시뮬레이션을 통해 암세포만을 특이적으로 공략할 수 있는 논리회로를 찾아내는데 사용되었다. 이 방법론으로 찾아진 논리회로를 장착한 CAR 면역세포는 마치 컴퓨터처럼 암과 정상 세포를 구별하여 작동함으로써 부작용은 최소화하면서도 항암치료의 효과는 극대화시킬 수 있을 것으로 기대된다.

제1 저자인 권준하 박사는 "이번 연구는 이전에 시도된 적이 없는 방법론을 제시했는데, 특히 주목할 점은 수백만개의 개별 암세포 및 정상세포들에 대한 시뮬레이션을 통해 최적의 CAR 세포용 회로들을 찾아낸 과정이다ˮ라며 "인공지능과 컴퓨터 논리회로를 면역세포 엔지니어링에 적용하는 획기적인 기술로서 혈액암에서 성공적으로 사용되고 있는 CAR 세포치료가 고형암으로 확대되는데 중요한 역할을 할 것으로 기대된다"고 설명했다.ᅠ

이번 연구는 한국연구재단 원천기술개발사업-차세대응용오믹스사업의 지원을 받아 수행됐다.

2023.03.02 조회수 14183 -

똑똑한 영상 복원 인공지능 기술 개발

딥러닝 기술은 영상 복원 속도가 기존 알고리즘 대비 수백 배 이상 빠를 뿐만 아니라 복원 정확도 역시 높다. 하지만, 주어진 학습 데이터에만 의존하는 딥러닝 기술은 영상 취득 환경상에 변화가 생기면 성능이 급격히 저하되는 치명적인 약점이 있다. 이는 알파고와 이세돌 九단과의 대국 시 `신의 한 수'에 의해 알파고의 성능이 급격하게 저하되었던 사례를 떠올리면 쉽게 이해할 수 있다. 즉, 인공지능이 학습하지 못했던 변수(학습 데이터상에 존재하지 않는 수)가 발생할 때 신뢰도가 급격히 낮아지는 인공지능 기술의 근본적인 문제이기도 하다.

우리 대학 바이오및뇌공학과 장무석 교수 연구팀과 김재철AI 대학원 예종철 교수 연구팀이 공동 연구를 통해 인공 지능의 신뢰도 문제를 해결할 수 있는 물리적 학습 기반의 영상 복원 딥러닝 기술을 개발했다고 6일 밝혔다.

연구팀은 영상 취득 환경에서 발생할 수 있는 변수 대부분이 물리적 법칙을 통해 수학적으로 기술 가능하다는 점에 착안해 물리적 법칙과 심층 신경망이 통합된 학습 기법을 제시했다.

모든 영상 기술은 물리적인 영상 기기를 통해 영상 정보를 취득한다. 연구팀은 이 정보 취득 과정에 대한 물리적인 통찰력을 인공지능에 학습시키는 방법을 개발했다. 예를 들면, `네가 도출한 복원 결과가 물리적으로 합당할까?' 혹은 `이 영상 기기는 물리적으로 이런 변수가 생길 수 있을 것 같은데?'라는 식의 질문을 통해 물리적 통찰력을 인공지능에 이식하는 방법을 제시한 것이다.

연구팀은 변화하는 영상 취득 환경에서도 신뢰도 높은 홀로그래피 영상* 을 복원하는데 성공했다. 홀로그래피 영상 기술은 의료 영상, 군용 감시, 자율 주행용 영상 등 다양한 정밀 영상 기술에 다양하게 활용될 수 있는데, 이번 연구는 의료 진단 분야의 활용성을 집중적으로 검증하였다.

*홀로그래피 영상: 물체의 그림자 패턴(회절 패턴)으로부터 물체의 형태를 복원하는 영상 기법, 일반적인 영상 기술과 달리 위상 변화에 의한 물체의 미세 구조를 감지할 수 있는 영상 기술

연구팀은 먼저 3차원 공간상에서 매우 빠르게 움직이는 적혈구의 회절 영상(확산된 그림자형상)으로부터 적혈구의 형태를 실시간으로 복원하는데 성공했다. 이러한 동적인 영상 환경에서 예상치 못한 변수로는 여러 개의 적혈구 덩어리가 복잡하게 겹쳐진다거나 적혈구가 예상하지 못했던 위치로 흘러가는 경우를 생각해 볼 수 있다. 여기서, 연구팀은 인공 지능이 생성한 영상이 합당한 결과인지 빛 전파 이론을 통해 검산하는 방식으로 물리적으로 유효한 복원 신뢰도를 구현하는데 성공하였다.

연구팀은 암 진단의 표준기술로 자리잡고 있는 생검 조직(생체에서 조직 일부를 메스나 바늘로 채취하는 것)의 영상 복원에도 성공했다. 주목할 점은 특정한 카메라 위치에서 측정된 회절 영상만을 학습했음에도 인공지능의 인지능력이 부가되어 다양한 카메라 위치에서도 물체를 인식하는데 성공했다는 점이다. 이번에 구현된 기술은 세포 염색 과정이나 수 천 만원에 달하는 현미경이 필요하지 않아 생검 조직 검사의 속도와 비용을 크게 개선할 수 있을 것으로 기대된다.

물리적 통찰력을 인공 지능에 이식하는 영상 복원 기술은 의료 진단 분야 뿐만 아니라 광범위한 영상 기술에 활용될 것으로 기대된다. 최근 영상 기술 산업계 (모바일 기기 카메라, 의료 진단용 MRI, CT, 광 기반 반도체 공정 불량 검출 등) 에선 인공지능 솔루션 탑재가 활발히 이루어지고 있다. 영상 취득에 사용되는 센서, 물체의 밝기, 물체까지의 거리와 같은 영상 취득 환경은 사용자마다 다를 수밖에 없어 적응 능력을 갖춘 인공 지능 솔루션에 대한 수요가 큰 상황이다. 현재 대부분의 인공 지능 기술은 적응 능력 부재로 신뢰도가 낮은 문제 때문에 실제 현장에서 활용성이 제한적인 상황이다.

바이오및뇌공학과 이찬석 연구원은 "데이터와 물리 법칙을 동시에 학습하는 적응형 인공지능 기술은 홀로그래피 영상뿐만 아니라 초고해상도 영상, 3차원 영상, 비시선 영상(장애물 뒷면을 보는 영상) 등 다양한 계산 영상 기술에 적용될 수 있을 것으로 기대된다ˮ고 밝혔다.

연구진은 "이번 연구를 통해 인공지능 학습에 있어서 학습 데이터에 대한 강한 의존성(신뢰도 문제)을 물리적 법칙을 결합해 해소했을 뿐만 아니라, 이미지 복원에 있어 매게 변수화된 전방 모델을 기반으로 했기 때문에 신뢰도와 적응성이 크게 향상됐다ˮ며, 이어 "이번 연구에서는 데이터의 다양한 특성 중에서 수학적 혹은 물리적으로 정확히 다룰 수 있는 측면에 집중했고, 향후 무작위적인 잡음이나 데이터의 형태에 대해서도 제약받지 않는 범용 복원 알고리즘을 개발하는 데 주력할 것이다ˮ라고 밝혔다.

바이오및뇌공학과 이찬석 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 1월 17일 字 출판됐다. (논문명: Deep learning based on parameterized physical forward model for adaptive holographic imaging with unpaired data)

한편 이번 연구는 삼성미래기술육성사업과 선도연구센터사업의 지원을 받아 수행됐다.

2023.02.06 조회수 8915

똑똑한 영상 복원 인공지능 기술 개발

딥러닝 기술은 영상 복원 속도가 기존 알고리즘 대비 수백 배 이상 빠를 뿐만 아니라 복원 정확도 역시 높다. 하지만, 주어진 학습 데이터에만 의존하는 딥러닝 기술은 영상 취득 환경상에 변화가 생기면 성능이 급격히 저하되는 치명적인 약점이 있다. 이는 알파고와 이세돌 九단과의 대국 시 `신의 한 수'에 의해 알파고의 성능이 급격하게 저하되었던 사례를 떠올리면 쉽게 이해할 수 있다. 즉, 인공지능이 학습하지 못했던 변수(학습 데이터상에 존재하지 않는 수)가 발생할 때 신뢰도가 급격히 낮아지는 인공지능 기술의 근본적인 문제이기도 하다.

우리 대학 바이오및뇌공학과 장무석 교수 연구팀과 김재철AI 대학원 예종철 교수 연구팀이 공동 연구를 통해 인공 지능의 신뢰도 문제를 해결할 수 있는 물리적 학습 기반의 영상 복원 딥러닝 기술을 개발했다고 6일 밝혔다.

연구팀은 영상 취득 환경에서 발생할 수 있는 변수 대부분이 물리적 법칙을 통해 수학적으로 기술 가능하다는 점에 착안해 물리적 법칙과 심층 신경망이 통합된 학습 기법을 제시했다.

모든 영상 기술은 물리적인 영상 기기를 통해 영상 정보를 취득한다. 연구팀은 이 정보 취득 과정에 대한 물리적인 통찰력을 인공지능에 학습시키는 방법을 개발했다. 예를 들면, `네가 도출한 복원 결과가 물리적으로 합당할까?' 혹은 `이 영상 기기는 물리적으로 이런 변수가 생길 수 있을 것 같은데?'라는 식의 질문을 통해 물리적 통찰력을 인공지능에 이식하는 방법을 제시한 것이다.

연구팀은 변화하는 영상 취득 환경에서도 신뢰도 높은 홀로그래피 영상* 을 복원하는데 성공했다. 홀로그래피 영상 기술은 의료 영상, 군용 감시, 자율 주행용 영상 등 다양한 정밀 영상 기술에 다양하게 활용될 수 있는데, 이번 연구는 의료 진단 분야의 활용성을 집중적으로 검증하였다.

*홀로그래피 영상: 물체의 그림자 패턴(회절 패턴)으로부터 물체의 형태를 복원하는 영상 기법, 일반적인 영상 기술과 달리 위상 변화에 의한 물체의 미세 구조를 감지할 수 있는 영상 기술

연구팀은 먼저 3차원 공간상에서 매우 빠르게 움직이는 적혈구의 회절 영상(확산된 그림자형상)으로부터 적혈구의 형태를 실시간으로 복원하는데 성공했다. 이러한 동적인 영상 환경에서 예상치 못한 변수로는 여러 개의 적혈구 덩어리가 복잡하게 겹쳐진다거나 적혈구가 예상하지 못했던 위치로 흘러가는 경우를 생각해 볼 수 있다. 여기서, 연구팀은 인공 지능이 생성한 영상이 합당한 결과인지 빛 전파 이론을 통해 검산하는 방식으로 물리적으로 유효한 복원 신뢰도를 구현하는데 성공하였다.

연구팀은 암 진단의 표준기술로 자리잡고 있는 생검 조직(생체에서 조직 일부를 메스나 바늘로 채취하는 것)의 영상 복원에도 성공했다. 주목할 점은 특정한 카메라 위치에서 측정된 회절 영상만을 학습했음에도 인공지능의 인지능력이 부가되어 다양한 카메라 위치에서도 물체를 인식하는데 성공했다는 점이다. 이번에 구현된 기술은 세포 염색 과정이나 수 천 만원에 달하는 현미경이 필요하지 않아 생검 조직 검사의 속도와 비용을 크게 개선할 수 있을 것으로 기대된다.

물리적 통찰력을 인공 지능에 이식하는 영상 복원 기술은 의료 진단 분야 뿐만 아니라 광범위한 영상 기술에 활용될 것으로 기대된다. 최근 영상 기술 산업계 (모바일 기기 카메라, 의료 진단용 MRI, CT, 광 기반 반도체 공정 불량 검출 등) 에선 인공지능 솔루션 탑재가 활발히 이루어지고 있다. 영상 취득에 사용되는 센서, 물체의 밝기, 물체까지의 거리와 같은 영상 취득 환경은 사용자마다 다를 수밖에 없어 적응 능력을 갖춘 인공 지능 솔루션에 대한 수요가 큰 상황이다. 현재 대부분의 인공 지능 기술은 적응 능력 부재로 신뢰도가 낮은 문제 때문에 실제 현장에서 활용성이 제한적인 상황이다.

바이오및뇌공학과 이찬석 연구원은 "데이터와 물리 법칙을 동시에 학습하는 적응형 인공지능 기술은 홀로그래피 영상뿐만 아니라 초고해상도 영상, 3차원 영상, 비시선 영상(장애물 뒷면을 보는 영상) 등 다양한 계산 영상 기술에 적용될 수 있을 것으로 기대된다ˮ고 밝혔다.

연구진은 "이번 연구를 통해 인공지능 학습에 있어서 학습 데이터에 대한 강한 의존성(신뢰도 문제)을 물리적 법칙을 결합해 해소했을 뿐만 아니라, 이미지 복원에 있어 매게 변수화된 전방 모델을 기반으로 했기 때문에 신뢰도와 적응성이 크게 향상됐다ˮ며, 이어 "이번 연구에서는 데이터의 다양한 특성 중에서 수학적 혹은 물리적으로 정확히 다룰 수 있는 측면에 집중했고, 향후 무작위적인 잡음이나 데이터의 형태에 대해서도 제약받지 않는 범용 복원 알고리즘을 개발하는 데 주력할 것이다ˮ라고 밝혔다.

바이오및뇌공학과 이찬석 박사과정이 제1 저자로 참여한 이번 연구는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 1월 17일 字 출판됐다. (논문명: Deep learning based on parameterized physical forward model for adaptive holographic imaging with unpaired data)

한편 이번 연구는 삼성미래기술육성사업과 선도연구센터사업의 지원을 받아 수행됐다.

2023.02.06 조회수 8915 -

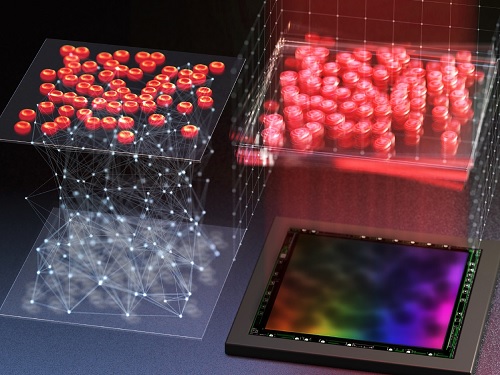

사진에서 3차원 정보를 추론하는 인공지능 반도체 IP(지식재산권) 세계 최초 개발

우리 대학 전기및전자공학부 유회준 교수가 이끄는 PIM 반도체 설계 연구센터(AI-PIM)가 유수 학계에서 인정한 5종의 최첨단 인공지능 반도체 IP(지식재산권)를 개발했다고 29일 밝혔다.

대표적으로 심층신경망 추론 기술 및 센서 퓨전* 기술을 통해 사진으로부터 3차원 공간정보 추출하고 물체를 인식해 처리하는 인공지능(AI) 칩은 KAIST에서 세계 최초로 개발해 SRAM PIM** 시스템에 필요한 기술을 IP(지식재산권)화 한 것이다.

* 센서 퓨전 : 카메라, 거리센서 등의 각종 센서로부터 얻은 데이터를 결합하여보다 정확한 데이터를 얻는 방식

** SRAM PIM : 기존 메모리 SRAM과 DRAM 중 SRAM에 연산기를 결합한 PIM반도체

이 IP는 올해 2월 20일부터 28일까지 개최된 국제고체회로설계학회(ISSCC)에서 현장 시연을 통해 많은 주목을 받았으며, 이를 누구라도 편리하게 활용할 수 있도록 한 것이다. (웹사이트 : www.ai-pim.org)

KAIST PIM 반도체 설계연구센터는 해당 IP를 포함해 ADC*, PLL** 등 총 5가지의 PIM IP를 확보했으며, 지난 28일 웹사이트를 오픈해 연구자들이 공유할 수 있는 환경을 제공하고 있다.

* ADC(Analog to Digital Converter) : 아날로그 데이터를 디지털 데이터로 변환시키는 회로

** PLL(Phase-Locked Loop) : 내부 신호의 위상과 외부 신호의 위상을 동기화할 수 있도록 설계된 회로

기존 물체 인식 인공지능 반도체는 사진과 같은 2차원 정보를 인식하는 `사진인식기술'에 불과하다. 하지만 현실 세계의 물체들은 3차원 구조물이기 때문에 3차원 공간정보를 활용해야만 정확한 `물체인식'이 가능하다.

3차원 공간정보는 사진과 같은 2차원 정보에 거리정보를 포함시켜 실제 3차원 공간을 표현한 것으로, 3차원 공간정보에 물체를 식별해 해당 물체의 위치 및 각도를 추적하는 3차원 물체인식 기술이다. 이는 자율주행, 자동화 기술, 개인용 증강현실 (AR)과 가상현실(VR) 등과 같은 3D 어플리케이션에서 사용하는 핵심기술이다.

기존 ToF 센서*를 활용해 센서 뷰 내에 있는 모든 물체에 대한 정밀한 3차원 정보를 추출하는 것은 전력 소모가 매우 크기 때문에 배터리 기반 모바일 장치(스마트폰, 태블릿 등)에서는 사용하기 어렵다.

* ToF 센서 : 3차원 공간정보를 추출하는 Time-of-Flight 센서로, 레이저를 방출하고 반사된 레이저가 검출되는 시간을 측정하여 거리를 계산, 대표적인 센서로 3D 라이다 (LiDAR) 센서가 있음

또한, ToF 센서는 특정 측정 환경에서 3차원 정보가 손실되는 문제와 데이터 전처리 과정에 많은 시간이 소요된다는 문제점이 있다.

3차원 물체인식 기술은 데이터가 복잡해 기존 인공지능 2차원 사진인식 가속 프로세서로 처리하기 어렵다. 이는 3차원 포인트 클라우드 데이터를 어떻게 선택하고 그룹화하느냐에 따라 메모리 접근량이 달라진다.

따라서 3차원 포인트 클라우드 기반 인공지능 추론은 연산 능력이 제한적이고 메모리가 작은 모바일 장치에서는 소프트웨어만으로 구현할 수 없었다.

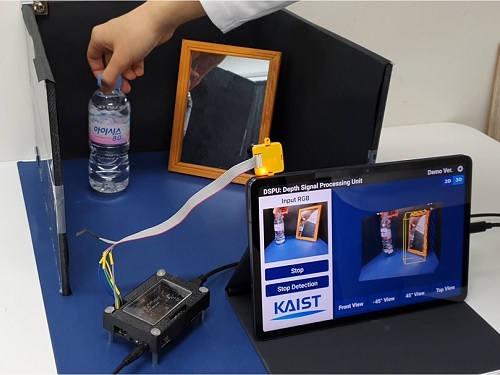

이에 연구팀은 카메라와 저전력 거리센서 (64픽셀)를 사용하여 3차원 공간정보를 생성했고, 모바일에서도 3차원 어플리케이션 구현이 가능한 반도체 (DSPU: Depth Signal Processing Unit)를 개발함으로써 인공지능 반도체의 활용범위를 넓혔다.

모바일 기기에서 저전력 센서를 활용한 3차원 정보 처리 시스템을 구동하면서, 실시간 심층신경망 추론과 센서 퓨전 기술을 가속하기 위해서는 다양한 핵심기술이 필요하다. 인공지능 핵심기술이 적용된 DSPU는 단순 ToF센서에 의존했던 3차원 물체인식 가속기 반도체 대비 63.4% 낮춘 전력 소모와 53.6% 낮춘 지연시간을 달성했다.

PIM반도체 설계연구센터(AI-PIM)의 소장인 유회준 교수는 “이번 연구는 저가의 거리센서와 카메라를 융합해 3차원 데이터 처리를 가능하게 한 인공지능 반도체를 IP화했다는 점에서 의미가 크며, 모바일 기기에서 인공지능 활용 영역을 크게 넓혀 다양한 분야에 응용 및 기술이전을 기대하고 있다”고 연구의 의의를 설명했다.

한편, 이번 연구는 과학기술정보통신부와 정보통신기획평가원의 PIM인공지능반도체핵심기술개발사업을 통해 개발되었으며, 이와 관련해 PIM 반도체 관련 기업과 연구기관에 개발된 IP들의 기술이전 및 활용을 돕고 있다.

2022.12.29 조회수 9374

사진에서 3차원 정보를 추론하는 인공지능 반도체 IP(지식재산권) 세계 최초 개발

우리 대학 전기및전자공학부 유회준 교수가 이끄는 PIM 반도체 설계 연구센터(AI-PIM)가 유수 학계에서 인정한 5종의 최첨단 인공지능 반도체 IP(지식재산권)를 개발했다고 29일 밝혔다.

대표적으로 심층신경망 추론 기술 및 센서 퓨전* 기술을 통해 사진으로부터 3차원 공간정보 추출하고 물체를 인식해 처리하는 인공지능(AI) 칩은 KAIST에서 세계 최초로 개발해 SRAM PIM** 시스템에 필요한 기술을 IP(지식재산권)화 한 것이다.

* 센서 퓨전 : 카메라, 거리센서 등의 각종 센서로부터 얻은 데이터를 결합하여보다 정확한 데이터를 얻는 방식

** SRAM PIM : 기존 메모리 SRAM과 DRAM 중 SRAM에 연산기를 결합한 PIM반도체

이 IP는 올해 2월 20일부터 28일까지 개최된 국제고체회로설계학회(ISSCC)에서 현장 시연을 통해 많은 주목을 받았으며, 이를 누구라도 편리하게 활용할 수 있도록 한 것이다. (웹사이트 : www.ai-pim.org)

KAIST PIM 반도체 설계연구센터는 해당 IP를 포함해 ADC*, PLL** 등 총 5가지의 PIM IP를 확보했으며, 지난 28일 웹사이트를 오픈해 연구자들이 공유할 수 있는 환경을 제공하고 있다.

* ADC(Analog to Digital Converter) : 아날로그 데이터를 디지털 데이터로 변환시키는 회로

** PLL(Phase-Locked Loop) : 내부 신호의 위상과 외부 신호의 위상을 동기화할 수 있도록 설계된 회로

기존 물체 인식 인공지능 반도체는 사진과 같은 2차원 정보를 인식하는 `사진인식기술'에 불과하다. 하지만 현실 세계의 물체들은 3차원 구조물이기 때문에 3차원 공간정보를 활용해야만 정확한 `물체인식'이 가능하다.

3차원 공간정보는 사진과 같은 2차원 정보에 거리정보를 포함시켜 실제 3차원 공간을 표현한 것으로, 3차원 공간정보에 물체를 식별해 해당 물체의 위치 및 각도를 추적하는 3차원 물체인식 기술이다. 이는 자율주행, 자동화 기술, 개인용 증강현실 (AR)과 가상현실(VR) 등과 같은 3D 어플리케이션에서 사용하는 핵심기술이다.

기존 ToF 센서*를 활용해 센서 뷰 내에 있는 모든 물체에 대한 정밀한 3차원 정보를 추출하는 것은 전력 소모가 매우 크기 때문에 배터리 기반 모바일 장치(스마트폰, 태블릿 등)에서는 사용하기 어렵다.

* ToF 센서 : 3차원 공간정보를 추출하는 Time-of-Flight 센서로, 레이저를 방출하고 반사된 레이저가 검출되는 시간을 측정하여 거리를 계산, 대표적인 센서로 3D 라이다 (LiDAR) 센서가 있음

또한, ToF 센서는 특정 측정 환경에서 3차원 정보가 손실되는 문제와 데이터 전처리 과정에 많은 시간이 소요된다는 문제점이 있다.

3차원 물체인식 기술은 데이터가 복잡해 기존 인공지능 2차원 사진인식 가속 프로세서로 처리하기 어렵다. 이는 3차원 포인트 클라우드 데이터를 어떻게 선택하고 그룹화하느냐에 따라 메모리 접근량이 달라진다.

따라서 3차원 포인트 클라우드 기반 인공지능 추론은 연산 능력이 제한적이고 메모리가 작은 모바일 장치에서는 소프트웨어만으로 구현할 수 없었다.

이에 연구팀은 카메라와 저전력 거리센서 (64픽셀)를 사용하여 3차원 공간정보를 생성했고, 모바일에서도 3차원 어플리케이션 구현이 가능한 반도체 (DSPU: Depth Signal Processing Unit)를 개발함으로써 인공지능 반도체의 활용범위를 넓혔다.

모바일 기기에서 저전력 센서를 활용한 3차원 정보 처리 시스템을 구동하면서, 실시간 심층신경망 추론과 센서 퓨전 기술을 가속하기 위해서는 다양한 핵심기술이 필요하다. 인공지능 핵심기술이 적용된 DSPU는 단순 ToF센서에 의존했던 3차원 물체인식 가속기 반도체 대비 63.4% 낮춘 전력 소모와 53.6% 낮춘 지연시간을 달성했다.

PIM반도체 설계연구센터(AI-PIM)의 소장인 유회준 교수는 “이번 연구는 저가의 거리센서와 카메라를 융합해 3차원 데이터 처리를 가능하게 한 인공지능 반도체를 IP화했다는 점에서 의미가 크며, 모바일 기기에서 인공지능 활용 영역을 크게 넓혀 다양한 분야에 응용 및 기술이전을 기대하고 있다”고 연구의 의의를 설명했다.

한편, 이번 연구는 과학기술정보통신부와 정보통신기획평가원의 PIM인공지능반도체핵심기술개발사업을 통해 개발되었으며, 이와 관련해 PIM 반도체 관련 기업과 연구기관에 개발된 IP들의 기술이전 및 활용을 돕고 있다.

2022.12.29 조회수 9374 -

인공지능으로 정확한 세포 이미지 분석..세계 AI 생명과학 분야 대회 우승

우리 대학 김재철AI대학원 윤세영 교수 연구팀이 세계 최고 수준의 인공지능(AI) 학회인 `뉴립스(NeurIPS, 신경정보처리시스템학회) 2022'에서 개최된 `세포 인식기술 경진대회'에서 취리히 리서치센터, 베이징대, 칭화대, 미시간대 등 다수의 세계 연구팀을 모두 제치고 1위로 우승을 달성했다고 28일 밝혔다.

뉴립스는 국제머신러닝학회(ICML), 표현학습국제학회(ICLR)와 함께 세계적인 권위의 기계학습 및 인공지능 분야 학회로 꼽힌다. 뛰어난 연구자들이 제출하는 논문들도 승인될 확률이 25%에 불과할 정도로 학회의 심사를 통과하기 어려운 것으로 알려져 있다.

윤세영 교수 연구팀은 이번 학회에서 `세포 인식기술 경진대회(Cell Segmentation Challenge)'에 참가했다. 이기훈(박사과정), 김상묵(박사과정), 김준기(석사과정)의 3명의 연구원으로 구성된 OSILAB 팀은 초고해상도의 현미경 이미지에서 인공지능이 자동으로 세포를 인식하는 MEDIAR(메디아) 기술을 개발해 2위 팀과 큰 성능 격차로 1위를 달성했다.

세포 인식은 생명 및 의료 분야의 시작이 되는 중요한 기반 기술이지만, 현미경의 측정 기술과 세포의 종류 등에 따라 다양한 형태로 관찰될 수 있어 인공지능이 학습하기 어려운 분야로 알려져 있다. 세포 인식기술 경진대회는 이러한 한계를 극복하기 위해 초고해상도의 현미경 이미지에서 제한된 시간 안에 세포를 인식하는 기술을 주제로 개최됐다.

연구팀은 기계학습에서 소수의 학습 데이터를 더 효과적으로 활용해 성능을 높이는 데이터 기반(Data-Centric) 접근법과 인공신경망의 구조를 개선하는 모델 기반(Model-Centric) 접근법을 종합적으로 활용해 MEDIAR(메디아) 기술을 개발했다. 개발된 인공지능 기술을 통해 정확하게 세포를 인식하고 고해상도 이미지를 빠르게 연산함으로써 대회에서 좋은 성과를 얻을 수 있었다. 지도교수인 KAIST 김재철AI대학원 윤세영 교수는 “MEDIAR는 세포 인식기술 경진대회를 통해 개발됐지만 기상 예측이나 자율주행과 같이 이미지 속 다양한 형태의 개체 인식을 통해 정확한 예측이 필요한 많은 분야에 적용할 수 있다”라고 향후 다양한 활용을 기대했다.

팀을 이끌었던 이기훈 박사과정은 "처음 접하는 분야에서도 성과를 낼 수 있었던 것은 평소 기본기를 중요시하는 교수님의 가르침 덕분ˮ이라며 "새로운 문제에 끊임없이 도전하자는 것이 연구팀의 기본 정신ˮ이라고 강조했다. 이어 같은 연구실 김상묵 박사과정은 "연구 과정에서 많은 실패가 있었지만, 세상에 꼭 필요한 기술이라는 생각으로 끝까지 노력했다ˮ라며 "혼자서라면 절대 해내지 못했던 결과인 만큼 팀원들에게 정말 감사하다ˮ라고 수상 소감을 전했다. 같은 연구실 김준기 석사과정은 "팀원들과 이룬 성과가 의료 분야 인공지능이 겪는 현실의 문제를 해결하는 데 도움이 될 수 있기를 바란다”라고 밝혔다.

연구팀은 생명과학 분야 연구의 발전을 돕기 위해 개발된 기술을 전면 오픈소스로 공개한다고 밝혔다. 학습된 인공지능 모델과 인공지능을 구현하기 위한 프로그램의 소스 코드는 개발자 플랫폼인 깃허브 (GitHub)를 통해 이용할 수 있다.

2022.12.28 조회수 11425

인공지능으로 정확한 세포 이미지 분석..세계 AI 생명과학 분야 대회 우승

우리 대학 김재철AI대학원 윤세영 교수 연구팀이 세계 최고 수준의 인공지능(AI) 학회인 `뉴립스(NeurIPS, 신경정보처리시스템학회) 2022'에서 개최된 `세포 인식기술 경진대회'에서 취리히 리서치센터, 베이징대, 칭화대, 미시간대 등 다수의 세계 연구팀을 모두 제치고 1위로 우승을 달성했다고 28일 밝혔다.

뉴립스는 국제머신러닝학회(ICML), 표현학습국제학회(ICLR)와 함께 세계적인 권위의 기계학습 및 인공지능 분야 학회로 꼽힌다. 뛰어난 연구자들이 제출하는 논문들도 승인될 확률이 25%에 불과할 정도로 학회의 심사를 통과하기 어려운 것으로 알려져 있다.

윤세영 교수 연구팀은 이번 학회에서 `세포 인식기술 경진대회(Cell Segmentation Challenge)'에 참가했다. 이기훈(박사과정), 김상묵(박사과정), 김준기(석사과정)의 3명의 연구원으로 구성된 OSILAB 팀은 초고해상도의 현미경 이미지에서 인공지능이 자동으로 세포를 인식하는 MEDIAR(메디아) 기술을 개발해 2위 팀과 큰 성능 격차로 1위를 달성했다.

세포 인식은 생명 및 의료 분야의 시작이 되는 중요한 기반 기술이지만, 현미경의 측정 기술과 세포의 종류 등에 따라 다양한 형태로 관찰될 수 있어 인공지능이 학습하기 어려운 분야로 알려져 있다. 세포 인식기술 경진대회는 이러한 한계를 극복하기 위해 초고해상도의 현미경 이미지에서 제한된 시간 안에 세포를 인식하는 기술을 주제로 개최됐다.

연구팀은 기계학습에서 소수의 학습 데이터를 더 효과적으로 활용해 성능을 높이는 데이터 기반(Data-Centric) 접근법과 인공신경망의 구조를 개선하는 모델 기반(Model-Centric) 접근법을 종합적으로 활용해 MEDIAR(메디아) 기술을 개발했다. 개발된 인공지능 기술을 통해 정확하게 세포를 인식하고 고해상도 이미지를 빠르게 연산함으로써 대회에서 좋은 성과를 얻을 수 있었다. 지도교수인 KAIST 김재철AI대학원 윤세영 교수는 “MEDIAR는 세포 인식기술 경진대회를 통해 개발됐지만 기상 예측이나 자율주행과 같이 이미지 속 다양한 형태의 개체 인식을 통해 정확한 예측이 필요한 많은 분야에 적용할 수 있다”라고 향후 다양한 활용을 기대했다.

팀을 이끌었던 이기훈 박사과정은 "처음 접하는 분야에서도 성과를 낼 수 있었던 것은 평소 기본기를 중요시하는 교수님의 가르침 덕분ˮ이라며 "새로운 문제에 끊임없이 도전하자는 것이 연구팀의 기본 정신ˮ이라고 강조했다. 이어 같은 연구실 김상묵 박사과정은 "연구 과정에서 많은 실패가 있었지만, 세상에 꼭 필요한 기술이라는 생각으로 끝까지 노력했다ˮ라며 "혼자서라면 절대 해내지 못했던 결과인 만큼 팀원들에게 정말 감사하다ˮ라고 수상 소감을 전했다. 같은 연구실 김준기 석사과정은 "팀원들과 이룬 성과가 의료 분야 인공지능이 겪는 현실의 문제를 해결하는 데 도움이 될 수 있기를 바란다”라고 밝혔다.

연구팀은 생명과학 분야 연구의 발전을 돕기 위해 개발된 기술을 전면 오픈소스로 공개한다고 밝혔다. 학습된 인공지능 모델과 인공지능을 구현하기 위한 프로그램의 소스 코드는 개발자 플랫폼인 깃허브 (GitHub)를 통해 이용할 수 있다.

2022.12.28 조회수 11425