%EC%9D%B8%EA%B3%B5%EC%A7%80%EB%8A%A5

-

낸드플래시 방식의 고신뢰성 인공 시냅스 소자 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 낸드플래시(NAND Flash)의 전하 저장 방식을 활용하여 양산성이 높으며 높은 균일도를 갖는 고신뢰성 인공 시냅스 소자 개발에 성공했다고 6일 밝혔다.

최근 고성능의 인공지능 기술(Artificial Intelligence; AI) 구현을 위하여 인공 시냅스 소자를 통해 크로스바 어레이 구조에서 고밀도의 메모리 집적과 행렬 연산 가속을 동시에 구현하는 맞춤형 하드웨어를 개발하기 위한 노력이 계속되고 있다.

시냅스 소자의 후보 물질로 다양한 물질이 제시되었으나, 인공지능 가속기가 요구하는 다비트성 (Multi-bit), 보존성 (retention), 균일성 (uniformity), 내구성(Endurance) 등을 모두 만족하는 소자는 매우 드물었으며, 또한 제시되는 후보 물질들의 동작 방식도 기존 반도체 소자들과 매우 달라 반도체 소자로 활용함에 있어 양산성 및 수율 등에도 추가적인 검증이 필요하다는 한계가 있었다.

김경민 교수 연구팀은 낸드플래시의 전하 저장하는 방식을 차용한 2단자 구조의 인공 시냅스 소자를 개발했다. 기존에는 2단자 시냅스 구조가 안정적으로 동작하기 위해서는 전하의 저장 상태를 읽기 위해 산화막을 얇게 하여 저장된 전하의 보존성을 희생해야하는 한계가 있었다. 연구팀은 이번 연구에서 알루미늄 산화막, 나이오븀 산화막, 탄탈룸 산화막 등이 순차적으로 적층된 최적의 시냅스 소자 구조를 제안하였으며, 이를 통해 안정적인 다비트성과 보존성을 모두 확보하였다.

또한, 제안한 시냅스 소자가 갖는 자가정류(self-rectifying) 특성을 활용하는 병렬 컴퓨팅 방법을 제시하여 기존의 순차적 컴퓨팅 대비 필요한 에너지를 약 71% 절약할 수 있었다.

공동 제1 저자인 신소재공학과 김근영 석박통합과정은 “이번 연구는 이미 검증된 낸드플래시 메모리 구조를 인공 시냅스 소자에 적용하여 시냅스 소자의 양산성에 대한 우려를 불식한데 의미가 있다”며 “이처럼 향후 개발되는 인공지능 반도체에도 기존 반도체 소자의 고성능 특성과 물질의 새로운 특성을 접목하는 연구가 활발히 이뤄질 것으로 예상된다”고 밝혔다.

이러한 인공 시냅스 소자 기술은 인공지능 컴퓨팅을 저전력으로 구현하는 지능형 반도체 소자에 적용되어 에지 컴퓨팅 (Edge computing)과 같이 적은 에너지 소모가 필수적인 인공지능 기술에 다양하게 적용될 수 있을 것으로 기대된다.

이번 연구는 국제 학술지 ‘어드밴스드 사이언스(Advanced Science)’에 11월 28일 字 온라인 게재됐으며 한국연구재단, KAIST, SK Hynix의 지원을 받아 수행됐다. (논문명: Retention secured nonlinear and self-rectifying analog charge trap memristor for energy-efficient neuromorphic hardware)

2022.12.06 조회수 7882

낸드플래시 방식의 고신뢰성 인공 시냅스 소자 개발

우리 대학 신소재공학과 김경민 교수 연구팀이 낸드플래시(NAND Flash)의 전하 저장 방식을 활용하여 양산성이 높으며 높은 균일도를 갖는 고신뢰성 인공 시냅스 소자 개발에 성공했다고 6일 밝혔다.

최근 고성능의 인공지능 기술(Artificial Intelligence; AI) 구현을 위하여 인공 시냅스 소자를 통해 크로스바 어레이 구조에서 고밀도의 메모리 집적과 행렬 연산 가속을 동시에 구현하는 맞춤형 하드웨어를 개발하기 위한 노력이 계속되고 있다.

시냅스 소자의 후보 물질로 다양한 물질이 제시되었으나, 인공지능 가속기가 요구하는 다비트성 (Multi-bit), 보존성 (retention), 균일성 (uniformity), 내구성(Endurance) 등을 모두 만족하는 소자는 매우 드물었으며, 또한 제시되는 후보 물질들의 동작 방식도 기존 반도체 소자들과 매우 달라 반도체 소자로 활용함에 있어 양산성 및 수율 등에도 추가적인 검증이 필요하다는 한계가 있었다.

김경민 교수 연구팀은 낸드플래시의 전하 저장하는 방식을 차용한 2단자 구조의 인공 시냅스 소자를 개발했다. 기존에는 2단자 시냅스 구조가 안정적으로 동작하기 위해서는 전하의 저장 상태를 읽기 위해 산화막을 얇게 하여 저장된 전하의 보존성을 희생해야하는 한계가 있었다. 연구팀은 이번 연구에서 알루미늄 산화막, 나이오븀 산화막, 탄탈룸 산화막 등이 순차적으로 적층된 최적의 시냅스 소자 구조를 제안하였으며, 이를 통해 안정적인 다비트성과 보존성을 모두 확보하였다.

또한, 제안한 시냅스 소자가 갖는 자가정류(self-rectifying) 특성을 활용하는 병렬 컴퓨팅 방법을 제시하여 기존의 순차적 컴퓨팅 대비 필요한 에너지를 약 71% 절약할 수 있었다.

공동 제1 저자인 신소재공학과 김근영 석박통합과정은 “이번 연구는 이미 검증된 낸드플래시 메모리 구조를 인공 시냅스 소자에 적용하여 시냅스 소자의 양산성에 대한 우려를 불식한데 의미가 있다”며 “이처럼 향후 개발되는 인공지능 반도체에도 기존 반도체 소자의 고성능 특성과 물질의 새로운 특성을 접목하는 연구가 활발히 이뤄질 것으로 예상된다”고 밝혔다.

이러한 인공 시냅스 소자 기술은 인공지능 컴퓨팅을 저전력으로 구현하는 지능형 반도체 소자에 적용되어 에지 컴퓨팅 (Edge computing)과 같이 적은 에너지 소모가 필수적인 인공지능 기술에 다양하게 적용될 수 있을 것으로 기대된다.

이번 연구는 국제 학술지 ‘어드밴스드 사이언스(Advanced Science)’에 11월 28일 字 온라인 게재됐으며 한국연구재단, KAIST, SK Hynix의 지원을 받아 수행됐다. (논문명: Retention secured nonlinear and self-rectifying analog charge trap memristor for energy-efficient neuromorphic hardware)

2022.12.06 조회수 7882 -

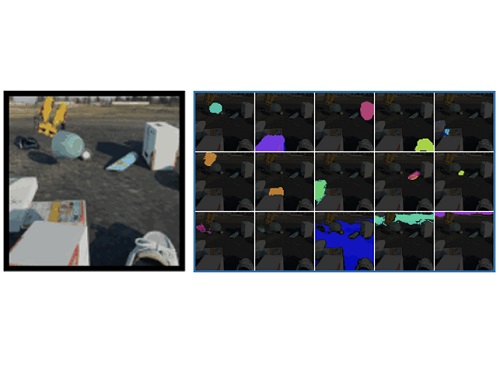

세계 최초로 사람처럼 사물의 개념을 스스로 학습하는 장면 인식 기술 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스(Rutgers) 대학교와 공동연구를 통해 사람의 라벨링 없이 스스로 영상 속 객체를 식별할 수 있는 인공지능 기술을 개발했다고 1일 밝혔다. 이 모델은 복잡한 영상에서 각 장면의 객체들에 대한 명시적인 라벨링 없이도 객체를 식별하는 최초의 인공지능 모델이다.

기계가 주변 환경을 지능적으로 인지하고 추론하기 위해서는 시각적 장면을 구성하는 객체들과 그들의 관계를 파악하는 능력이 필수적이다. 하지만 이 분야의 연구는 대부분 영상의 각 픽셀에 대응하는 객체의 라벨을 사람이 일일이 표시해야 하는 지도적 학습 방식을 사용했다. 이 같은 수작업은 오류가 발생하기 쉽고 많은 시간과 비용을 요구한다는 단점이 있다.

이에 반해 이번에 연구팀이 개발한 기술은 인간과 유사하게 환경에 대한 관측만으로 객체의 개념을 스스로 자가 학습하는 방식을 취한다. 이렇게 인간의 지도 없이 스스로 객체의 개념을 학습할 수 있는 인공지능은 차세대 인지 기술의 핵심으로 기대돼왔다.

비지도 학습을 이용한 이전 연구들은 단순한 객체 형태와 배경이 명확히 구분될 수 있는 단순한 장면에서만 객체를 식별하는 단점이 있었다. 이와 달리 이번에 안성진 교수 연구팀이 개발한 기술은 복잡한 형태의 많은 객체가 존재하는 사실적인 장면에도 적용될 수 있는 최초의 모델이다.

이 연구는 그림 인공지능 소프트웨어인 DALL-E와 같이 텍스트 입력을 통해 사실적인 이미지를 생성할 수 있는 이미지 생성 연구에서 영감을 얻었다. 연구팀은 텍스트를 입력하는 대신, 모델이 장면에서 객체를 감지하고 그 객체의 표상(representation)으로부터 이미지를 생성하는 방식으로 모델을 학습시켰다. 또한, 모델에 DALL-E와 유사한 트랜스포머 디코더를 사용하는 것이 사실적이고 복잡한 영상을 처리할 수 있게 한 주요 요인이라고 밝혔다.

연구팀은 복잡하고 정제되지 않은 영상뿐만 아니라, 많은 물고기가 있는 수족관과 교통이 혼잡한 도로의 상황을 담은 유튜브 영상과 같이 복잡한 실제 영상에서도 모델의 성능을 측정했다. 그 결과, 제시된 모델이 기존 모델보다 객체를 훨씬 더 정확하게 분할하고 일반화하는 것을 확인할 수 있었다.

연구팀을 이끈 안성진 교수는 "인간과 유사한 자가 학습 방식으로 상황을 인지하고 해석하는 혁신적인 기술ˮ이라며 "시각적 상황인지 능력을 획기적으로 개선해 지능형 로봇 분야, 자율 주행 분야뿐만 아니라 시각적 인공지능 기술 전반에 비용 절감과 성능향상을 가져올 수 있다ˮ고 말했다.

이번 연구는 미국 뉴올리언스에서 지난 11월 28일부터 개최되어 12월 9일까지 진행 예정인 세계 최고 수준의 기계학습(머신러닝) 학회인 제36회 신경정보처리학회(NeurIPS)에서 발표됐다.

2022.12.02 조회수 8758

세계 최초로 사람처럼 사물의 개념을 스스로 학습하는 장면 인식 기술 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스(Rutgers) 대학교와 공동연구를 통해 사람의 라벨링 없이 스스로 영상 속 객체를 식별할 수 있는 인공지능 기술을 개발했다고 1일 밝혔다. 이 모델은 복잡한 영상에서 각 장면의 객체들에 대한 명시적인 라벨링 없이도 객체를 식별하는 최초의 인공지능 모델이다.

기계가 주변 환경을 지능적으로 인지하고 추론하기 위해서는 시각적 장면을 구성하는 객체들과 그들의 관계를 파악하는 능력이 필수적이다. 하지만 이 분야의 연구는 대부분 영상의 각 픽셀에 대응하는 객체의 라벨을 사람이 일일이 표시해야 하는 지도적 학습 방식을 사용했다. 이 같은 수작업은 오류가 발생하기 쉽고 많은 시간과 비용을 요구한다는 단점이 있다.

이에 반해 이번에 연구팀이 개발한 기술은 인간과 유사하게 환경에 대한 관측만으로 객체의 개념을 스스로 자가 학습하는 방식을 취한다. 이렇게 인간의 지도 없이 스스로 객체의 개념을 학습할 수 있는 인공지능은 차세대 인지 기술의 핵심으로 기대돼왔다.

비지도 학습을 이용한 이전 연구들은 단순한 객체 형태와 배경이 명확히 구분될 수 있는 단순한 장면에서만 객체를 식별하는 단점이 있었다. 이와 달리 이번에 안성진 교수 연구팀이 개발한 기술은 복잡한 형태의 많은 객체가 존재하는 사실적인 장면에도 적용될 수 있는 최초의 모델이다.

이 연구는 그림 인공지능 소프트웨어인 DALL-E와 같이 텍스트 입력을 통해 사실적인 이미지를 생성할 수 있는 이미지 생성 연구에서 영감을 얻었다. 연구팀은 텍스트를 입력하는 대신, 모델이 장면에서 객체를 감지하고 그 객체의 표상(representation)으로부터 이미지를 생성하는 방식으로 모델을 학습시켰다. 또한, 모델에 DALL-E와 유사한 트랜스포머 디코더를 사용하는 것이 사실적이고 복잡한 영상을 처리할 수 있게 한 주요 요인이라고 밝혔다.

연구팀은 복잡하고 정제되지 않은 영상뿐만 아니라, 많은 물고기가 있는 수족관과 교통이 혼잡한 도로의 상황을 담은 유튜브 영상과 같이 복잡한 실제 영상에서도 모델의 성능을 측정했다. 그 결과, 제시된 모델이 기존 모델보다 객체를 훨씬 더 정확하게 분할하고 일반화하는 것을 확인할 수 있었다.

연구팀을 이끈 안성진 교수는 "인간과 유사한 자가 학습 방식으로 상황을 인지하고 해석하는 혁신적인 기술ˮ이라며 "시각적 상황인지 능력을 획기적으로 개선해 지능형 로봇 분야, 자율 주행 분야뿐만 아니라 시각적 인공지능 기술 전반에 비용 절감과 성능향상을 가져올 수 있다ˮ고 말했다.

이번 연구는 미국 뉴올리언스에서 지난 11월 28일부터 개최되어 12월 9일까지 진행 예정인 세계 최고 수준의 기계학습(머신러닝) 학회인 제36회 신경정보처리학회(NeurIPS)에서 발표됐다.

2022.12.02 조회수 8758 -

세계 최고 수준의 딥러닝 의사결정 설명기술 개발

우리 대학 김재철AI대학원 최재식 교수(㈜인이지 대표이사) 연구팀이 인공지능 딥러닝의 의사결정에 큰 영향을 미치는 입력 변수의 기여도를 계산하는 세계 최고 수준의 기술을 개발했다고 23일 밝혔다.

최근 딥러닝 모델은 문서 자동 번역이나 자율 주행 등 실생활에 널리 보급되고 활용되는 추세 및 발전에도 불구하고 비선형적이고 복잡한 모델의 구조와 고차원의 입력 데이터로 인해 정확한 모델 예측의 근거를 제시하기 어렵다. 이처럼 부족한 설명성은 딥러닝이 국방, 의료, 금융과 같이 의사결정에 대한 근거가 필요한 중요한 작업에 대한 적용을 어렵게 한다. 따라서 적용 분야의 확장을 위해 딥러닝의 부족한 설명성은 반드시 해결해야 할 문제다.

최교수 연구팀은 딥러닝 모델이 국소적인 입력 공간에서 보이는 입력 데이터와 예측 사이의 관계를 기반으로, 입력 데이터의 특징 중 모델 예측의 기여도가 높은 특징만을 점진적으로 추출해나가는 알고리즘과 그 과정에서의 입력과 예측 사이의 관계를 종합하는 방법을 고안해 모델의 예측 과정에 기여하는 입력 특징의 정확한 기여도를 계산했다. 해당 기술은 모델 구조에 대한 의존성이 없어 다양한 기존 학습 모델에서도 적용이 가능하며, 딥러닝 예측 모델의 판단 근거를 제공함으로써 신뢰도를 높여 딥러닝 모델의 활용성에도 크게 기여할 것으로 기대된다.

㈜인이지의 전기영 연구원, 우리 대학 김재철AI대학원의 정해동 연구원이 공동 제1 저자로 참여한 이번 연구는 오는 12월 1일, 국제 학술대회 `신경정보처리학회(Neural Information Processing Systems, NeurIPS) 2022'에서 발표될 예정이다.

모델의 예측에 대한 입력 특징의 기여도를 계산하는 문제는 해석이 불가능한 딥러닝 모델의 작동 방식을 설명하는 직관적인 방법 중 하나다. 특히, 이미지 데이터를 다루는 문제에서는 모델의 예측 과정에 많이 기여한 부분을 강조하는 방식으로 시각화해 설명을 제공한다.

딥러닝 예측 모델의 입력 기여도를 정확하게 계산하기 위해서 모델의 경사도를 이용하거나, 입력 섭동(행동을 다스림)을 이용하는 등의 연구가 활발히 진행되고 있다. 그러나 경사도를 이용한 방식의 경우 결과물에 잡음이 많아 신뢰성을 확보하기 어렵고, 입력 섭동을 이용하는 경우 모든 경우의 섭동을 시도해야 하지만 너무 많은 연산을 요구하기 때문에, 근사치를 추정한 결과만을 얻을 수 있다.

연구팀은 이러한 문제 해결을 위해 입력 데이터의 특징 중에서 모델의 예측과 연관성이 적은 특징을 점진적으로 제거해나가는 증류 알고리즘을 개발했다. 증류 알고리즘은 딥러닝 모델이 국소적으로 보이는 입력 데이터와 예측 사이의 관계에 기반해 상대적으로 예측에 기여도가 적은 특징을 선별 및 제거하며, 이러한 과정의 반복을 통해 증류된 입력 데이터에는 기여도가 높은 특징만 남게 된다. 또한, 해당 과정을 통해 얻게 되는 변형된 데이터에 대한 국소적 입력 기여도를 종합해 신뢰도 높은 최종 입력 기여도를 산출한다.

연구팀의 이러한 입력 기여도 측정 기술은 산업공정 최적화 프로젝트에 적용해 딥러닝 모델이 예측 결과를 도출하기 위해서 어떤 입력 특징에 주목하는지 찾을 수 있었다. 또한 딥러닝 모델의 구조에 상관없이 적용할 수 있는 이 기술을 바탕으로 복잡한 공정 내부의 다양한 예측변수 간 상관관계를 정확하게 분석하고 예측함으로써 공정 최적화(에너지 절감, 품질향상, 생산량 증가)의 효과를 도출할 수 있었다.

연구팀은 잘 알려진 이미지 분류 모델인 VGG-16, ResNet-18, Inception-v3 모델에서 개발 기술이 입력 기여도를 계산하는 데에 효과가 있음을 확인했다. 해당 기술은 구글(Google)이 보유하고 텐서플로우 설명가능 인공지능(TensorFlow Explainable AI) 툴 키트에 적용된 것으로 알려진 입력 기여도 측정 기술(Guided Integrated Gradient) 대비 LeRF/MoRF 점수가 각각 최대 0.436/0.020 개선됨을 보였다. 특히, 입력 기여도의 시각화를 비교했을 때, 기존 방식 대비 잡음이 적고, 주요 객체와 잘 정렬됐으며, 선명한 결과를 보였다. 연구팀은 여러 가지 모델 구조에 대해 신뢰도 높은 입력 기여도 계산 성능을 보임으로써, 개발 기술의 유효성과 확장성을 보였다.

연구팀이 개발한 딥러닝 모델의 입력 기여도 측정 기술은 이미지 외에도 다양한 예측 모델에 적용돼 모델의 예측에 대한 신뢰성을 높일 것으로 기대된다.

전기영 연구원은 "딥러닝 모델의 국소 지역에서 계산된 입력 기여도를 기반으로 상대적인 중요도가 낮은 입력을 점진적으로 제거하며, 이러한 과정에서 축적된 입력 기여도를 종합해 더욱 정확한 설명을 제공할 수 있음을 보였다ˮ라며 "딥러닝 모델에 대해 신뢰도 높은 설명을 제공하기 위해서는 입력 데이터를 적절히 변형한 상황에서도 모델 예측과 관련도가 높은 입력 특성에 주목해야 한다ˮ라고 말했다.

이번 연구는 2022년도 과학기술정보통신부의 재원으로 정보통신기획평가원의 지원을 받은 사람 중심 AI강국 실현을 위한 차세대 인공지능 핵심원천기술개발 사용자 맞춤형 플로그앤플레이 방식의 설명가능성 제공, 한국과학기술원 인공지능 대학원 프로그램, 인공지능 공정성 AIDEP 및 국방과학연구소의 지원을 받은 설명 가능 인공지능 프로젝트 및 인이지의 지원으로 수행됐다.

2022.11.23 조회수 11220

세계 최고 수준의 딥러닝 의사결정 설명기술 개발

우리 대학 김재철AI대학원 최재식 교수(㈜인이지 대표이사) 연구팀이 인공지능 딥러닝의 의사결정에 큰 영향을 미치는 입력 변수의 기여도를 계산하는 세계 최고 수준의 기술을 개발했다고 23일 밝혔다.

최근 딥러닝 모델은 문서 자동 번역이나 자율 주행 등 실생활에 널리 보급되고 활용되는 추세 및 발전에도 불구하고 비선형적이고 복잡한 모델의 구조와 고차원의 입력 데이터로 인해 정확한 모델 예측의 근거를 제시하기 어렵다. 이처럼 부족한 설명성은 딥러닝이 국방, 의료, 금융과 같이 의사결정에 대한 근거가 필요한 중요한 작업에 대한 적용을 어렵게 한다. 따라서 적용 분야의 확장을 위해 딥러닝의 부족한 설명성은 반드시 해결해야 할 문제다.

최교수 연구팀은 딥러닝 모델이 국소적인 입력 공간에서 보이는 입력 데이터와 예측 사이의 관계를 기반으로, 입력 데이터의 특징 중 모델 예측의 기여도가 높은 특징만을 점진적으로 추출해나가는 알고리즘과 그 과정에서의 입력과 예측 사이의 관계를 종합하는 방법을 고안해 모델의 예측 과정에 기여하는 입력 특징의 정확한 기여도를 계산했다. 해당 기술은 모델 구조에 대한 의존성이 없어 다양한 기존 학습 모델에서도 적용이 가능하며, 딥러닝 예측 모델의 판단 근거를 제공함으로써 신뢰도를 높여 딥러닝 모델의 활용성에도 크게 기여할 것으로 기대된다.

㈜인이지의 전기영 연구원, 우리 대학 김재철AI대학원의 정해동 연구원이 공동 제1 저자로 참여한 이번 연구는 오는 12월 1일, 국제 학술대회 `신경정보처리학회(Neural Information Processing Systems, NeurIPS) 2022'에서 발표될 예정이다.

모델의 예측에 대한 입력 특징의 기여도를 계산하는 문제는 해석이 불가능한 딥러닝 모델의 작동 방식을 설명하는 직관적인 방법 중 하나다. 특히, 이미지 데이터를 다루는 문제에서는 모델의 예측 과정에 많이 기여한 부분을 강조하는 방식으로 시각화해 설명을 제공한다.

딥러닝 예측 모델의 입력 기여도를 정확하게 계산하기 위해서 모델의 경사도를 이용하거나, 입력 섭동(행동을 다스림)을 이용하는 등의 연구가 활발히 진행되고 있다. 그러나 경사도를 이용한 방식의 경우 결과물에 잡음이 많아 신뢰성을 확보하기 어렵고, 입력 섭동을 이용하는 경우 모든 경우의 섭동을 시도해야 하지만 너무 많은 연산을 요구하기 때문에, 근사치를 추정한 결과만을 얻을 수 있다.

연구팀은 이러한 문제 해결을 위해 입력 데이터의 특징 중에서 모델의 예측과 연관성이 적은 특징을 점진적으로 제거해나가는 증류 알고리즘을 개발했다. 증류 알고리즘은 딥러닝 모델이 국소적으로 보이는 입력 데이터와 예측 사이의 관계에 기반해 상대적으로 예측에 기여도가 적은 특징을 선별 및 제거하며, 이러한 과정의 반복을 통해 증류된 입력 데이터에는 기여도가 높은 특징만 남게 된다. 또한, 해당 과정을 통해 얻게 되는 변형된 데이터에 대한 국소적 입력 기여도를 종합해 신뢰도 높은 최종 입력 기여도를 산출한다.

연구팀의 이러한 입력 기여도 측정 기술은 산업공정 최적화 프로젝트에 적용해 딥러닝 모델이 예측 결과를 도출하기 위해서 어떤 입력 특징에 주목하는지 찾을 수 있었다. 또한 딥러닝 모델의 구조에 상관없이 적용할 수 있는 이 기술을 바탕으로 복잡한 공정 내부의 다양한 예측변수 간 상관관계를 정확하게 분석하고 예측함으로써 공정 최적화(에너지 절감, 품질향상, 생산량 증가)의 효과를 도출할 수 있었다.

연구팀은 잘 알려진 이미지 분류 모델인 VGG-16, ResNet-18, Inception-v3 모델에서 개발 기술이 입력 기여도를 계산하는 데에 효과가 있음을 확인했다. 해당 기술은 구글(Google)이 보유하고 텐서플로우 설명가능 인공지능(TensorFlow Explainable AI) 툴 키트에 적용된 것으로 알려진 입력 기여도 측정 기술(Guided Integrated Gradient) 대비 LeRF/MoRF 점수가 각각 최대 0.436/0.020 개선됨을 보였다. 특히, 입력 기여도의 시각화를 비교했을 때, 기존 방식 대비 잡음이 적고, 주요 객체와 잘 정렬됐으며, 선명한 결과를 보였다. 연구팀은 여러 가지 모델 구조에 대해 신뢰도 높은 입력 기여도 계산 성능을 보임으로써, 개발 기술의 유효성과 확장성을 보였다.

연구팀이 개발한 딥러닝 모델의 입력 기여도 측정 기술은 이미지 외에도 다양한 예측 모델에 적용돼 모델의 예측에 대한 신뢰성을 높일 것으로 기대된다.

전기영 연구원은 "딥러닝 모델의 국소 지역에서 계산된 입력 기여도를 기반으로 상대적인 중요도가 낮은 입력을 점진적으로 제거하며, 이러한 과정에서 축적된 입력 기여도를 종합해 더욱 정확한 설명을 제공할 수 있음을 보였다ˮ라며 "딥러닝 모델에 대해 신뢰도 높은 설명을 제공하기 위해서는 입력 데이터를 적절히 변형한 상황에서도 모델 예측과 관련도가 높은 입력 특성에 주목해야 한다ˮ라고 말했다.

이번 연구는 2022년도 과학기술정보통신부의 재원으로 정보통신기획평가원의 지원을 받은 사람 중심 AI강국 실현을 위한 차세대 인공지능 핵심원천기술개발 사용자 맞춤형 플로그앤플레이 방식의 설명가능성 제공, 한국과학기술원 인공지능 대학원 프로그램, 인공지능 공정성 AIDEP 및 국방과학연구소의 지원을 받은 설명 가능 인공지능 프로젝트 및 인이지의 지원으로 수행됐다.

2022.11.23 조회수 11220 -

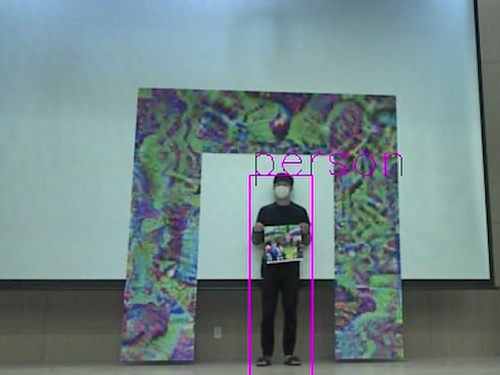

딥러닝 적대적 공격을 막는 방어 프레임 개발

우리 대학 전기및전자공학부 노용만 교수 연구팀이 물체를 검출하는 딥러닝 신경망에 대한 적대적 공격을 방어하는 알고리즘을 개발했다고 15일 밝혔다.

최근 몇 년간 인공지능 딥러닝 신경망 기술이 나날이 발전하고 실세계에 활용되면서, 딥러닝 신경망 기술은 자율주행 및 물체검출 등 다양한 분야에서 떠오르는 핵심기술로 주목받고 있다.

하지만 현재의 딥러닝 기반 검출 네트워크는, 특정한 적대적 패턴을 입력 이미지에 악의적으로 주입하여 잘못된 예측 결과를 초래하는 적대적 공격에 대해 심각하게 취약하다. 적대적 패턴이란 공격자가 검출이 되지 않기 위해 인위적으로 만든 패턴이다. 이 패턴이 포함된 물체는 검출이 되지 않게 하는 것으로 적대적 패턴 공격이라 한다.

이러한 취약성은 인공지능으로 대표되는 딥러닝 기반의 모델을 국방이나 의료 및 자율주행 등 국민의 생명과 재산을 직접 다루는 분야에 적용할 때 크게 문제가 된다. 구체적인 예로 국방·보안을 위한 감시 정찰 분야에서 적군이 적대적 패턴으로 위장하여 침입하면 검출을 못하는 경우가 발생하여 국방 및 보안에 매우 큰 위험을 초래할 수 있다.

기존의 많은 연구가 적대적 패턴 공격을 막기 위해 노력했으나 추가로 복잡한 모듈이 필요하거나 네트워크를 처음부터 다시 학습해야 했기 때문에, 기존 연구는 실시간으로 동작하는 물체검출 알고리즘에 현실적으로 적용하기가 쉽지 않았다.

노 교수 연구팀은 물리적인 환경에서 적대적 패턴 공격의 원리를 반대로 이용해 적대적 공격을 막아내는 방어 프레임을 고안했다. 이러한 방어 프레임은 부가적인 복잡한 모듈이나 네트워크의 재학습이 필요하지 않으므로 보다 실용적이고 강인한 물체검출 네트워크를 구축하는데 폭넓게 응용 및 적용될 수 있을 것으로 기대된다.

공동 제1 저자인 전기및전자공학부 유영준 박사과정 학생과 이홍주 박사과정 학생 등이 함께 수행한 이번 연구는 영상처리 분야 최고의 국제 학술지인 `IEEE Transactions on Image Processing'에 11월 1일 자로 온라인 게재됐다. (논문명 : Defending Person Detection Against Adversarial Patch Attack by using Universal Defensive Frame).

연구팀은 문제 해결을 위해 적대적 공격의 원리를 역으로 이용해, 학습된 네트워크에 접근하지 않으면서도 입력단에서 방어할 수 있는 방어 프레임 기술을 고안했다.

연구팀의 방어 기술은 적대적 공격과 정반대로 물체검출 시 딥러닝 모델이 옳은 예측 결과를 내리도록 방어 프레임을 만드는 것이다. 이러한 방어 프레임은 마치 창과 방패의 싸움처럼 적대적 패턴과 함께 경쟁적으로 학습되며, 해당 과정을 반복해 최종적으로 모든 적대적 패턴 공격에 대해 높은 방어성능을 지니도록 최적화된다.

연구팀은 입력 이미지 외부에 덧붙이는 방어 프레임을 변화시킴으로써 손쉽게 방어성능을 조절할 수 있음을 확인했고, 개발된 방어 프레임은 인리아(INRIA) 검출 벤치마크 데이터셋에서 기존 방어 알고리즘 대비 평균 31.6% 정확도가 향상하는 성과를 거뒀다.

연구팀이 개발한 방어 프레임은 실시간 물체 탐지 시, 모델의 재학습 없이 적대적 패턴 공격을 방어할 수 있으므로 예측 시간 및 비용 절감을 크게 이룰 수 있을 것으로 기대된다.

연구팀은 나아가 이번 연구에서 개발된 방어 프레임을 물리적으로 직접 구현시켜서, 물리적 환경에 자연스레 놓여있는 적대적 패턴 공격과 마찬가지로 좀 더 접근성 있는 방어 방법으로도 활발히 응용될 수 있음을 제시하였다.

노용만 교수는 "국방 및 보안 분야에서 인공지능이 활용되기 위해서 아직 인공지능의 완전성을 높이는 많은 연구가 필요한데, 이번에 개발된 방어 기술은 이 분야들에서 인공지능 모델을 적용 시 실용적인 적대적 방어를 제시함에 의의가 있을 것ˮ이라며 "이 기술은 국방 감시정찰, 보안, 자율주행 분야에도 적용될 수 있을 것이다ˮ라고 말했다.

한편 이번 연구는 방위사업청과 국방과학연구소의 지원으로 한국과학기술원 미래국방 인공지능 특화연구센터에서 수행됐다.

2022.11.15 조회수 7517

딥러닝 적대적 공격을 막는 방어 프레임 개발

우리 대학 전기및전자공학부 노용만 교수 연구팀이 물체를 검출하는 딥러닝 신경망에 대한 적대적 공격을 방어하는 알고리즘을 개발했다고 15일 밝혔다.

최근 몇 년간 인공지능 딥러닝 신경망 기술이 나날이 발전하고 실세계에 활용되면서, 딥러닝 신경망 기술은 자율주행 및 물체검출 등 다양한 분야에서 떠오르는 핵심기술로 주목받고 있다.

하지만 현재의 딥러닝 기반 검출 네트워크는, 특정한 적대적 패턴을 입력 이미지에 악의적으로 주입하여 잘못된 예측 결과를 초래하는 적대적 공격에 대해 심각하게 취약하다. 적대적 패턴이란 공격자가 검출이 되지 않기 위해 인위적으로 만든 패턴이다. 이 패턴이 포함된 물체는 검출이 되지 않게 하는 것으로 적대적 패턴 공격이라 한다.

이러한 취약성은 인공지능으로 대표되는 딥러닝 기반의 모델을 국방이나 의료 및 자율주행 등 국민의 생명과 재산을 직접 다루는 분야에 적용할 때 크게 문제가 된다. 구체적인 예로 국방·보안을 위한 감시 정찰 분야에서 적군이 적대적 패턴으로 위장하여 침입하면 검출을 못하는 경우가 발생하여 국방 및 보안에 매우 큰 위험을 초래할 수 있다.

기존의 많은 연구가 적대적 패턴 공격을 막기 위해 노력했으나 추가로 복잡한 모듈이 필요하거나 네트워크를 처음부터 다시 학습해야 했기 때문에, 기존 연구는 실시간으로 동작하는 물체검출 알고리즘에 현실적으로 적용하기가 쉽지 않았다.

노 교수 연구팀은 물리적인 환경에서 적대적 패턴 공격의 원리를 반대로 이용해 적대적 공격을 막아내는 방어 프레임을 고안했다. 이러한 방어 프레임은 부가적인 복잡한 모듈이나 네트워크의 재학습이 필요하지 않으므로 보다 실용적이고 강인한 물체검출 네트워크를 구축하는데 폭넓게 응용 및 적용될 수 있을 것으로 기대된다.

공동 제1 저자인 전기및전자공학부 유영준 박사과정 학생과 이홍주 박사과정 학생 등이 함께 수행한 이번 연구는 영상처리 분야 최고의 국제 학술지인 `IEEE Transactions on Image Processing'에 11월 1일 자로 온라인 게재됐다. (논문명 : Defending Person Detection Against Adversarial Patch Attack by using Universal Defensive Frame).

연구팀은 문제 해결을 위해 적대적 공격의 원리를 역으로 이용해, 학습된 네트워크에 접근하지 않으면서도 입력단에서 방어할 수 있는 방어 프레임 기술을 고안했다.

연구팀의 방어 기술은 적대적 공격과 정반대로 물체검출 시 딥러닝 모델이 옳은 예측 결과를 내리도록 방어 프레임을 만드는 것이다. 이러한 방어 프레임은 마치 창과 방패의 싸움처럼 적대적 패턴과 함께 경쟁적으로 학습되며, 해당 과정을 반복해 최종적으로 모든 적대적 패턴 공격에 대해 높은 방어성능을 지니도록 최적화된다.

연구팀은 입력 이미지 외부에 덧붙이는 방어 프레임을 변화시킴으로써 손쉽게 방어성능을 조절할 수 있음을 확인했고, 개발된 방어 프레임은 인리아(INRIA) 검출 벤치마크 데이터셋에서 기존 방어 알고리즘 대비 평균 31.6% 정확도가 향상하는 성과를 거뒀다.

연구팀이 개발한 방어 프레임은 실시간 물체 탐지 시, 모델의 재학습 없이 적대적 패턴 공격을 방어할 수 있으므로 예측 시간 및 비용 절감을 크게 이룰 수 있을 것으로 기대된다.

연구팀은 나아가 이번 연구에서 개발된 방어 프레임을 물리적으로 직접 구현시켜서, 물리적 환경에 자연스레 놓여있는 적대적 패턴 공격과 마찬가지로 좀 더 접근성 있는 방어 방법으로도 활발히 응용될 수 있음을 제시하였다.

노용만 교수는 "국방 및 보안 분야에서 인공지능이 활용되기 위해서 아직 인공지능의 완전성을 높이는 많은 연구가 필요한데, 이번에 개발된 방어 기술은 이 분야들에서 인공지능 모델을 적용 시 실용적인 적대적 방어를 제시함에 의의가 있을 것ˮ이라며 "이 기술은 국방 감시정찰, 보안, 자율주행 분야에도 적용될 수 있을 것이다ˮ라고 말했다.

한편 이번 연구는 방위사업청과 국방과학연구소의 지원으로 한국과학기술원 미래국방 인공지능 특화연구센터에서 수행됐다.

2022.11.15 조회수 7517 -

악천후에서도 자율주행을 가능하게 하는 세계 최고의 4D 레이더 인공지능 기술 개발

우리 대학 조천식모빌리티대학원 공승현 교수 연구팀이 세계 최초로 악천후 상황에서 안정적인 자율주행을 가능하게 하는 4D 레이더(Radar)의 주변 객체 인지 인공지능 기술을 개발했다고 20일 밝혔다. 연구팀은 구축된 인공지능 학습 데이터셋(Dataset)인 KAIST-레이더(이하 K-레이더)와 개발된 인공지능 신경망(RTN4D) 그리고 전 세계 연구자를 위한 4D 레이더 인공지능 개발 플랫폼(Platform)과 관련 벤치마크(Benchmark)를 모두 공개한다고 밝혔다.

현재 전 세계적으로 개발되고 있는 자율주행 자동차는 주로 카메라와 라이다(LiDAR)에서 출력되는 이미지와 포인트 클라우드(Pointcloud) 데이터를 적절한 인공지능 신경망으로 처리해 자동차 주변의 객체들을 인식하는 방식으로 구현돼 있다. 그러나 카메라와 라이다는 각각 가시광선과 적외선을 사용하므로 눈비 또는 안개 상황에서 측정 성능이 크게 떨어지는데, 이로 인해 주변 객체들에 대한 인식이 어려워져 안전한 자율주행이 불가능하다.

더구나, 차내에 설치할 수 있는 카메라와 달리 자동차의 지붕에 설치하는 라이다는 외부 환경에 노출돼 있어서 그 표면에 눈비 또는 흙먼지가 묻는 경우 라이다를 이용한 전방 탐지가 어려워진다. 공승현 교수는 "젖은 도로에서 전방에 주행 차량이 있는 경우, 그 바퀴에서 일어나는 흙먼지가 섞인 물보라로 라이다 표면이 빠르게 더럽혀지고, 결과적으로 모든 전방 객체에 대한 라이다 측정이 불가능해진다ˮ고 설명한다. {그림 1 참조}

적외선을 사용하는 라이다와는 달리 77기가헤르츠(GHz) 대역의 자동차 레이더는 눈, 비, 안개 등의 악천후 상황에 매우 강건하며 표면에 눈비나 흙먼지가 묻은 상황에서도 안정적인 측정 결과를 보인다. 최근에는 고해상도의 4D 레이더(대상까지의 거리, 방위각, 높이, 도플러 주파수를 측정)가 개발돼 상용화되고 있으며, 그 성능도 빠르게 향상되고 있다.

이에 따라서 전 세계적으로 4D 레이더에 인공지능을 이용한 주변 인지 기술 연구가 시작되고 있지만, 4D 레이더에 필요한 인공지능 연구는 매우 더디게 진행되고 있다. 카메라나 라이다와 달리, 고성능 인공지능 개발에 필수적인 충분한 데이터셋이 구축되지 못하고 있기 때문이다. 2021년부터 4D 레이더의 포인트 클라우드 데이터셋이 일부 공개됐으나, 데이터의 양이 충분하지 않고 측정치가 매우 희소해 신뢰할 만한 객체 인식 인공지능 신경망 개발이 쉽지 않다.

연구팀이 공개하는 K-레이더는 악천후를 포함한 다양한 날씨 및 교통 상황에서 수집된 다양성 높은 데이터셋이며, 정확히 동기된 카메라와 라이다 측정 데이터와 함께 구축된 13테라바이트(TB)에 이르는 대용량으로 세계 최초의 4D 레이더 데이터셋이다. 특히, K-레이더는 포인트 클라우드 형태가 아닌 인공지능 신경망의 성능을 극대화할 수 있는 텐서(Tensor) 형태의 데이터셋으로, 이는 일반적인 레이더의 잡음 제거 방식을 사용하지 않아 잡음 수준의 미약한 미세 측정치를 온전히 담고 있는 형태의 데이터셋이다.

연구팀이 개발한 4D 레이더 인공지능 신경망(RTN4D)은 K-레이더로 수많은 학습을 진행했고, 그 결과 다양한 날씨와 도로 상황에서 70m 이내의 객체에 대해 객체 판별, 위치 추정 및 주행 방향 추정의 3가지 추정을 정확히 수행하는 경우가 최종 62.5%인 세계 최고의 성능을 가진다.

또한, 연구팀은 전 세계의 연구자들이 자체적으로 데이터를 추가 구축하고 신경망 기술을 개발하며 그 성능을 자체 평가할 수 있도록 레이더용 인공지능 신경망 개발 플랫폼과 벤치마크도 공개 제공한다.

조천식모빌리티대학원 공승현 교수는 "눈이나 비가 오는 날씨에서 4D 레이더 인공지능 신경망은 기존 라이다 인공지능 신경망 보다 훨씬 더 안정적인 주변 객체 인지 성능을 갖는데, 이는 4D 레이더가 악천후에서 자율주행을 위한 필수 센서임을 보여주는 결과이며{그림 2 참조}, 최근 미국의 웨이모(Waymo)와 이스라엘의 모빌아이(Mobileye)가 수년 내로 4D 레이더를 자율주행의 주요 인지 센서로 활용할 계획임을 공개적으로 밝힌 이유다ˮ라며 "우리 연구팀이 공개한 K-레이더와 4D 레이더 인공지능 개발 플랫폼 및 벤치마크를 통해, 향후 4D 레이더에 관한 인공지능 연구가 더욱 활발히 진행될 것으로 기대한다ˮ라고 말했다.

K-레이더, 4D 레이더 인공지능 신경망(RTN4D), 4D 레이더 인공지능 개발 플랫폼과 벤치마크는 연구실 홈페이지(http://ave.kaist.ac.kr/)와 깃허브(https://github.com/kaist-avelab/K-Radar)를 통해서 배포될 예정이다. 이번 연구는 한국연구재단(NRF) 및 정보통신기획평가원(IITP)의 지원과 ㈜스마트레이더시스템의 협력으로 수행됐으며, 연구 성과는 백동희 박사과정 학생이 2022년 12월에 열리는 세계적인 인공지능 컨퍼런스인 `뉴립스(NeurIPS) 2022' 데이터셋&벤치마크 트랙(Datasets and Benchmark Track)에서 발표할 예정이다(논문명: K-Radar: 4D Radar Object Detection Dataset and Benchmark for Autonomous Driving in Various Weather Conditions)

2022.10.20 조회수 9038

악천후에서도 자율주행을 가능하게 하는 세계 최고의 4D 레이더 인공지능 기술 개발

우리 대학 조천식모빌리티대학원 공승현 교수 연구팀이 세계 최초로 악천후 상황에서 안정적인 자율주행을 가능하게 하는 4D 레이더(Radar)의 주변 객체 인지 인공지능 기술을 개발했다고 20일 밝혔다. 연구팀은 구축된 인공지능 학습 데이터셋(Dataset)인 KAIST-레이더(이하 K-레이더)와 개발된 인공지능 신경망(RTN4D) 그리고 전 세계 연구자를 위한 4D 레이더 인공지능 개발 플랫폼(Platform)과 관련 벤치마크(Benchmark)를 모두 공개한다고 밝혔다.

현재 전 세계적으로 개발되고 있는 자율주행 자동차는 주로 카메라와 라이다(LiDAR)에서 출력되는 이미지와 포인트 클라우드(Pointcloud) 데이터를 적절한 인공지능 신경망으로 처리해 자동차 주변의 객체들을 인식하는 방식으로 구현돼 있다. 그러나 카메라와 라이다는 각각 가시광선과 적외선을 사용하므로 눈비 또는 안개 상황에서 측정 성능이 크게 떨어지는데, 이로 인해 주변 객체들에 대한 인식이 어려워져 안전한 자율주행이 불가능하다.

더구나, 차내에 설치할 수 있는 카메라와 달리 자동차의 지붕에 설치하는 라이다는 외부 환경에 노출돼 있어서 그 표면에 눈비 또는 흙먼지가 묻는 경우 라이다를 이용한 전방 탐지가 어려워진다. 공승현 교수는 "젖은 도로에서 전방에 주행 차량이 있는 경우, 그 바퀴에서 일어나는 흙먼지가 섞인 물보라로 라이다 표면이 빠르게 더럽혀지고, 결과적으로 모든 전방 객체에 대한 라이다 측정이 불가능해진다ˮ고 설명한다. {그림 1 참조}

적외선을 사용하는 라이다와는 달리 77기가헤르츠(GHz) 대역의 자동차 레이더는 눈, 비, 안개 등의 악천후 상황에 매우 강건하며 표면에 눈비나 흙먼지가 묻은 상황에서도 안정적인 측정 결과를 보인다. 최근에는 고해상도의 4D 레이더(대상까지의 거리, 방위각, 높이, 도플러 주파수를 측정)가 개발돼 상용화되고 있으며, 그 성능도 빠르게 향상되고 있다.

이에 따라서 전 세계적으로 4D 레이더에 인공지능을 이용한 주변 인지 기술 연구가 시작되고 있지만, 4D 레이더에 필요한 인공지능 연구는 매우 더디게 진행되고 있다. 카메라나 라이다와 달리, 고성능 인공지능 개발에 필수적인 충분한 데이터셋이 구축되지 못하고 있기 때문이다. 2021년부터 4D 레이더의 포인트 클라우드 데이터셋이 일부 공개됐으나, 데이터의 양이 충분하지 않고 측정치가 매우 희소해 신뢰할 만한 객체 인식 인공지능 신경망 개발이 쉽지 않다.

연구팀이 공개하는 K-레이더는 악천후를 포함한 다양한 날씨 및 교통 상황에서 수집된 다양성 높은 데이터셋이며, 정확히 동기된 카메라와 라이다 측정 데이터와 함께 구축된 13테라바이트(TB)에 이르는 대용량으로 세계 최초의 4D 레이더 데이터셋이다. 특히, K-레이더는 포인트 클라우드 형태가 아닌 인공지능 신경망의 성능을 극대화할 수 있는 텐서(Tensor) 형태의 데이터셋으로, 이는 일반적인 레이더의 잡음 제거 방식을 사용하지 않아 잡음 수준의 미약한 미세 측정치를 온전히 담고 있는 형태의 데이터셋이다.

연구팀이 개발한 4D 레이더 인공지능 신경망(RTN4D)은 K-레이더로 수많은 학습을 진행했고, 그 결과 다양한 날씨와 도로 상황에서 70m 이내의 객체에 대해 객체 판별, 위치 추정 및 주행 방향 추정의 3가지 추정을 정확히 수행하는 경우가 최종 62.5%인 세계 최고의 성능을 가진다.

또한, 연구팀은 전 세계의 연구자들이 자체적으로 데이터를 추가 구축하고 신경망 기술을 개발하며 그 성능을 자체 평가할 수 있도록 레이더용 인공지능 신경망 개발 플랫폼과 벤치마크도 공개 제공한다.

조천식모빌리티대학원 공승현 교수는 "눈이나 비가 오는 날씨에서 4D 레이더 인공지능 신경망은 기존 라이다 인공지능 신경망 보다 훨씬 더 안정적인 주변 객체 인지 성능을 갖는데, 이는 4D 레이더가 악천후에서 자율주행을 위한 필수 센서임을 보여주는 결과이며{그림 2 참조}, 최근 미국의 웨이모(Waymo)와 이스라엘의 모빌아이(Mobileye)가 수년 내로 4D 레이더를 자율주행의 주요 인지 센서로 활용할 계획임을 공개적으로 밝힌 이유다ˮ라며 "우리 연구팀이 공개한 K-레이더와 4D 레이더 인공지능 개발 플랫폼 및 벤치마크를 통해, 향후 4D 레이더에 관한 인공지능 연구가 더욱 활발히 진행될 것으로 기대한다ˮ라고 말했다.

K-레이더, 4D 레이더 인공지능 신경망(RTN4D), 4D 레이더 인공지능 개발 플랫폼과 벤치마크는 연구실 홈페이지(http://ave.kaist.ac.kr/)와 깃허브(https://github.com/kaist-avelab/K-Radar)를 통해서 배포될 예정이다. 이번 연구는 한국연구재단(NRF) 및 정보통신기획평가원(IITP)의 지원과 ㈜스마트레이더시스템의 협력으로 수행됐으며, 연구 성과는 백동희 박사과정 학생이 2022년 12월에 열리는 세계적인 인공지능 컨퍼런스인 `뉴립스(NeurIPS) 2022' 데이터셋&벤치마크 트랙(Datasets and Benchmark Track)에서 발표할 예정이다(논문명: K-Radar: 4D Radar Object Detection Dataset and Benchmark for Autonomous Driving in Various Weather Conditions)

2022.10.20 조회수 9038 -

인공지능 심층 학습(딥러닝) 서비스 구축 비용 최소화 가능한 데이터 정제 기술 개발

최근 다양한 분야에서 인공지능 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서 인공지능은 심층신경망을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 고양이 사진에 `고양이'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간적 비용이 소요된다. 따라서 훈련 데이터 구축 비용을 최소화하는 방법 개발이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 심층 학습 훈련 데이터 구축 비용을 최소화할 수 있는 새로운 데이터 동시 정제 및 선택 기술을 개발했다고 12일 밝혔다.

일반적으로 심층 학습용 훈련 데이터 구축 과정은 수집, 정제, 선택 및 레이블링 단계로 이뤄진다. 수집 단계에서는 웹, 카메라, 센서 등으로부터 대용량의 데이터가 정제되지 않은 채로 수집된다. 따라서 수집된 데이터에는 목표 서비스와 관련이 없어서 주어진 레이블에 해당하지 않는 분포 외(out-of-distribution) 데이터가 포함된다 (예를 들어, 동물 사진을 수집할 때 재규어 `자동차'가 포함됨). 이러한 분포 외 데이터는 데이터 정제 단계에서 정제돼야 한다. 모든 정제된 데이터에 정답지를 만들기 위해서는 막대한 비용이 소모되는데, 이를 최소화하기 위해 심층 학습 성능 향상에 가장 도움이 되는 훈련 데이터를 먼저 선택해 레이블링하는 능동 학습(active learning)이 큰 주목을 받고 있다. 그러나 정제와 레이블링을 별도로 진행하는 것은 데이터 검사 측면에서 중복적인 비용을 초래한다. 또한 아직 정제되지 않고 남아 있는 분포 외 데이터가 레이블링 단계에서 선택된다면 레이블링 노력을 낭비할 수 있다.

이재길 교수팀이 개발한 기술은 훈련 데이터 구축 단계에서 데이터의 정제 및 선택을 동시에 수행해 심층 학습용 훈련 데이터 구축 비용을 최소화할 수 있도록 해준다.

우리 대학 데이터사이언스대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 신유주 박사과정, 이영준 박사과정 학생이 제2, 제4 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2022'에서 올 12월 발표될 예정이다. (논문명 : Meta-Query-Net: Resolving Purity-Informativeness Dilemma in Open-set Active Learning)

데이터의 정제 및 선택을 동시에 고려하기 위해서 구체적으로 가장 분포 외 데이터가 아닐 것 같은 데이터 중에서 가장 심층 학습 성능 향상에 도움이 될 데이터를 선택한다. 즉, 주어진 훈련 데이터 구축 비용 내에서 최고의 효과를 내도록 데이터의 순도(purity) 지표와 정보도(informativeness) 지표의 최적 균형(trade-off)을 찾는다. 순도와 정보도는 일반적으로 서로 상충하므로 최적 균형을 찾는 것이 간단하지 않다. 이 교수팀은 이러한 최적 균형이 정제 전 데이터의 분포 외 데이터 비율과 현재 심층신경망 훈련 정도에 따라 달라진다는 점을 발견했다.

이 교수팀은 이러한 최적 균형을 찾아내기 위해 추가적인 작은 신경망 모델을 도입했다. 연구팀은 추가된 모델을 훈련하기 위해 능동 학습에서 여러 단계에 걸쳐 데이터를 선별하는 과정을 활용했다. 즉, 새롭게 선택돼 레이블링 된 데이터를 순도-정보도 최적 균형을 찾기 위한 훈련 데이터로 활용했고, 레이블이 추가될 때마다 최적 균형을 갱신했다. 이러한 방법은 목표 심층신경망의 성능 향상을 위해 추가적인 상위 레벨의 신경망을 사용하였다는 점에서 메타학습(meta-learning)의 일종이라 볼 수 있다.

연구팀은 이 메타학습 방법론을 `메타 질의 네트워크'라고 이름 붙이고 이미지 분류 문제에 대해 다양한 데이터와 광범위한 분포 외 데이터 비율에 걸쳐 방법론을 검증했다. 그 결과, 기존 최신 방법론과 비교했을 때 최대 20% 향상된 최종 예측 정확도를 향상했고, 모든 범위의 분포 외 데이터 비율에서 일관되게 최고 성능을 보였다. 또한, `메타 질의 네트워크'의 최적 균형 분석을 통해, 분포 외 데이터의 비율이 낮고 현재 심층신경망의 성능이 높을수록 정보도에 높은 가중치를 둬야 함을 연구팀은 밝혀냈다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 실세계 능동 학습에서의 순도-정보도 딜레마를 발견하고 해결한 획기적인 방법ˮ 이라면서 "다양한 데이터 분포 상황에서의 강건성이 검증됐기 때문에, 실생활의 기계 학습 문제에 폭넓게 적용될 수 있어 전반적인 심층 학습의 훈련 데이터 준비 비용 절감에 기여할 것ˮ 이라고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2022.10.12 조회수 9434

인공지능 심층 학습(딥러닝) 서비스 구축 비용 최소화 가능한 데이터 정제 기술 개발

최근 다양한 분야에서 인공지능 심층 학습(딥러닝) 기술을 활용한 서비스가 급속히 증가하고 있다. 서비스 구축을 위해서 인공지능은 심층신경망을 훈련해야 하며, 이를 위해서는 충분한 훈련 데이터를 준비해야 한다. 특히 훈련 데이터에 정답지를 만드는 레이블링(labeling) 과정이 필요한데 (예를 들어, 고양이 사진에 `고양이'라고 정답을 적어줌), 이 과정은 일반적으로 수작업으로 진행되므로 엄청난 노동력과 시간적 비용이 소요된다. 따라서 훈련 데이터 구축 비용을 최소화하는 방법 개발이 요구되고 있다.

우리 대학 전산학부 이재길 교수 연구팀이 심층 학습 훈련 데이터 구축 비용을 최소화할 수 있는 새로운 데이터 동시 정제 및 선택 기술을 개발했다고 12일 밝혔다.

일반적으로 심층 학습용 훈련 데이터 구축 과정은 수집, 정제, 선택 및 레이블링 단계로 이뤄진다. 수집 단계에서는 웹, 카메라, 센서 등으로부터 대용량의 데이터가 정제되지 않은 채로 수집된다. 따라서 수집된 데이터에는 목표 서비스와 관련이 없어서 주어진 레이블에 해당하지 않는 분포 외(out-of-distribution) 데이터가 포함된다 (예를 들어, 동물 사진을 수집할 때 재규어 `자동차'가 포함됨). 이러한 분포 외 데이터는 데이터 정제 단계에서 정제돼야 한다. 모든 정제된 데이터에 정답지를 만들기 위해서는 막대한 비용이 소모되는데, 이를 최소화하기 위해 심층 학습 성능 향상에 가장 도움이 되는 훈련 데이터를 먼저 선택해 레이블링하는 능동 학습(active learning)이 큰 주목을 받고 있다. 그러나 정제와 레이블링을 별도로 진행하는 것은 데이터 검사 측면에서 중복적인 비용을 초래한다. 또한 아직 정제되지 않고 남아 있는 분포 외 데이터가 레이블링 단계에서 선택된다면 레이블링 노력을 낭비할 수 있다.

이재길 교수팀이 개발한 기술은 훈련 데이터 구축 단계에서 데이터의 정제 및 선택을 동시에 수행해 심층 학습용 훈련 데이터 구축 비용을 최소화할 수 있도록 해준다.

우리 대학 데이터사이언스대학원에 재학 중인 박동민 박사과정 학생이 제1 저자, 신유주 박사과정, 이영준 박사과정 학생이 제2, 제4 저자로 각각 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2022'에서 올 12월 발표될 예정이다. (논문명 : Meta-Query-Net: Resolving Purity-Informativeness Dilemma in Open-set Active Learning)

데이터의 정제 및 선택을 동시에 고려하기 위해서 구체적으로 가장 분포 외 데이터가 아닐 것 같은 데이터 중에서 가장 심층 학습 성능 향상에 도움이 될 데이터를 선택한다. 즉, 주어진 훈련 데이터 구축 비용 내에서 최고의 효과를 내도록 데이터의 순도(purity) 지표와 정보도(informativeness) 지표의 최적 균형(trade-off)을 찾는다. 순도와 정보도는 일반적으로 서로 상충하므로 최적 균형을 찾는 것이 간단하지 않다. 이 교수팀은 이러한 최적 균형이 정제 전 데이터의 분포 외 데이터 비율과 현재 심층신경망 훈련 정도에 따라 달라진다는 점을 발견했다.

이 교수팀은 이러한 최적 균형을 찾아내기 위해 추가적인 작은 신경망 모델을 도입했다. 연구팀은 추가된 모델을 훈련하기 위해 능동 학습에서 여러 단계에 걸쳐 데이터를 선별하는 과정을 활용했다. 즉, 새롭게 선택돼 레이블링 된 데이터를 순도-정보도 최적 균형을 찾기 위한 훈련 데이터로 활용했고, 레이블이 추가될 때마다 최적 균형을 갱신했다. 이러한 방법은 목표 심층신경망의 성능 향상을 위해 추가적인 상위 레벨의 신경망을 사용하였다는 점에서 메타학습(meta-learning)의 일종이라 볼 수 있다.

연구팀은 이 메타학습 방법론을 `메타 질의 네트워크'라고 이름 붙이고 이미지 분류 문제에 대해 다양한 데이터와 광범위한 분포 외 데이터 비율에 걸쳐 방법론을 검증했다. 그 결과, 기존 최신 방법론과 비교했을 때 최대 20% 향상된 최종 예측 정확도를 향상했고, 모든 범위의 분포 외 데이터 비율에서 일관되게 최고 성능을 보였다. 또한, `메타 질의 네트워크'의 최적 균형 분석을 통해, 분포 외 데이터의 비율이 낮고 현재 심층신경망의 성능이 높을수록 정보도에 높은 가중치를 둬야 함을 연구팀은 밝혀냈다.

제1 저자인 박동민 박사과정 학생은 "이번 기술은 실세계 능동 학습에서의 순도-정보도 딜레마를 발견하고 해결한 획기적인 방법ˮ 이라면서 "다양한 데이터 분포 상황에서의 강건성이 검증됐기 때문에, 실생활의 기계 학습 문제에 폭넓게 적용될 수 있어 전반적인 심층 학습의 훈련 데이터 준비 비용 절감에 기여할 것ˮ 이라고 밝혔다.

연구팀을 지도한 이재길 교수도 "이 기술이 텐서플로우(TensorFlow) 혹은 파이토치(PyTorch)와 같은 기존의 심층 학습 라이브러리에 추가되면 기계 학습 및 심층 학습 학계에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(2020-0-00862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2022.10.12 조회수 9434 -

인공지능으로 화학반응을 예측하다

우리 대학 생명화학공학과 정유성 교수 연구팀이 화학자처럼 생각하는 인공지능을 개발했다고 4일 밝혔다. 연구팀이 개발한 인공지능은 유기 반응의 결과를 정확하게 예측한다.

유기 화학자는 반응물을 보고 유기 화학반응의 결과를 예상해 약물이나 유기발광다이오드(OLED)와 같이 원하는 물성을 갖는 분자를 합성한다. 하지만 실험을 통해 화학반응의 생성물을 직접 확인하는 작업은 일반적으로 시간과 비용이 많이 소모된다. 게다가 유기 화학 반응은 같은 반응물에서 다양한 생성물이 생길 수 있어 숙련된 유기 화학자라도 모든 화학반응을 정확하게 예측하지 못한다.

이런 한계를 극복하고자 인공지능을 이용해 유기 반응을 예측하는 연구가 활발하게 일어나고 있다. 대부분의 연구는 반응물과 생성물을 서로 다른 두 개의 언어로 생각하고 한 언어에서 다른 언어로 번역하는 언어 번역 모델을 사용하는 방법에 집중하고 있다. 이 방법은 예측 정확도는 높지만, 인공지능이 화학을 이해하고 생성물을 예측했다고 해석하기 어려워 모델이 예측한 결과를 신뢰하기 어렵다.

정 교수팀은 화학적 직관을 바탕으로 모델을 설계해서 모델이 예측한 결과를 화학적으로 설명을 할 수 있을 뿐 아니라, 공개 데이터베이스에서 매우 우수한 예측 정확도를 달성했다.

정 교수팀은 화학자가 반응 결과를 예측하는 방법에서 아이디어를 얻었다. 화학자는 반응 중심을 파악하고 화학반응 규칙을 적용해 가능한 생성물을 예측한다. 이 과정을 본떠서 공개 화학반응 데이터베이스로부터 화학반응 규칙을 도출했다. 화학반응 규칙을 바탕으로 분자의 화학 반응성을 예측하기 위해서, 분자를 그래프로 취급하는 그래프 신경망(Graph Neural Network, GNN) 모델을 개발했다. 이 모델에 반응물들을 넣으면 화학반응 규칙과 반응 중심을 식별해 생성물을 성공적으로 예측한다.

정 교수팀은 화학반응에서 널리 사용되는 미국 특허무역청(USPTO) 데이터를 이용해 유기 반응을 90% 이상의 정확도로 예측하는 데 성공했다. 개발된 모델은 실제 사용 시 모델에 높은 신뢰성을 제공하는 `예측의 불확실성'을 말할 수 있다. 예를 들어, 불확실성이 낮다고 간주되는 모델의 정확도는 98.6%로 증가한다. 모델은 무작위로 샘플링된 일련의 유기 반응을 예측하는 데 있어 소규모의 합성 전문가보다 더 정확한 것으로 나타났다.

이번 연구의 성공으로 연구팀은 다른 분야에서 좋은 성능을 보인 모델을 그대로 사용하던 기존 방법보다, 화학자가 생각하는 방법과 동일하게 신경망을 설계하는 전략이 더 합리적이고 우수한 성능을 보인다는 것을 입증했다. 연구팀은 이 연구를 활용하면 분자 설계 과정이 비약적으로 빨라질 것으로 기대하며, 새로운 화합물 개발에 실용적인 응용을 기대하고 있다. 정유성 교수팀은 현재 연구 성과의 특허 출원을 준비하고 있다.

우리 대학 생명화학공학과 첸수안(Shuan Chen) 박사과정이 제1 저자로 참여한 이번 연구 결과는 국제 학술지 '네이처 머신 인텔리전스(Nature Machine Intelligence)'에 9월호 표지논문으로 선정돼 출판됐다.

한편 이번 연구는 산업통상자원부와 한국연구재단의 지원을 받아 수행됐다.

2022.10.04 조회수 26155

인공지능으로 화학반응을 예측하다

우리 대학 생명화학공학과 정유성 교수 연구팀이 화학자처럼 생각하는 인공지능을 개발했다고 4일 밝혔다. 연구팀이 개발한 인공지능은 유기 반응의 결과를 정확하게 예측한다.

유기 화학자는 반응물을 보고 유기 화학반응의 결과를 예상해 약물이나 유기발광다이오드(OLED)와 같이 원하는 물성을 갖는 분자를 합성한다. 하지만 실험을 통해 화학반응의 생성물을 직접 확인하는 작업은 일반적으로 시간과 비용이 많이 소모된다. 게다가 유기 화학 반응은 같은 반응물에서 다양한 생성물이 생길 수 있어 숙련된 유기 화학자라도 모든 화학반응을 정확하게 예측하지 못한다.

이런 한계를 극복하고자 인공지능을 이용해 유기 반응을 예측하는 연구가 활발하게 일어나고 있다. 대부분의 연구는 반응물과 생성물을 서로 다른 두 개의 언어로 생각하고 한 언어에서 다른 언어로 번역하는 언어 번역 모델을 사용하는 방법에 집중하고 있다. 이 방법은 예측 정확도는 높지만, 인공지능이 화학을 이해하고 생성물을 예측했다고 해석하기 어려워 모델이 예측한 결과를 신뢰하기 어렵다.

정 교수팀은 화학적 직관을 바탕으로 모델을 설계해서 모델이 예측한 결과를 화학적으로 설명을 할 수 있을 뿐 아니라, 공개 데이터베이스에서 매우 우수한 예측 정확도를 달성했다.

정 교수팀은 화학자가 반응 결과를 예측하는 방법에서 아이디어를 얻었다. 화학자는 반응 중심을 파악하고 화학반응 규칙을 적용해 가능한 생성물을 예측한다. 이 과정을 본떠서 공개 화학반응 데이터베이스로부터 화학반응 규칙을 도출했다. 화학반응 규칙을 바탕으로 분자의 화학 반응성을 예측하기 위해서, 분자를 그래프로 취급하는 그래프 신경망(Graph Neural Network, GNN) 모델을 개발했다. 이 모델에 반응물들을 넣으면 화학반응 규칙과 반응 중심을 식별해 생성물을 성공적으로 예측한다.

정 교수팀은 화학반응에서 널리 사용되는 미국 특허무역청(USPTO) 데이터를 이용해 유기 반응을 90% 이상의 정확도로 예측하는 데 성공했다. 개발된 모델은 실제 사용 시 모델에 높은 신뢰성을 제공하는 `예측의 불확실성'을 말할 수 있다. 예를 들어, 불확실성이 낮다고 간주되는 모델의 정확도는 98.6%로 증가한다. 모델은 무작위로 샘플링된 일련의 유기 반응을 예측하는 데 있어 소규모의 합성 전문가보다 더 정확한 것으로 나타났다.

이번 연구의 성공으로 연구팀은 다른 분야에서 좋은 성능을 보인 모델을 그대로 사용하던 기존 방법보다, 화학자가 생각하는 방법과 동일하게 신경망을 설계하는 전략이 더 합리적이고 우수한 성능을 보인다는 것을 입증했다. 연구팀은 이 연구를 활용하면 분자 설계 과정이 비약적으로 빨라질 것으로 기대하며, 새로운 화합물 개발에 실용적인 응용을 기대하고 있다. 정유성 교수팀은 현재 연구 성과의 특허 출원을 준비하고 있다.

우리 대학 생명화학공학과 첸수안(Shuan Chen) 박사과정이 제1 저자로 참여한 이번 연구 결과는 국제 학술지 '네이처 머신 인텔리전스(Nature Machine Intelligence)'에 9월호 표지논문으로 선정돼 출판됐다.

한편 이번 연구는 산업통상자원부와 한국연구재단의 지원을 받아 수행됐다.

2022.10.04 조회수 26155 -

세계 최초 네트워크 기술이 적용된 SSD 시스템 반도체 개발

우리 대학 전기및전자공학부 김동준 교수 연구팀이 세계 최초로 `패킷 기반 네트워크' 기술이 적용된 SSD(Solid State Drive, 반도체 기억소자를 사용한 저장장치) 시스템 개발을 통해 차세대 SSD의 읽기/쓰기 성능을 비약적으로 높이는 시스템 반도체를 개발했다고 28일 밝혔다.

패킷이란 다양한 크기를 지닌 데이터를 일정한 크기로 분할한 후 제어 정보를 추가한 데이터 전송의 기본 단위를 말하며, 효율적이고 신뢰성 있게 데이터를 전송할 수 있다는 장점이 있어 주로 컴퓨터 네트워크 기반 정보 기술에서 사용되고 있다. 최근 시스템 반도체 분야에서는 다양한 계산 자원들을 칩 내부 네트워크로 연결하여 효율적으로 활용하는 기술이 적용되고 있다. 본 연구는 이러한 시스템 반도체 분야에서 효과적인 네트워크 연결 기술을 메모리 반도체에 적용하였다는 점에서 큰 의미를 가지고 있다.

SSD는 플래시메모리를 이용해 정보를 저장하는 장치로, 기존 자기디스크를 이용한 데이터 저장장치인 `하드디스크 드라이브(HDD)'에 비해 데이터 입출력(읽기/쓰기) 속도가 빠르고 발열과 소음이 적어 데이터 센터 및 클라우드 서비스를 위한 주요 저장장치로 활용되고 있다. 전 세계적으로 수십억 명이 사용하는 페이스북(Facebook), 트위터(Twitter) 등과 같은 SNS 서비스를 제공하는 기업들뿐만 아니라 구글, 마이크로소프트 등과 같이 수십억 명의 사용자 정보를 저장하고 이를 활용해 서비스를 제공하는 기업들은 더 많은 데이터를 저장하고 성능이 좋은 고용량/고성능 SSD 제품을 필요로 한다.

특히 인터넷 서비스 제공 기업들은 많은 양의 정보가 데이터 센터에서 저장되고 처리되면서 더 많은 데이터를 저장할 수 있고, 더 빠르게 데이터를 읽고 쓰는 것이 가능한 고성능 SSD 제품을 요구한다. 따라서 SSD는 지속해서 성능과 용량의 개선을 요구하는 상황에 놓이게 된다.

이에 삼성, SK 하이닉스, 등과 같은 SSD 및 메모리를 제공하는 기업에서는 고성능 SSD 기술에 크게 주목하고 있으며, 이는 많은 애플리케이션의 성능 향상에 도움이 될 뿐만 아니라 비용적인 측면에서도 효율적으로 서버 시스템을 확장하는 데 도움이 될 것으로 기대하고 있다.

하지만 이러한 장점에도 불구하고, 고용량 및 고성능 SSD를 위해 규모를 증가시키는 스케일 업(scale-up)은 하드웨어 패키징 한계에 제한돼 쉽게 확장하기 어렵다. 무엇보다도 기존 SSD 시스템은 사용 가능한 처리량 (bandwidth)이 있음에도 불구하고 효율적으로 사용하지 못하는 비효율적인 데이터 송수신 방식 채택해 사용하고 있다.

이에 김동준 교수 연구팀은 기존 SSD 시스템 설계를 분석해 CPU, GPU 등과 같은 비메모리 시스템 반도체 설계에서 주로 활용되는 네트워크 기술을 적용해 SSD 성능을 크게 높일 수 있는 `네트워크 기술이 적용된 SSD 시스템 반도체'를 개발했다. 김동준 교수팀이 개발한 SSD 시스템은 플래시 인터커넥트(interconnection network) 와 패킷 기반 플래시 컨트롤러 (packet-based flash controller) 등으로 구성되어 있으며, 현재 사용되는 기존 SSD 시스템 대비 2배 많은 처리량을 제공하고 응답시간을 약 10배 줄인 성능을 보인다고 연구팀 관계자는 설명했다.

또한 이번 개발을 통해서 기존 하드웨어의 한계를 비메모리 시스템 반도체에서 주로 사용되는 패킷(packet) 기반 송수신 기법의 사용으로 극복해 고성능 SSD 기술에 도움을 줄 수 있을 것으로 기대된다고 연구팀 관계자는 설명했다.

전기및전자공학부 김지호 박사과정이 제1 저자로, 한양대학교 컴퓨터소프트웨어학과 강석원 박사과정, 박영준 연세대학교 컴퓨터과학과 교수가 공동 저자로 참여한 이번 연구는 미국 시카고에서 열리는 컴퓨터 구조 분야 최우수 국제 학술대회인 `55th IEEE/ACM International Symposium on Microarchitecture (MICRO 2022)'에서 오늘 10월 발표될 예정이다. (논문명 : Networked SSD: Flash Memory Interconnection Network for High-Bandwidth SSD)

연구를 주도한 김동준 교수는 "이번 연구는 지금까지는 없던 네트워크 패킷(packet)이 적용된 SSD 시스템 반도체를 세계 최초로 개발했다는 점에서 의의가 있으며, 데이터 센터 및 클라우드 서비스 시장에서 지속적으로 증가하는 고성능 SSD 요구에 발맞춰 큰 도움을 줄 수 있을 것으로 보인다ˮ며, "SSD의 성능 향상은 인공지능 연구 및 빅데이터 분석 기술을 활용하는 다양한 알고리즘 성능 개선에도 기여할 것으로 보인다ˮ고 연구의 의의를 설명했다.

한편 이번 연구는 한국연구재단과 정보통신기획평가원 차세대지능형반도체기술개발사업의 지원을 받아 수행됐다.

2022.09.28 조회수 10368

세계 최초 네트워크 기술이 적용된 SSD 시스템 반도체 개발

우리 대학 전기및전자공학부 김동준 교수 연구팀이 세계 최초로 `패킷 기반 네트워크' 기술이 적용된 SSD(Solid State Drive, 반도체 기억소자를 사용한 저장장치) 시스템 개발을 통해 차세대 SSD의 읽기/쓰기 성능을 비약적으로 높이는 시스템 반도체를 개발했다고 28일 밝혔다.

패킷이란 다양한 크기를 지닌 데이터를 일정한 크기로 분할한 후 제어 정보를 추가한 데이터 전송의 기본 단위를 말하며, 효율적이고 신뢰성 있게 데이터를 전송할 수 있다는 장점이 있어 주로 컴퓨터 네트워크 기반 정보 기술에서 사용되고 있다. 최근 시스템 반도체 분야에서는 다양한 계산 자원들을 칩 내부 네트워크로 연결하여 효율적으로 활용하는 기술이 적용되고 있다. 본 연구는 이러한 시스템 반도체 분야에서 효과적인 네트워크 연결 기술을 메모리 반도체에 적용하였다는 점에서 큰 의미를 가지고 있다.

SSD는 플래시메모리를 이용해 정보를 저장하는 장치로, 기존 자기디스크를 이용한 데이터 저장장치인 `하드디스크 드라이브(HDD)'에 비해 데이터 입출력(읽기/쓰기) 속도가 빠르고 발열과 소음이 적어 데이터 센터 및 클라우드 서비스를 위한 주요 저장장치로 활용되고 있다. 전 세계적으로 수십억 명이 사용하는 페이스북(Facebook), 트위터(Twitter) 등과 같은 SNS 서비스를 제공하는 기업들뿐만 아니라 구글, 마이크로소프트 등과 같이 수십억 명의 사용자 정보를 저장하고 이를 활용해 서비스를 제공하는 기업들은 더 많은 데이터를 저장하고 성능이 좋은 고용량/고성능 SSD 제품을 필요로 한다.

특히 인터넷 서비스 제공 기업들은 많은 양의 정보가 데이터 센터에서 저장되고 처리되면서 더 많은 데이터를 저장할 수 있고, 더 빠르게 데이터를 읽고 쓰는 것이 가능한 고성능 SSD 제품을 요구한다. 따라서 SSD는 지속해서 성능과 용량의 개선을 요구하는 상황에 놓이게 된다.

이에 삼성, SK 하이닉스, 등과 같은 SSD 및 메모리를 제공하는 기업에서는 고성능 SSD 기술에 크게 주목하고 있으며, 이는 많은 애플리케이션의 성능 향상에 도움이 될 뿐만 아니라 비용적인 측면에서도 효율적으로 서버 시스템을 확장하는 데 도움이 될 것으로 기대하고 있다.

하지만 이러한 장점에도 불구하고, 고용량 및 고성능 SSD를 위해 규모를 증가시키는 스케일 업(scale-up)은 하드웨어 패키징 한계에 제한돼 쉽게 확장하기 어렵다. 무엇보다도 기존 SSD 시스템은 사용 가능한 처리량 (bandwidth)이 있음에도 불구하고 효율적으로 사용하지 못하는 비효율적인 데이터 송수신 방식 채택해 사용하고 있다.

이에 김동준 교수 연구팀은 기존 SSD 시스템 설계를 분석해 CPU, GPU 등과 같은 비메모리 시스템 반도체 설계에서 주로 활용되는 네트워크 기술을 적용해 SSD 성능을 크게 높일 수 있는 `네트워크 기술이 적용된 SSD 시스템 반도체'를 개발했다. 김동준 교수팀이 개발한 SSD 시스템은 플래시 인터커넥트(interconnection network) 와 패킷 기반 플래시 컨트롤러 (packet-based flash controller) 등으로 구성되어 있으며, 현재 사용되는 기존 SSD 시스템 대비 2배 많은 처리량을 제공하고 응답시간을 약 10배 줄인 성능을 보인다고 연구팀 관계자는 설명했다.

또한 이번 개발을 통해서 기존 하드웨어의 한계를 비메모리 시스템 반도체에서 주로 사용되는 패킷(packet) 기반 송수신 기법의 사용으로 극복해 고성능 SSD 기술에 도움을 줄 수 있을 것으로 기대된다고 연구팀 관계자는 설명했다.

전기및전자공학부 김지호 박사과정이 제1 저자로, 한양대학교 컴퓨터소프트웨어학과 강석원 박사과정, 박영준 연세대학교 컴퓨터과학과 교수가 공동 저자로 참여한 이번 연구는 미국 시카고에서 열리는 컴퓨터 구조 분야 최우수 국제 학술대회인 `55th IEEE/ACM International Symposium on Microarchitecture (MICRO 2022)'에서 오늘 10월 발표될 예정이다. (논문명 : Networked SSD: Flash Memory Interconnection Network for High-Bandwidth SSD)

연구를 주도한 김동준 교수는 "이번 연구는 지금까지는 없던 네트워크 패킷(packet)이 적용된 SSD 시스템 반도체를 세계 최초로 개발했다는 점에서 의의가 있으며, 데이터 센터 및 클라우드 서비스 시장에서 지속적으로 증가하는 고성능 SSD 요구에 발맞춰 큰 도움을 줄 수 있을 것으로 보인다ˮ며, "SSD의 성능 향상은 인공지능 연구 및 빅데이터 분석 기술을 활용하는 다양한 알고리즘 성능 개선에도 기여할 것으로 보인다ˮ고 연구의 의의를 설명했다.

한편 이번 연구는 한국연구재단과 정보통신기획평가원 차세대지능형반도체기술개발사업의 지원을 받아 수행됐다.

2022.09.28 조회수 10368 -

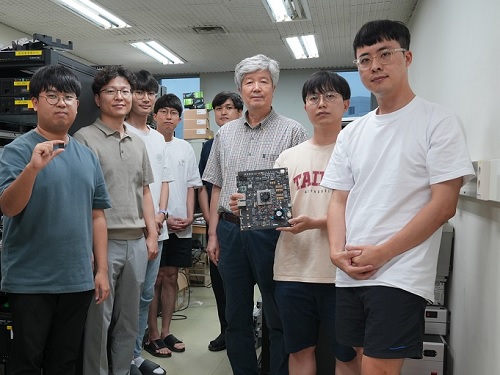

정밀한 시각적 판단을 추론한 새로운 인공지능 가속칩 개발

우리 대학 전기및전자공학부 윤찬현, 김주영 교수 연구팀이 설명 가능한 인공지능(eXplainable AI, XAI) 기법을 처리하기 위한 노이즈(잡음)에 강한 다중 피라미드 활성화 맵 기반 주의집중 구조가 탑재된 인공지능 칩을 설계하고, 삼성전자 DS부문의 지원으로 설명가능 뉴로프로세싱 유닛(이하 EPU, Explainable neuro-Processing Unit)을 개발했다고 24일 밝혔다.

설명가능 인공지능이란 사람이 이해할 수 있고 신뢰할 수 있는 설명을 제공할 수 있는 인공지능 기법이다. 기존의 수학적 알고리즘으로 학습되는 인공지능은 학습예제에 편향되어 신뢰할 수 없거나, 수천억개의 매개변수를 사람이 이해할 수 없다는 문제점을 해결하기 위해, 왜 인공지능이 특정 결과를 추론했는지 판단근거를 설명할 수 있도록 개발되었다. 설명가능한 인공지능은 어떤 이유에 의해서 인공지능의 의사결정에 큰 영향을 주었는지 설명할 수 있다는 점에서 기존의 인공지능보다 정확성, 공정성, 신뢰성을 보장할 수 있다는 특징을 가진다.

공동연구팀은 다중 규모 및 다중물체의 특징 추출 구조인 피라미드형 신경망 구조에서 추론 결과에 영향을 주는 인공지능 내부의 신경층별 활성화되는 정도를 복합적으로 해석할 수 있는 인공지능 모델과 이를 가속처리 특화된 채널 방향 합성곱 연산 및 정확도를 유지하는 EPU칩을 구현했다.

다중 규모 및 다중물체 특징 추출에 특화된 피라미드형 인공지능 모델에서 설명 시각화 구현을 위해서는 추론 과정의 역방향으로 모든 합성곱 층별 활성화 맵에서 모델 파라미터의 변화도를 추출할 수 있는 구조가 요구된다.

그러나 역전파 계산 과정은 기존의 추론처리 가속을 위한 인공지능 칩 설계와 달리 이전 파라미터 및 상태를 기억해야 하며 이는 한정된 온 칩 메모리 크기 및 인공지능 모델 전체를 특정한 용도에 맞게 주문 제작(ASIC; Application Specific Integrated Circuit)해 구현하기에는 물리적 한계가 있다.

또한, 피라미드형 구조의 설명 가능한 인공지능 모델은 설명성 보장을 위한 N개 층의 활성화 맵으로부터 기울기 기반의 클래스 활성 맵핑 시각화 처리 각각 필요해 복잡도를 높이는 문제가 있다. 그리고, 입력의 매우 작은 노이즈에도 클래스 활성화 맵핑 시각화 설명이 완전히 달라져 설명 가능한 인공지능 모델의 신뢰도 저하가 큰 문제점이었다.

전기및전자공학부 윤찬현 교수 연구팀은 문제해결을 위해(그림1 참조) 설명 가능한 인공지능의 다중 활성화 맵 고유의 특성 정보를 융합해 전역 주의 집중 맵을 생성하는 네트워크 구조와 입력 이미지 노이즈에 강건한 모델 생성을 위한 상호학습 방법을 개발해, 단일 활성화 맵 기반 주의집중 맵 생성 기술에 비해 설명성 지표를 최대 6배가량 높였다.

또한, 다중 스케일의 다양한 주의집중 맵들의 상호 보완적인 특성을 일원화된 주의집중 맵으로 정교하게 재구성함으로써 사람이 해석 가능한 수준의 정밀한 설명성을 제공할 수 있게 했다. 이번 연구 성과를 통해 위성 영상과 같이 객체 크기 변화가 큰 이미지 분석에서 인공지능 모델의 설명성을 크게 향상할 수 있을 것으로 기대된다고 연구팀 관계자는 설명했다.

전기및전자공학부 김주영 교수 연구팀은 제안된 설명 가능한 인공지능 모델을 가속하기 위해 기존 모델의 추론과 역전파 과정에 더해 활성화 맵 생성까지 처리할 수 있는 XAI 코어를 개발하고, 다양한 연산 태스크를 유연하게 분할해 동시에 처리할 수 있는 멀티 데이터 플로우 방식을 제안했다. 또한, 많은 0 값을 포함하는 활성화 맵의 특성을 활용해, 연속된 0을 건너뛸 수 있는 새로운 데이터 압축 포맷을 제안하고 이를 지원하는 가속 유닛을 개발해 최대 10배 이상의 활성화 맵을 칩 내부에서 처리할 수 있도록 했다.

연구팀이 개발한 EPU 칩은 광학 위성, 전천후 관측 영상레이더(Synthetic Aperture Radar) 위성 등 특수 목적과 고정밀 인공지능 영상처리시스템에 적용할 수 있으며, 저지연‧저전력으로 인공지능 시스템의 판단 근거에 대한 설명성을 획기적으로 높일 수 있을 것으로 기대된다. 연구팀은 EPU 칩 개발 후속 연구를 진행할 계획이다.

2022.08.25 조회수 9097

정밀한 시각적 판단을 추론한 새로운 인공지능 가속칩 개발

우리 대학 전기및전자공학부 윤찬현, 김주영 교수 연구팀이 설명 가능한 인공지능(eXplainable AI, XAI) 기법을 처리하기 위한 노이즈(잡음)에 강한 다중 피라미드 활성화 맵 기반 주의집중 구조가 탑재된 인공지능 칩을 설계하고, 삼성전자 DS부문의 지원으로 설명가능 뉴로프로세싱 유닛(이하 EPU, Explainable neuro-Processing Unit)을 개발했다고 24일 밝혔다.

설명가능 인공지능이란 사람이 이해할 수 있고 신뢰할 수 있는 설명을 제공할 수 있는 인공지능 기법이다. 기존의 수학적 알고리즘으로 학습되는 인공지능은 학습예제에 편향되어 신뢰할 수 없거나, 수천억개의 매개변수를 사람이 이해할 수 없다는 문제점을 해결하기 위해, 왜 인공지능이 특정 결과를 추론했는지 판단근거를 설명할 수 있도록 개발되었다. 설명가능한 인공지능은 어떤 이유에 의해서 인공지능의 의사결정에 큰 영향을 주었는지 설명할 수 있다는 점에서 기존의 인공지능보다 정확성, 공정성, 신뢰성을 보장할 수 있다는 특징을 가진다.

공동연구팀은 다중 규모 및 다중물체의 특징 추출 구조인 피라미드형 신경망 구조에서 추론 결과에 영향을 주는 인공지능 내부의 신경층별 활성화되는 정도를 복합적으로 해석할 수 있는 인공지능 모델과 이를 가속처리 특화된 채널 방향 합성곱 연산 및 정확도를 유지하는 EPU칩을 구현했다.

다중 규모 및 다중물체 특징 추출에 특화된 피라미드형 인공지능 모델에서 설명 시각화 구현을 위해서는 추론 과정의 역방향으로 모든 합성곱 층별 활성화 맵에서 모델 파라미터의 변화도를 추출할 수 있는 구조가 요구된다.

그러나 역전파 계산 과정은 기존의 추론처리 가속을 위한 인공지능 칩 설계와 달리 이전 파라미터 및 상태를 기억해야 하며 이는 한정된 온 칩 메모리 크기 및 인공지능 모델 전체를 특정한 용도에 맞게 주문 제작(ASIC; Application Specific Integrated Circuit)해 구현하기에는 물리적 한계가 있다.

또한, 피라미드형 구조의 설명 가능한 인공지능 모델은 설명성 보장을 위한 N개 층의 활성화 맵으로부터 기울기 기반의 클래스 활성 맵핑 시각화 처리 각각 필요해 복잡도를 높이는 문제가 있다. 그리고, 입력의 매우 작은 노이즈에도 클래스 활성화 맵핑 시각화 설명이 완전히 달라져 설명 가능한 인공지능 모델의 신뢰도 저하가 큰 문제점이었다.

전기및전자공학부 윤찬현 교수 연구팀은 문제해결을 위해(그림1 참조) 설명 가능한 인공지능의 다중 활성화 맵 고유의 특성 정보를 융합해 전역 주의 집중 맵을 생성하는 네트워크 구조와 입력 이미지 노이즈에 강건한 모델 생성을 위한 상호학습 방법을 개발해, 단일 활성화 맵 기반 주의집중 맵 생성 기술에 비해 설명성 지표를 최대 6배가량 높였다.

또한, 다중 스케일의 다양한 주의집중 맵들의 상호 보완적인 특성을 일원화된 주의집중 맵으로 정교하게 재구성함으로써 사람이 해석 가능한 수준의 정밀한 설명성을 제공할 수 있게 했다. 이번 연구 성과를 통해 위성 영상과 같이 객체 크기 변화가 큰 이미지 분석에서 인공지능 모델의 설명성을 크게 향상할 수 있을 것으로 기대된다고 연구팀 관계자는 설명했다.

전기및전자공학부 김주영 교수 연구팀은 제안된 설명 가능한 인공지능 모델을 가속하기 위해 기존 모델의 추론과 역전파 과정에 더해 활성화 맵 생성까지 처리할 수 있는 XAI 코어를 개발하고, 다양한 연산 태스크를 유연하게 분할해 동시에 처리할 수 있는 멀티 데이터 플로우 방식을 제안했다. 또한, 많은 0 값을 포함하는 활성화 맵의 특성을 활용해, 연속된 0을 건너뛸 수 있는 새로운 데이터 압축 포맷을 제안하고 이를 지원하는 가속 유닛을 개발해 최대 10배 이상의 활성화 맵을 칩 내부에서 처리할 수 있도록 했다.

연구팀이 개발한 EPU 칩은 광학 위성, 전천후 관측 영상레이더(Synthetic Aperture Radar) 위성 등 특수 목적과 고정밀 인공지능 영상처리시스템에 적용할 수 있으며, 저지연‧저전력으로 인공지능 시스템의 판단 근거에 대한 설명성을 획기적으로 높일 수 있을 것으로 기대된다. 연구팀은 EPU 칩 개발 후속 연구를 진행할 계획이다.

2022.08.25 조회수 9097 -

인공지능 활용 고용량 배터리 소재 역설계 기술 개발

우리 대학 신소재공학과 홍승범 교수 연구팀이 우리 대학 조은애 교수, 변혜령 교수, 이혁모 교수, 신종화 교수, 육종민 교수, 그리고 미국의 르하이 대학교(Lehigh University), 죠수아 C 에이가(Joshua C. Agar) 교수와 협업해 기존 문헌에 발표된 실험값들을 추출하는 데이터 마이닝 과정과 이런 실험값들을 입력변수로 하는 다변수 선형회귀 모형을 기반으로 배터리 소재 역설계 머신러닝(기계학습) 모델을 수립했다고 23일 밝혔다.

인공지능은 고차원의 변수 공간에서 각 매개변수 간의 정량적인 상관관계를 신속하고 정확하게 추출할 수 있다. 이를 공정-구조-물성 간의 상관관계를 기반으로 발전하는 신소재공학에 적용하면 신소재 개발 시간을 단축할 수 있으며, 이런 이유로 많은 연구자가 인공지능을 신소재 개발에 활용하려고 노력하고 있다. 특히, 배터리 소재 개발에 인공지능을 활용하는 예가 가장 많은데, 주로 제1 원리 계산(양자화학에 기반한 계산법으로 계산 시 다른 경험적 수량을 전혀 사용하지 않음)과 머신러닝을 융합해 수많은 전극 소재 조합을 대량으로 스크리닝하는 기술 개발이 주를 이루고 있다.

그런데, 인공지능을 활용해서 새로운 배터리 소재를 탐색하고, 탐색한 소재를 합성 및 특성 평가에 있어 가장 큰 문제점은 데이터의 신뢰성과 양이다. 제1 원리 계산으로 예측한 값들은 실험으로 검증이 돼야 하며, 실험데이터의 경우 실험실마다 편차가 있고, 중요한 공정변수들을 공개하지 않은 경우가 많아 인공지능이 학습할 수 있는 데이터의 크기가 한정적이라는 문제가 대두되고 있다.

연구팀은 배터리 양극재 원료조성, 1차 및 2차 소결 온도와 시간 등의 공정 변수와 컷오프 전위 및 충․방전률과 같은 측정 변수, 그리고 1차 및 2차 입자의 크기와 같은 구조 변수, 마지막으로 충․방전 용량과 같은 성능 변수 간의 상관관계를 정량적으로 수립했고, 이를 활용해 요구되는 에너지 용량에 맞는 합성 조건을 찾는 알고리즘을 개발했다.

홍 교수 연구팀은 고니켈 함량 양극재 관련 논문 415편 안에 발표된 주요 변수들을 추출하고, 그중 16% 정도의 정보가 기입되지 않음을 발견했으며, 머신러닝 기법 중에서 k-최근접 이웃 알고리즘(k-nearest neighbors (KNN)), 랜덤 포레스트(random forest (RF)), 연쇄등식을 이용한 다중대치(multiple imputations by chained equations (MICE))를 활용해 빠진 정보를 예측하여 기입했다. 그리고, 가장 신뢰도가 높은 MICE를 선택해 얻은 입력 데이터 셋을 기반으로 주어진 공정 및 측정 변수에 대해서 성능 변수를 예측하는 순방향 모델을 얻었다.

이어서 입자 군집 최적화(particle swarm optimization, PSO) 알고리즘을 활용하여 주어진 성능 변수에 대응하는 공정 및 측정 변수를 추출하는 역방향 모델을 수립했고, 이 모델을 검증하기 위해 소재를 실제로 합성하여 타깃 용량인 200, 175, 150 mAh/g과 11% 정도의 오차를 보여 상당히 정확하게 역설계할 수 있음을 입증했다.

교신 저자인 홍승범 교수는 "인공지능을 활용해 대량의 논문 및 특허 내에 있는 공정-구조-물성 변수들을 자동으로 분류하고 실험값들을 추출해 각 변수 간의 다차원 상관관계를 기반으로 모델을 수립하는 것이 차세대 배터리 소재의 역설계의 핵심ˮ이라며 "향후 데이터 마이닝 기술, 머신러닝 기술 그리고 공정 자동화 기술을 융합하는 것이 미래의 신소재공학ˮ이라고 말했다.

신소재공학과 치 하오 리오우(Chi Hao Liow) 박사가 제1 저자로 참여한 이번 연구는 국제 학술지 `나노에너지(Nano Energy)'에 게재됐다. (논문명: Machine learning assisted synthesis of lithium-ion batteries cathode materials)

한편 이번 연구는 KAIST 글로벌 특이점 사업의 지원을 받아 수행됐다.

2022.08.23 조회수 9939

인공지능 활용 고용량 배터리 소재 역설계 기술 개발

우리 대학 신소재공학과 홍승범 교수 연구팀이 우리 대학 조은애 교수, 변혜령 교수, 이혁모 교수, 신종화 교수, 육종민 교수, 그리고 미국의 르하이 대학교(Lehigh University), 죠수아 C 에이가(Joshua C. Agar) 교수와 협업해 기존 문헌에 발표된 실험값들을 추출하는 데이터 마이닝 과정과 이런 실험값들을 입력변수로 하는 다변수 선형회귀 모형을 기반으로 배터리 소재 역설계 머신러닝(기계학습) 모델을 수립했다고 23일 밝혔다.

인공지능은 고차원의 변수 공간에서 각 매개변수 간의 정량적인 상관관계를 신속하고 정확하게 추출할 수 있다. 이를 공정-구조-물성 간의 상관관계를 기반으로 발전하는 신소재공학에 적용하면 신소재 개발 시간을 단축할 수 있으며, 이런 이유로 많은 연구자가 인공지능을 신소재 개발에 활용하려고 노력하고 있다. 특히, 배터리 소재 개발에 인공지능을 활용하는 예가 가장 많은데, 주로 제1 원리 계산(양자화학에 기반한 계산법으로 계산 시 다른 경험적 수량을 전혀 사용하지 않음)과 머신러닝을 융합해 수많은 전극 소재 조합을 대량으로 스크리닝하는 기술 개발이 주를 이루고 있다.

그런데, 인공지능을 활용해서 새로운 배터리 소재를 탐색하고, 탐색한 소재를 합성 및 특성 평가에 있어 가장 큰 문제점은 데이터의 신뢰성과 양이다. 제1 원리 계산으로 예측한 값들은 실험으로 검증이 돼야 하며, 실험데이터의 경우 실험실마다 편차가 있고, 중요한 공정변수들을 공개하지 않은 경우가 많아 인공지능이 학습할 수 있는 데이터의 크기가 한정적이라는 문제가 대두되고 있다.

연구팀은 배터리 양극재 원료조성, 1차 및 2차 소결 온도와 시간 등의 공정 변수와 컷오프 전위 및 충․방전률과 같은 측정 변수, 그리고 1차 및 2차 입자의 크기와 같은 구조 변수, 마지막으로 충․방전 용량과 같은 성능 변수 간의 상관관계를 정량적으로 수립했고, 이를 활용해 요구되는 에너지 용량에 맞는 합성 조건을 찾는 알고리즘을 개발했다.

홍 교수 연구팀은 고니켈 함량 양극재 관련 논문 415편 안에 발표된 주요 변수들을 추출하고, 그중 16% 정도의 정보가 기입되지 않음을 발견했으며, 머신러닝 기법 중에서 k-최근접 이웃 알고리즘(k-nearest neighbors (KNN)), 랜덤 포레스트(random forest (RF)), 연쇄등식을 이용한 다중대치(multiple imputations by chained equations (MICE))를 활용해 빠진 정보를 예측하여 기입했다. 그리고, 가장 신뢰도가 높은 MICE를 선택해 얻은 입력 데이터 셋을 기반으로 주어진 공정 및 측정 변수에 대해서 성능 변수를 예측하는 순방향 모델을 얻었다.

이어서 입자 군집 최적화(particle swarm optimization, PSO) 알고리즘을 활용하여 주어진 성능 변수에 대응하는 공정 및 측정 변수를 추출하는 역방향 모델을 수립했고, 이 모델을 검증하기 위해 소재를 실제로 합성하여 타깃 용량인 200, 175, 150 mAh/g과 11% 정도의 오차를 보여 상당히 정확하게 역설계할 수 있음을 입증했다.

교신 저자인 홍승범 교수는 "인공지능을 활용해 대량의 논문 및 특허 내에 있는 공정-구조-물성 변수들을 자동으로 분류하고 실험값들을 추출해 각 변수 간의 다차원 상관관계를 기반으로 모델을 수립하는 것이 차세대 배터리 소재의 역설계의 핵심ˮ이라며 "향후 데이터 마이닝 기술, 머신러닝 기술 그리고 공정 자동화 기술을 융합하는 것이 미래의 신소재공학ˮ이라고 말했다.

신소재공학과 치 하오 리오우(Chi Hao Liow) 박사가 제1 저자로 참여한 이번 연구는 국제 학술지 `나노에너지(Nano Energy)'에 게재됐다. (논문명: Machine learning assisted synthesis of lithium-ion batteries cathode materials)

한편 이번 연구는 KAIST 글로벌 특이점 사업의 지원을 받아 수행됐다.

2022.08.23 조회수 9939 -

세계 최초 개인정보 보호 기술이 적용된 인공지능(AI) 반도체 개발

우리 대학 전기및전자공학부 유민수 교수 연구팀이 세계 최초로 `차등 프라이버시 기술이 적용된 인공지능(AI) 어플리케이션(Differentially private machine learning)'의 성능을 비약적으로 높이는 인공지능 반도체를 개발했다고 19일 밝혔다.

빅데이터 및 인공지능 기술의 발전과 함께 구글, 애플, 마이크로소프트 등 클라우드 서비스를 제공하는 기업들은 전 세계 수십억 명의 사용자들에게 인공지능 기술을 기반으로 여러 가지 서비스(머신러닝 애즈 어 서비스, ML-as-a-Service, MLaaS)를 제공하고 있다. 이러한 서비스 중에는, 대표적으로 유튜브나 페이스북 등에서 시청자의 개별 취향에 맞춰 동영상 콘텐츠나 상품 등을 추천하는 `개인화 추천 시스템 기술(예- 딥러닝 추천 모델, Deep Learning Recommendation Model)' 이나, 구글 포토(Photo) 와 애플 아이클라우드(iCloud) 등에서 사진을 인물 별로 분류해주는 `안면 인식 기술 (예- 합성곱 신경망 네트워크 안면 인식, Convolutional Neural Network based Face Recognition)' 등이 있다.

이와 같은 서비스는 사용자의 정보를 대량으로 수집해, 이를 기반으로 인공지능 알고리즘의 정확도와 성능을 개선한다. 이 과정에서 필연적으로 많은 양의 사용자 정보가 서비스 제공 기업의 데이터 센터로 전송되고, 민감한 개인정보나 파일들이 저장되고 사용되는 과정에서 정보가 유출되는 문제가 발생하기도 한다.

또한 이러한 문제는 최근 주목받는 대형 인공지능 모델의 경우에 더 쉽게 발생하는 경향이 있으며, 실제 구글에서 사용하는 대화형 인공지능 모델인 GPT-2의 경우, 특정 단어들을 이야기했을 때 사용자의 개인정보 등을 유출하는 문제를 보였다. [참고1] 유사사례로서 국내에서 2020년 화제가 되었던 스캐터랩의 인공지능 챗봇 이루다의 경우에도 비슷한 문제가 불거진 적이 있다. [참고2]

[참고1] https://ai.googleblog.com/2020/12/privacy-considerations-in-large.html

[참고2] https://n.news.naver.com/mnews/article/092/0002243051?sid=105

이에 애플, 구글, 마이크로소프트 등 빅 테크 기업에서는 `차등 프라이버시 (differential privacy)' 기술을 크게 주목하고 있다. 차등 프라이버시 기술은 학습에 사용되는 그라디언트(gradient, 학습 방향 기울기)에 잡음(노이즈)를 섞음으로써 인공지능 모델로부터 사용자의 개인정보를 유출하는 모든 종류의 공격을 방어할 수 있다.

하지만 이러한 장점에도 불구하고, 차등 프라이버시 기술 적용 시, 기존 대비 어플리케이션의 속도와 성능이 크게 하락하는 문제 때문에 아직까지 범용적으로 널리 적용되지는 못했다. 이는 차등 프라이버시 머신러닝 학습 과정이 일반적인 머신러닝 학습과 다른 특성을 보이고, 이로 인해 기존의 하드웨어에서 효과적으로 실행되지 않아 메모리 사용량, 학습 속도 및 하드웨어 활용도 (hardware utilization) 측면에서 비효율적이기 때문이다.

이에 유민수 교수 연구팀은 차등 프라이버시 기술의 성능 병목 구간을 분석해 해당 기술이 적용된 어플리케이션의 성능을 크게 시킬 수 있는 `차등 프라이버시 머신러닝을 위한 인공지능(AI) 반도체 칩'을 개발했다. 유민수 교수팀이 개발한 인공지능 반도체는 외적 기반 연산기와 덧셈기 트리 기반의 후처리 연산기 등으로 구성돼 있으며, 현재 가장 널리 사용되는 인공지능 프로세서인 구글 TPUv3 대비 차등 프라이버시 인공지능 학습 과정을 3.6 배 빠르게 실행시킬 수 있고, 엔비디아의 최신 GPU A100 대비 10배 적은 자원으로 대등한 성능을 보인다고 연구팀 관계자는 설명했다. 또한 이번 개발을 통해서 기존 하드웨어의 한계로 널리 쓰이지 못했던 차등 정보보호 기술의 대중화에 도움을 줄 수 있을 것으로 기대된다고 전했다.

우리 대학 전기및전자공학부 박범식, 황랑기 연구원이 공동 제1 저자로, 윤동호, 최윤혁 연구원이 공동 저자로 참여한 이번 연구는 미국 시카고에서 열리는 컴퓨터 구조 분야 최우수 국제 학술대회인 `55th IEEE/ACM International Symposium on Microarchitecture(MICRO 2022)'에서 오늘 10월 발표될 예정이다. (논문명 : DiVa: An Accelerator for Differentially Private Machine Learning)

또한 이번 연구는 지금까지는 없던 차등 프라이버시가 적용된 인공지능 반도체를 세계 최초로 개발했다는 점에서 의의가 있으며, 차등 프라이버시 인공지능 기술을 대중화해 인공지능 기반 서비스 사용자들의 개인정보를 보호하는 데에 큰 도움을 줄 수 있을 것으로 보인다. 또한, 가속기의 성능 향상은 인공지능 연구 효율을 높여 차등 프라이버시 인공지능 모델의 정확도 개선에도 기여할 것으로 보인다.

한편 이번 연구는 한국연구재단, 삼성전자, 그리고 반도체설계교육센터 (IDEC, IC Design Education Center)의 지원을 받아 수행됐다.

2022.08.19 조회수 13036

세계 최초 개인정보 보호 기술이 적용된 인공지능(AI) 반도체 개발

우리 대학 전기및전자공학부 유민수 교수 연구팀이 세계 최초로 `차등 프라이버시 기술이 적용된 인공지능(AI) 어플리케이션(Differentially private machine learning)'의 성능을 비약적으로 높이는 인공지능 반도체를 개발했다고 19일 밝혔다.

빅데이터 및 인공지능 기술의 발전과 함께 구글, 애플, 마이크로소프트 등 클라우드 서비스를 제공하는 기업들은 전 세계 수십억 명의 사용자들에게 인공지능 기술을 기반으로 여러 가지 서비스(머신러닝 애즈 어 서비스, ML-as-a-Service, MLaaS)를 제공하고 있다. 이러한 서비스 중에는, 대표적으로 유튜브나 페이스북 등에서 시청자의 개별 취향에 맞춰 동영상 콘텐츠나 상품 등을 추천하는 `개인화 추천 시스템 기술(예- 딥러닝 추천 모델, Deep Learning Recommendation Model)' 이나, 구글 포토(Photo) 와 애플 아이클라우드(iCloud) 등에서 사진을 인물 별로 분류해주는 `안면 인식 기술 (예- 합성곱 신경망 네트워크 안면 인식, Convolutional Neural Network based Face Recognition)' 등이 있다.

이와 같은 서비스는 사용자의 정보를 대량으로 수집해, 이를 기반으로 인공지능 알고리즘의 정확도와 성능을 개선한다. 이 과정에서 필연적으로 많은 양의 사용자 정보가 서비스 제공 기업의 데이터 센터로 전송되고, 민감한 개인정보나 파일들이 저장되고 사용되는 과정에서 정보가 유출되는 문제가 발생하기도 한다.

또한 이러한 문제는 최근 주목받는 대형 인공지능 모델의 경우에 더 쉽게 발생하는 경향이 있으며, 실제 구글에서 사용하는 대화형 인공지능 모델인 GPT-2의 경우, 특정 단어들을 이야기했을 때 사용자의 개인정보 등을 유출하는 문제를 보였다. [참고1] 유사사례로서 국내에서 2020년 화제가 되었던 스캐터랩의 인공지능 챗봇 이루다의 경우에도 비슷한 문제가 불거진 적이 있다. [참고2]

[참고1] https://ai.googleblog.com/2020/12/privacy-considerations-in-large.html

[참고2] https://n.news.naver.com/mnews/article/092/0002243051?sid=105

이에 애플, 구글, 마이크로소프트 등 빅 테크 기업에서는 `차등 프라이버시 (differential privacy)' 기술을 크게 주목하고 있다. 차등 프라이버시 기술은 학습에 사용되는 그라디언트(gradient, 학습 방향 기울기)에 잡음(노이즈)를 섞음으로써 인공지능 모델로부터 사용자의 개인정보를 유출하는 모든 종류의 공격을 방어할 수 있다.

하지만 이러한 장점에도 불구하고, 차등 프라이버시 기술 적용 시, 기존 대비 어플리케이션의 속도와 성능이 크게 하락하는 문제 때문에 아직까지 범용적으로 널리 적용되지는 못했다. 이는 차등 프라이버시 머신러닝 학습 과정이 일반적인 머신러닝 학습과 다른 특성을 보이고, 이로 인해 기존의 하드웨어에서 효과적으로 실행되지 않아 메모리 사용량, 학습 속도 및 하드웨어 활용도 (hardware utilization) 측면에서 비효율적이기 때문이다.

이에 유민수 교수 연구팀은 차등 프라이버시 기술의 성능 병목 구간을 분석해 해당 기술이 적용된 어플리케이션의 성능을 크게 시킬 수 있는 `차등 프라이버시 머신러닝을 위한 인공지능(AI) 반도체 칩'을 개발했다. 유민수 교수팀이 개발한 인공지능 반도체는 외적 기반 연산기와 덧셈기 트리 기반의 후처리 연산기 등으로 구성돼 있으며, 현재 가장 널리 사용되는 인공지능 프로세서인 구글 TPUv3 대비 차등 프라이버시 인공지능 학습 과정을 3.6 배 빠르게 실행시킬 수 있고, 엔비디아의 최신 GPU A100 대비 10배 적은 자원으로 대등한 성능을 보인다고 연구팀 관계자는 설명했다. 또한 이번 개발을 통해서 기존 하드웨어의 한계로 널리 쓰이지 못했던 차등 정보보호 기술의 대중화에 도움을 줄 수 있을 것으로 기대된다고 전했다.

우리 대학 전기및전자공학부 박범식, 황랑기 연구원이 공동 제1 저자로, 윤동호, 최윤혁 연구원이 공동 저자로 참여한 이번 연구는 미국 시카고에서 열리는 컴퓨터 구조 분야 최우수 국제 학술대회인 `55th IEEE/ACM International Symposium on Microarchitecture(MICRO 2022)'에서 오늘 10월 발표될 예정이다. (논문명 : DiVa: An Accelerator for Differentially Private Machine Learning)

또한 이번 연구는 지금까지는 없던 차등 프라이버시가 적용된 인공지능 반도체를 세계 최초로 개발했다는 점에서 의의가 있으며, 차등 프라이버시 인공지능 기술을 대중화해 인공지능 기반 서비스 사용자들의 개인정보를 보호하는 데에 큰 도움을 줄 수 있을 것으로 보인다. 또한, 가속기의 성능 향상은 인공지능 연구 효율을 높여 차등 프라이버시 인공지능 모델의 정확도 개선에도 기여할 것으로 보인다.

한편 이번 연구는 한국연구재단, 삼성전자, 그리고 반도체설계교육센터 (IDEC, IC Design Education Center)의 지원을 받아 수행됐다.

2022.08.19 조회수 13036 -

인공지능 기반 약물 가상 스크리닝 기술로 신규 항암 치료제 발굴 성공

우리 대학 생명과학과 김세윤 교수 연구팀이 `약물 가상 스크리닝 기술을 이용한 신규 항암 치료제 개발'에 성공했다고 12일 밝혔다.

이번 연구 결과는 국제 학술지인 `세포 사멸과 질병(Cell Death & Disease)'에 지난 7월 12일 字 온라인 게재됐다.

※ 논문명 : Lomitapide, a cholesterol-lowering drug, is an anticancer agent that induces autophagic cell death via inhibiting mTOR

※ 저자 정보 : 이보아 (한국과학기술원, 공동 제1 저자), 박승주 (한국과학기술원, 공동 제1 저자), 이슬기 (한국과학기술원, 제2 저자), 오병철 (가천대학교 의과대학, 공동 저자), 정원석 (한국과학기술원, 공동 저자), 손종우 (한국과학기술원, 공동 저자), 김세윤 (한국과학기술원, 교신저자), 포함 총 10명

`엠토르(mTOR)'라고 알려진 신호전달 단백질은 많은 암세포에서 활성이 비정상적으로 높아져 있으며 또한 암뿐만 아니라 당뇨, 염증 및 노화와 같은 다양한 질병에서 핵심적인 역할을 한다. 특히 암을 유발하는 다양한 신호전달 경로가 엠토르 단백질을 통해 매개되기 때문에 많은 제약사에서 항암 치료제 개발의 목적으로 엠토르 저해제 개발에 많은 투자를 하고 있다.

자가포식(autophagy, 오토파지)으로 알려진 생명 현상은 세포 내 엠토르 단백질에 의해 활성 조절이 정교하게 매개되는 것으로 잘 알려져 있다. 자가포식이란 `세포가 자기 살을 먹는다'는 의미로, 영양분이 과도하게 부족하거나 세포 내외적 스트레스 조건에 처한 경우, 세포가 스스로 내부 구성물질들을 파괴해 활용함으로써 세포 내 항상성을 유지하는 일종의 방어기전이다.

이러한 자가포식 활성의 조절은 양날의 칼과 같이 작용하는 것으로 알려져 있으며, 이는 암, 당뇨와 같은 질환의 발생 및 치료에 이용 가능하다고 주목받고 있다. 암세포에 과도하게 활성화돼있는 엠토르 단백질의 활성을 저해하면 자가포식을 과도하게 증가시킬 수 있으며 이를 통해 암세포의 세포 사멸이 유도될 수 있다는 사실이 알려져 있으며 이를 바탕으로 자가포식 강화에 기반한 항암제 약물의 개발전략이 제시되고 있다.

이에 김세윤 교수 연구팀은 단백질의 3차원적 구조를 활용해 화합물과 표적 단백질 사이의 물리적 상호작용을 모델링하는 유효 결합 판별 기술에 기반한 약물 재창출 전략으로 엠토르 억제성 항암제 개발 연구를 수행했다.

약물 재창출은 이미 안전성이 검증된 FDA 승인 약물 또는 임상 진행 중인 약물군을 대상으로 새로운 적응증을 찾는 신약 개발 방식이다. 이 전략은 전통적으로 10년 이상 소요되는 신약 개발의 막대한 시간과 투자를 혁신적으로 단축할 수 있는 미래 시대 신약 개발전략이다.

연구팀은 FDA 승인 약물 또는 임상 시험 중인 약물에 기반한 데이터베이스를 통해 3,391종의 약물 라이브러리를 활용했다. 라이브러리의 모든 약물을 실험적으로 검증하기에는 연구비용과 시간이 많이 소요되므로, 3차 구조 모델링을 통한 유효 결합 판별 기술을 적용해 엠토르 활성 저해능력을 보이는 약물만 신속하게 스크리닝했다.

연구팀은 엠토르 단백질의 활성을 담당하는 효소 활성부위의 3차 구조 분석과 인공지능 기반 유효 결합 판별 기술을 도입해 후보 물질 발굴의 정확도와 예측도를 높이는 데 성공했다. 그리고 3차 구조를 타깃으로 약물 결합 분석 모듈을 도입해 가상 스크리닝의 정확도와 예측도를 높이는 데 성공했다. 이번 연구를 통해 개발된 기술의 가장 큰 특징은 타깃 단백질과 약물 간의 3차 구조 정보를 이용해 많은 양의 후보 성분들을 빠르고 정확하게 분석하고 결합 여부를 예측할 수 있는 것이다.

우리 대학 생명과학과 이보아 박사, 박승주 박사는 현재 가족성 고콜레스테롤혈증(familial hypercholesterolemia) 치료제로서 임상에서 판매, 활용되고 있는 로미타피드(lomitapide) 약물의 엠토르 활성 억제 가능성을 예측했다. 연구팀은 생화학적 및 세포 생물학적 분석을 통해 로미타피드에 의한 엠토르 효소활성의 억제효능을 검증하는 데 성공했다. 대장암, 피부암 등의 암세포에 로미타피드를 처리할 경우, 암세포의 엠토르 활성이 효과적으로 억제되고 이후 과도한 자가포식이 유도됨으로써 암세포 사멸효과가 발생함을 다각적으로 확인해 로미타피드의 항암 효능을 확립했다.

또한 대장암 환자로부터 유래한 암 오가노이드(organoid)에 로미타피드를 처리할 경우, 기존의 화학 항암 치료제 대비 우수한 암세포 사멸 능력을 보였다. 나아가 최근 차세대 고형암 치료용 항암 전략으로 주목받고 있는 면역관문억제제(immune checkpoint inhibitor)와 로미티피드를 병행할 경우, 면역관문억제제의 단독 처리 대비 비약적으로 개선된 시너지 항암효과를 나타냄을 동물모델 연구를 통해 검증하는 데 성공했다.

연구팀이 발굴한 로미타피드의 항암 효능 성과는 향후 엠토르 억제 및 자가포식 기반 항암제 개발 및 임상적 활용에 적극 활용될 것으로 기대된다.

이러한 연구성과는 벤처창업으로 연계돼 이보아 박사, 박승주 박사, 이슬기 박사는 인공지능 기반 신약개발 전문기업 `에아스텍'을 공동창업했으며 중소벤처기업부 팁스(TIPS) 창업지원 프로그램에 선정되는 등 활발한 연구개발을 수행하고 있다.

한편 이번 연구는 한국연구재단 중견연구자지원사업, 선도연구센터, 창의도전연구사업 및 KAIX 포스트닥펠로사업의 지원을 받아 수행됐다.

2022.08.12 조회수 11404

인공지능 기반 약물 가상 스크리닝 기술로 신규 항암 치료제 발굴 성공

우리 대학 생명과학과 김세윤 교수 연구팀이 `약물 가상 스크리닝 기술을 이용한 신규 항암 치료제 개발'에 성공했다고 12일 밝혔다.

이번 연구 결과는 국제 학술지인 `세포 사멸과 질병(Cell Death & Disease)'에 지난 7월 12일 字 온라인 게재됐다.

※ 논문명 : Lomitapide, a cholesterol-lowering drug, is an anticancer agent that induces autophagic cell death via inhibiting mTOR

※ 저자 정보 : 이보아 (한국과학기술원, 공동 제1 저자), 박승주 (한국과학기술원, 공동 제1 저자), 이슬기 (한국과학기술원, 제2 저자), 오병철 (가천대학교 의과대학, 공동 저자), 정원석 (한국과학기술원, 공동 저자), 손종우 (한국과학기술원, 공동 저자), 김세윤 (한국과학기술원, 교신저자), 포함 총 10명

`엠토르(mTOR)'라고 알려진 신호전달 단백질은 많은 암세포에서 활성이 비정상적으로 높아져 있으며 또한 암뿐만 아니라 당뇨, 염증 및 노화와 같은 다양한 질병에서 핵심적인 역할을 한다. 특히 암을 유발하는 다양한 신호전달 경로가 엠토르 단백질을 통해 매개되기 때문에 많은 제약사에서 항암 치료제 개발의 목적으로 엠토르 저해제 개발에 많은 투자를 하고 있다.

자가포식(autophagy, 오토파지)으로 알려진 생명 현상은 세포 내 엠토르 단백질에 의해 활성 조절이 정교하게 매개되는 것으로 잘 알려져 있다. 자가포식이란 `세포가 자기 살을 먹는다'는 의미로, 영양분이 과도하게 부족하거나 세포 내외적 스트레스 조건에 처한 경우, 세포가 스스로 내부 구성물질들을 파괴해 활용함으로써 세포 내 항상성을 유지하는 일종의 방어기전이다.

이러한 자가포식 활성의 조절은 양날의 칼과 같이 작용하는 것으로 알려져 있으며, 이는 암, 당뇨와 같은 질환의 발생 및 치료에 이용 가능하다고 주목받고 있다. 암세포에 과도하게 활성화돼있는 엠토르 단백질의 활성을 저해하면 자가포식을 과도하게 증가시킬 수 있으며 이를 통해 암세포의 세포 사멸이 유도될 수 있다는 사실이 알려져 있으며 이를 바탕으로 자가포식 강화에 기반한 항암제 약물의 개발전략이 제시되고 있다.

이에 김세윤 교수 연구팀은 단백질의 3차원적 구조를 활용해 화합물과 표적 단백질 사이의 물리적 상호작용을 모델링하는 유효 결합 판별 기술에 기반한 약물 재창출 전략으로 엠토르 억제성 항암제 개발 연구를 수행했다.

약물 재창출은 이미 안전성이 검증된 FDA 승인 약물 또는 임상 진행 중인 약물군을 대상으로 새로운 적응증을 찾는 신약 개발 방식이다. 이 전략은 전통적으로 10년 이상 소요되는 신약 개발의 막대한 시간과 투자를 혁신적으로 단축할 수 있는 미래 시대 신약 개발전략이다.

연구팀은 FDA 승인 약물 또는 임상 시험 중인 약물에 기반한 데이터베이스를 통해 3,391종의 약물 라이브러리를 활용했다. 라이브러리의 모든 약물을 실험적으로 검증하기에는 연구비용과 시간이 많이 소요되므로, 3차 구조 모델링을 통한 유효 결합 판별 기술을 적용해 엠토르 활성 저해능력을 보이는 약물만 신속하게 스크리닝했다.

연구팀은 엠토르 단백질의 활성을 담당하는 효소 활성부위의 3차 구조 분석과 인공지능 기반 유효 결합 판별 기술을 도입해 후보 물질 발굴의 정확도와 예측도를 높이는 데 성공했다. 그리고 3차 구조를 타깃으로 약물 결합 분석 모듈을 도입해 가상 스크리닝의 정확도와 예측도를 높이는 데 성공했다. 이번 연구를 통해 개발된 기술의 가장 큰 특징은 타깃 단백질과 약물 간의 3차 구조 정보를 이용해 많은 양의 후보 성분들을 빠르고 정확하게 분석하고 결합 여부를 예측할 수 있는 것이다.

우리 대학 생명과학과 이보아 박사, 박승주 박사는 현재 가족성 고콜레스테롤혈증(familial hypercholesterolemia) 치료제로서 임상에서 판매, 활용되고 있는 로미타피드(lomitapide) 약물의 엠토르 활성 억제 가능성을 예측했다. 연구팀은 생화학적 및 세포 생물학적 분석을 통해 로미타피드에 의한 엠토르 효소활성의 억제효능을 검증하는 데 성공했다. 대장암, 피부암 등의 암세포에 로미타피드를 처리할 경우, 암세포의 엠토르 활성이 효과적으로 억제되고 이후 과도한 자가포식이 유도됨으로써 암세포 사멸효과가 발생함을 다각적으로 확인해 로미타피드의 항암 효능을 확립했다.

또한 대장암 환자로부터 유래한 암 오가노이드(organoid)에 로미타피드를 처리할 경우, 기존의 화학 항암 치료제 대비 우수한 암세포 사멸 능력을 보였다. 나아가 최근 차세대 고형암 치료용 항암 전략으로 주목받고 있는 면역관문억제제(immune checkpoint inhibitor)와 로미티피드를 병행할 경우, 면역관문억제제의 단독 처리 대비 비약적으로 개선된 시너지 항암효과를 나타냄을 동물모델 연구를 통해 검증하는 데 성공했다.

연구팀이 발굴한 로미타피드의 항암 효능 성과는 향후 엠토르 억제 및 자가포식 기반 항암제 개발 및 임상적 활용에 적극 활용될 것으로 기대된다.

이러한 연구성과는 벤처창업으로 연계돼 이보아 박사, 박승주 박사, 이슬기 박사는 인공지능 기반 신약개발 전문기업 `에아스텍'을 공동창업했으며 중소벤처기업부 팁스(TIPS) 창업지원 프로그램에 선정되는 등 활발한 연구개발을 수행하고 있다.

한편 이번 연구는 한국연구재단 중견연구자지원사업, 선도연구센터, 창의도전연구사업 및 KAIX 포스트닥펠로사업의 지원을 받아 수행됐다.

2022.08.12 조회수 11404