%EB%A9%80%ED%8B%B0%EB%AA%A8%EB%8B%AC

-

지금 당신의 마음 건강은 어떠한가요?

최근 빠른 고령화 및 출산율 감소 등으로 1인 가구가 급속하게 증가하면서, 1인 가구의 정신건강 문제에 대한 관심도 함께 높아지고 있다. 서울시가 실시한 1인 가구 실태조사에 따르면, 1인 가구의 60% 이상이 외로움을 느끼고 있으며, 특히 사회적 고립과 함께 외로움을 겪는 비율이 상당히 높은 것으로 나타났다.

우리 대학 전산학부 이의진 교수 연구팀이 1인 가구의 정신건강 관리를 위해, 사용자 스스로가 자신의 심리 상태를 기록할 수 있도록 지원하는 상황 인식 기반 멀티모달 스마트 스피커 시스템을 개발했다고 24일 밝혔다.

연구팀은 사용자의 주변 상황을 실시간으로 파악해 최적의 시점에 정신건강 관련 질문하도록 이 시스템을 설계했고 기존의 무작위 설문보다 높은 응답률을 달성하는 것을 확인했다.

기존 스마트 스피커를 활용한 정신건강 자가 추적 연구에서 무작위 설문을 할 경우 사용자의 스트레스, 짜증 등 부정적인 감정이 유발시켜 설문 응답에 편향이 발생할 수 있어 각별한 주의가 필요했다.

이러한 문제 해결을 위해 이의진 교수 연구팀은 스마트 스피커에 멀티 모달 센서를 장착해, 사용자의 주변 상황의 변화를 감지해 스피커가 말 걸기 좋은 시점이 검출되면 정신건강 자가 추적 설문을 능동적으로 요청하는 상황 인식 기반 자가 추적 기술을 개발했다.

스피커는 실내 움직임, 조명, 소음, 이산화탄소 등 다양한 센서 데이터를 종합적으로 분석해 사용자의 존재 및 활동을 감지한 뒤, 사용자가 응답하기 적합한 시점에 자가 추적 설문을 능동적으로 요청함으로써, 설문 응답의 효율성을 극대화했다.

또한, 설문 입력 방식의 경우 최근 출시된 스마트 스피커는 명령뿐만 아니라 터치스크린도 지원하므로 사용자들이 음성 또는 터치 입력 방식을 자유롭게 선택할 수 있도록 해 상호작용의 폭을 넓혔다. 이를 통해 사용자는 상황에 맞는 최적의 인터페이스를 선택해 자가 추적을 쉽게 수행할 수 있도록 했다.

개발된 스피커의 사용자 경험을 평가하기 위해서 연구팀은 1인 가구 20세대에 자가 추적 스마트 스피커를 설치해, 한 달 동안 실증 연구를 수행해서 총 2,201개의 정신건강 설문 응답 데이터셋을 구축했다.

데이터셋 분석을 통해 설문 응답 시간, 활동 맥락에 따른 설문 응답 패턴 및 어떤 상황에서 음성 입력(VUI) 또는 터치 입력(GUI)이 더 선호되는지 파악했다.

특히, 스마트 스피커가 말로 사용자에게 요청을 하다 보니 스피커 근처에서 사용자의 활동을 감지하는 것이 정신건강 설문 응답률에 큰 영향을 미쳤다. 음성 입력의 편의성에도 불구하고 전반적으로 참가자들은 음성 입력보다는 빠른 응답이 가능한 터치 입력을 선호했다.

데이터 분석 결과, 사용자의 주변 상황을 실시간으로 파악해 최적의 시점에 정신건강 관련 질문을 할 경우 응답률이 더 높으며, 어떤 상황에서 음성 또는 터치 인터페이스를 선호하는지도 파악했다.

연구를 주도한 이의진 교수는 “이번에 개발한 스마트 스피커를 앞으로 수용전념치료 기법을 활용한 인간상담사와 같은 기능의 정신건강 관리 지원 스마트 스피커로 발전시키고자 한다. 나아가 실내에서 수집된 일상생활 데이터를 AI 모델로 학습해 사용자 정신건강 상태에 따라 라이프 스타일 패턴을 예측하는 시스템도 개발하여 향후 정신질환 조기 발견과 효율적인 관리를 가능케 할 인공지능 에이전트의 혁신을 이끌 것으로 기대된다” 라고 말했다.

한편 이 연구는 LG전자-KAIST 디지털 헬스케어 연구센터의 지원을 받아 수행됐고 인간 컴퓨터 상호작용(HCI) 분야 국제 최우수 국제학술대회인 미국컴퓨터협회(ACM) 소속 ‘Conference on Human Factors in Computing Systems (CHI)’에서 지난 2024년 5월에 발표됐다.

논문명: Exploring Context-Aware Mental Health Self-Tracking Using Multimodal Smart Speakers in Home Environments

2024.09.24 조회수 4546

지금 당신의 마음 건강은 어떠한가요?

최근 빠른 고령화 및 출산율 감소 등으로 1인 가구가 급속하게 증가하면서, 1인 가구의 정신건강 문제에 대한 관심도 함께 높아지고 있다. 서울시가 실시한 1인 가구 실태조사에 따르면, 1인 가구의 60% 이상이 외로움을 느끼고 있으며, 특히 사회적 고립과 함께 외로움을 겪는 비율이 상당히 높은 것으로 나타났다.

우리 대학 전산학부 이의진 교수 연구팀이 1인 가구의 정신건강 관리를 위해, 사용자 스스로가 자신의 심리 상태를 기록할 수 있도록 지원하는 상황 인식 기반 멀티모달 스마트 스피커 시스템을 개발했다고 24일 밝혔다.

연구팀은 사용자의 주변 상황을 실시간으로 파악해 최적의 시점에 정신건강 관련 질문하도록 이 시스템을 설계했고 기존의 무작위 설문보다 높은 응답률을 달성하는 것을 확인했다.

기존 스마트 스피커를 활용한 정신건강 자가 추적 연구에서 무작위 설문을 할 경우 사용자의 스트레스, 짜증 등 부정적인 감정이 유발시켜 설문 응답에 편향이 발생할 수 있어 각별한 주의가 필요했다.

이러한 문제 해결을 위해 이의진 교수 연구팀은 스마트 스피커에 멀티 모달 센서를 장착해, 사용자의 주변 상황의 변화를 감지해 스피커가 말 걸기 좋은 시점이 검출되면 정신건강 자가 추적 설문을 능동적으로 요청하는 상황 인식 기반 자가 추적 기술을 개발했다.

스피커는 실내 움직임, 조명, 소음, 이산화탄소 등 다양한 센서 데이터를 종합적으로 분석해 사용자의 존재 및 활동을 감지한 뒤, 사용자가 응답하기 적합한 시점에 자가 추적 설문을 능동적으로 요청함으로써, 설문 응답의 효율성을 극대화했다.

또한, 설문 입력 방식의 경우 최근 출시된 스마트 스피커는 명령뿐만 아니라 터치스크린도 지원하므로 사용자들이 음성 또는 터치 입력 방식을 자유롭게 선택할 수 있도록 해 상호작용의 폭을 넓혔다. 이를 통해 사용자는 상황에 맞는 최적의 인터페이스를 선택해 자가 추적을 쉽게 수행할 수 있도록 했다.

개발된 스피커의 사용자 경험을 평가하기 위해서 연구팀은 1인 가구 20세대에 자가 추적 스마트 스피커를 설치해, 한 달 동안 실증 연구를 수행해서 총 2,201개의 정신건강 설문 응답 데이터셋을 구축했다.

데이터셋 분석을 통해 설문 응답 시간, 활동 맥락에 따른 설문 응답 패턴 및 어떤 상황에서 음성 입력(VUI) 또는 터치 입력(GUI)이 더 선호되는지 파악했다.

특히, 스마트 스피커가 말로 사용자에게 요청을 하다 보니 스피커 근처에서 사용자의 활동을 감지하는 것이 정신건강 설문 응답률에 큰 영향을 미쳤다. 음성 입력의 편의성에도 불구하고 전반적으로 참가자들은 음성 입력보다는 빠른 응답이 가능한 터치 입력을 선호했다.

데이터 분석 결과, 사용자의 주변 상황을 실시간으로 파악해 최적의 시점에 정신건강 관련 질문을 할 경우 응답률이 더 높으며, 어떤 상황에서 음성 또는 터치 인터페이스를 선호하는지도 파악했다.

연구를 주도한 이의진 교수는 “이번에 개발한 스마트 스피커를 앞으로 수용전념치료 기법을 활용한 인간상담사와 같은 기능의 정신건강 관리 지원 스마트 스피커로 발전시키고자 한다. 나아가 실내에서 수집된 일상생활 데이터를 AI 모델로 학습해 사용자 정신건강 상태에 따라 라이프 스타일 패턴을 예측하는 시스템도 개발하여 향후 정신질환 조기 발견과 효율적인 관리를 가능케 할 인공지능 에이전트의 혁신을 이끌 것으로 기대된다” 라고 말했다.

한편 이 연구는 LG전자-KAIST 디지털 헬스케어 연구센터의 지원을 받아 수행됐고 인간 컴퓨터 상호작용(HCI) 분야 국제 최우수 국제학술대회인 미국컴퓨터협회(ACM) 소속 ‘Conference on Human Factors in Computing Systems (CHI)’에서 지난 2024년 5월에 발표됐다.

논문명: Exploring Context-Aware Mental Health Self-Tracking Using Multimodal Smart Speakers in Home Environments

2024.09.24 조회수 4546 -

멀티모달 대형언어모델이 GPT-4V를 뛰어넘다

멀티모달 대형 언어모델이란 텍스트뿐만 아니라 이미지 데이터 유형까지 처리할 수 있는 초대형 언어모델을 말한다. 해외 대형 기업의 풍부한 컴퓨팅 자원의 지원으로부터 인간의 뇌에 있는 신경망의 개수와 유사한 수준초대형모델들이 만들어지고 있으나 학계에서는 이런 개발이 쉽지 않았다. KAIST 연구진이 오픈AI의 GPT-4V와 구글의 제미나이-프로(Gemini-Pro)를 뛰어넘는 멀티모달 대형언어모델을 개발하여 화제다.

우리 대학 전기및전자공학부 노용만 교수 연구팀이 오픈AI(OpenAI)의 GPT-4V 등 기업에서 비공개하고 있는 상업 모델인 초대형 언어모델의 시각 성능을 뛰어넘는 공개형 멀티모달 대형 언어모델을 개발해 출시했다고 20일 밝혔다.

노용만 교수 연구팀은 단순히 모델의 크기를 키우거나 고품질의 시각적 지시 조정 데이터셋을 만들지 않고 멀티모달 대형언어모델의 시각 성능을 획기적으로 높인 콜라보(CoLLaVO), 모아이(MoAI) 2가지 기술을 연속적으로 개발했다고 밝혔다.

연구팀이 개발한 첫번째 기술인 ‘콜라보(CoLLaVO)’는 현존하는 공개형 멀티모달 대형언어모델이 비공개형 모델의 성능에 비해 현저하게 낮은 이유를 일차적으로 물체 수준에 대한 이미지 이해 능력이 현저하게 떨어진다는 것을 먼저 검증해 보였다.

해당 능력을 효율적으로 증가시켜 시각-언어 태스크에 대한 성능을 향상 하기 위해 연구팀은 이미지 내의 정보를 배경과 물체 단위로 분할하고 각 배경 및 물체에 대한 정보를 멀티모달 대형언어모델에 입력으로 직접 넣어주는 새로운 방법‘크레용 프롬프트(Crayon Prompt)’라는 시각적 프롬프트를 새롭게 제안했다.

또한 시각적 지시 조정 단계에서 크레용 프롬프트로 학습한 정보를 잃어버리지 않기 위해 연구팀은 물체 수준 이미지 이해 능력과 시각-언어 태스크 처리 능력을 서로 다른 파라미터로 학습해 서로 간의 정보를 잃지 않게 만드는 획기적인 학습 전략인 ‘듀얼 큐로라(Dual QLoRA)’를 제안했다. 이를 통해, 콜라보(CoLLaVO) 멀티모달 대형언어모델은 이미지 내에서 배경 및 물체를 구분하는 능력이 뛰어나 일차원적인 시각 구분 능력이 크게 향상됐다고 밝혔다.

두 번째 대형언어모델인 ‘모아이(MoAI)’는 인간이 사물을 판단할 때 물체의 존재, 상태, 물체 간의 상호작용, 배경에 대한 이해, 텍스트에 대한 이해 등으로부터 상황을 판단하는 인지과학적인 요소에 영감을 받아서 만들어졌다고 밝혔다.

이는 기존 멀티모달 대형언어모델이 텍스트에 의미적으로 정렬된 시각 인코더(vision encoder)만을 사용하기 때문에, 이미지 픽셀 수준에서의 상세하고 종합적인 실세계 장면 이해가 부족하다는 점을 지적하며 이런 컴퓨터 비전 모델들의 결과를 받으면 모두 인간이 이해할 수 있는 언어로 변환한 뒤에 멀티모달 대형언어모델에 입력으로 직접 사용했다.

노용만 교수는 “연구팀에서 개발한 공개형 멀티모달 대형언어모델이 허깅페이스 일간 화제의 논문(Huggingface Daily Papers)에 추천됐고, 각종 SNS를 통해 세계 연구자에게 알려지고 있으며, 모든 모델을 공개형 대형언어모델로 출시 했기 때문에 이 연구모델이 멀티모달 대형언어모델 발전에 기여할 것이다”이라고 언급했다.

연구팀이 개발한 멀티모달 대형언어모델인 콜라보(CoLLaVO)와 모아이(MoAI)는 KAIST 전기및전자공학부 이병관 박사과정이 제1 저자로 참여하고 박범찬 석박사통합과정, 김채원 박사과정이 공동 저자로 참여했다.

콜라보(CoLLaVO)는 자연어 처리(NLP) 분야 최고의 국제 학회인 ‘Findings of the Association for Computational Linguistics(ACL Findings) 2024’에 5월 16일 자로 학회에 승인받았고, 모아이(MoAI)는 컴퓨터 비전 최고의 국제 학회인 ‘European Conference on Computer Vision(ECCV) 2024’학회 승인 결과를 기다리고 있다고 밝혔다.

한편 이번 연구는 KAIST 미래국방 인공지능 특화연구센터 및 전기및전자공학부의 지원을 받아 수행됐다.

[1] CoLLaVO 데모 GIF 영상

https://github.com/ByungKwanLee/CoLLaVO

[2] MoAI 데모 GIF 영상

https://github.com/ByungKwanLee/MoAI

2024.06.20 조회수 8558

멀티모달 대형언어모델이 GPT-4V를 뛰어넘다

멀티모달 대형 언어모델이란 텍스트뿐만 아니라 이미지 데이터 유형까지 처리할 수 있는 초대형 언어모델을 말한다. 해외 대형 기업의 풍부한 컴퓨팅 자원의 지원으로부터 인간의 뇌에 있는 신경망의 개수와 유사한 수준초대형모델들이 만들어지고 있으나 학계에서는 이런 개발이 쉽지 않았다. KAIST 연구진이 오픈AI의 GPT-4V와 구글의 제미나이-프로(Gemini-Pro)를 뛰어넘는 멀티모달 대형언어모델을 개발하여 화제다.

우리 대학 전기및전자공학부 노용만 교수 연구팀이 오픈AI(OpenAI)의 GPT-4V 등 기업에서 비공개하고 있는 상업 모델인 초대형 언어모델의 시각 성능을 뛰어넘는 공개형 멀티모달 대형 언어모델을 개발해 출시했다고 20일 밝혔다.

노용만 교수 연구팀은 단순히 모델의 크기를 키우거나 고품질의 시각적 지시 조정 데이터셋을 만들지 않고 멀티모달 대형언어모델의 시각 성능을 획기적으로 높인 콜라보(CoLLaVO), 모아이(MoAI) 2가지 기술을 연속적으로 개발했다고 밝혔다.

연구팀이 개발한 첫번째 기술인 ‘콜라보(CoLLaVO)’는 현존하는 공개형 멀티모달 대형언어모델이 비공개형 모델의 성능에 비해 현저하게 낮은 이유를 일차적으로 물체 수준에 대한 이미지 이해 능력이 현저하게 떨어진다는 것을 먼저 검증해 보였다.

해당 능력을 효율적으로 증가시켜 시각-언어 태스크에 대한 성능을 향상 하기 위해 연구팀은 이미지 내의 정보를 배경과 물체 단위로 분할하고 각 배경 및 물체에 대한 정보를 멀티모달 대형언어모델에 입력으로 직접 넣어주는 새로운 방법‘크레용 프롬프트(Crayon Prompt)’라는 시각적 프롬프트를 새롭게 제안했다.

또한 시각적 지시 조정 단계에서 크레용 프롬프트로 학습한 정보를 잃어버리지 않기 위해 연구팀은 물체 수준 이미지 이해 능력과 시각-언어 태스크 처리 능력을 서로 다른 파라미터로 학습해 서로 간의 정보를 잃지 않게 만드는 획기적인 학습 전략인 ‘듀얼 큐로라(Dual QLoRA)’를 제안했다. 이를 통해, 콜라보(CoLLaVO) 멀티모달 대형언어모델은 이미지 내에서 배경 및 물체를 구분하는 능력이 뛰어나 일차원적인 시각 구분 능력이 크게 향상됐다고 밝혔다.

두 번째 대형언어모델인 ‘모아이(MoAI)’는 인간이 사물을 판단할 때 물체의 존재, 상태, 물체 간의 상호작용, 배경에 대한 이해, 텍스트에 대한 이해 등으로부터 상황을 판단하는 인지과학적인 요소에 영감을 받아서 만들어졌다고 밝혔다.

이는 기존 멀티모달 대형언어모델이 텍스트에 의미적으로 정렬된 시각 인코더(vision encoder)만을 사용하기 때문에, 이미지 픽셀 수준에서의 상세하고 종합적인 실세계 장면 이해가 부족하다는 점을 지적하며 이런 컴퓨터 비전 모델들의 결과를 받으면 모두 인간이 이해할 수 있는 언어로 변환한 뒤에 멀티모달 대형언어모델에 입력으로 직접 사용했다.

노용만 교수는 “연구팀에서 개발한 공개형 멀티모달 대형언어모델이 허깅페이스 일간 화제의 논문(Huggingface Daily Papers)에 추천됐고, 각종 SNS를 통해 세계 연구자에게 알려지고 있으며, 모든 모델을 공개형 대형언어모델로 출시 했기 때문에 이 연구모델이 멀티모달 대형언어모델 발전에 기여할 것이다”이라고 언급했다.

연구팀이 개발한 멀티모달 대형언어모델인 콜라보(CoLLaVO)와 모아이(MoAI)는 KAIST 전기및전자공학부 이병관 박사과정이 제1 저자로 참여하고 박범찬 석박사통합과정, 김채원 박사과정이 공동 저자로 참여했다.

콜라보(CoLLaVO)는 자연어 처리(NLP) 분야 최고의 국제 학회인 ‘Findings of the Association for Computational Linguistics(ACL Findings) 2024’에 5월 16일 자로 학회에 승인받았고, 모아이(MoAI)는 컴퓨터 비전 최고의 국제 학회인 ‘European Conference on Computer Vision(ECCV) 2024’학회 승인 결과를 기다리고 있다고 밝혔다.

한편 이번 연구는 KAIST 미래국방 인공지능 특화연구센터 및 전기및전자공학부의 지원을 받아 수행됐다.

[1] CoLLaVO 데모 GIF 영상

https://github.com/ByungKwanLee/CoLLaVO

[2] MoAI 데모 GIF 영상

https://github.com/ByungKwanLee/MoAI

2024.06.20 조회수 8558 -

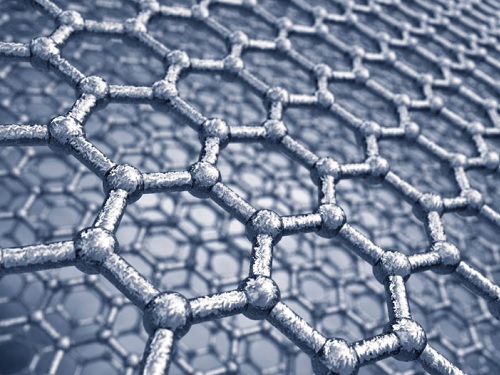

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05 조회수 11972

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05 조회수 11972